翻车,大翻车。

就在今天凌晨,谷歌版Her——Gemini Live正式发布。

毕竟明显是对标OpenAI家的GPT-4o,可以说是吸足了科技圈的眼球。

在官网发布的demo中,拍照问答功能的效果是这样的:

它大致实现的功能,是用手机拍摄演唱会的海报,并让Gemini查看用户的日历,看看行程是否适合参加。

以及还可以基于此进行一系列后续的操作,包括定时间查票价等等。

然而……当来到发布会现场演示环节的时候,画风却180°大变样。

请看VCR:

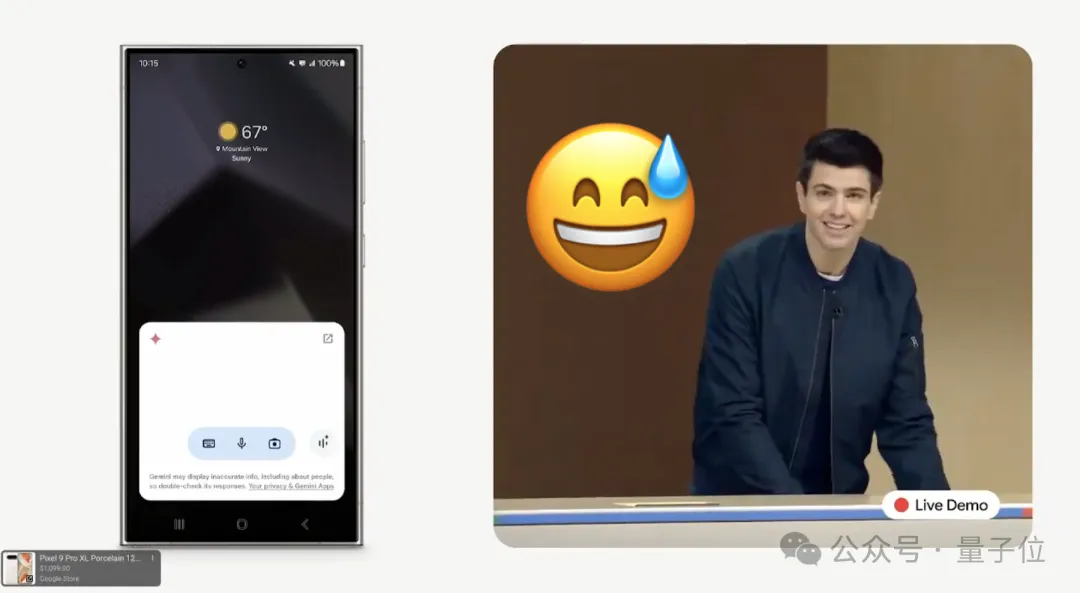

- 第一次:失败了。

- 第二次:失败了。

- 第三次:换手机,成功了。

嗯……小哥表情,肉眼可见的有点慌。

就连知名科技媒体TechCrunch都配上了这样的emoji:

甚至还有网友开启了辣评模式:

我10秒钟就能搜索我的日历。

当然,这只是今天Made by Google的一个小插曲。

关于Gemini Live的更多内容,我们继续往下看。

谷歌版Her的全貌

正如我们刚才提到的,Gemini Live和GPT-4o的功能十分相似。

除了“拍照问答”之外,它也可以做到实时对话,甚至在Gemini回复过程中进行打断。

据了解,目前Gemini Live的功能已经在安卓系统中向Advanced订阅者开放(仅限英语)。

未来几周,这个功能会陆续扩展到更多语言并且向iOS开放。

在对话声音方面,Gemini Live推出了10种新的声音供选择,效果是这样的:

在操作方面,由于Gemini已经完全集成到了系统中,所以只需长按电源按钮或说“Hey Google”,就可以调用了。

例如在写邮件的过程中,让Gemini帮你生成配图,效果如下:

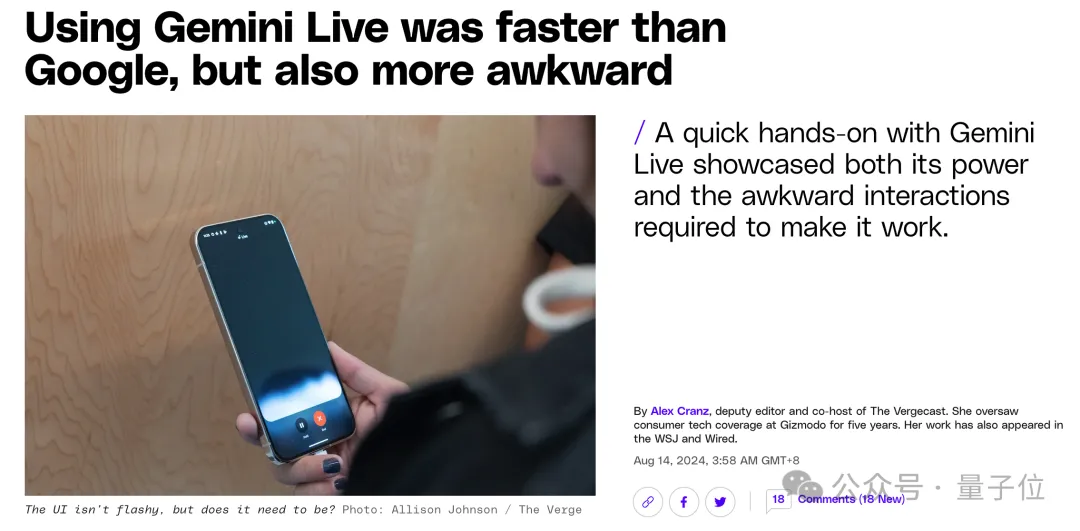

不过对于这项功能,外媒们的评价却是褒贬不一。

例如The Verge的一位作者在亲测后给出的标题是——

Gemini Live比Google快,但更尴尬。

具体原因是作者在一次为期三天的公路旅行中,汽车的音频系统突然失效。

使用原先的谷歌助手寻找解决方案花费了至少五分钟,而Gemini Live仅耗时15秒。

但对话过程中的Gemini Live的持续发言和需要用户主动打断的交互方式,却让作者感到尴尬。

他认为:

声音和说话方式过于人性化,以至于在打断它时感到不自在。

与Gemini Live的互动中投入了更多情感,而不是将其作为解决问题的工具。

无独有偶,对于Gemini Live在云端运行这个点,华尔街日报也给出了犀利的评价——

对话上的进步,功能上的退步。

具体到技术层面,GPT-4o是一个端到端的系统,但从谷歌发布的内容来看,Gemini Live则并非如此。

而是将STT、VAD、LLM和TTS系统做了集成:

除此之外,谷歌所发布的新Pixel系列手机中,也出现了Gemini Live的身影。

包括Pixel 9 Pro Fold、Pixel 9、Pixel 9 Pro和Pixel 9 Pro XL。

AI功能方面,谷歌的Pixel手机在拍照上增加了一个叫“Add Me”的功能。

可以用增强现实(AR)和AI技术,可以把两张不同照片中的人物“塞”到一起。

谷歌为什么追不上OpenAI?

虽然谷歌这次发布Gemini Live,算是对OpenAI GPT-4o的一种应战,但自从大模型时代拉开序幕以来,我们可以看到一个非常明显的一种趋势——

谷歌,跟不上OpenAI的脚步。

首先是在最为关键的ChatGPT发布的这个节点上,OpenAI成为了开拓者,但谷歌随后发布的Bard,和这次Gemini Live很相似,后续出现了翻车情况。

而后近一年半多的时间来,似乎所有重磅模型、重磅应用的发布,都是OpenAI在引领。

反观谷歌这边,不仅是技术呈现出步步慢的状态;甚至在舆论上,还出现了被OpenAI用一个人事变动(Ilya离职)消息盖过谷歌年度最大活动(I/O大会)热度的情况。

那么谷歌在大模型时代为什么不行了?

对此,前谷歌CEO Eric Schmidt(2001年至2011年任职)在斯坦福最新的演讲中表达了他的观点:

谷歌非常重视工作与生活的平衡,例如允许员工居家办公。

但创业公司,他们工作真的很拼。

甚至还有网友爆料称:

我兄弟是谷歌顶级AI程序员,他有3个全职工作,每天只在谷歌这边花2个小时。