大家好,我是小寒

今天给大家分享一个强大的算法模型,集成学习

集成学习(Ensemble Learning)是一种提升模型性能和鲁棒性的重要方法,它通过组合多个学习器(通常称为基学习器)来解决同一个问题。

它的核心思想是 “集体智慧”,即通过整合多个模型的预测结果,可以抵消单个模型的偏差和方差,从而提升整体的预测准确性和泛化能力。集成学习在各种复杂任务中,如分类、回归、异常检测等,显示出了强大的效果。

集成学习的类型

集成学习主要分为以下几种类型

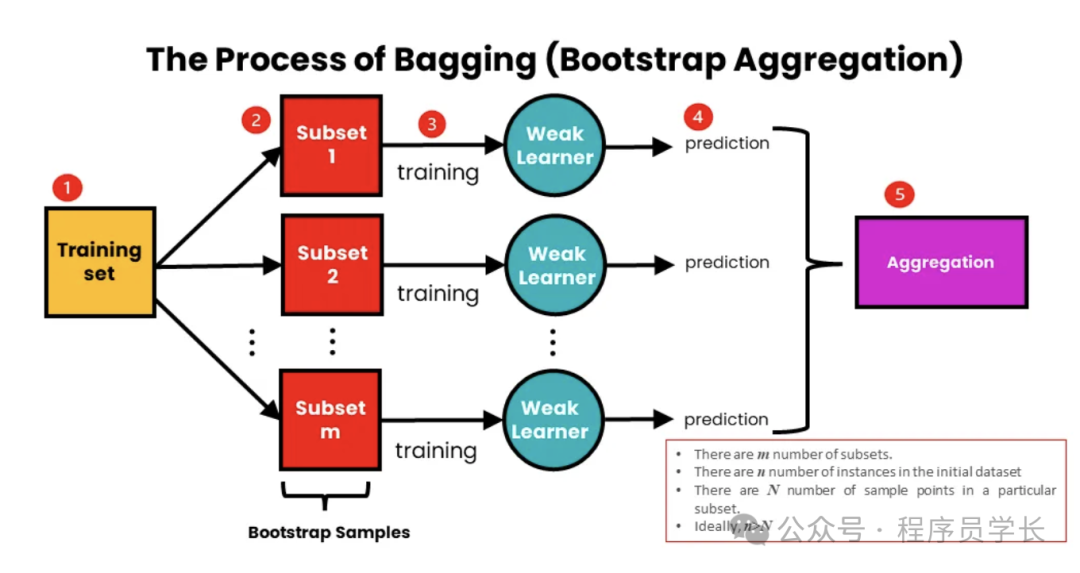

1.Bagging

Bagging(Bootstrap Aggregating)是一种集成方法,旨在通过平均多个模型的预测来减少方差并防止过度拟合。

- 基本原理

通过对原始数据集进行有放回的随机采样,生成多个不同的子数据集,每个子数据集用于训练一个基学习器。

最终的预测结果通过对所有基学习器的预测结果进行平均(回归)或投票(分类)得到。 - 典型算法

随机森林(Random Forest),其中每个基学习器是一个决策树。 - 优点

可以显著降低模型的方差,减少过拟合。

图片

图片

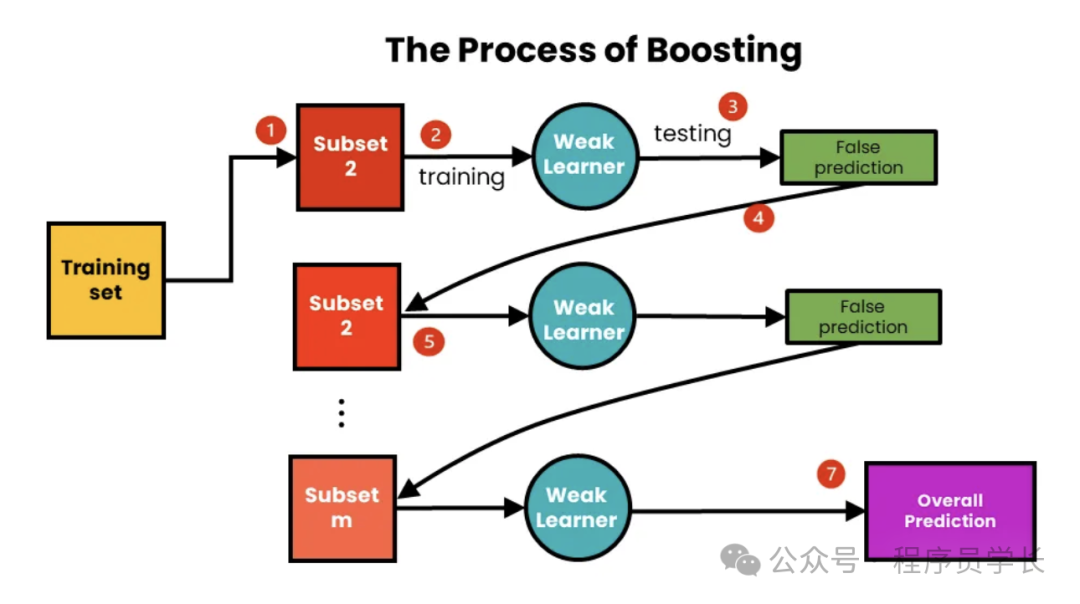

2.Boosting

Boosting 是一种集成技术,专注于通过顺序训练弱学习器来提高其性能。

每个模型都试图纠正其前任所犯的错误,从而对错误分类的实例赋予更大的权重。

- 基本原理

通过逐步训练一系列基学习器,每个基学习器都试图纠正其前一个基学习器的错误。

最终的预测结果是这些基学习器的加权和。 - 典型算法

AdaBoost、Gradient Boosting、XGBoost、LightGBM。 - 优点

能够有效地提高模型的准确性。

图片

图片

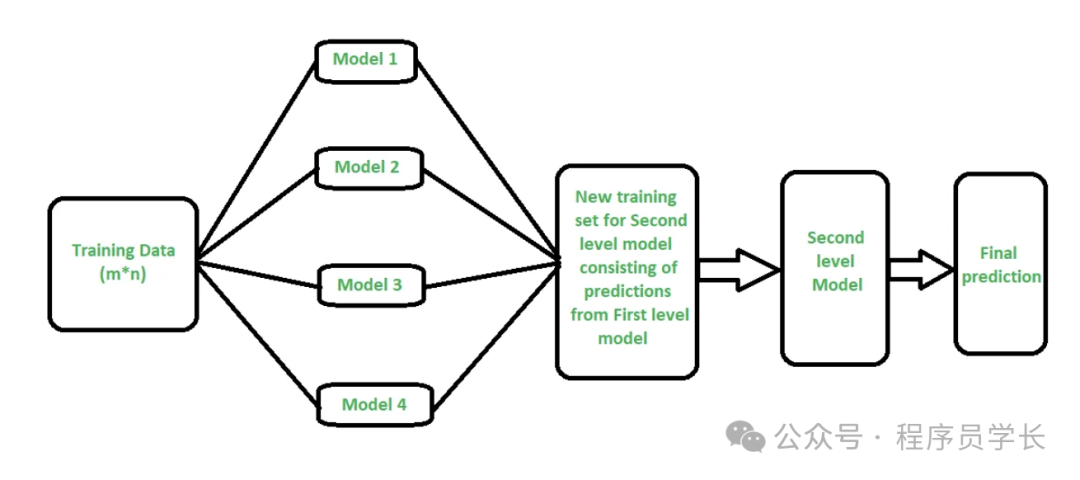

3.Stacking

堆叠是一种集成方法,涉及训练多个不同的模型(基学习器)并使用元模型来组合它们的预测。

元模型根据基学习器的输出进行训练,以做出最终预测。

- 基本原理

将多个不同类型的基学习器的预测结果作为新的特征,再训练一个元学习器(Meta-Learner)来进行最终的预测。

这个元学习器通常也是一个机器学习模型。 - 优点

能够综合利用多种不同类型模型的优势,提高预测性能。

图片

图片

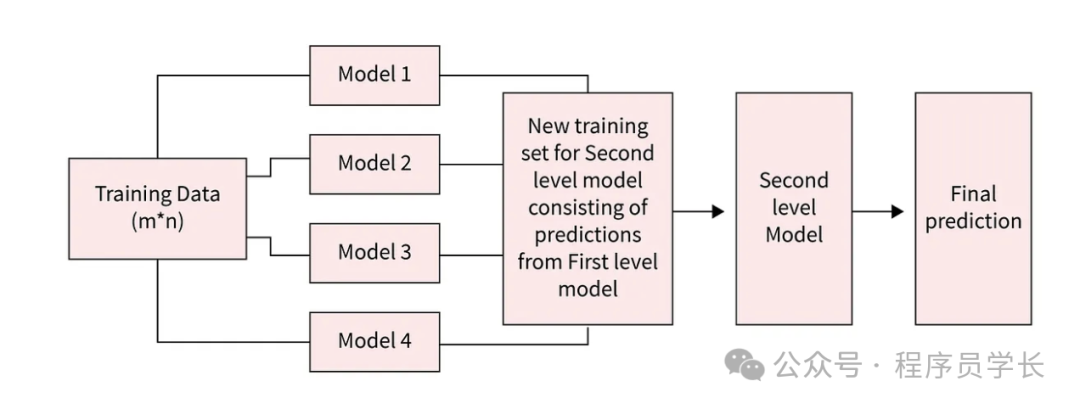

4.Blending

Blending 与 Stacking 类似,但 Blending 使用的是验证集来训练次级学习器。

具体来说,先使用训练数据的一个子集(如70%)训练多个基学习器,再用另一个独立的验证集(如剩余的30%)来训练次级学习器。

案例分享

下面是一些使用 scikit-learn 实现 Bagging 和 Boosting 的示例代码。

Bagging 示例(使用随机森林)

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

data = load_iris()

X, y = data.data, data.target

# 拆分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 训练随机森林分类器

clf = RandomForestClassifier(n_estimators=100, random_state=42)

clf.fit(X_train, y_train)

# 预测并评估

y_pred = clf.predict(X_test)

print('Accuracy:', accuracy_score(y_test, y_pred))Boosting 示例(使用 AdaBoost)

from sklearn.ensemble import AdaBoostClassifier

from sklearn.tree import DecisionTreeClassifier

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.metrics import accuracy_score

# 加载数据集

data = load_iris()

X, y = data.data, data.target

# 拆分数据集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3, random_state=42)

# 训练 AdaBoost 分类器

clf = AdaBoostClassifier(base_estimator=DecisionTreeClassifier(max_depth=1), n_estimators=50, random_state=42)

clf.fit(X_train, y_train)

# 预测并评估

y_pred = clf.predict(X_test)

print('Accuracy:', accuracy_score(y_test, y_pred))最后