谷歌致力于负责任地打造 AI 驱动的产品

跟我们一起来回顾

2024 Google 开发者大会 AI 专题演讲

探索多款 AI 工具更新

了解如何解锁 AI 潜力推动开源协作

加快创新速度

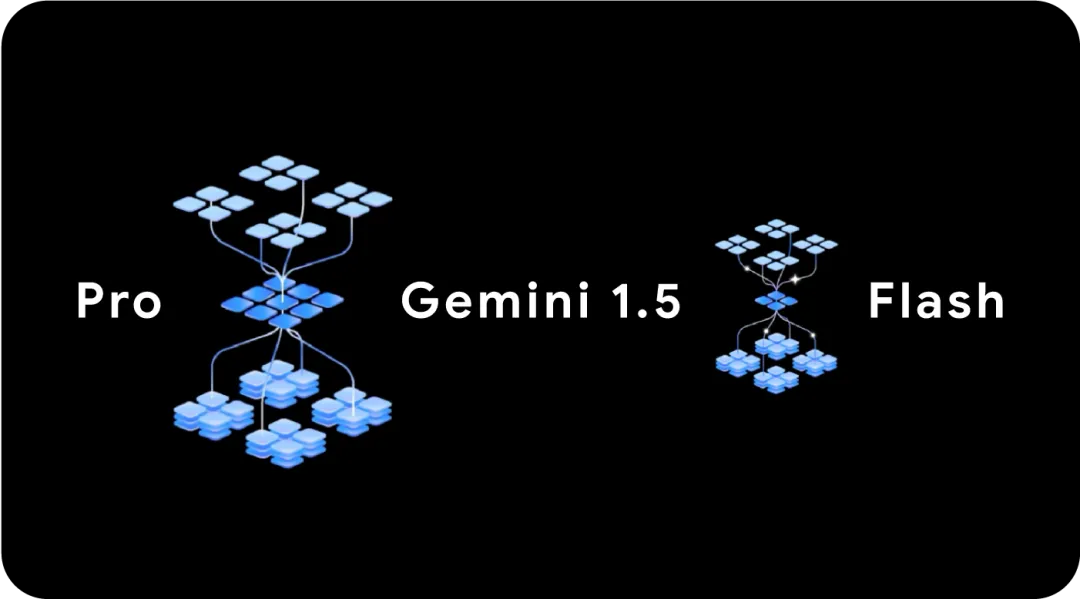

谷歌致力于让生成式 AI 触手可及,助力全球每一位开发者借助 AI 释放创新潜能,提升开发效率。为此,谷歌提供了三种不同规格的 Gemini 模型*,更好地满足不同的需求,包括适合处理设备端任务的 Gemini Nano,适合处理高容量任务的 Gemini 1.5 Flash,能够处理各种复杂任务 Gemini 1.5 Pro。

Gemini 1.5 Pro & Gemini 1.5 Flash

Gemini 1.5 Pro 已成功升级,上下文窗口扩展至 200 万 token,现已向所有开发者开放。

Gemini 1.5 Pro 和 1.5 Flash 推出上下文缓存功能。开发者可以将提示中不变的部分缓存起来,在后续调用中轻松引用,大幅降低费用。

Google AI Studio* 集成了丰富的模型资源,出海企业的开发者可借此更便捷地免费试用这些 Gemini 模型,并将 Gemini API *集成到自己的应用中,在不同场景中实现创新。

*适用于出海开发者

Gemma 是一系列先进的轻量级开放模型,采用与 Gemini 模型相同的研究成果和技术构建。Gemma 拥有同等规模最领先的性能,采用负责任的设计,可以在开发者的笔记本或者台式机上运行,同时支持跨框架、工具和硬件的优化,能够帮助开发人员和研究人员负责任地构建和部署人工智能应用程序。

Gemma 的优势

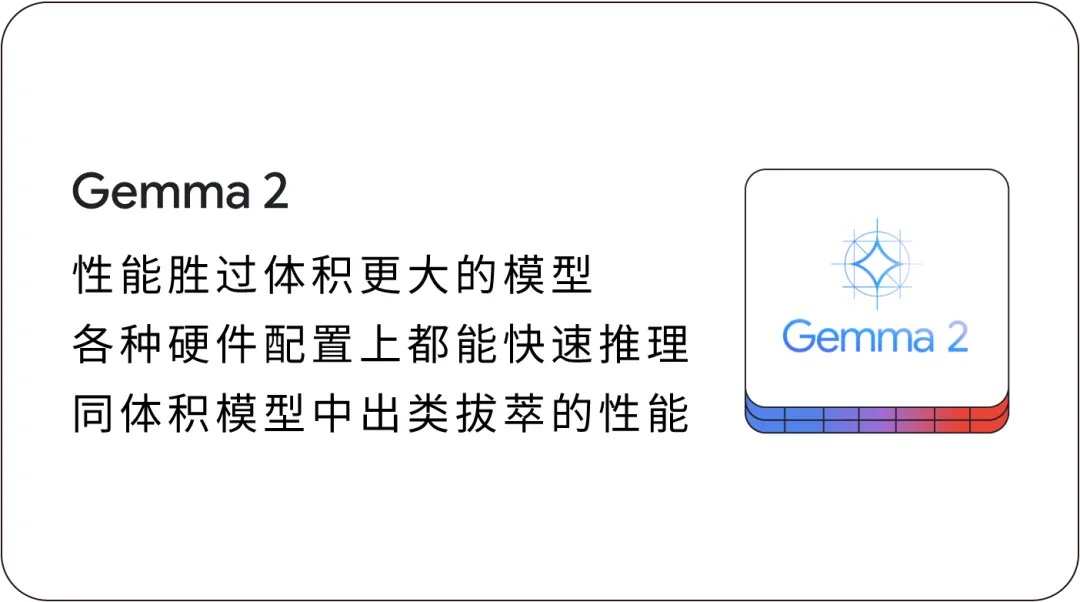

现在,Gemma 家族迎来新成员,同时新一代开放模型 Gemma 2 性能和效率将再上新台阶。

Gemma 2 不仅功能强大,其设计还确保了能够更便捷地与开发者现有工作流集成。首先是开放易用,Gemma 2 使用了适合商用的 Gemma 许可,便于开发者分享创新成果并实现商业化。

○ 广泛的框架兼容性,Gemma 2 能够无缝集成JAX、PyTorch、TensorFlow 等主流 AI 框架,并针对 NVIDIA GPU 进行了优化。

○ 轻松部署,开发者现在可以通过预建的入门 notebook,在 Vertex AI 或 GKE 上轻松部署和管理 Gemma 2。

○ 灵活微调,用户可以利用 Google Cloud 和 Ollama 等平台的工具链微调 Gemma 2 模型或进行模型推理。

PaliGemma 现在可以执行图片说明生成、短视频字幕配给、视觉问答、文本阅读以及对象检测和分割等多样化的视觉语言任务。

CodeGemma 全面兼容 Keras、Hugging Face、NVIDIA、MediaPipe、Gemma.cpp 等平台和框架,并可在Vertex AI 上使用。

RecurrentGemma 新增的 9B 变体,继承了 Gemma 系列的卓越质量,并采用一样的 API 设计。

更多详情,可以登录 ai.google.dev/gemma, 开始你的 Gemma 探索旅程!

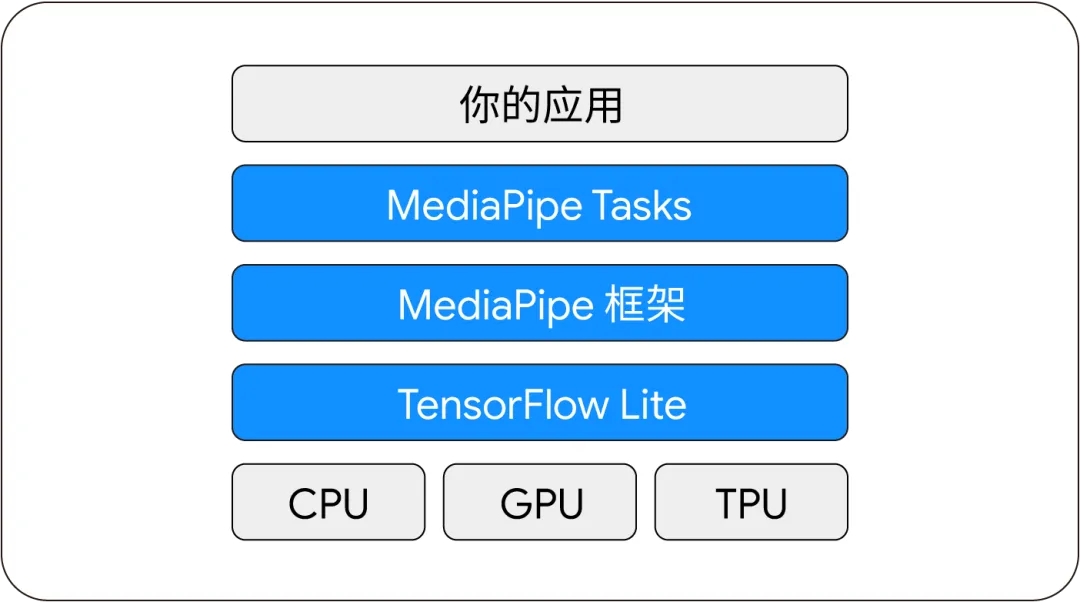

为了让开发者更好地进行创新构建,谷歌正在尝试将边缘机器学习技术和一些新工具整合到 Google AI Edge 中,帮助开发者一站式将设备端 AI 集成到面向移动设备、网站设备、嵌入式设备以及其他边缘设备的应用中。

面向端侧应用场景的端到端技术栈

○ Generative Torch API 发布,支持开发者只需几行代码,即可轻松将使用各种不同架构的模型转换至能在设备端运行。

○ 在 PyTorch 的 Beta 版中,已支持超过 70 种热门模型架构通过 TensorFlow Lite 转换器转换为现成可用的 TFLite 格式,并计划支持更多操作。

○ Model Explorer 面向所有人开放,用以帮助开发者理解、调试和优化机器学习模型。该框架能够以直观的分层格式可视化大型图表,同时也非常适合小型模型的使用。

从 Gemini API* 的强大数据处理能力到 Google AI Studio* 的集成开发环境,再到 AI 技术的跨平台应用,Google 技术正不断推动技术边界拓展,以负责任的方式使 AI 更加易于访问和使用。同时,谷歌将积极致力于在这一开放的框架下不断探索,确保 AI 技术的发展能够惠及更广泛的群体,进而推动创新。

*适用于出海开发者

2024 Google 开发者大会

专题演讲持续更新中!

扫码直达官网

观看精彩回放