1.引言

Hello,大家好!我是小米,今天要和大家聊聊一个非常有意思的算法实战问题——在2GB内存中,如何在20亿个整数中找到出现次数最多的数。这个问题涉及到大数据处理和算法优化,特别适合喜欢钻研技术的你!让我们一起来探讨一下吧!

图片

图片

2.问题描述

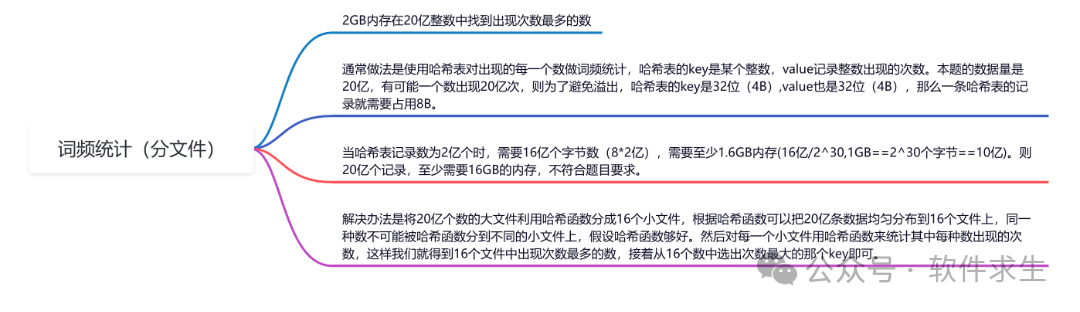

我们有一个包含20亿个整数的大文件,目标是在有限的内存(2GB)内找到出现次数最多的整数。通常情况下,我们可以使用哈希表对每个出现的数进行词频统计,哈希表的key是某个整数,value记录整数出现的次数。

假设每个整数是32位(4B),每个出现次数的记录也是32位(4B),那么一条哈希表记录需要占用8B的内存。当哈希表记录数达到2亿个时,需要16亿个字节(1.6GB)内存。而我们要处理的是20亿个记录,至少需要16GB的内存,显然不符合题目要求。

3.解决方案

为了解决这个问题,我们可以利用哈希函数将20亿个数的大文件分成16个小文件。这样,每个小文件中的数就大大减少了,且每个小文件的大小也在可控范围内。具体步骤如下:

- 数据分割:利用哈希函数将20亿个数分成16个小文件,使得每个文件的大小和数目均匀分布。

- 词频统计:对每一个小文件分别用哈希表来统计其中每个数出现的次数。

- 结果合并:从16个小文件中分别选出出现次数最多的数,再从这16个数中选出次数最大的那个数。

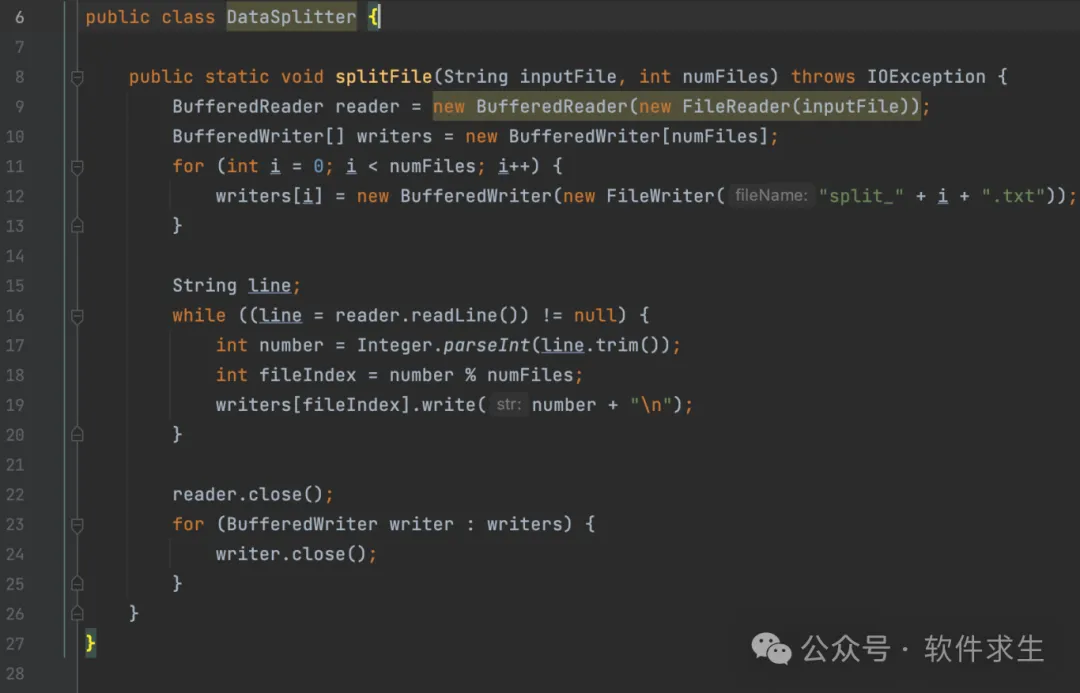

4.数据分割

首先,我们需要将大文件分割成多个小文件,用一个好的哈希函数来保证数的均匀分布。假设我们使用简单的模运算哈希函数:

图片

图片

我们将20亿个数分别读入,并根据哈希函数的值分配到不同的文件中。例如,如果num_files是16,那么我们可以创建16个文件,分别存储哈希值为0到15的数。

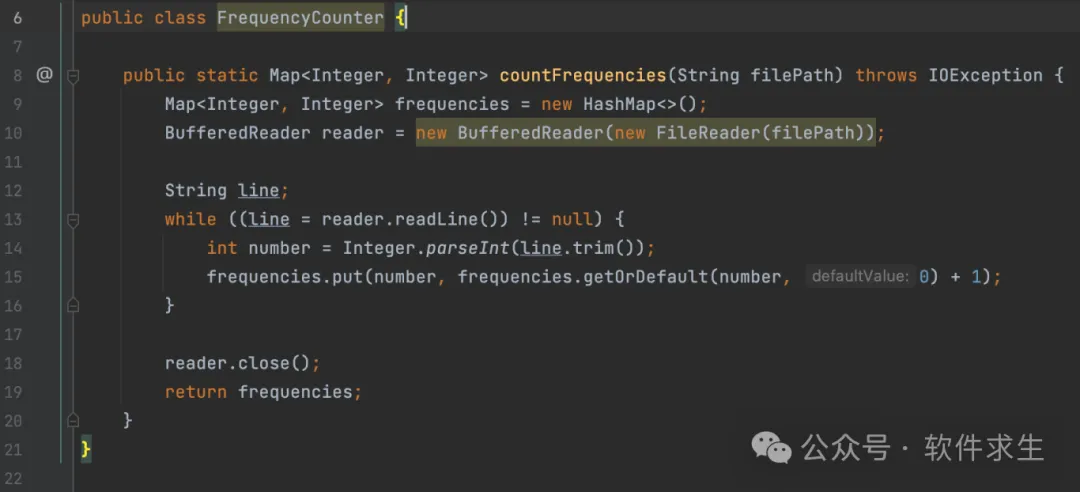

5.词频统计

接下来,对每个小文件分别进行词频统计。我们可以使用Python的字典(dict)来实现哈希表:

图片

图片

我们对每个小文件调用count_frequencies函数,得到每个数的出现次数。

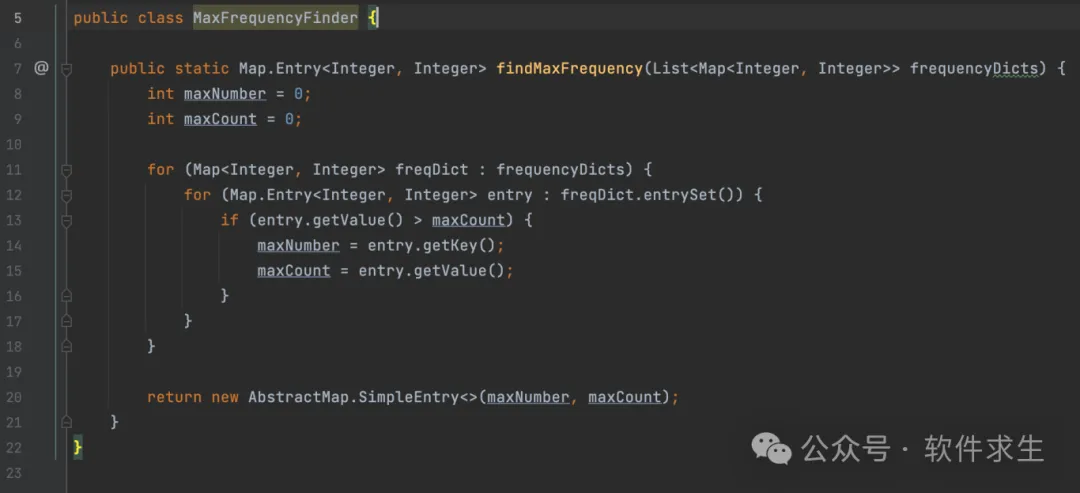

6.结果合并

最后,我们从每个小文件中选出出现次数最多的数,并将这些数进行比较,找出最终的结果:

图片

图片

将所有小文件的词频字典传入find_max_frequency函数,即可得到最终的结果。

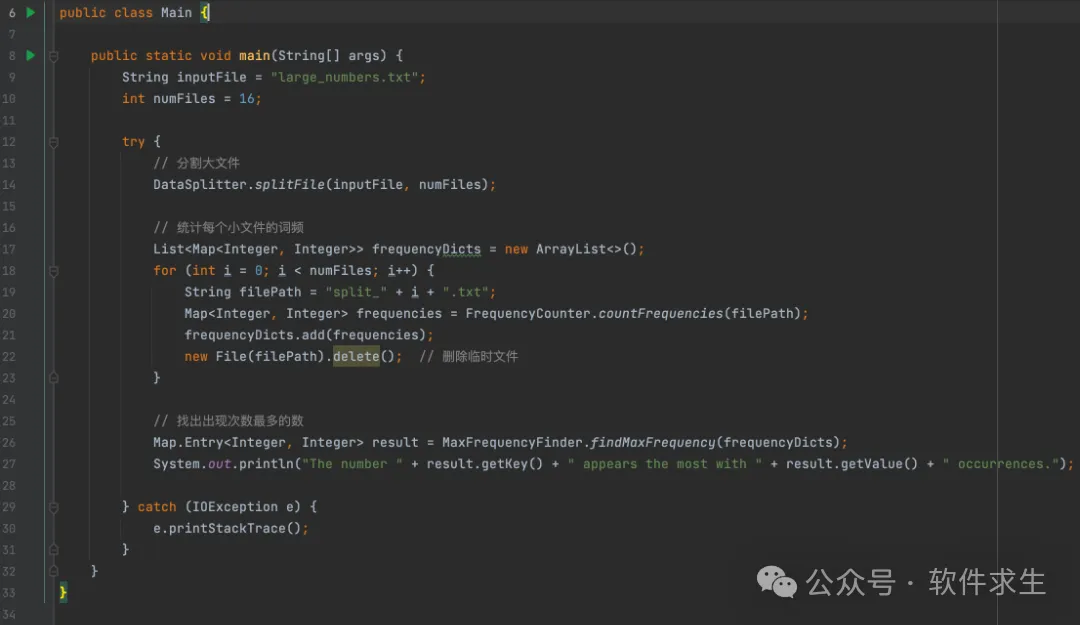

7.代码实现

我们将以上步骤整合到一起,实现整个算法流程:

图片

图片

END

通过将大文件分割成小文件,我们成功地在有限内存内解决了20亿整数中找出出现次数最多数的问题。这个方法不仅适用于整数,还可以推广到其他大数据处理场景中。希望大家通过这篇文章能够对大数据处理和算法优化有更深的理解,也欢迎大家在评论区分享你们的思考和实践经验!