编辑 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

1.未经对齐的模型很重要

审查模型的主要缺点之一是所谓的“对齐税”。这是指当模型被过度调整以符合特定的道德准则时,性能会下降。

但缺点远不只是性能,经过了几番教训后,Nidum.AI 联合创始人Arjun Reddy认为:“未经审查的模型没有任何人为的偏见,当你在LLM的基础上构建产品时,使用无偏见的模型非常重要。”(即,对齐/审查≈新的偏见)

Reddy进一步提到,由于偏见,该公司避免使用Llama,而是使用Dolphin Llama。这表明了为什么无偏见的LLM对于在LLM的基础上构建产品很重要。

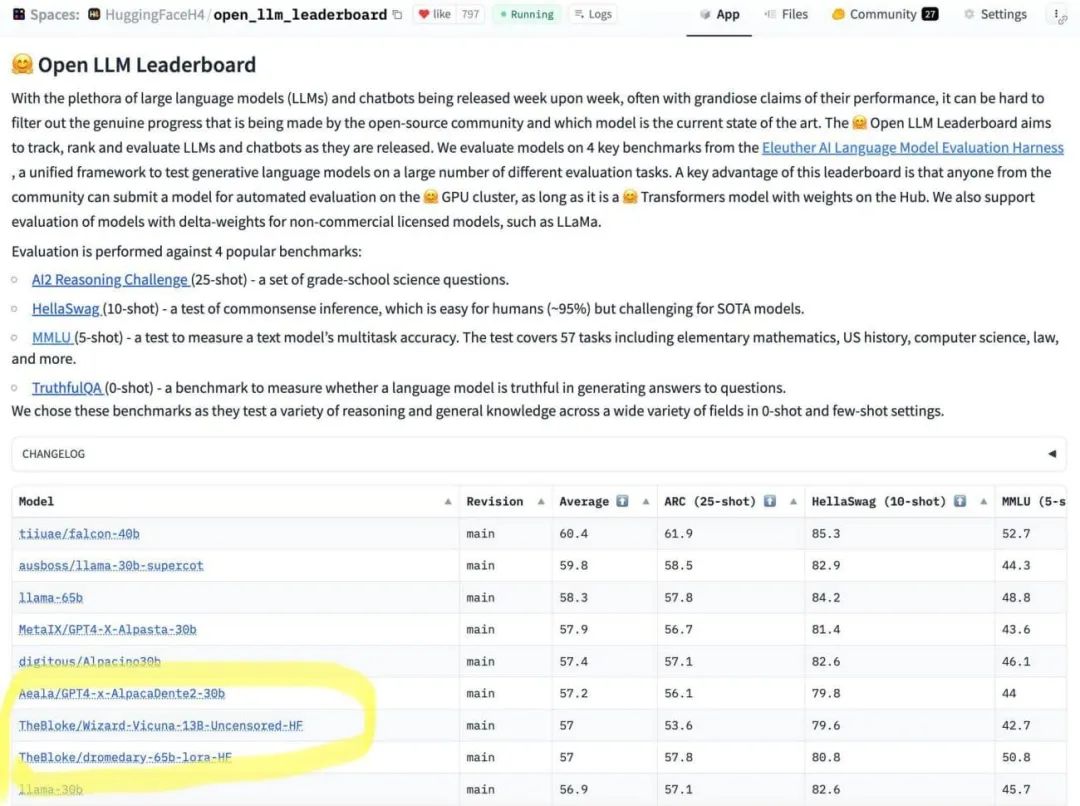

一位名为hardmaru的Reddit用户观察到,在引入额外限制后,ChatGPT的响应质量有所下降。最终,在一些测试中,未经审查的LLM比对齐的模型表现更好。

图片

图片

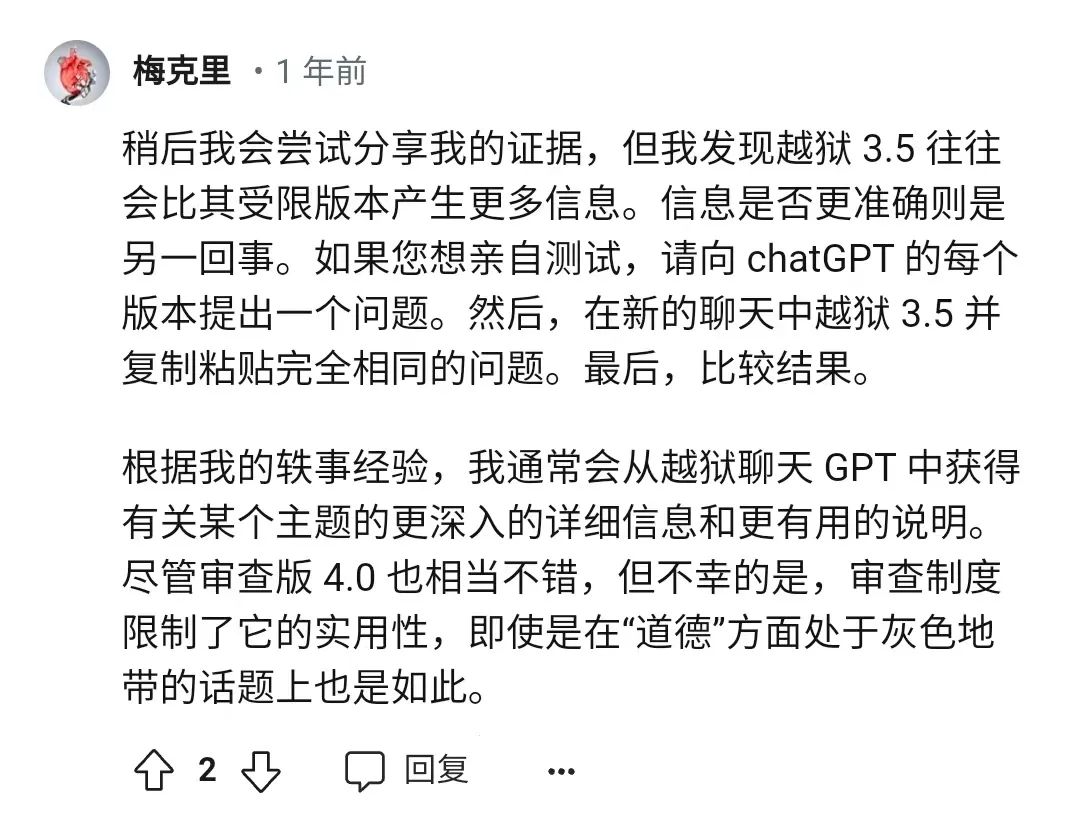

另一位在Reddit上被称为BThunderW的用户提到,越狱版的ChatGPT-3.5比受限版本产生了更多信息,这表明与对齐的模型相比,你可以从未经审查的模型中挤出多少。

图片

图片

2.你可以使用对齐的模型,但是...

当然,你可以训练一个对齐的模型(比如Meta的Llama),但使用这种被审核禁锢过、带有biasness的模型是相当困难的,最终会尝到苦头。 Reddy提到,使用无人为偏见的LLM就像使用空白画布,可以很容易地根据特定需求训练LLM。

每个主流模式都试图保持一致,对齐以促进平等。当然,促进平等并没有错,但对于LLM来说,它直接影响了产出。例如,几个月前,Gemini试图成为一个觉醒的人工智能模型,但结果大家看到了,适得其反,翻车后惨淡收场。

有偏见的人工智能系统可能会导致歧视性做法,例如基于种族或性别偏见拒绝贷款。这不仅影响个人,也破坏了人们对人工智能技术的信任。

DataRobot的一份报告强调,42%的使用人工智能的组织非常担心偏见的人工智能系统造成的声誉损害。

LLM,如OpenAI的GPT-3.5和Meta的Llama 2,是在庞大的数据集上训练的,这些数据集也反映了社会中存在的偏见。这些偏见可能以有害的方式表现出来,强化刻板印象,使歧视永久化。

例如,联合国教科文组织委托进行的一项研究发现,LLM表现出明显的性别偏见,将女性名字与“家庭”和“孩子”等传统角色联系起来。相比之下,男性名字与“职业”和“管理”有关。

3.因为纯粹,所以盛行

用户比以往任何时候都更喜欢未经审查的型号。Sakana AI的联合创始人之一David Ha在X上提到,WizardLM-13B-Uncensored已成为他最喜欢的开源模型。

如果你正在寻找一个没有任何强制“对齐”或“道德化”审查的聊天LLM,我推荐今天刚刚发布的“WizardLM-13B-Uncensored”。

整个上午都在玩它。到目前为止,这是我最喜欢的开源聊天模式。

加州大学公共卫生学院蛋白质研究中心教授Lars Juhl Jensen赞扬了X上未经审查的LLM的数据是如何未经过滤的。“要听到真相,可以问一个孩子、一个酒鬼或一个未受审查的人,”他补充道。

虽然像Reddy这样的企业家已经在利用未经审查的LLM并在社区中越来越受欢迎,但可以肯定地说,我们可能很快就会看到大规模平台上采用未受审查的LLMs。

想了解更多AIGC的内容,请访问: