Hello folks,我是 Luga,今天我们来聊一下 LLM(大型语言模型) 生态相关技术:Meta Llama 3.1,一个被称为世界上最大、最有能力、最先进的开源人工智能模型。

2024年,对于人工智能领域来说可谓意义非凡。继 OpenAI 推出备受赞誉的 GPT-4o mini后,Meta 的 Llama 3.1 模型亦在 7月23日 惊艳亮相,再一次掀起了新一轮人工智能热潮。这款全新的大型语言模型凭借其卓越的技术实力和无限的应用前景,迅速在全球范围内引发了广泛关注。

Meta Llama 3.1 的崭露头角,标志着生成式人工智能迈向了一个全新的里程碑。这款模型不仅在处理复杂语言任务上展现出了超群的表现,更在准确性、速度和可扩展性等关键指标上达到了前所未有的高度,彻底刷新了业内的认知水平。其卓越的性能源于 Meta 团队长期以来在深度学习和自然语言处理领域的不懈探索,汇聚了众多顶尖科学家和工程师的智慧结晶。

更为难能可贵的是,Meta Llama 3.1 作为一款开源模型,为全球的研究人员和开发者提供了一个宝贵的实践平台。凭借这一强大工具,科研人员可以更深入地探索人工智能的奥秘,而开发者们也将获得充分的创新空间,将人工智能的力量释放到各个应用场景中。由此可见,Meta Llama 3.1 的诞生不仅是人工智能技术的一大飞跃,更为推动整个行业的可持续发展注入了新的动力。

一、如何定义及看待 Meta Llama 3.1 ?

作为这一开创性工程的发起人,Meta 核心人物马克·扎克伯格在《开源人工智能是前进之路》一文中阐释了公司对开放式人工智能的深切期许。他强调,开源人工智能将为开发者、科技公司乃至整个社会带来诸多裨益。首先,开放的代码库为创新开辟了无限可能,允许开发者根据特定需求定制模型;其次,开源助力人工智能技术的民主化进程,有助于降低应用成本,解决数据安全隐患,避免供应商锁定;再者,透明度和社区审查将确保开源人工智能的可靠性和安全性,甚至超越封闭系统。

然而,事实上,马克·扎克伯格的开源理念不仅体现在最新力作Llama 3.1之上,更植根于 Meta 长期以来的产品战略。因此,某种意义上而言,我们不难发现,通过推广开源框架如 PyTorch、开放数据集等,Meta 一直在为人工智能生态系统的建设贡献自身的力量。

毫无疑问,Llama 3.1 的发布标志着 Meta 在开源人工智能道路上迈出了坚实的新步伐。通过开放获取强大的人工智能能力,将有助于构建一个更加多元、包容的技术生态系统,促进创新、维护公平,最终让人工智能的力量惠及全人类。

Llama 3.1 系列包括三种型号:Llama 3.1 8B、Llama 3.1 70B 和 Llama 3.1 405B。所有这三款模型现在都具备了改进的 128 K上下文长度,大大提升了其处理复杂任务的能力。此外,Meta 现已开放了使用 Llama 模型输出来改进其他模型的功能,为开发者提供了更强大的工具和灵活性。

此外,Meta 在超过 150 个基准数据集上对 Llama 3.1 系列模型进行了广泛评估。这些评估不仅涵盖了模型在各类任务中的表现,还包括通过多次人类评估,将这些模型与现实世界中的其他顶尖竞争模型进行比较。评估结果显示,Llama 3.1 405B 在性能上与当前领先的基础模型如 GPT-4、GPT-4o 和 Claude 3.5 Sonnet 具有竞争力。基于这些结果,Meta 现在自豪地声称,Llama 3.1 405B 是目前世界上最大、最有能力的公开基础模型。

不仅如此,较小的 Llama 3.1型号(8B和70B)在性能上也展示出与同类封闭式和开源模型相媲美的竞争力。无论是在处理能力还是在应用灵活性方面,Llama 3.1系 列都为开发者和研究人员提供了卓越的选择,推动了生成性人工智能的进步和发展。

二、Meta Llama 3.1 基础特性概述

众所周知,Llama 3.1 版本诞生之际,引领着人工智能领域踏上了一个全新的里程碑。这款堪称当今最先进的大型语言模型,汇聚了 Meta 团队在深度学习和自然语言处理领域多年来的卓越研究成果。其卓越的表现,不仅在一般知识储备、多语种翻译、逻辑推理等传统任务上展现出了无与伦比的实力,更突破性地在诸如合成数据生成、模型蒸馏等前沿领域拥有了广阔的创新空间。

1.模型增强

除了尖端的 405B 参数旗舰版本外,Llama 3.1 还推出了增强版的 8B 和 70B 小型模型。这些升级版本不仅支持了多种语言,更将上下文长度拓展至128K,大幅提升了长格式文本处理、多语种对话交互、代码生成辅助等高级应用场景的性能表现。可以说,这一系列型号的推出,将从根本上重塑人类与人工智能之间的交互体验。

2.开源理念承诺

除了上述的模型增强特性之外,最令人鼓舞的是,Llama 3.1 忠实地秉承了Meta一贯的开源理念。该系列模型不仅在 Meta 的开源平台上提供下载,更与 Hugging Face 等知名社区建立了合作,确保全球开发者都能公平获取这一人工智能力作。基于这一强大工具,开发者们可以自由定制,将其应用于各种场景,无论是改进其他模型,抑或在本地、云端等不同环境中部署运行,皆可尽展所长。

3.无与伦比的先进性

在一般知识储备方面,Llama 3.1 405B 展现出了人类水准的认知能力,涵盖了广博的学科知识和见解,可以随意应对各种复杂问题。更令人赞叹的是,它在逻辑推理和语境转换能力上堪称登峰造极,能够灵活地把握语义关联,合理地引申和过渡话题,彷佛拥有独立的思维能力。

此外,Llama 3.1 405B 在数学运算、工具使用等专业领域也毫不逊色,可精准地进行复杂的计算和操作,为人类解决实际问题提供了强有力的辅助。值得一提的是,它在多语种自然语言处理上更是出类拔萃,能够无缝转换不同语种,为跨语言交流提供了极大便利。

4.全面的生态支持

事实上,在 Llama 3.1 面世之初,Meta就已与超过25家顶尖科技公司达成了深度合作,共同努力将这一革命性的人工智能模型融入各种平台和环境中。在这些合作伙伴中,不乏像AWS、NVIDIA、Google Cloud 这样的科技巨头,它们均拥有业内领先的云计算和硬件加速能力,确保了Llama 3.1 可以毫无阻碍地在各种云平台上高效运行。

除了云服务商,一些专注于人工智能的创新公司也加入了 Llama 3.1 的生态阵营。他们致力于为用户提供优化的部署和管理解决方案,让这款人工智能模型能够在本地环境或边缘设备上流畅发挥效能,满足不同场景下的应用需求。

三、Meta Llama 3.1 架构解析

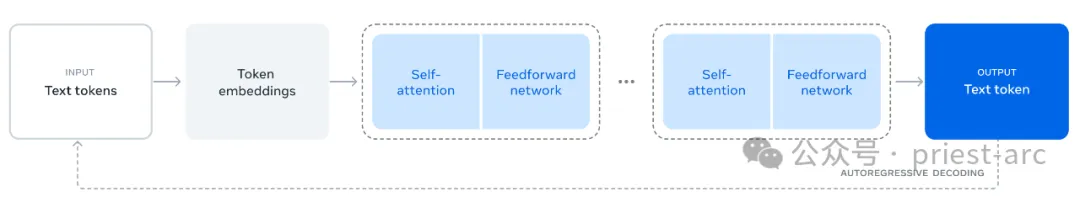

Llama 3 使用的是标准的密集 Transformer 架构(Vaswani 等,2017 年)。在模型架构方面,它与 Llama 和 Llama 2(Touvron 等,2023 年)没有显著的不同,主要来自于数据质量和多样性的改进以及训练规模的增加。

图:Llama 3.1 模型架构

相比于 Llama 3,我们确实做了一些小的修改:

- 使用了分组查询注意力机制(GQA;Ainslie 等,2023),并配备了8个键值头,以提高推理速度并减少解码期间键值缓存的大小。

- 采用了一种注意力掩码,防止同一序列中不同文档之间的自注意力。在标准预训练期间,这一变化的影响有限,但在非常长的序列上进行持续预训练时,这一改动显得尤为重要。

- 使用了包含 128K 词汇的词表。该词汇表结合了来自 tiktoken3 分词器的 100K 词汇和额外的 28K 词汇,以更好地支持非英语语言。与 Llama 2 的分词器相比,新分词器在一部分英语数据上的压缩率从3.17个字符每词提升到3.94个字符每词。这使得模型在相同的训练计算量下可以“阅读”更多的文本。我们还发现,增加28K的非英语词汇不仅改善了压缩率,还提升了下游任务的性能,同时对英语分词没有影响。

- 将RoPE基频超参数增加到 500,000。这使我们能够更好地支持更长的上下文长度;Xiong等(2023)显示这一数值在支持长达32,768的上下文长度时非常有效。

基于上述所述,Llama 3 405B 采用了126层的架构,具有16,384的词元表示维度和128个注意力头;具体细节请参见表3。这使得模型的规模大约符合我们的数据和训练预算(3.8 × 10^25 FLOPs)下的计算最优缩放法则。

在架构设计中,针对 Llama 3.1 训练方法,Llama 3.1 系列模型引以为傲的是其卓越的多语种支持能力。通过集成128K超大规模的令牌词汇表,不仅涵盖了主流语种,还囊括了众多小语种,可以轻松驾驭包括英语、汉语、西班牙语、阿拉伯语在内的数十种语言。这种语言上的广度覆盖,使得Llama 3.1孕育出了强大的跨语言理解和生成能力,为构建多语种人工智能代理奠定了坚实基础。

图:Llama 3.1 模型家族

Llama 3.1 的训练过程可谓是一个层层递进、循序渐进的严格流程,着眼于最终将其塑造成一款真正意义上的通用人工智能助手。整个过程大致可分为两个主要阶段:预训练和训练后调优。

预训练阶段是奠基之作。在这一阶段,Meta 团队将大规模的多语种文本语料库转化为离散化的标记,并以经典的语言模型任务——下一个标记预测为目标,对大型语言模型(LLM)进行预训练。通过这一过程,模型不仅掌握了语言的内在结构和规律,更从海量文本中汲取了丰富的世界知识。

值得一提的是,Llama 3.1 预训练的规模之大前所未有。据悉,在论文中 Meta 透露,他们在 15.6 万亿个标记的语料库上,采用了上下文窗口为 8K 标记的方式,对拥有405B参数的大模型展开了预训练。如此庞大的预训练规模,确保了模型对知识的广博吸纳。

预训练之后,还有一个持续预训练的环节,将支持的上下文窗口拓展至 128K 标记。这一重要优化不仅提升了模型处理长文本的能力,更为未来在文献挖掘、知识总结等场景下的应用奠定了基础。

而真正将 Llama 3.1 的潜力无限释放的,则是训练后调优的这一决定性阶段。在这里,预训练的语言模型虽已能理解文本内容,但尚未获得指令理解和意图把握的能力。因此,Meta 采取了分阶段的方式,通过数轮人工反馈,使模型逐步对齐指令调优数据,完成了直接偏好优化(DPO)。

在这一环节,Meta 还融入了诸如工具使用等创新功能,并专注优化了编码、推理等复杂任务的能力。可以说,训练后调优阶段是让 Llama 3.1从一个被动的知识贮存者,蜕变成为一个主动的任务执行者的关键所在。

此外,出于对模型安全性和伦理性的高度重视,Meta 在训练后调优阶段还融入了一系列安全缓解措施,努力促使 Llama 3.1 在提供强大功能的同时,也能秉持正确的价值观和原则,真正造福人类。

Reference :

- [1] https://llama.meta.com/

- [2] https://about.fb.com/news/2024/07/open-source-ai-is-the-path-forward/