1 概括

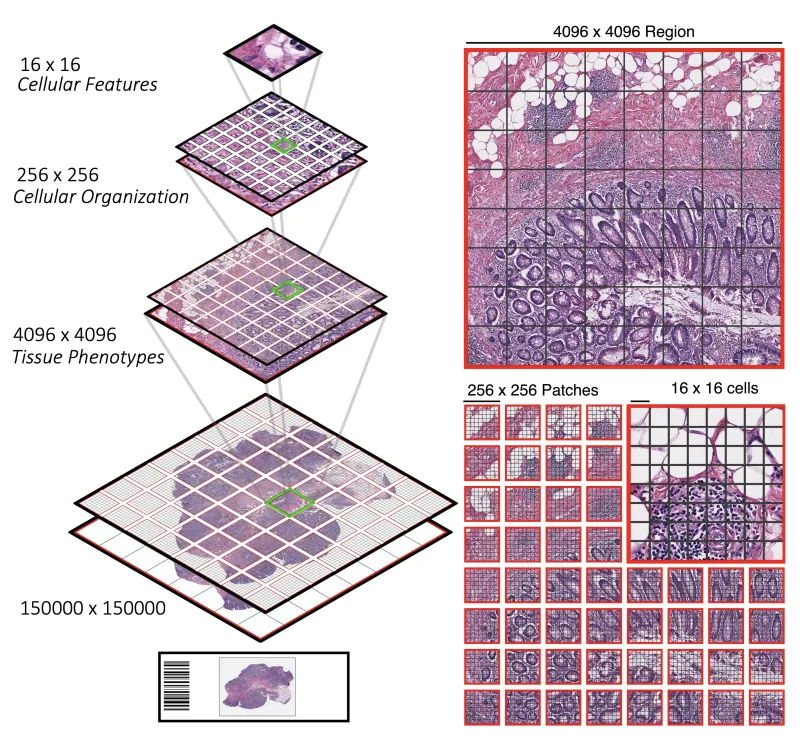

对于计算病理学中的千兆像素全玻片成像 (WSI),WSI在20倍放大倍率下可大至150000×150000像素,并在不同分辨率下呈现视觉标记的层次结构:从捕获单个细胞的16×16图像到4096×4096图像表征组织微环境内的相互作用。

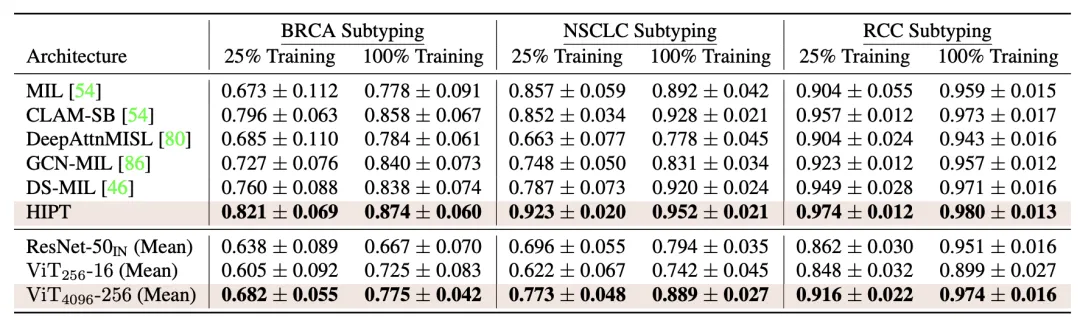

研究者引入了一种新的ViT架构,称为分层图像金字塔变换器 (HIPT),它利用WSI中固有的自然分层结构,使用两个级别的自监督学习来学习高分辨率图像表示。HIPT使用10,678千兆像素WSI、408,218 4096×4096图像和104M 256×256图像对33种癌症类型进行了预训练。在9个幻灯片级任务上对HIPT表示进行基准测试,并证明:

1) 具有分层预训练的HIPT优于当前最先进的癌症分型和生存预测方法;

2) 自监督ViT能够对重要的归纳建模关于肿瘤微环境中表型的层次结构的偏见。

2 主要框架

整张幻灯片图像(WSI)的层次结构。左边:与自然图像不同,由于WSI具有固定的比例,因此存在不同图像分辨率的视觉标记的层次结构。右边:除了将单个256×256图像表示为256 [16×16]标记的序列外,还可以将这些256×256图像视为4096中更大的、不相交的[256×256]标记序列的一部分4096×4096区域。

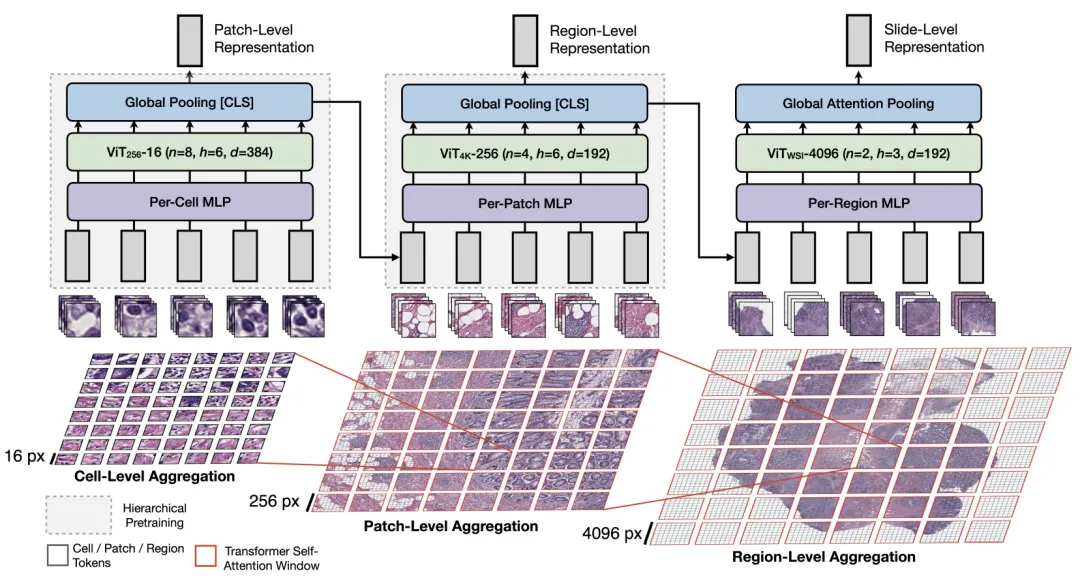

HIPT 架构

受在自然语言处理中使用分层表示的启发,其中嵌入可以在字符、单词、句子和段落级别聚合以形成文档表示,在x16单元格、x256补丁、x4096区域级以形成幻灯片表示。为了在每个阶段对视觉概念之间的重要依赖关系进行建模,将Transformer自注意力调整为置换等变聚合层。请注意,由于使用x256标记修补x4096区域的复杂性与使用x16标记修补x256图像的复杂性相同,可以使用类似的自监督ViT技术为低分辨率图像预训练高分辨率图像的聚合层。

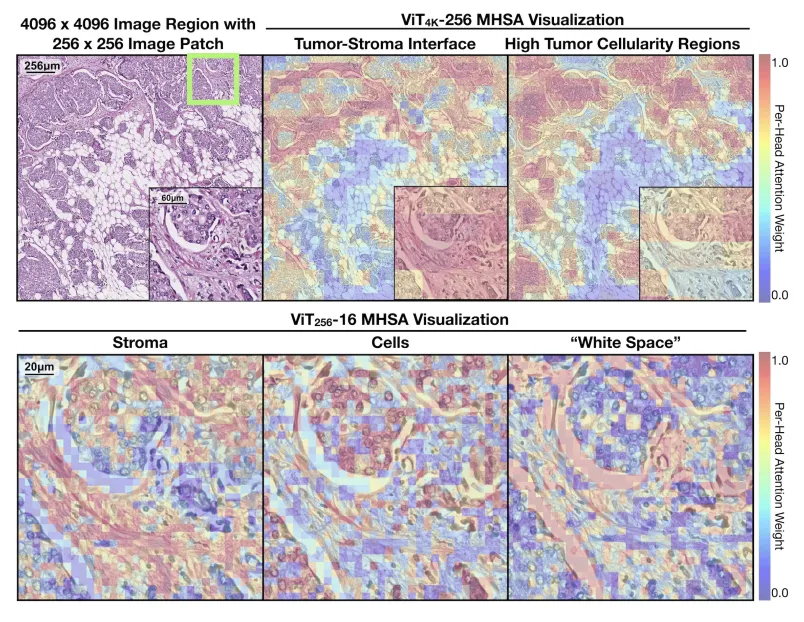

Multi-Head Self-Attention Visualization of SelfSupervised ViTs

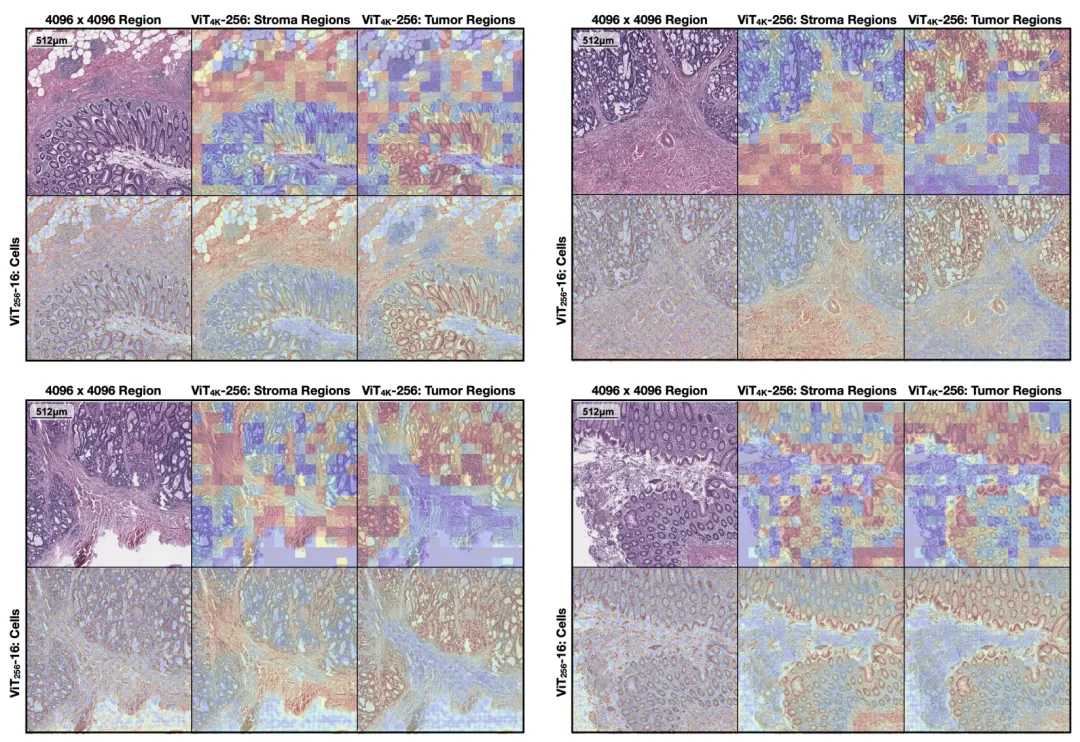

对于浸润性导管癌(IDC),展示了ViT256-16和ViT4096-256的自监督可视化,分别在x256和x4096区域上进行了预训练。对于x256补丁,ViT256-16能够描绘x16 tokens中的基质、细胞和“空白”存在。对于x4096区域,ViT4096-256描绘了粗粒度的形态特征,例如肿瘤巢及其周围的促纤维增生(松散)基质。

3 实验

HIPT中的Hierarchical Attention Maps

ViT256-16 DINO Pretraining

Hierarchical Attention Maps for Colorectal Cancer (CRC)