两个月又两周过去了,我们仍然没有见到公开发布版的OpenAI《Her》。

5月14日,OpenAI发布GPT-4o和端到端实时音视频对话模式,现场演示AI对话丝滑如人类。

它能感受到你的呼吸节奏,也能用比以前更丰富的语气实时回复,甚至可以做到随时打断AI,效果非常惊艳。

可万众期待中,不时有推迟的消息传出。

是什么拖住了OpenAI的后腿?根据已知情报:

有法律纠纷,要确保语音音色不会再出现与“寡姐”斯佳丽·约翰逊这样的争议。

也有安全问题,需要做好对齐,以及实时音视频对话开启新的使用场景,被当成诈骗工具也会是其中之一。

……

不过,除了以上这些,还有什么技术问题和困难需要克服吗?

渡过最初的热闹后,内行们开始看门道了。

眼尖的网友可能已经注意到,发布会现场演示手机可是插着网线的。

在业内人士眼中,GPT-4o发布会演示效果如此丝滑,还是有几大限制:

需要“固定网络、固定设备、固定物理环境”。

真的公开发布后,全球用户能否获得与发布会相比不打折扣的体验,也还是个未知数。

发布会现场还有一个有趣的细节,帅气的研究员小哥Barret Zoph,在演示视频通话时被ChatGPT当成桌子。

视频通话部分的延迟可见一斑了,语音部分提问已经处理完了,视觉部分还在处理上一个镜头,也就是手机刚被拿起来时摄像头拍到的木桌。

试想最终发布后,很多人用它的场景是什么?

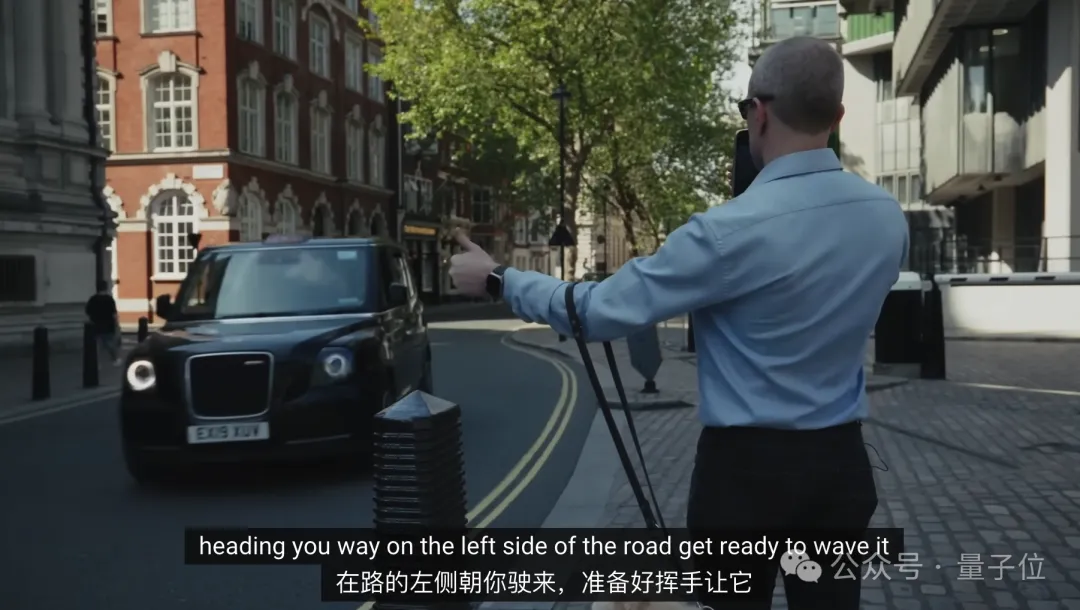

宣传片中一个最为人津津乐道的案例,盲人在AI语音的帮助下招手打车,一时间被网友津津乐道。

不过也要注意到,这会是一个非常依赖低延迟特性的场景,如果AI指导来的稍慢一点,出租车也就开过去了。

室外场景网络信号都不一定能保证稳定,更别提机场火车站、旅游景点这些人多设备多挤占带宽的场景,难度还要增加不少。

此外,室外场景还会出现噪音的问题。

大模型本来就深受“幻觉”问题困扰,如果噪音影响到用户语音的识别,出现一些与指令不相关的词语,那回答就不知道拐到哪去了。

最后,还有一个容易被忽视的问题,多设备适配。

可以看出目前OpenAI发布会和宣传片,清一色用的新款iPhone Pro。

否能在较低端的机型也获得一致体验,也要等正式发布后再揭晓了。

OpenAI宣传GPT-4o可以在短至232毫秒、平均320毫秒的时间内响应音频输入,与人类在对话中的反应速度一致。

但这只是大模型从输入到输出的时间,并非整个系统。

总而言之,仅仅把AI能做好,还搞不出《Her》一般丝滑的体验,还需要低延时、多设备适配、应对多种网络条件和嘈杂环境等一系列能力。

光靠AI,还做不出《Her》

要做到低延时、多设备适配等,靠的就是RTC(实时通信,Real-Time Communications)技术了。

在AI时代之前,RTC技术已广泛用于直播、视频会议等场景,发展的较为成熟。

在RTC视角下,用户的语音提示词在输入大模型之前,还要经历一整套复杂流程。

信号采集与预处理:在手机等端侧设备,将用户的语音采集成原始信号,并对其进行降噪、消除回声等处理,为后续识别做好准备。

语音编码与压缩:为尽量节省传输带宽,要对语音信号进行编码和压缩。同时,还要根据网络实际情况自适应地加入一些冗余和纠错机制,以抵抗网络丢包。

网络传输:压缩后的语音数据被切分成一个个数据包,通过互联网送往云端。如果距离服务器物理距离较远,传输往往还要经过多个节点,每一跳都可能引入延迟和丢包。

语音解码与还原:数据包到达服务器后,系统对其进行解码,还原出原始的语音信号。

最后才轮到AI出手,先通过Embedding模型将语音信号转化为tokens,才能真正让端到端多模态大模型能够理解并生成回复。

当然,大模型生成回复后还要走一套相反的流程,再把回复的音频信号最终传回给用户。

整个一套流程走下来,每一个环节都需要极致的优化,才能真正把AI音视频对话做到实时。

其中对大模型本身的压缩、量化等手段毕竟会影响AI能力,结合音频信号处理、网络丢包等因素联合优化,就显得尤为重要了。

据了解,OpenAI也并不是独立解决这个问题的,而是选择与第三合作。

合作伙伴为开源RTC厂商LiveKit,目前凭借支持ChatGPT语音模式成为业界关注焦点。

除OpenAI之外,LiveKit与Character.ai、ElevenLabs等相关AI公司也都展开了合作。

可能除了谷歌等少数有较为成熟的自研RTC技术的巨头之外,与术业有专攻的RTC厂商合作,是AI实时音视频对话玩家目前的主流选择。

这一波当然也少不了国内玩家参与,不少国内AI公司已经在加紧研发端到端多模态大模型以及AI实时音视频对话应用。

国内AI应用能不能赶上OpenAI的效果,大家又什么时候能真正亲自上手体验到呢?

由于这些项目基本都在早期阶段,公开透露的消息并不多,不过他们的RTC合作伙伴声网倒成了一个突破口。

量子位从声网处打听到,以目前国内的技术水平,已经能把一轮对话的延迟压到1秒左右,再辅以更多优化技巧,实现能及时响应的流畅对话已不成问题。

做好RTC,AI不只是《Her》

声网是谁?

RTC行业代表性企业,2020年成为全球实时互动云服务第一股,

声网上一次出圈,是因为对红极一时的音频社交应用Clubhouse提供技术支持。

实际上,B站、小米、小红书等许多大家耳熟能详的应用都选择声网的RTC解决方案,海外业务这几年也发展迅速。

那么对于,AI实时音视频对话应用,具体该怎么解决低延迟、多设备适配这些难点,又能做到什么效果呢?

我们请到了声网首席科学家、CTO钟声来回答这个问题。

据钟声介绍,不计算大模型推理,光说信号在网络线路上一来一回的时间,已经可以做到到70-300毫秒。

具体来说,主要从三个方面入手优化。

首先,声网在全球建设了200多个数据中心,建立连接时选址也都是选在离终端用户最近的地方。

结合上智能路由技术,就可以在当某条线路拥堵,系统可自动选择其它延迟和带宽更优的路径,确保通信质量。

如果不涉及跨区域传输,就可以端到端低于100ms。如果包含跨区域,比如从中国到美国,更偏向200-300ms。

第二,成立于2014年的声网,正在根据多年来积累的海量真实场景数据,通过数据挖掘分析出各种弱网场景,然后在实验室中进行复现。这为优化传输算法提供了”靶场”,使之能应对复杂多变的网络环境;也可以在实时传输过程中出现对应的弱网模式时及时做出传输策略的调整使得传输更顺利进行。

第三,声网针对垂直行业、特定任务,也在尝试定制参数量更小的模型,压缩大模型自身的响应时间。特定大小的大语言模型和语音模型的极限能力是值得探索的方向,这对优化对话式AI或者chatbot的性价比以及低延时体验很关键。

最后,声网开发的RTC SDK也针对不同的终端设备进行适配与优化,尤其针对一些低端机型,可以做到低功耗、低内存占用、极小包体等。尤其是设备端的基于AI算法的语音降噪、回声消除、视频质量提升的能力,可以直接影响AI chatbot的适用范围和效果。

钟声还介绍到,在他们探索RTC与大模型技术的结合过程中,RTC技术本身的范畴也在变化。

他举了自己的一些思考方向,比如可以从传输音频信号改成传输大模型可以直接理解的tokens,甚至可以把语音转文字(STT)和情绪识别在端上实现,这样可以仅传送文字及相关情绪参数。

这样一来,就可以把更多信号处理流程放在端侧,把算力需求较小的Embbeding模型放在离用户更近的地方,减少整个流程的带宽需求和云端模型的成本了。

从这一点出发,钟声认为最后AI与RTC技术结合的形态,会走向端云结合。

也就是不能完全依赖云端的大模型,无论是从成本、能耗、延迟的体验,这都不是最好的选择。

在端云结合观点下,整个基础设施相应的都需要变化,算力不仅在云端,手机的算力也会被用上。边缘端的传输节点也会分布算力,数据传输协议也会相应变化……

目前,声网与大模型应用厂商已摸索出三种合作模式,也就是整个系统中,大模型、RTC与云服务器三个部分的不同供应方式:

- 私有化部署:声网只提供RTC SDK,与大模型一起部署在合作伙伴自己的数据中心,适合有自研大模型或大模型推理基础设施的公司选择。

- 声网云平台:声网提供RTC SDK和云服务器资源,开发者可根据需求灵活选择模型、部署位置与计算资源。无需自建基础架构,快速构建AI语音应用。

- 声网端到端解决方案:声网提供自研大模型、RTC SDK与云服务器资源。可为细分行业如教育、电商、社交娱乐、客服等定制垂类模型,并与RTC能力深度整合,提供一体化的语音交互解决方案。

而且已有合作项目中,跑得快的应用离与大家见面的时间不远了。

在与声网的交流中,量子位发现还有一个值得关注的新趋势:

国内AI应用,形态上逐渐在超越AI助手问答与AI情感陪伴的范畴。

就拿社交娱乐、电商直播以及在线教育这些行业来说,大家最关注的就是网红主播和名师。AI实时音视频对话驱动的数字人,就可以成为他们的“数字分身”,进一步和每个粉丝或学生进行一对一的交流互动。同时用户本身的时间和精力也有限,分身乏术,对自身的AI分身也有需求。随着技术的发展、AI分身技术体验的提升、成本的下降,他们的应用范围会日益扩大。

拿钟声的话来说“人终极最稀缺的东西就是时间”:

我们肯定都有这种体会,如果说两个会议冲突了,只能参加一个怎么办?

可能自己参加一个,派AI助手去参加另一个活动,把精彩的信息带回来。以后甚至这个助手可以是自己的AI分身,在活动过程中可以做个性化的交流,按自己的兴趣和关注点提问或回答各种各样的问题,与其他人或者其他人的分身互动。

所以说,AI实时音视频对话能做的,还远不止是《Her》。