随着“大语言模型”技术不断深化到应用层,在全球多地形成了开发定制化生成式人工智能的热潮。

无论是从国家层面:法国将人工智能技术与国家的工业和数字主权挂钩;印度下定了“必须要有自己的主权人工智能”的决心;日本以举国之力押注主权AI......

还是从行业层面:金融行业利用AI提升交易算法的速度与精度,优化风险管理;医疗行业,利用AI精准诊断和个性化治疗,提高患者护理的质量;制造业,通过AI赋能的生产流程,降低成本,提升效率;零售业,基于AI进行客户行为分析,增强个性化推荐和服务,提升顾客满意度......

越来越多组织甚至国家期待依赖定制化的AI解决方案来提高其核心能力的智能化水平。这种转变不仅加速了AI技术的实际应用,还将推动全球AI技术的发展和创新,尤其是在有效整合人工智能以解决特定行业问题方面。

试想,如果有这样一个模型,它不仅支持最尖端的工具、资源以及强大基础设施,还能让你根据自有数据自行设计和定制,那将会是怎样的情景?

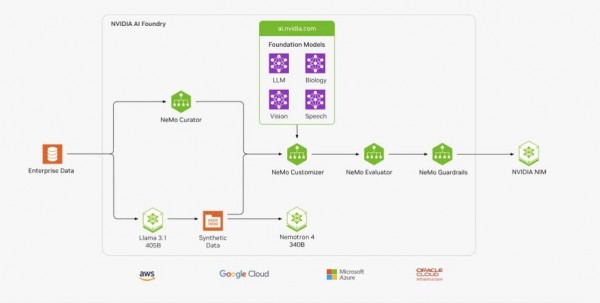

NVIDIA“AI 代工厂” 帮助用户定制“超级模型”

如今,业界期待已久的“超级模型”已经变为现实。NVIDIA 宣布推出全新 NVIDIA AI Foundry 服务和 NVIDIA NIM™ 推理微服务,与同样刚推出的 Llama 3.1 系列开源模型一起,为全球企业的生成式 AI 提供强力支持。

老黄(NVIDIA 创始人兼首席执行官黄仁勋)强调说:“NVIDIA AI Foundry 已经在整个过程中集成了 Llama 3.1,并能够帮助企业构建和部署自定义 Llama 超级模型。借助 NVIDIA AI Foundry,可以使用自有数据以及由 Llama 3.1 405B 和 NVIDIA Nemotron™ Reward 模型生成的合成数据,来训练这些“超级模型”。

具体而言,基于 NVIDIA DGX™ Cloud AI平台驱动的NVIDIA AI Foundry,由 NVIDIA与全球领先的公有云提供商共同设计,专门为满足企业不断变化的AI计算需求而打造。

来源:NVIDIA

NVIDIA AI Foundry提供的计算资源不仅可以根据需求灵活扩展,为企业带来前所未有的便利,还可使用企业数据以及合成生成的数据来增强和更改预训练基础模型中包含的一般知识。

一旦模型经过定制、评估并具有护栏,就会输出NVIDIA NIM 推理微服务(推理微服务,包括定制模型、优化引擎和标准 API,支持不同环境的部署),开发人员只需几行代码便可使用NIM 的标准API来构建由人工智能驱动的生成应用程序,同时还能利用NIM 容器无缝集成 Kubernetes(K8s)生态系统,高效地协调和管理容器化人工智能应用。而从部署中的应用程序中获得的知识可以反馈到 AI Foundry中,以进一步改进自定义模型。

来源:NVIDIA

而Llama 3.1 多语种大语言模型(LLM)集合则是一个具有 8B、70B 和 405B 三种参数规模的生成式 AI 模型集合。该集合中的模型在超过 16,000 个NVIDIA Tensor Core GPU上训练而成,并针对 NVIDIA 加速计算和软件(无论是在数据中心、云以及配备 NVIDIA RTX™ GPU 的本地工作站或配备 GeForce RTX GPU 的 PC 上)进行了优化。

值得注意的是,NIM 微服务也是将 Llama 3.1 模型部署到生产中的最快途径。Meta 创始人兼首席执行官马克·扎克伯格表示:“全新的 Llama 3.1 模型是开源 AI迈出极其重要的一步。借助 NVIDIA AI Foundry,企业可以轻松创建和定制大家想要的最先进的 AI 服务,并通过 NVIDIA NIM 进行部署。”

测试数据显示,直接部署Llama 3.1 模型的吞吐量,最多可比不使用 NIM 运行推理时高出 2.5 倍。

为应对企业组织需要更多训练数据创建特定领域模型的需求,NVIDIA 和 Meta 支持可以在创建自定义的同时使用 Llama 3.1 405B 和 Nemotron-4 340B 生成合成数据,以提高模型的准确性。对于拥有自己的训练数据的用户可以使用 NVIDIA NeMo 对 Llama 3.1 模型进行自定义,通过领域自适应预训练(DAPT)进一步提高模型的准确性。

面向AI PC及AI基础设施轻量化的蓝海,NVIDIA 和 Meta为帮助企业能够在AI 工作站、笔记本电脑等加速基础设施上运行由 Llama 驱动的 AI 应用,更是提供了提炼方法,供开发者为生成式 AI 应用创建更小的自定义 Llama 3.1 模型。

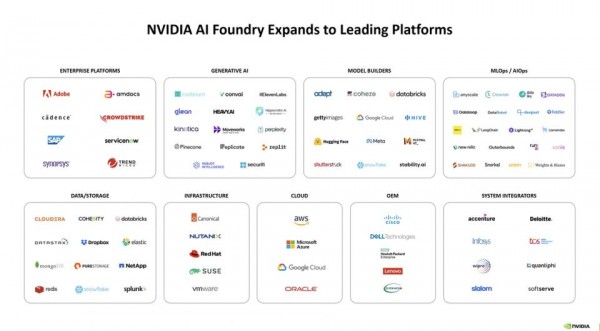

“NVIDIA +Llama” 强化行业“AI 实力”

现在,医疗、能源、金融服务、零售、交通、电信等行业的企业已在使用适用于 Llama 的 NVIDIA NIM 微服务。同时,数百家提供企业、数据和基础设施平台的 NVIDIA NIM 合作伙伴现在能够将这些新的微服务集成到其 AI 解决方案中,从而为 NVIDIA 社区 500 多万开发者和 1.9 万家初创公司的生成式 AI 提供超强助力。

来源:NVIDIA

全球专业服务巨头埃森哲更是先行一步,率先借助 NVIDIA AI Foundry 引入了一股创新的新风潮!不仅为自己定制了 Llama 3.1 模型,还利用自家的 Accenture AI Refinery™ 框架,为那些渴望反映其独特文化、语言和行业需求的客户提供了同样的服务。

埃森哲的董事长兼CEO Julie Sweet 分享说:“全球领军企业看到了生成式 AI 正在如何深入改变各行各业,并且希望部署由自定义模型驱动的应用。埃森哲的内部 AI 应用一直在使用 NVIDIA NIM 推理微服务。现在,借助 NVIDIA AI Foundry,我们能够帮助客户快速创建和部署自定义 Llama 3.1 模型,为他们的优先业务事项提供变革性的 AI 应用。”

对于行业企业而言,NVIDIA AI Foundry 提供的不仅仅是一种服务,而是一条快速打造定制超级模型的捷径。这个全方位服务结合了 NVIDIA 的尖端软件、健壮的基础设施和深厚的专业知识,并且融合了 NVIDIA AI 生态系统中的丰富资源与开放社区的模型和技术。

通过 NVIDIA AI Foundry,企业可以轻松使用 Llama 3.1 模型和 NVIDIA NeMo 平台(包括在 Hugging Face RewardBench 排名首位的 NVIDIA Nemotron-4 340B Reward 模型)来塑造自己的定制解决方案。

定制模型就位后,企业便能够构建基于 NVIDIA NIM 推理微服务的应用,这些服务可以在他们选择的云平台上运行,支持全球服务器制造商提供的 NVIDIA 认证系统™,并与顶级的机器学习运维(MLOps)和人工智能运维(AIOps)平台无缝对接。

NVIDIA也承诺,NVIDIA AI Enterprise 的专家团队与全球的系统集成商合作伙伴一起,帮助 AI Foundry 的客户加速从开发到部署的整个过程,使得企业可以更快速地实现 AI 驱动的业务变革。

写在最后

不难看出,NVIDIA AI Foundry 代表企业AI服务向“即服务”模式转变的趋势。通过此平台,企业能快速定制和部署AI解决方案,满足特定业务需求。此外,与全球系统集成商的合作也加速了从开发到部署的过程,帮助企业实现AI驱动的业务变革。

同时,对于 Llama 3.1 模型而言,这款开源模型在NVIDIA的支持下,正迈出通向开源通用人工智能的下一步!”目前,Meta已经在研发Llama 4,相信在NVIDIA的支持下,“开源的胜利”未来可期!

现在,Llama 3.1 NIM 和 NeMo Retriever NIM 微服务的生产支持可以通过 NVIDIA AI Enterprise 获得。NVIDIA 开发者计划也声称,将很快为会员提供免费访问 NIM 微服务,并支持在他们首选的基础设施上进行研究、开发和测试。