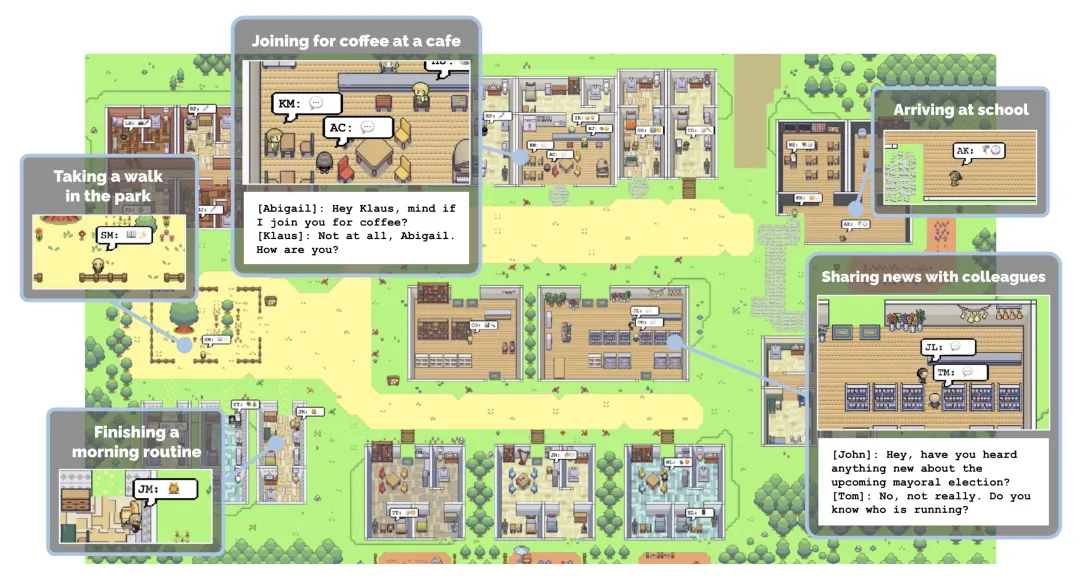

还记得斯坦福的 AI 小镇吗?这是斯坦福的 AI 研究者打造的一个虚拟环境。在这个小镇上,25 个 AI 智能体正常生活、工作、社交,甚至谈恋爱,每个智能体都有自己的个性和背景故事。智能体的行为和记忆通过大语言模型来驱动,这些模型能够存储和检索智能体的经历,并根据这些记忆来规划行动。(参见《斯坦福的「虚拟小镇」开源了:25 个 AI 智能体照进《西部世界》》)

与之类似,最近,来自上海人工智能实验室 OpenRobotLab 等机构的一批研究者也打造了一个虚拟小镇。不过,生活在其中的是机器人和 NPC。

这个小镇包含 10 万个交互式场景和 89 种不同的场景类别,是首个专为各种机器人设计的模拟互动 3D 社会。

作者表示,他们设计这个环境是为了解决具身智能领域的数据稀缺问题。众所周知,由于收集真实世界数据的成本过高,在具身智能领域探索 scaling law 一直困难重重。因此,从仿真到真实(Sim2Real)的范式成了扩展具身模型学习的关键一步。

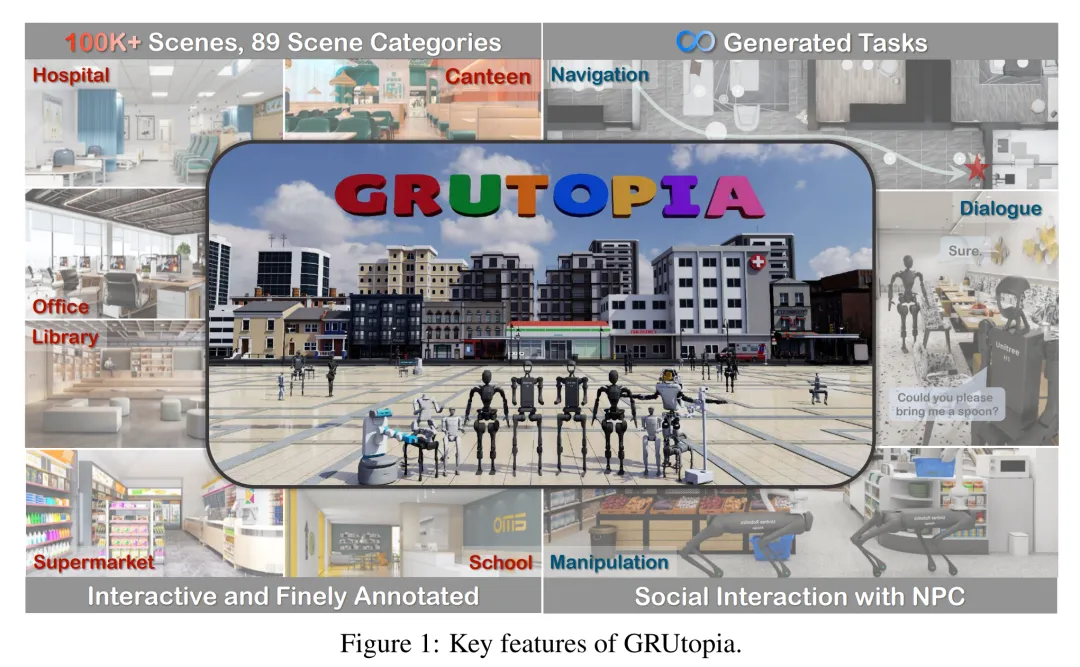

他们为机器人设计的这个虚拟环境名叫 GRUtopia,项目主要包括:

1、场景数据集 GRScenes。包含 10 万个交互式、精细注释的场景,可自由组合成城市规模的环境。与以往主要关注家庭的工作不同,GRScenes 涵盖了 89 种不同的场景类别,弥补了服务型环境的空白(一般机器人最初会部署在服务型环境中)。

2、GRResidents。这是一个大型语言模型(LLM)驱动的非玩家角色(NPC)系统,负责社交互动、任务生成和任务分配,从而模拟具身 AI 应用的社交场景。

3、基准 GRBench。支持各种机器人,但侧重于作为主要智能体的有腿机器人,并提出了涉及物体定位导航、社交定位导航和定位操纵的中等难度任务。

作者希望这项工作能缓解该领域高质量数据稀缺的问题,并为具身 AI 研究提供更全面的评估。

- 论文标题:GRUtopia: Dream General Robots in a City at Scale

- 论文地址:https://arxiv.org/pdf/2407.10943

- 项目地址:https://github.com/OpenRobotLab/GRUtopia

GRScenes:大规模的完全互动环境

要建立一个用于训练和评估具身智能体的平台,具有不同场景和物体资产的完全交互式环境是必不可少的。因此,作者收集了一个包含各种物体资产的大规模 3D 合成场景数据集,作为 GRUtopia 平台的基础。

多样、逼真的场景

由于开源 3D 场景数据的数量和类别有限,作者首先从设计师网站上收集了约 10 万个高质量的合成场景,从而获得多样化的场景原型。然后,他们对这些场景原型进行清理,并对其进行区域和物体级别的语义注释,最后将它们组合在一起,形成城镇,作为机器人的基本游乐场。

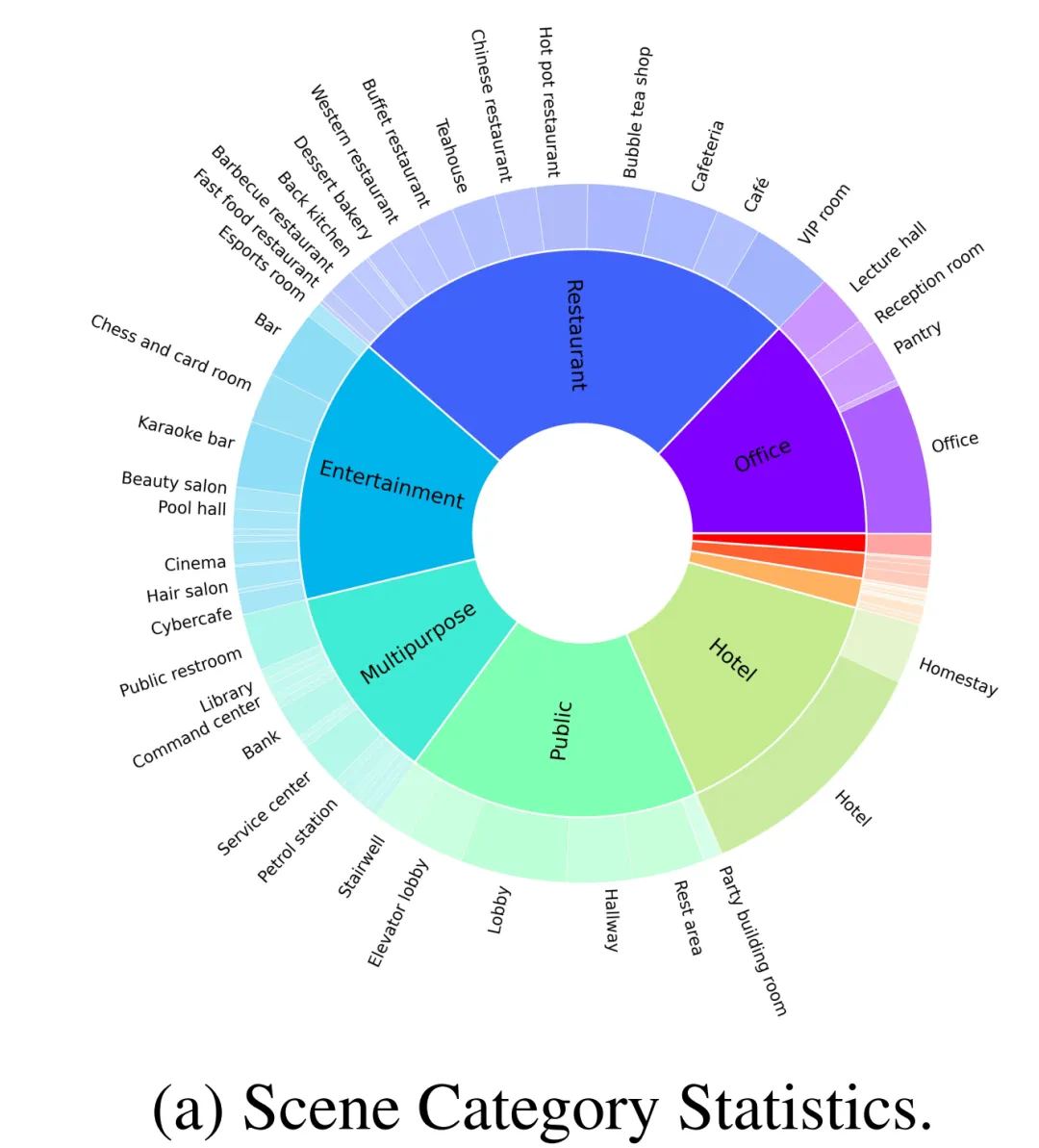

如图 2-(a) 所示,除了常见的家庭场景外,作者构建的数据集中还有 30% 的其他不同类别的场景,如餐厅、办公室、公共场所、酒店、娱乐等。作者从大规模数据集中初步筛选出 100 个带有精细注释的场景,用于开源基准测试。这 100 个场景包括 70 个家庭场景和 30 个商业场景,其中家庭场景由综合性常见区域和其他不同区域组成,商业场景涵盖医院、超市、餐厅、学校、图书馆和办公室等常见类型。

此外,作者还与几位专业设计师合作,按照人类的生活习惯来分配物体,使这些场景更加逼真,如图 1 所示,而这在以前的作品中通常是被忽略的。

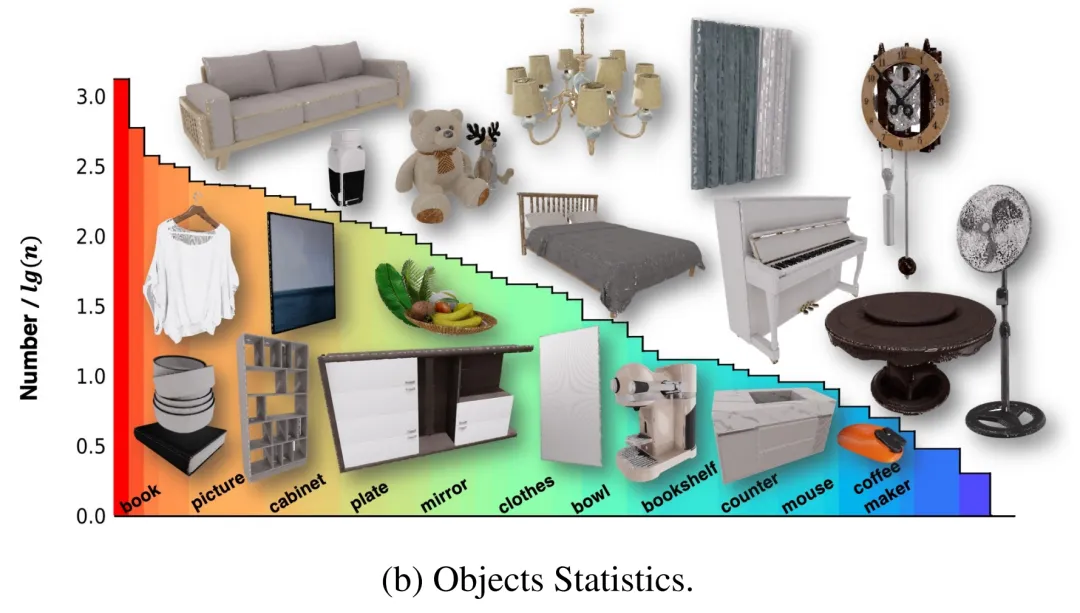

具有部件(part)级注释的交互式物体

这些场景原本包含多个 3D 物体,但其中一些没有内部建模,因此无法训练机器人与这些物体进行交互。为了解决这个问题,作者与专业团队合作,对这些资产进行修改,并创建完整的物体,使它们能够以物理上可信的方式进行交互。此外,为了提供更全面的信息,使智能体能够与这些资产进行交互,作者在英伟达 Omniverse 中以 X 形式为所有物体的交互部件附加了细粒度部件标签。最后,100 个场景包含 96 个类别的 2956 个交互式物体和 22001 个非交互式物体,其分布情况如图 2-(b) 所示。

分层多模态注释

最后,为了实现具身智能体与环境以及 NPC 的多模态交互,还需要对这些场景和对象进行语言注释。与之前的多模态 3D 场景数据集只关注对象层面或对象间关系不同,作者还考虑了场景元素的不同粒度,如对象与区域的关系。鉴于缺乏区域标签,作者首先设计了一个用户界面,在场景鸟瞰图上用多边形注释区域,然后可以在语言注释中涉及对象 - 区域关系。对于每个对象,他们都会用渲染的多视图图像提示功能强大的 VLM(如 GPT-4v),以初始化注释,然后由人工进行检查。由此产生的语言注释为后续基准测试生成具身任务提供了基础。

GRResidents3D 环境中的生成式 NPC

在 GRUtopia 中,作者通过嵌入一些「居民」(即由 LLM 驱动的生成式 NPC)来赋予世界以社交能力,从而模拟城市环境中的社会互动。这个 NPC 系统被命名为 GRResidents。在 3D 场景中构建真实虚拟角色的主要挑战之一是整合 3D 感知能力。然而,虚拟角色可以轻松访问场景注释和模拟世界的内部状态,从而实现强大的感知能力。为此,作者设计了一个世界知识管理器(WKM),用于管理实时世界状态的动态知识,并通过一系列数据接口提供访问。借助 WKM,NPC 可以检索所需的知识,并通过参数化函数调用执行细粒度的对象 grounding,这构成了其感知能力的核心。

世界知识管理器(WKM)

WKM 的主要职责是持续管理虚拟环境知识,并向 NPC 提供高级场景知识。具体来说,WKM 分别从数据集和模拟器后台获取分层注释和场景知识,构建场景图作为场景表示,其中每个节点表示一个对象实例,边表示对象之间的空间关系。作者采用 Sr3D 中定义的空间关系作为关系空间。WKM 会在每个模拟步骤中保留该场景图。此外,WKM 还提供了三个核心数据接口,用于从场景图中提取知识:

1、find_diff (target, objects):比较目标对象与一组其他对象之间的差异;

2、get_info (object, type):根据所需的属性类型获取对象的知识;

3、filter (objects, condition)::根据条件过滤对象。

LLM 规划器

NPC 的决策模块是一个基于 LLM 的规划器,由三个部分组成(图 3):一个存储模块,用于存储 NPC 与其他智能体之间的聊天历史记录;一个 LLM 程序员,使用 WKM 的接口来查询场景知识;以及一个 LLM 发言器,用于消化聊天历史记录和查询到的知识,从而生成回复。当一个 NPC 收到一条信息时,它会首先将信息存储在内存中,然后将更新的历史记录转发给 LLM 程序员。然后,程序员会反复调用数据接口来查询必要的场景知识。最后,将知识和历史记录发送给 LLM 发言器,由其生成响应。

实验

作者进行了对象指代、语言 grounding 和以对象为中心的 QA 等方面的实验,以证明论文中的 NPC 能够生成对象说明,通过描述定位对象,以及为智能体提供对象信息。这些实验中的 NPC 后端 LLM 包括 GPT-4o、InternLM2-Chat-20B 和 Llama-3-70BInstruct。

如图 4 所示,在指代实验中,作者采用了 human-in-the-loop 评估。NPC 随机选择一个对象并对其进行描述,然后人类注释者根据描述选择一个对象。如果人类注释者能找到与描述相对应的正确对象,则指代成功。在 grounding 实验中,GPT-4o 扮演了人类注释者的角色,它提供了一个物体的描述,然后由 NPC 对其进行定位。如果 NPC 能够找到相应的物体,则 grounding 成功。

表 2 中的成功率(指代和 grounding)显示,不同 LLM 的准确率分别为 95.9%-100% 和 83.3%-93.2% ,这验证了我们的 NPC 框架在不同 LLM 中指代和接地的准确性。

在以对象为中心的 QA 实验中,作者评估了 NPC 在导航任务中通过回答问题向智能体提供对象级信息的能力。他们设计了一个 pipeline 来生成以对象为中心的导航情节,模拟真实世界的场景。在这些场景中,智能体向 NPC 提问以获取信息,并根据回答采取行动。给定智能体问题后,作者根据 NPC 的答案与真实答案之间的语义相似性对其进行评估。表 2(QA)中显示的总体得分表明,NPC 可以提供精确而有用的导航帮助。

GRBench:一个评估具身智能体的基准

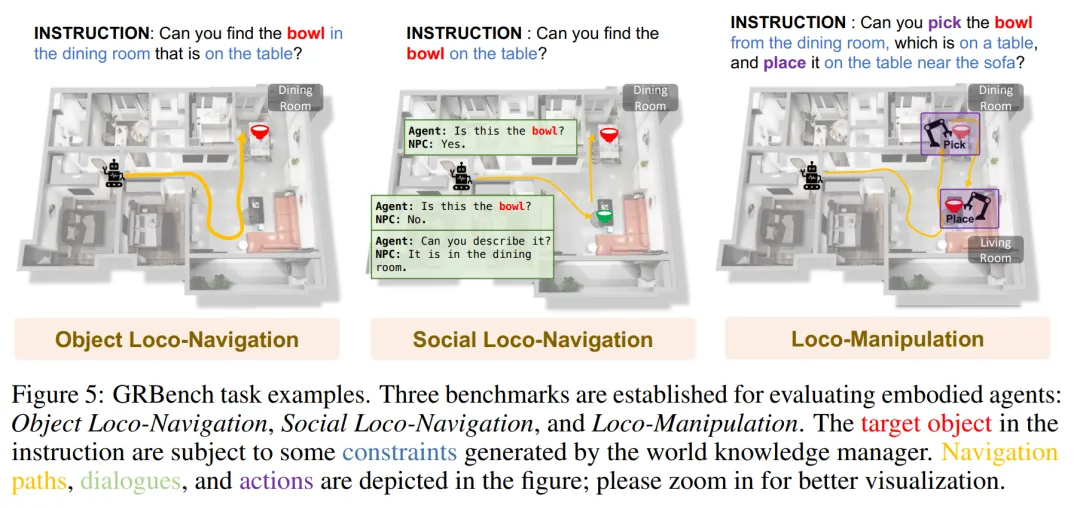

GRBench 是评估机器人智能体能力的综合评估工具。为了评估机器人智能体处理日常任务的能力,GRBench 包括三个基准:物体定位导航、社交定位导航和定位操作。这些基准的难度逐渐增加,对机器人技能的要求也随之提高。

由于腿式机器人具有卓越的跨地形能力,作者优先考虑将其作为主要智能体。然而,在大规模场景中,要同时执行高级感知、规划和低级控制并取得令人满意的结果,对当前的算法来说具有挑战性。

GRBench 的最新进展证明了在仿真中针对单项技能训练高精度策略的可行性,受此启发,GRBench 的初始版本将重点放在高级任务上,并提供基于学习的控制策略作为 API,如行走和拾放。因此,他们的基准提供了更真实的物理环境,缩小了模拟与真实世界之间的差距。

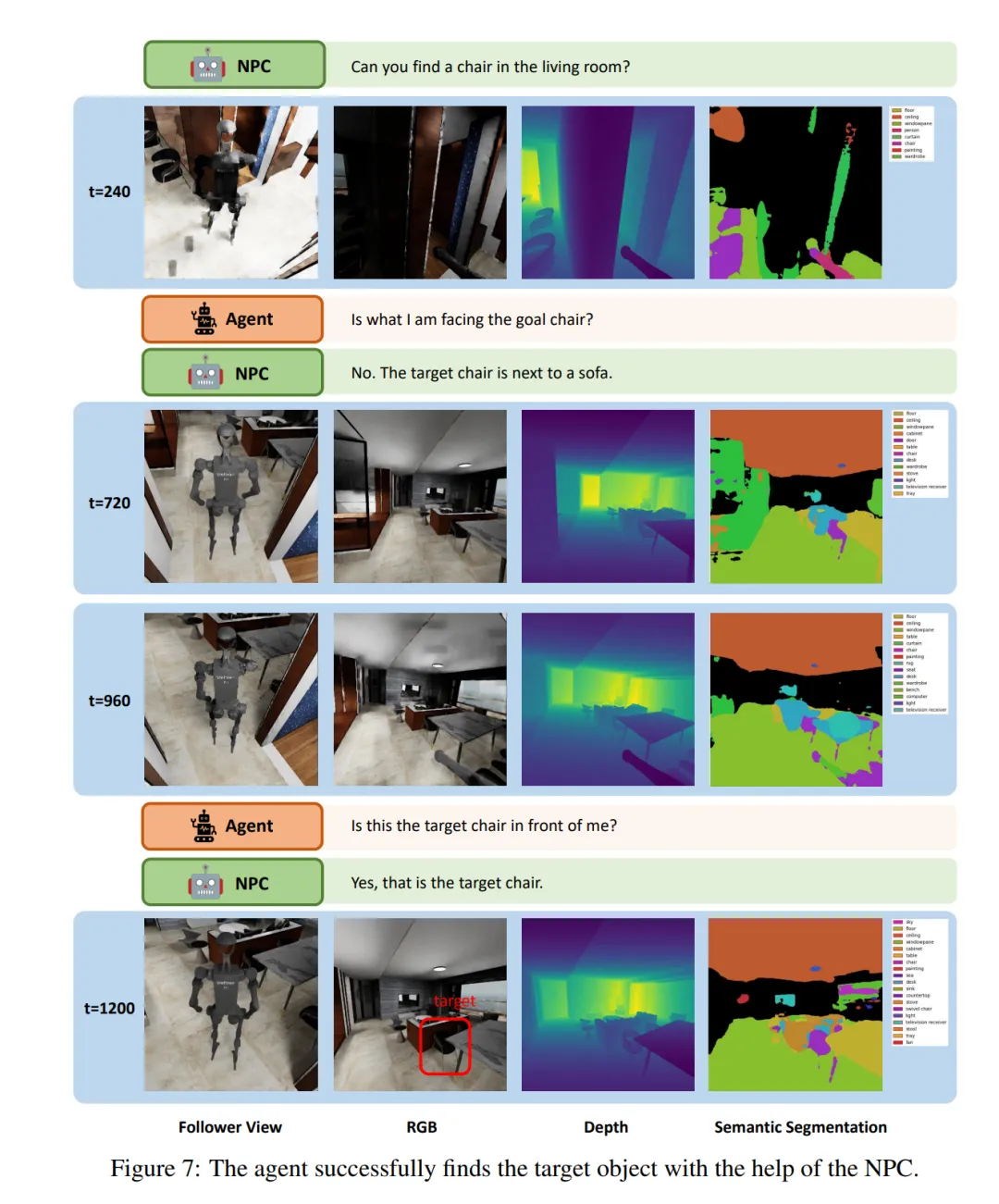

下图是 GRBench 的一些任务示例。

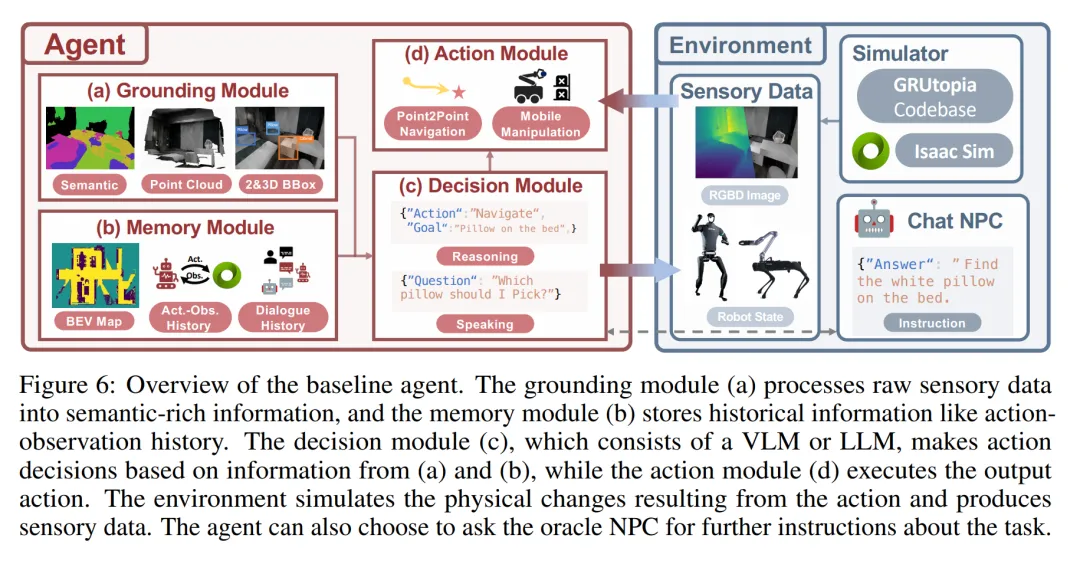

下图是基准智能体的概览。grounding 模块 (a) 将原始感官数据处理成语义丰富的信息,记忆模块(b)存储行动观察历史等历史信息。决策模块(c)由 VLM 或 LLM 组成,根据(a)和(b)的信息做出行动决策,而行动模块(d)则执行输出的行动。环境模拟行动带来的物理变化,并产生感官数据。智能体可以选择向顾问 NPC 询问有关任务的进一步指示。

定量评估结果

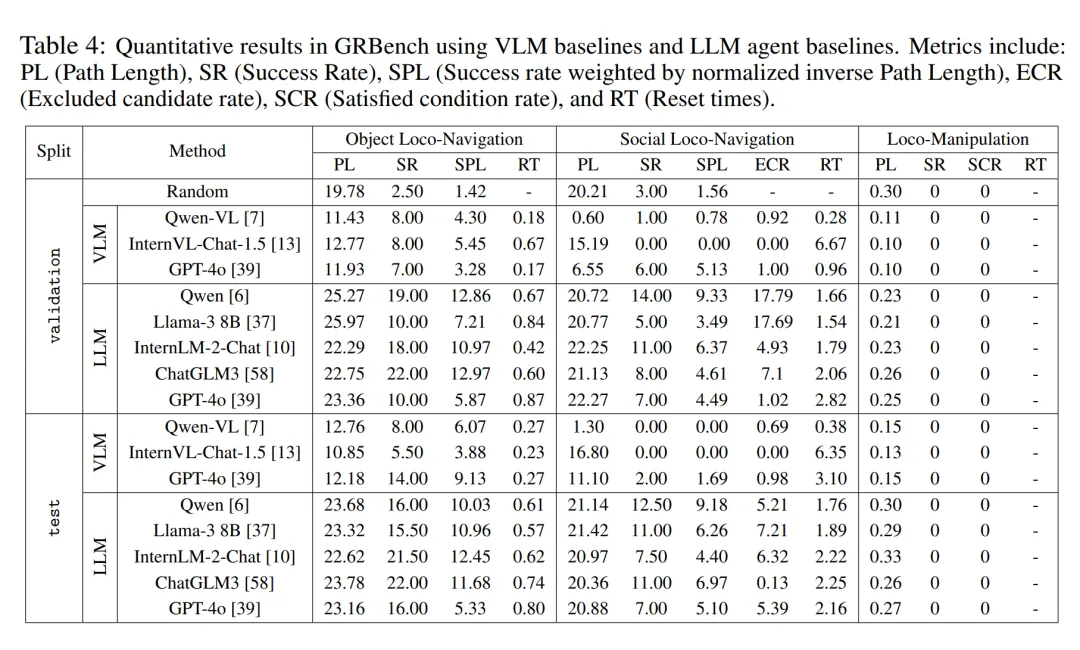

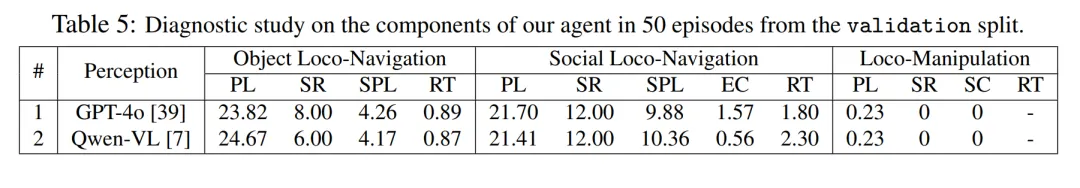

作者在三个基准测试中对不同大型模型后端下的大型模型驱动智能体框架进行了比较分析。如表 4 所示,他们发现随机策略的性能接近于 0,这表明他们的任务并不简单。当使用相对较优的大型模型作为后端时,他们在所有三个基准测试中都观察到了明显更好的整体性能。值得一提的是,他们观察到 Qwen 在对话中的表现优于 GPT-4o(见表 5)。

此外,与直接使用多模态大模型进行决策相比,本文提出的智能体框架表现出明显的优越性。这表明,即使是目前最先进的多模态大型模型,在现实世界的具身任务中也缺乏强大的泛化能力。不过,本文的方法也有相当大的改进空间。这表明,当引入更接近真实世界的任务设置时,即使是像导航这样已经研究多年的任务,仍然远未完全解决。

定性评估结果

图 7 展示了 LLM 智能体在「社会定位导航」(Social Loco-Navigation)任务中执行的一个小片段,以说明智能体如何与 NPC 互动。该智能体最多可与 NPC 对话三次,以查询更多任务信息。在 t = 240 时,智能体导航到一把椅子前,询问 NPC 这把椅子是否是目标椅子。然后,NPC 提供有关目标的周边信息,以减少模糊性。在 NPC 的协助下,智能体通过类似人类行为的交互过程成功识别了目标椅子。这表明,本文中的 NPC 能够为研究人与机器人的互动和协作提供自然的社会互动。