本文经计算机视觉研究院公众号授权转载,转载请联系出处。

1.概述

目前的OD算法对于长距离的小物体的成功率有限。为了提高这项任务的准确性和效率,我们提出了一套新的算法,将图像划分为块,选择具有不同尺度对象的块,详细说明小对象的细节,并尽早检测到它。我们的方法建立在transformer的网络上,并集成了扩散模型以提高检测精度。如在BDD100K,我们的算法将小目标的mAP从1.03提高到8.93,并将计算中的数据量减少了77%以上。

2.背景

物体检测(OD)在许多现实场景的应用中发挥着至关重要的作用,如自动驾驶和机器人。尽管针对这项任务的各种算法激增,但现有方法在早期目标检测方面仍然面临重大挑战,这是实现快速和主动决策的关键方面。在这样的场景中,由于距离长,捕获图像中的对象的大小通常会显著减小。

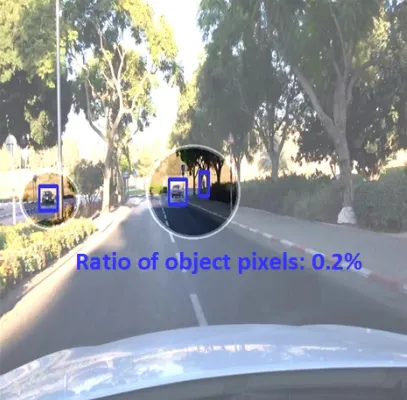

如上图所示,当图像仅包含有限数量的对象,并且由于数据量不足,目标检测的性能显著不理想。为了应对这一挑战,我们可以利用超分辨率(SR)算法来重建更高分辨率的图像,从而增加可用于后续目标检测模型的数据。SR也是计算机视觉中的一个经典问题,拥有大量为该任务量身定制的解决方案。

最近,与生成对抗性网络(GAN)相比,扩散模型,如DDPM,在图像生成方面表现出了显著的能力,并表现出了更大的稳定性。此外,专注于条件扩散模型(CDM)应用于SR的研究取得了显著进展。通过利用扩散模型生成高分辨率图像,我们可以显著提高目标检测性能。然而,扩散模型具有巨大的计算成本,这对自动驾驶等现实的应用构成了挑战。从上图中的图像示例来看,图像的整体细化会对背景像素造成相当大的计算负担,导致资源的过度浪费,对OD没有任何有意义的贡献。

3.新框架详细分解

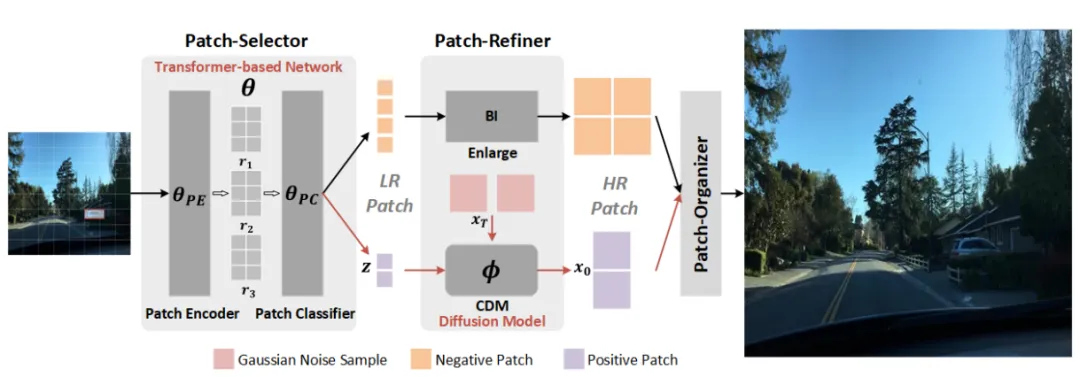

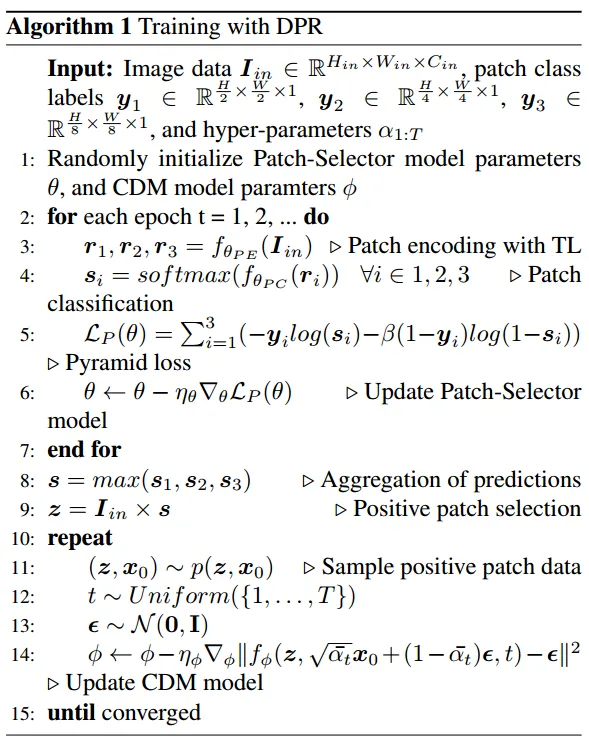

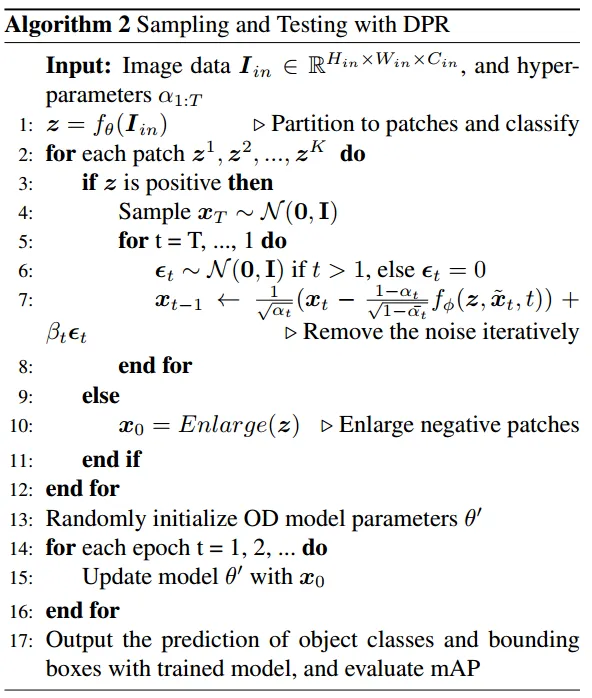

如下图所示,DPR包括三个关键模块:Patch-Selector, Patch-Refiner, Patch-Organizer。Patch-Selector模块负责提取补丁特征并执行分类。接下来,Patch-Refiner模块详细阐述了正补丁,利用CDM将其重建到更高的分辨率,从而提高了目标检测精度。最后,为了完全展示我们提出的方法的效率和准确性,我们使用廉价的插值技术来放大负补丁,并将所有补丁组织成完整的图像,以便于与原始图像进行直接比较。接下来我们对所有模块进行了详细讨论,并概述了算法1中提出的DPR的具体训练过程。此外,算法2详细说明了采样和测试过程。

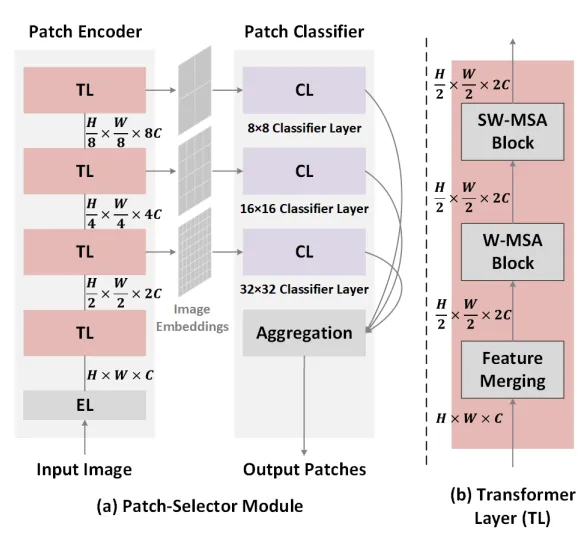

Patch-Selector模块的设计如下图:(a)利用分层结构编码器,输入图像被嵌入到三个不同尺度的特征中。随后,对这些特征中的补丁进行分类和聚合,以形成最终输出。(b)每个变换器层(TL)包括一个特征合并块和多个基于窗口的自关注块。

4.实验及可视化

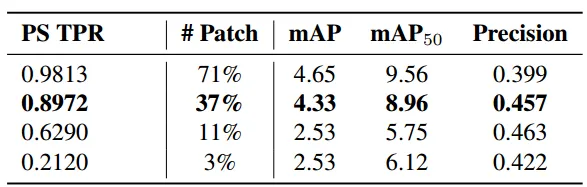

为了权衡计算和性能,在下表中对将图像从64×64放大到512×512时的不同阈值进行了补丁分类实验。第二排的mAP为4.33,是最佳选择,计算量减少了63%。

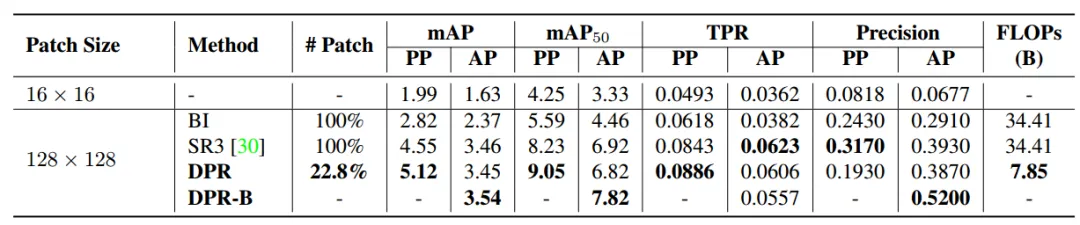

对于具有相同阈值的从128×128到1024×1024的FBDD上采样,我们的PS模块仅输出22.8%的CDM生成和OD补丁,并且与CDM相比,PS的FLOP可以忽略不计,这意味着与全图像生成相比,我们节省了77.2%的计算,如下表所示:

上图显示了集成补丁后BI和DPR的可视化比较。虽然DPR生成的总体图像看起来与BI相似,但包含对象的关键补丁显示出更精细的细节,这表明CDM只需要处理少量数据,从而实现更高效的计算。