开发基于大型模型的应用时,选择合适的应用框架不仅能显著提高开发效率,还能增强应用的质量属性。这类似于在Windows上开发传统软件服务时从MFC过渡到.NET Framework,或在Linux服务器端使用Java语言时采用Spring及Spring Boot框架,以及在Web前端开发中选择VUE、React或Angular等多样的框架。面对基于大模型的应用开发,我们应如何挑选合适的应用框架呢?对于两种常见的大模型应用框架——Langchain和LlamaIndex,它们各自拥有独特的特性和适用场景,我们又该如何做出明智的选择呢?

图片

图片

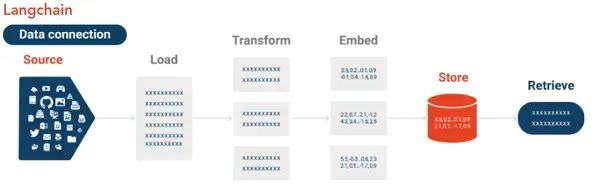

1.关于LangChain

在《解读LangChain》一文中,老码农曾对LangChain 做个一些探索,这里重新回顾一下LangChain 的主要特点以及优势与局限。

1.1 主要特性

LangChain是一个工具,它支持大型语言模型与多种数据源的集成、定制化NLP管道的创建、模块化设计以及广泛的预训练模型使用。

数据连接

LangChain 实现了大型语言模型(LLM)与各类数据源的深度整合,包括:

- 数据库:使 LLM 能够连接至关系型数据库(例如 MySQL、PostgreSQL)及 NoSQL 数据库(如 MongoDB),实现数据的动态获取与存储。

- API:与 Web API 紧密结合,便于获取实时数据、进行外部服务交互,或基于模型输出执行特定操作。

- 文件系统:允许访问并管理位于本地或云端文件存储系统中的数据,支持处理文档、日志及其他多种文件类型。

定制化管道

LangChain 赋予用户打造个性化 NLP 管道的能力,可根据具体应用场景进行定制开发,涵盖:

- 预处理步骤:实现标记化、词干分析、词素化等关键文本预处理任务。

- 模型集成:轻松融合各种预训练或微调过的模型,以配合特定任务需求,如文本分类、摘要提取或翻译。

- 后处理:对模型输出进行格式化、过滤,并无缝对接至下游应用程序,确保流程完整性与高效率。

模块化设计

LangChain 采用模块化架构设计,带来以下优势:

- 重用组件:借助现有模块处理常规任务,无需重复编写代码,简化流程。

- 扩展功能:通过新增模块或扩展既有模块,轻松适应特定场景需求,增强功能灵活性。

- 配置灵活:针对不同任务或数据源,可便捷配置及重新配置管道,实现高效定制。

预训练模型

LangChain 广泛支持多种预训练语言模型,涵盖:

- 主流模型如 BERT、GPT 和 T5:适用于文本生成、问答及文本分类等多种任务。

- 领域特定模型:专为医疗、金融或法律等特定领域定制的预训练模型,满足行业特定需求。

- 微调功能:能够在特定数据集上对模型进行微调,以提升在专业任务上的表现。

图片

图片

1.2 优势

LangChain 灵活适应多种 NLP 任务,便捷集成外部数据源,凭借模块化设计轻松扩展,且享有活跃社区的广泛支持。

- 灵活性:LangChain 具备极高的适应性,能够应对从基础文本处理到复杂多步骤工作流程的各种 NLP 任务。

- 集成性:它能够高效地与外部数据源及 API 集成,极其适合需要实时数据访问或与其它服务交互的应用场景。

- 模块化:LangChain 的模块化架构使得定制化和扩展变得简单,方便开发者在现有组件基础上进行构建或根据需求创建新组件。

- 社区支持:LangChain 拥有一个活跃而强大的社区,提供丰富的资源、教程以及论坛平台,促进问题解决与协作交流。

1.3 局限

LangChain 的学习曲线相对陡峭,对资源的需求较高,且依赖管理较为复杂,更适合有经验的用户。

- 复杂性:LangChain 的功能丰富,配置选项多样,对初学者来说学习曲线可能较为陡峭,需要时间适应和掌握。

- 资源密集型:训练和微调大型模型时,LangChain 需要大量的计算能力和内存资源,对硬件要求较高。

- 依赖管理:在大型项目中,依赖关系和集成的管理可能会变得复杂,有时可能会出现冲突或兼容性问题,需细致处理。

1.4 使用场景

LangChain 极为适合开发需要整合多种数据源的定制化 NLP 应用,例如智能文档管理系统、自动化客服系统以及个性化推荐引擎。研究人员在试验不同 NLP 模型与技术时,可借助 LangChain 快速搭建原型并测试新思路,利用其支持预训练模型及自定义处理流程的特性。

对于聊天机器人和虚拟助手,LangChain 能够助力打造能够理解并回应用户询问、与后端系统无缝集成并提供个性化互动体验的高级对话代理。

图片

图片

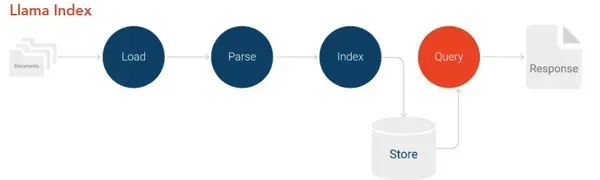

2. 关于LlamaIndex

作为一个大模型应用框架,LlamaIndex专为基于RAG的大型语言模型应用设计。它的主要目的是帮助用户将私有或特定领域的数据结构化,并安全、可靠地集成到语言模型中,以提高文本生成的准确性。LlamaIndex名字中的"Llama"象征着智能和负载能力,而"Index"表示其在数据索引和检索方面的功能。

2.1 主要特点

本质上,LlamaIndex是一个高效的索引工具,专为大型数据集设计,支持反向索引和自定义索引策略。它具有分布式索引和水平可伸缩性,可与LLM集成以提供上下文感知搜索和动态数据获取。优化技术包括缓存和查询预处理,确保快速响应时间。

高效索引

LLlamaIndex 为大型数据集提供强大的索引工具,便于快速检索,包括:

- 反向索引:这些数据结构将单词或短语映射到数据集中的位置,以便快速搜索和查询。

- 自定义索引策略:用户可根据数据类型或访问模式定义索引机制,如对结构化数据分层索引,非结构化文本使用平面索引。

可伸缩性

LlamaIndex 设计用于处理庞大数据集,提供:

- 分布式索引:在多个节点上分布索引任务,无瓶颈处理大量数据。

- 水平可伸缩性:通过添加更多资源(如服务器)来扩展系统,应对不断增长的数据和查询,保持高性能。

与 LLM 的集成

LlamaIndex 能够与大型语言模型(LLM)集成,实现上下文数据检索功能:

- 上下文感知搜索:依托 LLM 的能力,LlamaIndex 能深入理解查询的语境,提供更相关且精确的搜索结果。

- 动态数据获取:在与 LLM 的互动中,LlamaIndex 能动态地获取并呈现相关数据,确保响应具备丰富的信息量和上下文关联性。

查询优化

LlamaIndex 通过一系列优化技术确保查询的快速响应,包括:

- 缓存:将频繁访问的数据存储于内存中,显著减少常规查询的检索时间。

- 查询预处理:在执行前对查询进行细致分析和重写,以提升处理性能,确保系统高效应对复杂查询。

图片

图片

2.2 优点

LlamaIndex高效处理大型数据集,保证快速搜索与检索。具备高度可伸缩性,适应数据增长而无需担忧性能下降。针对实时应用优化数据检索,支持低延迟场景如实时推荐和分析。

- 性能: LlamaIndex 在管理和查询大型数据集方面非常高效。它的设计确保即使有大量的数据,搜索和检索操作仍然保持快速和反应迅速。

- 可伸缩性: 它可以大规模地处理数据集,而不会造成显著的性能下降。这使得它适用于数据量不断增长的应用程序,例如企业搜索引擎和大型内容管理系统。

- 优化: LlamaIndex 侧重于优化数据检索,这对于实时应用程序至关重要。系统快速获取和传递相关数据的能力使其非常适合低延迟的用例,例如实时推荐和实时分析。

2.3 缺点

LlamaIndex主要专注于数据索引和检索,不提供完整的NLP功能。与LangChain相比,它在构建自定义NLP应用方面的灵活性有限,且初始设置和配置较为复杂,需较多时间投资。

- 功能域狭窄: LlamaIndex 主要关注数据索引和检索。它不是一个成熟的 NLP 框架,这意味着它不能为创建自定义 NLP 管道或执行大量自然语言处理任务提供同等水平的灵活性。

- 灵活性有限: 与 LangChain 等框架相比,LlamaIndex 在构建自定义 NLP 管道和应用程序方面的灵活性较低。它是为特定任务设计的,可能不太适合索引和检索之外的各种需求。

- 设置复杂: LlamaIndex 的初始设置和配置可能很复杂,特别是对于不熟悉数据索引概念和分布式系统的新用户。正确配置和优化系统可能需要大量的时间投资。

2.4 使用场景

LlamaIndex适用于数据密集型应用如搜索引擎和推荐系统,以及需要快速数据检索的实时系统如金融交易和网络安全监控。它支持与大型语言模型集成,提升智能搜索和交互式问答系统的性能。

数据密集型应用

LlamaIndex 非常适合那些需要迅速访问和处理大量数据的应用,比如:

- 搜索引擎:必须从庞大的索引库中快速且准确地拉取信息。

- 推荐系统:依据用户的偏好和互动来动态地提供相关内容。

实时系统

LlamaIndex 极其适用于那些对快速数据检索有严苛要求的实时系统,例如:

- 金融交易平台:在其中,实时的数据访问与分析对于做出明智的交易决策至关重要。

- 实时监控系统:如网络安全或运营监控等系统,为了能够及时作出反应,需要能够即刻访问数据。

对 LLM 的支持

LlamaIndex 能够与大型语言模型(LLM)结合使用,在推理过程中提供与上下文相关的数据,从而提升应用程序性能。具体应用如:

- 智能搜索:通过 LLM 使用索引数据来提供更准确、更贴合上下文的搜索结果。

- 交互式问答系统:需要从大型数据集中提取相关信息,以有效地回答用户的查询。

开发人员和架构师可以通过理解这些特性、优点、缺点和使用场景,更好地评估 LlamaIndex 如何适应他们特定的生成式 AI 项目和数据密集型应用程序。

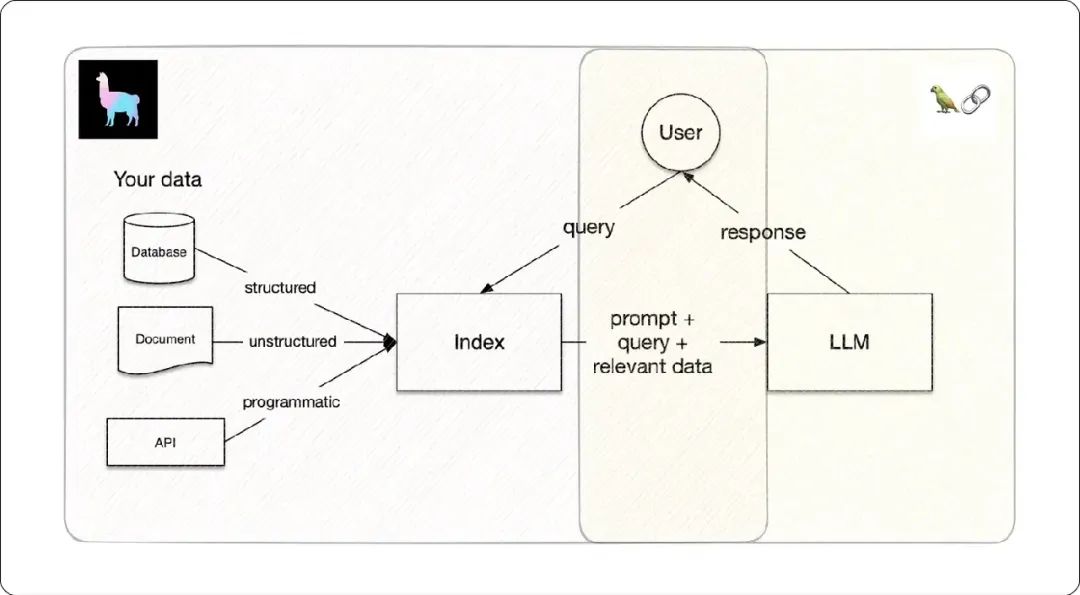

3. LangChain与LlamaIndex的对比选择

LlamaIndex 和 LangChain 对于希望构建自定义的基于 LLM 的应用程序的开发人员来说都是非常有用的框架。总结一下,LangChain 与 LlamaIndex 的对比如下:

比较项 | LangChain | LlamaIndex |

聚焦功能域 | 定制化NLP流水线与大模型集成 | 高效数据索引和信息提取 |

灵活性 | 高 | 中 |

扩展性 | 中 | 高 |

集成性 | 与外部数据源的高度集成 | 主要是数据索引 |

易用性 | 学习曲线陡峭 | 配置复杂,聚焦使用 |

性能 | 资源密集型 | 可以高性能优化 |

社区支持 | 强 | 成长中 |

当需要搭建复杂的 NLP 应用程序,并要求与多种数据源及自定义流水线配置进行灵活集成时,LangChain 是不二之选。对于依赖综合语言模型运用的项目,LangChain 显得尤为适合。

若主要关注高效的数据索引与检索,尤其是在处理大型数据集方面,LlamaIndex 则是理想选择。对于追求数据处理性能和可伸缩性至关重要的应用程序,LlamaIndex 高度契合。

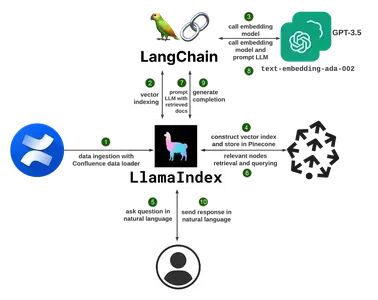

LangChain 和 LlamaIndex 这两种框架各具特色,选择时应基于生成式 AI 应用程序的具体需求来决定, 同时,二者可以有机的结合,示例如下:

图片

图片

4. LangChain与LlamaIndex的对比选择

LangChain 的主要重点是 LLM 的开发和部署,以及使用微调方法对 LLM 进行定制。然而,LlamaIndex 旨在提供端到端的机器学习工作流,以及数据管理和模型评估。在二者结合的时候,一般地,LlamaIndex 可以处理数据预处理和初始模型培训阶段,而 LangChain 可以促进 LLM 的微调、工具集成和部署。