本文作者来自于新加坡国立大学、南洋理工大学以及哈工深。其中,费豪的研究方向为多模态学习、多模态大语言模型。吴胜琼,新加坡国立大学博士生,主要研究方向为多模态大语言模型。吉炜的主要研究方向为多模态学习,多模态内容生成。张含望教授的研究兴趣包含计算机视觉、因果推断。张梅山教授的研究方向包括代码智能,自然语言处理,多模态生成与理解。Mong-Li Lee和Wynne Hsu教授的研究方向为社交媒体分析,协同机器学习等等。

最近,新加坡国立大学联合南洋理工大学和哈工深的研究人员共同提出了一个全新的视频推理框架,这也是首次大模型推理社区提出的面向视频的思维链框架(Video-of-Thought, VoT)。视频思维链VoT让视频多模态大语言模型在复杂视频的理解和推理性能上大幅提升。该工作已被ICML 2024录用为Oral paper。

- 论文链接: https://openreview.net/pdf?id=fO31YAyNbI

- 项目链接: http://haofei.vip/VoT/

从感知到认知的飞跃

相比于理解和推理静态的图片,在视觉处理社区,推理视频的难度要复杂困难很多,因为视频天然地存在更具挑战的动态时序特性,以及存在更多冗余的视觉内容。过去的视频理解研究多集中于视频的浅层感知,如视频动作识别、动态识别和视频描述生成。然而,这些方法对复杂视频的深入理解和推理仍存在显著不足。相较于浅层的视频感知,复杂视频的推理不仅需要对视频的时空特性有复杂的理解,还需深刻把握像素背后的内在高阶常识。为了彻底解决这一问题,VoT应运而生。

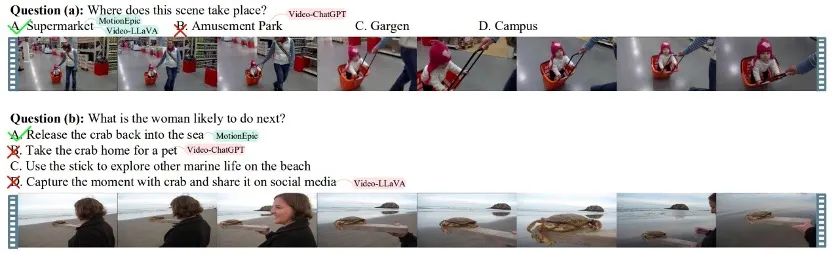

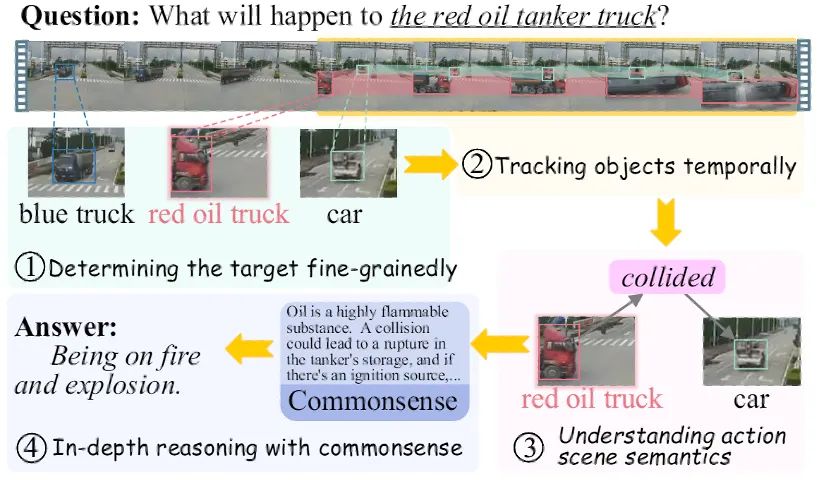

对于人类而言,理解视频就像吃饭喝水一样简单。那么我们人类是如何进行视频理解推理的呢?我们不妨考虑以下一个案例。以下的这段视频展示了一个场景:一辆高速行驶的汽车与一辆红色油罐卡车在公路上相撞。对应的问题是:“这辆红色油罐卡车会发生什么?”

当人类拿到这个题目的视频,首先,我们会根据问题确定感兴趣的目标,即红色油罐卡车。然后,我们会仔细观看视频,跟踪目标对象在视频中的动作语义。接着,我们会进行一些深入和高层次的推理,可能会结合一些常识知识。最后,我们给出推理答案:“可能会着火甚至爆炸。”

双重能力:感知与认知的完美结合

从以上的人类的认知模式和模式汲取灵感,研究团队指出,要实现复杂视频推理,需要具备两个关键能力:像素理解的感知能力和语义理解的认知能力。并且最重要的是,视频推理可能不是一个瞬时一步到位的过程,而是一个由低级感知到高级认知的多跳过程。

感知能力:为了实现精确的内容感知,必须对视频运动进行细致的像素级理解。这个过程可能需要深入结合给定的视频内容,并且具备精细的内容定位。

然而,大多数现有视频理解方法局限于实例分析,缺乏精细的控制和准确的对象级识别或跟踪,更不用说深入的视频理解了。

认知能力:深入的推理需要认知能力,允许模型提供合理的解释甚至因果想象。这个层次需要结合一定的世界常识知识。例如理解「从高处跳下可能导致骨折」,或者「与油罐车相撞可能引发爆炸」。

全新推理框架:视频思维链的诞生

为了实现这一目标,研究团队提出了一个全新的推理框架——“视频思维链”。该思维链将复杂的视频推理问题分解为从底层视觉感知到上层常识认知的一系列子问题。

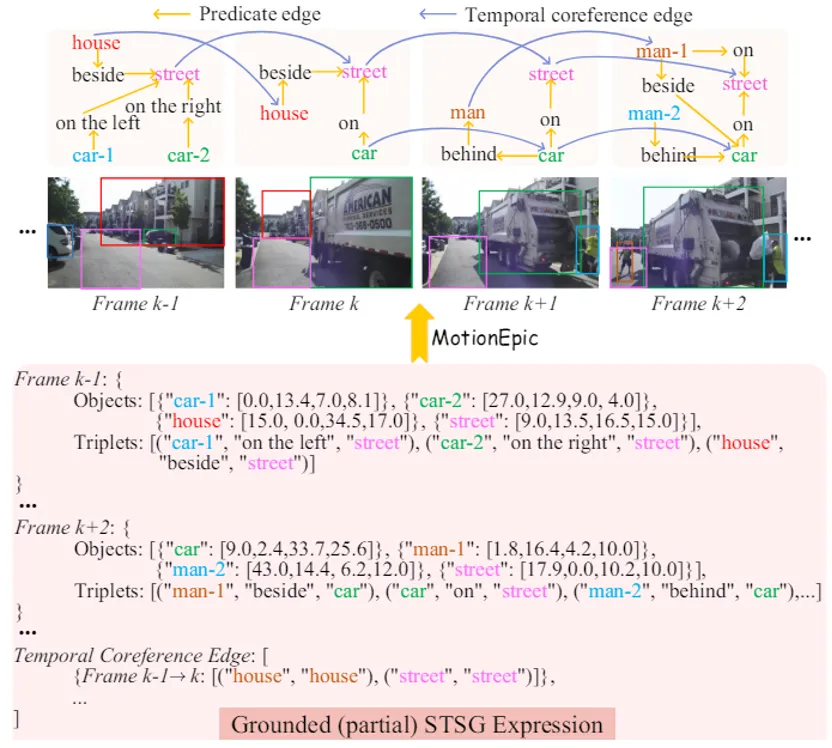

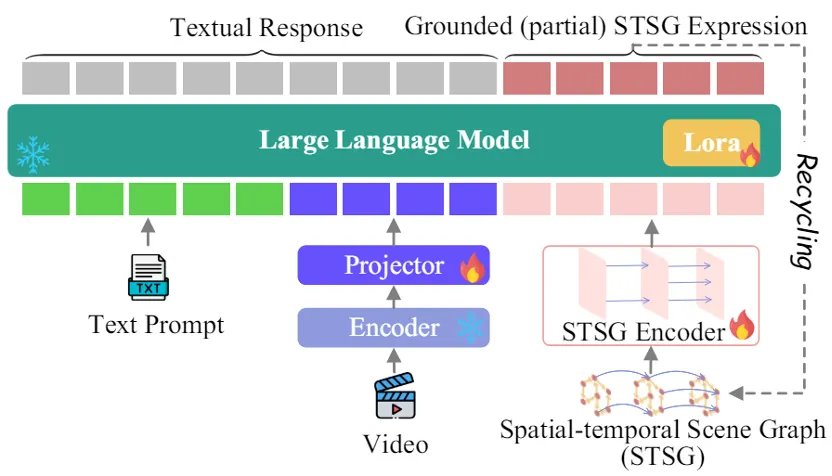

与此同时,为了协助实现上述的细粒度视频感知能力,作者还提出利用时空场景图(Spatial-Temporal Scene Graph, STSG)表征协助推理过程,帮助生成的细粒度感知中间结果,从而实现精细的时空特征理解。

并与视频多模态大模型相结合,最终提出了一个全新的视频MLLM, MotionEmpic。

实验结果表明,作者提出的全新推理框架可显著提升模型在各类视频QA上的性能,超越了当前所有传统视频MLLM以及CoT方法的表现。

A.视频思维链VoT推理框架

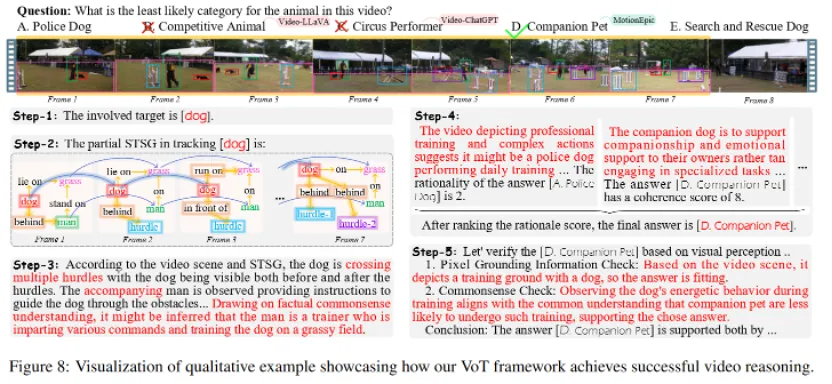

VoT推理框架一共包含5个步骤:

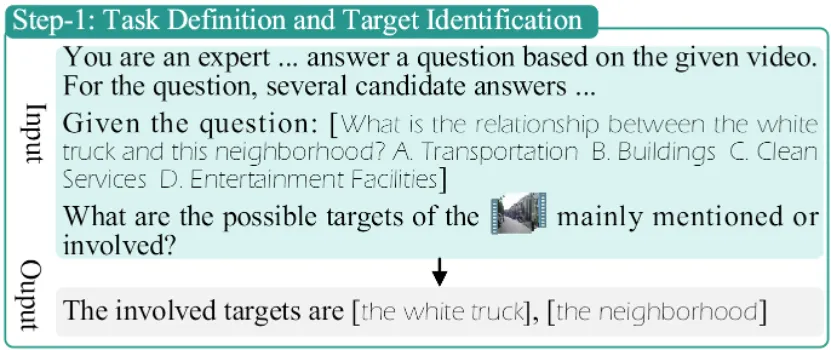

Step-1:任务定义与目标识别

首先,给定输入视频和问题,VoT会识别问题中涉及的所有可能目标。这个过程确保系统明确了解需要分析的对象和相关任务。

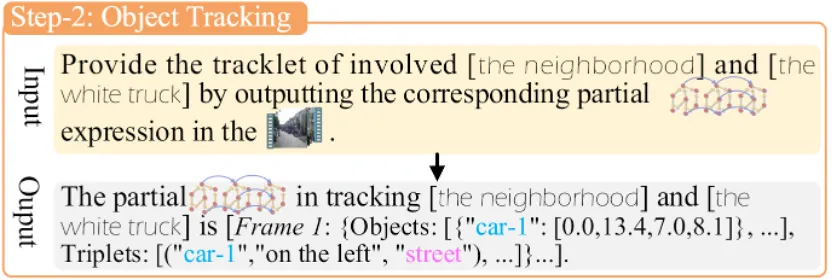

Step-2:目标追踪

接下来,VoT分析视频内容,追踪问题所涉及的目标行为轨迹,输出感知层面的时空场景图 (STSG)。生成的关于目标轨迹STSG将为下一步行为分析的感知证据。

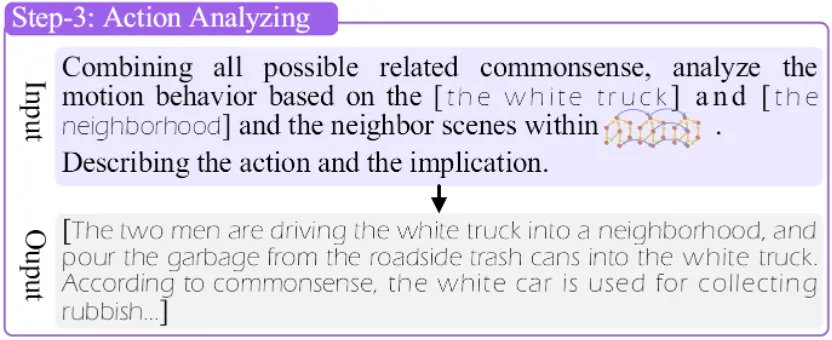

Step-3:行为分析

在这一步中,VoT通过整合STSG中的目标跟踪结果,进一步提示模型考虑更多潜在相关的常识知识,使模型能够将视频像素观察与现实世界联系起来,实现对视频的更深入理解。

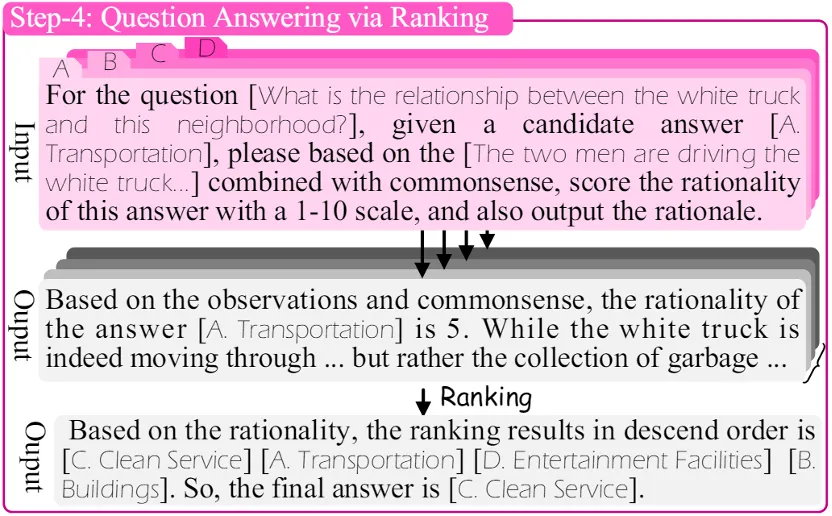

Step-4:排名机制回答问题

在深入理解了视频中目标行为之后,现在开始回答原始问题。首先,本系统将所有QA问题统一为多项题,即从提供的多个候选答案中选出最终答案。进一步,受人类解答多选题的模式启发,本系统还采用了排名机制来确定最终答案。具体来说,对于每个候选答案,VoT将提示模型根据常识知识评估其可能性(从1到10),并提供相应的理由。最终根据,排名高的候选则为最终回答。

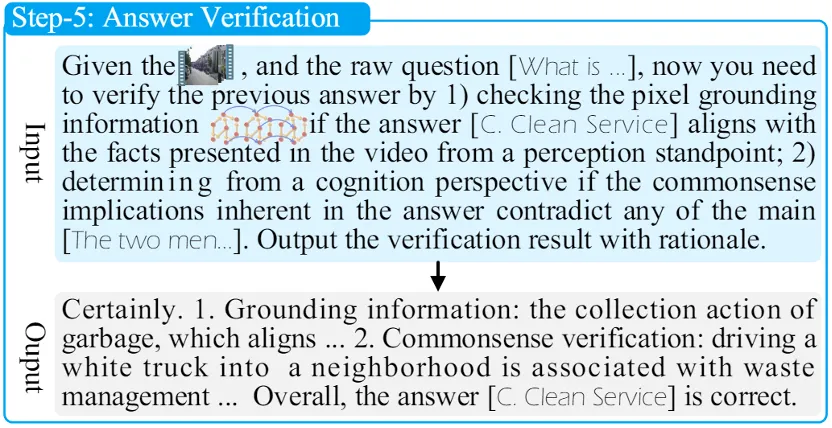

Step-5:答案验证

鉴于复杂视频任务通常涉及复杂的问题和答案,并且整个推理过程包含了多个环节,因此核实上一步提供的答案至关重要。本系统的基本核验思路是,假设答案A是正确的,我们将从两个方面回顾性评估答案是否与输入问题和视频内容相矛盾:

- 感知验证:检查像素定位信息是否与视频中从感知角度呈现的事实一致。

- 认知验证:从认知角度提示模型,确定答案中固有的常识性知识是否与第三步推理中推断出的主要观察结果相矛盾。

最终,确保VoT能够输出最正确的结果。

VoT推理框架的五个步骤,从任务定义与目标识别,到最终的答案验证,全面提升了视频理解和推理的精确性和可靠性,为复杂视频任务提供了强有力的解决方案

B.实验验证

1. 主实验比较

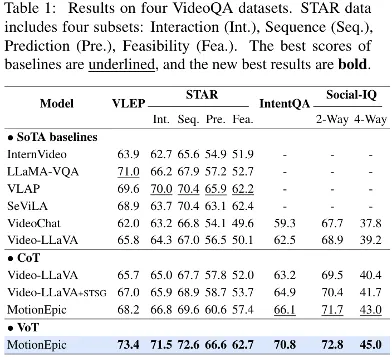

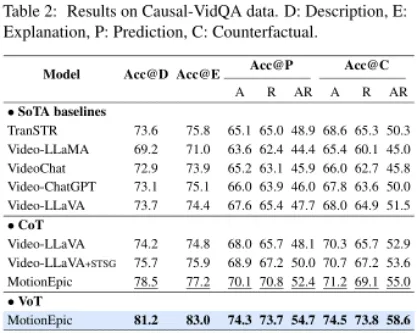

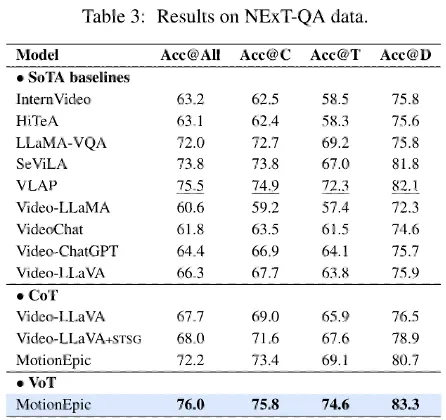

作者首先在多个复杂VideoQA的数据集上进行了测试。实验结果证明VoT在所有的测试集上获得了持续的强于SoTA基线模型的表现,甚至超越传统CoT的性能。

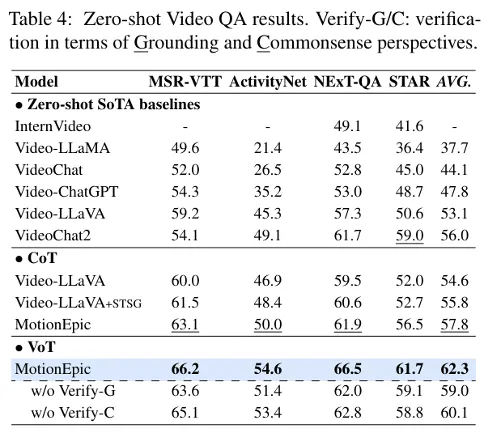

2. Zero-shot结果

接下来,作者比较了不同模型在zero-shot下的性能。值得注意的是,相比较与传统的CoT,VoT性能提升更大、更明显。并且,在两个复杂的视频问答任务上的增强效果比在相对简单的任务(例如,MSR-VTT和ActivityNet)上的增强更为明显。这主要是因为后者的数据集更倾向于感知推理(例如,描述视频中的内容),而不是认知推理(例如,解释、预见)。

3. 推理能力详细分析

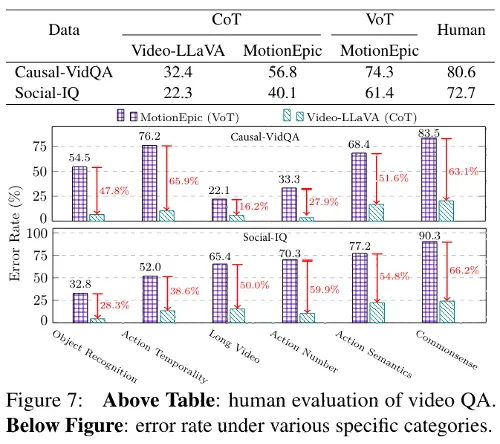

首先,作者进行了人类评估。如图7上表所示,使用VoT推理框架的MotionEpic取得了相当出色的结果,甚至可以与人类表现相媲美。进一步,作者总结了六种常见的错误案例,并分析六种最常见错误类别的差异。如图下部分所示,MotionEpic(使用VoT)显著降低了VideoLLaVA(使用CoT)的错误率,特别是在动作语义和常识理解方面。

4. 推理过程可视化分析

最后,作者通过一个案例分析直观地展示了VoT的优越性。如图8所示,视频内容显示了“训导员带着小狗跨越各类障碍比赛”的复杂场景,而给定的问题是抽象且复杂,需要结合常识,而不能简单地通过视频本身的感知直接回答。实验结果发现,只有本系统给出了正确的答案。具体地,在内容感知层面,VoT通过基于STSG的视频定位确保了准确且稳健的理解,防止了幻觉,即正确地解释了动物是一只狗,然后从常识推断场景涉及训练者正在训练狗。然后,在认知层面,它分析每个选项以确定最佳答案。通过进一步验证,结果与视频内容和事实常识理解一致。总体而言,通过问题分解,整个推理在每个步骤上大大提高了准确性,同时确保了一个可解释的过程决策理由。

作者还提供了更多的可视化分析: