谷歌2024学术指标,刚刚出炉了!

最新排名是针对2019-2023年之间发表的文章的统计,还包含了截至2024年7月在Google Scholar中被引的所有文章数。

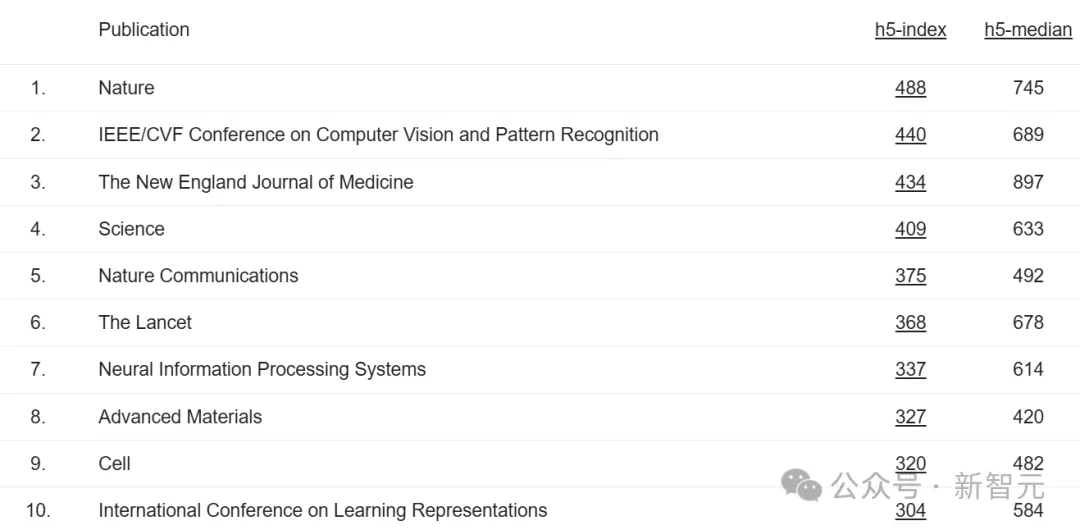

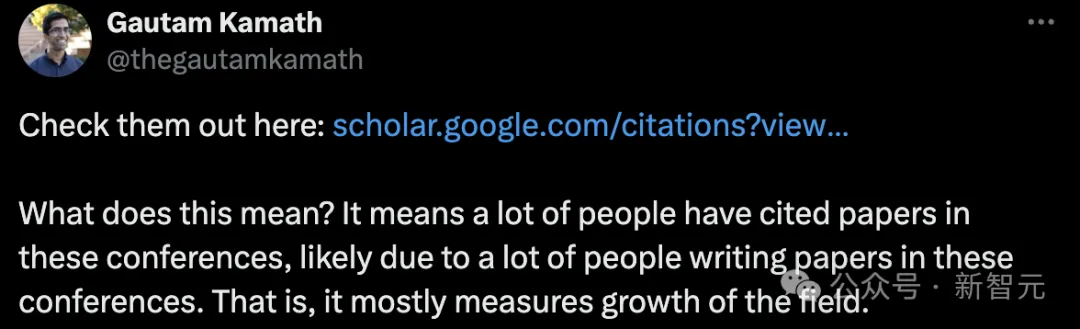

今年,依据h5-index,排在前十的期刊/国际顶级学术会议中,Nature已经连续霸榜多年。

除了Nature,还有新英格兰医学杂志、Science、自然通讯、柳叶刀、Advanced Materials、细胞国际期刊进入前十。

此外,CVPR、NeurIPS、ICLR三大顶会跻身TOP 10,分别位列第二、第七和第十。

2023学术指标中,CVPR位列第四,NeurIPS位列第九。ICLR排名不变。

网友们纷纷惊叹道,「CVPR已经攀升至第二,仅次Nature」!

「看到CVPR比Science有更大一个影响力,和Nature相差不远,简直太疯狂了」。

CVPR、NeurIPS顶会排名跃升如此之高,说明了什么问题?

加拿大滑铁卢大学计算机教授Gautam Kamath称,要么是很多人引用了这些顶会中的论文,要么是很多人在顶会中发表了论文。也就是说,这一现象主要反映了该研究领域的增长。

AI五大顶会冲进TOP 20

除了开头我们提到了三个顶会位列前十,在总榜前20名中,还有ICCV、ICML两个机器学习/计算机视觉顶会入选。

其中,ICCV位列第13,ICML位列第17。

接下来,一起分别看看这5大顶会,近5年来(2019-2023年)被引最高的文章。

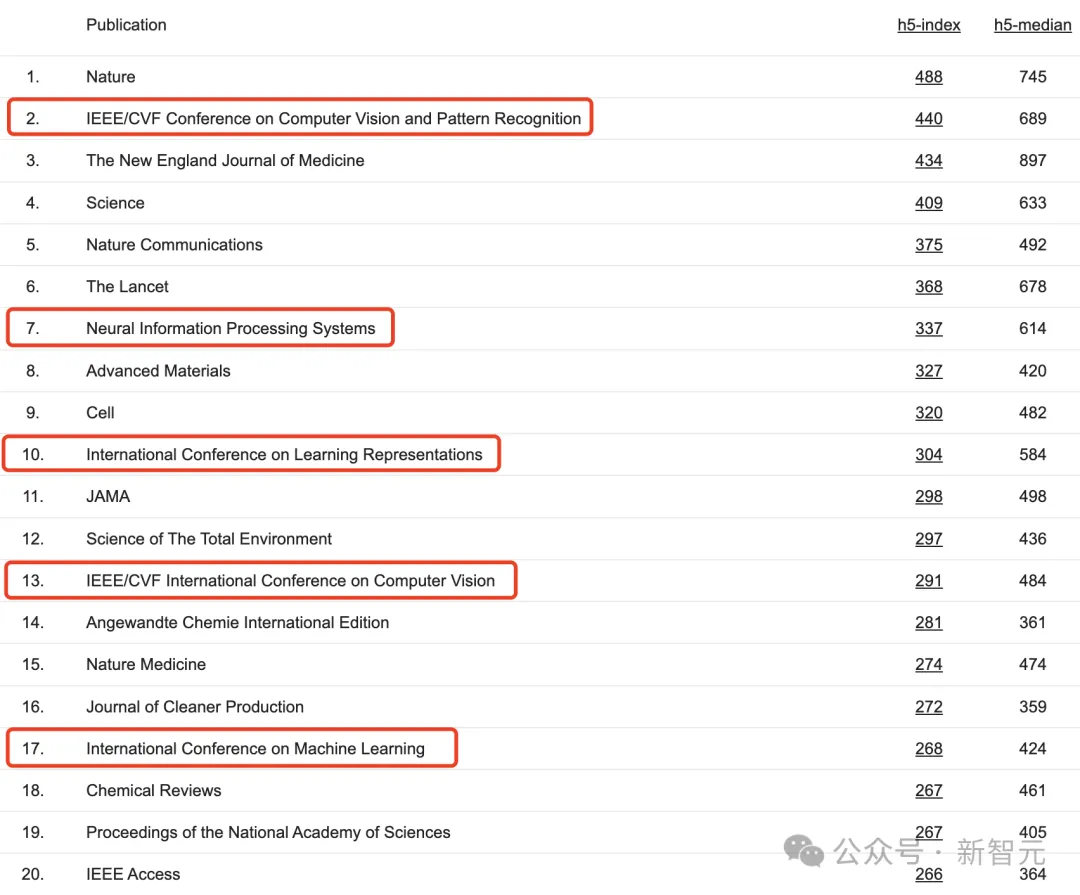

CVPR:StyleGAN、LDM

首先来看CVPR,h5-index为440,h5-median为689。

在前20篇高被引的论文中,优秀的产出成果分别聚集在2019年、2020年、2022年中,分散在2021年、2023年的论文只有零星几篇。

这里,有几篇极具代表性,每个人或多或少熟知的作品:

由何凯明、谢赛宁等人联手在2020年提出的动量对比(MoCo)算法被引最高,达11878次。这是一种构建大型且一致的词典的方法,用于无监督学习。

还有英伟达团队提出的StyleGAN算法,让AI可以生成无数个细节丰富、逼真的人脸,很难看出伪造的痕迹。

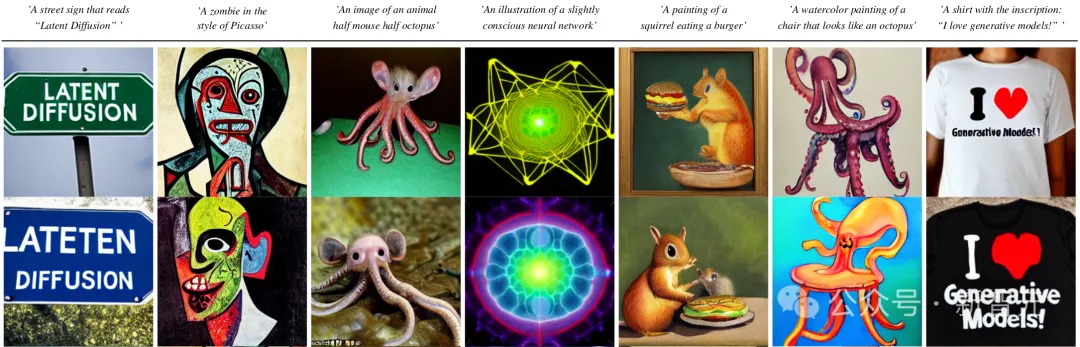

Runway的AI视频模型从Gen-1到Gen-3 Alpha完成多次进化,离不开的是「潜在扩散模型」(LDM)。

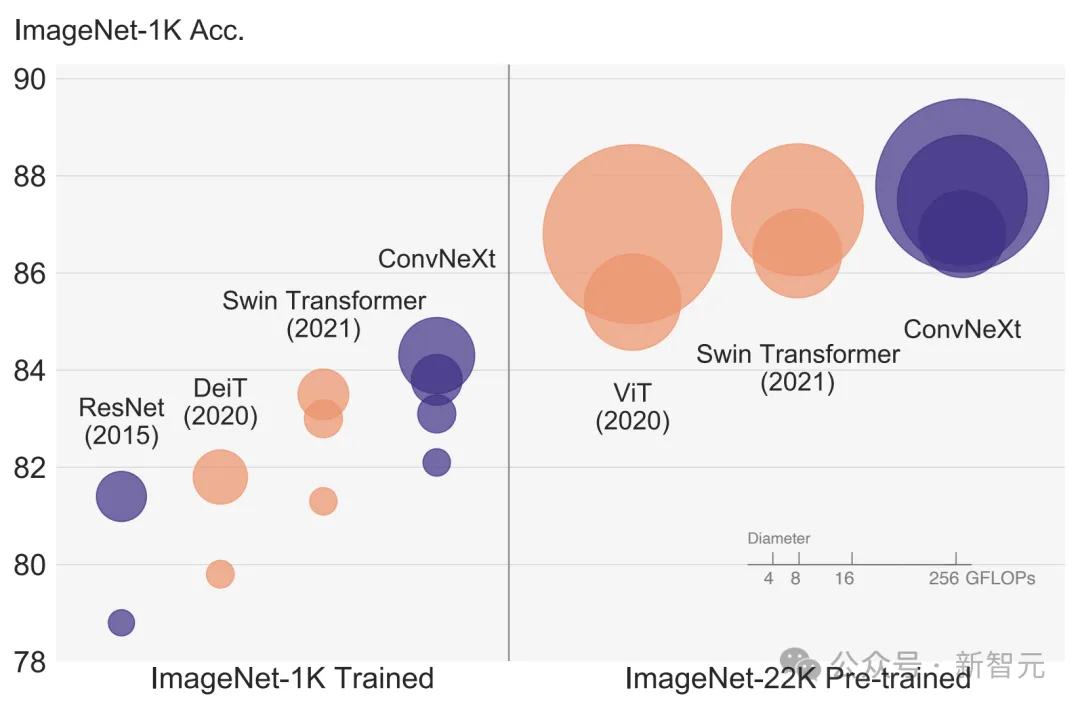

还有谢赛宁带领团队发表的A ConvNet for the 2020s,带来全新纯卷积模型ConvNeXt,性能反超Swin Transformer,直接在CV圈里掀起了模型架构之争。

2023年有一篇YOLOv7的论文进入TOP 20,现在这一算法已经改进到了YOLOv10(清华团队)。

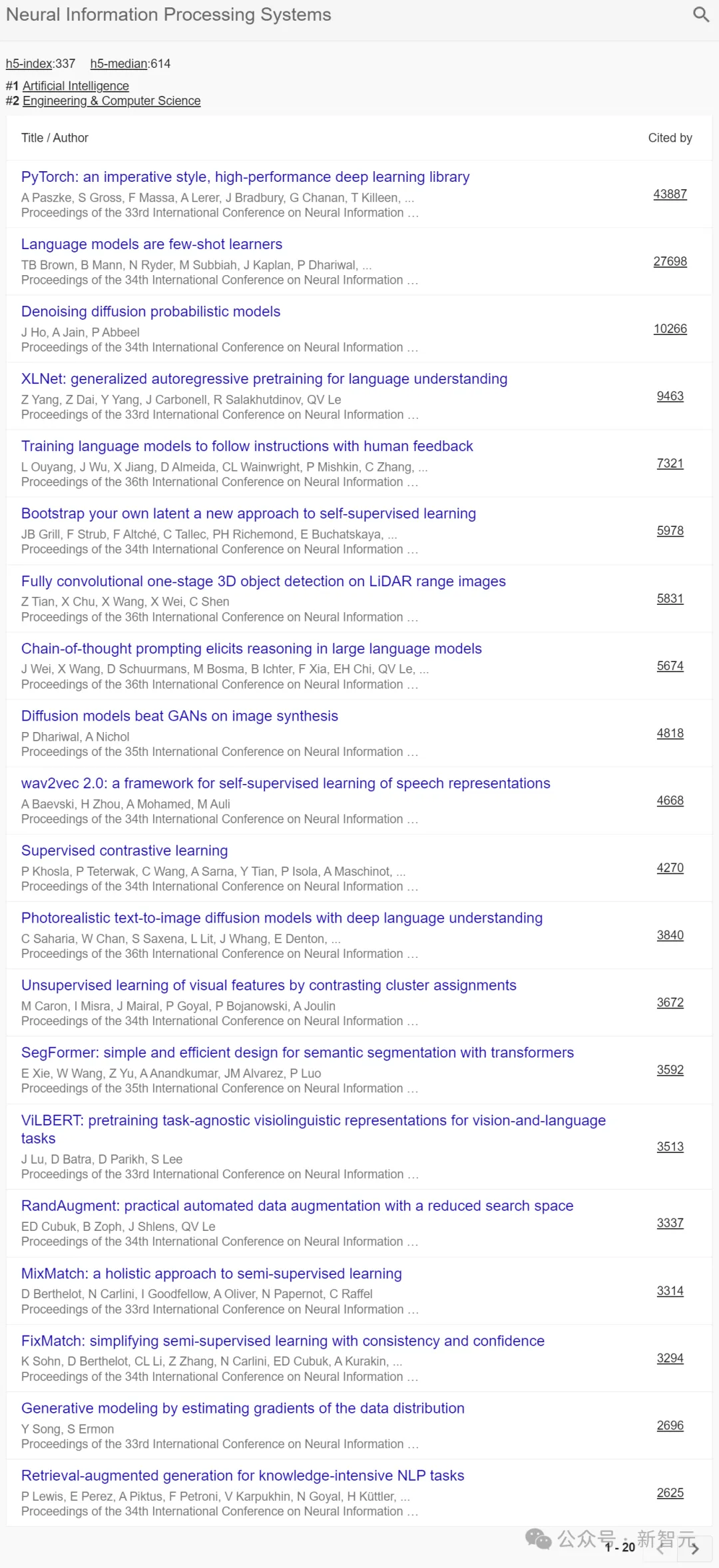

NeurIPS:GPT-3、CoT、RAG

在NeurIPS中,h5-index为337,h5-median为614。

在前20篇高被引的论文中,优秀的产出成果分别聚集在2019-2022年之间。

被引最高的论文是PyTorch开山之作,被引数为43887,可见其影响力之深远。

其次,被引第二高的是由前OpenAI科学家Ilya Sutskever带队的研究——大名鼎鼎的GPT-3背后之作,成为业界拜读之笔。

其他著名的研究还包括:

谷歌大脑一作Jason Wei和团队提出「思维链」(CoT)算法,已经成为当今大模型弥补幻觉问题的一种重要的手段。

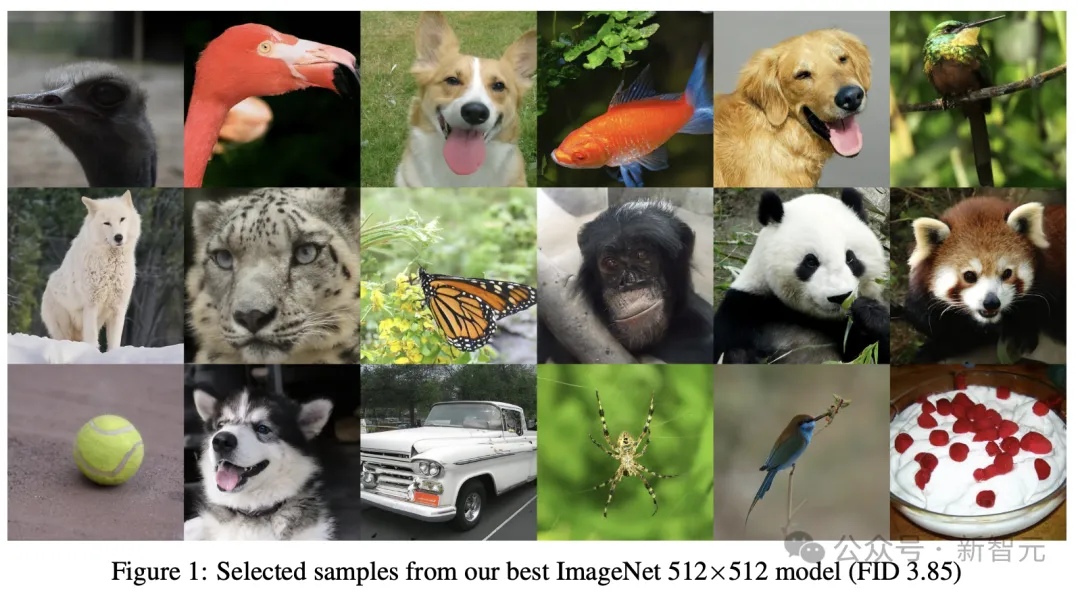

还有OpenAI团队提出的使用类别引导图像生成扩散模型,首次击败了GAN。

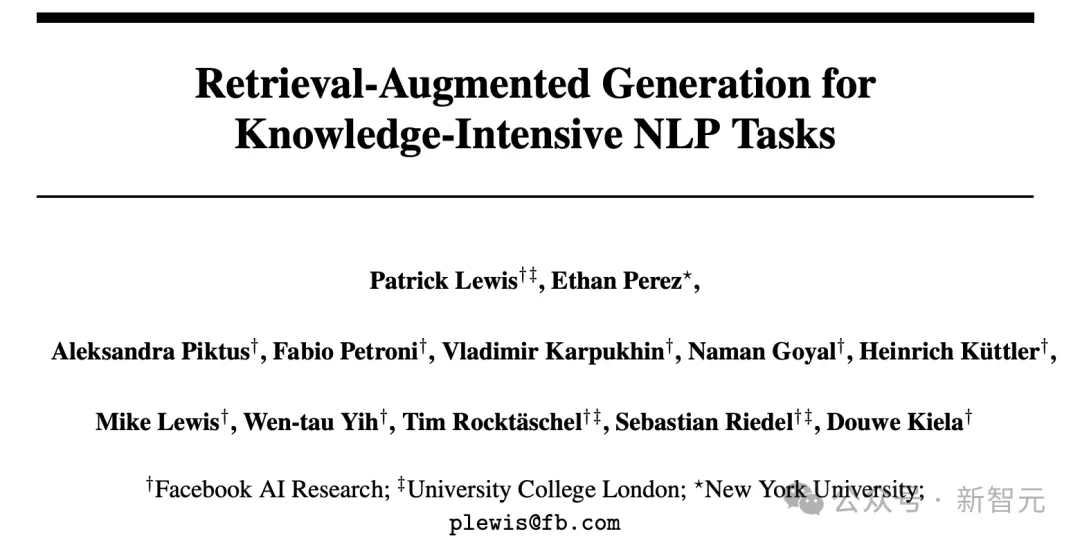

另有Meta(Facebook)团队在2020年在如下论文中,首次提出了如今大模型用到的一项技术的概念——检索增强生成(RAG)。

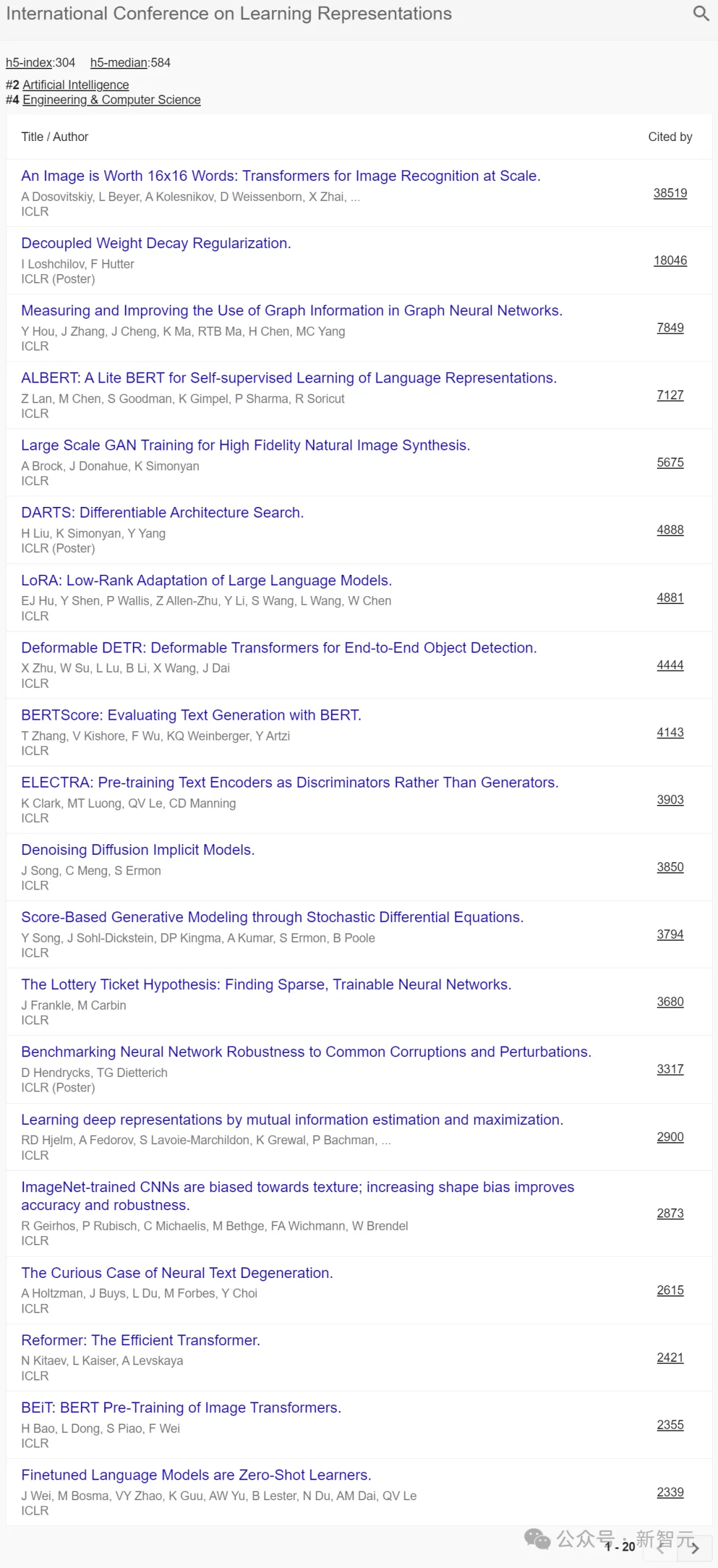

ICLR:LoRA、ViT

在ICLR中,h5-index为304,h5-median为584。

在前20篇高被引的论文中,优秀的产出成果分别聚集在2019-2022年之间,2021年比例偏少一些。

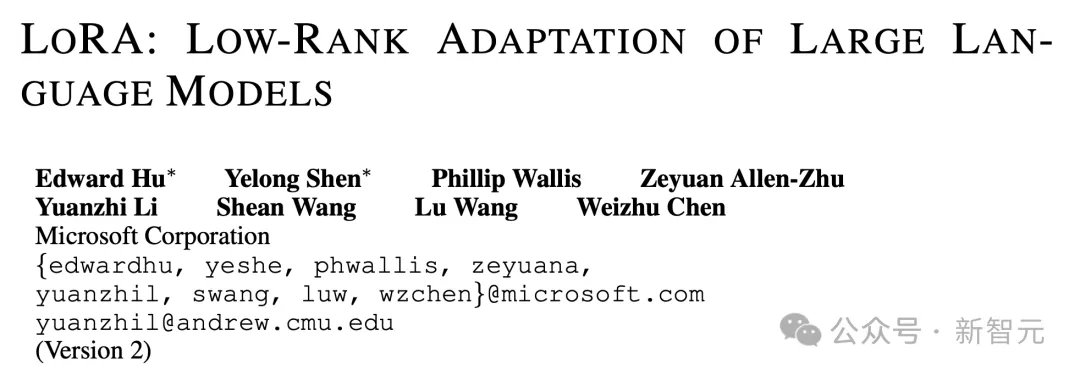

其中的经典之作,包括微软团队提出的大模型时代爆火技术之一——LoRA。这是一种降低模型可训练参数,又尽量不损失模型表现的大模型微调方法。

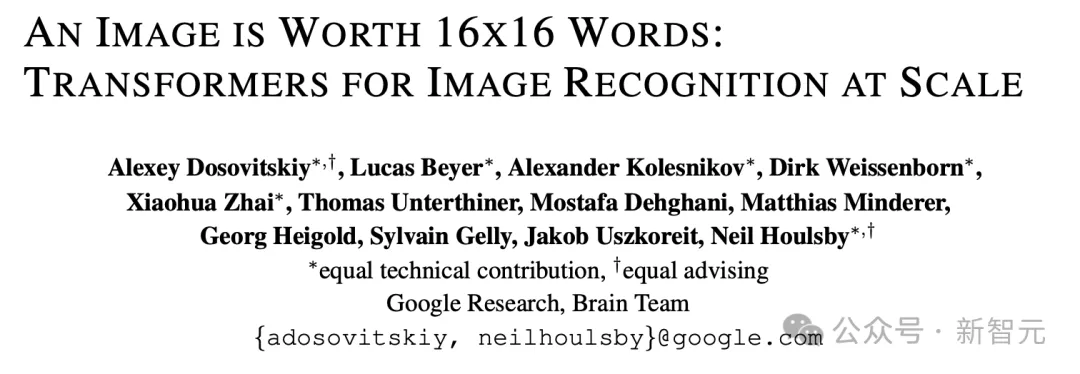

如下这篇论文成为Transfomer在CV领域的里程碑之作,引爆了后续的相关研究。

谷歌大脑团队提出了Vision Transformer(ViT)全新架构,不用卷积神经网络(CNN),可以直接用Transformer对图像进行分类,性能赶超CNN。

斯坦福团队提出的「去噪扩散隐式模型」(DDIM),大幅减少采样的步骤,极大的提高了图像生成的效率。

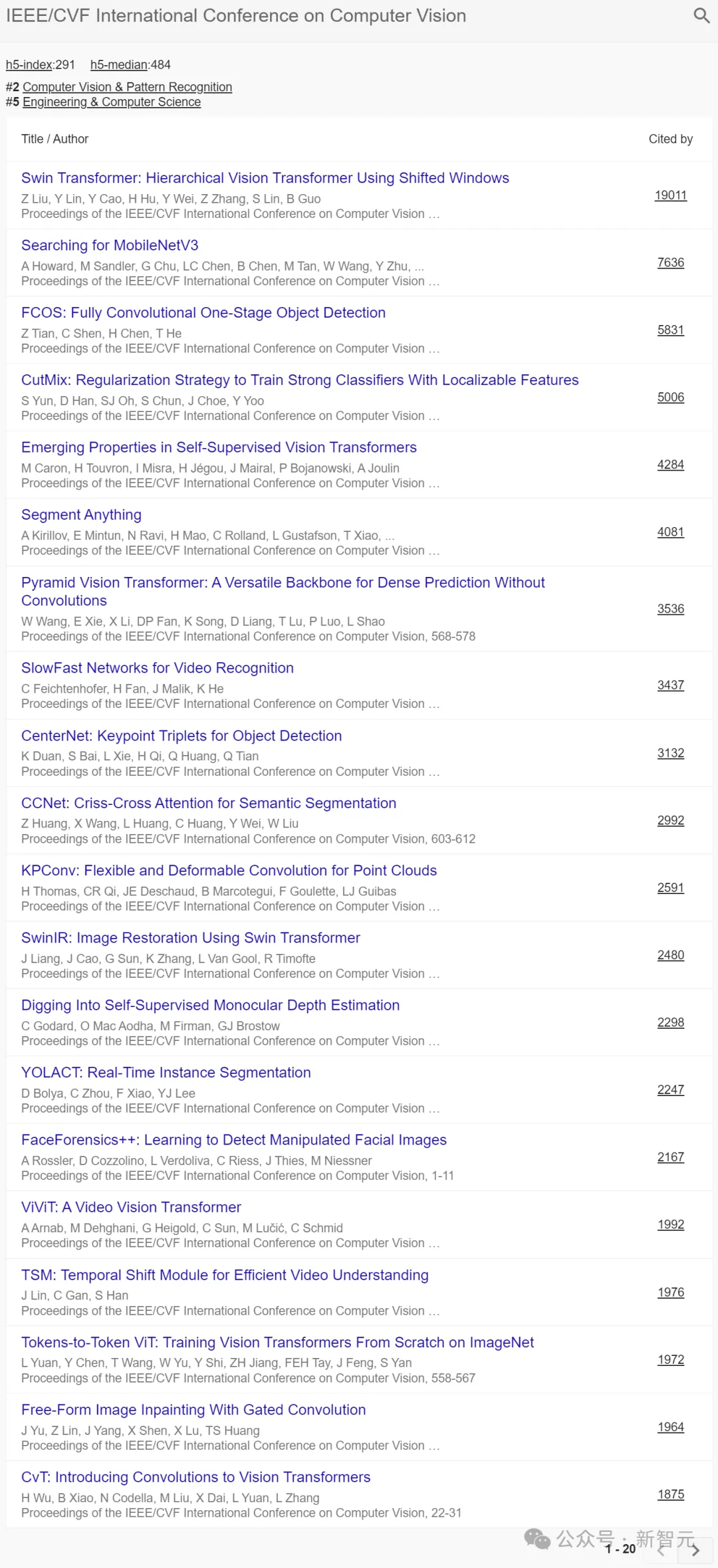

ICCV:Swin Transformer、SAM

在ICLR中,h5-index为291,h5-median为484。

在前20篇高被引的论文中,优秀的产出成果主要聚集在2019年、2021年。

其中,有大家熟知的:

全华人团队提出的Swin Transformer,是Transformer模型在视觉领域的又一次碰撞。它在物体检测和语义分割任务中大幅刷新了此前的纪录,并被广泛应用于众多视觉任务中。

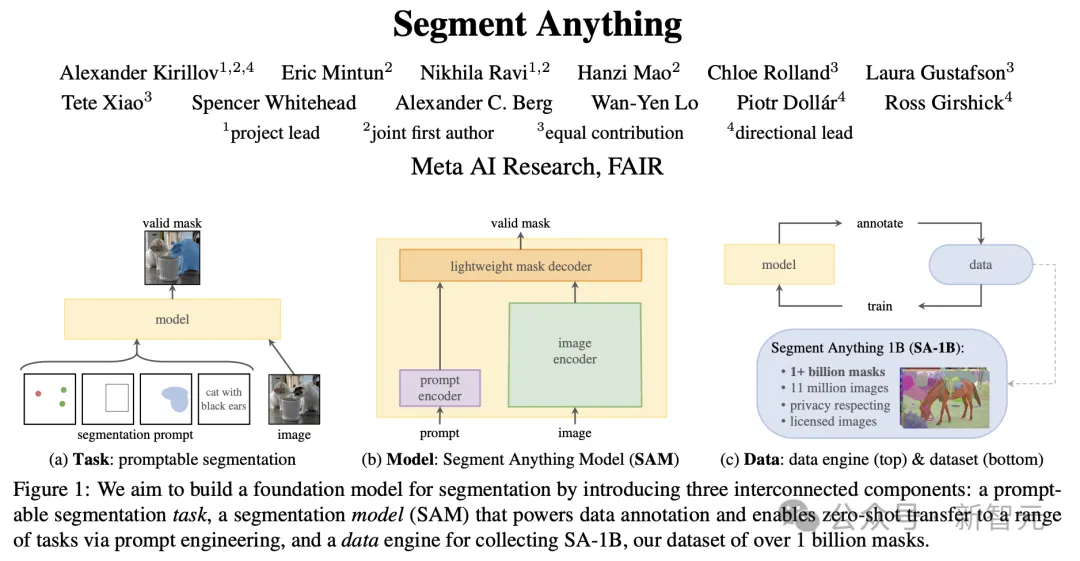

Meta团队提出的「分割一切」(SAM)模型,让学术圈直呼CV不存在了。

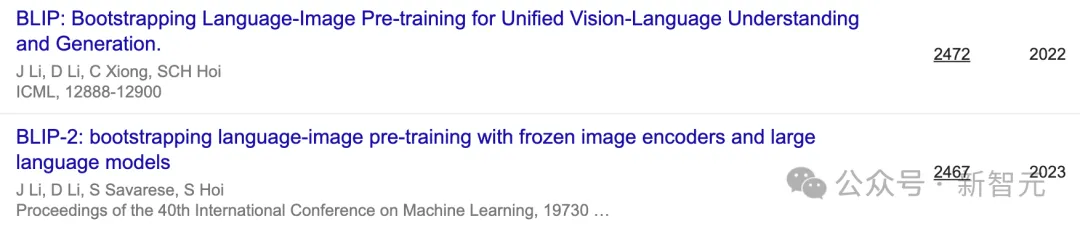

ICML:DALL·E、GLIDE、BLIP

在ICML中,h5-index为268,h5-median为424。

在前20篇高被引的论文中,优秀的产出成果分散在2019-2023年之间。

在GAN之后,Ian Goodfellow团队又提出了「自注意力生成对抗网络」(SAGAN),在GAN的基础上引入了自注意力机制,改进了图像生成的质量和多样性。

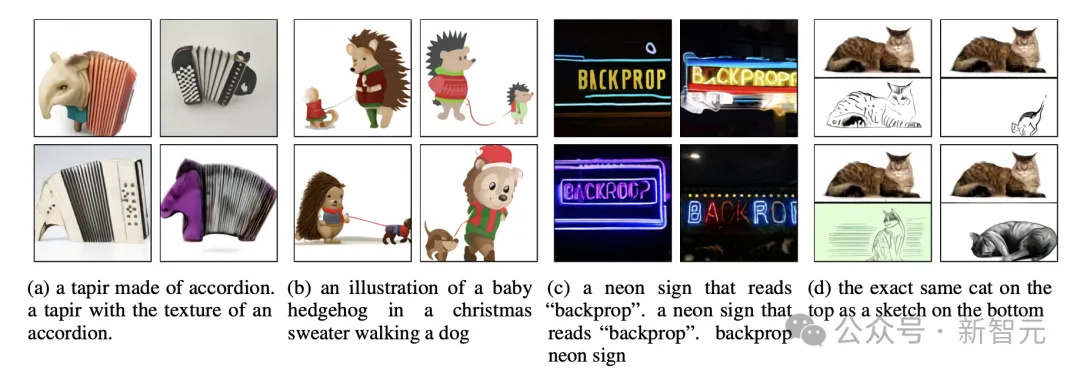

OpenAI DALL·E背后经典之作,便是如下这篇了。

另一篇同由OpenAI团队提出的的文本生成图像模型GLIDE,仅用35亿参数,就能媲美初代DALL·E的性能。

此外,还有双语视觉语言模型BLIP、BLIP-2。

从以上五大顶会的趋势研究中,看得出当前GenAI、大模型的爆发,与近年来的研究一脉相承。

另外,对于其他领域感兴趣的读者,可以进入Google Scholar主页自行查阅。

传送门:https://scholar.google.com/citations?view_op=top_venues

最权威学术指标,也陷争议

每年,Google Scholar都会更新一次学术指标,并列出位列前100名的出版物。

「谷歌学术指标」提供了一种简便的方法,可以快速评估近期文章在学术出版物中的可见度和影响力。

它总结了许多出版物最近的引用情况,可以帮助业界研究者们参考那里发表最新的研究成果。

这些出版物按照5年h-index、h-median,这两个指标去排序。

若想具体查看,排名中某出版物中哪些文章被引数最多,以及谁引用了这些文章,直接单击h-index,便可查看。

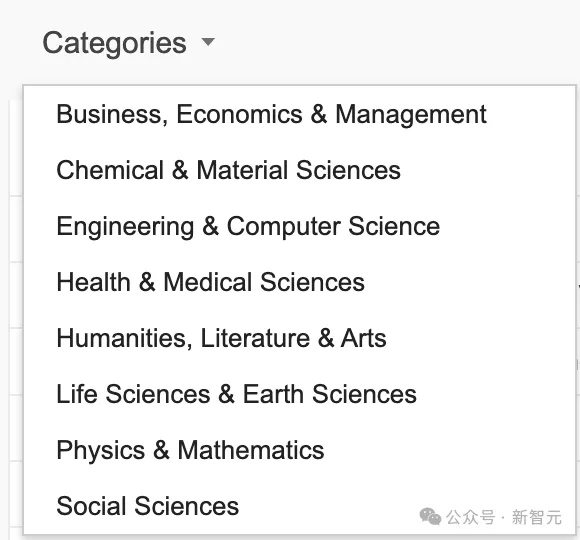

总榜,是不分类榜单。针对不同领域,比如工程&计算机视觉、物理&数学、化学&材料科学等,都有各自榜单排名。

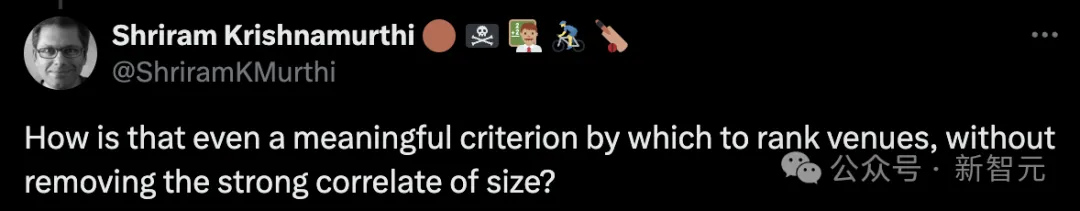

有网友发出质疑:如果不考虑「顶会规模」这一「强相关」的因素,这怎么可能成为一个有意义的评价顶会的标准呢?

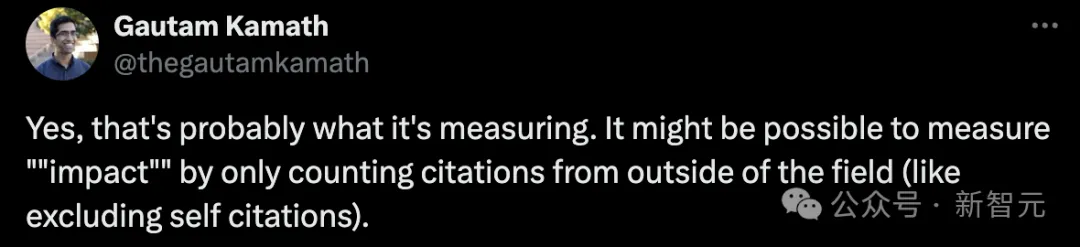

对此,Gautam Kamath称,是的这就是谷歌正在衡量的因素。我觉得这里有一个更好的衡量「影响力」的方法——只计算来自本领域外的引用(类似于排除「自引」)。

另有网友粗略计算了下,14个顶会中,仅有4个不收取出版费用。当然,虽然没有出版费用,但参加会议仍有其他相关费用,而且根据提交论文的数量等因素而变化。

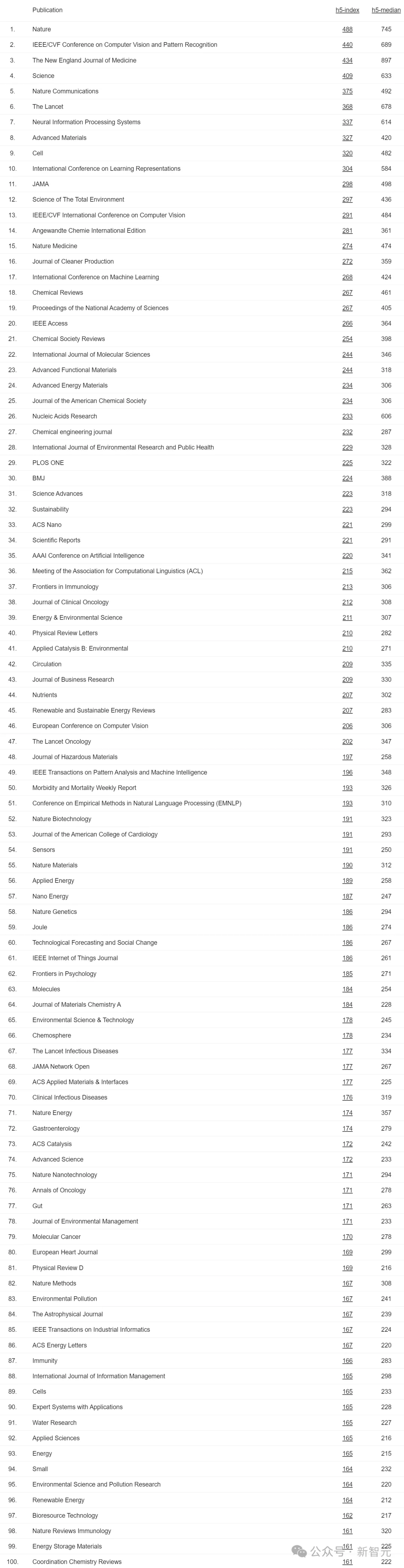

TOP 100名单

今年谷歌学术指标中,所有TOP 100名单如下: