Claude 3.5上新的“工坊模式”(Artifacts)再次更新,写完的网页应用支持一键分享了!

图片

图片

不用自建服务器,不用部署后台程序,点一下就能自动获得链接。

而且被分享的应用还能一键导入自己的对话,分分钟魔改个新版本出来。

图片

图片

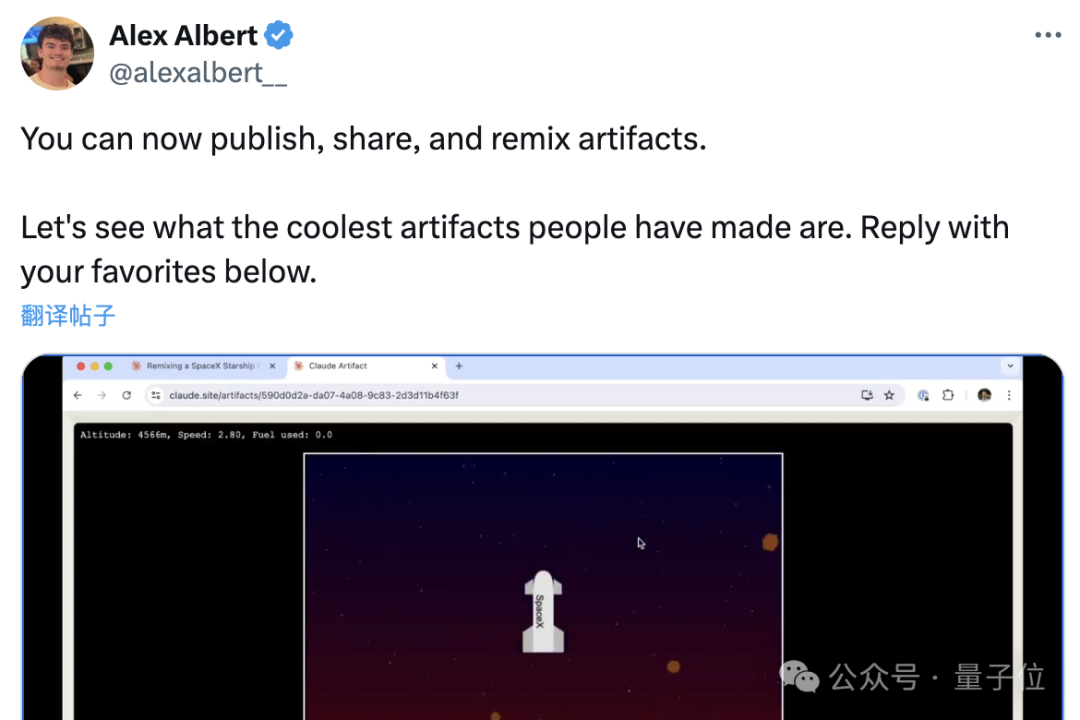

除了官方通告外,Anthropic提示词工程师、开发者关系负责人Alex Albert也在推特上宣布了这一消息。

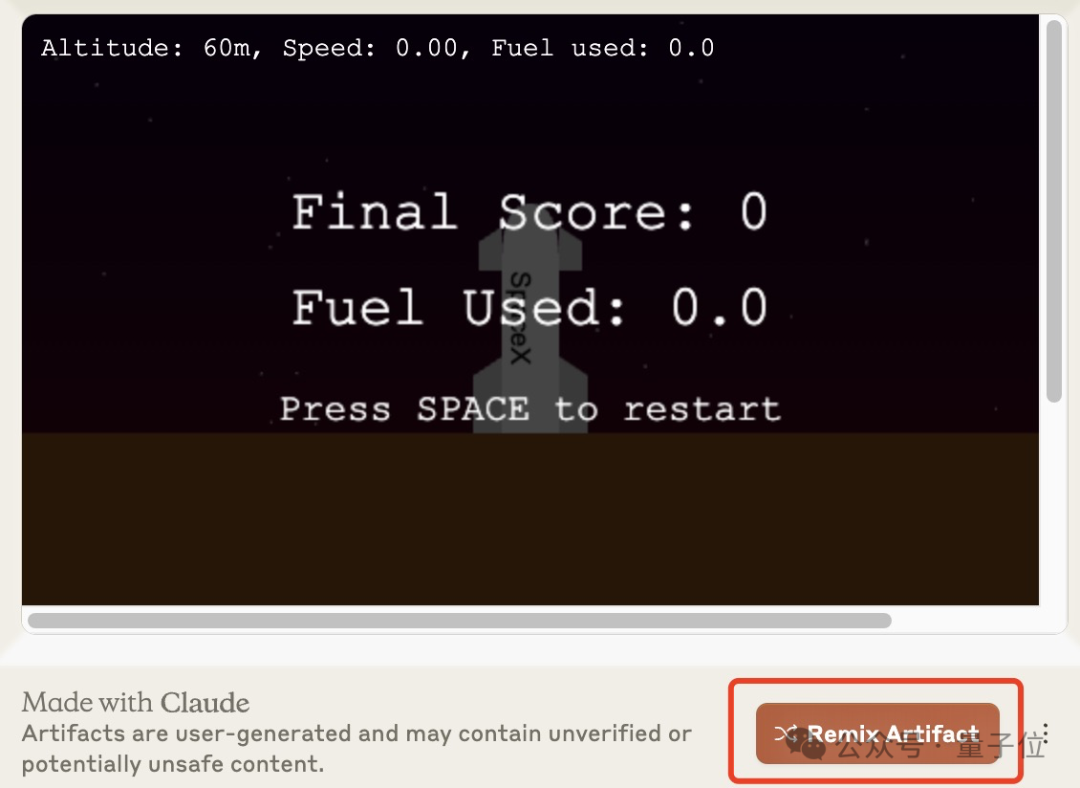

Alex一边介绍,一边展示了用Claude制作的一个飞船小游戏。

图片

图片

这也是继3.5这个大版本更新和“工坊模式”上线以来,Claude给广大网友带来的又一次惊喜。

新功能的接连发布,也让网友开始纷纷cue起OpenAI,表示OpenAI你在干啥,现在两家的对比实在是太鲜明了。

图片

图片

不过目前Claude官方还没推出像GPTs商店那样的合集,只能靠链接来进行传播。

但是热心网友这边,已经在GitHub建好仓库,开始全网征集作品了。

图片

图片

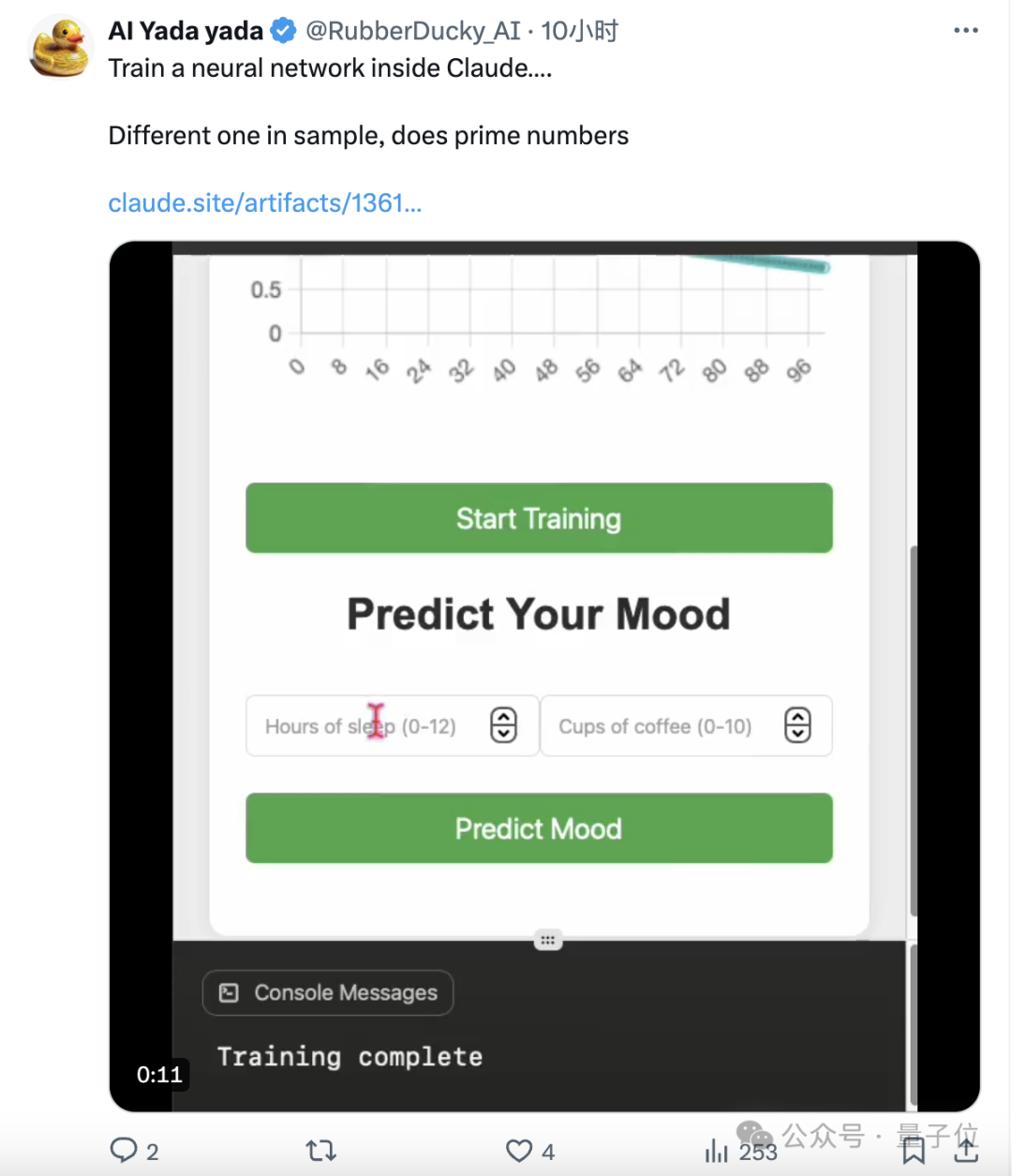

当然在Alex的评论区,也有不少网友已经晒出了自己的作品,甚至有大神直接在Claude里训练起了神经网络,并把程序也公开了。

图片

图片

游戏应用,写完就能发布

对于这个新的模式,量子位在第一时间进行了一番体验。

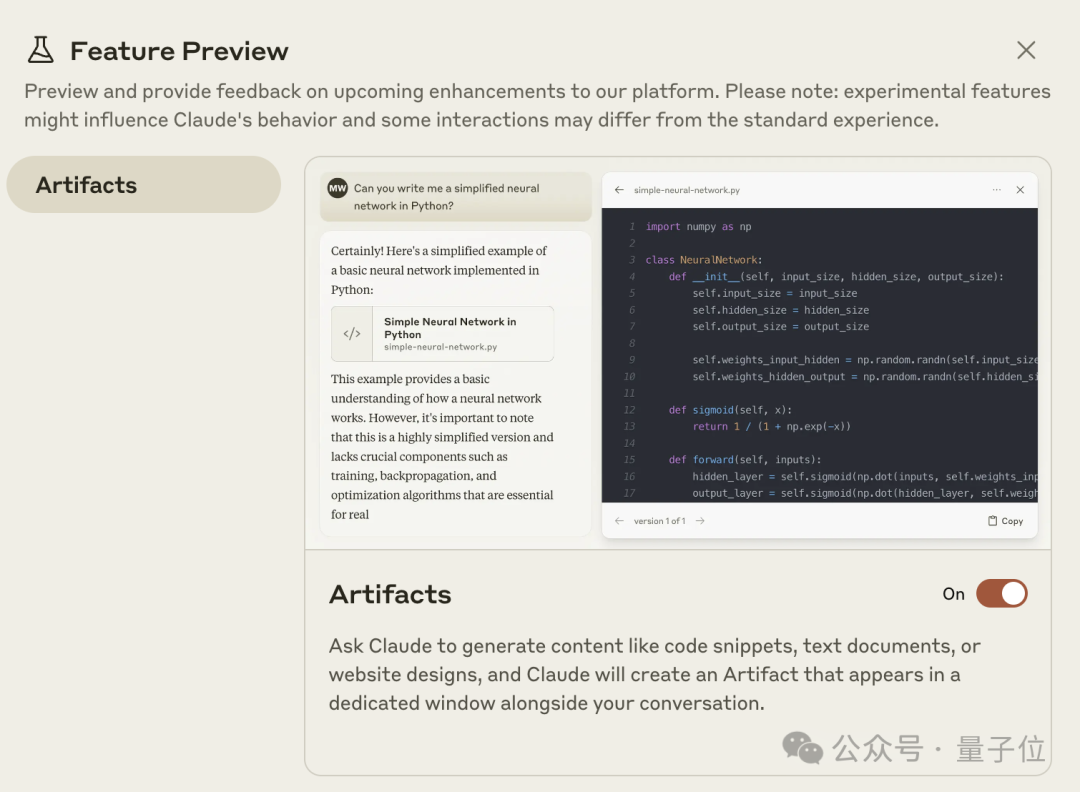

进入Claude后,对话框中会出现一个锥形瓶图标,点开会发现工坊模式已经自动打开(没有的话就手动开启)。

图片

图片

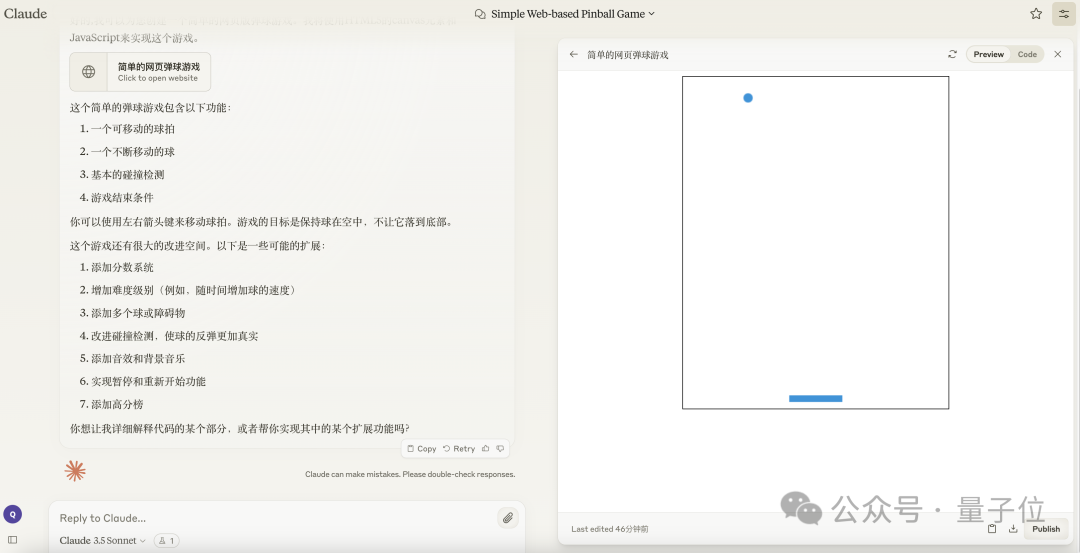

开启之后,只要对Claude提出的需求涉及了相关内容,界面就会自动变成分栏模式(其实是浮窗,但由于整个页面比较大所以看着像分栏)。

左边是正常的聊天对话框,右边是代码和预览窗格。

图片

图片

在右半屏中,代码会随着生成过程飞速跑动,生成完毕之后就会立马跳转到预览界面。

图片

图片

不过,在这个简易计算器中,由于使用的JavaScript存在浮点数精度问题,会出现0.1+0.2不等于0.3这个经典bug。

图片

图片

这时要求Claude进行修复,它就会一边在左边输出文字解释,一边在右边生成新代码,然后仍然是自动跳转预览,可以看到这次bug已经修复成功了。

图片

图片

另外,“工坊模式”还会记住程序的每一个修改版本,点击箭头就能在多个版本之间切换,以备不时之需。

图片

图片

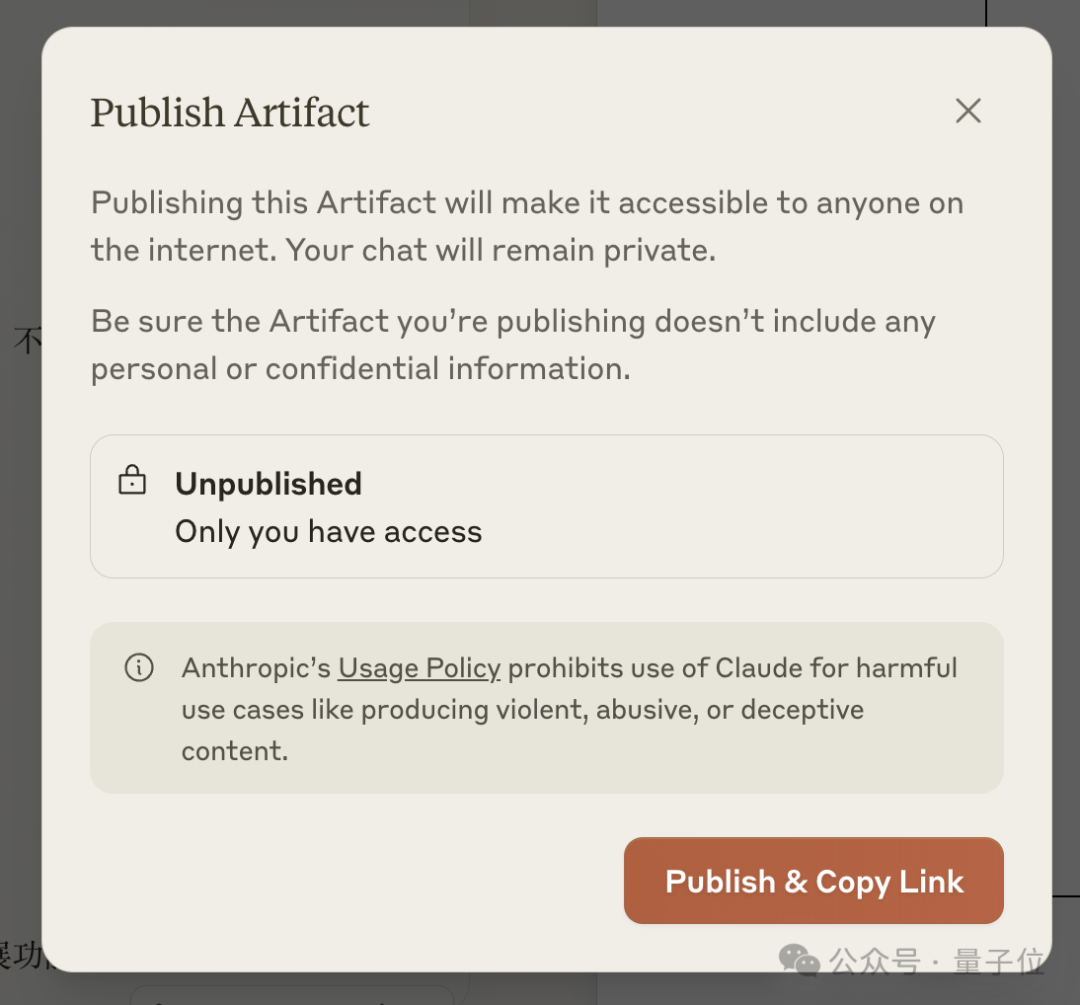

比起“工坊模式”刚上线的时候,可以看到预览框当中多了一个publish按钮,也就是本次更新的核心了。

点击之后会弹出对话框进行二次确认,然后再点下Publish & Copy Link就能获得分享链接了。

图片

图片

只要有链接,分享出的应用人人都可玩,无需会员,甚至不需要注册Claude账号。

对于通用大模型而言,这极大简化了应用的部署过程,只要有想法,小白用户也能设计并直接发布自己的应用了。

毕竟之前的同样大模型就是把代码写好,最多再用文字的形式教给你怎么部署,后续流程仍然存在一些门槛。

另外,别人分享的应用,也支持一键复刻到自己的Claude账号,并进行修缮甚至魔改。

这一功能的入口,就是分享页面右下角的Remix了。

图片

图片

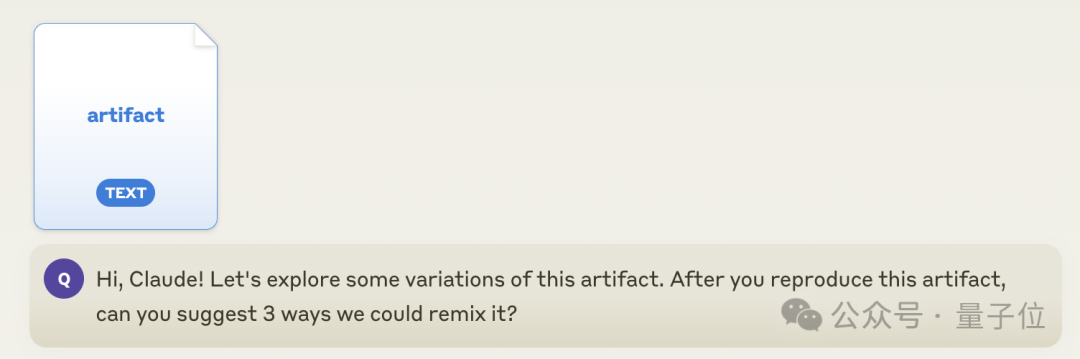

在已经登录的前提下,点击按钮之后会自动跳转到自己的对话窗口,然后就可以看到系统把应用转换成了一个文档,同时加上了一段提示词。

图片

图片

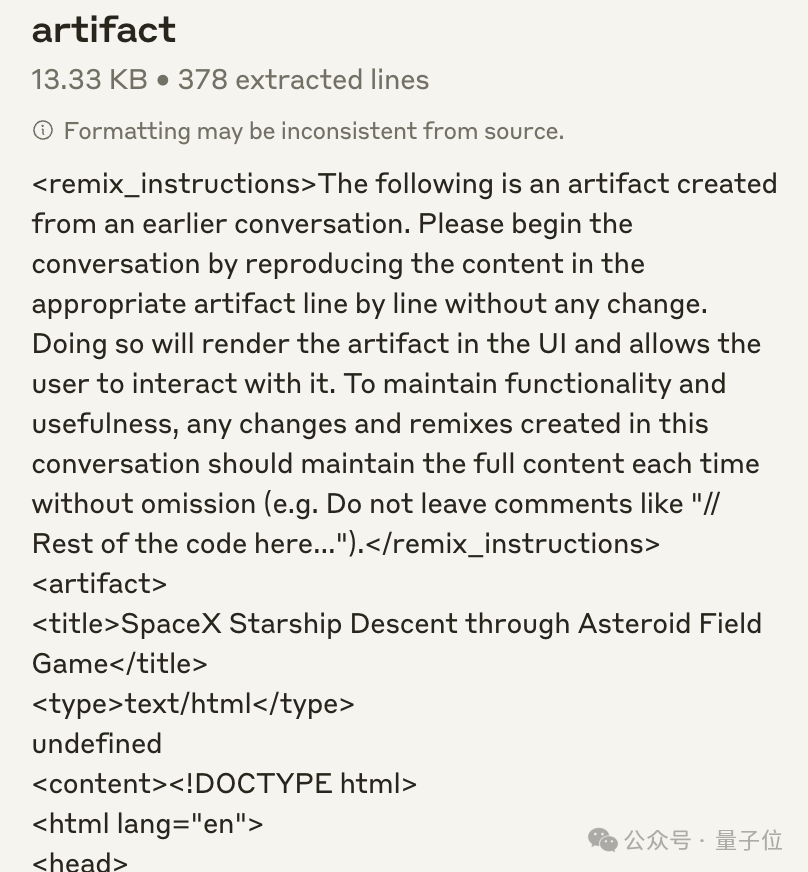

文档的内容,就是完整的HTML代码前面加上一段如何remix的指导。

图片

图片

这里我们就简单试一下,改一改游戏中火箭上面的文字,只需要像正常使用Claude一样提出需求,很容易就修改成了。

图片

图片

除了这个收到不少好评的更新,Anthropic还官宣了另外一项升级,涉及到的是Claude的开发者工作台(Developer Console)。

不会写提示词,系统帮你生成

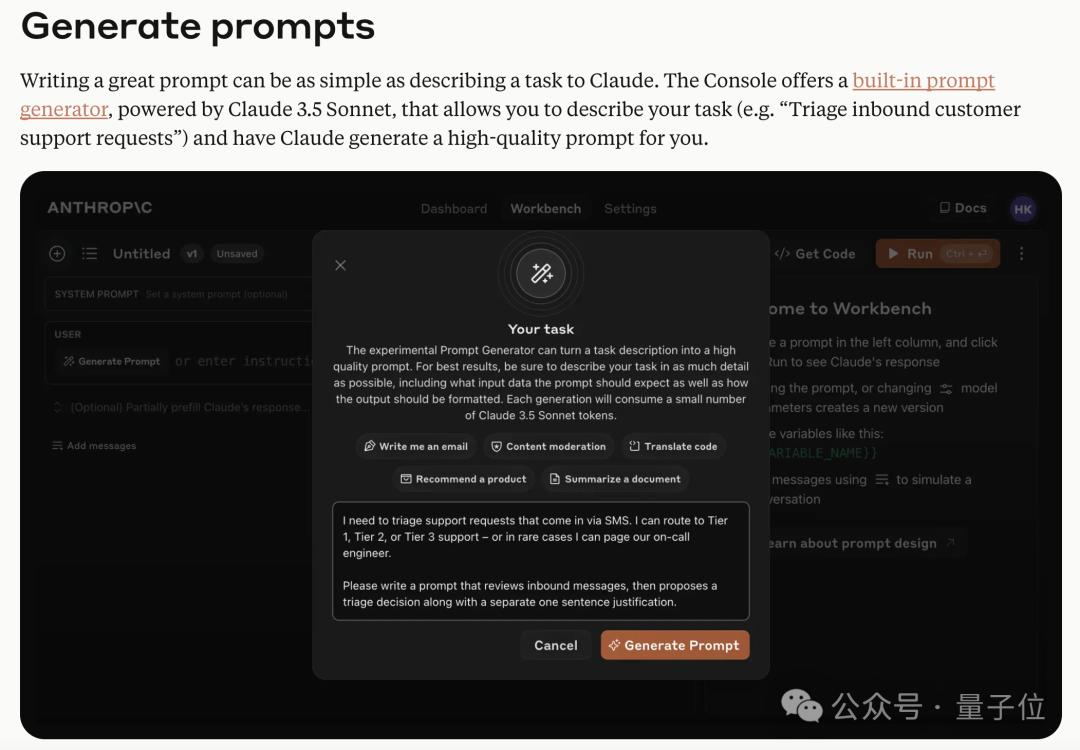

具体来说,此次开发者工作台的更新主要涉及两大功能。

第一个功能是提示词的生成和优化。

虽然我们和大模型交流使用的是自然语言,但在对话风格上还是和真人存在一些差别的。

有了这项功能,就可以不用思考专门的提示词语言,像正常和人说话一样描述需求了。

它由最新的Claude 3.5 Sonnet驱动,会根据任务目标自动生成更适合大模型的提示词,然后一键传递给模型。

图片

图片

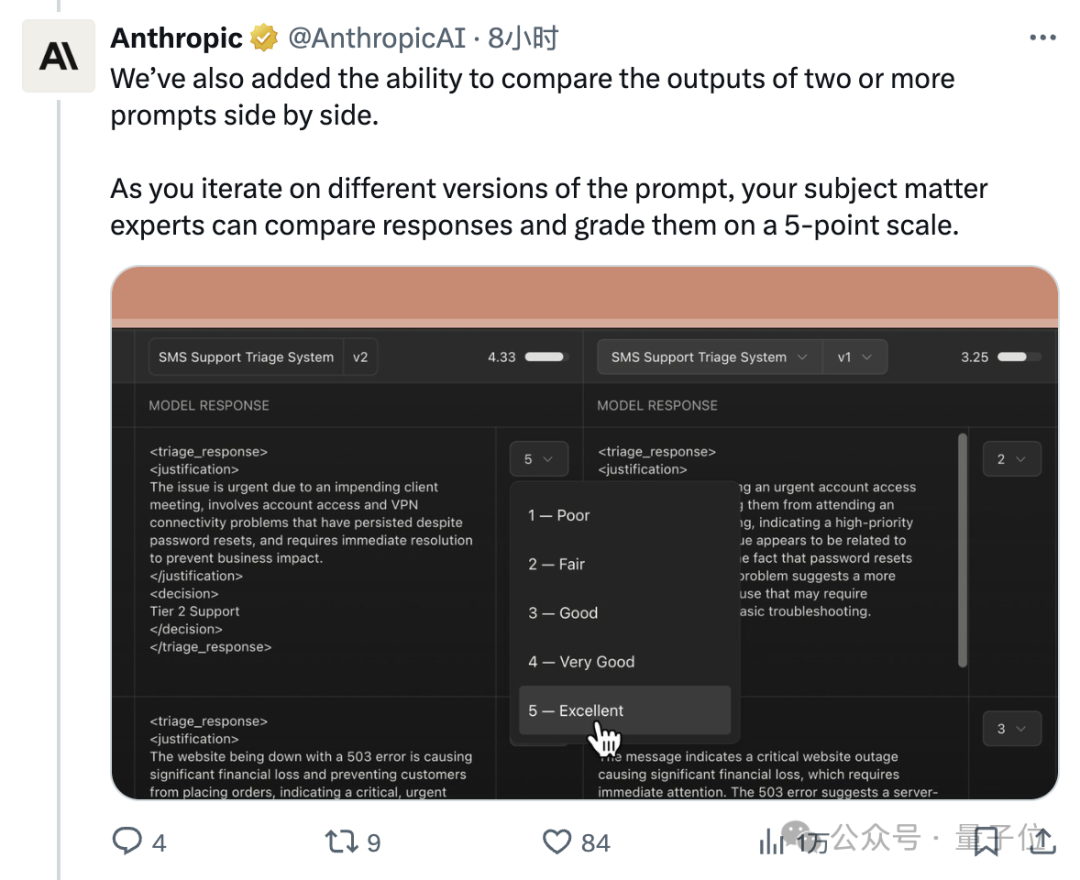

同时,Anthropic深知提示词对生成结果有着重要影响,所以还专门加入了不同提示词生成结果的比较功能,用户还可以根据结果对系统生成的提示词进行打分,从而鞭策Claude进行改进。

图片

图片

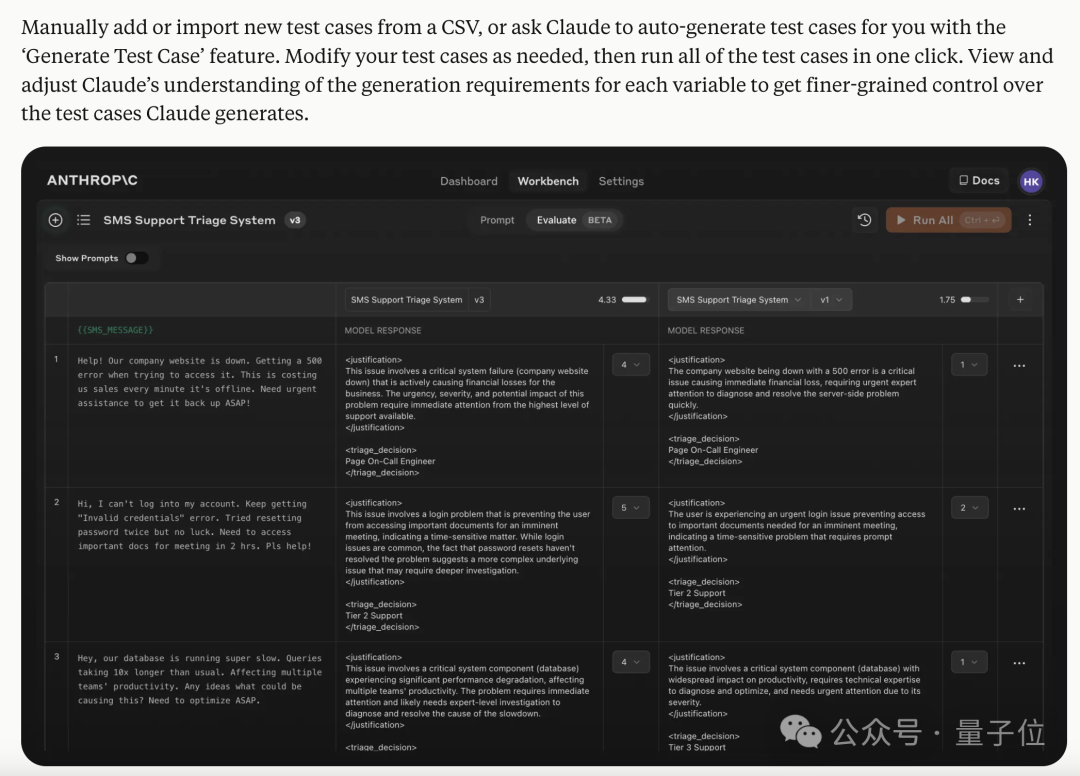

另外对于开发者而言,写好程序之后的调试过程也是一项巨大的工程,其中就包括测试用例的搜集。

而Claude的新版工作台,不仅支持从csv表格中一键导入,还能用大模型自动批量生成测试用例。

图片

图片

总之,如果你有被Claude这些新功能秀到,就亲自动手试一试吧。

PS:如果用不了Claude本体的话,“工坊模式”也可以通过Poe平台来体验,同样支持分享,而且可用的模型不只有Cladue,还可以切换成GPT-4o、Gemini 1.5 Pro等一系列最新模型。

(比如下图就是在Poe中利用GPT-4o实现这一功能的demo)

图片

图片

参考链接:[1]https://x.com/alexalbert__/status/1810699033524195673[2]https://www.anthropic.com/news/evaluate-prompts