AI行业巨大的收支鸿沟近日引起了广泛讨论,仅仅按照现在的训练成本计算,已经达到了5000亿美元的天文数字,许多人都在担忧AI泡沫被戳破之后,有可能会导致新的经济危机。

目前来看,能够商业化落地并实现大额盈利的「巨物」还未诞生,但是AI训练的成本却还在攀升,并且会逐年呈指数级增长。

Anthropic首席执行官Dario Amodei在In Good Company播客节目中表示,目前正在开发的人工智能模型的训练成本高达10亿美元。

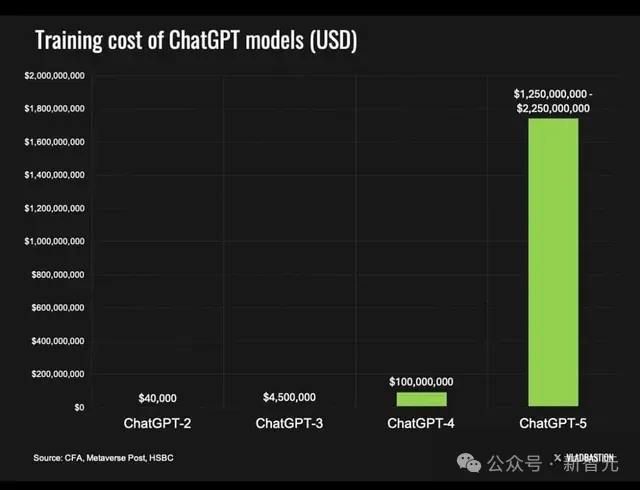

GPT-4o已经成为了历史,因为像它这样的模型「仅」需花费约1亿美元,跟现在正在开发的模型相比,可谓是小巫见大巫了。

Dario Amodei预计,从现在开始,短短三年内,AI模型的训练成本将上升到100亿美元甚至1000亿美元。

Dario Amodei,OpenAI前研究副总裁,2021年创立Claude大模型母公司Anthropic

预测来自于Amodei在讨论AI如何从生成式人工智能(GenAI)发展到通用人工智能(AGI)时的一段分析。

他说,「我们不会在某一点上突然达到 AGI,这将是一个循序渐进的发展过程,模型建立在过去模型发展的基础上,就像人类儿童的学习方式一样」。

如果人工智能模型每年强大十倍,我们可以合理地预期训练它们所需的硬件也至少强大十倍。

因此,硬件可能是人工智能训练中最大的成本驱动因素。「卖铲子」的英伟达又要赚得盆满钵满了。

早在2023年,就有报道称ChatGPT将需要超过30000个GPU,Sam Altman证实GPT-4的训练成本为1亿美元。

去年,超过380万个GPU交付给数据中心。鉴于英伟达最新的B200 AI芯片的成本约为 30000-40000 美元,两个数字相乘,我们就能明白Dario所言非虚——2024年AI训练成本已经高达10亿美元。

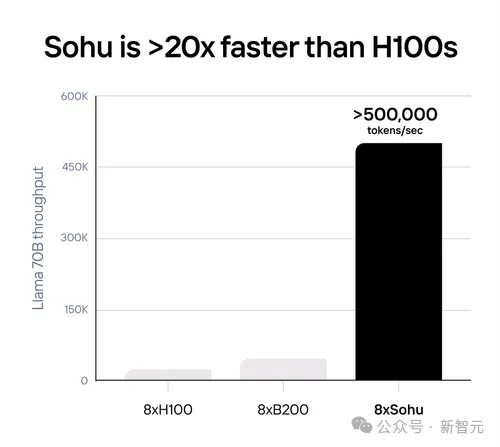

如果模型继续以当前的指数速度增长,那硬件资源也得跟上,缺口会越来越大,除非像Sohu人工智能芯片这样更高效的技术变得更加普遍。

我们已经可以看到这种指数级增长的发生。

埃隆·马斯克计划采购30万个B200 AI芯片,据报道OpenAI和微软正在计划建造一个价值1000亿美元的 AI 数据中心。

考虑到所有这些需求,如果英伟达和其他供应商能够跟上市场的步伐,明年GPU数据中心的交付量将激增至3800万个,是去年的10倍!

芯片硬件不是唯一掣肘的因素,电力和相关基础设施也是重要的成本损耗之一。

据估计,去年售出的所有数据中心GPU的总耗电量可为130万户家庭供电。

如果数据中心的电力需求继续呈指数级增长,那么当前足够的价格经济的电力将会被消耗殆尽。

此外,这些数据中心不仅需要发电厂,它们还需要一个完全升级的电网,以处理耗电量巨大的人工智能芯片运行所需的所有电子。

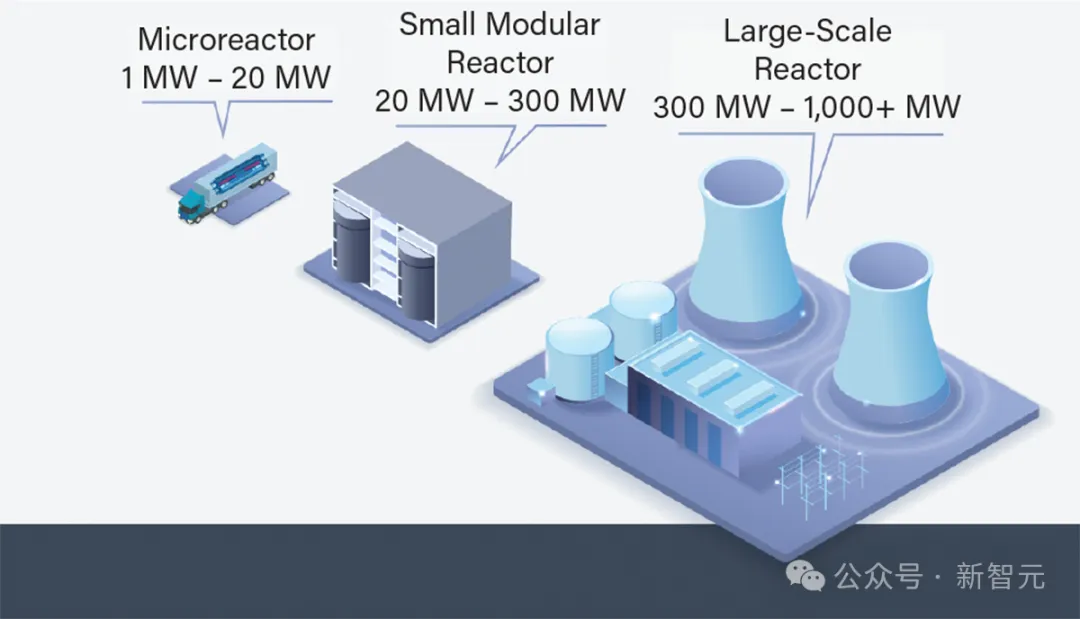

因此,包括微软在内的许多科技公司现在都在考虑为其数据中心采用模块化核电,微软正在寻找一位关键人物来领导其核技术战略,重点是为其数据中心实施小型模块化反应堆 (SMR) 和微反应堆。

那么,3年之内,AI训练成本真的会达到Anthropic所预测的1000亿美元吗?有没有更多的证据支撑呢?我们一起来算笔账看看——

1000亿美元怎么花?

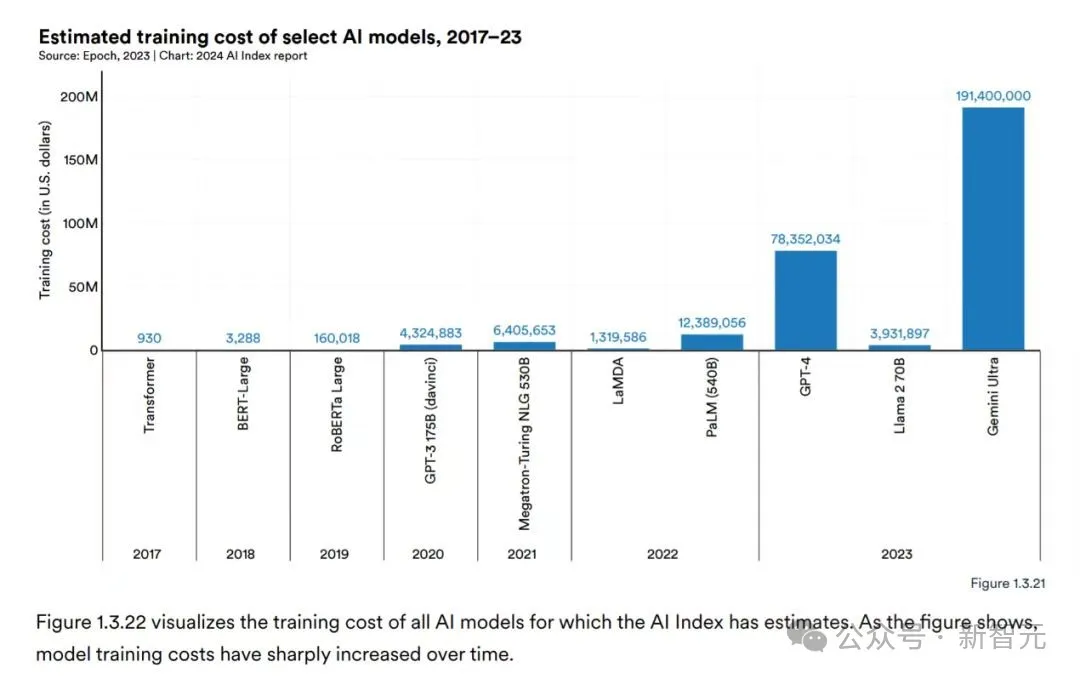

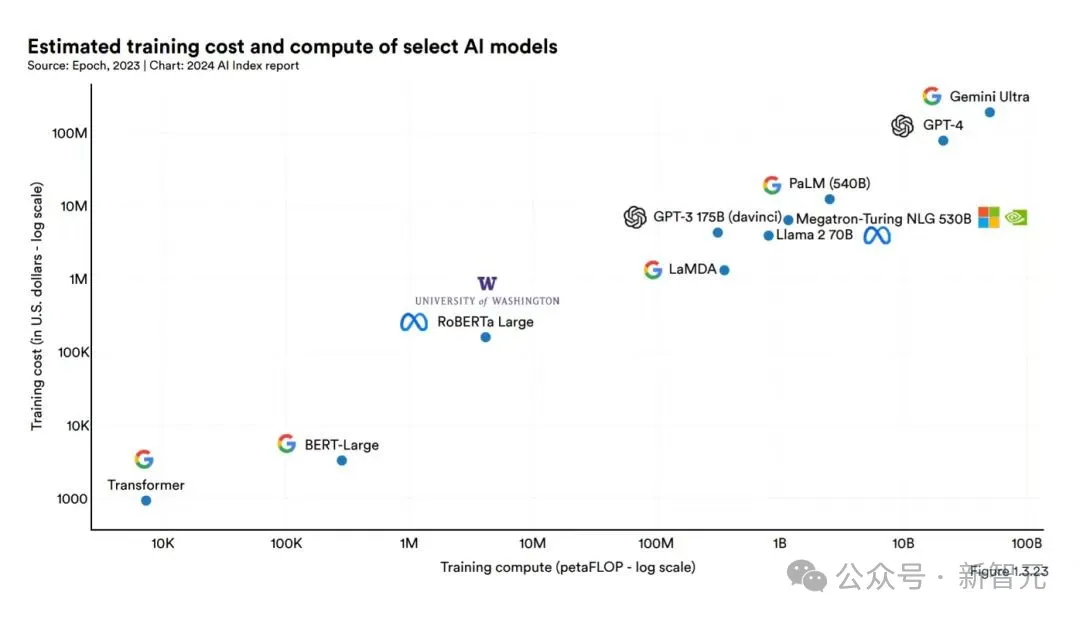

根据斯坦福大学《人工智能指数数据报告2024》显示,AI模型的训练成本呈现飞速增长,短短几年间从四位数跃升至九位数。

例如,2017年训练最初的Transformer模型的成本仅为约900美元,而到了2019年,RoBERTa Large模型的训练成本已经升至约160000美元。

到了2023年,OpenAI的GPT-4和Google的Gemini Ultra的训练成本更是分别达到了约7800万美元和近2亿美元。

报告指出,随着AI模型参数数量的激增,其训练所需的算力和能耗也随之水涨船高。

大参数模型通常意味着更高的训练成本,因为它们需要更强大的硬件设施、更长的训练时间以及更大的数据集来支撑。

这种关联性在报告中通过图表清晰地显示出参数数量与训练成本之间成正比例关系,参数越大,训练成本越高。

2亿已经数额颇为惊人了,那么十个指头都数不过来的千亿美刀会怎么花?

首先大头必定花在硬件成本上。

主要包括购置和维护高性能计算设备(如GPU、TPU、CPU集群等)的费用。这些设备是执行大量计算以训练大规模模型所必需的。

硬件成本占比较高,尤其是在需要大规模并行计算和高吞吐量存储的情况下。

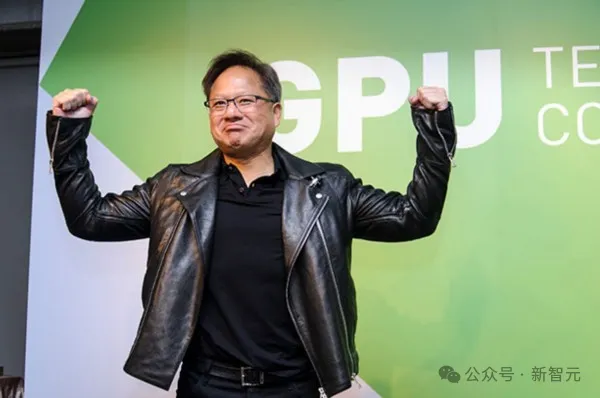

前几天马斯克刚透露花40亿美元购买10万张H100训练Grok 3,这会儿Amodei预言千亿训练模型,老黄屏幕背后微微一笑,又可以靠卖铲子买新皮衣了!

reddit网友也指出,千亿美元一大半要被老黄赚走。

黄仁勋:(兴奋地搓手手)

老黄家GPU产生的热量,把亿万资金烧的付之一炬。

也有网友打趣到,不管是GPU烧的热量还是未来百亿大单让人想想就红温,皮衣战神可以脱下他的经典皮肤散散热。

其次成本的重头还在于能源消耗。

有数据显示,全美AI数据中心的耗电量占全美总用电量的2.5%,足以点亮整个纽约市。

GPT-3的训练约消耗1300兆瓦时电力,如果连续播放视频可持续播放约186年。

由此可见,AI模型训练是一个高度能源密集的过程,涉及到大量的计算操作和数据交换。

数据中心的电力消耗、冷却设施运行以及潜在的碳排放成本构成了能源成本。随着对可持续性和碳中和目标的关注增加,这部分成本的重要性愈发凸显。

奥特曼曾经就表示,AGI的尽头可能是能源问题,核聚变或是AI能源战的最终方案。

微软已经表示,他们正在考虑建造一座价值1000亿美元的设施,其中最令人震惊的是对电力的投入。

首先需要解决能源问题,否则就不会有 AGl。大脑使用约20瓦特的功率,而粗放的使用方法消耗的功率相当于一个国家的使用量。

第三是人力资源的支出。

训练AI模型需要一支专业的工程师和科学家团队,包括数据工程师、AI研究员、软件工程师等。他们的薪资、福利、培训和发展成本构成了人力资源成本。

AI人才也是AI军备竞赛中一个不可忽视的兵家必争之地。大佬们纷纷开百万年薪,亲自发邮件挖人,亲自打电话留人等等,只为获得AI人才青睐。

第四就是数据成本的花销,高质量、大规模的训练数据对于AI模型的性能至关重要。

数据采集、标注、清洗、存储和传输等环节会产生相应的成本,包括人力、工具、平台使用费等。

对于某些特定领域的数据(如医疗影像、金融交易数据),数据获取可能涉及购买许可证、支付版权费等额外支出。

例如,Scale AI CEO就开出时薪40美元招聘高学历博士训练AI数据标注,只为获得专业性强的高质量数据。

最后要考虑运行维护和管理成本。

包括数据中心运维、网络带宽、安全防护、故障恢复、备份系统等的建设和维护费用。

随着模型规模的扩大和模型复杂度的提升,对基础设施的稳定性和可靠性要求更高。

其中,硬件成本和能源消耗占比较大,特别是在训练超大规模模型时,这两部分成本可能会占到总成本的大头。

随着AI技术的发展和应用规模的扩大,能源消耗问题的解决迫在眉睫。许多研究和实践已经开始探讨如何通过优化算法、提高硬件能效、采用可再生能源、采用液冷系统等方式降低AI训练的能源成本。

总体来说,资金在未来大规模流向AI领域早就可以预见,不过也有人怀疑如此大规模的千亿巨单钱从哪儿来?投入产出比又会如何?

虽说AI被类比为人类儿童的学习方式,但它可比「训练」人类小孩花费多得多,网友在投入产出比这块儿调侃道「请训练我好不好」。

谁在我身上花一千亿我搞不好也能达到一样的目标,训的比大多数人厉害呢。