大模型当上福尔摩斯,学会对视频异常进行检测了。

来自华中科技大学、百度、密歇根大学的研究团队,提出了一种可解释性的视频异常检测框架,名为Holmes-VAD。

Holmes-VAD不仅能给出精确的视频异常定位,还能够对检测到的异常提供解释和分析。

比如,给它看一段监控视频,询问它视频中是否有任何异常迹象,它立马就能识别出:

有异常,一辆白色面包车正在路上行驶,突然一辆摩托车出现并撞上了面包车,造成了一起严重的事故。

爆炸场景也不在话下:

视频显示在沙漠地区发生了一次大规模爆炸,导致大量烟尘飘到空中。这是异常的,因为在自然环境中,如此突然和强烈的能量释放是一种意料之外且不寻常的事件。

像是打篮球互相追逐竞争这样婶儿的具有迷惑性的视频,它也能正确识别并作出解释:

视频中展示的是一场典型的篮球比赛,球员们在一个维护良好的球场上比赛。这是一个常见且熟悉的体育赛事场景,没有任何不寻常或可疑的活动。

Holmes-VAD基于视频多模态大模型微调,并利用精确的时序监督和丰富的多模态指令来实现准确的异常定位和全面的解释,在监控视频安全分析、视频生成内容检验等领域具有广泛应用前景。

在定量和定性实验中,Holmes-VAD在多方面的表现优于此前SOTA方法。

除此外,研究团队还首次引入了视频异常检测领域的大规模多模态指令数据集——VAD-Instruct50k。

那么,Holmes-VAD、VAD-Instruct50k长啥样?

用数据引擎构建大规模数据集

首先,研究团队构建了首个大规模多模态VAD指令微调数据集,VAD-Instruct50k。

该数据集使用半自动数据引擎创建。

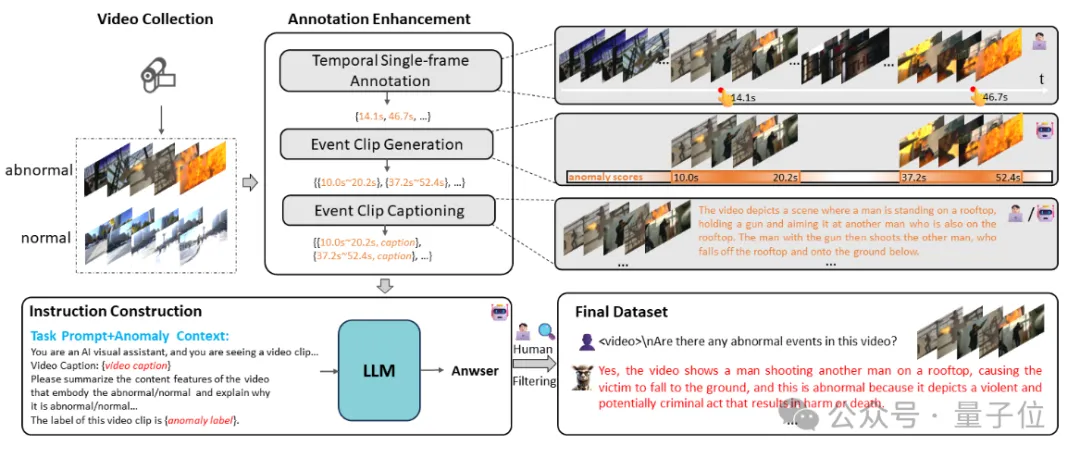

△数据引擎流程图

主要包括下列步骤:

时序单帧标注

研究团队采用了一种高效的时间注释方法,即标注涉异常事件中的随机单帧,用该方法来减小注释成本,利于扩大标注视频的数量。

事件片段生成

基于单帧注释,团队设计了一种可靠的伪帧级标签生成方法,对于每个具有单帧注释G = {gi}的异常视频及其由训练好的VAD网络估算的异常评分,在注释帧周围生成多个异常事件提议,对于正常视频,也随机提取若干正常事件提议。

完成此过程后,收集所有带有异常标签的剪辑事件片段:E={si, ei, yi},其中如果事件片段来自异常视频,则yi设置为视频的异常类别(例如,爆炸),否则设置为正常。

事件片段描述

为了充分提取事件片段中的语义信息,研究人员利用基于视频的多模态大型语言模型(MLLM)为每个事件片段生成详细的描述。

还包括Surveillance Vision数据集,该数据集为UCF-Crime视频片段提供了手动注释的详细细粒度事件描述。结合这些资源后,获得了所有带有相应描述和异常标签的事件片段:E={si, ei, yi, ci}。

异常对话生成

研究人员将异常标签和事件片段描述作为视频的文本信息,并设计丰富的异常内容提问,如:“Are there any unexpected or unusual events in the video clip?”。

将它们输入到大语言模型中进行分析回答,得到“视频-提问-回答”的指令对,最后对质量低下的指令对进行筛查过滤。

提出可解释视频异常检测框架

为实现开放世界的视频异常检测(VAD),现有的方法在面对具有挑战性或未见过的事件时往往表现出偏见,并且不能对异常内容作出解释。

基于VAD-Instruct50k,研究团队设计了一种可解释视频异常检测框架Holmes-VAD。

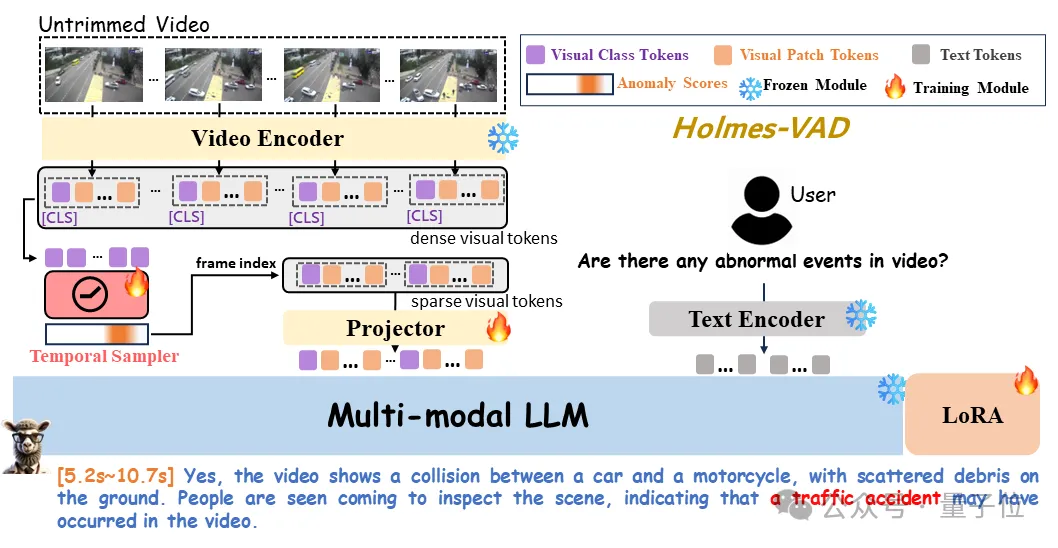

△HolmesVAD网络框架

其由下列部分组成:

视觉编码器

研究团队利用LanguageBind中冻结的视频编码器,该编码器继承了CLIP的ViT-L/14结构,称之为ϕv。

与原始的ViT不同,它通过在时间维度上添加自注意力层来建模帧之间的时间关系。

时序采样器

由于视频中大量视觉tokens导致的过度计算负担,过去基于视频的MLLM方法采用了视频的均匀时间帧采样,例如8帧。

研究团队认为这种方法显然不适用于视频异常检测任务中的长视频,因为它增加了忽略关键信息的概率。

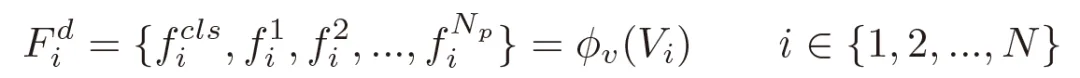

为了解决这个问题,团队首先利用VAD网络评估每帧的异常分数,该网络接收视频帧的cls token并输出异常分数:

然后,根据异常分数对视频标记进行采样。

具体来说,只有对应异常分数高于设定阈值的帧对应的tokens会被输入到LLM中,通过这种方式,模型可以对长视频做出高效响应。

LLM

为了使LLM理解视觉编码器输出的特征,在它们之间设计了一个由两层MLP组成的projector,与LLM的输入维度对齐,团队使用Vicuna作为LLM。

效果如何?

在训练过程中,时序上的单帧异常标注被用于训练时间采样器来选择具有高异常响应的帧,数据集中的异常相关对话内容被用于微调多模态大语言模型(MLLM)来生成解释性内容。

研究人员进行了大量定量和定性实验分析,结果验证了所提出的Holmes-VAD的通用性和可解释性。

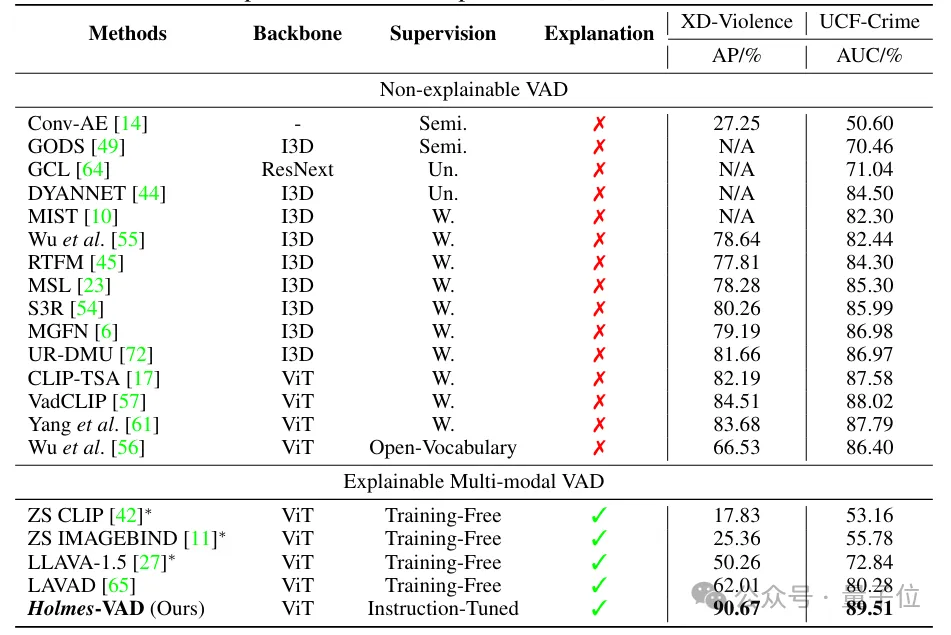

定量评估方面,研究人员将本文方法与最先进的方法进行了比较,包括半监督方法、无监督方法、弱监督方法和最近的Training-Free方法。

下表1中列出了它们的骨干网络、监督方法以及在UCF-Crime和XD-Violence数据集上的表现。

Holmes-VAD方法在XD-Violence上的AP为90.67%,在UCF-Crime上的AUC为89.51%,显著超越了之前的最先进方法,证明了该方法可以生成更少偏见的异常评分。

△表1.视频异常检测性能比较

值得一提的是,Holmes-VAD实现了精确的异常定位的同时,还能够对模型检测到的异常提供解释和分析,这是现有不可解释的VAD方法所不具备的功能。

虽然LAVAD具有可解释性,但由于缺乏足够的监督数据,这种无训练的大型语言模型对异常知识的理解有限。

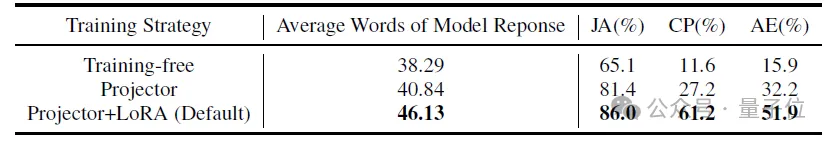

此外,研究人员还进行了用户研究,通过86个测试样本和10名志愿者评估了三种不同的训练策略:

- 无训练:不进行微调;

- Projector:在VAD-Instruct50k上进行微调,仅训练投影器,而保持多模态LLM固定;

- Projector+LoRA:在VAD-Instruct50k上进行微调,训练投影器并使用LoRA 微调多模态LLM。

如表2所示,投影器+LoRA提供了最详细的响应(平均46.13个词)并达到了最高的判断准确率(86.0%)。

此外,它在内容感知和异常解释方面也达到了最高的投票率,分别为61.2%和51.9%。

△表2.不同微调策略的影响

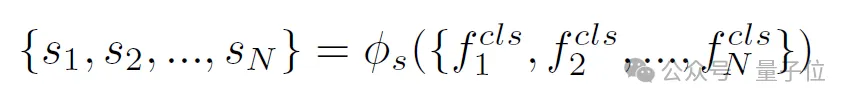

定性结果方面,研究人员将Holmes-VAD的可解释性结果与Video-LLaVA(未经过微调)进行比较。正确和错误的解释分别用绿色和红色表示。

结果表明,Holmes-VAD能够准确识别视频中的异常,并为体育比赛中的冲突、爆炸和车载摄像头捕捉到的事故(异常案例)提供具体解释。

即使是对于正常视频,Holmes-VAD也展现出强大的分析能力,纠正了时间采样器的错误响应(正常案例)。这些发现突显了Holmes-VAD在感知视频事件和分析异常方面的有效性和优势。

项目主页:https://holmesvad.github.io/

论文地址:https://arxiv.org/abs/2406.12235