本文经自动驾驶之心公众号授权转载,转载请联系出处。

Sky Shaw

目前的话,我认为若是探索、讨论和分析一些SLAM领域的新方向的话,除了对目前已有的算法进行较完整的分析外,再就是结合实际落地的困难点进行单方向的深入研究了。

本人在之前的文章中针对激光SLAM中的挑战和阶段进行过一次简单地分析,SLAM技术综述、挑战和阶段分析。

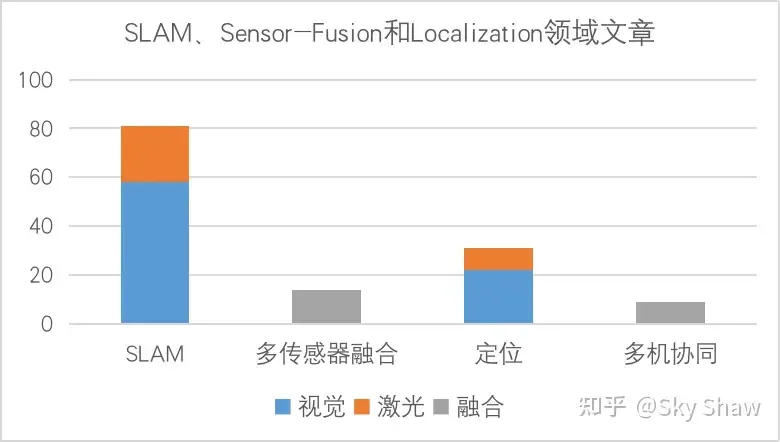

截止至2022年5月24日,2022年ICRA总共收到了3344篇文章的申请,最终1498篇文章通过审核上线发表。在这优秀的1498篇文章中,SLAM、Sensor-Fusion和Localization领域的文章简单整理下来有140篇左右,再进一步细分Visual SLAM相关领域的有大约58篇,利用视觉传感器进行定位的相关论文大约有22篇,Lidar SLAM相关领域文章大约是23篇,基于雷达传感器的定位模块的相关论文就只有9篇左右。由上可见,视觉方向的相关研究相较于激光方向还是更加收科研人员和审稿者青睐,从工业落地和传感器性能发展的角度上分析的话,人们还是希望能将实现该技术所产生的费用降到global min,同时从发表的论文主题上看,越来越多的优秀科研人员已经在视觉和激光传感器的融合方向上做出了突出的成绩,往后展望多传感器融合的工作还能继续挖掘,并且相对来说较容易做出“成果”

最后,笼统的来说,可以先考虑一个绝对安全的前提环境(也就是感知和决策功能100%无故障运行),自主移动机器人的大规模落地对SLAM的性能指标方向可以归纳为三类:鲁棒性、精度和效率,往下细分一些具体的方向和困难的话,我个人认为还有以下几个方面可以深入研究和分析:

- 退化场景下给位姿估带来的挑战

- 传感器失效时给融合技术带来的挑战

- 动态场景中作业给SLAM带来的难点及其life-long问题落地的挑战

- Large-Scale SLAM技术落地的挑战

- SLAM(Localization)技术在低算力处理器上的实时性挑战

- SLAM技术输出的“地图”最终的形态到底应该是何种表现形式的疑问

以上问题的具体分析可详见:ICRA 2022 All PaperList | 给SLAM研究带来的启发 | SLAM领域研究方向的思考

以上是我个人的抛砖引玉了,上述内容如若存在不严谨和错误的地方,还望大佬们批评和指正。同时,希望有更多的大佬们来讨论这个问题。我是致力于机器人和自动驾驶技术研究的Sky Shaw,乐衷于在知乎上分享前沿技术的分析和个人职业经验,欢迎大家点赞和关注支持

殷鹏

这个问题关注的人好少,slam领域还是太冷清了。

可以研究的方向有一堆啊,跟cv结合,跟rl结合,跟gan结合,和nerf绑定,跟决策结合等。问题不在于有什么大方向,而在于什么是slam。

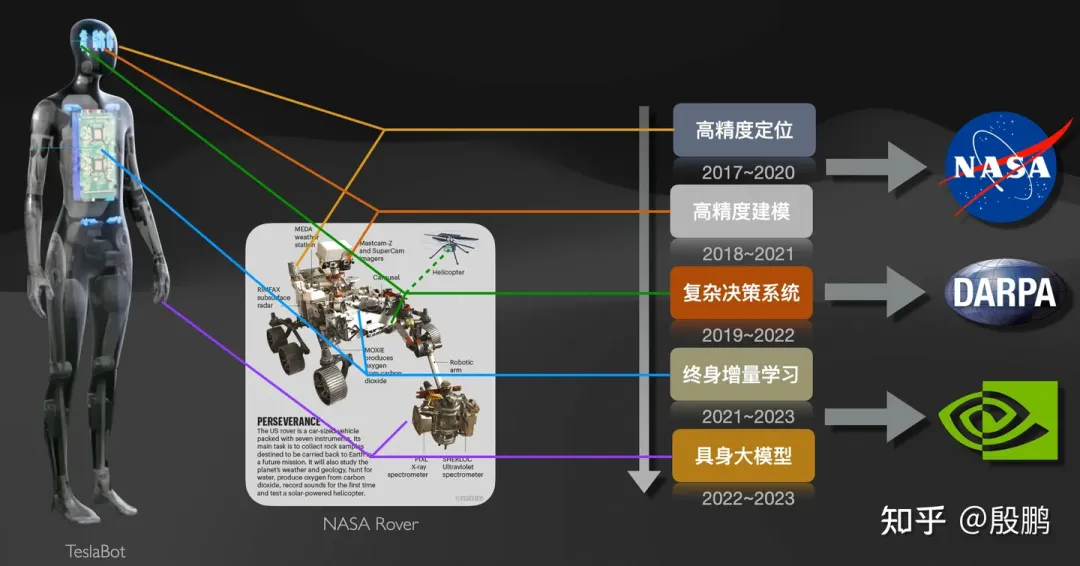

其实SLAM的研究热点不只是里程计这些算法,它里面所涉及的场景识别和数据耦合在当前大模型+机器人的时代背景下,变得越来越重要,甚至包括跟强化学习的高度耦合。虽然SLAM这个领域已经诞生了几十年,但是我始终感觉,SLAM的核心热点才刚刚开始。我在之前的一个帖子里面详细的展开了一些讨论,后面也会和大家多多分享SLAM的最前沿进展。

在机器人/自动驾驶中,强化学习和slam哪个方向更有前景?

不可否认的是,在最近一段时间,SLAM领域灌水的文章确实层出不穷,各种各样类型的数据融合算法、视觉/激光里程计方法都在讲述同一个故事,但是本质上很少有太大的创新性。但是正如在很多脑神经方面的文章分析所得,哺乳动物都存在一个类似的“海马”模样的零部件,就叫做海马回“Hippocampus”。它复杂了智能体的定位和记忆能力,而这种能力又跟智能体自身的行为优化(强化学习)密切相关。因此如何把SLAM的基础技能和智能体的行为优化绑定起来,会是以后SLAM领域的一个核心研究热点。在这个方面上我们也有一些列工作,而且随着Lifelong Leanring和大模型的进化,这个领域也会变大越来越具备使用价值。

换句话说,SLAM不再是定位+建模这两件小事情,而是指引智能体进化的核心引擎之一。

具体请参考我在SLAM/RL中的考虑。

solomon-ma

这可多了去了呀拆分SLAM看看,无非是定位和建图两大部分。

定位:

- 结合大语言模型定位

- 结合语义地图定位

- 没有地图,边探索边定位(未知环境下如何快速定位)

- 场景图构建

- 开放场景下定位

建图:

- 构建稠密地图(mesh)

- “实时”构建稠密地图(mesh)

- 多智能体配合建图(mesh)

- 构建层次化地图

- 自主建图(机器人自主判断下一个视角位置)

把SLAM当成个组件,往上走:

- object navigation

- social navigation

- image navigation

- image arrangement

刘斯坦

代码是挺多的,就是没一个能用的。SLAM的框架,随便哪一个,拉出来就是巨大的一个东西,每个小部分都需要调设置参数。前前后后加起来的设置能有四五十个,互相之间还有逻辑联系!

给我一个场景,我慢慢调,总能调出能用的那么一组参数。一个视频某一帧跟丢了,找几个阈值调一调,最终总是能连上。但要找到一组参数放心的让他随便跑,那是不可能的。

各种SLAM框架的鲁棒性还是太差了,不说一组参数跑到底吧,能够想办法对场景进行自适应参数调节那也是不错的。我觉得这个方向大有可为,至少我在工作的时候,会被迫去实现这个,但似乎没见过这方面的论文。

格雷伍德斯堪

我认为在学术上面,SLAM仍然有着很大的提升空间,而题主所说的在工业方面的落地,仍然也有着很长的路要走。

学术上,目前SLAM系统大概是厘米级别的精度,那么如何提升到毫米级别呢?显然需要更高精度的传感器,而如果引入新的传感器的话,那么又会涉及到优化的问题,大家都用位姿图,都用滑窗,那么这其中最底层的数学原理是不是也能够创新呢?显然这也是一个待解决的问题,而引入新的传感器后如何进行时间同步呢?毕竟也不是所有的传感器都支持硬件触发。而且在优化的过程中,如果位姿图规模过大,SLAM实时性又会出现问题,因此如何能够权衡SLAM精度和实时性呢?相似的问题还有很多。

除了增加传感器,再来谈一谈算法和特征的角度,ORBSLAM只用了特征点,众所周知,特征点只占了一幅图像中的很少一部分,也就是说ORBSLAM是稀疏特征点以及匹配的系统,那么剩下的数目巨大的像素点呢,我们是否也可以考虑通过ICP等方法来充分利用呢?而且仅仅基于特征点的话在室内环境中也会出现特征数量不足的问题,那么我们也可以进一步充分利用图像中检测到的特征线以及平面,以及线和面之间都有特殊的几何关系,比如平行,正交,亦或是一些其他的特殊结构,如果我们能够将这些引入到整个SLAM或者优化系统当中,那么是否能让系统更加鲁棒呢?跑过SLAM的同学都有体会,如果在一些快速转弯的地方很容易出现追踪失败的问题,那么在一些极端条件下,我们是否能通过一些registration的方法来计算出pose从而使系统更加稳定呢?

类似的问题还有很多,如果从语义理解以及场景理解来说,SLAM系统仍有很大的提升空间,SLAM+DL, SLAM+RL?

很多方向都可以进行思考至于工业界落地的话,就要平衡好SLAM的实时性 内存消耗 以及 鲁棒性的问题,需要考虑的也有很多。

本人也是SLAM小学生,刚刚学习不到两年,回答中如有不严谨或者错误的地方,欢迎大家指正。

IRPN-HKUST(GZ)

本人推荐如下两个方向:

- 动态场景下的SLAM(基于神经网络和/或多视图几何约束);

- 三维场景/物体重建及渲染(基于神经网络,利用几何先验和/或语义信息)和SLAM相结合。