YOLO 的全称“You Only Look Once”,它通过引入一种与传统方法截然不同的方法,彻底改变了物体检测领域。YOLO 摆脱了传统的提案驱动技术,创新地在一次传递中直接从完整图像中预测边界框和类别概率。这种突破常规的做法不仅简化了物体检测流程,还显著加快了检测速度,使实时检测不仅成为可能,而且成为现实。

概念概述

YOLO 创新方法的核心是将对象检测视为单一回归问题的概念,从图像像素直接到边界框坐标和类别概率。以下是 YOLO 如何实现这一点的细分:

- 网格划分: YOLO 首先将输入图像划分为S × S网格。每个网格单元负责预测中心位于该单元内的物体。这种划分使模型能够定位物体并确保检测分布在图像上。

- 边界框预测:对于每个网格单元,YOLO 会预测多个边界框。每个边界框预测包括坐标(中心、宽度和高度)以及置信度分数,该分数反映了边界框的准确性以及该框包含特定对象的可能性。

- 类别概率:除了边界框预测之外,每个网格单元还会预测其检测到的对象属于哪个类别的概率。这些概率取决于包含对象的网格单元。

- 组合预测: YOLO 流程的最后一步是将边界框预测与类别概率相结合,以提供完整的检测输出。每个边界框的置信度分数由类别概率调整,确保检测既反映边界框的准确性,又反映模型对对象类别的置信度。

这种简化的方法可以同时分析图像的每个部分,从而使 YOLO 能够实现惊人的速度,同时又不影响准确性。YOLO 只需查看一次整个图像(因此得名),就可以了解图像的全局背景,从而减少误报,并使其在实时应用中非常高效。YOLO 架构的简单性和有效性不仅使其成为对象检测任务的热门选择,而且还激发了该领域的进一步创新和研究,突破了计算机视觉的极限。

YOLO 架构揭晓

从图像到预测

YOLO 架构是一个引人注目的例子,展示了如何利用卷积神经网络 (CNN) 完成物体检测等复杂任务。与可能输出单个类别概率向量的传统 CNN 不同,YOLO 架构旨在输出包含边界框预测和类别概率的多维张量。以下是它如何处理图像的概述:

- 卷积主干: YOLO 使用一系列卷积层作为主干。这些层负责从输入图像中提取特征。这些层的架构在 YOLO 的不同版本(例如 YOLOv3、YOLOv4 等)之间可能有所不同,每个版本都旨在在速度和准确性之间取得平衡。

- 特征提取:当图像穿过卷积层时,网络会提取和下采样特征,从而创建一个丰富的特征图,其中包含检测所需的基本信息。

- 预测层:在网络末端,YOLO 过渡到预测层,该层通常是具有特定数量滤波器的卷积层。这些滤波器对应于每个网格单元的预测向量,包括边界框坐标、置信度分数和类别概率。

- 输出张量:输出是形状为 ( S × S ×( B ×5+ C )) 的张量,其中S × S是网格大小,B是每个网格单元的边界框数量,55 表示四个边界框坐标加上置信度分数,C表示类别数量。此张量封装了网络对图像进行的所有检测。

代码片段:加载和使用预训练的 YOLO 模型

以下是一个简化的 Python 示例,演示如何使用流行的深度学习框架(例如 TensorFlow 或 PyTorch)加载预训练的 YOLO 模型并对图像执行对象检测。此示例假设使用 PyTorch 并且可以使用预训练的 YOLO 模型:

import torch

import torchvision.transforms as transforms

from PIL import Image

# Load a pre-trained YOLO model

model = torch.hub.load('ultralytics/yolov5', 'yolov5s', pretrained=True)

# Function to perform object detection

def detect_objects(image_path):

# Load and transform the image

image = Image.open(image_path)

transform = transforms.Compose([

transforms.ToTensor(),

])

image = transform(image).unsqueeze(0) # Add batch dimension

# Perform inference

model.eval() # Set the model to evaluation mode

with torch.no_grad():

predictions = model(image)

# Process predictions

# Note: The output format can vary, so adjust the processing as needed

for pred in predictions[0]:

bbox = pred[:4] # Bounding box coordinates

score = pred[4] # Confidence score

class_id = pred[5] # Class ID

print(f'Class: {class_id}, Score: {score}, BBox: {bbox}')

# Example usage

detect_objects('path/to/your/image.jpg')此代码片段提供了加载 YOLO 模型和执行对象检测的基本框架。实际实现细节(例如处理输出格式和置信度分数的阈值)将取决于所使用的 YOLO 的具体模型和版本。

训练 YOLO 模型

学会观察

训练 YOLO 模型涉及一个独特而复杂的过程,这主要是由于其独特的输出格式以及同时预测多个边界框和类概率。此训练过程的一个关键方面是 YOLO 采用的专门损失函数,该函数旨在有效地最小化预测任务不同部分之间的误差。此损失函数通常包含几个部分:

- 定位损失:损失函数的这一部分惩罚边界框预测位置和大小的误差。它通常关注预测边界框坐标与地面真实坐标之间的差异,通常使用诸如平方误差和之类的度量。

- 置信度损失:此组件惩罚边界框置信度分数中的错误。置信度分数反映了模型对边界框包含物体的确定性以及模型认为边界框的准确度。对于包含物体的边界框和不包含物体的边界框,计算的损失不同,以帮助模型区分这两种情况。

- 分类损失:损失函数的这一部分针对每个网格单元的类别概率预测。它通常涉及预测概率和独热编码的真实类别标签之间的分类交叉熵损失。

总损失是这些成分的加权和,平衡了定位、置信度和分类错误对整体训练目标的贡献。

代码片段:YOLO 的训练设置

下面是一个简化的示例,演示了训练 YOLO 模型的设置。此示例是概念性的,旨在说明配置训练过程所涉及的关键组件,包括损失函数和优化。实际实施将根据 YOLO 的具体版本和所使用的深度学习框架而有所不同:

import torch

import torch.optim as optim

# Assuming yolo_model is your YOLO model and train_loader is your data loader

# Define the optimizer

optimizer = optim.Adam(yolo_model.parameters(), lr=0.001)

# Placeholder for the YOLO loss function

# Note: You'll need to define this based on the specific YOLO version and its output format

def yolo_loss(predictions, targets):

# Compute localization loss, confidence loss, and classification loss

# localization_loss = ...

# confidence_loss = ...

# classification_loss = ...

# Combine the losses

total_loss = localization_loss + confidence_loss + classification_loss

return total_loss

# Training loop

for epoch in range(num_epochs):

for images, targets in train_loader: # Assuming targets contain ground truth

optimizer.zero_grad() # Zero the gradients

# Forward pass

predictions = yolo_model(images)

# Compute loss

loss = yolo_loss(predictions, targets)

# Backward pass and optimize

loss.backward()

optimizer.step()

print(f'Epoch [{epoch+1}/{num_epochs}], Loss: {loss.item()}')此代码提供了设置 YOLO 模型训练循环的基本框架,重点介绍了使用专门的损失函数来解决 YOLO 预测任务的独特方面。实际损失函数的实现、优化器的选择和其他训练超参数可以根据任务和数据集的具体要求进行调整。

YOLO 实际应用:真实世界的应用

超越基础

YOLO 物体检测系统以其速度和准确性而闻名,使其成为需要实时处理和可靠检测的众多实际应用的理想选择。它处理动态和具有挑战性的环境的能力已在各个领域得到证实:

- 监控:YOLO 的实时处理能力在监控系统中特别有用,它可以同时检测和跟踪多个物体,例如个人、车辆或任何异常活动,从而增强公共和私人空间的安全措施。

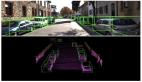

- 自动驾驶:在自动驾驶汽车领域,YOLO 有助于完成检测和分类汽车、行人和交通标志等物体的关键任务,使汽车能够做出明智的决策并安全行驶。

- 野生动物监测: YOLO 已被用于野生动物监测项目,它有助于自动检测和识别自然栖息地中的物种,协助保护工作和生物多样性研究。

- 零售和库存管理:在零售领域,YOLO 可以通过实时检测和跟踪货架上的产品来简化库存管理,并可以通过交互式显示和监控来增强客户体验。

代码片段:将 YOLO 应用于视频流

以下示例演示了如何使用 Python 应用预先训练的 YOLO 模型来处理和显示视频流中的检测结果。此示例使用 OpenCV 进行视频处理,并假设使用基于 PyTorch 的 YOLO 模型:

import cv2

import torch

# Load the pre-trained YOLO model

model = torch.hub.load('ultralytics/yolov5', 'yolov5s', pretrained=True)

# Initialize the video stream (replace '0' with a video file path for processing a video file)

cap = cv2.VideoCapture(0)

while True:

# Read frames from the video stream

ret, frame = cap.read()

if not ret:

break

# Convert the frame to the format expected by the model

frame_rgb = cv2.cvtColor(frame, cv2.COLOR_BGR2RGB)

results = model([frame_rgb], size=640) # Adjust size as needed

# Render the detections on the frame

frame_with_detections = results.render()[0]

# Convert the frame back to BGR for displaying with OpenCV

frame_with_detections_bgr = cv2.cvtColor(frame_with_detections, cv2.COLOR_RGB2BGR)

# Display the frame with detections

cv2.imshow('YOLO Object Detection', frame_with_detections_bgr)

# Break the loop when 'q' is pressed

if cv2.waitKey(1) & 0xFF == ord('q'):

break

# Release the video stream and close windows

cap.release()

cv2.destroyAllWindows()此代码片段展示了 YOLO 在视频流中实时检测物体的简单性和强大功能。通过高效处理视频的每一帧并叠加检测到的物体,YOLO 可帮助实现需要即时分析和响应的广泛应用。

结论

YOLO(You Only Look Once)的探索及其对物体检测领域的变革性影响,凸显了计算机视觉技术能力的重大飞跃。YOLO 的创新方法以单次检测为特点,可以同时预测多个边界框和类别概率,不仅提高了物体检测的速度和效率,还扩大了其在各种现实场景中的适用性。

从通过先进的监控系统增强安全性到提高自动驾驶汽车的安全性和可靠性,从协助野生动物保护工作到彻底改变零售和库存管理,YOLO 的多功能性和效率使其成为各个领域的基石技术。它能够以惊人的准确性和速度处理动态和具有挑战性的环境,这凸显了深度学习模型在处理曾经无法实现的复杂实时任务方面的潜力。

提供的代码片段深入了解了 YOLO 的架构、训练过程和视频流应用,证明了该模型的可访问性和适应性。它们说明了如何在实际应用中集成和使用 YOLO,使开发人员和研究人员能够在他们的项目中利用实时对象检测的强大功能。

展望未来,YOLO 的持续开发和迭代有望取得更大进步,检测精度、处理速度和对更广泛应用的适应性都有可能得到改善。YOLO 从诞生到现在乃至更远的未来,是人工智能和计算机视觉领域不懈追求创新的生动例证。它是未来发展的灯塔,鼓励人们不断探索,突破人工智能的极限。