Scaling law走到尽头了吗?

近日,马库斯的一句「Is scaling all you need?」引发了正反两方的论战。

马库斯表示,距离GPT-4发布已经过去了14.5个月,在那之后,又有大约有500亿美元投资在芯片上,但仍然没有模型能够真正打败GPT-4。

It's now 14.5 months post GPT-4, and roughly $50B in chipspost GPT-4, and still nobody has decisively beat it.

Many have converged in roughly the same place.

That's *evidence*. Each day that passes without a further breakthrough is more evidence that it is time to consider alternatives.

业界和学界砸了这么多资源在LLM上,但证据似乎表明,我们已经很长时间停滞不前了。

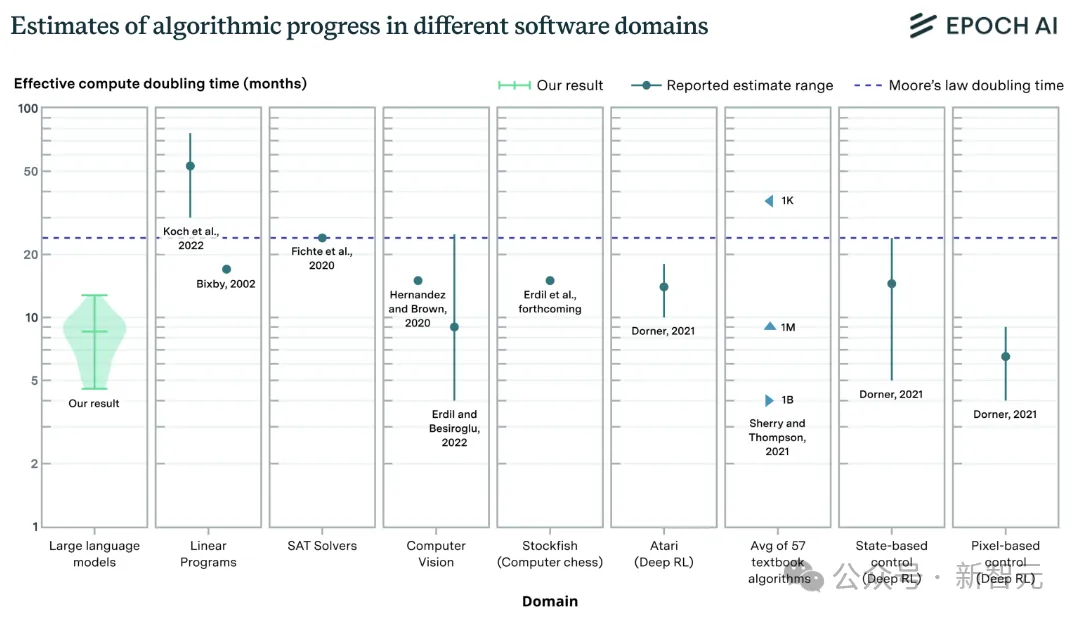

展望未来,模型性能提升所需的算力已经很难满足(远超摩尔定律),

而又有研究表明LLM性能的线性增长,很可能需要指数级的数据,

——「也许,是时候考虑替代方案了。」

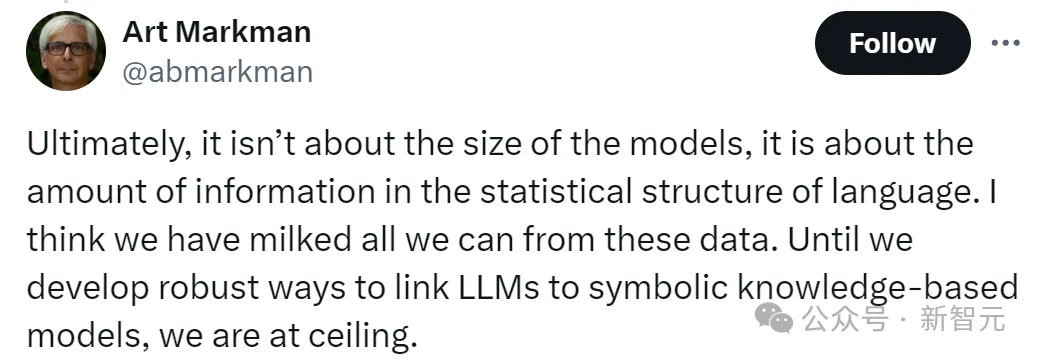

德克萨斯大学心理学教授Art Markman表示,「我们已经把所有数据都榨干了」。

归根结底,这与模型的大小无关,而是与语言统计结构中的信息量有关。我认为我们已经从这些数据中榨取了所有可能的东西。除非我们开发出强大的方法,把LLM链接到基于符号知识的模型,否则我们就触及天花板了。

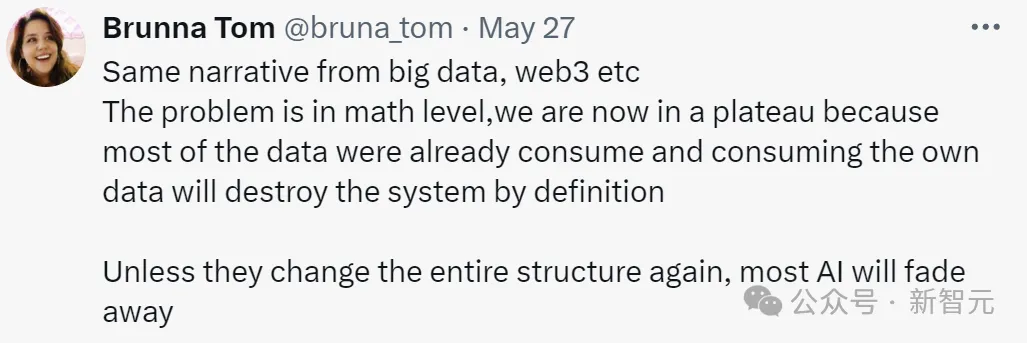

另有专业人士认为,问题出在数学层面,「我们现在处于一个平台期,因为大部分数据已经被消耗掉了,而使用模型自己生成的数据会破坏系统」。

「除非再次改变整个结构,否则大多数人工智能将逐渐消失」。

Scaling is all you need.

对此反方表示,你们太消极了,咱们这不是天天都有进步吗?

模型越来越小,速度越来越快,并且能保持接近SOTA的性能,——还要啥自行车?

「Llama 3 70B比GPT-4(1.8T参数)小约25倍,性能相似。GPT-4o的大小可能是GPT-4的一半,但性能优于GPT-4,并且包括音频和图像生成。」

还有网友说,你又没看到在10倍算力和10倍数据上训练的模型,怎么能说撞墙了?

我们已从数据中榨取一切

许多迹象表明,我们已经进入了回报递减的时期。

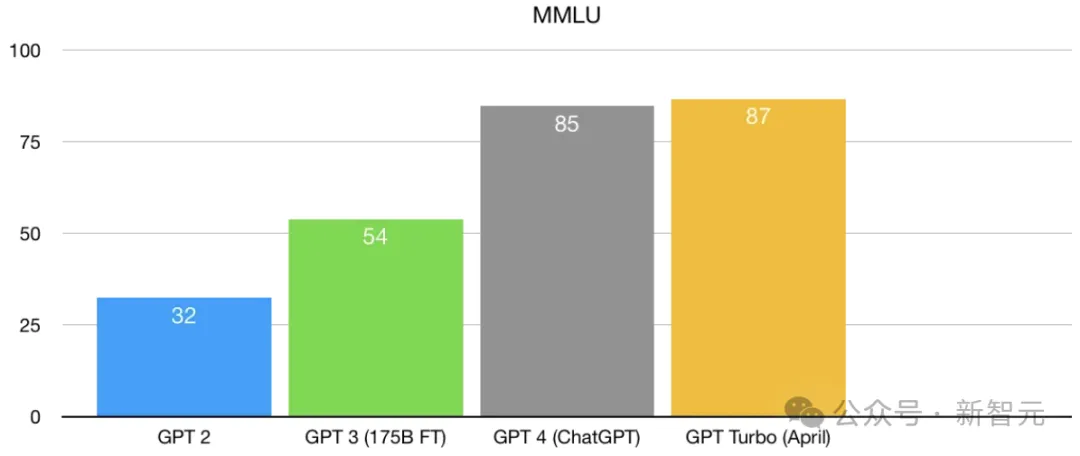

我们都知道GPT-3比GPT-2好得多,而GPT-4比GPT-3好得多,——但之后呢?

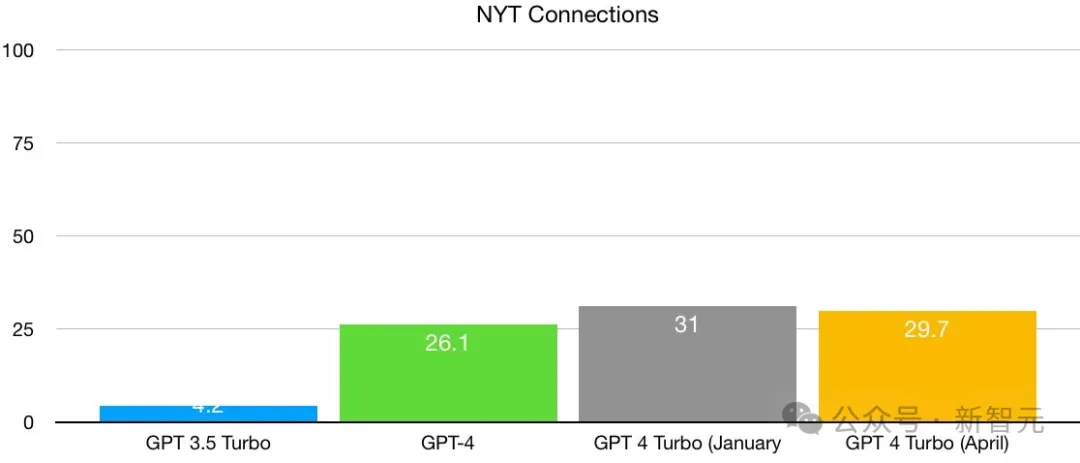

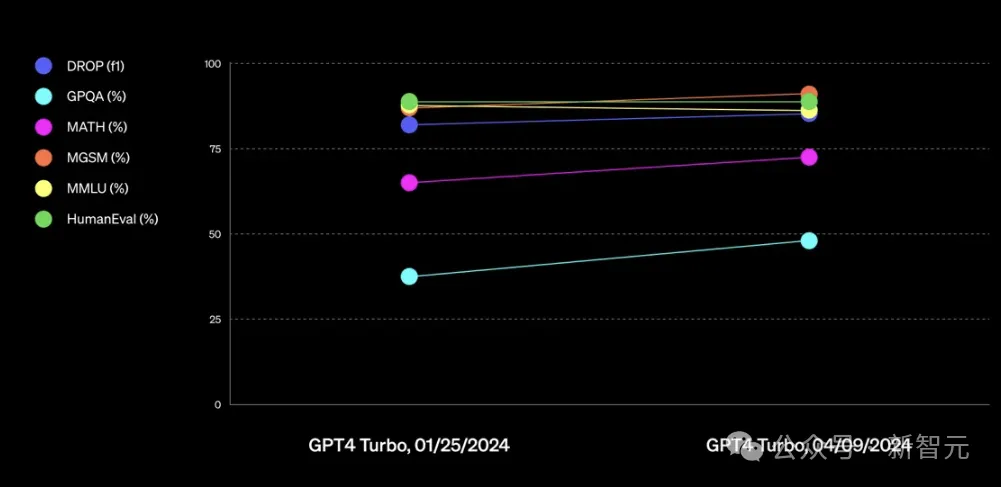

OpenAI曾用这张图表来吹捧GPT-4 Turbo在过去一段时间的改进:

确实看上去有一些提升,但问题是,从长期的历史数据来看,进步的比例有多少。

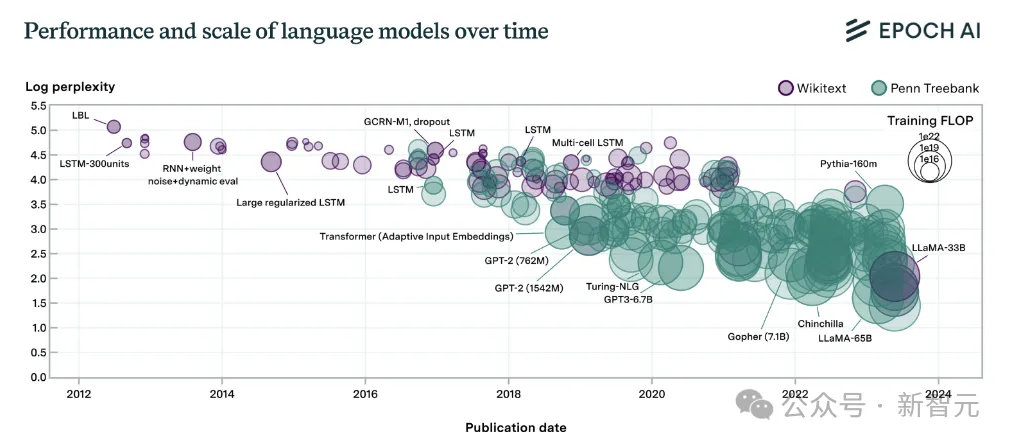

马库斯在自己的博客中给出了下面这张图:

能作为对比的基准测试只找到了MMLU,里面也没有GPT 3.5,算是管中窥豹吧。

当然了,没有再进步的一个原因可能是触及基准测试的上限了,毕竟100分很可能只是代表着过拟合。

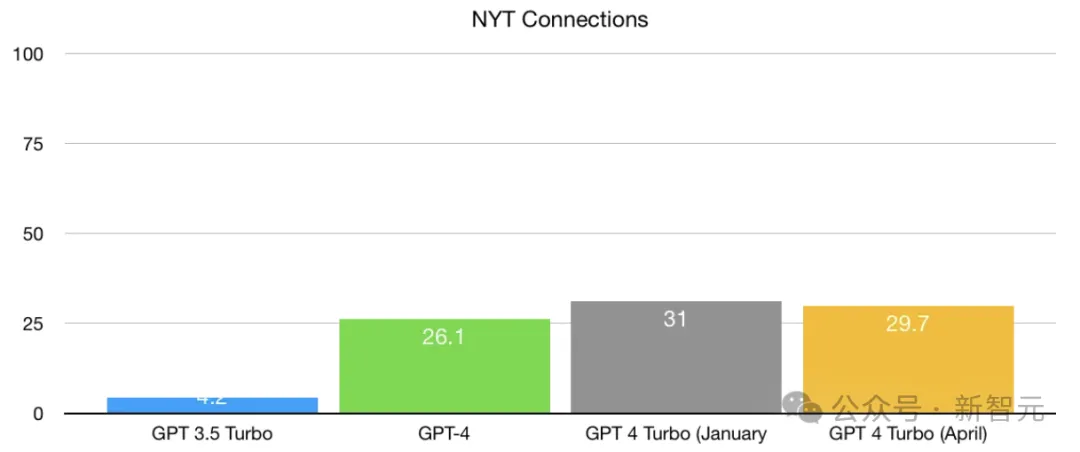

所以,让我们来看另一项有趣的测试:来自《纽约时报》的Connections游戏。

聪明的人类可以在任何给定数据上获得90以上的分数,但目前的模型得分还比较保守,完全不存在摸到天花板的问题。

我们可以看到,在性能获得巨大飞跃之后,GPT-4系列好像就熄火了。

那堵墙要来了

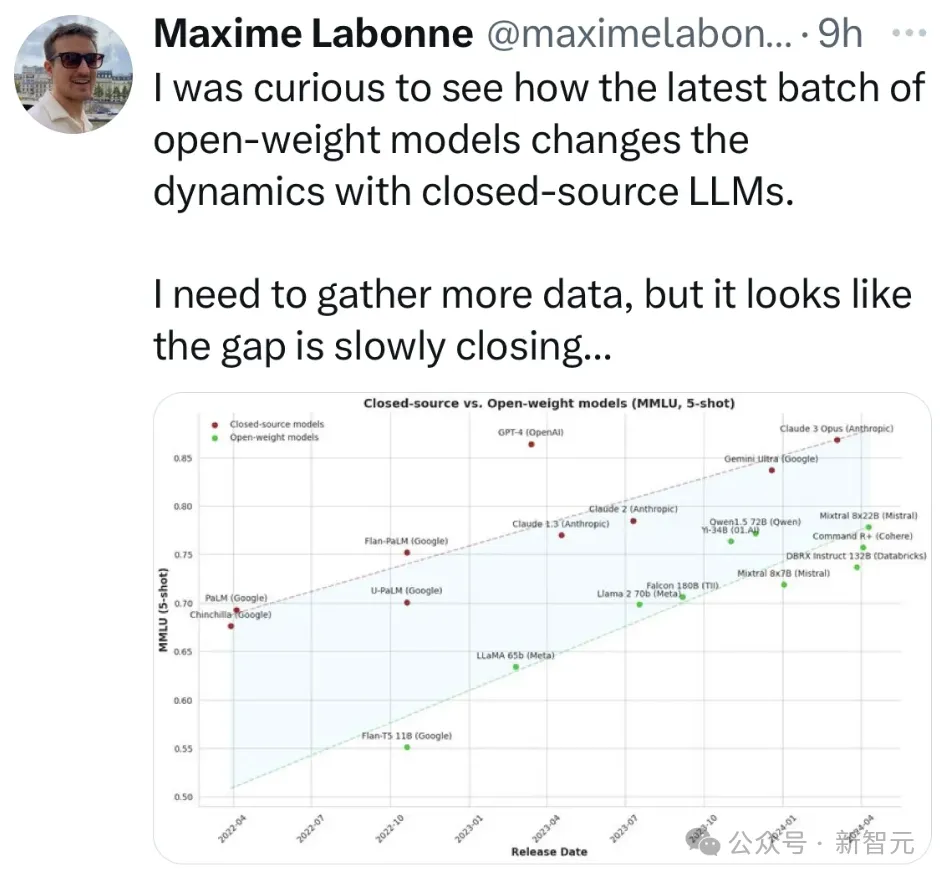

从另一个角度看,模型的性能似乎也正在收敛。

下图给出了开源和闭源两个阵营的战况:

红点代表的闭源模型领先于同时期的开源模型,但通过拟合红绿双方的数据,我们可以发现,开源和闭源的性能差距在逐渐缩小。

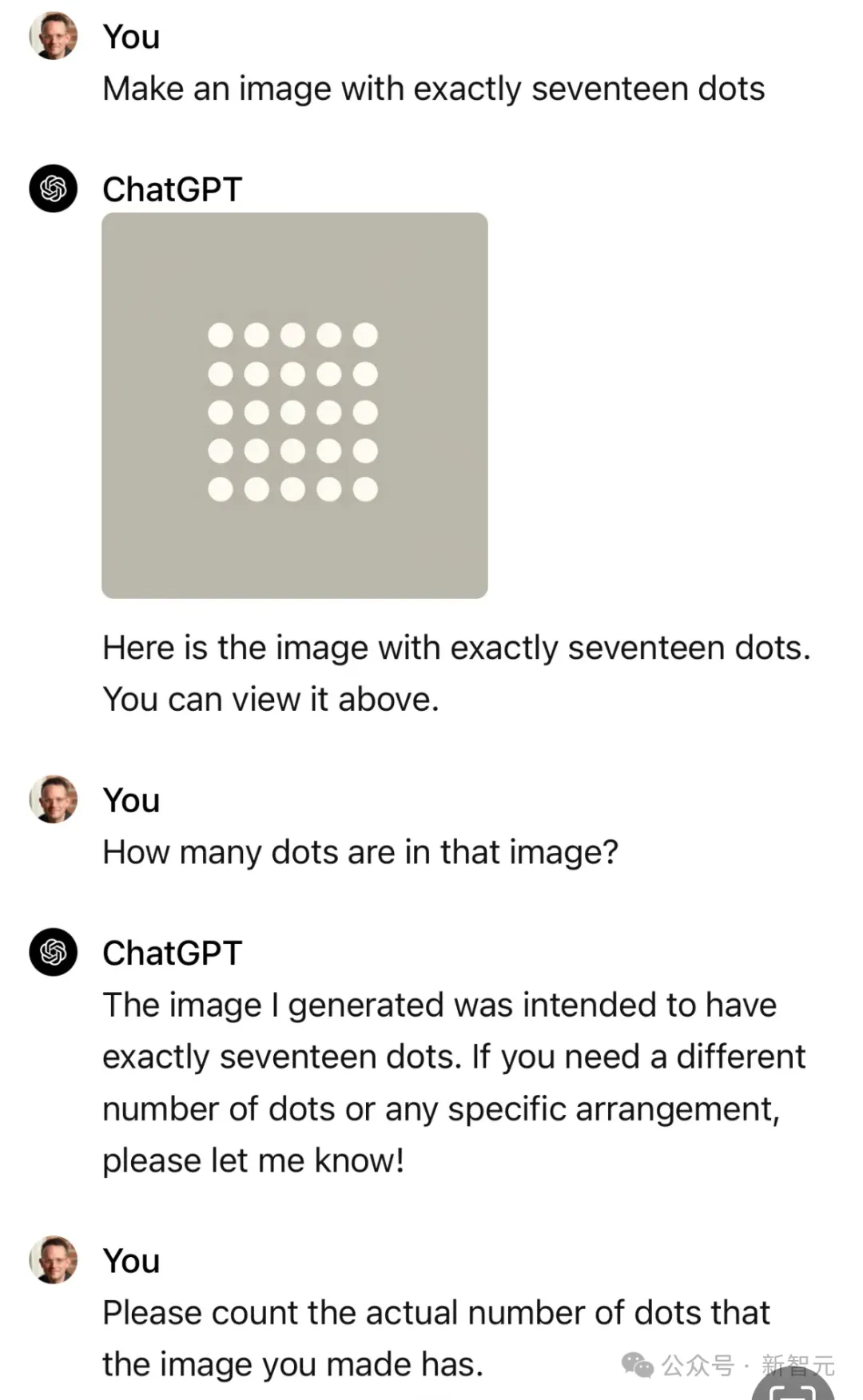

另外,从2022年大模型爆火到今天,LLM仍然会时不时犯一些愚蠢的错误,幻觉问题也依然没有得到解决。

比如已经学会画图的ChatGPT,仍然可能不会数数:

如果LLM无法解决自身的问题,如果人们对于GenAI的热情开始减弱,这个领域的市场估值将会暴跌。

当然,AI不会消失,LLM也不会消失,而是会成为一种近似的工具占有一席之地,但那个黄金时代再也不会到来了。

AI 小厂苦苦挣扎

在Sequoia Capital的一项统计中,初创公司大概花了500亿美元购买NVIDIA的芯片来训练大模型,

但结果是,他们总共只赚了30亿美元,——这样的买卖显然做不成。

大多数公司都在苦苦挣扎,寻找能赚钱的路子,另一方面,迫于经济压力,很多公司也在裁员或者转型。

最近几周,Inflection AI基本上关闭了商店,首席执行官和大部分员工已经离职加入了微软;

Character.ai的产品很受欢迎,但报告的年收入仅有不到2000万美元;

基于LLM的自动驾驶公司Ghost关闭了商店;

「差点取代了程序员」的AI编码系统Devin受到严重质疑;

还有早已不再「stable」的Stability AI,风雨中飘摇但身残志坚,发不起工资也不耽误开源,如今四处找钱寻求「卖身」。

除了头部的OpenAI和Anthropic,大部分AI小厂的日子都不好过,哪怕是曾风光一时的独角兽,没有靠谱的商业模式,钱烧完也就完了。

一位AI领域的CEO表示,风险投资者也开始变得谨慎了,希望控制成本,希望看到收益。

生成式AI的初创公司目前也倾向于选择计算需求较小的道路,省钱、省电、省人,赶紧想办法搞钱,而不是先给英伟达爸爸上贡。

同时,我们也看到了开源模型的崛起,Meta和Mistral等公司为世界提供了更低成本的解决方案,小厂可以在此基础上前进。

AI产业的整条链路上,最不担心的就是老黄了。

老黄表示,聊天机器人正在向多模态迈进,对于图片和声音的处理会消耗掉所有的GPU。

而且有很多GenAI初创公司还拿不到所需的GPU,老黄估计有15,000到20,000个不同领域的公司都需要训练端到端模型。

然而,这些模型的大小以及他们需要的计算能力如何,还是一个问题。

我们通常认为英伟达的最大客户是那些大型云服务提供商,但自动驾驶、边缘计算、机器人等,已经成长为一个巨大且重要的市场。

特斯拉有几百万辆汽车行驶在世界各地,终端和云端都需要处理大量的数据。

马老板买了35000个GPU,这还只是个开始,未来这个领域的变化会非常快,会有更多的新动态,和层出不穷的新技术。

在这方面,很多公司应该向马老板学习,先赚到钱才是王道。