本文经自动驾驶之心公众号授权转载,转载请联系出处。

- 端到端落地的难点在哪?

- 如果说特斯拉和小鹏的优势在数据,那么wayve作为初创数据应该是个门槛,但是它的端到端也些亮眼成果了?

- 基于合成数据,3dgs,world model这类新技术有没有可能让端到端突破真实数据的枷锁?

- 端到端的技术路线会是什么方向?从感知,轨控 独立模型演进到端到端,是否比 从0直接上端到端模型 有技术优势和壁垒?

清华大学博士生&加州大学伯克利分校博士后 Kimi

- 端到端的难点主要在于如何评价学出来的端到端系统,特别是他是否学出来了真正的开车逻辑。这是因为输出轨迹是一个很简单的任务,即使你什么也没学会,就输出一条跟着前车的直线轨迹也大差不差。这跟感知任务还不太一样,感知任务的难度还是比较高的。这就使得端到端系统,输入图像的话很容易学到一些shortcut,也就是他学到的逻辑其实是不对的。这也是为什么端到端系统中高质量的数据是真正重要的,因为这样的数据才蕴含了真正的开车逻辑。

- 端到端数据只是一方面, 正如第1点提到的,更重要的是如果只告诉它一个真实轨迹真值,怎么才能让这个系统从数据中学到真正的开车逻辑,也就是为什么这个真值是对的,其他是错的。因此端到端的系统设计其实没那么容易,而wayve很早之前就开始探索端到端自动驾驶,也一直有一些高质量的工作,因此端到端做得好也不奇怪了。

- 我认为这个是非常有希望的一个方向,不仅仅是在训练阶段,在测试阶段其实更加重要。对于端到端系统的测试,很难像感知那样直接通过GT来评判他的对错,而是要把他放在一个仿真系统里来进行闭环测试。这就使得我们需要给端到端系统新视角的输入,这个在数据集里大概率是没有的,需要3dgs这样的技术来实现。但是这个目前的技术距离真正实用还有一段距离,但我认为这方面的技术突破是自动驾驶的落地的一个核心。

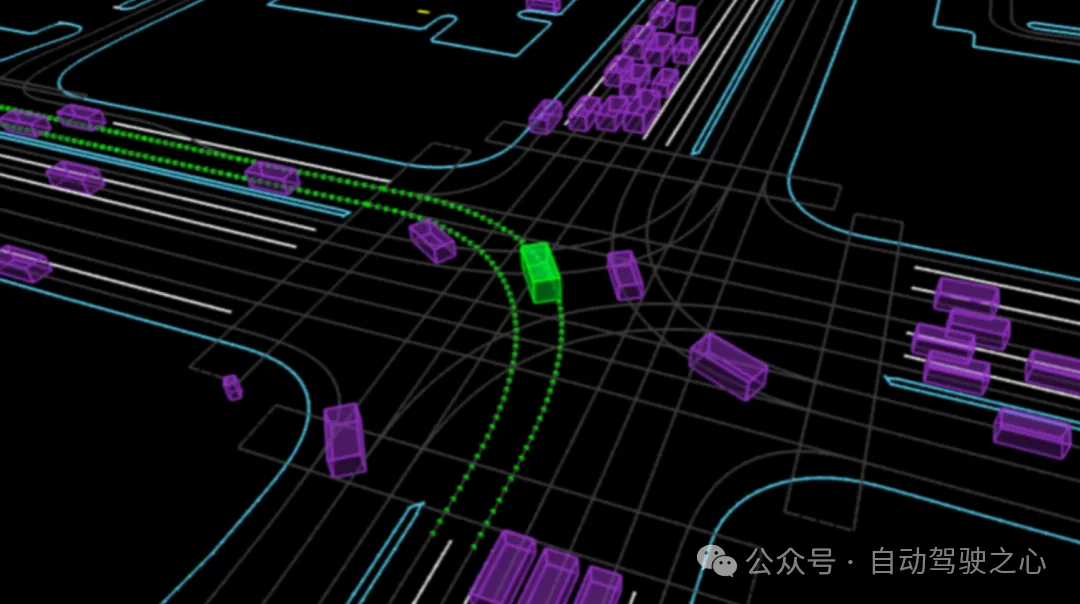

- 通过我上面说的其实可以看出来,端到端模型的设计不是用一个神经网络来拟合真实轨迹这么简单的。除了从高质量数据筛选这个角度来教模型有用的开车逻辑,在感知、轨控方面的技术积累是很有帮助的。端到端系统的设计中,图像和轨迹之间的这个场景表示是最核心的。我个人认为occupancy是最接近终极场景表示的方式了,一方面因为occ对三维场景表达的全面性,另一方面也是因为它可以使用自监督被有效地学到,这也是我们后续课程会重点讲的一部分。

端到端论文带读老师 资深算法工程师 Jason

非常赞同上述第4点。我认为比较工程友好的路线是分模块先实现端到端,比如规控模块先用模型代替,感知模块用一个统一的模型代替,后面再把两个模块拼接起来的形式。实际上规控的模型化难度是比较高的,一方面数据收集的困难,比如一些corner cases怎么收集,这里可能需要借助仿真或者world model来帮忙。此外规控模型的测试也是很难的。不像感知可以直接有几个测集就可以,规控严格来说需要去做闭环测试才能接近真实车端的表现,那么总不能发一版模型让车去到处测吧,那样可能测试一个模型比训一个模型的代价还大了。

轨迹预测课程老师 资深算法工程师 Thomas

端到端是从sensor到控制信号,比较大的优势1)是sensor的信息不会有损失吧,2)不会因为前级模型的误差导致级联误差。

传统的技术路线相当于把端到端抽象成一个个人工定义的显示子任务,每个任务有明确定义和相对高的可解释性。

目前来看,端到端的方法还有提升的空间吧,它并没有体现出比传统方法更好的可解释性稳定性可靠性安全性。比如一个case接管了,我们并不知道是端到端的模型的哪个模块出问题了比较难针对性地去解这个case,但对于传统Pipeline 我可以定位到是感知预测还是归控出了问题,所以我感觉端到端达到百分百的安全性的难度可能会更大。

端到端还有一个难点是优质数据的搭建和收集,需要标注大量有驾驶行为的视频和控制行为。但是当数据量达到一定的level, 基于scaling law, 我还是比较看好端到端或者/ world model会给我们带来惊艳的表现

头部大厂算法专家 Dylan

- 难点是根本没有可以闭环的模型,只有各种公司和公众号在乱吹,pnc是个系统不是个简单模型搞定的,一步一步走才是硬道理,第一步不如想想ML和AI怎么帮助现有的pnc而不是一口吃成胖子

- 数据量不是优势,有效数据才是,wayve有后发优势,可能有更完善高效挖掘和收集有效数据方法

- 从业务角度看,个人短期(2-3年)看不到生成特别重要的用处。端到端可能也没到那个阶段,先理清楚端到端怎么用到现有的自驾框架怎么用更重要。

- 学术和业务发展应该是分开的。学术可以考虑更远的可能性,考虑各种思路,业务需要一步一步来(当然人力财力足够可以多方案同步尝试)。另外感觉当前端到端模型没啥壁垒,近期发的那几篇论文比再早期的也没啥真的新东西,借了纯视觉bev的东风吧。

NeRF与自动驾驶知名博主:意茗

针对问题3,当前3DGS或者NeRF这类合成数据的方法,暂时不能让端到端突破真实数据的枷锁,但未来可期。当前合成数据做的事情是

- 采集数据的倍增,比如提升传感器高度在重建好的模型中做渲染,来模拟不同高度车型的采集数据;

- 有限的闭环仿真,比如自车车道变化引起的相机和雷达传感器渲染数据变化。

但这些功能还远未达到能够突破真实数据的枷锁,枷锁在于天气模拟、动态前景和corner case。对于天气模拟,当前逐渐取代NeRF的3DGS方法天生没法重建环境光照,很难去做光线条件或者天气的更改,即便有carla之类的工具也没法作用到GS模型中未解耦的反光、表面和材质;对于动态前景,3DGS或者NeRF作为静态重建方法,自然是不支持动态的重建,因此需向重建和渲染pipeline中引入大量或许不适配3DGS/NeRF特性的动态重建工具,很难,也未必是动态重建的最优解;对于corner case的数据合成,可以做到一部分,但是真实生活中的corner case的数量和类型远超开发者想象,只期望生成模型有一天能够补足这一部分,让合成数据的过程更方便简单,结果更真实可用。

上海AI LAB 资深研究员 DOMIN

个人理解现在的仿真主要还是偏规控,像carla这种三维建模场景加上比较简单的随机交通流,有些算法就有不小domain gap,做不了端到端。我们团队也做过,我们发现其实是需要大量实车动力学数据以及carsim数据去训模型,也就是说模型能力上限其实是carsim。我理解端到端是要做closed loop的,喂感知数据很难去完整评价,更难让模型自己去不断迭代

新加坡南洋理工大学博士生 加州大学伯克利分校访问学者 黄志宇

- 端到端实施的主要难点何在?

自动驾驶系统或产品的首要目标是确保安全。端到端实施面临的最大挑战是如何确保系统的安全性,能否完全信赖模型输出的决策和规划,以及这些决策是否能与人类的价值观和期望相符。

- 关于Tesla和Xpeng在数据方面的优势,Wayve作为初创公司是如何应对的?

尽管Wayve是一家初创公司,但它已在伦敦进行了早期的数据收集,并开展了端到端模型的训练,成为该领域的先行者之一。未来,Wayve可能会探索与欧洲的OEM厂商合作,部署其开发的系统。

- 利用合成数据、3DGS、World Model等新技术,端到端能否突破真实数据的限制?

我认为3DGS和World Model主要是作为测试和仿真工具而不是训练工具。由于机器学习的方法依赖于训练数据的分布,仅用合成数据难以显著增加数据多样性或提升模型性能。因此,关键还是要在真实世界中持续收集新的多样化数据。不过,将这些技术用作测试驾驶系统确实是一个有前途的方向。此外,World Model的概念相当广泛,并不局限于特定方法,可以作为端到端系统中一个关键的模块,既可用于决策也可用于系统测试。

- 端到端技术的发展方向将如何演进?

我认为感知任务的目标应是尽可能准确地提供周围环境的关键信息至决策模块。即便拥有了完美的感知信息,如何设计出高效的人性化决策模块依然是一个挑战。端到端系统旨在为决策模块提供尽可能多的感知信息,通过高维潜在信息替代人工定义和处理的物理信息,以优化交互和决策过程。近期,学术界在基于学习的规划上已取得进展,这也推动了端到端技术的广泛关注和应用。总的来说,应当首先开发高效的AI决策模型,待其能力成熟后,再向全面的端到端系统演进,确保决策能力的优先发展

多传感器融合与多目标跟踪全栈老师 感知算法专家 Edison

- 一方面,端到端模型会远比现有的检测、分割、预测、规划小模型要复杂,甚至完全是另一种范式,现在来看这种模型的框架还没有完全探索出来;另一方面, 由于模型的复杂性,人类工程师更难理解它工作的机制,当模型在corner case上表现差时,仅仅增加数据可能无法提升模型性能。

- 对于Wayve了解不多,但是很多人对数据的理解比较简单,一般来说,即使原始数据量很大,其中蕴含的有效的高质量数据却很少。如果缺乏高效合理的数据工程能力,绝大部分数据都无法用来提升模型能力。小公司能把数据Pipeline做好的话,在数据上或许也会很有优势,和公司体量无关,和原始数据量大小也无关。

- 我认为真正的未来的端到端模型和分模块小模型是两种不同的技术范式,不断提升感知、预测、规划的AI成分,使其不断接近100%可微网络,可能无法达到真正的端到端可学习自动驾驶大模型。但是从公司角度来说,在这个过程中会积累出对自动驾驶技术有深刻理解的工程师和技术团队,这批人在工程实践中的自我迭代,会逐渐超越既有技术范式,探索出真正的端到端大模型。

Waymo研究员:自动驾驶方向算法专家,jerry

- 端到端落地的难点在哪?

数据/云端算力/车端算力/组织架构/infra效率/评测体系

- 如果说特斯拉和小鹏的优势在数据,那么wayve作为初创数据应该是个门槛,但是它的端到端也些亮眼成果了?

小鹏在新宙离开之后,已经是另一个公司。数据总量 不等于 数据能力 wayve科研工作很好,e2e具体落地的稳定性有待观察。

e2e对整个自动驾驶管线的影响系统性的,数据总量很关键,但并不是唯一因素。并不排除有些新公司,在有限数据的情况下能把e2e做好。

- 基于合成数据,3dgs,world model这类新技术有没有可能让端到端突破真实数据的枷锁?

对于合成数据在业务中如何使用,是个目前没有共识的方向。看起来评测会比训练先用起来。

用大量的数据去训练合成数据生成,再用这些数据训练。未必比直接训练自监督的模型效果更好。需要等待更多的研究。

- 端到端的技术路线会是什么方向?从感知,轨控 独立模型演进到端到端,是否比 从0直接上端到端模型 有技术优势和壁垒?

会是多个方向并行。很多时候并不存在唯一解。甚至端到端都不一定是唯一解。

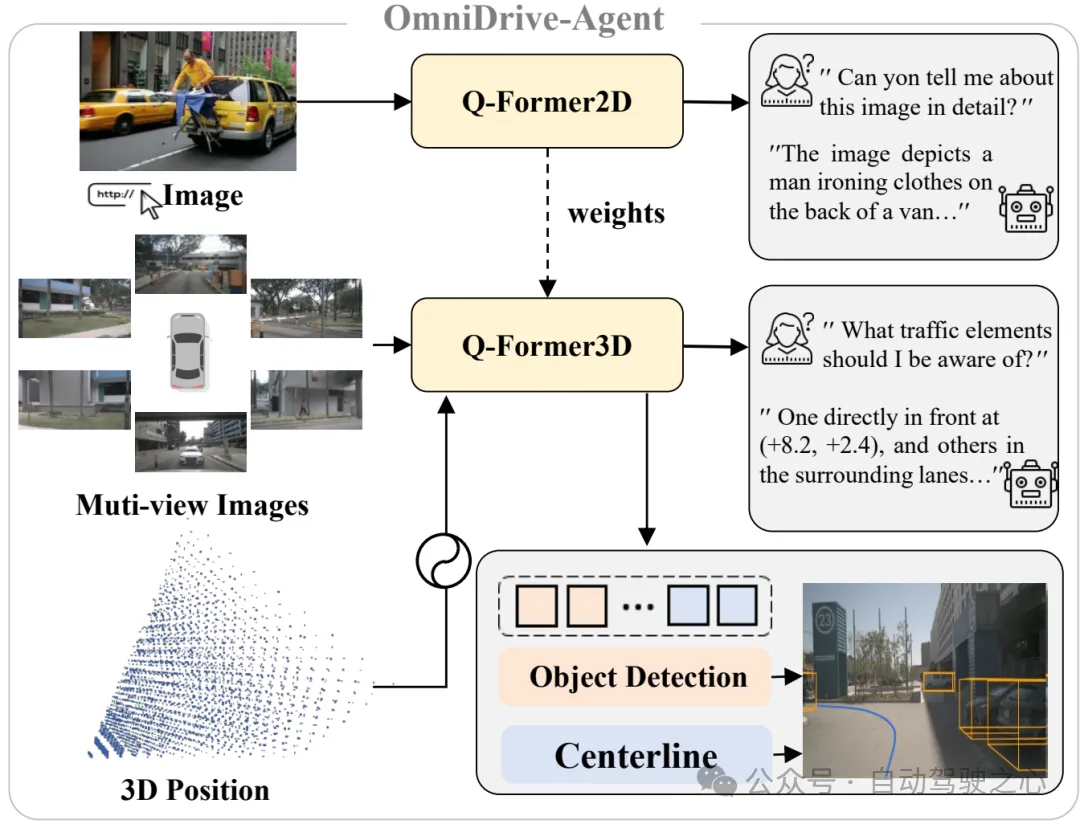

但就具体到e2e这个方向。长期看来,模块化的端到端和现有自驾体系更匹配,类似UniAD等方案。一体化的e2e方案,LLM-based 或者diffusion-based 由或者 VFM+LLM的二阶段方案,在车端算力冗余的前提下,很可能经历多个方向并行在市场中竞争,最终收敛到某些固定的格局。各自面临的技术挑战不一样,都有壁垒。最终市场上存在,应该都是针对各自的优势进行不同程度的trade-oof

感知算法专家 星球嘉宾 LEO

- (1) 算力 (2) 如何保证正确性和安全性 (3)模型收敛

- 我想,我们应该意识到的是,端到端技术的出现,就是为了打破 标注数据 瓶颈。希望通过更简单的监督信息,来实现更有效的驾驶行为决策。

传统意义上的标注数据(bbox, segmentation )由于人工标注环节的存在,始终无法进一步跨越规模瓶颈。而端到端的任务下,期待的是更廉价和高效的数据获取,更弱的监督,更大规模的模型,scale up 来实现“智能涌现”。从这个角度看,传统意义上的数据闭环,数据积累,不一定有跨越性的优势。

- 先问是不是,“数据是不是端到端任务的枷锁”?我认为目前而言,端到端任务的设计可能还不够清晰,正如王乃岩博士(聊一聊端到端)的那篇文章提到 “我认为端到端的本质应当是感知信息的无损传递。” 因此,我认为端到端在方法上尚未到达终局。

而我们是否需要合成数据来实现端到端,我倾向于认为这是一个成本收益问题,当任务设计清晰明确后,在未来,哪种数据获取方式更简单更廉价,哪种就会被应用。

- 端到端的技术路线会是什么方向?从感知,轨控 独立模型演进到端到端,是否比 从0直接上端到端模型 有技术优势和壁垒?

先上一下乃岩大佬的文章引用:

“我们还应该从本质上思考一下,端到端的本质是什么?我认为端到端的本质应当是感知信息的无损传递。我们先回想一下在非端到端系统中,感知和PnC模块的接口是什么样子的。一般我们会有针对白名单物体(车,人,etc)的检测/属性分析/预测,会有对静态环境的理解(道路结构/限速/红绿灯,etc),如果做的更细致一些的话,还会做通用障碍物的一些检测工作。从宏观的角度来讲,感知输出的这些信息,都是对复杂驾驶场景的一种抽象,而且是人工定义的显式抽象。然而,对于一些非常见场景中,现在的显式抽象难以充分表达场景中会影响驾驶行为的因素,亦或是我们需要定义的任务过多过琐碎,也难以枚举尽所有需要的任务。所以端到端系统,提供了一种(也许是隐式)全面表示,希望能够自动地无损地将这样的信息作用于PnC。我认为,所有能满足这样的系统,都可以叫做广义端到端。”

模块化的任务设计方式更像是一种妥协,用人类容易理解和保证安全性的方式来解决自动驾驶问题,当然,我们遇到了一些瓶颈。而这些瓶颈是否可以被端到端解决?这很难讲。

我更倾向于认为,这可能是两种并行的技术路线。在未来长期一段时间内可能会同时存在。

我相信很多自动驾驶公司尽管谈端到端,但仍然会有模块化的设计在背后兜底。

从这个角度讲,我认为从传统模块化再到端到端,比从 0 直接到端到端的厂家更有优势。他们对自动驾驶任务,系统设计难点,相对有更清晰的认识。

数据闭环方向资深工程师 神秘网友小邱

- 我们不需要做端到端落地,所以可能有失偏颇,望抛砖引玉,个人认为e2e的最大问题是可解释性问题,从sensor直接到plan中间空间太大了,不知道问题出在哪里,而且每一次版本迭代可能都要做复杂的测试,需要保证测试数据的多样性和覆盖性,还要保证不会过拟合,仍然拥有良好的泛化能力,第二是难做闭环,驾驶可能存在多种合理的驾驶选择,而且驾驶场景存在博弈,虽然有waymax这样的multi-agent simulator工具或gaia-1这样的工作,但是仍然有局限性

- wayve数据说不上多,但也不是很少,gaia-1的时候就有4,700小时的数据,他们能够通过gaia-1合成数据或验证e2e的能力,同时他们做了很多Self-Supervised的工作,这样对"已标注数据"的需求量就更少了

- 个人认为合成数据最大的使用场景在找到bad case / corner case和失衡数据,通过仿真环境去生成补集,帮助模型更鲁棒,但是合成数据也有局限性,我认为顾险峰老师对Sora的评价用在这个问题也合适:模型忽略了物理过程中最为关键的临界(灾变)态,一方面因为临界态样本的稀缺,另一方面因为扩散模型将稳恒态数据流形的边界模糊化,消弭了临界态的存在,生成的视频出现了不同稳恒态之间的跳跃。而基于几何方法的最优传输理论框架,可以精确检测到稳恒态数据流形的边界,从而强调了临界态事件的生成,避免了不同稳恒态之间的横跳,更加接近物理的真实。

Gao

- 难点除了可解释性,似乎E2E也比较考验公司的工程能力和数据闭环能力。目前很多模型还是基于模仿学习的,一些重要但不常见的场景,很难采集,而且数据均衡也不好搞。

- wayve好像是引入了一些强化学习的策略,似乎有效果,这个是前几天听分享听到的,具体的还没看。

- 从之前做感知的经验,会有帮助,但是真实数据还是不能丢,但是生成数据的占比可能会逐渐提升比例。此外,基于真实数据采集的离线标注,也可以大幅度降低标注成本。

- 有数据、各模块技术储备充足的公司、团队,可以直接搞,但是其他团队可能还是分段搞积累数据和经验,以及验证数据闭环能力和工程能力之后搞更靠谱些。

再补充一点,就是闭环指标,也需要在模块化阶段摸索。目前的公开指标可能还是太学术了,难以评价所谓的驾驶水平,需要开发和磨合额外的指标

NeRF/3DGS重建 专家

- 难点在数据。

- Wayve 的 gaia 解决了数据,而且可以按需产生稀缺的corner cases 数据。

- 取决于怎么串联端到端模型。

- UniAD based 的端到端更靠谱,更适合工业界

仿真专家 JamesZhang

对于问题3:我的感觉是,现在这类技术还仍然处于“似是而非”的状态,数据的确定性也许还不够高吧

端到端论文带读群学员讨论

CH:

- 难点在于可解释性-因果关系,噪音处理和控制安全。

- 针对问题3:有可能,但目前来看有限。仿真能补充数据,但总归和实际有偏差,标注数据不可替代。

- 针对问题4:分段模型逐步可控可验证,直接端到端,即便像 driverAdapter 这样的分层监督也需要包一层rule based安全层。