自 2023 年 3 月 14 日开源 ChatGLM-6B 以来,GLM 系列模型受到了广泛的关注和认可。特别是在 ChatGLM3-6B 开源之后,开发者对智谱 AI 推出的第四代模型充满了期待。而这一期待,随着 GLM-4-9B 的发布,终于得到了满足。

GLM-4-9B 的诞生

为了赋予小模型(10B 以下)更加强大的能力,GLM 技术团队经过近半年的探索,推出了这一全新的第四代 GLM 系列开源模型:GLM-4-9B。

创新预训练技术

在预训练过程中,我们引入大语言模型进行数据筛选,最终获得了 10T 高质量多语言数据。这一数据量是 ChatGLM3-6B 模型的 3 倍以上。此外,我们采用了 FP8 技术进行高效的预训练,相较于第三代模型,训练效率提高了 3.5 倍。考虑到用户的显存需求,GLM-4-9B 的参数规模从 6B 提升到了 9B。最终,我们将预训练计算量增加了 5 倍,从而在有限的显存条件下最大化性能。

卓越性能展示

综合以上的技术升级,GLM-4-9B 具备了更强大的推理性能、更加优异的上下文处理能力、多语言支持、多模态处理以及全工具 All Tools 调用等优势。

GLM-4-9B 系列包括多个版本:

- 基础版本:GLM-4-9B(8K)

- 对话版本:GLM-4-9B-Chat(128K)

- 超长上下文版本:GLM-4-9B-Chat-1M(1M)

- 多模态版本:GLM-4V-9B-Chat(8K)

GLM-4-9B 的强大能力

基础能力

在强大的预训练基础上,GLM-4-9B 的中英文综合性能相比 ChatGLM3-6B 提升了 40%。尤其是中文对齐能力 AlignBench、指令遵从能力 IFeval,以及工程代码处理能力 Natural Code Bench 方面都实现了显著提升。即使对比训练量更多的 Llama 3 8B 模型,GLM-4-9B 也丝毫不逊色,在英文表现上略有领先,而在中文学科领域,GLM-4-9B 更是提升了高达 50% [性能评测图表]。

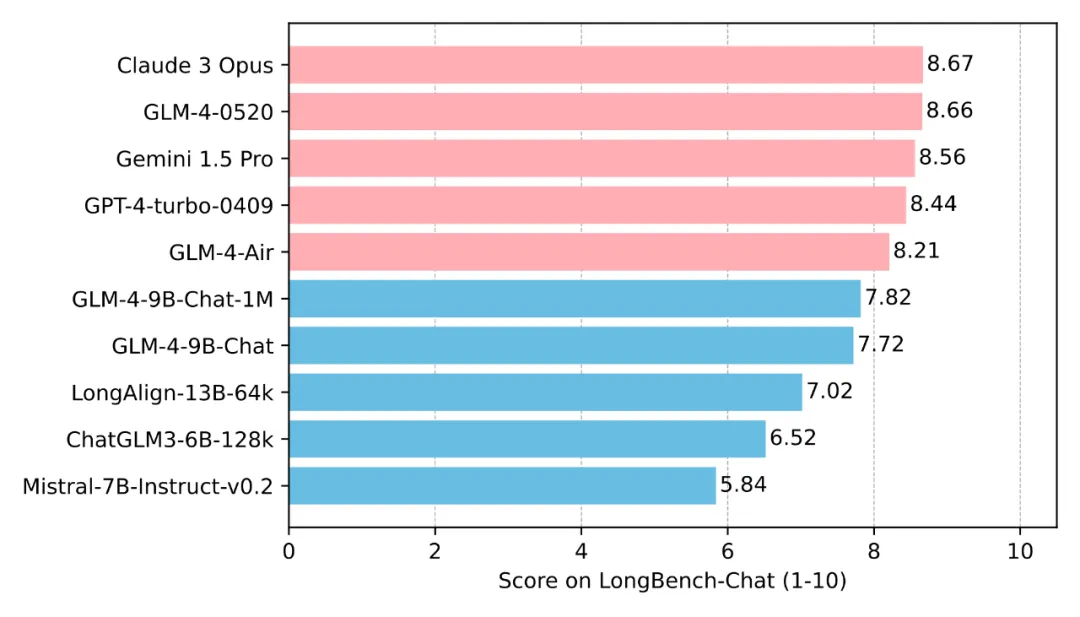

长文本处理能力

图片

图片

GLM-4-9B 模型的上下文长度从 128K 扩展到了 1M tokens,意味着能同时处理多达 200 万字的输入,相当于两本《红楼梦》或 125 篇学术论文的长度。GLM-4-9B-Chat-1M 模型在“大海捞针”实验中,成功展示了其出色的无损处理长文本输入的能力 [长文本实验图示]。

以下是两个展示长文本处理能力的 demo 视频案例:

- GLM-4-9B-Chat 模型: 输入 5 个 PDF 文件,总长度约为 128K,给出写一篇关于中国大模型发展的详细调研报告的 prompt。模型能够快速生成高质量的调研报告(视频未加速)。

- GLM-4-9B-Chat-1M 模型: 输入《三体》全集约 90 万字,要求模型给该小说写续集大纲的 prompt。模型合理规划并给出续写框架(视频加速 10 倍)。

多语言支持

GLM-4-9B 支持多达 26 种语言,包括汉语、英语、俄语等。我们将 tokenizer 的词表大小从 65K 扩展到 150K,编码效率提高了 30%。在多语言理解和生成任务中,GLM-4-9B-Chat 显著超越 Llama-3-8B-Instruct [多语言性能比较图]。

Function Call 能力

GLM-4-9B 的函数调用能力相较上一代提升了 40%,在 Berkeley Function-Calling Leaderboard 上,其 Function Call 能力与 GPT-4 不相上下 [函数调用性能对比图表]。

All Tools 全工具调用

“All Tools”能力即模型可以理解和使用各种外部工具(如代码执行、联网浏览、画图等)来辅助完成任务。在 1 月 16 日的 Zhipu DevDay 上,GLM-4 模型全线升级了 All Tools 能力,可以智能调用网页浏览器、代码解释器、CogView 等工具,完成复杂请求 [All Tools 任务图示]。

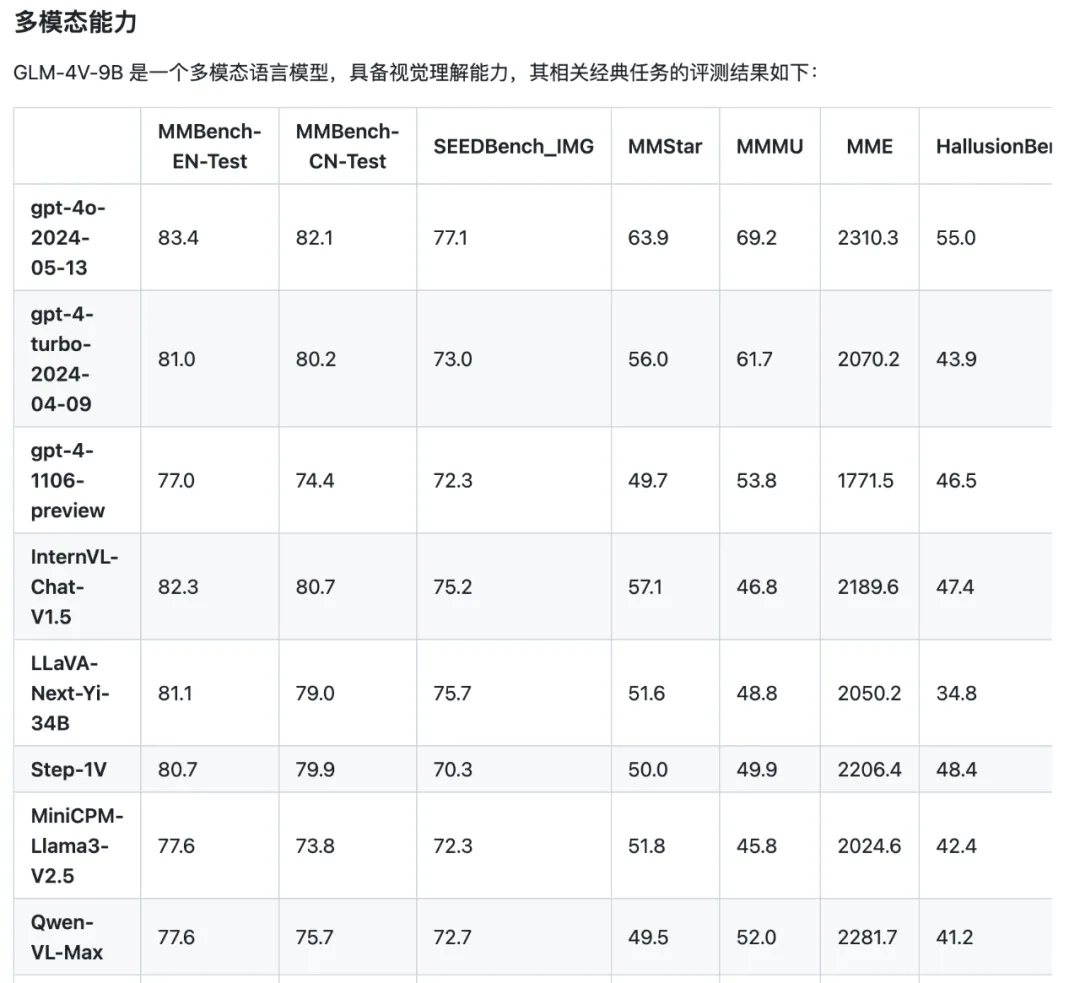

多模态处理

GLM-4V-9B 作为 GLM-4 基座的开源多模态模型,能够处理高分辨率输入,将视觉和文本数据直接混合进行训练,展现了显著的多模态处理效果,与 GPT-4V 性能相当。在识别和处理复杂多模态任务时,表现非常出色 [多模态应用实例图]。

图片

图片

未来展望

GLM-4-9B 展现了其在多种任务中的强大性能,是自然语言处理领域的一大突破。无论是学术研究还是工业应用,GLM-4-9B 都将成为您的不二选择。

我们诚挚邀请您加入 GLM-4 的使用者行列,共同探索这款卓越模型带来的可能性:

- GitHub 仓库

- Hugging Face 模型页面

- 魔搭社区