北航的研究团队,用扩散模型“复刻”了一个地球?

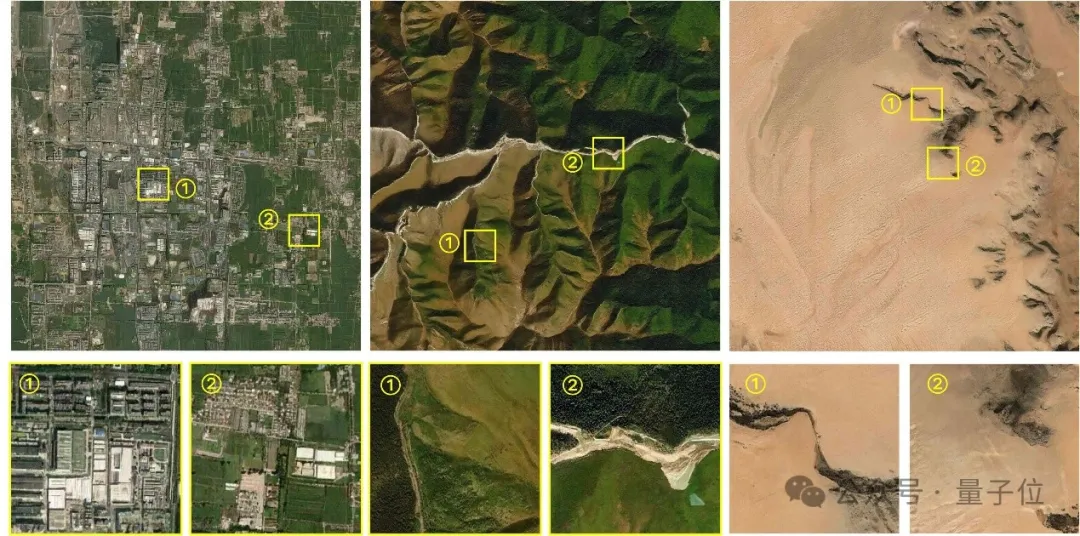

在全球的任意位置,模型都能生成多种分辨率的遥感图像,创造出丰富多样的“平行场景”。

而且地形、气候、植被等复杂的地理特征,也全都考虑到了。

受Google Earth启发,北航的研究团队从俯拍视角出发,将整颗地球的卫星遥感影像“装进”了深度神经网络。

基于这样的网络,团队构建出了覆盖全球的俯视视角视觉生成模型MetaEarth。

MetaEarth拥有6亿参数,可实现多种分辨率、无界且覆盖全球任意地理位置的遥感图像生成。

覆盖全球的遥感图像生成模型

相比于此前的研究,构建世界范围的视觉生成基础模型更具挑战性,过程之中克服了多个难点。

首先是模型容量的挑战,因为地球具有城市、森林、沙漠、海洋、冰川和雪地等广泛的地理特征,需要模型能够理解并表征。

即使是同一类型的人造地物,在不同的纬度、气候和文化环境下,也会表现出巨大差异,这对生成模型的容量提出了很高的要求。

MetaEarth成功解决了这一困难,实现了不同地点、地貌的高分辨率、大范围场景生成。

另外,实现分辨率可控的遥感图像生成,同样是一项挑战。

因为在俯拍图像成像过程中,地物特征的展现受分辨率影响很大,在不同图像分辨率下具有明显的差异,难以具备在指定分辨率(米/像素)下精准生成的能力。

而在MetaEarth生成不同分辨率的图像时,都能准确合理地呈现地物特征,而且不同分辨率之间的关联性也得到了精确对应。

最后是无界图像生成的挑战——与日常自然图像不同,遥感图像具有超大幅宽的特性,边长可能达到数万像素,此前的方法都难以生成连续、任意大小的无界图像。

但MetaEarth生成的连续无界场景,避开了这一缺陷,可以看到随着“镜头”的平移图像的移动十分丝滑。

此外,MetaEarth具有强大的泛化性能,能够以未知场景作为条件输入级联生成多分辨率图像。

例如,将GPT4-V生成的“潘多拉星球”作为初始条件输入模型,MetaEarth仍然能够生成具有合理地物分布和逼真细节的图像。

下游任务上的验证结果表明,MetaEarth作为一种全新的数据引擎,有望为地球观测领域各类下游任务提供虚拟环境和训练数据支持。

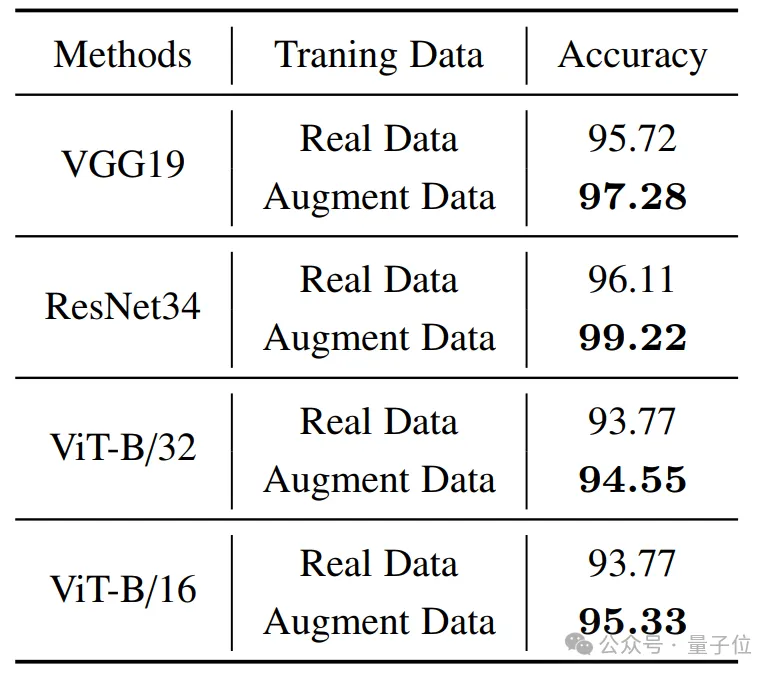

实验过程中,作者选择了遥感图像分类这一基础任务进行验证,结果显示,MetaEarth所生成的高质量图像的辅助下,下游任务分类精度有显著提升。

作者认为,MetaEarth有望为卫星等空天无人系统平台提供一个逼真的虚拟环境,并在城市规划、环境监测、灾害管理、农业优化等领域广泛应用;

除了作为数据引擎之外,MetaEarth在构建生成式世界模型方面也具有巨大潜力,为未来的研究提供新的可能。。

那么,MetaEarth究竟是如何实现的呢?

6亿参数扩散模型“复刻”地球

MetaEarth基于概率扩散模型构建,具有超过六亿的参数规模。

为支持模型训练,团队收集了一个大型遥感图像数据集,包含覆盖全球大多数地区的多个空间分辨率的图像及其地理信息(纬度、经度和分辨率)。

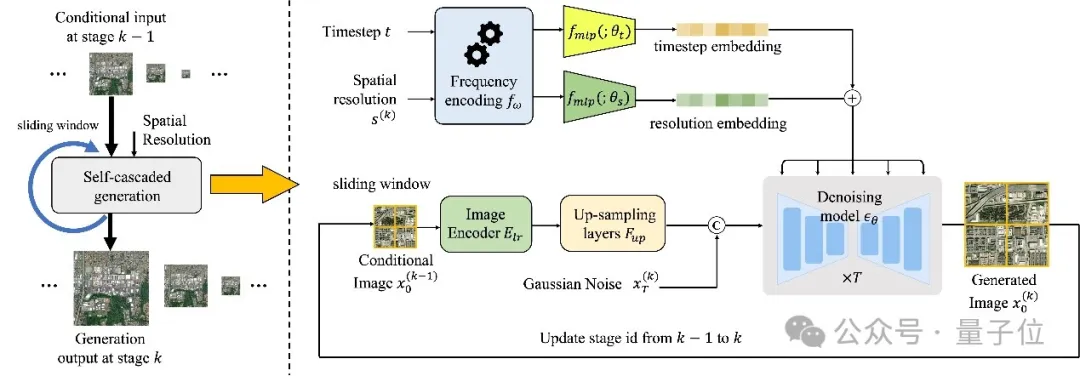

在本项研究中,作者提出了一种分辨率引导的自级联生成框架。

△MetaEarth的整体框架

在该框架下,仅用单一模型即可实现给定地理位置的多分辨率图像生成,并在每一级分辨率下创造出丰富多样的“平行场景”。

具体来说,这是一种编解码器结构的去噪网络,将低分辨率条件图像和空间分辨率编码后与去噪过程的时间步嵌入相结合,预测每个时间步的噪声,实现图像生成。

为了生成无界的任意大小图像,作者还设计了一种内存高效的滑动窗口生成方法和噪声采样策略。

该策略将生成的图像切分成重叠的图像块作为条件,通过特定的噪声采样策略,使相邻图像块的共享区域生成相似的内容,从而避免拼接缝隙。

此外,这种噪声采样策略,也使得模型能在实现任意尺寸的无界图像生成时,消耗更少的显存资源。

团队简介

本研究的作者来自北京航空航天大学的“学习、视觉与遥感实验室”(LEarning, VIsion and Remote sensing laboratory,LEVIR Lab),实验室由国家杰青史振威教授领导。

史振威教授曾经的博士生、密歇根大学博士后,现任该实验室成员的邹征夏教授,是本文的通讯作者。

论文地址:https://arxiv.org/abs/2405.13570

项目主页:https://jiupinjia.github.io/metaearth/