图片

图片

一、结论写在前面

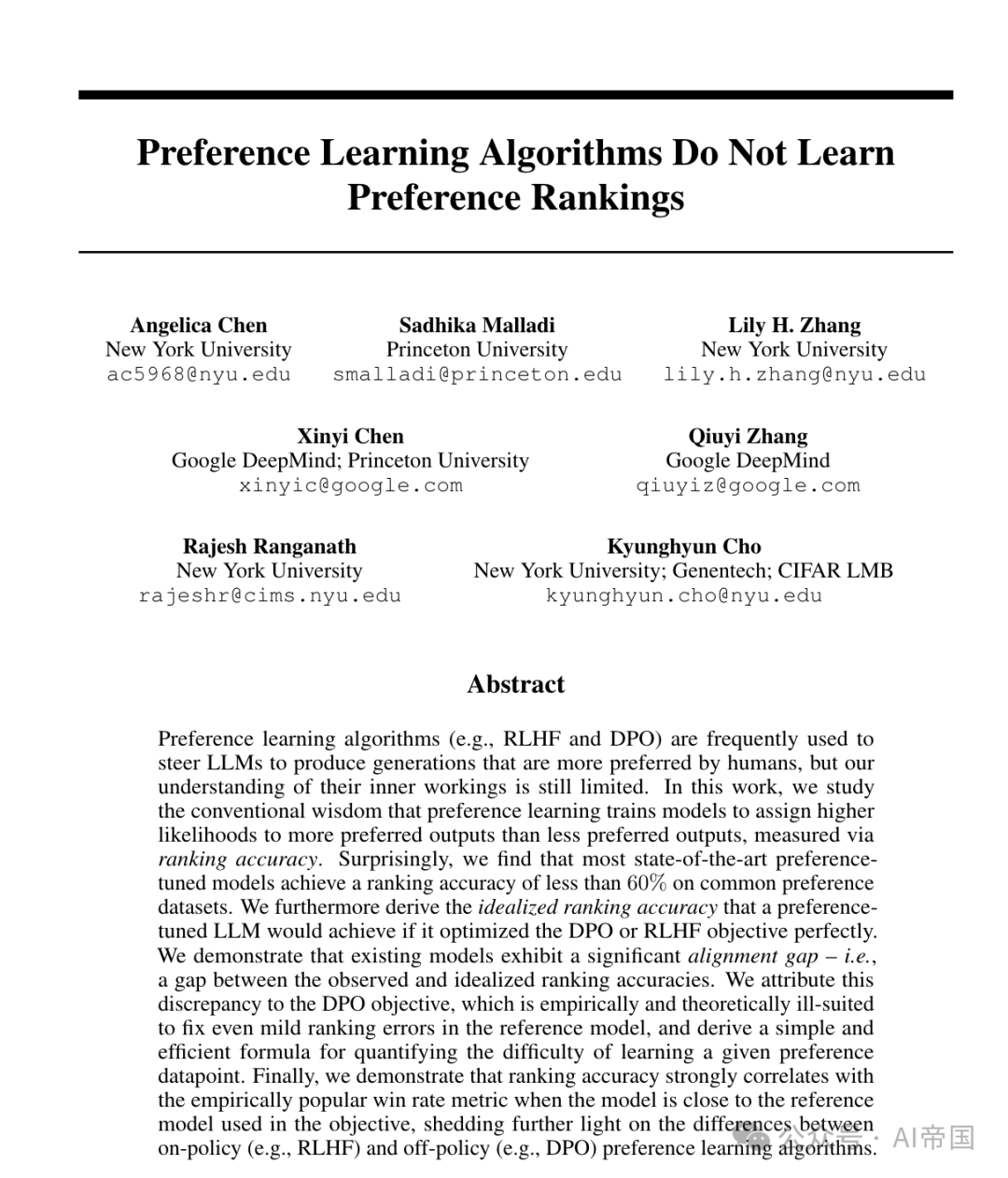

偏好学习算法(Preference learning algorithms,如RLHF和DPO)常用于引导大型语言模型(LLMs)生成更符合人类偏好的内容,但论文对其内部机制的理解仍有限。论文探讨了传统观点,即偏好学习训练模型通过排序准确性来赋予更偏好的输出比不太偏好的输出更高的似然性。

论文的工作凸显了偏好学习与排序准确性之间显著但关系微妙。论文理论和实证上都证明了RLHF和DPO难以教会模型正确地对偏好和非偏好输出进行排序,即使在训练数据集中也是如此。尽管学习目标理论上促进了高排序准确性。论文发现大多数最先进的偏好调整模型在常见偏好数据集上的排序准确率不足60%。论文进一步推导了如果偏好调整的LLM完美优化DPO或RLHF目标,其理想化的排序准确率。

论文证明现有模型存在显著的对齐差距——即观察到的与理想化的排序准确率之间的差距。论文认为这种差异源于DPO目标,该目标在经验上和理论上都不适合修正参考模型中的轻微排序错误,并推导出一个简单高效的公式来量化学习特定偏好数据点的难度。最后,论文证明当模型接近目标中使用的参考模型时,排序准确性与经验上流行的胜率指标高度相关,进一步揭示了策略内(如RLHF)和策略外(如DPO)偏好学习算法之间的差异。

二、论文的简单介绍

2.1 论文的背景

偏好学习算法最初设计用于使用候选者之间的成对偏好数据集来训练具有高排序准确性的模型——即,模型能够精确地将偏好的输出排在不偏好的输出之上。在语言模型的情况下,排序由分配给每个候选的似然性决定。

许多语言模型对齐技术旨在产生具有高偏好排序准确性的模型,包括SLiC、RAFT、PRO和RRHF[。最著名的是,Rafailov等人声称他们流行的直接偏好优化(DPO)算法"增加了优选响应相对于非优选响应的对数概率"。通常通过测量结果模型的生成结果相对于另一个模型的偏好程度(即胜率)来评估这些不同的目标[69]。然而,损失函数、排序准确性和胜率之间的关系尚不清楚,这让人不禁怀疑这些对齐技术在训练过程中实际上在做什么。

2.2 对齐差距

使用完美的参考模型训练以达到低DPO损失,将产生一个具有完美排序准确性的模型。然而,图1a显示现实世界的参考模型在常见的偏好数据集上排序准确性较低,这促使论文研究更现实、不完美的参考模型。

2.2.1 现有参考模型很少具有正确排序

图1a表明,参考模型在常见的偏好数据集上很少能达到高排序准确性(除了合成指令GPT-J成对数据集),尽管许多模型可能已经根据偏好完成进行了训练。许多模型的训练数据没有详细记录,因此论文不清楚哪些偏好数据集,如果有的话,是分布内的。论文还对几个预训练的大型语言模型(LLMs)进行了微调,以偏好完成,并观察到排序准确性并没有显著提高。基于论文的发现,论文转向不完美的参考模型的情况。

2.2.2 理想化的排序准确性

论文上面表明,从经验上看,参考模型在排序可能的完成时表现出较差的准确性。然而,RLHF奖励和DPO目标被设计为确保模型学习偏好数据集,但不会偏离参考模型rRef太远,因此偏好调整模型的可能准确性可能存在限制。在这里,论文通过研究在完美优化DPO或RLHF时,当访问完美数据(即人类偏好的真实比例)时,最优策略将是什么,来正式化这一直觉。

2.2.3 测量对齐差距

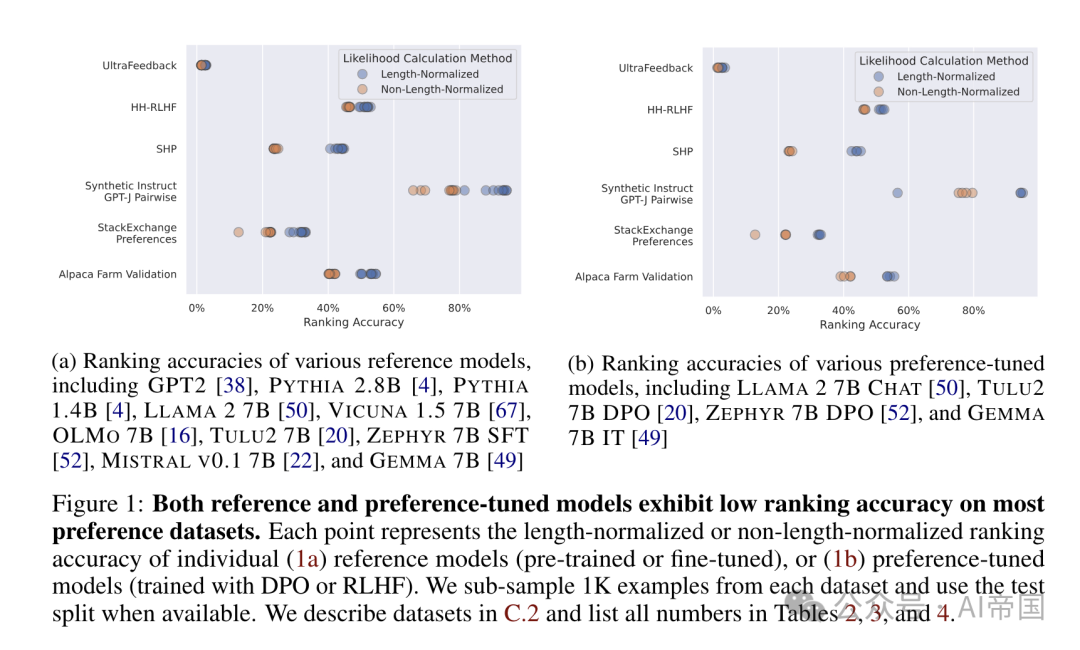

论文发现了一些令人惊讶的结果。首先,即使在理想条件下(即在真实偏好数据上完美优化目标函数),理想排序准确性有时仍低于100%。这种差距随着β的选择而变化,表明DPO/RLHF的极限在很大程度上取决于对πRef的依赖程度。此外,论文发现许多最先进的模型都无法达到接近理想排序准确性的排序准确性,表现出19到59个百分点的对齐差距。

表1:现有算法的理想排名准确性并不完美,但偏好调整模型显示出的排名准确性远未达到这种理想情况。论文提供了在Alpaca Farm [8]验证数据集(详见附录C.2)上,多种开放访问的偏好调整模型的长度归一化(R)和非长度归一化(R)排名准确性。同时提供了理想排名准确性(推论3.3)。由于理想排名准确性可以通过多种B值计算,论文提供了最小、中位数和最大理想排名准确性值的范围,详情见附录C.4

图片

图片

2.3 理解DPO的排名准确性

论文现在转向训练目标来解释对齐差距。论文专注于DPO目标,因为其未能达到高排名准确性特别令人惊讶(表1)。特别是,DPO直接在线下数据集上最大化偏好-非偏好对的奖励边际,因此论文期望它在分布外的保留数据上表现良好。论文还注意到,DPO是社区中对齐LLMs的流行选择,因为它比执行RLHF成本更低。

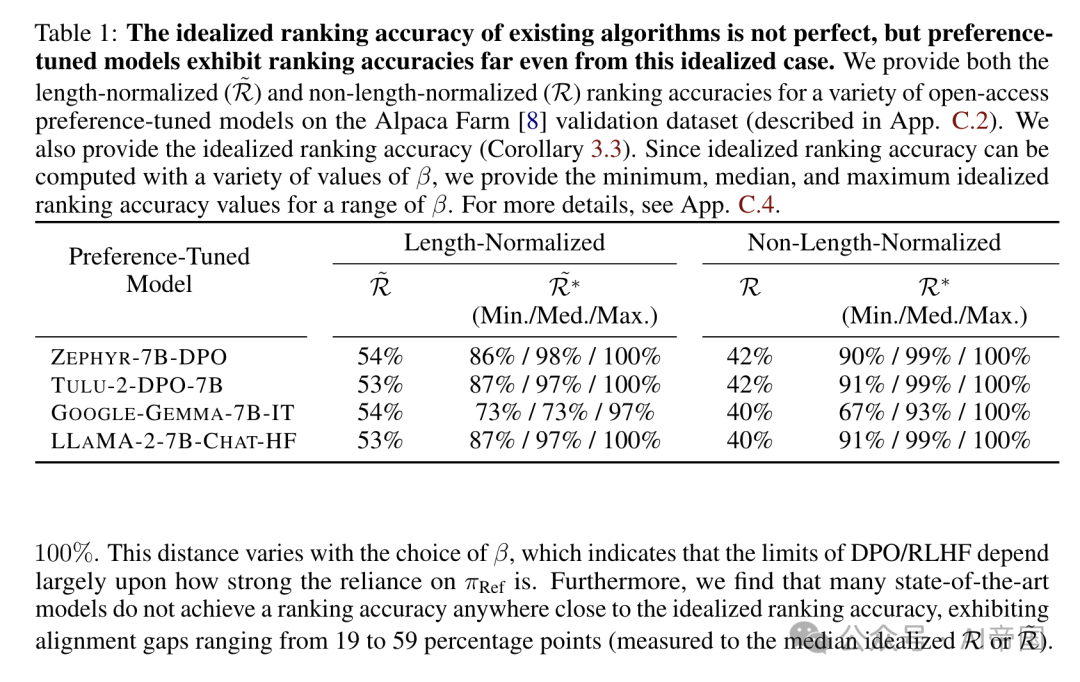

2.3.1 DPO很少改变偏好排序

为了研究DPO训练过程中排序准确性的变化,论文在Anthropic HH-RLHF偏好数据集上训练了三种规模的模型(GPT-2、Pythia 2.8B和Llama 2-7B),每种模型都有三个随机种子,并研究了训练数据集的不同分区上的排序准确性。论文在图2中展示了训练一个Pythia 2.8B模型的结果,其他两个模型的结果放在附录D.2中。在图2中,论文根据参考模型πRef是否具有正确的排序以及当前模型πθ是否具有正确的排序,将训练数据集中随机抽取的1K个样本划分为四组。

令人惊讶的是,图2显示,尽管DPO在训练过程中持续降低损失Cppo,但它很少改变排序。除了模型忘记正确偏好排序的那组点之外,论文观察到损失持续下降,奖励边际持续增加。然而,在验证损失最低的点,不到一半的错误排序点已被翻转为正确的排序。这表明DPO目标在实际中诱导高排序准确性方面存在问题。

图片

图片

图2:尽管不断降低损失,DPO很少颠倒对子的排名,而是主要增加了已正确排序对子的奖励边际。论文使用DPO目标训练了一个Pythia-2.8B模型,并将训练数据集分为四个子集:初始时排名正确并被翻转为(1)正确或(2)错误的例子,以及初始时排名错误并被翻转为(3)正确或(4)错误的例子。在所有三个图中,点的色调表示类别。虚线垂直线表示评估损失达到最低的训练步骤。论文还为另外两个模型提供了每种三个种子的结果,详见附录D

图片

图片

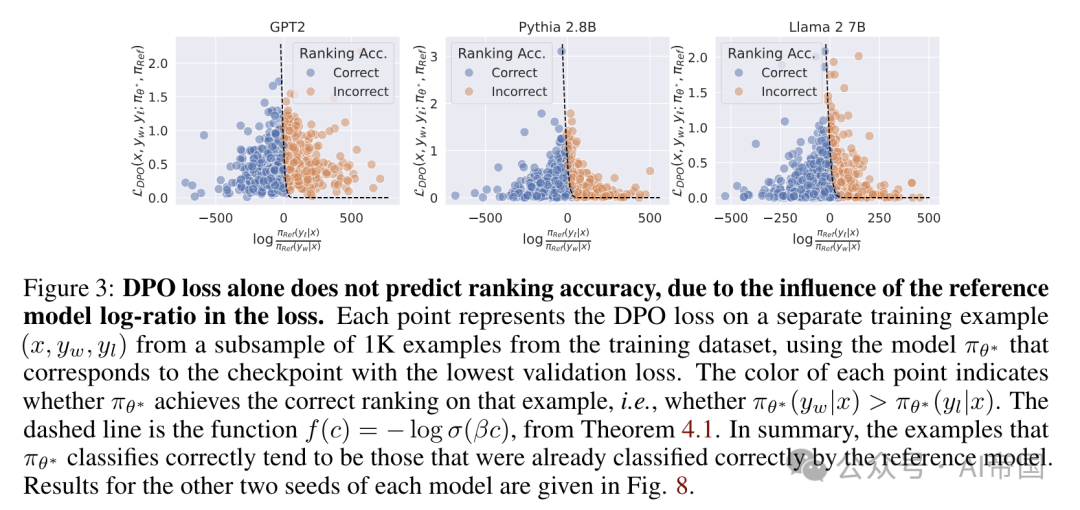

图 3:单独的 DPO 损失并不能预测排名准确性,这是由于损失中参考模型对数比率的影响。每个点代表来自训练数据集 1K 子样本中一个独立训练示例的 DPO 损失,使用的是对应于验证损失最低检查点的模型 rg-。每个点的颜色表示 wg 是否在该示例上实现了正确的排名,即是否 o (yw .c) > To* (yw w)。虚线是定理 4.1 中的函数 f(c) = - log o(3o)。总之,tg- 正确分类的示例往往是参考模型已经正确分类的那些。

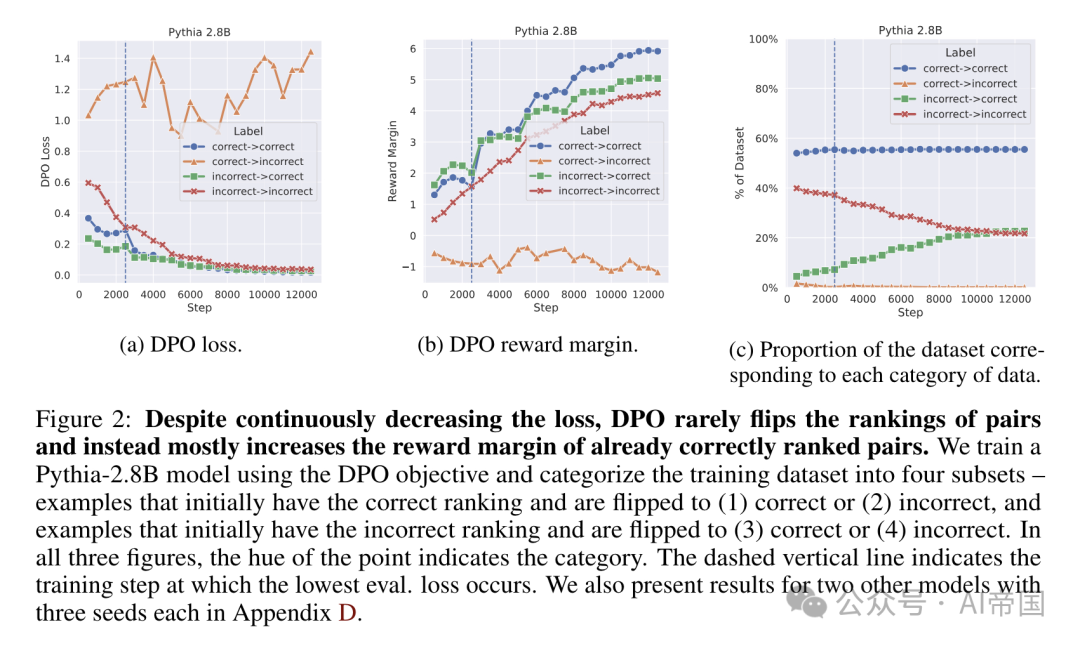

2.3.2 分析:翻转排名有多容易?

下面的结果表明,DPO 损失可以在模型排名准确性没有改善的情况下显著降低。论文的理论成果使论文能够正式识别那些在其排名中难以翻转的点。图 3 展示了多种设置下的参考模型对数比率,并强调了即使在参考模型中排名错误轻微的数据点,也需要损失降低到非常低的值才能翻转排名。论文观察到,难以学习的数据点明显比易于学习的点要长,而且易于学习的数据点通常包含的偏好注释较为明确。更广泛地说,论文的结果激发了使用更强大的 TRef 模型以及 DPO 的迭代或策略内变体的需求。

2.4 排名准确性与胜率

论文对排名准确性的研究揭示了 DPO 和 RLHF 如何与偏好数据对齐,但论文尚未将这些见解与模型在对齐过程中生成行为的变化联系起来。特别是,排名准确性是一个方便但策略外的指标,因此不如策略内指标(如胜率)那样被广泛采用(见第 2.2 节)。论文通过排名准确性和胜率的视角,探讨了大型语言模型(LLMs)的策略内(即生成性)和策略外(即分类性)行为之间的差距。由于 DPO 目标直接优化排名准确性(命题 2.6),这两个指标之间的关系直接反映了策略外训练如何影响策略内行为。

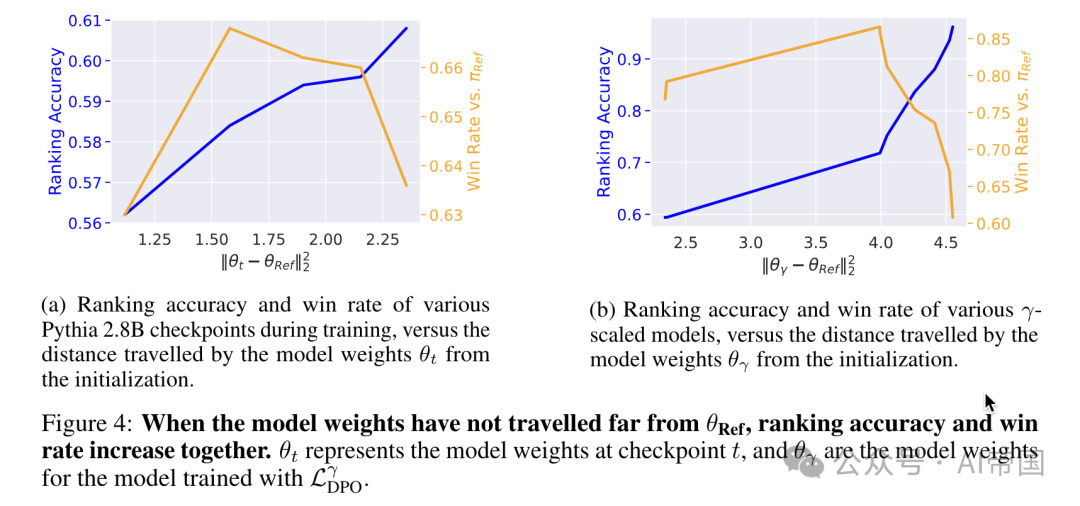

论文研究了胜率与排名准确性之间的关系,具体在两种情况下进行:(1) 在DPO训练期间,以及(2) 在一种调节TRef影响的DPO变体中。论文使用Alpaca Eval GPT4 自动标注工具对训练数据集中的500个响应进行胜率测量。

论文推测,当模型与参考模型相距较远时,向参考模型进行正则化可能会损害模型在预训练阶段主要获得生成能力。换句话说,当离线目标中使用的参考模型与当前模型相距甚远时,模型的离策略行为无法再可预测地描述在线策略生成。论文的发现证实了在拟合偏好数据与维持预训练阶段获得的生成能力之间的基本权衡[21],并与先前的观察结果一致,即添加在线策略偏好数据可以使离线学习更有效[48, 63, 23, 51]。

图片

图片

图4:当模型权重未远离ORef时,排名准确率和胜率同步增加。 表示在检查点t时的模型权重,而0,表示模型权重转移

表示在检查点t时的模型权重,而0,表示模型权重转移

论文标题:Preference Learning Algorithms Do Not Learn Preference Rankings