译者 | 布加迪

审校 | 重楼

本文介绍了如何使用Groq LPU推理引擎在Jan AI和VSCode中生成超快速响应。

每个人都致力于构建更好的大语言模型(LLM),而Groq专注于AI的基础设施方面,旨在确保这些大模型更快速响应。

本教程将介绍Groq LPU推理引擎以及如何在笔记本电脑上使用API和Jan AI本地访问它。本文还将把它整合到VSCode中,以帮助我们生成代码、重构代码、记入文档并生成测试单元。本文将免费创建我们自己的人工智能编程助手。

Groq LPU推理引擎简介

Groq LPU(语言处理单元)推理引擎旨在为拥有顺序组件的计算密集型应用程序(比如LLM)生成快速响应。

与CPU和GPU相比,LPU拥有更强大的算力,这减少了预测单词所需的时间,大大加快了生成文本序列的速度。此外,与GPU相比,LPU还可以处理内存瓶颈,从而在LLM上提供更好的性能。

简而言之,Groq LPU技术使你的LLM超级快速,实现实时AI应用。不妨阅读Groq ISCA 2022论文(https://wow.groq.com/isca-2022-paper/),以了解关于LPU架构的详细信息。

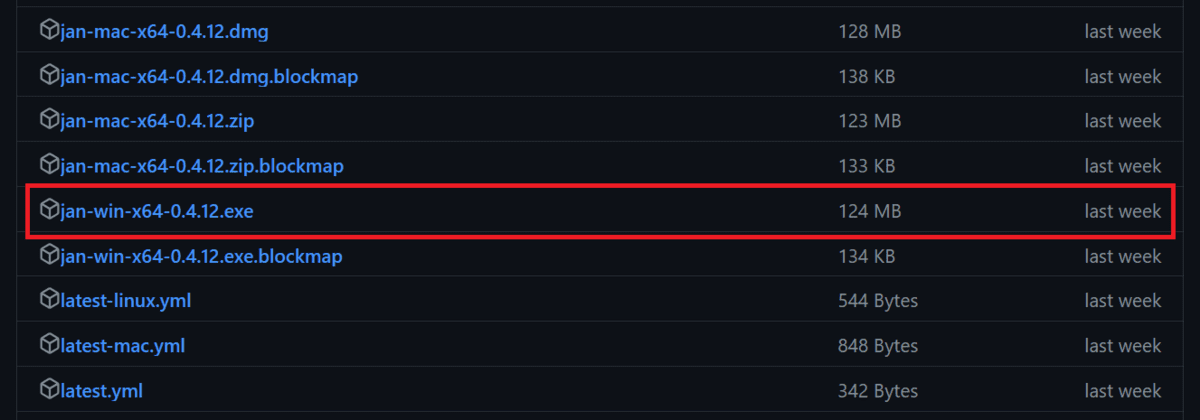

安装Jan AI

Jan AI是一个桌面应用程序,在本地运行开源和专有的大语言模型。它提供Linux、macOS和Windows版本供人下载。我们将下载Jan AI并安装在Windows中,为此进入到https://github.com/janhq/jan/releases,点击扩展名为“.exe”的文件。

如果你想在本地使用LLM以增强隐私,请阅读《在笔记本电脑上使用LLM的5种方法》博文(https://www.kdnuggets.com/5-ways-to-use-llms-on-your-laptop),开始使用最先进的开源语言模型。

创建Groq Cloud API

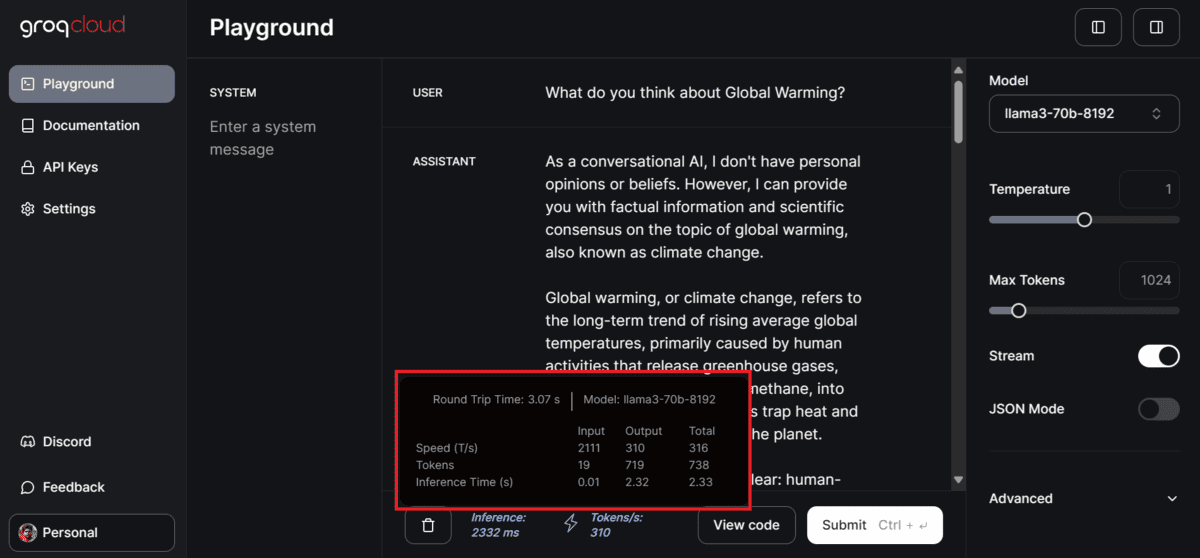

要在Jan AI中使用Grog Llama 3,我们需要一个API。为此,我们将进入到https://console.groq.com/,创建一个Groq Cloud帐户。

如果你想要测试Groq提供的各种模型,无需任何设置就能做到这一点,只需进入到Playground选项卡,选择模型,并添加用户输入。

在本文这个例子中,它非常快,每秒生成310个token,这是我迄今见过的最快速度。连Azure AI或OpenAI也无法获得这种类型的结果。

要生成API密钥,点击左侧面板上的“API密钥”按钮,然后点击“创建API密钥”按钮,创建并复制API密钥。

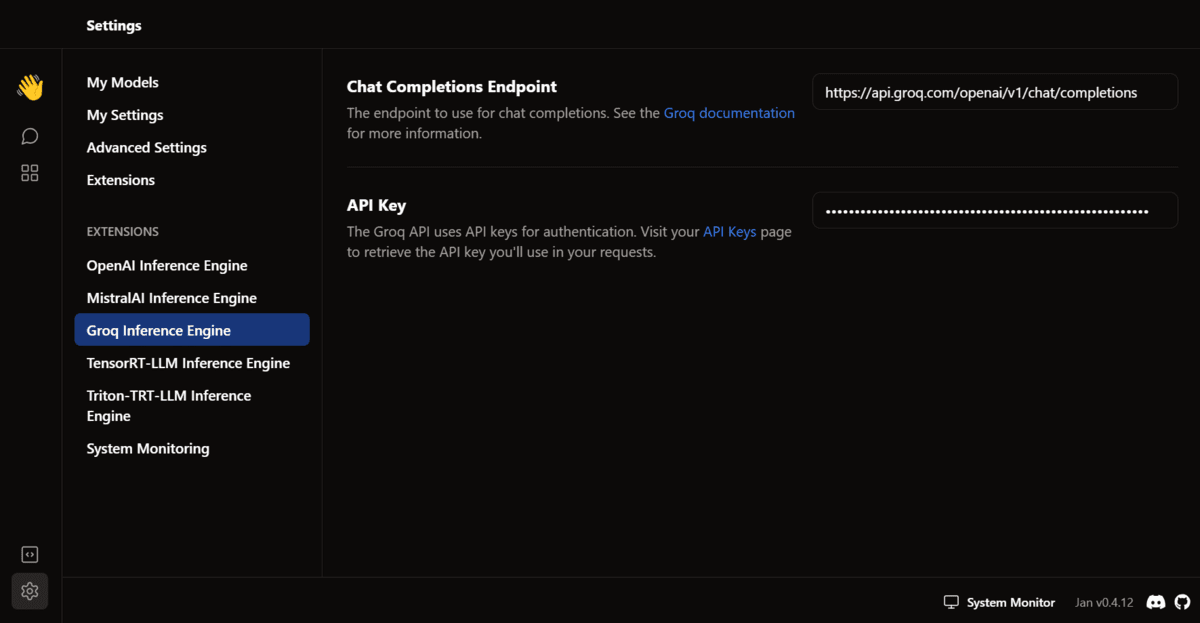

在Jan AI中使用Groq

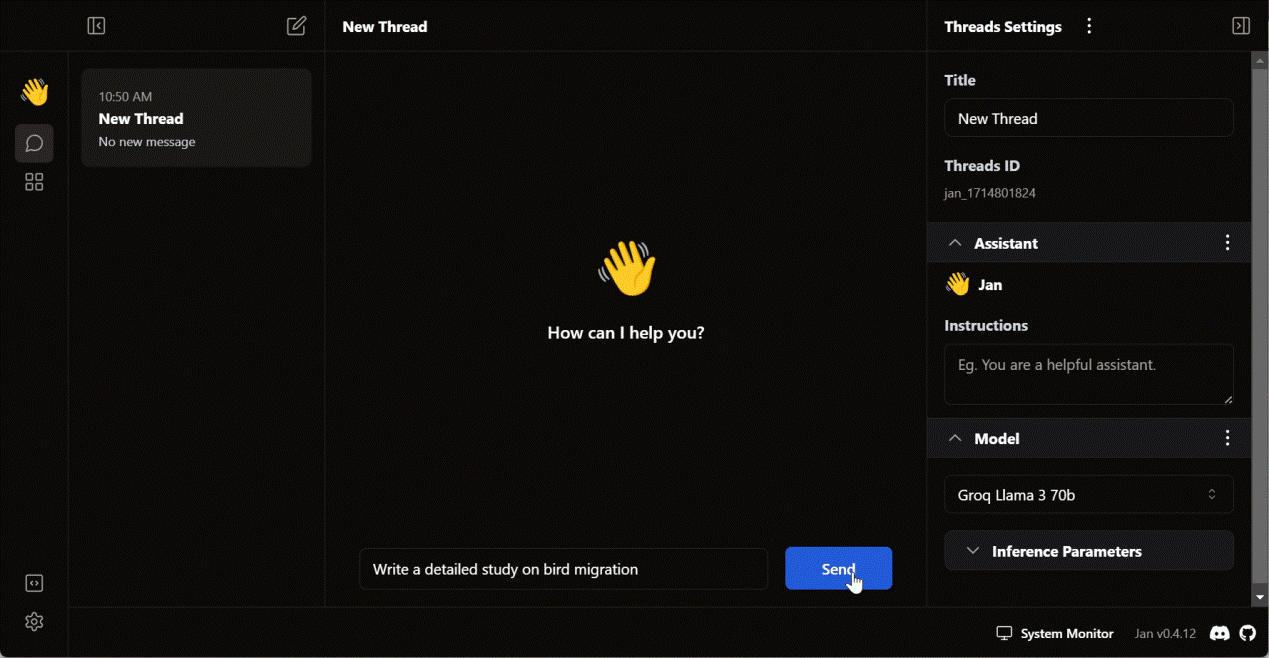

在下一步中,我们将把Groq Cloud API密钥粘贴到Jan AI应用程序中。

启动Jan AI应用程序,进入到设置,在扩展部分选择“Groq推理引擎”选项,并添加API密钥。

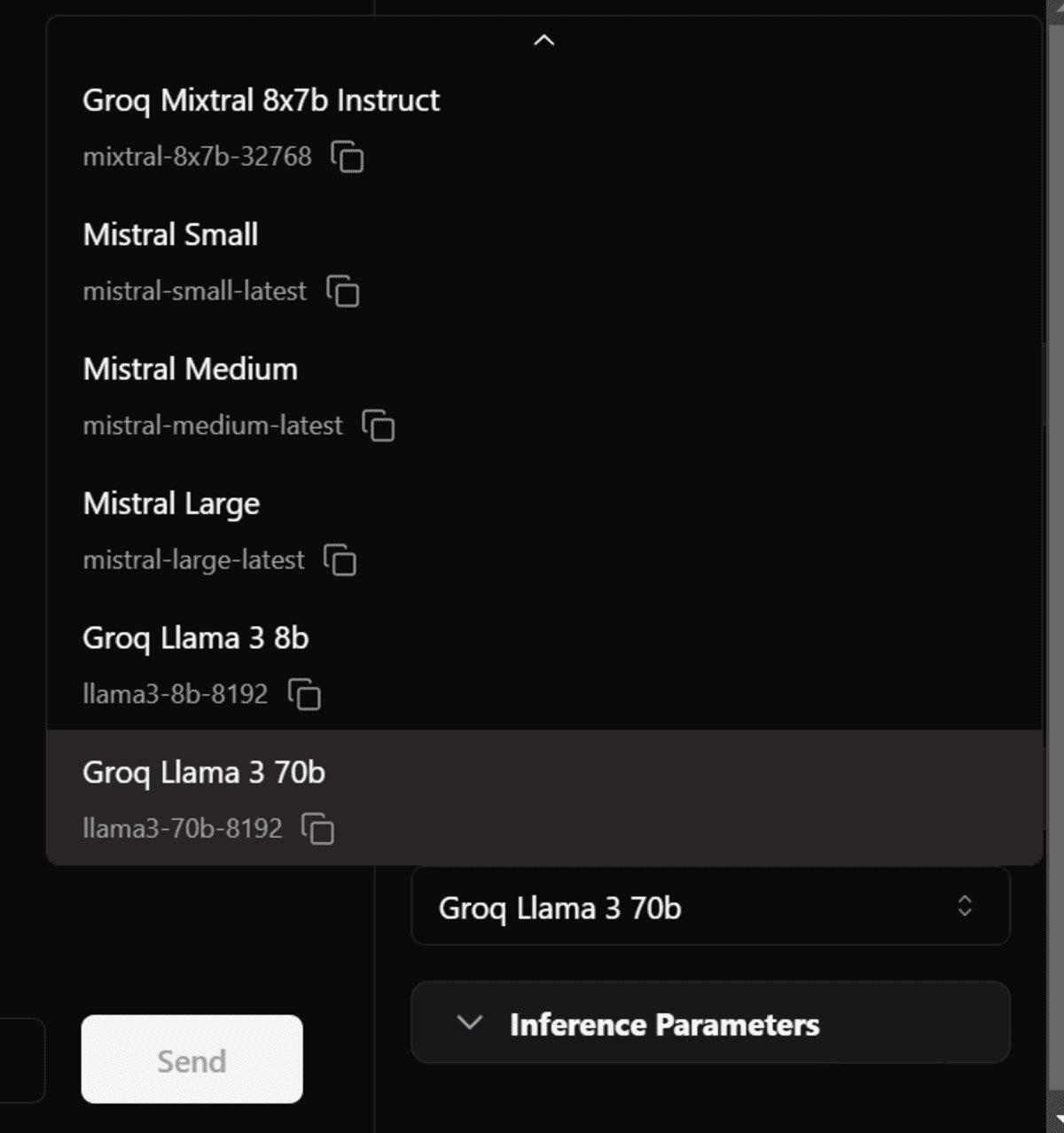

然后,返回到线程窗口。在模型部分,在“Remote”部分选择Groq Llama 370B,开始输入提示。

响应生成的速度太快了,我都跟不上了。

注意:该API的免费版本有一些限制。请访问https://console.groq.com/settings/limits,了解有关它们的更多信息。

在VSCode中使用Groq

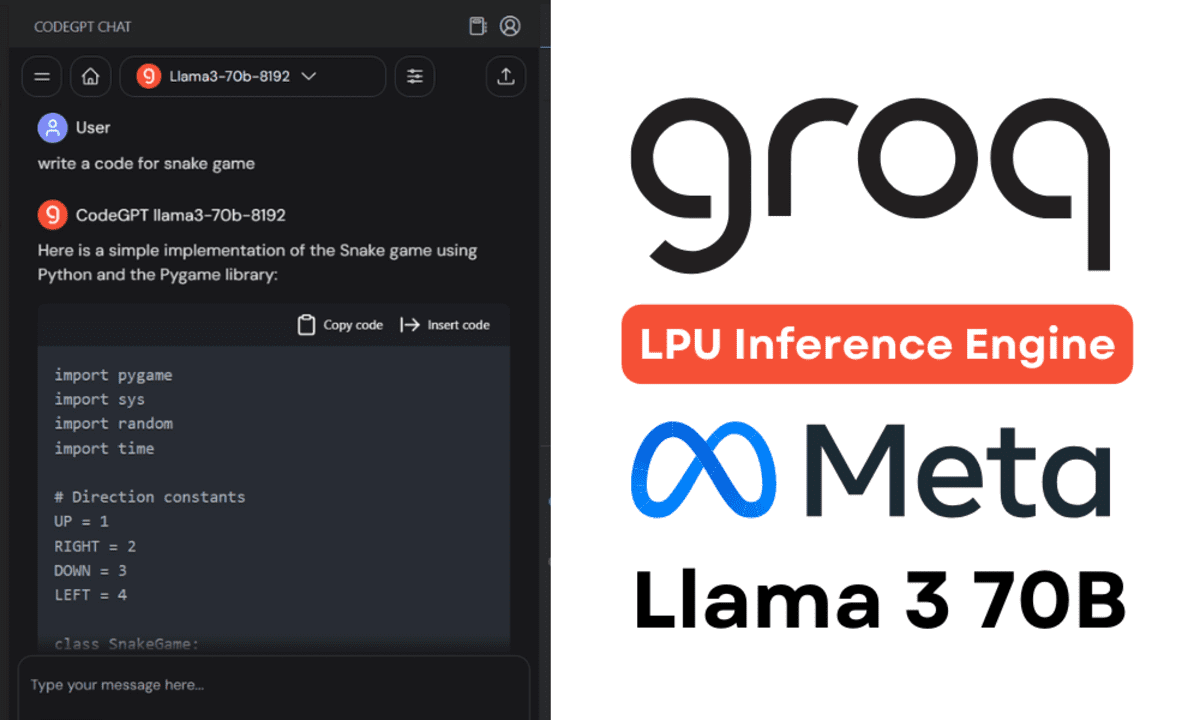

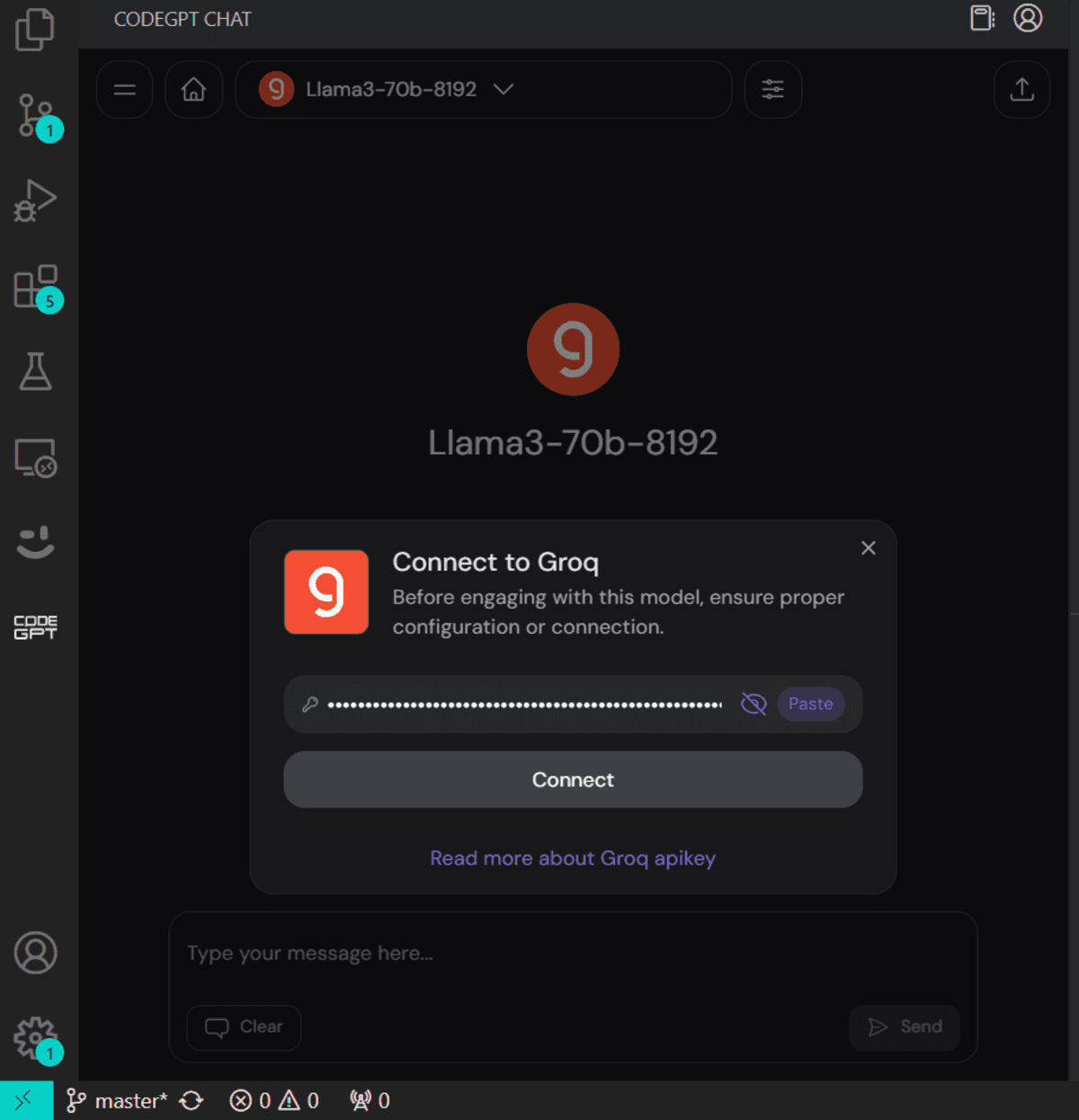

接下来,我们将尝试将相同的API密钥粘贴到CodeGPT VSCode扩展中,并构建自己的免费AI编程助手。

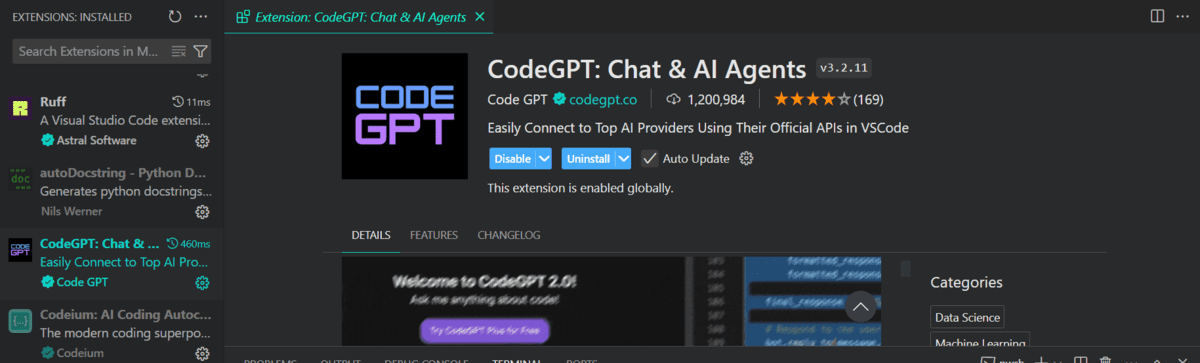

在扩展选项卡中搜索CodeGPT扩展,安装它。

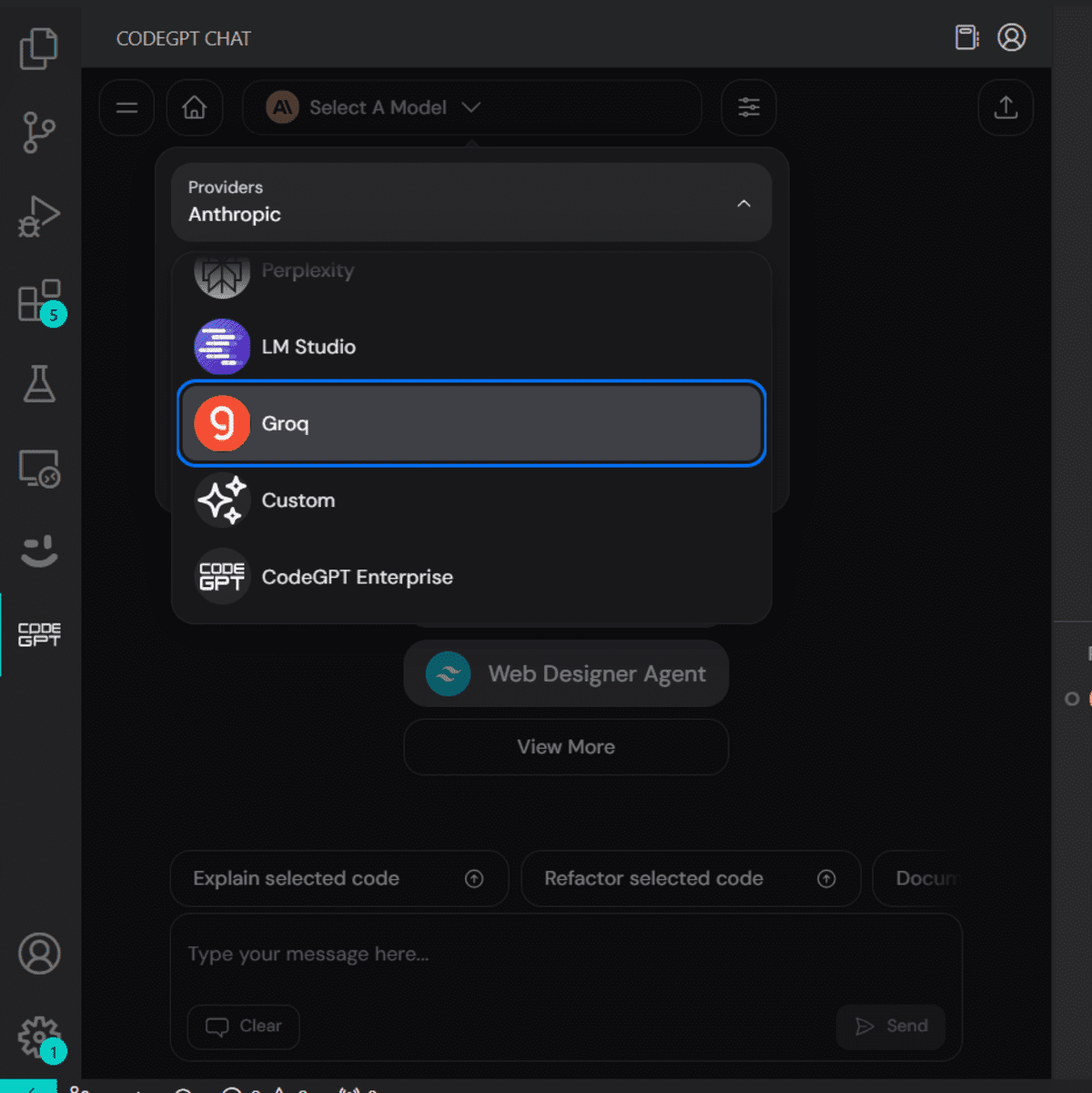

CodeGPT选项卡将出现,以便你选择模型提供方。

当你选择Groq作为模型提供方时,它将要求你提供API密钥。只需粘贴相同的API密钥,我们就可以开始了。你甚至可以为CodeGPT生成另一个API密钥。

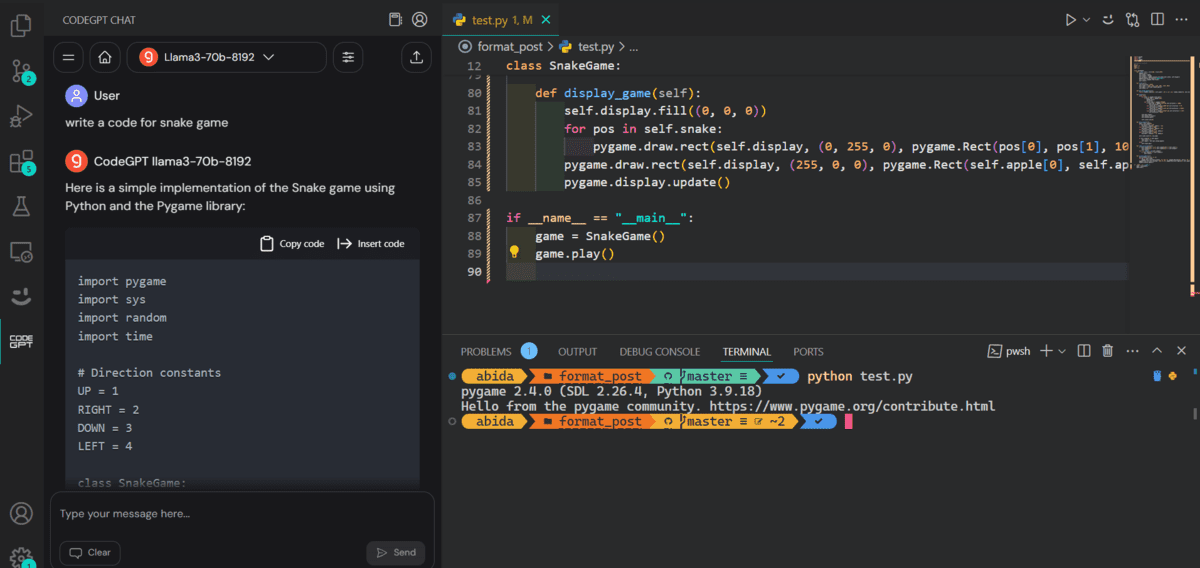

现在我们将要求它为蛇游戏编写代码。生成并运行代码只花了10秒钟。

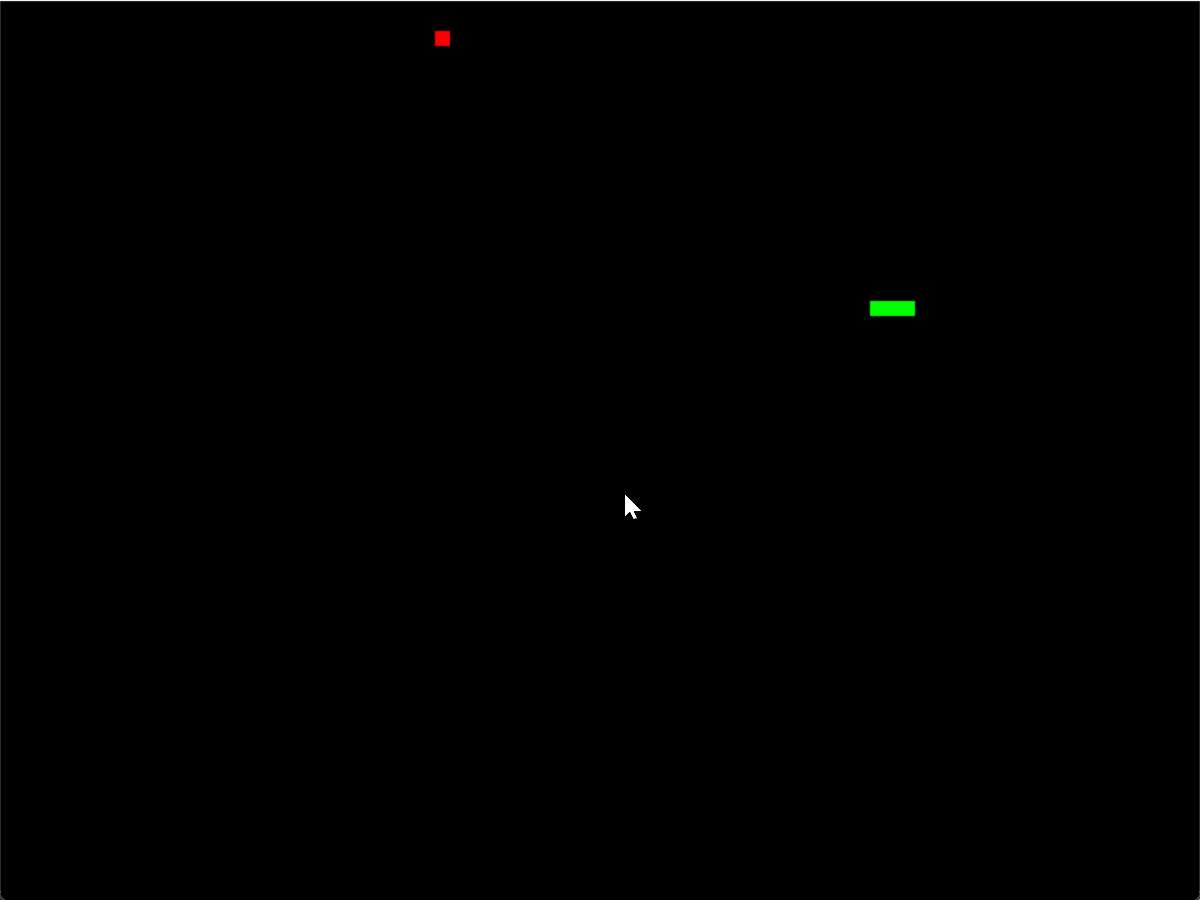

下面演示了我们的蛇游戏。

不妨了解五大AI编程助手(https://www.kdnuggets.com/top-5-ai-coding-assistants-you-must-try),成为AI驱动的开发人员和数据科学家。记住,人工智能旨在帮助我们,而不是取代我们,所以不妨对它持开放的心态,用它来提高代码编写水平。

结论

我们在本教程中了解了Groq推理引擎以及如何使用Jan AI Windows应用程序在本地访问它。最后,我们通过使用CodeGPT VSCode扩展,将其整合到我们的工作流中,这真是太棒了。它实时生成响应,以获得更好的开发体验。

原文标题:Using Groq Llama 3 70B Locally: Step by Step Guide,作者:Abid Ali Awan

链接:https://www.kdnuggets.com/using-groq-llama-3-70b-locally-step-by-step-guide。