本文经自动驾驶之心公众号授权转载,转载请联系出处。

写在前面&笔者的个人理解

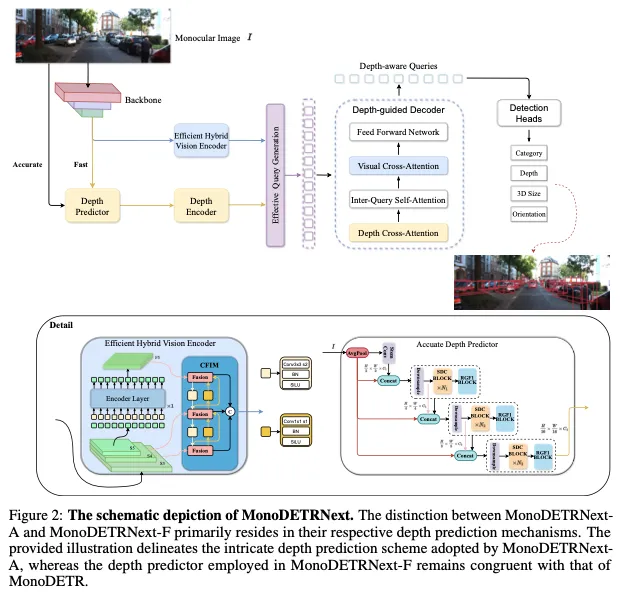

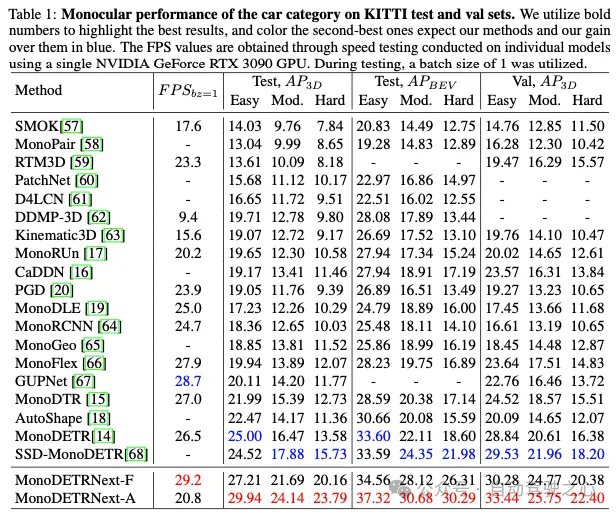

基于单目视觉的3D目标检测在各个领域都至关重要,但现有方法在准确性和计算效率方面面临着重大挑战。在2D检测和深度估计的成功策略的基础上,本文提出了MonoDETRNext,它寻求在精度和处理速度之间取得最佳平衡。我们的方法包括开发高效的混合视觉编码器,增强深度预测机制,以及引入创新的查询生成策略,并通过高级深度预测器进行增强。在MonoDETR的基础上,MonoDETRNext引入了两种变体:强调速度的MonoDETRNext-F和注重精度的MonoDETRNext-A。我们认为MonoDETRNext为单目3D物体检测建立了一个新的基准,并为未来的研究开辟了道路。我们进行了详尽的评估,证明了该模型相对于现有解决方案的优越性能。值得注意的是,与MonoDETR相比,MonoDETRNext-A在KITTI测试基准上的AP3D指标提高了4.60%,而MonoDETRNext-F提高了2.21%。此外,MonoDETRNext-F的计算效率略高于其前身。

总结来说,本文的主要贡献如下:

- 提出了两种新的单目3D物体检测模型,即MonoDETRNext-F和MonoDETRNext-A,前者充分平衡了速度和精度,而后者强调了以精度为中心的目标。

- 构建用于3D目标检测的混合视觉编码器,精通对单目3D目标检测任务至关重要的特征的有效提取,以及集成精细但轻便的深度估计模块,可视化以提高检测精度。

- 利用迄今为止在2D目标检测范式中根深蒂固的方法,我们提出了一种有说服力的目标查询生成策略,该策略以精心设计的训练策略为基础,旨在有效优化模型性能,以适应单目3D目标检测的需求。

相关工作回顾

目前的3D目标检测方法通常可以分为两类:基于相机的方法和集成激光雷达和其他传感器的融合方法。

基于相机的方法可以根据输入视点的数量进一步分为单目(单视图)和多视图方法。单色探测器仅使用前向图像作为输入,以有限的2D信息处理更复杂的任务。多视图检测器同时对周围场景的图像进行编码,利用视点之间的关系来理解3D空间。另一方面,基于激光雷达和其他传感器集成的融合方法依赖于来自深度相机和激光雷达等设备的输入,这些设备提供了各种传感器数据类型的融合,包括图像和点云。因此,他们可以获得更丰富、更全面的深度信息。尽管成本较高,但这些方法通常在复杂环境中表现出更大的鲁棒性和准确性,因为它们可以利用多个传感器的优势并集成来自不同数据源的信息。

MonoDETR and other monocular 3D detection

MonoDETR是一种最先进的方法,它利用渲染传输从单个RGB图像预测深度图。与传统的单目深度估计方法相比,通过捕捉输入图像中的细微线索,MonoDETR实现了对不同照明条件的准确度和鲁棒性的提高。

近年来,已经提出了其他几种单目3D重建方法。例如,MonoDTR是一个深度学习模型,使用基于Transformer的架构从单个RGB图像预测深度图。虽然MonoDTR实现了高精度,但它需要额外的激光雷达数据来辅助训练。同时,CaDDN和Monorun不仅在训练过程中需要激光雷达数据,而且在推理过程中也需要数据。Autoshape将CAD数据集成到模型中,以增强受限制的3D提示。MonoDETR需要最小的2D-3D几何先验,并且不需要额外的注释。我们的MonoDETRNext继承了这一特性。

如MonoDLE、PGD和PackNet所示,替代方法集成了多尺度特征融合和注意力机制,用于深度图估计和误差分析,从而提高了性能。尽管这些方法具有很高的准确性,但会产生大量的计算成本,并需要大量的内存资源。相反,MonoDETR的特点是其重量轻、效率高。此外,MonoDETRNext-F在速度和效率方面超过了它,而MonoDETRNext-A表现出明显优越的性能。

Multi-view 3D object detection

为了从周围视图中联合提取特征,DETR3D最初采用一组3D目标查询,然后将其反向投影到多视图图像上以聚合特征。PETR系列进一步介绍了3D位置特征的生成,避免了不稳定的投影,并探索了前一帧的时间信息的优势。

或者,BEVFormer及其改进使用可学习的BEV查询生成BEV(鸟瞰图)特征,并引入用于视觉特征聚合的时空BEV转换器。随后的研究还研究了跨模态蒸馏和mask图像建模以提高性能。

LiDAR and multi-source information fusion 3D object detection

DeepFusion和PointPainting等方法代表了激光雷达点云数据与相机图像集成的显著进步,以促进三维空间环境中的精确目标检测。这种融合策略最佳地利用了不同传感器模态固有的协同效应,将空间深度线索与颜色纹理信息融合在一起,从而增强了检测结果的弹性和准确性。

BevFusion将BEVFormer的原理集成到融合范式中,促进了进一步的改进,最终提高了精度,MV2D和Futr3d中描述的示例模型证明了这一点。mmFusion最近的端点通过集成来自多个传感器(包括相机、激光雷达和雷达)的数据,扩展了融合方法的范围,从而在性能上取得了显著进步。

与此同时,该领域见证了大规模架构的出现,例如OMNI3D和GLEE,它们在3D目标检测任务中表现出了显著的效率。利用丰富的训练数据和以数十亿个或更多参数为特征的复杂模型架构,这些框架已经使用先进的优化算法进行了训练,从而提高了检测性能和精度。

方法

Efficient Hybrid Vision Encoder

根据[36]中的研究结果,可变形DETR将其49%的计算工作量分配给编码器,但该组件仅对平均精度(AP)指标贡献11%。

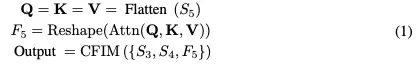

受RT-DETR架构的启发,我们设计了一种创新的高效混合视觉编码器,专门为3D目标检测任务量身定制。该编码器的特点是减少了计算占用,同时保持了特征提取的效率。如图2所示,我们提出的编码器包括两个集成元件:奇异编码器层和基于CNN的跨尺度特征集成模块(CFIM)。如图3所示,CFIM起着融合单元的作用,将形容词特征融合成新颖的表征。该融合过程如以下公式:

Accurate Depth Predictor

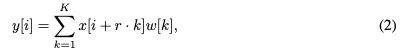

The Sequential Dilated Convolution (SDC)模块,利用膨胀卷积提取多尺度局部特征。与lite-mono类似,我们采用了一种分阶段的方法,通过插入具有不同膨胀率的多个连续膨胀卷积来有效地聚合多尺度上下文。

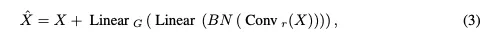

The Regional-Global Feature Interaction (RGFI)的操作如下:给定输入特征图X,它被线性投影到查询、键和值中。交叉协方差注意力用于增强输入X:

Effective Query Generation and Overall Loss

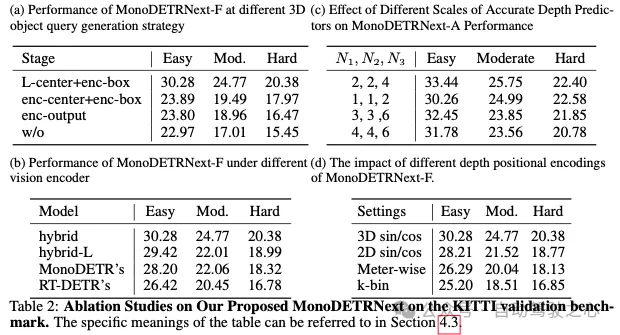

实验结果

结论和限制

结论:本文介绍了一种新的基于单目视觉的3D目标检测方法。利用2D检测领域的进步,我们提出了高效而精确的MonoDETRNext。在MonoDETR奠定的基础上,我们引入了两种变体:MonoDETRNext-F优先考虑速度,MonoDETRNext-A强调准确性。我们的方法包括开发高效的混合视觉编码器、增强深度预测机制以及改进目标查询生成。通过综合性能评估,我们确定了我们的模型相对于现有方法的优势。通过优化精度和计算效率,MonoDETRNext在单目3D目标检测方面树立了一个新的基准,促进了未来在各种现实世界场景中的研究和应用。

局限性:尽管MonoDETRNext在提高单目3D物体检测的准确性和计算效率方面取得了实质性进展,但仍存在某些局限性。由于单目视觉方法的固有限制,与采用多视图方法或传感器融合技术(如激光雷达与相机的集成)的方法相比,在精度和性能方面仍然存在显著差异。