大神Karpathy已经不满足于用C语言造Llama了!

他给自己的最新挑战:复现OpenAI经典成果,从基础版GPT-2开始。

挑战成功本身并不意外,但是只花费20美元、90分钟完成训练,Loss和评测还超越原版,就!有!点!过!分!了!。

不仅如此,他把复现过程写成了完整教程,果不其然再次火爆。

由于Karpathy自己租用的是A100云服务,训练124M版本花费20了美元。

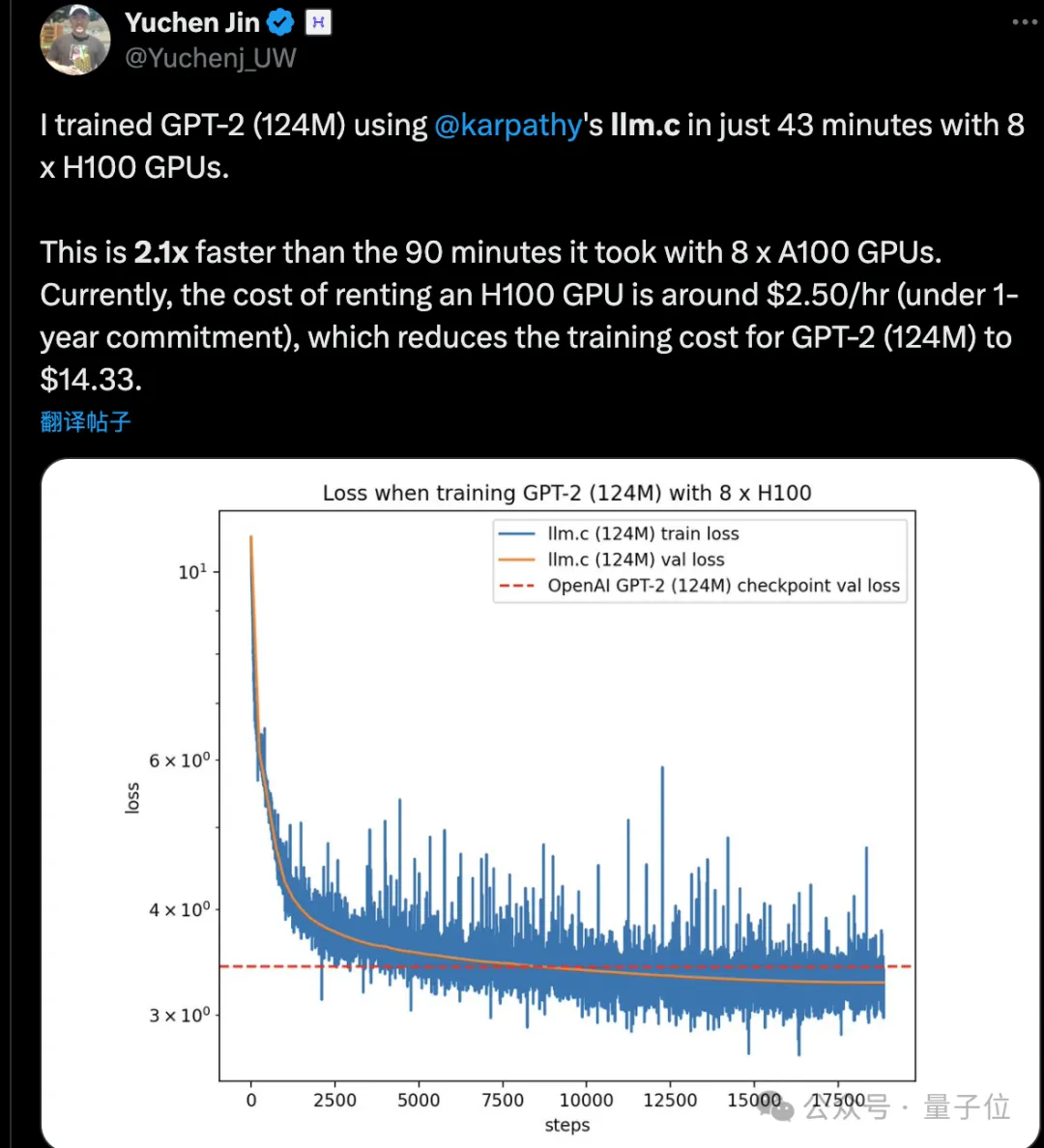

不过有人按照教程用H100跑了一把,不仅训练时间更短,还更省钱了:43分钟完成,只花14美元。

另外Karpathy还自掏腰包200美元,为大家复现了350M版本的GPT-2。

但1.5B大杯版,照计算要花1周时间和2500美元,有点玩不起了,主要他手里也没有H100。

还好各路卡壕非常仗义,该出手时就出手:

有需要随时给你用!

只收你2美元一小时!

90分钟复现GPT-2

这次Karpathy复现GPT-2,还是基于他的llama.c代码库,端到端完成训练。

代码库这些日子被他不断完善,现在启动训练非常简单:

具体来说,网络结构是GPT-2,但许多超参数设置遵循了GPT-3的那一套。

Karpathy分析,按照Chinchilla定律的标准,GPT-2在100B tokens上训练应该属于过度训练了,后面收益递减,124M模型按计算2.5Btokens就够。

不过他自己训练了10B tokens,训练数据也用刚刚发布不久FineWeb,比起OpenAI原版WebText数据集token质量更高。

原版WebText从未公开,无法在控制变量在相同条件下实验,另外今天的互联网数据分布,也可能与5年前大不相同了。

据推测,评测分数比原版更高的原因可能就在这些差别了。

另外有网友注意到,训练时的GPU利用效率也比OpenAI的工作高,不过Karpathy表示主要是由于用了单个云服务节点,不需要考虑服务器间通信问题。

最后,对于已训练完的350M版本GPT-2,同样取得了超越原版的成绩。

掌声响起来~

大神也不是那么卷

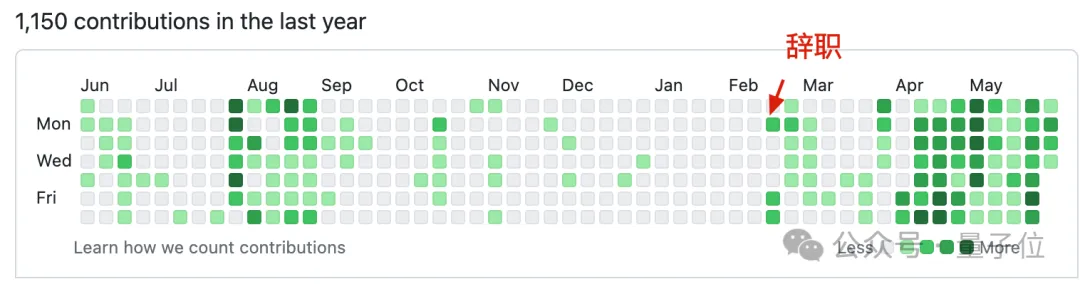

自今年二月份再次从OpenAI辞职之后,Karpathy已经用C语言搞出不少大模型成果,从Llama到GPT玩了一遍。

观察他的GitHub热力图,只有刚开始休息了一段时间,进入4月以后就越来越卷了。

这是辞职在家还要997的节奏?

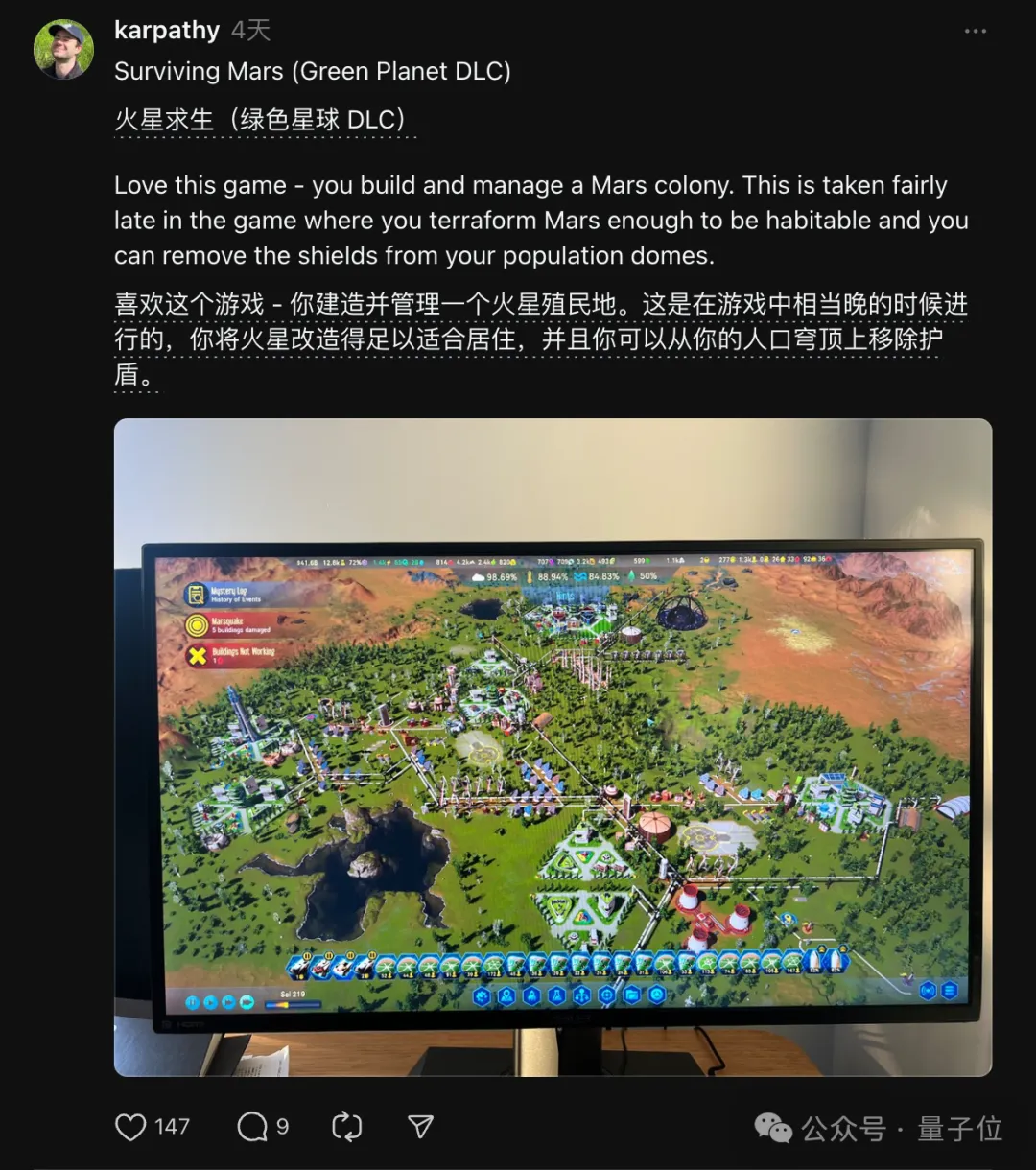

其实Karpathy这段时间也旅游过,也分享过在打的游戏,并没那么卷。

根据他晒出的一周时间表:在职时975,离职后工作4-20小时不等,看心情。

- 周一工作4小时,

- 周二工作14小时到晚上11点

- 周三失眠了,4点爬起来写代码,到中午崩溃

- 周四干了20小时

- 周五休息

- 周六12小时

- 周日4小时

- 然后出去旅游两周。

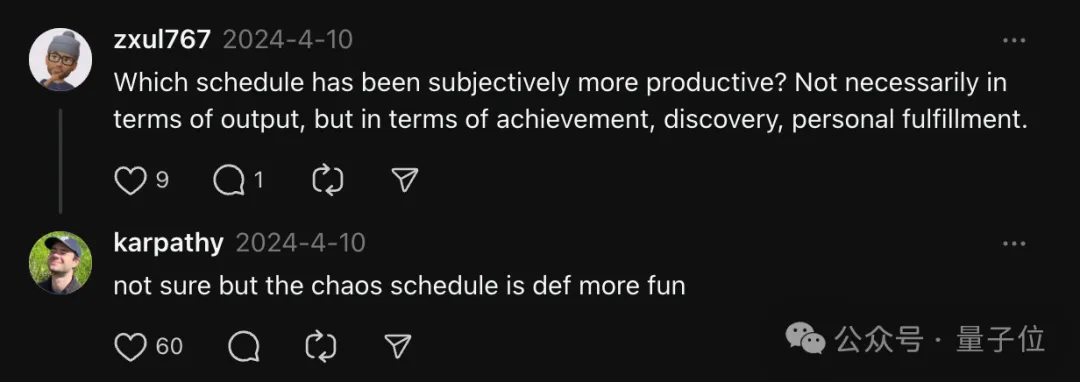

大家看到这里也比较好奇,是规律的安排感觉更好,还是随心所欲能有奇效呢?

Karpathy自己也不确定,不过混乱的日程安排肯定更有趣。

最后他还分享了一条自由职业心得:

起床后直接开始工作,不看任何消息,吃完午饭再上网,避免外界信息分散注意力。

有条件的朋友可以试试了。

教程:https://github.com/karpathy/llm.c/discussions/481。

参考链接:

[1]https://x.com/karpathy/status/1795484547267834137。

[2]https://www.threads.net/@karpathy。