「OpenAI下一代前沿模型,正在训练中」。

经历了几周前Ilya、安全团队负责人Jan Leike离职后,超级对齐团队也被OpenAI解散。

今天,奥特曼领衔的OpenAI全新的「安全与保障委员会」官宣成立。

不仅如此,OpenAI预计,正在训练的下一代旗舰模型,将带领他们通往AGI的道路上迈向新的水平。

OpenAI研究科学家,德扑之父发帖确认了新模型训练的消息。

安全委员会的成立,下一代模型的布局,一切说明了OpenAI已非常接近AGI。

虽然这是板上钉钉的官方实锤,但只是含糊不清地用了一句「前沿模型」,并没有确认会不会是GPT-5或者其他型号。

模型官宣引起的讨论完全抢走了新成立安全委员会的风头(不知道是不是奥特曼故意安排的)。

下一代模型全网大猜想

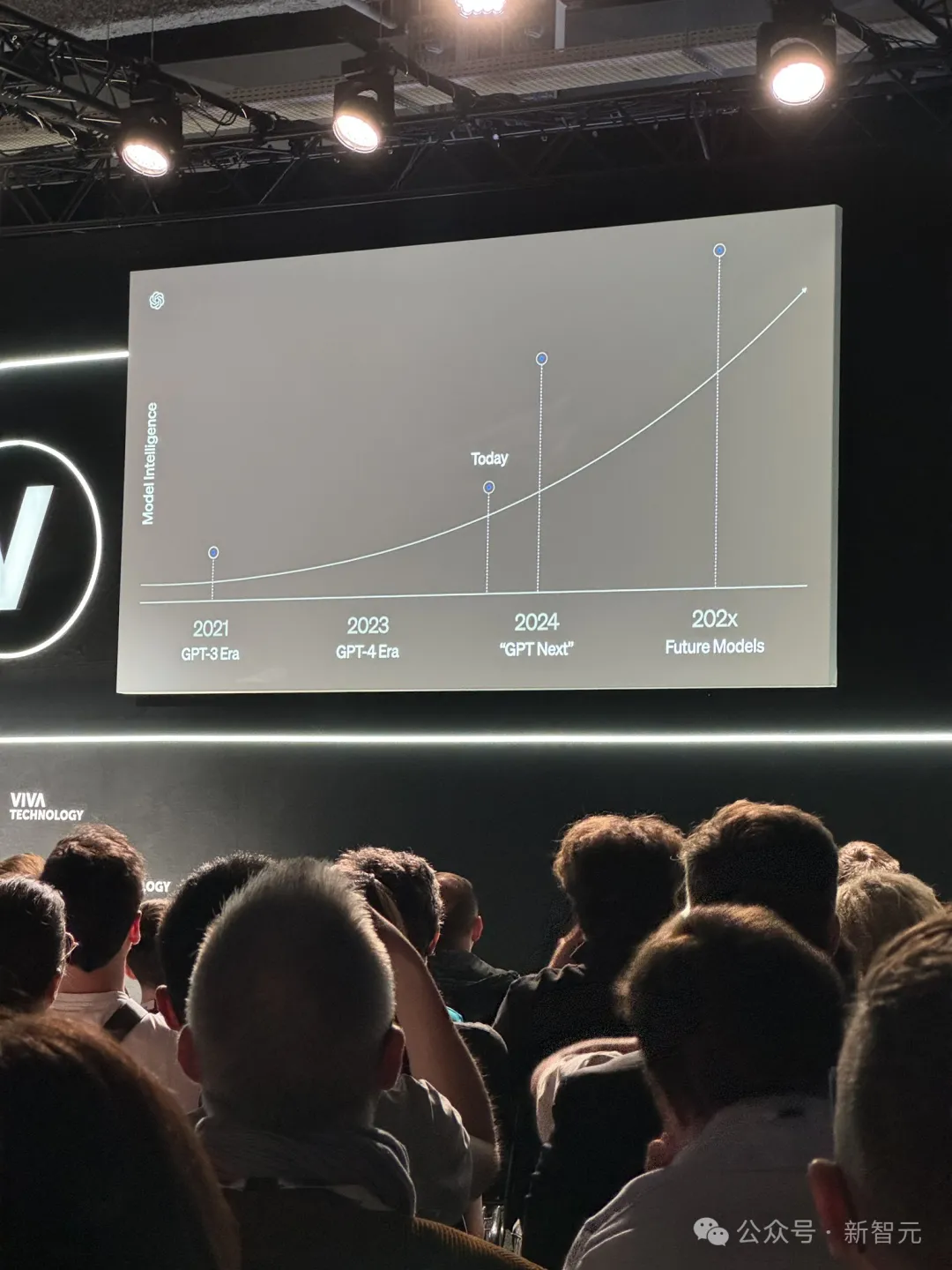

GPT-4之后,全网对于OpenAI发布的下一代旗舰模型臆测了很久。

不过,这一次,他们提到的前沿模型,究竟是什么?

几天前,巴黎VivaTech科技活动上,OpenAI开发者体验负责人暗示了,今年一定会发新模型「GPT Next」,而且网友猜测预计在11月发布。

大多数网友纷纷认定,这次可能就是GPT-5了。

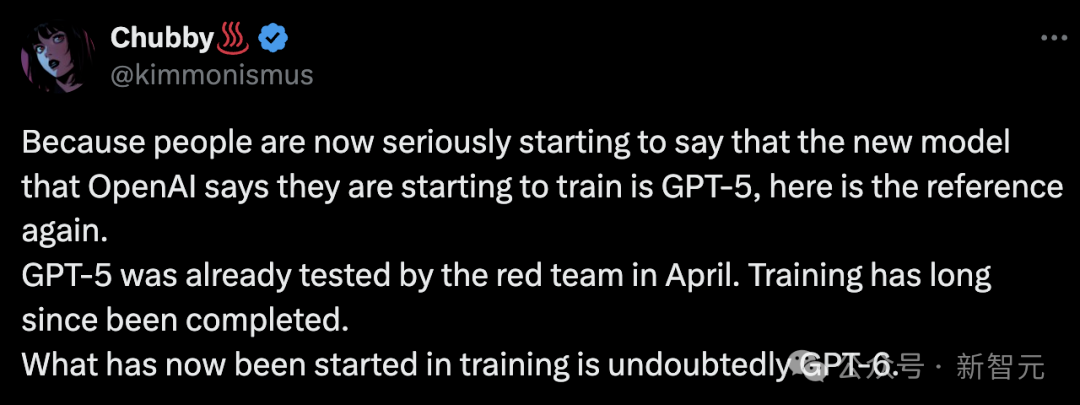

不过,又有人指出,在今年4月的时候,GPT-5早已开始了红队测试。

这完全说明了GPT-5的训练早已完成,OpenAI正在研究的下一代前沿模型绝不可能是GPT-5。

因此,他们训的是GPT-6无疑了。

另一位爆料人Flowers更加确认了这一点,OpenAI当然没有刚开始训练GPT-5。

同时,他还坚持表示,也不会有GPT-6。

当有人问道,为什么这么确信OpenAI没有GPT-6时,Flowers首次透露出一个新奇的点子:

「因为大模型的发展已经接近它们的极限」。

尽管可以通过使用工具、增加功能、提升多模态能力,扩展上下文等方式来改进LLM,但这终将不是长久之计。

但Reddit上有人发帖否认了GPT-5的猜想,甚至新模型应该不属于GPT家族,而是Q*,理由如下:

- GPT-5从12月/1月就开始训练,大致是目前GPT-4o的底层架构,不可能再发布一次

- 如果扩展到GPT-6,则需要储备更多的算力

- 要真正实现LLM的逻辑推理和长期任务规划能力,就需要训练一个新模型来操作LLM,而OpenAI一直在研究Q*来解决这个问题

楼主还提出了Q*方法的大致原理:

- 先提出一个复杂的Agent任务

- 让GPT生成数百万个潜在解决方案,以树状结构表达,树中每一个节点代表Agent推理的一个步骤

- 让GPT对每个解决方案评分

在已经有一个强大GPT模型的基础上,重复这个过程就能创建出一个庞大的数据集,用来训练新模型指导LLM完成长期的推理或规划任务。

这种猜想甚至比GPT-5更激动人心,评论区就有人回复说「像Q*这样的东西即使不大,也能改变整个游戏」。

也有评论力挺这种说法,因为OpenAI经常谈到Agent。现在可能无法使用内置的逻辑推理Agent来训练LLM,但用外置的新模型对LLM进行「指导」是可行的。

算力体量有多大?

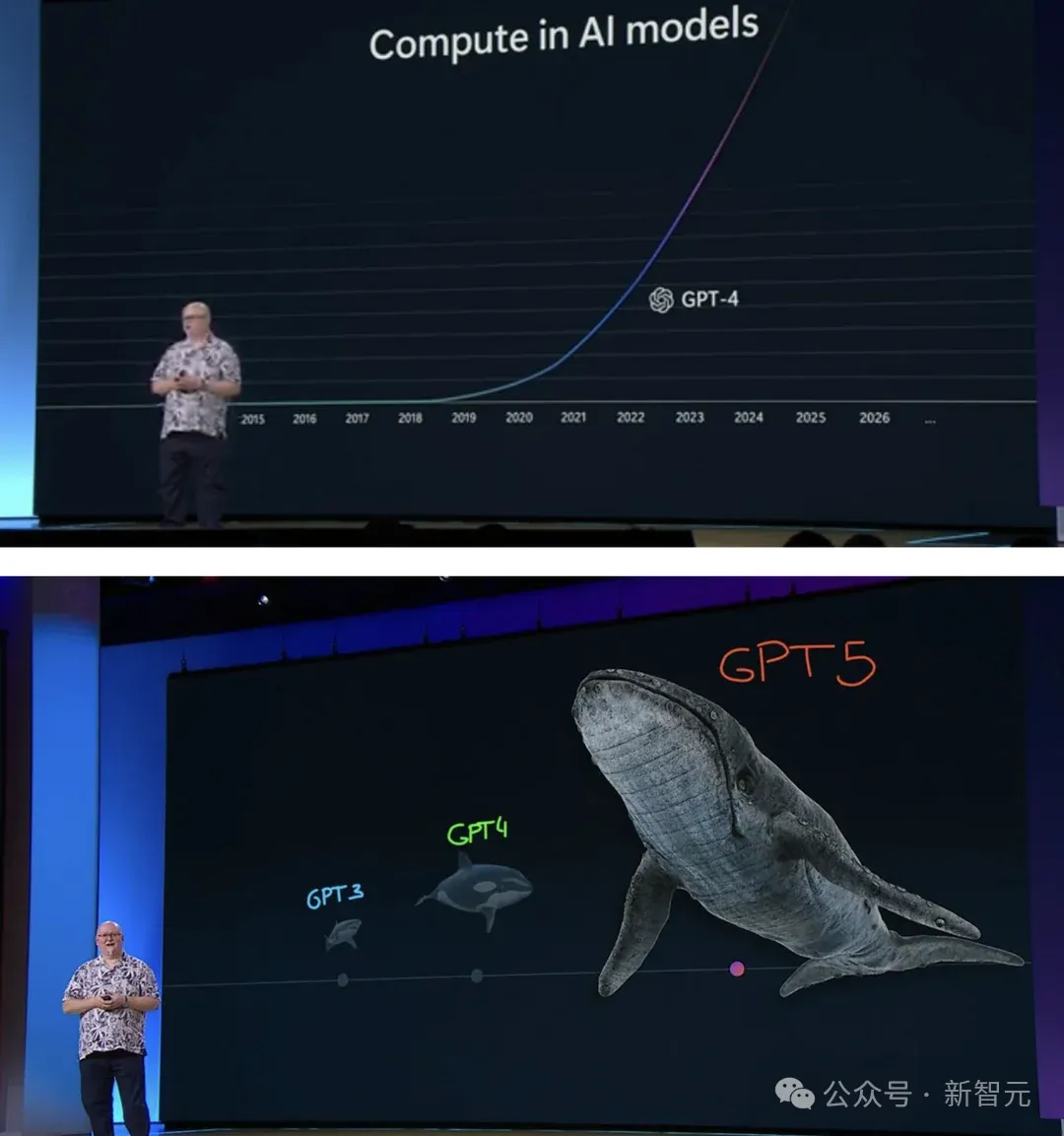

下一代前沿模型虽未知,不过微软Build大会上,CTO Kevin Scott表示,微软正在为OpenAI打造「鲸鱼」级别的超算。

当时训练GPT-3使用的是「鲨鱼」级的算力,GPT-4则用上了「虎鲸」级的算力。

90天倒计时开始,全力打造AGI

除了奥特曼本人,「安全与保障委员会」的董事会成员还有主席Bret Taylor、Adam D'Angelo、Nicole Seligman,共四个人。

「安全与保障委员会」的首要任务将是,在接下来的90天内,评估改进OpenAI现有的AI安全和保障的流程措施。

90天期满后,他们将与全体董事会提交一份报告。

经过董事会的审查之后,OpenAI将公开分享所采纳的改进措施。

因此,有理由得出结论,无论下一代「前沿模型」是什么,至少它在90天内不会发布。

委员会中,除了董事会成员,还包括:

OpenAI的技术和政策专家Aleksander Madry(Preparedness团队的负责人)、Lilian Weng(安全系统负责人)、John Schulman(对齐科学负责人)、Matt Knight(安全负责人)和Jakub Pachocki(首席科学家)。

此外,OpenAI还聘请了外部网络安全和技术专家,比如Rob Joyce、John Carlin,来提供咨询意见。

不搞「超级智能」

奥特曼此前,曾对外公开宣称,OpenAI终极目标是打造一种比人类先进的「超级智能」。

他甚至表示,2023年自己有一半的时间都在研究「如何打造超智能」。如今这一说法,却被另一位高管否认。

OpenAI负责全球事务的副总Anna Makanju在接受FT采访中提到:

我们的使命是打造AGI,并非是「超级智能」。因为超级智能是一种比地球上人类高出多个数量级的技术。

不过,她还补充道,「AGI还不存在,我们在确保其安全前,不会发布这样的技术」。

委员会并非独立

一些人批评到,新的委员会完全由OpenAI的「自己的高管」组成,这意味着对该公司安全措施的评估,将不会是独立的。

还有网友调侃道,这不都是由奥特曼本人组成的安全委员会。

之所以出现这样的声音,是因为OpenAI董事会去年发动的政变,成为一直以来争议的来源。

2023年11月,奥特曼被董事会解雇,理由是「他并不坦诚」。

而最近,由两名前董事会成员在TIME期刊上撰写的文章中,更是对奥特曼对OpenAI的治理提出了严厉的批评。

她们表示,Ilya和其他安全对齐团队人员的离开,预示着OpenAI「自治实验」的前景不妙。

团队重组

在Ilya Sutskever和负责人Jan Leike离职后,许多人愈加担忧,OpenAI如何管理类AGI技术的潜在危险。

彭博称,Ilya走后,OpenAI将他原先团队中剩余的成员,整合到了更大的研究部门,而不是保留独立的形式。

与此同时,OpenAI联创John Schulman也在负责监管超级对齐研究。

作为职务的扩展,他被授予了一个新头衔——对齐科学负责人(Head of Alignment Science)。

OpenAI宫斗内幕曝光

与此同时,针对奥特曼的舆论还在持续发酵。

前董事会成员Helen Toner在最近的播客频道TED AI Show上揭露了一些2023年底OpenAI「宫斗风波」的情况。

她解释了董事会决定罢免奥特曼的原因——隐瞒信息,歪曲事实,公然向董事会撒谎。

比如2022年底ChatGPT发布时,董事会完全没有得到消息,而是在推特上才第一次看到。

此外,他一直宣称自己在公司中没有任何经济利益,从没有告知董事会他拥有OpenAI启动基金。

奥特曼在AI安全方面的表现也让Toner不安,因为他只会向董事会透露「关于公司正在实施安全流程的少量、不准确的信息」。

这意味着,董事会没有办法获知这些流程的真实情况,更无从实行有效的监督和指导。

而且,当她的论文中包含了对奥特曼的负面评价时,他开始不择手段,试图将Toner赶出董事会。

结合此前推特网友历数的「七宗罪」,奥特曼带领下的安全团队,真的能让下一代模型安全可靠吗?