出品 | 51CTO技术栈(微信号:blog51cto)

在巴黎举行的初创企业年度技术大会VivaTech上,Meta AI的首席执行官Yann LeCun建议希望在AI生态系统中工作的学生不要从事LLM(大型语言模型)方面的工作。

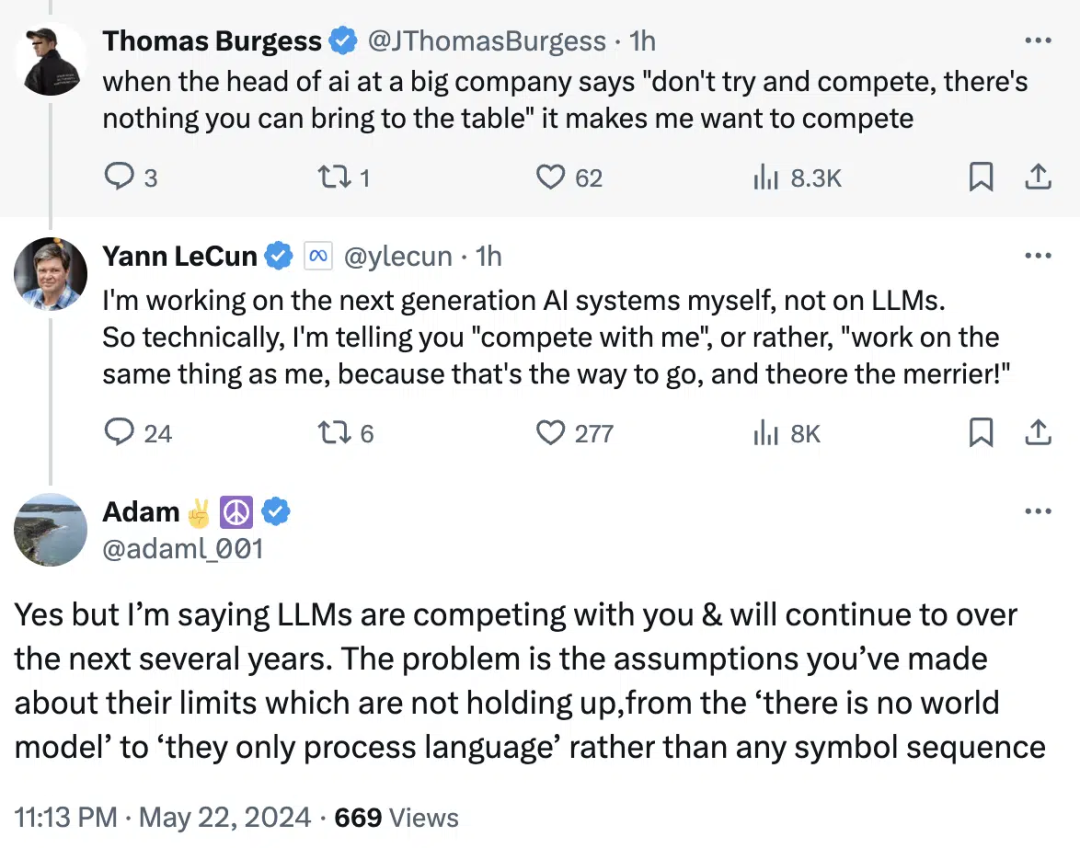

“如果你是对构建下一代AI系统感兴趣的学生,请不要从事LLM方面的工作。这是大公司的事情,你们无法对此有所贡献,”LeCun在会议上表示。

他还说,人们应该开发能够克服大型语言模型局限性的下一代AI系统。

1.远离LLM

有趣的是,关于LLM(大型语言模型)替代品的讨论已经持续了一段时间。最近,Devika的年轻创始人Mufeed VH(Devika是Devin的替代品)谈到了人们应该如何远离Transformer模型并开始构建新的架构。

“每个人都在做同样的事情,但如果我们专注于不同的架构,比如RMKV(一种RNN架构),那将是非常好的,”Mufeed说,他接着解释了这种特定架构的无限上下文窗口和推理能力。

他还认为,通过这种方法,甚至有可能构建出与GPT-4一样令人印象深刻的东西。

图片

图片

2.但是,LLM 仍在不断进步

尽管LeCun反对一股脑全部研究LLM,但Transformer训练模型仍在不断发展。AI/ML顾问Dan Hou谈到了GPT-4o,并强调了其训练模型。

当文本被认为是所有复杂模型的基础时,GPT-4o被设计用来原生地理解视频和音频。这影响了未来版本可以训练的数据量。

“AI能变得多聪明?有了原生的多模态架构,我猜测答案是非常、非常好,”Hou说。

此外,Sam Altman在最近的一次采访中也谈到了数据将不再是问题,从而解决了训练LLM的担忧。可以试想,如果数据问题能够得以解决,LLM的尺度定律将继续存在。