今年 2 月,谷歌上线了多模态大模型 Gemini1.5,通过工程和基础设施优化、MoE 架构等策略大幅提升了性能和速度。拥有更长的上下文,更强推理能力,可以更好地处理跨模态内容。

本周五,Google DeepMind 正式发布了 Gemini 1.5 的技术报告,内容覆盖 Flash 版等最近升级,该文档长达 153 页。

技术报告链接:https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

在本报告中,谷歌介绍了 Gemini 1.5 系列模型,它是代表了下一代高计算效率的多模态大模型,能够从数百万 token 上下文中调用细粒度信息并进行推理,包括多个长文档、数小时的视频。

该系列包括两个新型号:

- 更新的 Gemini 1.5 Pro,其大部分功能和基准都超过了 2 月份的版本

- Gemini 1.5 Flash,一种更轻量级的变体,专为提高效率而设计,并且在性能方面的减益很小。

有关本周谷歌 I/O 大会上提到的 Flash 版,报告中表示,Gemini 1.5 Flash 是一个 Transformer 解码器模型,具有与 Gemini 1.5 Pro 相同的 2M+ 上下文和多模态功能,旨在高效利用张量处理单元 (TPU),并具有较低的模型服务延迟。例如,Gemini 1.5 Flash 可以并行计算注意力和前馈分量,并且也是拥有更大网络在线提取能力的 Gemini 1.5 Pro 模型。它使用高阶预处理方法进行训练以提高质量。

报告评估了从 Gemini 1.5 和 Vertex AI 流 API 中获取的英语、中文、日语和法语查询的每个输出字符的平均时间。

英语、中文、日语和法语响应的每个输出字符的时间(毫秒),在输入 1 万个字符的情况下,Gemini 1.5 Flash 在所有测试的语言中实现了最快生成速度。

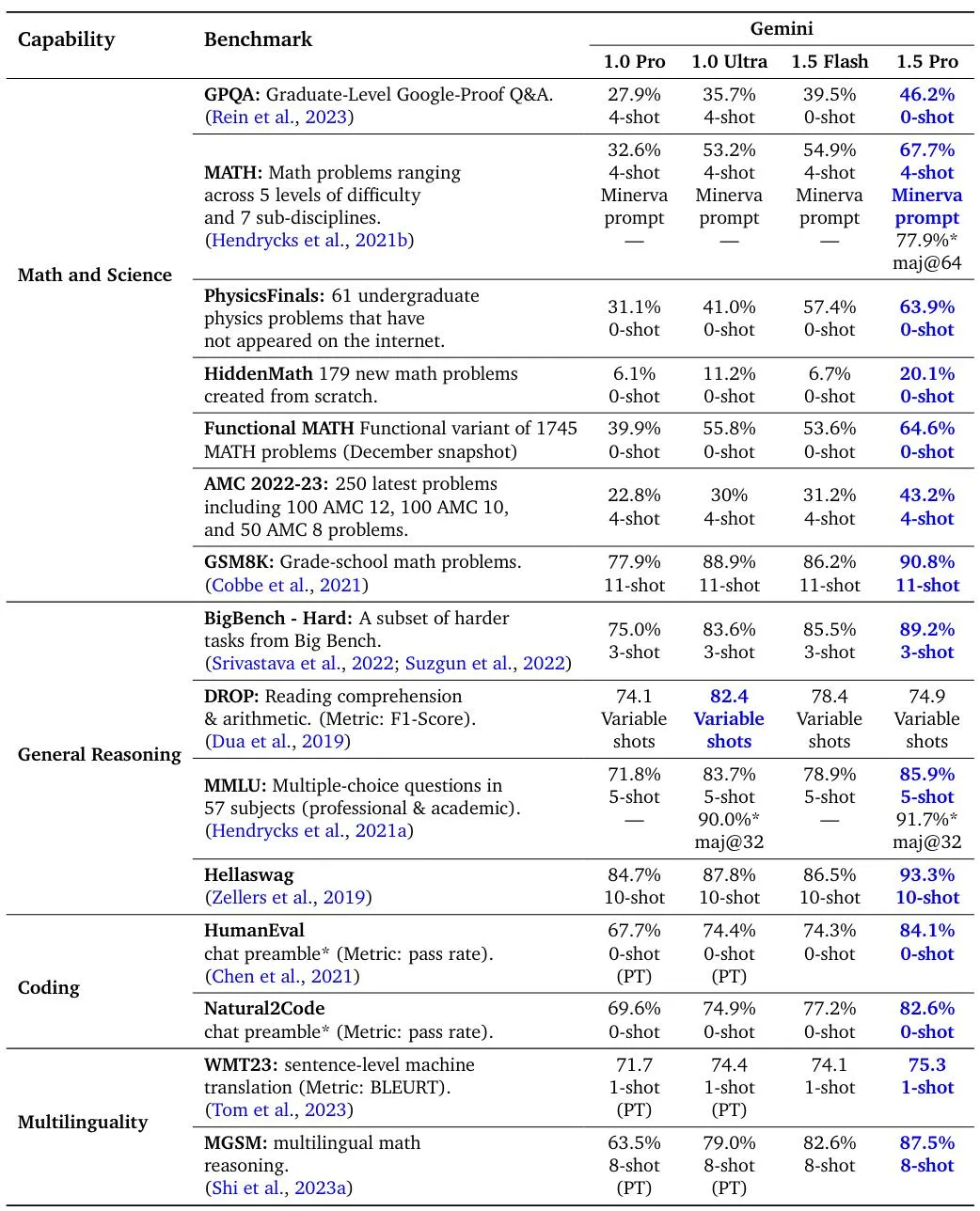

Gemini 1.5 Pro、1.5 Flash 和 Gemini 1.0 模型在标准编码、多语言以及数学、科学和推理基准上的评估结果。1.5 Pro 和 1.5 Flash 的所有数字都是在指令调整后获得的。

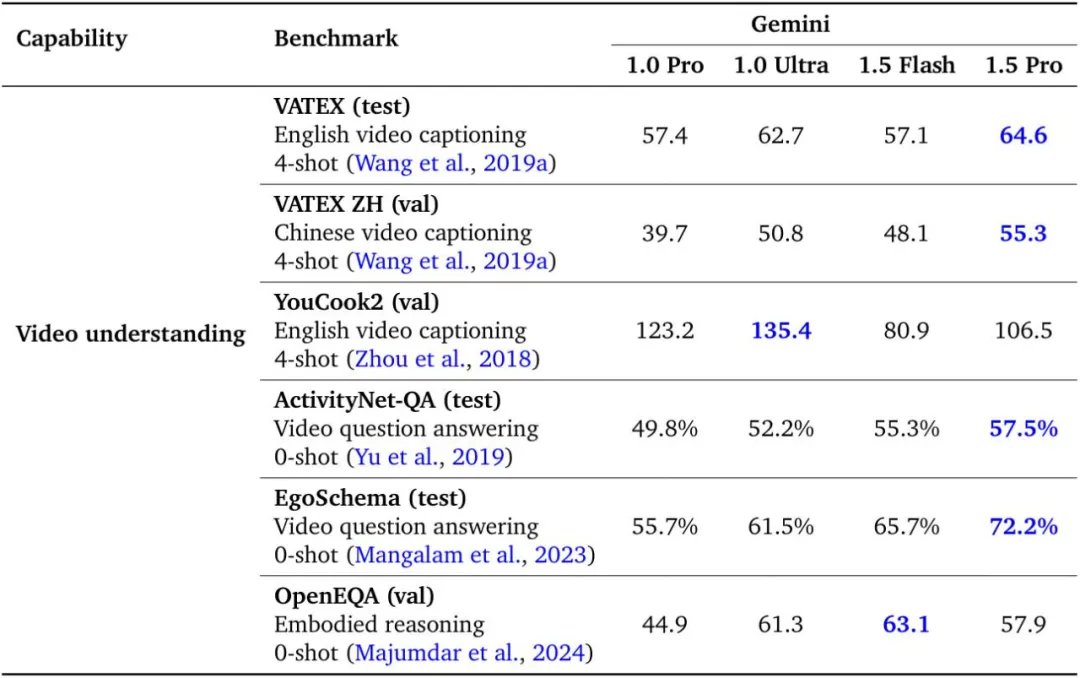

Gemini 1.5 Pro 与 Gemini 1.0 Pro 和 Ultra 在视频理解基准上的比较。

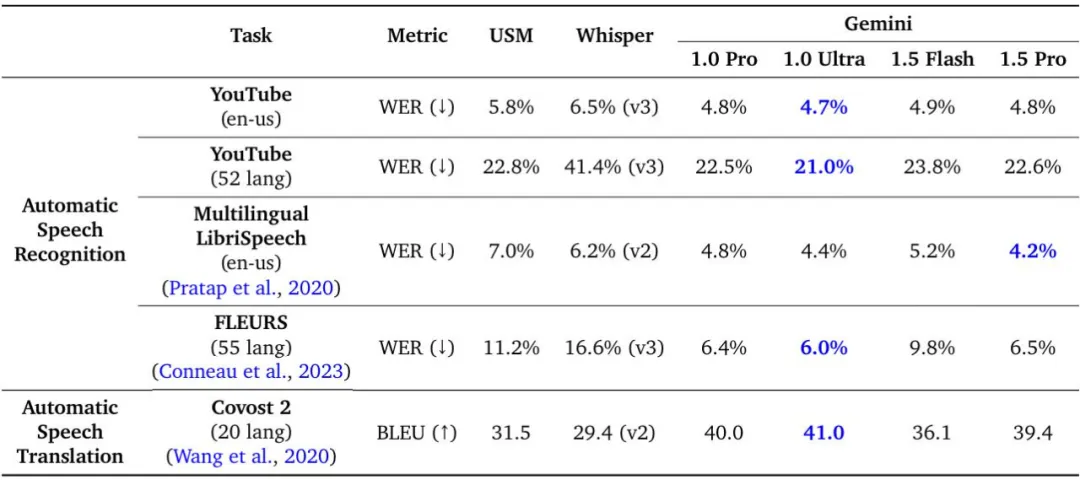

Gemini 1.5 Pro 与 USM、Whisper、Gemini 1.0 Pro 和 Gemini 1.0 Ultra 在音频理解任务上的比较。

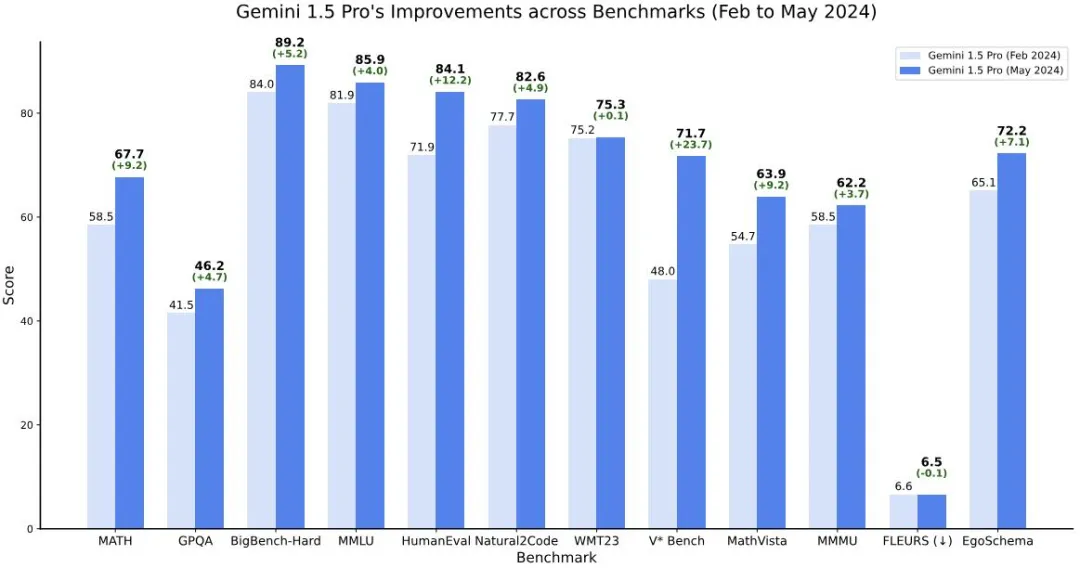

Gemini 1.5 模型在跨模态的长上下文检索任务上实现了近乎完美的召回,提高了长文档 QA、长视频 QA 和长上下文 ASR 的最优水平,并匹配或超越 Gemini 1.0 Ultra 在一系列广泛的基准测试中表现出最先进的性能。此外,谷歌也表示,到今年 5 月,Gemini 1.5 的性能相比 2 月份已有明显提升。

Gemini 1.5 Pro(5 月)与初始版本(2 月)在多个基准测试中的比较。最新的 Gemini 1.5 Pro 在所有推理、编码、视觉和视频基准测试中进行了改进,而音频和翻译性能保持不变。注意,对于 FLEURS,分数越低越好。

Google DeepMind 副总裁,Gemini 项目联合负责人 Oriol Vinyals 总结道,Gemini 1.5 Pro > 1.0 Ultra、1.5 Flash(目前最快型号) ~= 1.0 Ultra。

通过研究 Gemini 1.5 的长上下文能力的极限,我们可以看到在下一个 token 预测和近乎完美的检索(>99%)方面持续改进。相比 Claude 3.0 (200k) 和 GPT-4 Turbo (128k) 等现有模型实现了一代的飞跃。

在报告的第七章节,谷歌介绍了 Gemini 1.5 Pro 数学增强版本的跑分,它在竞赛级数学问题上表现出色,包括在未使用工具的情况下在 Hendryck 的 MATH 基准测试中取得了 91.1% 的突破级性能。

以下是该模型解决亚太数学奥林匹克(APMO)题目的一些示例,这些问题是此前模型显然无法解决的。Oriol Vinyals 表示,这个回答相当棒,因为它是一个证明(而不是计算),解决方案切中要害,而且「很漂亮」。

最后,谷歌重点介绍了大模型在现实世界的用例,例如 Gemini 1.5 与专业人士合作完成任务并实现目标,在 10 个不同的工作类别中可节省 26-75% 的时间。

这种前沿大语言模型也展示出了一些令人惊讶的新功能。当给定 Kalamang(一种巴布亚新几内亚西部不到 200 人使用的语言)的语法手册时,该模型可以学会将英语翻译成 Kalamang,与从相同内容中学习的人类处于相似的水平。