根据麦肯锡的报告显示,到2030年,大模型推动的全球经济增量将达到49万亿人民币,其中中国部分的经济增量将达到14万亿人民币。这里面既包括大模型对现有工作效率的提升,也包括新技术所带来的新场景和新业态。

虽然我们看到更多的企业和开发者在积极拥抱大模型,甚至有些企业已经将大模型应用于真实的生成环境中。然而,大模型的落地却并不是件容易的事情。

火山引擎总裁谭待指出,企业真正做好大模型有三大关键挑战,首先是模型效果,有好的基础大模型才能解决复杂的问题;其次是推理成本,只有非常低的成本服务,才能让大模广泛应用;第三是落地难度,企业需要更多的工具、插件、平台和应用,才能更加容易地将大模型在更多场景落地。

火山引擎总裁谭待

火山引擎总裁谭待

在5月15日举办的火山引擎原动力大会上,字节跳动正式发布豆包大模型(原云雀大模型)家族,并且通过火山引擎对外提供服务。同时,火山引擎推出火山方舟平台2.0,以及伴随着大模型发布推出的AI应用和AI基础设施的新产品,帮助企业做好AI转型。

豆包大模型家族亮相,9款模型满足用户不同场景需求

谭待指出,模型效果是AI落地最关键的一环。因为大模型只有在真实场景中落地,用的人越多,调用量越大,才能让模型越来越好。

去年,字节跳动就完成了自主研发大模型豆包(原名云雀),字节跳动内部50多个业务已经大量使用豆包大模型进行AI 创新,包括抖音、头条等数亿DAU产品。截至目前,豆包大模型日均处理1200亿tokens文本、生成3000万张图片。

为了帮助企业做好大模型场景落地,字节跳动推出豆包大模型家族,满足企业不同场景的关键需求。

豆包通用模型pro:字节跳动自研LLM模型专业版,支持128k长文本,全系列可精调,具备更强的理解、生成、逻辑等综合能力,适配问答、总结、创作、分类等丰富场景;

豆包通用模型lite:字节跳动自研LLM模型轻量版,对比专业版提供更低token成本、更低延迟,为企业提供灵活经济的模型选择;

豆包·角色扮演模型:个性化的角色创作能力,更强的上下文感知和剧情推动能力,满足灵活的角色扮演需求;

豆包·语音合成模型:提供自然生动的语音合成能力,善于表达多种情绪,演绎多种场景;

豆包·声音复刻模型:5秒即可实现声音1:1克隆,对音色相似度和自然度进行高度还原,支持声音的跨语种迁移;

豆包·语音识别模型:更高的准确率及灵敏度,更低的语音识别延迟,支持多语种的正确识别;

豆包·文生图模型:更精准的文字理解能力,图文匹配更准确,画面效果更优美,擅长对中国文化元素的创作;

豆包·Function call模型:提供更加准确的功能识别和参数抽取能力,适合复杂工具调用的场景;

豆包·向量化模型:聚焦向量检索的使用场景,为LLM知识库提供核心理解能力,支持多语言。

值得注意的是,此次字节跳动发布的9款大模型,除了通用模型Pro和lite,其他模型更加注重企业场景化需求,帮助企业快速落地大模型。

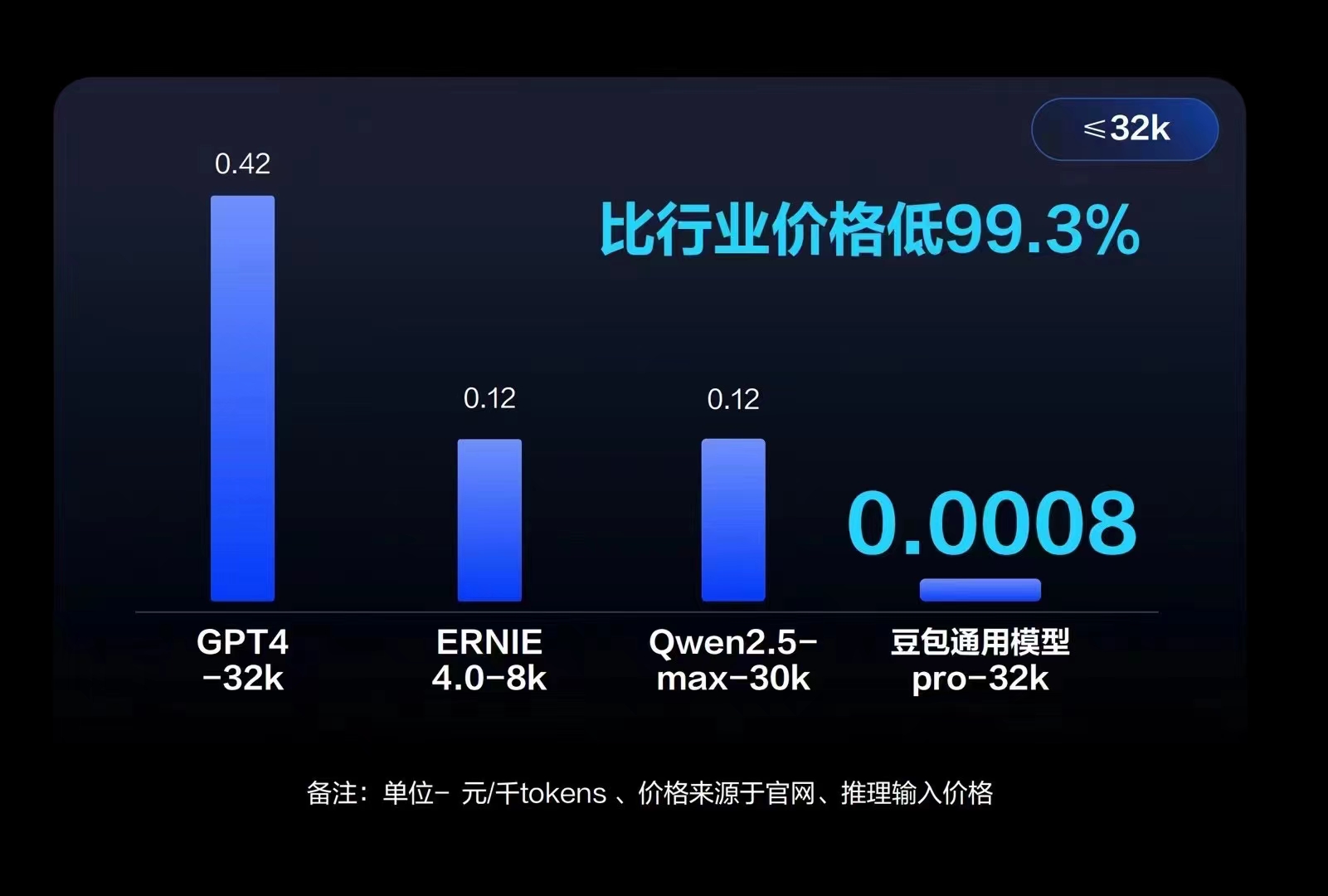

推动AI普惠,大模型价格步入“厘时代”

落地大模型,不只是要模型效果好,而且要足够的便宜,让每个人、每家企业都用得起大模型。为此,豆包大模型也发布了其推理价格。

以豆包通用模型pro-32k 版为例,模型推理输入价格仅为0.0008元/千 tokens,0.8厘就能处理1500多个汉字,比行业便宜99.3%。市面上同规格模型的定价一般为0.12元/千 tokens,是豆包模型价格的150倍。

如此低廉的价格背后,原因有两点。谭待解释道,“在技术方面,我们采用非常多的优化手段,例如通过模型结构优化调整降低成本价格;其次是工程方面采用分布式推理,更好地利用底层算力,降低成本。”

谈到为何要将价格定到如此之低,谭待表示,“创新的事情风险很高,特别是AI风险会更高,当面临非常多的不确定性时,我们必须将试错成本降到非常低,大家才能广泛用起来。大模型从以分计价到以厘计价,将助力企业以更低成本加速业务创新。”

为何是豆包?

据了解,字节跳动基于豆包大模型打造了AI对话助手“豆包”、AI应用开发平台“扣子”、互动娱乐应用“猫箱”,以及星绘、即梦等AI创作工具,并把大模型接入抖音、番茄小说、飞书、巨量引擎等50余个业务,用以提升效率和优化产品体验。

字节跳动产品和战略副总裁朱骏分享了字节跳动对于豆包产品的思考。

字节跳动产品和战略副总裁朱骏

字节跳动产品和战略副总裁朱骏

豆包,看似和大模型没有任何关系,为何字节跳动的大模型会叫豆包呢?朱骏分享了豆包名字背后的故事。在给产品起名时,就定下来起名的通用原则是简单、好读、好记。同时,也定义了三个产品设计原则。

第一个设计原则是“拟人化”。朱骏表示,“拟人化”是大模型产品的新特性,AI 除了带来了新的能力,也带来了新的交互方式,用和人类对齐的交互体验,降低使用门槛,也让用户在使用产品时感觉到产品有类似人的温度。因此,内部团队在诸多候选中选中了豆包。

其实,用户也给豆包赋予了全新的含义,其中有两个解释,一是抖音的官方bot,“抖bot”谐音就是豆包;另一个是豆包就是“都包了”,工作生活学习的需求都包了,寓意是通用助手的产品愿景。而用户的创意解释后来也成为了朱骏认可的解释。

第二条设计原则是需要离用户很近,需要随时伴随用户,嵌入用户的不同使用环境。这也就意味着,豆包应该到用户身边,而不是用户到豆包身边。为此,用户可以在户外随时随地问豆包,更方便地在移动场景互动;还可以在电脑桌面端,利用豆包更高效地工作;同时,还可以通过豆包插件在阅读PDF或编写代码时,就近解决问题。

第三条设计原则是个性化。虽然通用大模型能解决非常广泛的任务,但实际上,每个用户都有自己个性化的需求,包括对智能体的功能定位,回答风格、声音、形象、记忆都有非常个性化的需求。

在智能体世界里,字节跳动认为,未来用户大概率会有一个主要的智能体(比如豆包)做最高频的互动,解决很多任务;但是也会因为个性化、多样化的需要,和很多其他的智能体互动。

对于那些更复杂的,需要更高阶能力,甚至更异构的交互方式的智能体,字节跳动也提供了智能体定义平台“扣子”。除了自然语言定义外,也支持通过工作流、代码、插件,赋予这个智能体更强、更稳定的能力。

朱骏表示,一方面大模型技术本身在不断进步,另一方面行业里对于应用形态和交互方式的摸索会逐渐成熟,这样大模型产品会逐渐融入更多用户的生活和工作里。

如今,豆包的用户规模在快速增长,已经有超过2600万的月活用户,和800多万个被大家创建出来的智能体。

火山引擎基础设施升级,多款AI应用发布

为了更好地帮助企业落地大模型,火山引擎还升级其基础设施产品,并发布了多款AI应用,提供全栈AI服务。

一站式大模型服务平台火山方舟进行了全面升级。在插件和工具链上,火山方舟2.0 升级了联网插件,提供头条抖音同款搜索能力,大幅提升模型的信息获取能力;升级内容插件,提供头条抖音同源海量内容,支持多模态交互,帮助大模型深入理解、检索和生成内容;升级知识库插件,提供毫秒级百亿规模的高性能检索,秒级流式知识库索引更新,内嵌豆包向量化模型,提高搜索的相关性和准确性。此外,火山方舟2.0也全面升级了系统承载能力、安全防护能力和算法服务能力,帮助企业推进大模型的价值创造。

除了好的模型效果、便捷的插件、强劲的系统性能,还需要提供简单易用的开发平台,才能让所有人都能成为AI应用的开发者。火山引擎正式发布了扣子专业版。扣子专业版在扣子可视化灵活编排智能体的能力基础上,进一步提供企业级SLA和多种高级特性,使AI应用更易落地,让企业更专注于通过智能体创新,驱动业务增长。

为了让企业数据消费更普惠、更便捷,火山引擎智能数据洞察DataWind正式发布AI助手ChatBI,用户可通过自然语言交互生成指标,用于图表制作、数据查询,还可进行深度数据分析,且ChatBI支持IM交互,可多端应用,随时随地自助分析,这将大幅降低数据消费门槛,提升读数、用数效率,为数据飞轮加速运转提供动力。

面向营销场景,火山引擎进行了智能创作云2.0的升级,成为从内容创作、矩阵分发、广告投放到数据洞察一站式的企业内容营销增长方案;不仅提供多模态的理解与生成能力,助力视频创作效率提升25倍,更上线抖音话题、POI、小程序等营销工具,使门店页面曝光提升600%。目前已经有3000+企业在火山引擎开启AIGC视频营销增长。

面向销售场景,火山引擎发布了销售AI助手Sales Copilot,能够高效跟进客户需求,随时辅助销售解答复杂的产品问题。此外,它还能通过角色扮演的方式模拟不同风格的对客演练,并提供优秀话术学习,提升销售沟通质量。

结语

正如谭待所言,好的大模型不只是榜单第一、参数量最大,或者是在PPT中超越GPT4,而更多的应该是大的使用量才能打磨出好模型。

如今,豆包大模型和火山方舟2.0已经在金融、汽车、智能终端、电商零售、教育科研等多个行业实践落地。招商银行、海底捞火锅、超级猩猩、携程旅游、飞常准、猎聘等企业也已经在扣子上搭建了智能体。复旦大学、浙江大学等名校也为课程和实验搭建了 “AI 助教”。

相信,在大模型“厘时代”,好的大模型将会加速更多企业真正落地,借助大模型来实现业务创新。