Hello folks,我是 Luga,今天我们来聊一下人工智能(AI)生态领域相关的技术 - LLM 构建块:向量、令牌和嵌入 。

随着技术的不断进步,LLM 带来了前所未有的机遇,吸引了开发者和组织纷纷尝试利用其强大的能力构建应用程序。然而,当预训练的 LLM 在实际应用中无法达到预期的性能水平时,人们将不由自主地开始思考:我们到底应该使用哪种技术来改善这些模型在特定场景下的表现?

Fine-Tuning(微调)和 RAG(检索增强生成),作为两种常见的 LLM 性能优化方法,在很多人眼中可能还带有一丝神秘感。在深入探讨两者的利弊之前,我们有必要先了解这两种方法的基本原理和特点。

一、高效赋能 LM 的利器—Fine-Tuning

什么是 Fine-Tuning (微调)?

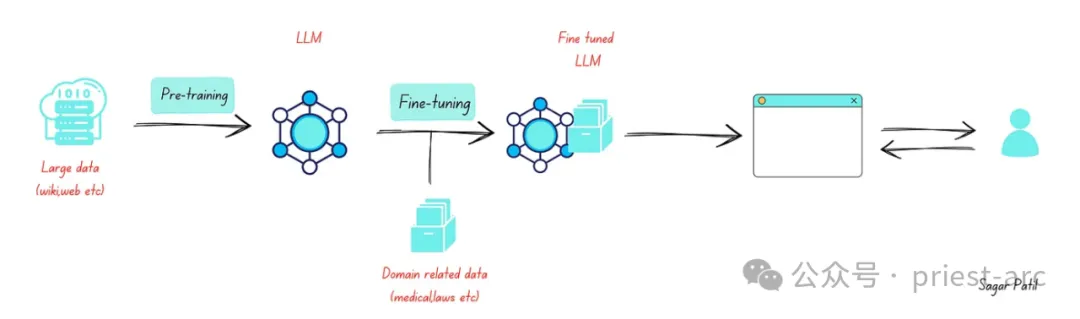

在当今的自然语言处理领域,预训练语言模型(PLM)凭借其在大规模语料上学习到的通用语义知识,俨然已成为各类下游任务的强力基石。但要充分发挥 PLM 在特定场景中的专业能力,就需要有一种高效的"定制化"方法,那便是 Fine-Tuning(微调)。

Fine-Tuning (微调)过程的核心,是在新的任务和数据集上对预训练模型的参数进行微小的调整,使其能精准契合目标场景的需求。不同于完全从头训练一个全新模型,Fine-Tuning (微调)巧妙地利用了 PLM 在大规模语料上学习到的通用语义表征,在此基础上进行"权重调校",从而大幅提高了模型收敛的速度和效率。

以情感分析任务为例,假设我们需要对电影评论进行正负面情绪判断。此时,与从零开始构建一个全新模型不同,我们可以选择像 GPT-3 这样在海量文本上预训练过的 PLM,并使用标注好的电影评论数据集对其进行微调。通过这一调整权重的过程,原本通用的语义模型就被"赋能"了情感分析的专业技能,可以高精度地捕捉评论中的情感倾向。

Fine-Tuning (微调)参考架构示意图

二、开辟 LLM 智能认知的新领域—RAG

LLM (大型语言模型)正以其惊人的学习能力和泛化性能,开辟着认知智能的全新境界,而 RAG(检索增强生成)便是为其插上智能利用外部知识的强力翅膀。

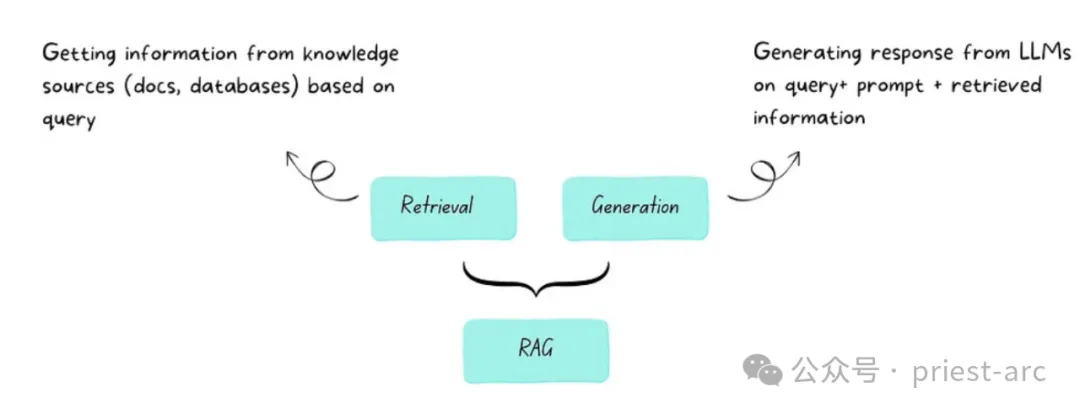

那么,什么是 Retrieval-Augmented Generation(检索增强生成)?

RAG(检索增强生成)是一种优化大型语言模型输出的技术,在生成响应之前,让模型除了查询训练数据源外,还能同时查阅可靠的知识库。 LLM (大型语言模型)在训练过程中使用了数十亿参数和大量数据,能够对问答、语言翻译、句子补全等任务生成独特的输出。RAG 无需重新训练模型,便能扩展 LLM 已有的强大能力,让其能够适用于新的领域或组织的内部知识库。这是一种经济高效的方式,能够提升 LLM 输出的准确性、相关性和实用性,使其在各种环境中依然保持出色表现。

RAG(检索增强生成)参考架构示意图

在 RAG 的智能架构下,语言模型不再是相对封闭的"语义孤岛"。它们将与庞大的异构知识库无缝集成,在生成响应之前,先通过智能检索系统获取与任务相关的外部知识作为补充。由此,语言模型的认知能力得以突破自身训练语料的局限,注入更为广博、专业的知识维度。无论是回答一个特定领域的问题,还是完成专业化的文本生成任务,LLM 均能依托 RAG 的知识补给,提供更加准确、流畅、内容充实的输出,大大增强了其在特殊场景下的适用性。

除了认知能力的开放突破,RAG 还为 LLM 的训练和应用效率带来了全新的优化。采用传统方式,我们需要用特定领域的大量数据反复训练 LLM,从而使其"学会"相关知识。这种重新训练的过程不仅代价昂贵、效率低下,同时,知识的覆盖面和时效性也极为有限。而 RAG 则通过灵活、高效的知识检索和融合,快速赋能了 LLM 在新领域的应用能力,无需进行大规模的重复训练。我们只需构建合适的知识库,RAG 就能自动获取与任务相关的最新信息,为 LLM 提供有力补充。

三、评估 Fine-Tuning & RAG 5 要素解析

在评估和应用 Fine-Tuning (微调)与 RAG(检索增强生成)等语言 AI 技术时,我们需要全面审视和深入权衡诸多关键因素,方能最大限度发挥它们的能力,并将其贯彻落实到实际场景中。

1. 动态数据挑战 vs 静态数据局限

面对瞬息万变的动态数据环境,RAG 凭借其独特的检索增强生成架构,展现出了卓越的适应能力和实时更新优势。通过持续从外部知识源中查询并融合最新信息,RAG 能够确保模型的输出始终保持高度时效性,完全无需频繁的重新训练过程。

相比之下,传统的 Fine-Tuning (微调)方法则面临着更多的困难和局限性。由于微调后的模型实际上只是训练数据的静态快照,在高速变化的数据场景中,很快就会被动态信息所超越而过时失效。更为棘手的是,微调无法保证模型对知识的持久记忆和回忆能力,从而使其在特定任务上的表现难以可靠把控。

综上所述,RAG 作为一种全新的语言模型架构,凭借其对动态外部信息的高度敏感性和融合能力,使其成为应对多变数据环境的不二之选。无论是确保输出时效性,还是保证知识覆盖的广度和深度,RAG 都展现出了其独特的优越性。

2. 外部知识融合

在智能语言时代,知识获取的广度和深度决定了模型的天花板。面对海量异构知识库,RAG 以其超越者的气概,为语言模型赋能于外部知识融合的非凡能力。

作为一种革命性的语言模型架构,RAG 被诞生于充分利用外部知识源的终极需求。它通过智能检索机制,高效地从各类结构化、非结构化的知识库中获取与任务相关的信息,并将其与内部语义表征相融合,生成增强后的最终响应。无论是查询数据库、文档,还是其他异构数据存储库,RAG 均能轻松驾驭,展现出卓越的外部知识利用能力。

反观传统的 Fine-Tuning (微调)方式,其知识获取能力受到了诸多束缚。虽然通过微调,可以使大型语言模型"学习"特定领域的知识,但这种学习过程无法适应频繁变化的外部数据源,并且每一次模型重新训练,都需要付出极高的计算代价,效率显著低下。更为关键的是,微调模型的知识种类和来源也受到了较大限制,难以全面获取和利用互联网上的异构海量知识。

综上所述,对于高度依赖外部知识源、且知识存储形式多变的应用场景而言,RAG 无疑是当前最具前景的解决方案。它为语言模型赋予了无与伦比的知识检索与融合能力,轻松突破了传统 Fine-Tuning (微调)方式的种种局限,让模型的输出质量和知识覆盖面得到了极大的提升。

3. 幻觉减少

通常而言,RAG 系统的设计本质上可以降低其产生幻觉的可能性。这是因为 RAG 系统不是单纯地根据生成模型的输出生成响应,而是将每个响应都基于实际检索到的证据进行构建。

具体来说,RAG 系统由两个主要组件组成:一个检索模块和一个生成模块。检索模块负责从大规模的知识库中找到与输入相关的信息片段。而生成模块则根据这些检索到的证据来生成最终的响应。

这种基于检索的方式限制了模型单凭自身的生成能力来构造响应的可能性。相比于仅依赖生成模型的纯粹生成式系统,RAG 需要严格遵循检索到的事实性信息,从而降低了模型制造虚假或幻觉性响应的风险。

Fine-Tuning (微调)技术确实可以通过使用特定领域的训练数据来帮助降低模型产生幻觉的可能性。因为微调过程可以使模型的参数更好地适应某个特定的应用场景或领域,从而减少模型在这些熟悉领域外产生虚假或无根据的响应。

然而,即使经过微调,模型在面对不熟悉的输入或领域时,仍然可能会尝试编造一些看似合理但实际上是虚假的反应。这是因为即使经过微调,模型的基本生成机制和推理能力并没有根本性的改变。在缺乏足够的相关训练数据和背景知识的情况下,模型仍可能倾向于根据自身的推测或猜测来生成响应,而非严格基于事实。

因此,微调虽然可以在一定程度上缓解模型产生幻觉的倾向,但并不能完全消除这一风险。在使用微调后的模型时,仍需要格外谨慎,并结合其他技术手段,如增强模型的可解释性,来进一步降低模型制造虚假信息的可能性。只有通过多管齐下,我们才能更好地确保模型在各种情况下都能给出可靠、事实性的响应。

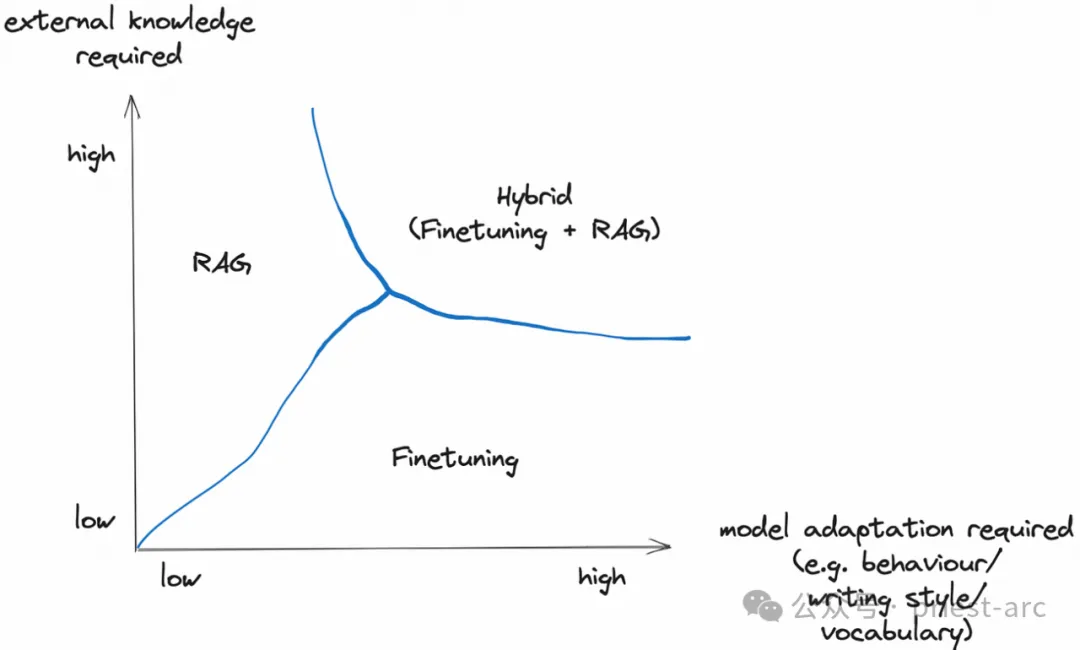

4. 模型定制化需求

基于架构设计角度而言,RAG 主要专注于信息检索,其设计可能无法根据检索到的内容自动调整模型的语言风格或领域特定性。虽然 RAG 擅长将外部知识整合到生成过程中,但可能缺乏完全定制模型行为和写作风格的能力。也就是说,RAG 系统更侧重于利用丰富的背景知识来提升生成质量,而不是对模型本身进行深度定制。

相比之下, Fine-Tuning (微调)技术为调整大型语言模型的行为、写作风格和领域专有知识提供了更直接的路径。通过微调,我们可以使模型的行为、语气和术语更贴合特定的应用需求和细节。这种针对性的定制能够实现模型与特定风格或专业领域的深度融合。

因此,如果我们的应用程序需要专门的写作风格或深度契合特定领域的词汇和惯例,那么 Fine-Tuning (微调)技术无疑提供了更直接和有效的定制途径。相比之下,虽然 RAG 系统擅长利用外部知识,但在定制模型的语言特性和行为方面可能存在一定局限性。

当然,RAG 和 Fine-Tuning (微调)并非完全互斥,在某些情况下可以结合使用以发挥各自的优势。关键在于根据具体的应用需求,选择最合适的定制技术来提升模型的性能和行为特性。无论采用哪种方法,合理的模型定制都是提升应用效果的关键所在。

5. 模型成本效益

在实际的业务场景中,RAG 系统本身并不支持使用更小型的模型。它需要依赖较大的基础模型来执行信息检索和生成任务,无法通过缩小模型规模来获得成本优势。

相比之下, Fine-Tuning (微调)技术可以在很大程度上提高小型模型的效率和性能。这意味着在部署和维护时,小型模型所需的硬件基础设施更少,从而能够带来云计算开支或硬件采购方面的成本节省。

当成本考量成为首要因素时,训练和部署小型模型能够带来显著的成本优势,特别是在大规模应用场景下。这是 Fine-Tuning (微调)技术的一大优势。

与 RAG 系统需要依赖较大模型的限制相比, Fine-Tuning (微调)可以充分利用小型模型的优势。通过精心的微调过程,小型模型可以在特定任务上展现出媲美甚至超越大型模型的性能。同时,小型模型的部署和维护成本也大幅降低。

因此,对于追求成本效益的应用场景而言, Fine-Tuning (微调)技术能够充分发挥小型模型的优势,为项目带来显著的经济收益。这是 RAG 系统所无法提供的。简而言之,在成本优先的情况下, Fine-Tuning (微调)方法显然具有更强的优势。

四、关于 Fine-Tuning vs RAG 一点见解

在语言人工智能的探索进程中,技术创新往往是一场场思想的碰撞与融合。而微调和检索增强生成(RAG)这两大范式,正是智能语言模型发展历程中的里程碑式进展。但我们不应将其等同于一场"这一家喻户晓或彼一家臭"的技术范式之争,因为在更高的智能进化视角下,两者实则是有机统一、相辅相成的共生体。

1.Fine-Tuning 微调:赋能语言模型任务专注的秘钥

微调技术的核心功能,是通过对预训练语言模型权重的精细调校,将其通用的语义认知能力定制化为某一特定任务或领域的专注技能。这种"通过少量数据开启定制化"的高效方式,让语言模型得以脱胎于通用知识的卵壳,孵化出应对特殊场景的专业能力。

2.RAG:外延语言模型认知边界的知识加持

而检索增强生成则是另一种智能范式,赋予了语言模型高效获取和利用外部异构知识的能力。通过智能检索系统,语言模型可在生成响应前,从海量专业知识库中获取与之相关的补充信息,从而突破了其受限于训练数据集的知识边界,使输出更加准确、专业、内容丰富。

Reference :

- [1] https://ai.plainenglish.io/fine-tuning-vs-rag-in-generative-ai-64d592eca407

- [2] https://www.goml.io/rag-vs-finetuning-which-is-the-best-tool-for-llm-application/