经典计算,一定是最好的方式吗?

这家名叫Extropic的公司,选择利用物质随机波动驱动计算。

他们认为,这种计算比经典计算机更快,更接近自然和我们大脑的计算方式。

因此,它扩展了硬件的性能界限,超越了传统数字计算的约束。

比起当前的CPU、GPU、TPU、FPGA等数字处理器,这种全新的AI加速器快了数个数量级,而且更加节能。

因为,这种新方法使得在数字处理器上不可行的强大概率AI算法,成为可能。

创始人40分钟视频上线,网友吐槽没讲清楚

最近,公司创始人Gill Verdon的一段长达40分钟的采访视频上线了。

视频地址:https://www.youtube.com/watch?v=QjVOfM2EBnE

整个访谈的画面,就是联合创始人Guillaume Verdon和主持人Jason Carman的一问一答。

在留言区,反响十分热烈。

一些网友表示内容非常优质,简直好到爆。

「多么吸引人的纪录片啊!为什么社交媒体上没人讨论,太奇怪了。」

但仔细听完这段访谈的一位网友,给出了这样的反馈:整整40分钟,都没有解释清楚芯片的工作原理和架构……

他猜测,原因可能是创始人没有想好是将技术保密,还是选择向公众公开。

或者,就是他觉得观众太笨无法理解,或者纯粹是表达能力太差。

看到网友的质疑,公司成员Beff Jezos赶紧发了条超长的QA,重新解释了一遍:

问:模拟神经网络并不是新事物,IBM/Intel等公司尝试过类脑计算,为什么它们都没成功?

答:确实,类脑计算已经被研究很长时间了。这些系统通常需要使用特殊的组件,如忆阻器(memristors)等,或者过度追求模仿生物特性,如脉冲神经网络(spiking neural networks)。

但是,这些系统往往无法直接与最终应用对接,也很难找到有效的训练方法。而Extropic就在解决这些问题,还会通过论文分享自己的研究成果。

问:关于模拟计算的一般情况是怎样的?

答:以往的模拟计算,主要集中在确定性算法上。

在这方面想取得突破非常难,因为确定性的微分方程可以通过固定的开销进行离散化,并在数字计算机上解决,这就极大限制了模拟计算的加速潜力。

随机动力学则与之不同。模拟随机系统的数字算法通常收敛性较弱,且每个时间步骤所需的计算量远超其确定性的对应算法。

因此,尽管存在一些困难,采用随机模拟方法是有其合理性的。

问:为什么现在才开始使用随机模拟技术?

答:直到最近,我们才具备了构建真正随机模拟计算机的技术条件。

即便在室温环境下,热波动也非常微小,只有非常微小的物理系统才会受到显著影响。而在电路设计上,这种微小化要求意味着需要具备几百阿托法拉(aF)的特征电容,这种电容只能通过较新的CMOS工艺来实现。

因此,以前从未有过真正的基于热动力学的电路计算机被造出来。也是因此,随机模拟技术从未得到充分的试验。

图源:https://www.youtube.com/watch?app=desktop&v=oSrUsM0hoPs

问:为什么选择超导技术?为什么选择CMOS技术?

答:仅包含线性元件(如电阻、电容和电感)的随机电路,只能从高斯分布中进行抽样,这在实际应用中显然是有限的,尤其是电感的体积通常较大,但是,数字计算机在这方面已经已经卓有成效了。

我们选择超导技术作为起点,是因为通过约瑟夫森结,就可以实现非线性哈密顿动力学的模拟,这不仅跟我们的研究起点相一致,也是因为随机哈密顿系统在理论上非常优雅。

然而,超导系统需要在几开尔文的低温下工作,这限制了它的实用性,而且大幅增加了工程复杂性。

因此,我们需要自然而然地探索,如何在大规模可制造的环境中构建非线性随机系统。显然,选择CMOS是自然而然的。

当前的挑战,就是清楚理解随机状态下晶体管的工作原理。对此,我们已经取得了重大进展,并且期待尽快构建出实用、可扩展的系统。

问:模拟技术中,处理相关噪声源特别困难,你们有什么应对策略吗?

答:确实,这是一个复杂的问题。我曾经参与Google Quantum的一个项目,团队需要对设备进行精密校准,以模拟并纠正复杂的相关噪声,这是实现首次量子霸权实验的关键。

Trevor曾在该团队工作数年,专注于噪声物理和硬件问题,他在MIT的博士研究也是围绕这个主题,并发表了多篇论文。

问:硬件的个体差异很大,每个芯片都有其独特性,你们怎么处理这种情况?

答:尽管硬件的个体差异带来了挑战,但你日常使用的设备,从汽车到智能手机,大多数都能正常工作。这并非偶然,而是因为背后有很多工程师,花费了大量时间,开发了复杂的特性化、校准和补偿技术,有效减少了这些差异对用户的影响。

在Extropic,我们也采用了类似的方法。几十年来,我们在随机CMOS芯片领域积累了丰富经验,加快了研发进程。此外,我们计划针对每个芯片的独特物理特性,进行个性化的训练和微调,包括它们的瑕疵。

我们不仅进行推理计算,还计划在芯片上直接进行训练。像训练大脑一样,这种带着缺陷进行的训练,能使芯片更好地适应这些个性化的差异。

问:设计、验证、测试非常复杂,当前的工具是否支持你们设备运行的模式(例如,海森堡极限)?

答:我们的CMOS设备并不是在量子模式下运行,而是在随机模式下。的确这个流程非常复杂,但我们内部有一些超低功耗晶体管的先进模型,是由我们的硬件物理专家团队开发的。

我们不仅有丰富的经验,还有顶尖的人才。在测试和表征噪声方面,这是许多团队成员在量子计算领域多年职业生涯中的专长。

图源:https://www.youtube.com/watch?app=desktop&v=6Qc4BvToD3Y

问:数字硅技术已经非常成熟,为什么还要与整个技术栈竞争?你们如何从实验室规模扩展到大规模制造?

答:我完全同意这一点。相较于超导技术,CMOS的供应链和工具更为成熟,这也是我们使用CMOS并尽可能利用现有工具和供应链的原因。我们的目标是,将Extropic芯片最终应用于大多数需要神经计算功能的设备中。

问:你们有进行任何模拟研究吗?计划提供模拟器吗?

答:是的,我们从一开始就在使用随机模拟进行设计。目前,我们正在准备详尽的科学论文,计划开源部分代码。

不过最主要的挑战是,由于需要模拟时间加速,这些模拟需要大量的计算资源,因此在普通的笔记本电脑或台式机上运行这些模拟并不现实。

问:超导技术和低温技术难以大规模应用,难以触及大众市场,你们有什么应对策略?

答:在此领域工作多年,我们深知超导技术难以规模化。对我们而言,这主要是一个测试平台,用于验证我们关于电子的参数随机物理学的理念,以及我们的编程模型。

这是我们能制造的最接近宏观的真实热力学芯片,它利用环境热量的自然噪声,但必须经过极度冷却,才能达到理想工作状态。而下一代芯片,就将采用CMOS技术,来大幅减少对低温技术的依赖,做到能在室温下正常工作。

问:为什么重视采样扩散过程?

答:如果你使用过扩散模型,就会注意到DALLE或Midjourney生成图像的速度有多慢。视频扩散的缓慢程度也差不多。这些实例都证明,神经扩散过程需要大幅提速。

通过直接利用模拟随机电子物理学,我们就能显著提高处理速度。具体的性能基准将在即将发布的白皮书中详细介绍,敬请关注!

开创热力学的未来

在3月份,公司也发表了博客,解释这个了这个「热力学计算机」的原理。

Extropic表示,自己正在开发的这个项目是一个全栈硬件平台,可以将物质自然的波动作为计算资源,从而为生成式AI提供支持:

- 突破传统数字计算的限制,将硬件的扩展能力推向新的高度。

- 使AI加速器的速度和能效远远超过传统的数字处理器(CPU/GPU/TPU/FPGA),提升可达好几个数量级。

- 可以完成那些在传统数字处理器上无法实现的强大概率性AI算法。

能量基模型(EBMs)这一概念在热力学物理和基础概率机器学习中均有出现。

在物理学中,它们被称为参数化热态,由具有可调参数的系统的稳态产生。在机器学习领域,则被称为指数族。

指数族是参数化概率分布的理想方式,它们能够用最少的数据量准确确定参数。

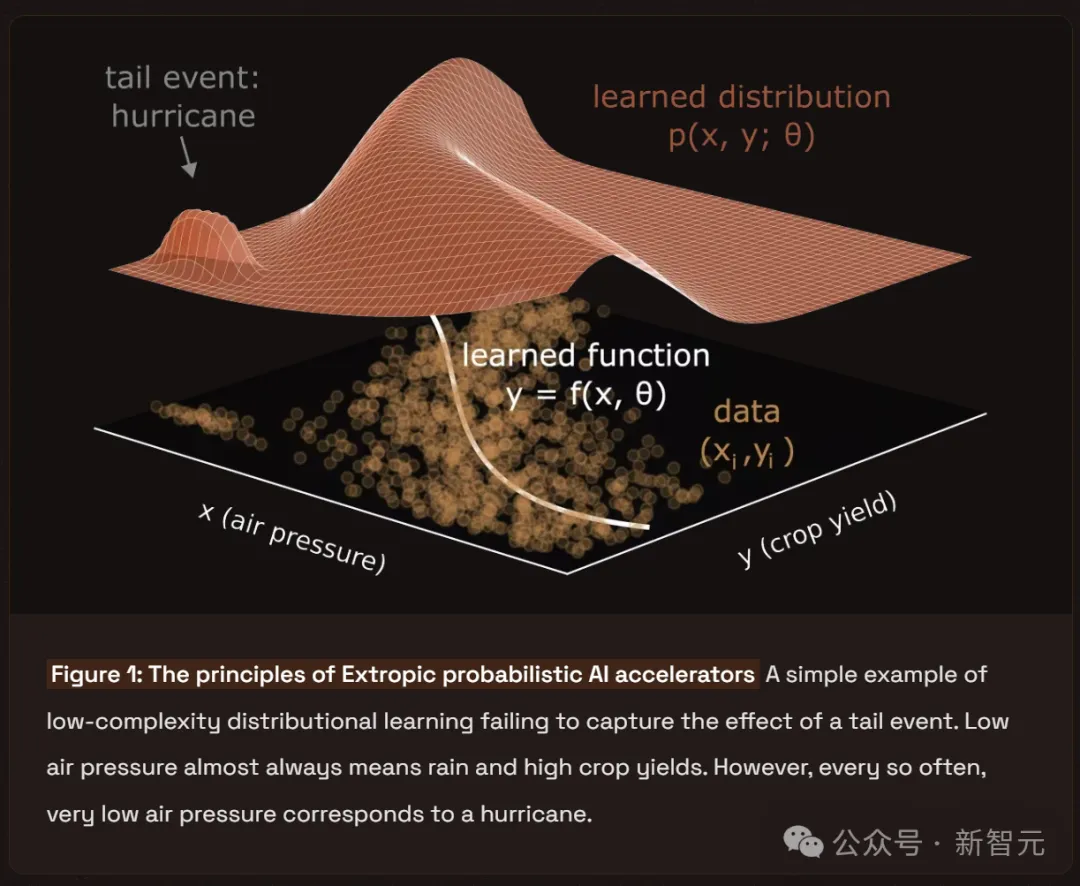

在数据较少的情况下,指数族尤为有效,适用于需要在关键任务应用中对尾部事件进行建模的场景,如图1所示。

它们通过在数据空白处引入噪声来实现这一目标,努力在保持目标分布统计特性的同时,最大化熵值。

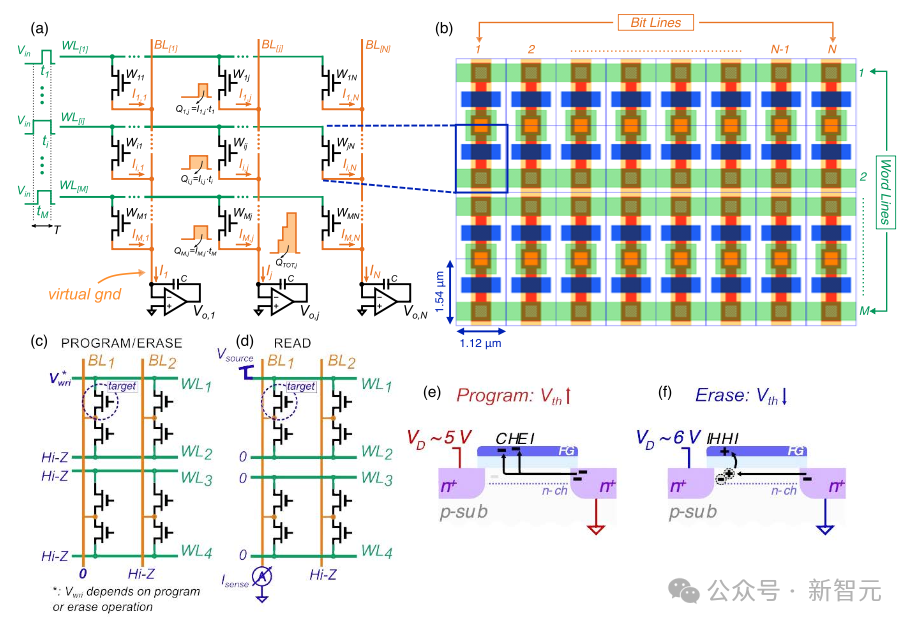

图1:Extropic概率性AI加速器的基本原理

能量基模型(EBMs)在生产应用中面临的主要挑战是采样需求。

在数字硬件上,从通用能量景观中进行采样非常困难,因为这需要硬件消耗大量电能来产生和调整扩散过程所需的熵。

Extropic通过将能量基模型直接实现为参数化的随机模拟电路,有效地解决了这一低效问题。与数字计算机相比,Extropic加速器在运行时间和能源效率方面将实现多个数量级的改进。

具体来说,Extropic加速器的工作原理与布朗运动相似。

在布朗运动中,宏观但轻质的粒子在流体中悬浮,由于与微观液体分子的频繁碰撞,这些粒子会经历随机的力,导致它们在容器中随机移动。

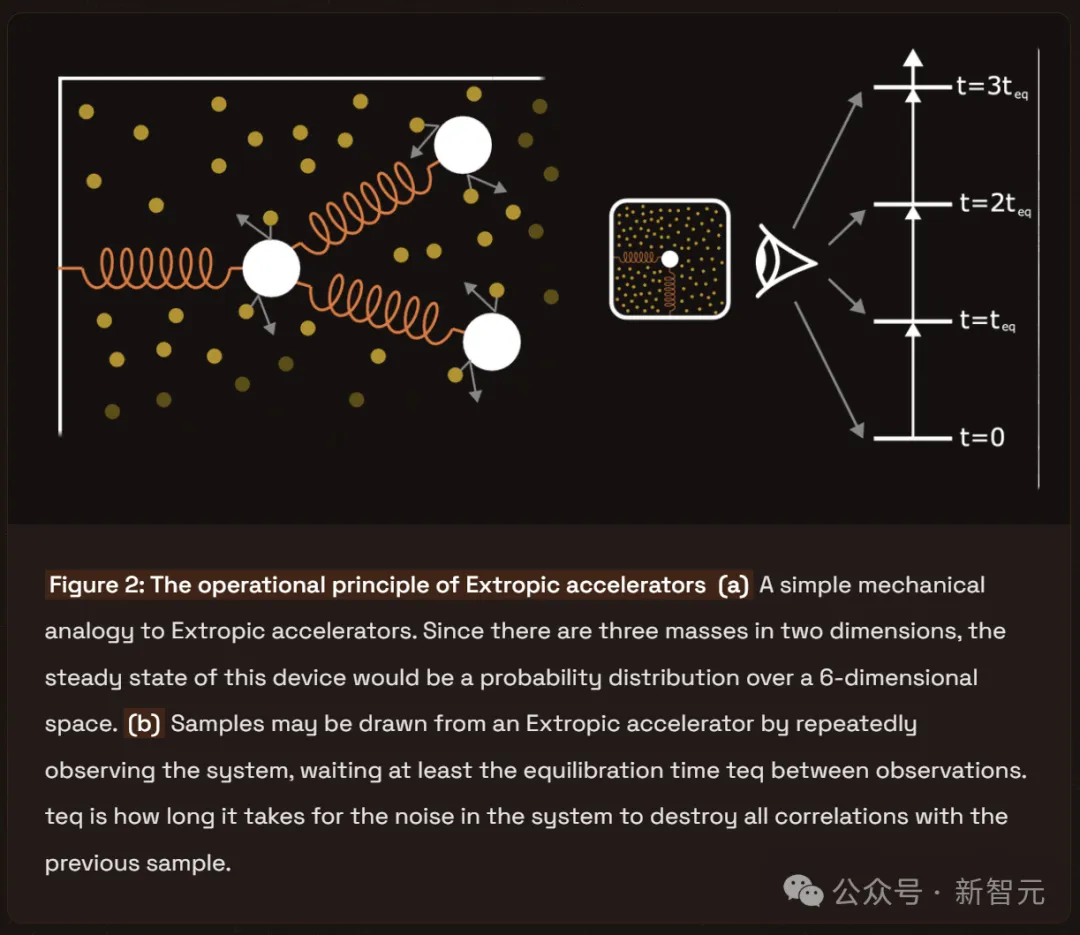

如图2(a)所示,可以想象,通过弹簧将布朗粒子固定在容器壁和彼此之间。这样,弹簧会抵抗随机力,使得粒子倾向于聚集在容器的某些特定区域。

如图2(b)所示,如果不断地重复采样粒子的位置,并在两次样本之间留出足够的时间我们会发现它们遵循一个可预测的稳定的概率分布。

通过改变弹簧的刚度,我们可以调整这个分布。这种简单的机械系统提供了一种可编程的随机性。

图2:Extropic加速器的运行原理

(a)Extropic加速器的简单机械类比。因为设备涉及三个质量点在两个维度上的活动,其稳定状态将对应一个六维空间的概率分布;

(b)从Extropic加速器中抽取样本的方法是,反复观察系统,并确保每次观察之间至少有一个平衡时间teq。这个平衡时间teq是指系统中的噪声消除与前一个样本相关性所需的时长。

这个机械模型直接关联到构成Extropic加速器的参数化随机模拟电路。

这里,轻质粒子相当于电子,而液体分子则是导电介质中的原子,它们在碰撞中能将能量传递给电子。弹簧则代表了限制电子运动的电路元件,比如电感或晶体管。通过施加控制电压或电流,可以调整这些元件的参数,进而改变电路的采样分布。

虽然每个电路都存在噪声,但并非所有电路都适合用作Extropic加速器。

从工程学的角度来看,打造一个以噪声为主导且表现稳定的设备颇具挑战性。由于热波动较小,这类设备必须设计得足够小且功率低,以便显著受到这些波动的影响。

因此,如果想利用宏观组件(如在印刷电路板上)来构建Extropic加速器,就必须引入人造噪声。但这种做法会削弱设备在时间和能源节省方面的基本优势,最终的性能可能与数字执行算法相似。

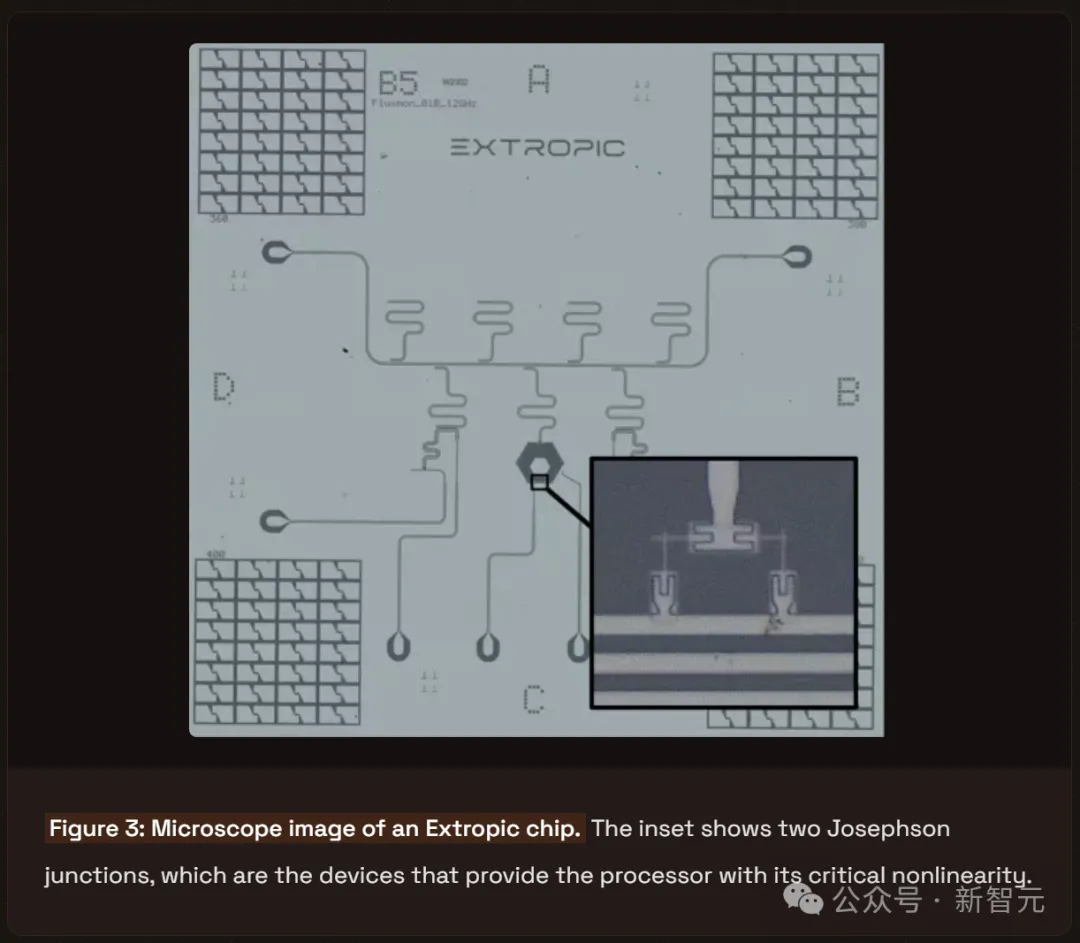

图 3:Extropic芯片的显微镜图像。图中小图展示了两个Josephson结,这些是为处理器提供关键非线性功能的设备。

这些神经元构成了基本单元,组合起来可以构建一个更大的超导系统。

在这种大型系统中,多个线性和非线性神经元结合,形成一个能从丰富且高维的分布中采样的电路。神经元的偏置和相互作用强度都是可调整的参数,使得单一设备能够支持多种概率分布。

Extropic的超导芯片完全是被动式的,这意味着只会在测量或调整其状态时才消耗能量。这可能使得这些神经元成为全宇宙中最节能的。

Extropic还在开发可在常温下运行的半导体设备,以便扩大市场。

这些设备用晶体管替代了Josephson结,虽牺牲了一些能效,但可利用标准的制造流程和供应链进行生产,从而大规模生产。

由于这些设备可以在常温下运行,因此可以将它们设计成类似GPU的扩展卡形式。这将使我们能够在每个家庭中安装一个Extropic加速器,让每个人都能体验到热力学AI加速的优势。

为了支持多种硬件平台,Extropic正在开发一个软件层,从而将能量基函数模型的抽象规范转换为相应的硬件控制语言。

这个编译层基于因子图(factor graphs)的理论框架,因子图描述了大型分布如何分解为局部块。这使得Extropic加速器能够拆解并运行那些单个模拟核心无法完全承载的庞大程序。

许多以前的AI加速器公司因为深度学习的内存限制而难以获得优势——现今的算法约有25%的时间用于在内存中移动数据。

因此,根据Amdahl定律,任何专门加速某一操作(如矩阵乘法)的芯片都难以实现超过4倍的速度提升。

Extropic芯片能够本质上通过物理方式快速且高效地运行广泛的概率算法,从而有望开启一个全新的人工智能加速时代,远超过之前认为可能的水平。