撰稿 | 言征

出品 | 51CTO技术栈(微信号:blog51cto)

Sora带火了“视频一致性”的研究,但单纯在时间一致性已经不能满足业内对于高逼真视频的渴望。这不,华人又出来炸场了!

近日,一个名为VideoGigaGAN的视频模型在业界走红。超分辨率电影镜头,不用等Sora了!

图片

图片

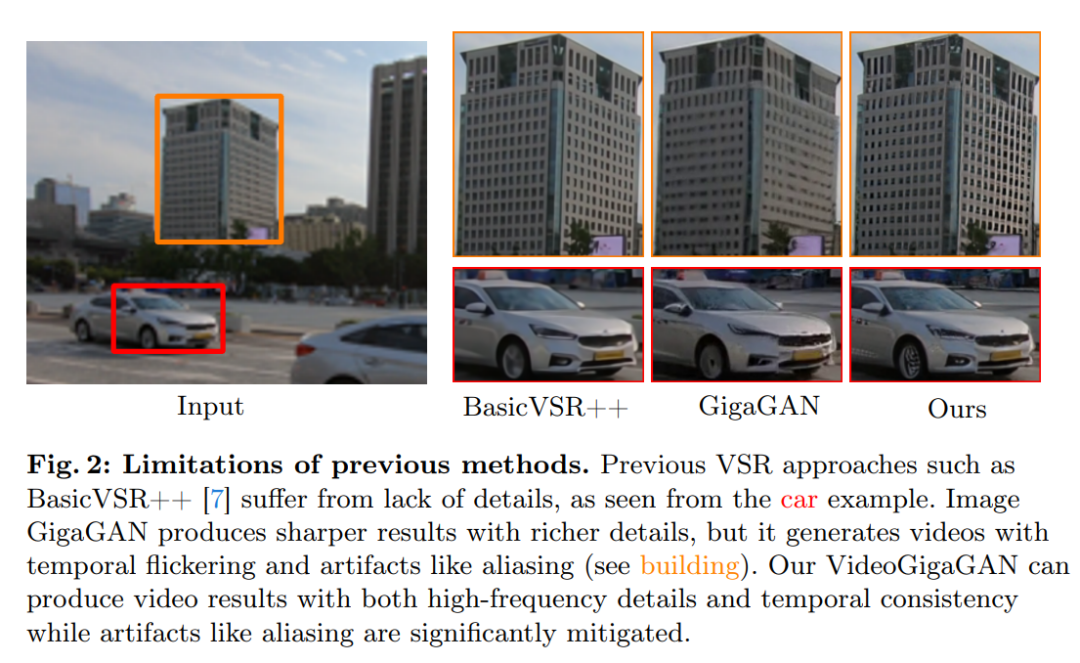

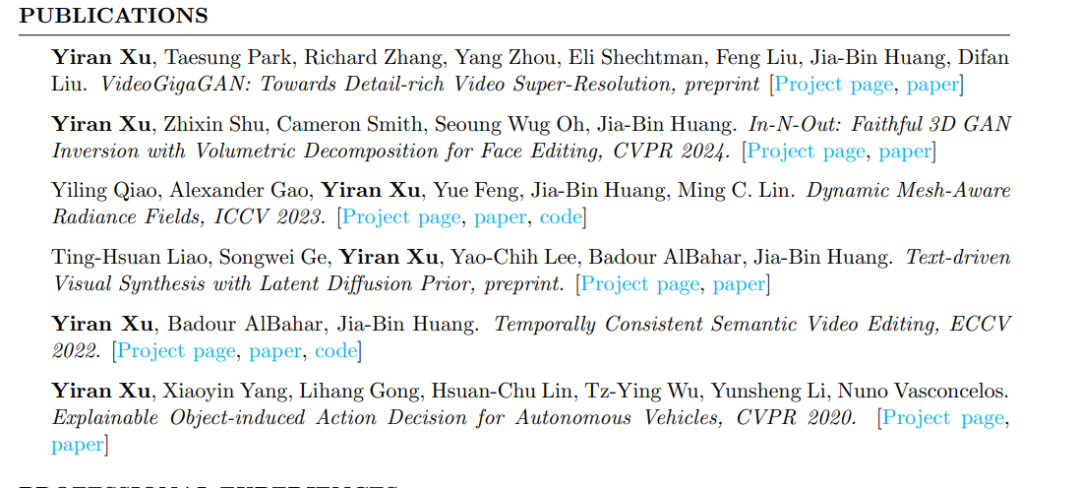

据介绍,目前VSR(视频超分辨率)领域有两大难题:一个挑战是保持输出帧之间的时间一致性。第二个挑战是在上采样帧中生成高频细节。这篇论文主要的就是第二个问题。针对这个问题,GAN(生成式对抗网络)似乎再一次被验证而来有效性。

1.让模糊视频还原逼真细节,8倍于SOTA

举个汽车识别的例子,以前的VSR方法,比如BasicVSR++等都缺乏细节,而ImageGigaGAN可以通过更丰富的细节产生更清晰的效果,但它生成的视频存在时间闪烁和混叠等伪影(注意视频中的建筑画面)。

而新提出的VideoGigaGAN方法则可以生成兼具高频细节和时间一致性的视频结果,同时显著减轻了像混叠伪影的问题。

图片

图片

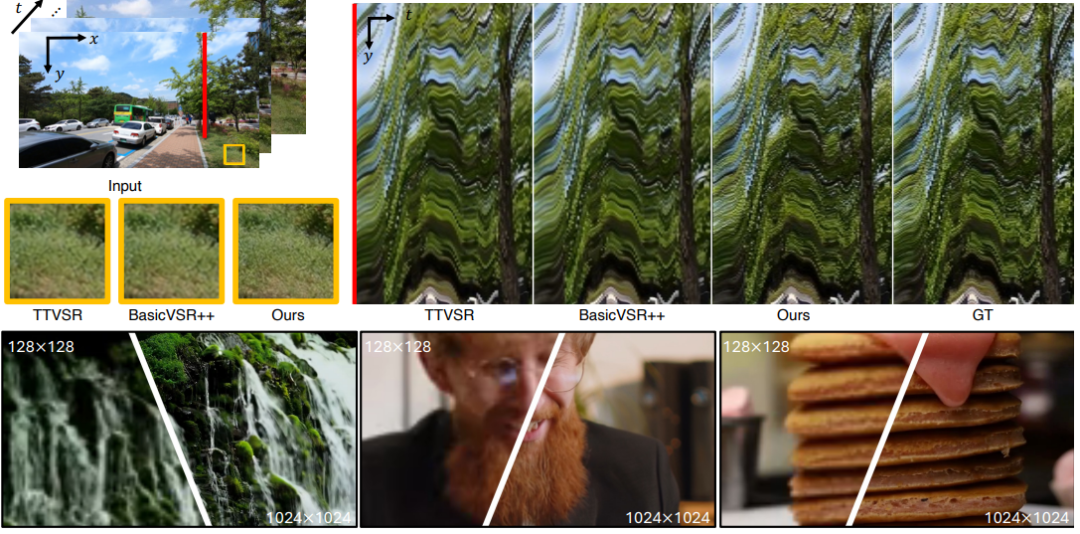

VideoGigaGAN是一种生成式视频超分辨率模型,该模型能够在保持时间一致性的同时,对视频进行高频细节的超采样。与现有的VSR方法相比,VideoGigaGAN能够生成具有更多细粒度外观细节的时间一致性视频。

研究显示,VideoGigaGAN在公共数据集上非常有效,并展示了超过目前最先进的VSR模型8倍超分辨率的视频结果。

图片

图片

先亮出几个对比视频,相信你都不敢相信自己的眼睛:视频黑科技就是如此震撼!

见证奇迹的时刻到了——

研究团队放出了一张金针菇涮锅的视频对比,题外话:Xu本人也是一名Cooking爱好者。

大家应该还记得之前类Sora工具放出的飞鸟视频,从书上飞起后,总是会有一层虚影,这个问题已经被VideoGigaGAN解决掉了。

动物世界非常精彩,但如果你看不清楚蜘蛛背后的网丝,“小花猫”跟绳子之间是如何互动的,多少损失一些镜头的美感。

2.怎么做到的?答案藏在模型细节

接下来,我们看下这个模型的厉害之处。

图片

图片

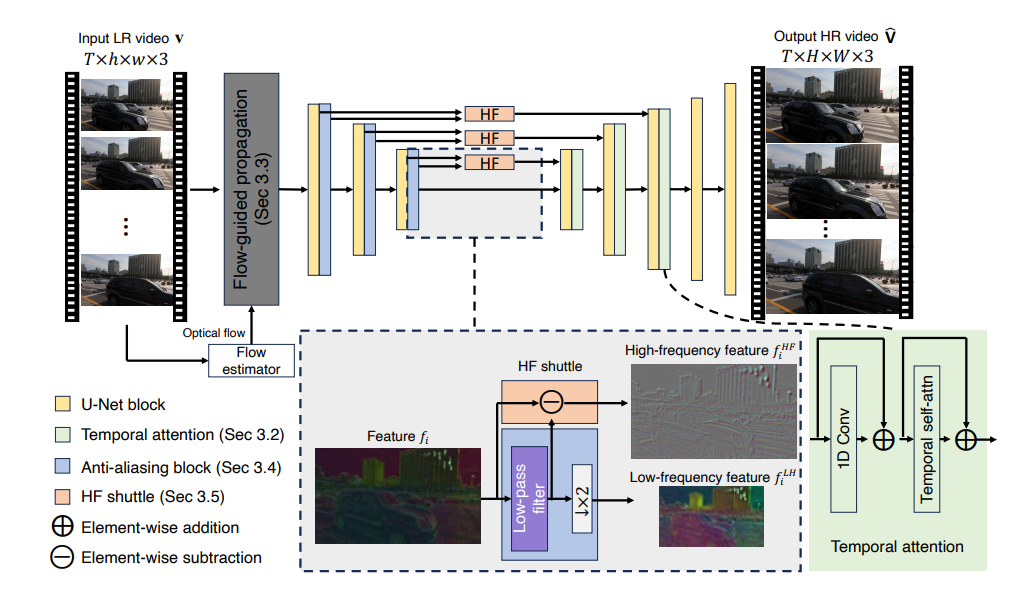

首先,该视频超分辨率(VSR)模型建立在图像的不对称U-Net架构的GigaGAN上采样器之上。

其次,为了增强时间一致性,团队通过将时间注意力层添加到解码器块,将图像采样放大为视频采样器。

然后,另外一个秘诀,就是通过整合流导向传播模块的特征来增强一致性。

接下来,为了抑制混叠伪影,团队使用编码器下采样层中的抗锯齿块(Anti-aliasing)。

最后,Xu等通过跳层连接直接将高频特征传递到解码器层,以补偿BlurPool过程中损失的细节。

这里值得注意的一点:因为时间注意力的空间窗口大小有限。所以,Xu等团队将流导向特征传播引入到放大的GigaGAN中,以便基于流信息更好地对齐不同帧的特征。

其次,还有抗混叠的技术处理,也进一步减轻了GigaGAN编码器中的下采样块引起的时间闪烁,同时通过将高频特征直接传输到解码器块来保持高频细节。

当然,这些想法也被最后的实验结果验证了。所以说,这些模型设计选择非常重要。

3.背后的一作:爱Cook的Xu yiyan

没错,本篇研究成果的一作 Xuyiyan(许姓)又是一位中国学者,本科毕业于华南理工大学,现在是美国马里兰大学帕克学院的博士生。Xu目前在主要研究方向包括生成模型及其应用,据悉他也做过自动驾驶领域的场景理解的研究。

图片

图片

图片

图片

正如前文所说,Xu的个人爱好蛮特别:摄影、徒步旅行、做饭。

图片

图片

4.网友热议:质量不错,时长太短了我们需要200帧的(至少9秒)

镜头时长问题的研究成重点,HN上一位用户评论道:“视频质量看起来不错,但局限性很大。我们的模型在处理极长视频(例如200帧或更多)时遇到了挑战。”所以他认为,要用于实际环境,还需要进行更多的研究。

对此还有网友亮出了类似的观点:“在某种程度上,我会强迫性地计算镜头的秒数,知道一个节目/电影有几个镜头超过9秒,并且能够赢得我们的信任,我才可以放手了。”

据另一位Hackernews用户评论,现代电影的平均镜头长度约为2.5秒,对于动画来说大约是15秒。而此项研究中的30fps的帧率并不够,意味着时间将少于7秒。

总之,大家非常期待如果该篇论文能够扩展到200帧后的结果。

5.One More Thing:别忘了打上AI标签

此外,此次研究成果的发布也再一次引起了AI被滥用的担忧。“这对于娱乐来说非常有用,但过于逼真清晰的画面依然有可能被用作任何类型的‘证据’,而大家对于这些幻觉的细节的工作原理并不知晓,所以此类视频还是需要进行显眼的标记。”不过清醒的是,目前智能手机上已经有不少软件或视频/摄影功能已经在使用专有算法来“推断”是否存在虚假的细节,而且检查规模会更大。不过,回到本篇研究,最有意思的,还是神奇的还原细节的能力。想想电视和电影中的许多画面,尤其十年前的珍贵影响,有了这项技术,“增强”低分辨率图像使其变得清晰,将不再是一件难事!