本文经自动驾驶之心公众号授权转载,转载请联系出处。

写在前面&笔者的个人理解

本文介绍了一种用于3D目标检测和多目标跟踪的相机-毫米波雷达融合方法(CR3DT)。基于激光雷达的方法已经为这一领域奠定了一个高标准,但是其高算力、高成本的缺陷制约了该方案在自动驾驶领域的发展;基于相机的3D目标检测和跟踪方案由于它的成本较低,也吸引了许多学者的关注,但是检测效果较差。因此,将相机与毫米波雷达融合正在成为一个很有前景的方案。作者在现有的相机框架BEVDet下,融合毫米波雷达的空间和速度信息,结合CC-3DT++跟踪头,显著提高了3D目标检测和跟踪的精度,中和了性能和成本之间的矛盾。

主要贡献

传感器融合架构 提出的CR3DT在BEV编码器的前后均使用中间融合技术来集成毫米波雷达数据;而在跟踪上,采用一种准密集外观嵌入头,使用毫米波雷达的速度估计来进行目标关联。

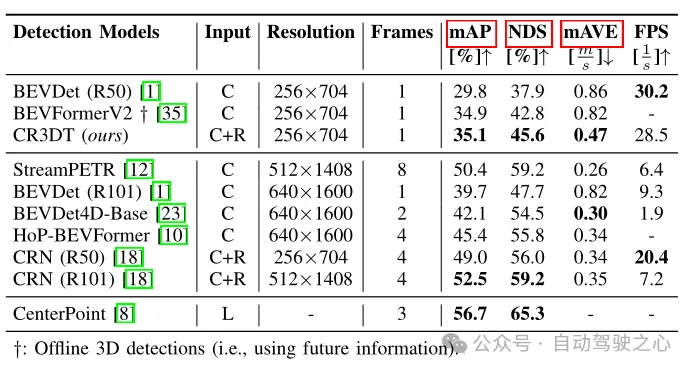

检测性能评估 CR3DT在nuScenes 3D检测验证集上实现了35.1%的mAP和45.6%的nuScenes检测分数(NDS)。利用雷达数据中包含的丰富的速度信息,与SOTA相机检测器相比,检测器的平均速度误差(mAVE)降低了45.3%。

跟踪性能评估 CR3DT在nuScenes跟踪验证集上的跟踪性能为38.1% AMOTA,与仅使用相机的SOTA跟踪模型相比,AMOTA提高了14.9%,跟踪器中速度信息的明确使用和进一步改进显著减少了约43%IDS的数量。

模型架构

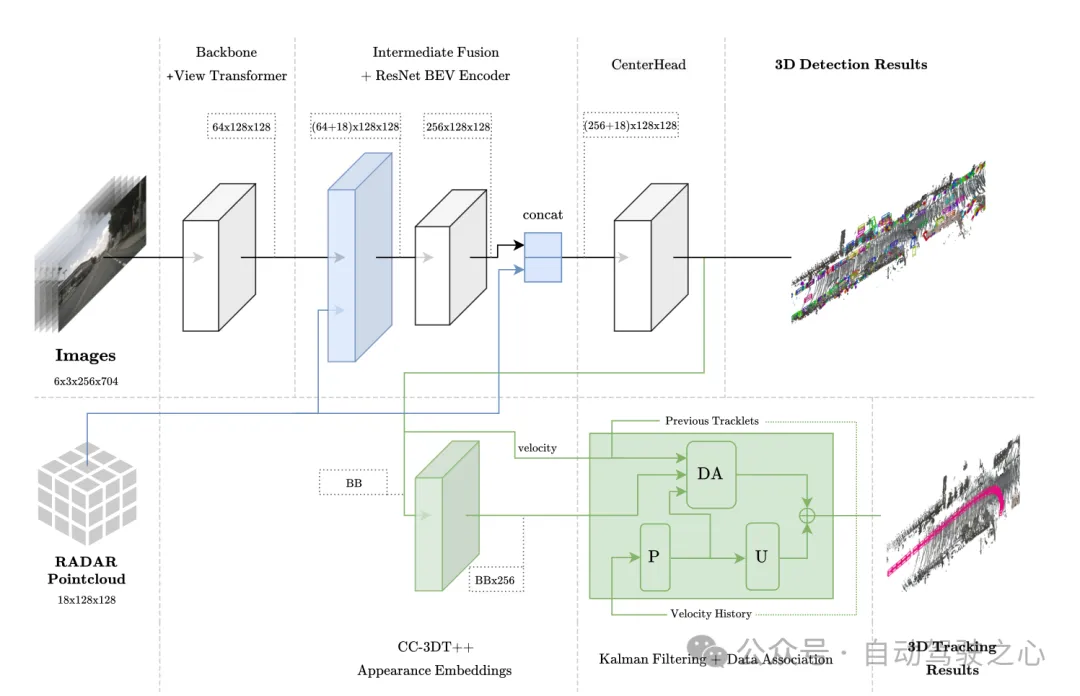

该方法基于BEVDet架构,融合RADAR的空间与速度信息,结合CC-3DT++跟踪头,该头在其数据关联中明确使用了改进的毫米波雷达增强检测器的速度估计,最终实现了3D目标检测和跟踪。

图1 整体架构。检测和跟踪分别以浅蓝色和绿色突出显示。

图1 整体架构。检测和跟踪分别以浅蓝色和绿色突出显示。

BEV 空间中的传感器融合

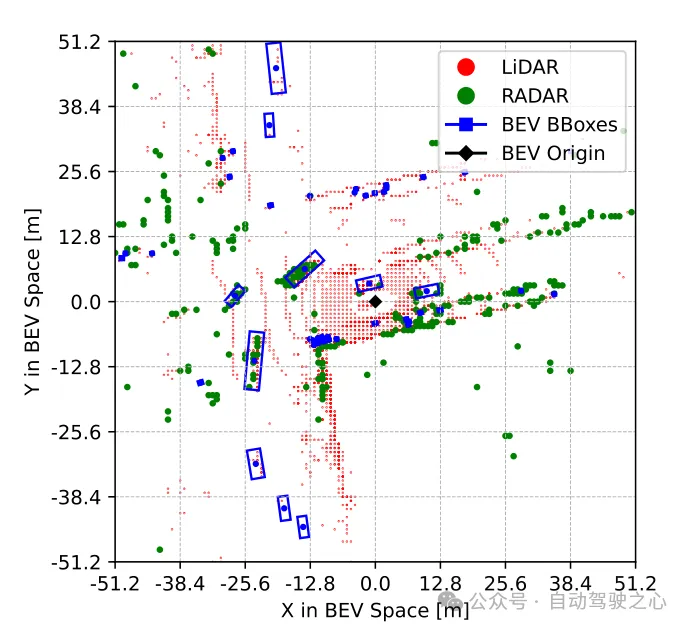

如图2所示是聚合到BEV空间以进行融合操作的Radar点云可视化结果,其中的LiDAR点云仅用于可视化对比。该模块采用类似PointPillars的融合方法,包括其中的聚合和连接,BEV网格设置为[-51.2, 51.2],分辨率为0.8,从而得到一个(128×128)的特征网格。将图像特征直接投射到BEV空间中,每个网格单元的通道数是64,继而得到图像BEV特征是(64×128×128);同样的,将Radar的18个维度信息都聚合到每个网格单元中,这其中包括了点的x,y,z坐标,并且不对Radar数据做任何增强。作者认为Radar点云已经包含比LiDAR点云更多的信息,因此得到了Radar BEV特征是(18×128×128)。最后将图像BEV特征(64×128×128)和Radar BEV特征(18×128×128)直接连接起来((64+18)×128×128)作为BEV特征编码层的输入。在后续的消融实验中发现,在维度为(256×128×128)的BEV特征编码层的输出中添加残量连接是有益的,从而使CenterPoint检测头的最终输入大小为((256+18)×128×128)。

图2 聚合到BEV空间进行融合操作的Radar点云可视化

跟踪模块架构

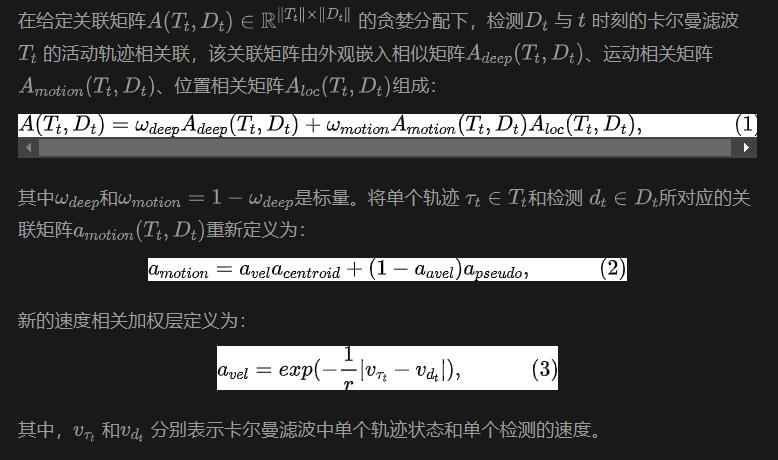

跟踪就是基于运动相关性和视觉特征相似性将两个不同帧的目标关联起来。在训练过程中,通过准密集多元正对比学习获得一维视觉特征嵌入向量,然后在CC-3DT的跟踪阶段同时使用检测和特征嵌入。对数据关联步骤(图1中DA模块)进行了修改,以利用改进的CR3DT位置检测和速度估计。具体如下:

实验及结果

基于nuScenes数据集完成,且所有训练均没有使用CBGS。

受限制模型

因为作者整个模型是在一台3090显卡的电脑上进行的,所以称之为受限制模型。该模型的目标检测部分以BEVDet为检测基线,图像编码的backbone是ResNet50,并且将图像的输入设置为(3×256×704),在模型中不使用过去或者未来的时间图像信息,batchsize设置为8。为了缓解Radar数据的稀疏性,使用了五次扫描以增强数据。在融合模型中也没有使用额外的时间信息。

对于目标检测,采用mAP、NDS、mAVE的分数来评估;对于跟踪,使用AMOTA、AMOTP、IDS来评估。

目标检测结果

表1 在nuScenes验证集上的检测结果

表1显示了CR3DT与仅使用相机的基线BEVDet (R50)架构相比的检测性能。很明显,Radar的加入显著提高了检测性能。在小分辨率和时间帧的限制下,与仅使用相机的BEVDet相比,CR3DT成功地实现了5.3%的mAP和7.7%的NDS的改进。但是由于算力的限制,论文中并没有实现高分辨率、合并时间信息等的实验结果。此外在表1中最后一列还给出了推理时间。

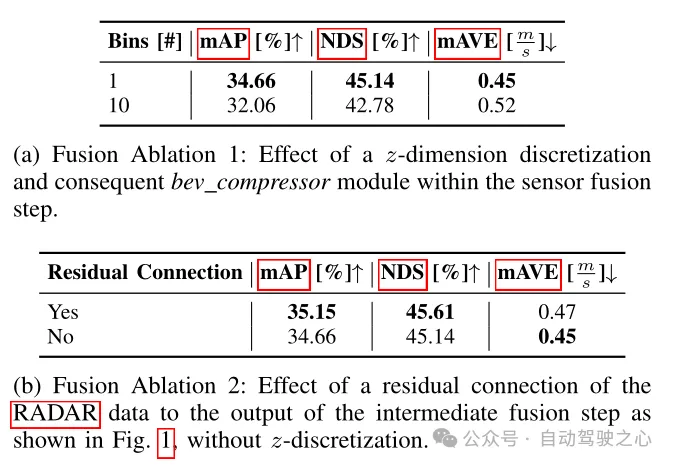

表2 检测框架的消融实验

在表2中比较了不同的融合架构对于检测指标的影响。这里的融合方法分为两种:第一种是论文中提到的,放弃了z维的体素化和随后的3D卷积,直接将提升的图像特征和纯RADAR数据聚合成柱,从而得到已知的特征尺寸为((64+18)×128×128);另一种是将提升的图像特征和纯RADAR数据体素化为尺寸为0.8×0.8×0.8 m的立方体,从而得到替代特征尺寸为((64+18)×10×128×128),因此需要以3D卷积的形式使用BEV压缩器模块。由表2(a)中可以看到,BEV压缩器数量的增加会导致性能下降,由此可以看到第一种方案表现得更为优越。而从表2(b)中也可以看到,加入了Radar数据的残差块同样能够提升性能,也印证了前面模型架构中提到的,在BEV特征编码层的输出中添加残量连接是有益的。

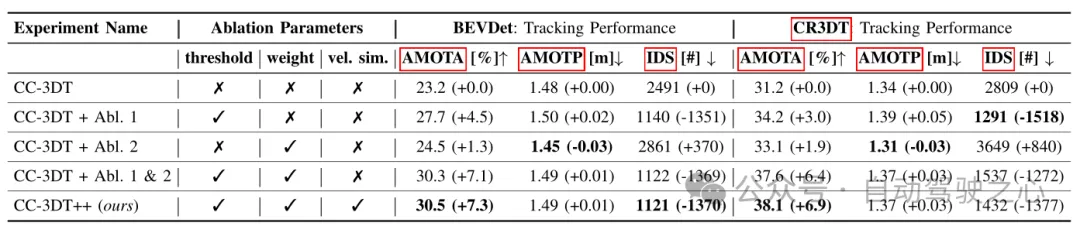

表3 基于基线BEVDet和CR3DT的不同配置在nuScenes验证集上的跟踪结果

表3 基于基线BEVDet和CR3DT的不同配置在nuScenes验证集上的跟踪结果

表3给出了改进的CC3DT++跟踪模型在nuScenes验证集上的跟踪结果,给出了跟踪器在基线和在CR3DT检测模型上的性能。CR3DT模型使AMOTA的性能在基线上提高了14.9%,而在AMOTP中降低了0.11 m。此外,与基线相比,可以看到IDS降低了约43%。

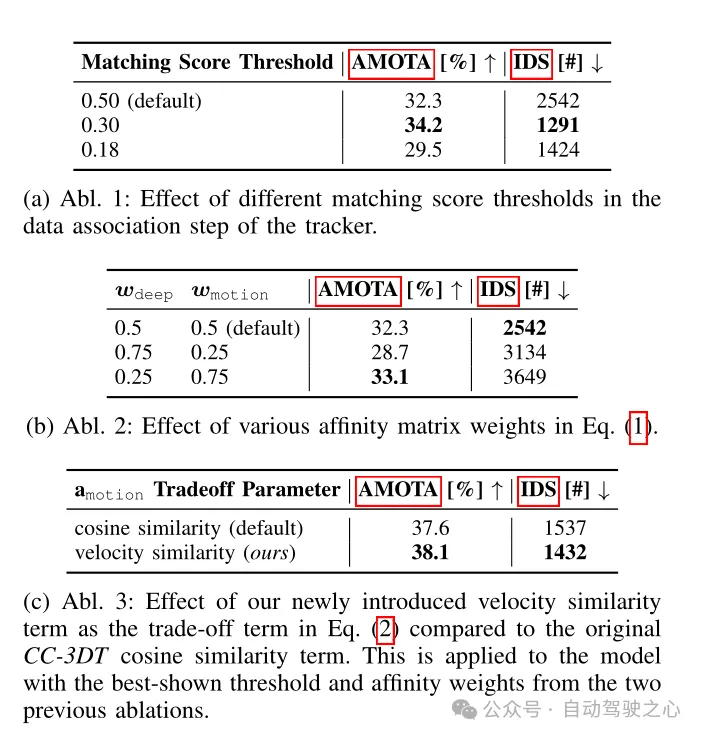

表4 在CR3DT检测骨干上进行了跟踪架构消融实验

结论

这项工作提出了一种高效的相机-雷达融合模型——CR3DT,专门用于3D目标检测和多目标跟踪。通过将Radar数据融合到只有相机的BEVDet架构中,并引入CC-3DT++跟踪架构,CR3DT在3D目标检测和跟踪精度方面都有了大幅提高,mAP和AMOTA分别提高了5.35%和14.9%。

相机和毫米波雷达融合的方案,相较于纯LiDAR或者是LiDAR和相机融合的方案,具有低成本的优势,贴近当前自动驾驶汽车的发展。另外毫米波雷达还有在恶劣天气下鲁棒的优势,能够面对多种多样的应用场景,当前比较大的问题就是毫米波雷达点云的稀疏性以及无法检测高度信息。但是随着4D毫米波雷达的不断发展,相信未来相机和毫米波雷达融合的方案会更上一层楼,取得更为优异的成果!