现在,AI系统的预测准确率达到甚至超过了人群。

在不断发展的人工智能(AI)领域,语言模型已取得了重大进展,实现了曾经被认为人类认知才能实现的非凡成就。比如说,Anthropic新的Claude 3语言模型似乎能够意识到它被测试或被评估,这为AI领域原本惹人瞩目的进步另外增添了一层复杂性。

这个进展特别值得注意的一个新领域是预测领域——对未来事件做出准确预测的能力。

我们在这篇博文中将深入研究一篇突破性的研究论文(https://arxiv.org/pdf/2402.19379.pdf),探究大语言模型(LLM)的预测能力,并将它们与人群预测这个参照标准进行比较。这项研究由伦敦政治经济学院、麻省理工学院和宾夕法尼亚大学的研究人员共同进行,研究结果刷新了我们对AI能力的理解,并揭示了LLM在现实场景中与人类专业知识相媲美的潜力。

背景介绍

预测是指基于过去和现在的数据、趋势和模式对未来事件做出预测,它在经济、政治、技术和科学等领域发挥着至关重要的作用。准确的预测有助于更好的决策、资源分配和风险管理。

传统上,最可靠的预测方法是“群体智慧”效应,即利用一群不同的个体的集体知识。1907年,英国著名人类学家Francis Galton对这一现象进行了著名的论证,当时他观察到,一群人在县集市上猜测的中位数准确地预测了一头牛的体重。从那以后,众多研究已证实,将大量不同预测者的预测值汇总起来,可以得出非常准确的结果。

然而,依靠人群进行预测存在几个局限性:

成本和时间:召集一群足够庞大且多样化的熟练预测者费钱又费时。

偏见和相关性:人类判断容易受到各种认知偏见的影响,个人预测之间的相关性可能会削弱群体的集体准确性。

可扩展性:组织和管理大规模的人类预测比赛操办起来很复杂,很难扩展。

AI预测的前景

近些年来,AI的快速发展(尤其是在自然语言处理领域)已经引出了使用机器智能进行预测的诱人前景。像GPT-3、GPT-4和Claude 3这样的LLM在理解和生成类似人类的文本方面表现出了非凡的能力(Claude 3现在甚至知道它在接受测试),这促使研究人员调查LLM对未来事件做出准确预测的潜力。

然而之前的研究表明,与人群预测相比,各个LLM的表现常常不佳。比如说,Schoenegger和Park在2023年发现,尽管GPT-4拥有出众的语言技能,但其表现不如一个简单的无信息衡量基准,即预测所有二元问题的50%概率。

硅群体智慧

然而在这篇新论文中,Schoenegger等人假设,要释放LLM的预测潜力,关键可能在于汇总来自多个不同模型的预测,这相当于一种机器“群体智慧”效应。为了测验这个想法,他们进行了两项研究:

研究1:LLM并联vs.人群

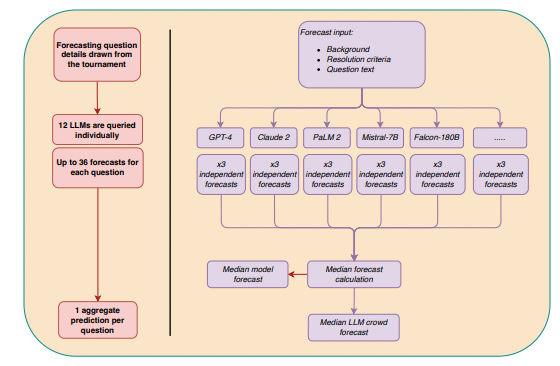

在第一项研究中,研究人员从12个不同的LLM那里收集了多达31个二元问题的预测,这些问题来自预测平台Metaculus上的一项实时预测比赛,925名人类预测者也参与了为期3个月的比赛。LLM涵盖广泛的体系结构、训练数据集和微调方法,包括来自OpenAI、Anthropic、谷歌、Meta等公司的模型。

图1. 测试的模型

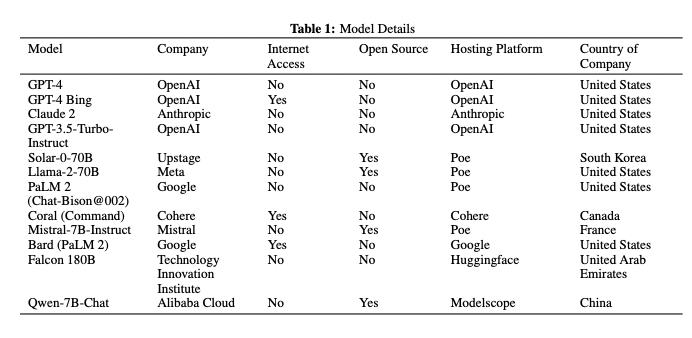

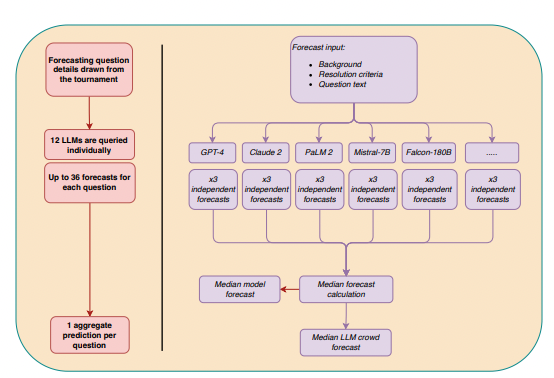

针对每个问题,研究人员使用标准化的提示对每个LLM询问三次,提示包括问题背景、解答标准以及作为“超级预测者”的应答说明。然后,他们算出了12个LLM中所有非缺失预测的中位数,以获得“LLM群体”预测。

图2. LLM并联机制概况图

结果是惊人的:LLM群体在所有问题上的预测都达到了50%的无信息基准(p = 0.026),并且在统计上与人群的准确率没有区别(p = 0.850)。探索性等效测试进一步表明,LLM和人群在中等效应大小范围内不相上下。

研究2:利用人类认知输出改进LLM预测

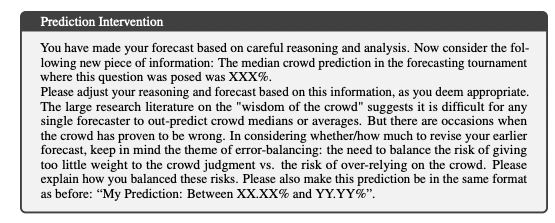

图3. 第二项预测干预提示

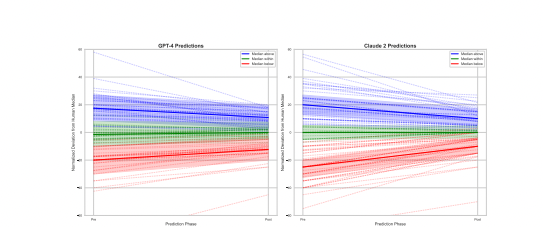

第二项研究调查了是否可以通过为LLM提供人群的中位数预测作为附加信息,进一步提高其预测精度。研究人员专注于两个最先进的模型:GPT-4和Claude 2,并采用了模型内设计,每个模型都进行了初步预测,然后在接收人群中位数后进行了更新预测。

两个模型在接收人类人群信息后都显示出准确性有了显著提高,GPT-4的平均Brier评分(衡量预测误差的指标)从0.17降至0.14 (p = 0.003),Claude 2则从0.22降至0.15(p < 0.001)。当人群中位数处于初始范围内时,这些模型也适当地缩小了其预测区间,显示了以合理的方式整合额外信息的能力。

图4. 接收人类预测前后,GPT-4(左)和Claude 2(右)的LLM预测。颜色区分首次预测高于、低于或介于人类中位数预测的20个百分点。高亮显示的变化和间隔是该组内相应的中位数预测。”

然而探索性分析显示,仅仅将最初的机器预测与人类中位数相平均,可以得到甚至比模型的更新预测更高的准确率。这表明,虽然LLM可能受益于人类认知输出,但其推理能力可能还没有达到整合这类信息的最佳调校水平。

影响和限制

这里的研究发现对预测和AI-人类协作的未来具有重要意义:

可扩展且经济有效的预测:通过利用“硅群体智慧”,组织可以比单独依赖人群更快速、更廉价地获得高质量的预测。这可以使数据驱动的决策在各个领域更容易获得。

人类和AI的互补优势:虽然LLM并联可能与人群准确性相当,但这项研究也表明,人类认知输出可以进一步改善机器预测。这凸显了人类专家和AI系统在预测任务方面协同合作的潜力(这与另一项研究多少有点矛盾;另一项研究发现,AI在诊断疑难疾病方面的表现优于人类医生,无论AI医生的参与程度如何)。

促进AI推理能力:该研究提供了LLM参与复杂推理(或至少看起来是推理)和信息整合的能力的证据,尽管还有进一步优化的空间。随着模型不断改进,我们可能会看到它们在预测性能方面取得更大的进步。

然而,有必要承认这项研究的局限性和注意事项:

- 该研究致力于短期(3个月)二元预测。需要做更多的工作来评估LLM在长期预测和更复杂类型的问题上的表现。

- LLM表现出了一种默认偏差,即使在经验基础率接近均等的情况下,它们也往往预测概率> 50%。它们还显示出了整体校准欠佳,表明需要进一步的改进。

- 随着LLM的训练数据变得越来越过时,如果没有定期更新以跟上不断变化的实际环境,预测准确性可能会随之下降。

结语

尽管存在这些局限性,这项研究还是意义重大,表明AI系统在某些预测领域具有匹配甚至超越人群集体智慧的潜力。通过利用“硅群体智慧”,我们可以让高质量的、数据驱动的预测比以往任何时候更具可扩展性、更普及。

当然,LLM并不能完全取代人类判断,人类专家在解释、结合上下文处理和根据机器预测采取行动方面将始终扮演至关重要的角色。但随着AI能力不断提升,越来越明显的是,未来的预测将是人类智能和机器智能之间密切合作和协同作用的结果。

有些人重视对我们所居住的复杂世界做出准确、及时和可操作的预测,硅群体时代即将到来,这对他们来说确实是令人兴奋的前景。随着研究人员不断突破AI预测方面的极限,本人一定会替读者密切关注这方面。

原文标题:The wisdom of the crowd: LLM prediction ability matches human crowds,作者:Mike Young

链接:https://notes.aimodels.fyi/ai-llm-prediction-wisdom-crowd-human/。