本文经自动驾驶之心公众号授权转载,转载请联系出处。

写在前面&笔者的个人理解

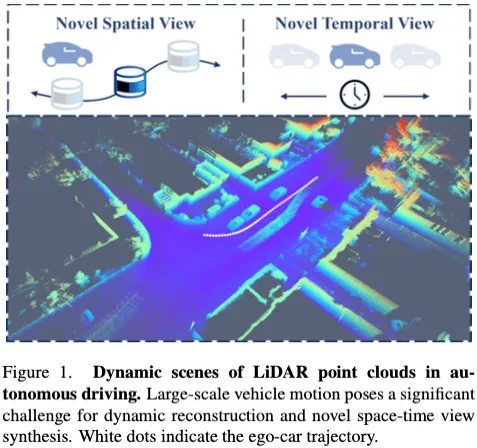

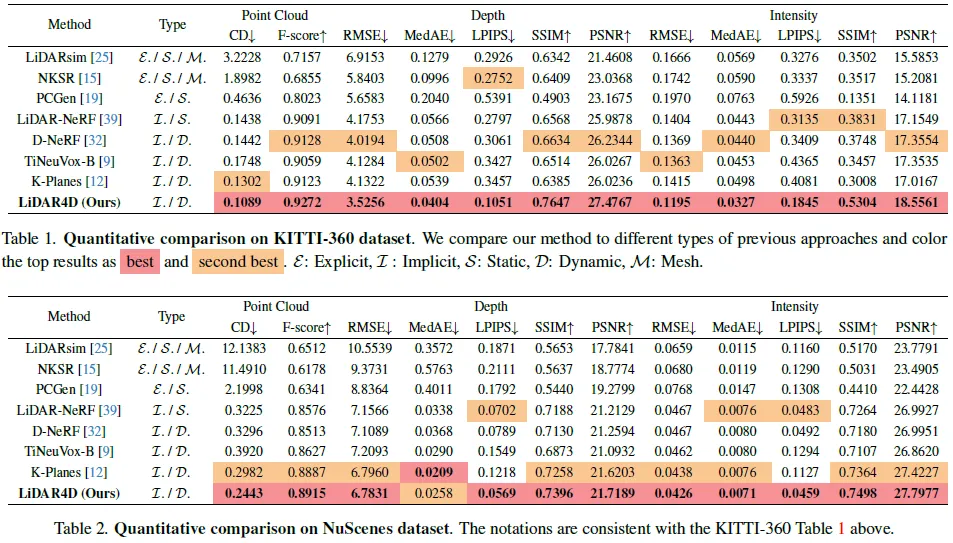

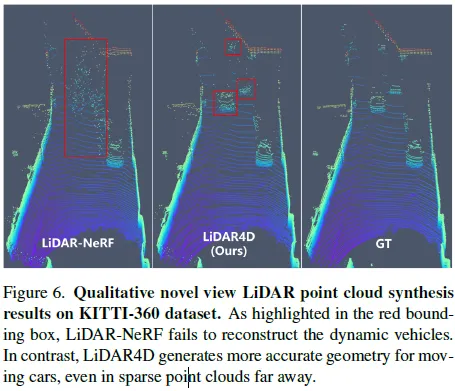

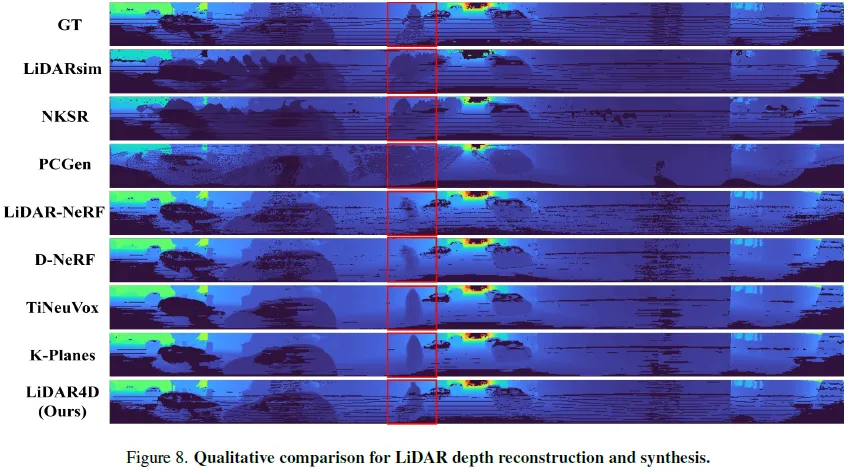

尽管神经辐射场(NeRFs)在图像新视角合成(NVS)方面取得了成功,但激光雷达NVS的发展却相对缓慢。之前的方法follow图像的pipeline,但忽略了激光雷达点云的动态特性和大规模重建问题。有鉴于此,我们提出了LiDAR4D,这是一种用于新的时空LiDAR视图合成的LiDAR-only的可微分框架。考虑到稀疏性和大规模特征,进一步设计了一种结合多平面和网格特征的4D混合表示,以实现从粗到细的有效重建。此外引入了从点云导出的几何约束,以提高时序一致性。对于激光雷达点云的真实重建,我们结合了ray-drop概率的全局优化,以保持cross-region模式。在KITTI-360和NuScenes数据集上进行的大量实验证明了我们的方法在实现几何感知和时间一致的动态重建方面的优越性。

开源地址:https://github.com/ispc-lab/LiDAR4D

总结来说,本文的主要贡献如下:

- 提出了LiDAR4D,这是一种用于新的时空LiDAR视图合成的LiDAR-only的可微分框架,它重建动态驾驶场景并端到端生成逼真的LiDAR点云。

- 介绍了4D混合神经表示和从点云导出的运动先验,用于几何感知和时间一致的大规模场景重建。

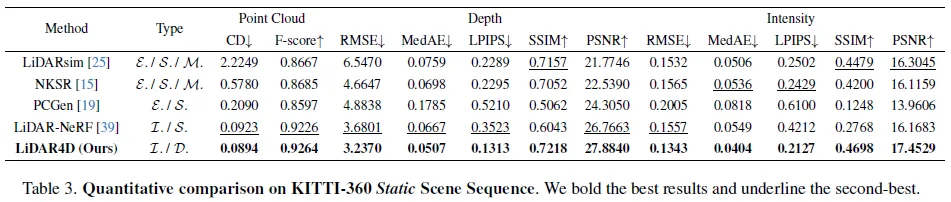

- 综合实验证明了LiDAR4D在具有挑战性的动态场景重建和新颖视图合成方面的SOTA性能。

相关工作回顾

激光雷达仿真。CARLA等传统仿真器基于物理引擎,可以在手工制作的虚拟环境中通过光线投射生成激光雷达点云。然而,它有多样性限制,并且严重依赖昂贵的3D资产。与真实世界的数据相比,domain gap仍然很大。因此,最近的几项工作通过在仿真之前从真实数据重建场景,进一步缩小了这一差距。LiDARsim重建网格表面表示,并使用神经网络来学习光线下降特性。此外,值得注意的是,还有其他表面重建工作,如NKSR,可以将激光雷达点云转换为网格表示。尽管如此,这些显式重建工作对于在大规模复杂场景中恢复精确的曲面来说是麻烦的,这进一步导致点云合成的精度下降。相反,PCGen直接从点云进行重建,然后以类似光栅化的方式进行渲染并进行第一次峰值平均。尽管它更好地保留了原始信息,但渲染点云仍然相对嘈杂。此外,上述所有这些显式方法仅适用于静态场景。相反,我们的方法通过时空神经辐射场隐式重建连续表示,实现了更高质量的真实点云合成,摆脱了静态重建的局限。

神经辐射场。最近基于神经辐射场的大量研究在新视图合成(NVS)任务中取得了突破和显著成就。基于MLP、体素网格、三平面、向量分解和多级哈希网格的各种神经表示已被充分用于重建和合成。然而,大多数工作都集中在以目标为中心的室内小场景重建上。随后,几部作品逐渐将其扩展到大型户外场景。尽管如此,神经辐射场通常在RGB图像输入的情况下存在几何模糊性。因此,DS-NeRF和DDP-NeRF在提高效率之前引入了深度,URF还利用激光雷达点云来促进重建。在本文中,我们使用新的混合表示和神经激光雷达场来重建激光雷达NVS的大规模场景。

用于激光雷达NVS的NeRF。最近,一些研究开创了基于神经辐射场的激光雷达点云新视图合成的先河,大大超过了传统的仿真方法。其中,NeRF-LiDAR和UniSim需要RGB图像和LiDAR点云作为输入,并在具有光度损失和深度监督的情况下重建驾驶场景。随后,可以通过神经深度渲染生成新的视图LiDAR点云。在仅使用LiDAR的方法中,LiDAR-NeRF和NFL首次提出了可微分LiDAR-NVS框架,该框架同时重建了深度、强度和raydrop概率。然而,这些方法仅限于静态场景重建,并且不能处理诸如移动车辆之类的动态目标。尽管UniSim确实支持动态场景,但它在很大程度上受到3D目标检测的地面实况标记以及重建前背景和动态目标解耦需求的限制。相反,我们的研究专注于仅用于动态场景重建和新颖时空视图合成的激光雷达输入,而无需RGB图像或地面实况标签的帮助。值得注意的是,NFL对激光雷达的详细物理建模做出了重大贡献,如光束发散和二次返回,这与我们的正交,可能有利于所有激光雷达NVS工作。

动态场景重建。大量的研究致力于扩展神经辐射场,以涵盖动态场景重建。一般来说,动态NeRF可以大致分为两组。一种是通过连续变形场将坐标映射到规范空间的可变形神经辐射场。虽然变形场和辐射场的解耦简化了优化,但建立准确的远距离对应仍然具有挑战性。另一个是时空神经场,它将时间视为构建4D时空表示的额外维度输入。因此,可以灵活地将外观、几何结构和运动同时建模为连续的时变函数。之前的大多数工作都集中在室内相对较小的位移上,而自动驾驶场景中的大规模车辆移动则更具挑战性。此外,我们的工作也是首次将动态神经辐射场引入激光雷达NVS任务。

详解LiDAR4D

本节从新型激光雷达视图合成的问题公式和NeRF的初步问题开始。在此之后,提供了我们提出的LiDAR4D框架的详细描述。

问题公式。在动态驾驶场景中,给定收集的激光雷达点云序列,以及相应的传感器姿态和时间戳作为输入。每个单个激光雷达帧Si包含3D坐标x和1D反射强度ρ的K个点。

LiDAR4D的目标是将这种动态场景重建为基于神经场的连续隐式表示。此外,给定新的传感器姿态和任意时刻,LiDAR4D执行神经渲染,以在新的时空视图下合成具有强度的LiDAR点云。

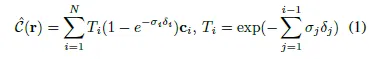

NeRF的准备工作。神经辐射场,简称NeRFs,以位置x∈R3和观看方向(θ,ξ)的5D输入为输入,建立到体积密度σ和颜色c的映射。然后,进行体积渲染,估计像素值,合成未知新视图中的图像。详细地说,它从传感器中心o发射方向为d的光线r,即r(t)=o+td,然后沿该光线对N个样本的神经场输出进行积分,以近似像素颜色C。体积渲染函数可以形成如下:

LiDAR4D概述

根据神经辐射场,我们提出的LiDAR4D将点云场景重建为隐式连续表示。与RGB图像具有光度损失的原始NeRF不同,我们重新定义了基于激光雷达的神经场,称为神经激光雷达场。如图2所示,它专注于对激光雷达点云的几何深度、反射强度和光线下降概率进行建模。对于大规模动态驾驶场景,LiDAR4D将粗分辨率多平面特征与高分辨率哈希网格表示相结合,实现高效有效的重建。然后,我们将其提升到4D,并将时间信息编码引入到新的时空视图合成中。为了确保几何感知和时间一致的结果,我们还引入了从点云导出的显式几何约束。最终,我们预测每条光线的raydrop概率,并使用运行时优化的U-Net执行全局细化,以提高生成真实性。

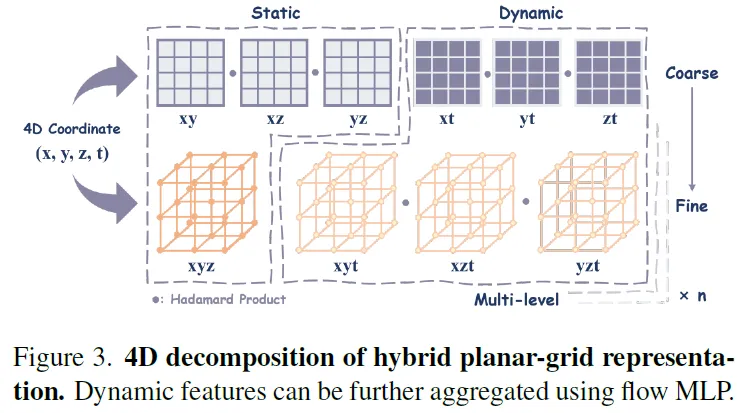

4D Hybrid Planar-Grid Representation

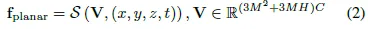

图3说明了我们提出的新的混合表示如何将4D空间分解为平面和哈希网格特征,这些特征进一步细分为静态和动态特征。与室内小物体的重建不同,大规模自动驾驶场景对特征的表示能力和分辨率提出了更高的要求。然而,TiNeuVox等密集网格表示由于其立方体增长的复杂性,对于大规模场景是不可缩放的。因此,我们遵循K平面,将场景空间分解为多个正交平面中的特征组合,以大幅减少参数量。平面特征可以如下获得:

尽管如此,对于跨越数百米的场景,这种分辨率的提高仍然不够,尤其是对于高频强度重建。由于Instant NGP中提出的哈希网格,具有超高分辨率的显式网格结构是可能的。此外,激光雷达点云场景的稀疏性基本上避免了散列碰撞的不利影响。

其中密集网格G将通过散列映射被进一步压缩到有限的存储器中以用于参数缩减。类似地,在三线性插值和级联之前,4D坐标被投影到静态(xyz)和动态(xyt,xzt,yzt)多级哈希网格中,其中使用Hadamard乘积来乘以动态特征。

然而,值得注意的是,纯哈希网格表示仍然存在视觉伪影和噪声重建结果(如图4所示),这阻碍了精确对象几何结构的构建。有鉴于此,我们采用低分辨率的多平面特征进行整体平滑表示,并采用高分辨率的哈希网格来处理更精细的细节,最终在大规模场景重建中实现高精度和高效率。

Scene Flow Prior

为了增强当前4D时空表示的时间一致性,我们进一步引入了用于运动估计的流MLP。它将编码的时空坐标作为输入,并构建从坐标场R4到运动场R3的映射。

由于在自动驾驶场景中,车辆运动范围可能跨越很长的距离,因此在可变形神经辐射场中很难建立与规范空间的长期对应关系。因此,我们利用流MLP仅预测相邻帧之间的运动,并聚合多帧动态特征以实现时间一致的重建。

此外,可以从输入的激光雷达点云进一步导出显式几何约束。通过将点云馈送到流MLP中以产生场景流预测,我们可以将倒角距离调节为几何损失。它对激光雷达4D施加了运动先验和额外的监督,从而实现了几何感知重建。点云S和的两个帧之间的倒角距离定义如下:

Neural LiDAR Fields

激光雷达发射激光脉冲并测量飞行时间(ToF),以确定物体距离以及反射光的强度。旋转式激光雷达具有360度水平视场(FOV)和有限的垂直视场范围,可以通过特定的角分辨率激光感知环境。以与神经激光雷达场相同的方式,我们在视场内以特定的角度间隔发射激光,使用激光雷达传感器的中心作为原点o。激光的方向d由极坐标系下的方位角θ和仰角决定,如下所示。

然后,我们查询沿激光器采样的三维点坐标,并将其输入神经场,以预测相应位置的密度。接下来,对沿着射线的密度进行积分,以获得深度值D的期望值,该深度值D用作激光束的返回距离。

此外,我们分别预测了每个点的强度I和ray-drop概率P,并类似地沿着射线进行α组成。

我们使用单独的MLP来获取时间聚合的平面和哈希特征,以及位置编码的视点作为预测的输入。

Ray-drop Refinement

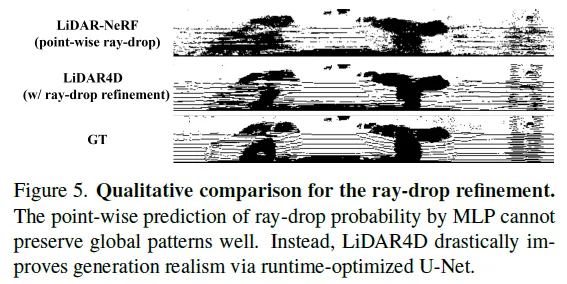

在激光测距过程中,一部分发射的光线不会反射回传感器,这被称为光线下降特性。事实上,激光雷达的射线降受到各个方面的显著影响,包括距离、表面特性和传感器噪声。与LiDAR-NeRF中一样,ray-drop预测是直接用逐点MLP头来完成的,这本质上是有噪声和不可靠的。为了解决这个问题,我们使用具有残差的U-Net来全局细化ray-drop掩模,并更好地保持跨区域的一致图案。它以LiDAR4D的全射线下降概率、深度和强度预测为输入(与之前的工作不同),并通过二进制交叉熵损失细化最终掩模,如下所示:

我们强调,轻量级网络是在运行时随机初始化和优化的,可以有效地进行重建。如图5所示,全局优化大大提高了预测结果,并进一步增强了生成的激光雷达点云的保真度。

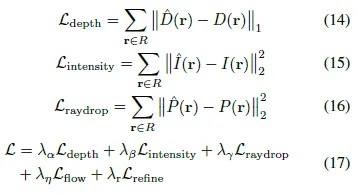

Optimization

对于LiDAR4D的优化,总重建损失是深度损失、强度损失、ray-drop损失、流量损失和精细化损失的加权组合,可以形式化为:

实验

LiDAR4D在KITTI-360和NuScenes上展开实验。

限制

尽管LiDAR4D在大量实验中表现出了非凡的性能,但点云的远距离车辆运动和遮挡问题仍然是悬而未决的问题。与静态对象相比,动态对象的重建仍然存在显著差距。此外,前景和背景可能难以很好地分离。此外,基于真实世界的数据集,NVS的定量评估仅限于自车轨迹,不允许新的空间和时间视图合成的解耦。

结论

本文重新审视了现有激光雷达NVS方法的局限性,并提出了一个新的框架来应对三大挑战,即动态重建、大规模场景表征和逼真合成。我们提出的方法LiDAR4D在大量实验中证明了其优越性,实现了大规模动态点云场景的几何感知和时间一致性重建,并生成了更接近真实分布的新时空视图LiDAR点云。我们相信,未来更多的工作将集中在将激光雷达点云与神经辐射场相结合,探索动态场景重建和合成的更多可能性。