LLM界的「真·Open AI」,又来整顿AI圈了!

业内惊呼:首个开源GPT-4级的模型,终于来了!开源模型追上闭源模型的历史性一刻,或许就在眼前了?

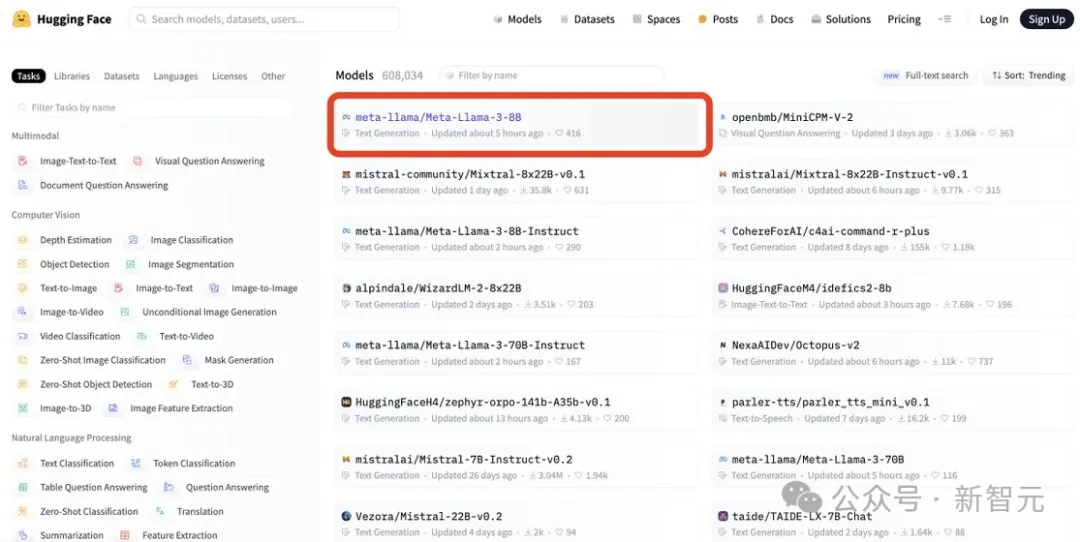

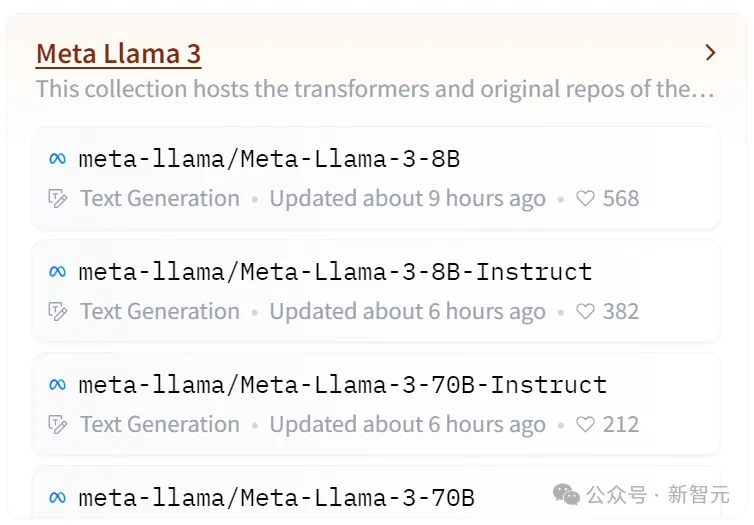

一石激起千层浪,Llama 3才刚刚发布没几小时,就破纪录地登顶了Hugging Face排行榜。

图片

图片

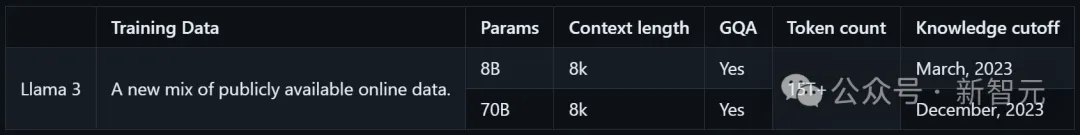

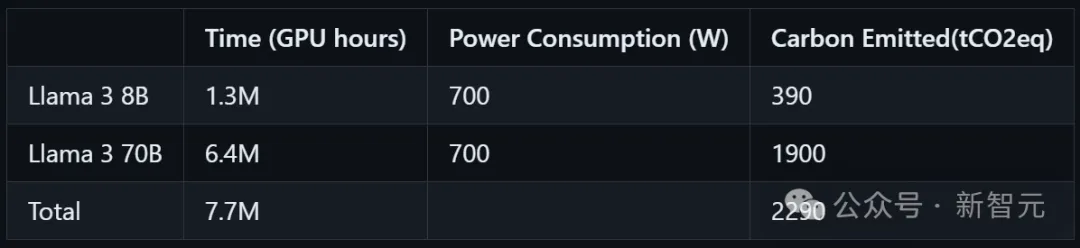

这次,Meta共开源了Llama 3 8B和Llama 3 70B两款模型,分别有预训练和指令微调两个版本。

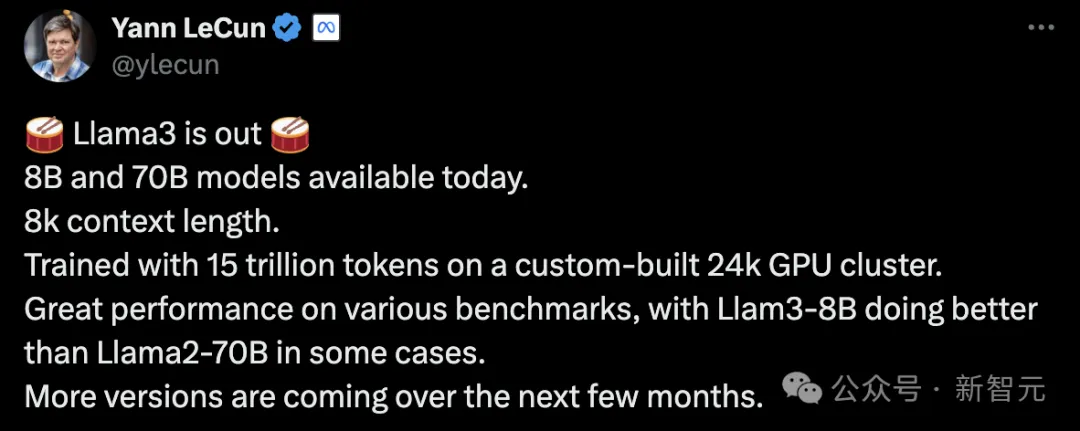

小扎、LeCun也纷纷在第一时间开启了宣传模式:

Llama 3是在由24000块GPU组成的定制集群上,使用15万亿个token训练的。

甚至就连最小8B版本,有时都能打败大出一个数量级的Llama 2 70B!

值得期待的是,在未来几个月,Llama 3还将推出更多版本

值得期待的是,在未来几个月,Llama 3还将推出更多版本

不过,虽然上下文长度相较之前实现了翻倍,但依然只有8K。

图片

图片

顺带提一句,Llama 3已经可以在网页版Meta AI用上了,还是免登录那种。

对此,Hugging Face联创兼CEO表示:「Llama 1和Llama 2现在已经衍生出了30,000个新模型。我迫不及待地想看到Llama 3将会给AI生态带来怎样的冲击了。」

400B性能野兽,刷新开源SOTA

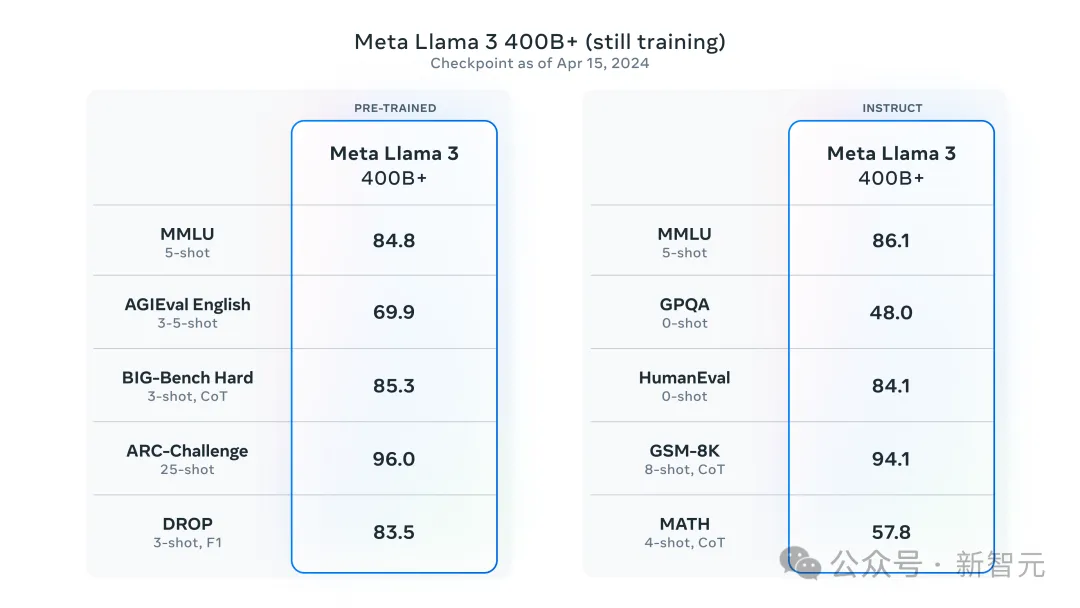

然而,8B和70B版本的Llama 3,还只是开胃菜,更大的还在后面呢!

真正的性能野兽——Llama 3 400B不久便要解禁,目前还在训练中。

图片

图片

其中,预训练版本在推理挑战测试集ARC-Challenge上,拿下了96的高分。

而指令微调版的Llama 3 400B更是在数学(GSM-8K)、代码(Human-Eval)、大规模多任务语言理解基准(MMLU)上,表现非常亮眼。

图片

图片

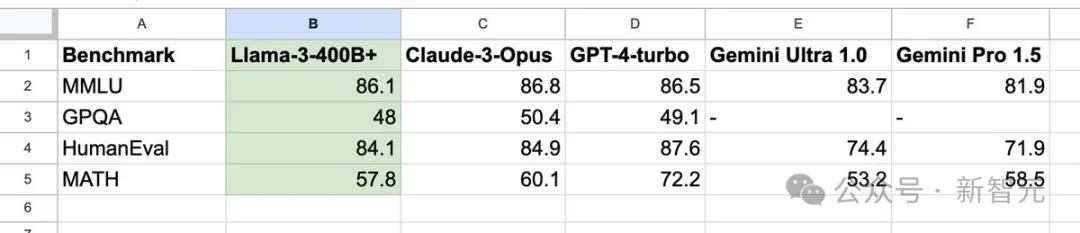

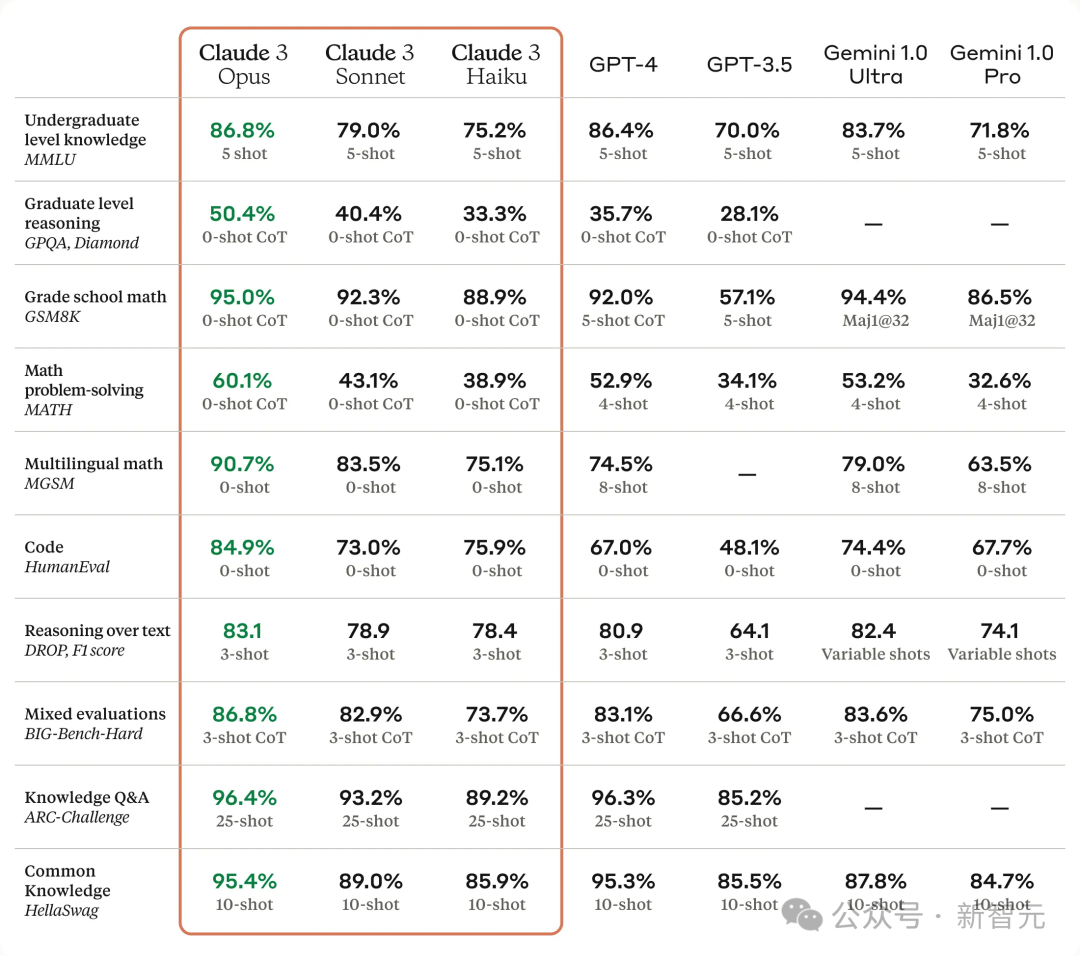

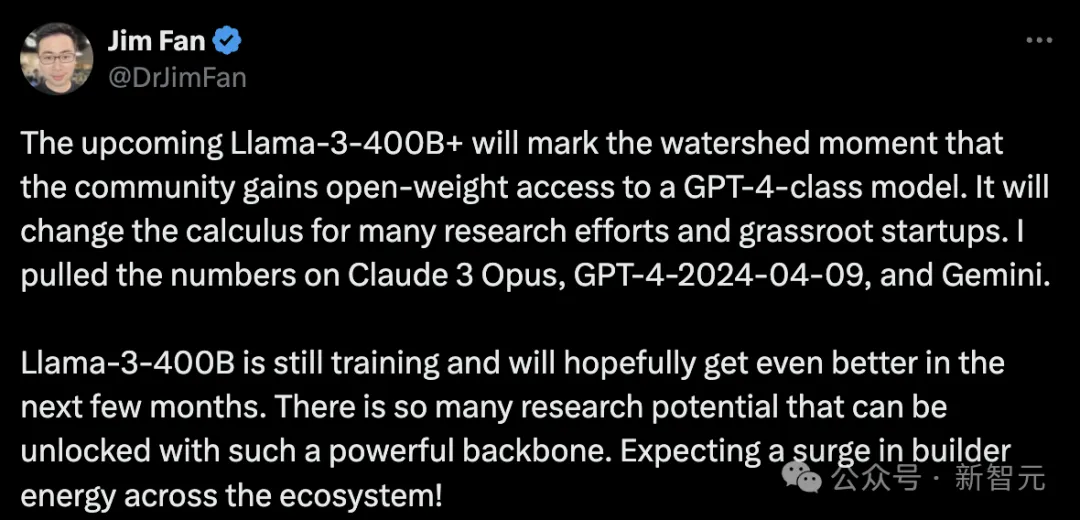

这些数据是什么概念?

英伟达高级科学家Jim Fan做了一个对比图,与Claude 3 Opus、GPT-4-2024-04-09和Gemini在同基准数据中的结果:

看得出,Llama 3 400B已经在多语言推理任务、代码能力,可与GPT-4、Claude 3相匹敌。

更亮眼的是,它在所有能力上,均打败了Gemini Ultra 1.0。

图片

图片

还有一个更详细的数据对比图,自己体会。

图片

图片

一时间,全网陷入了疯狂。

网友:首个「开源GPT-4」来了

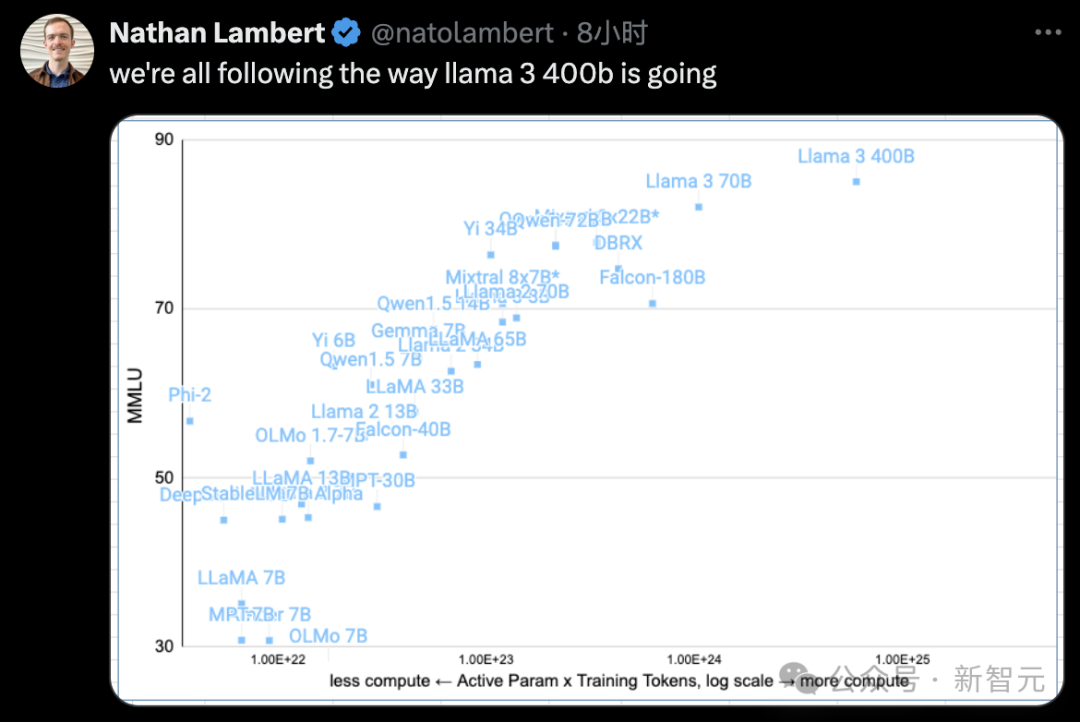

Karpathy精辟地总结道,400B模型将会是「首个开源GPT-4级别的模型」。

图片

图片

图片

图片

Jim Fan感慨道:

即将推出的Llama 3 400B将成为一个分水岭,即社区将获得开源重量级的GPT-4模型。它将改变许多研究工作和草根创业公司的计算方式。

Llama 3 400B还在训练中,希望在接下来的几个月里会有更好的表现。有了如此强大的后盾,我们可以释放出更多的研究潜能。期待整个生态系统的建设能量激增!

图片

图片

OpenAI研究科学家Will Depue也表达的同样的看法,非常期待一款开源GPT-4级别的模型——Llama 3 400B,未来的可能性无穷无尽!

图片

图片

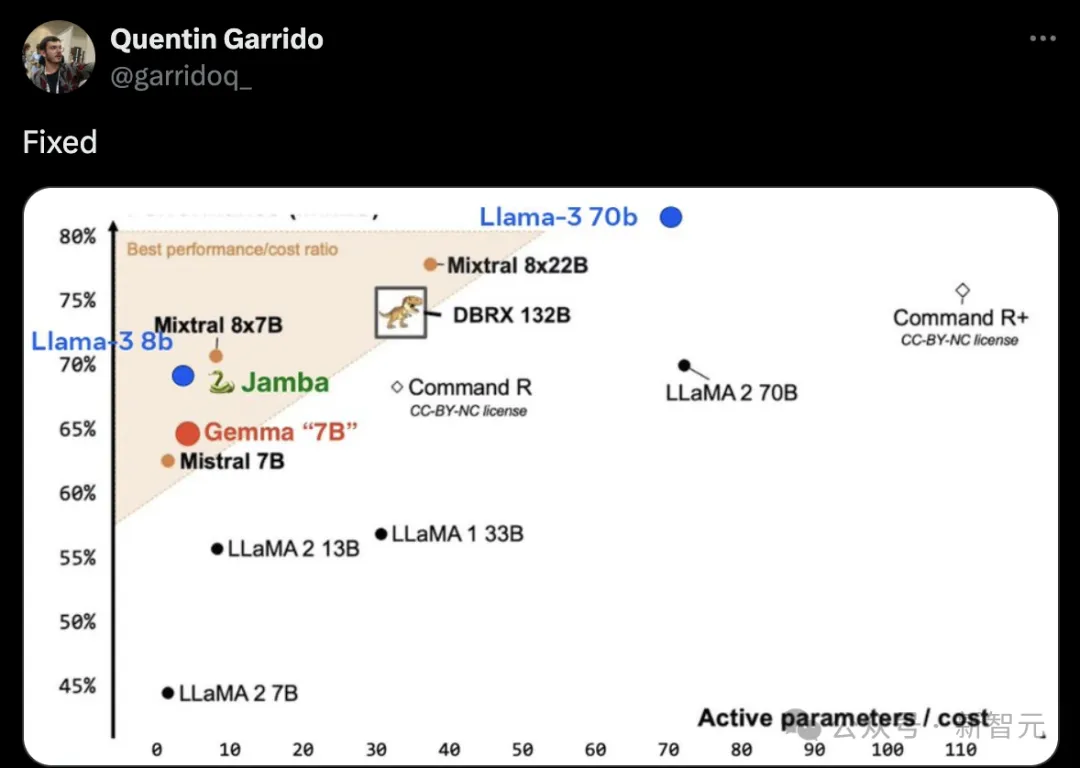

昨天刚刚发布的Mixtral 8×22B刷新SOTA之后,没想到,却被Llama 3 70B碾压了。

图片

图片

开源模型的SOTA,当属于Llama 3 400B。

图片

图片

吴恩达的生日,却收到一份别致的「礼物」。

图片

图片

Meta在博客中预告了,接下来几个月,将发布多个新功能的模型,包括多语言对话、更长上下文,以及整体能力提升。

一旦Llama 3完成训练,技术报告将直接发布。

Meta重回开源模型「铁王座」

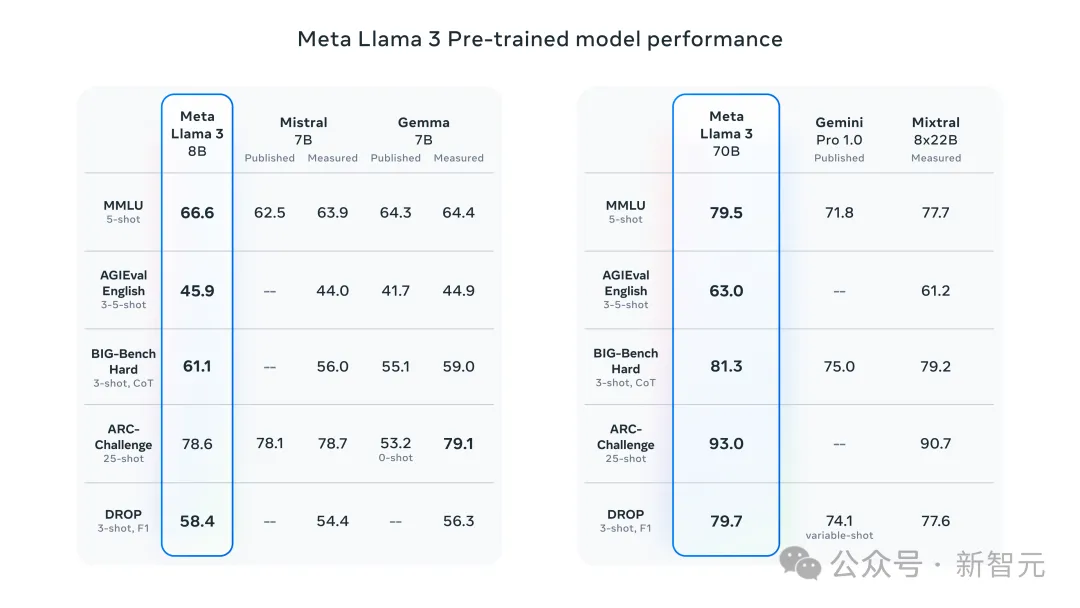

在性能上,8B和70B显著优于Llama 2,取得了SOTA。

预训练模型和指令微调模型在8B和70B的参数规模上取得了如此先进的性能,都是得益于预训练和训练后的优化改进。

图片

图片

而Meta的研究团队,还对训练后优化过程进行了改进,这就大大降低了错误拒绝执行任务的比率,提高了模型输出与人类意图的一致性,还让模型响应的多样性也增加了。

同时,模型的逻辑推理、代码生成和指令遵循等能力也都大幅提升,让Llama 3成为了一个可控性更强的模型。

与近乎同等规模预训练的开源模型相比,Llama 3 8B完全打败了Mistral,以及Gemma。不过推理能力,比Gemma-7B弱一些。

与闭源Gemini Pro 1.0,以及开源Mixtral 8×22B相比,Llama 3-70B在多项基准测试中拔得头筹。

图片

图片

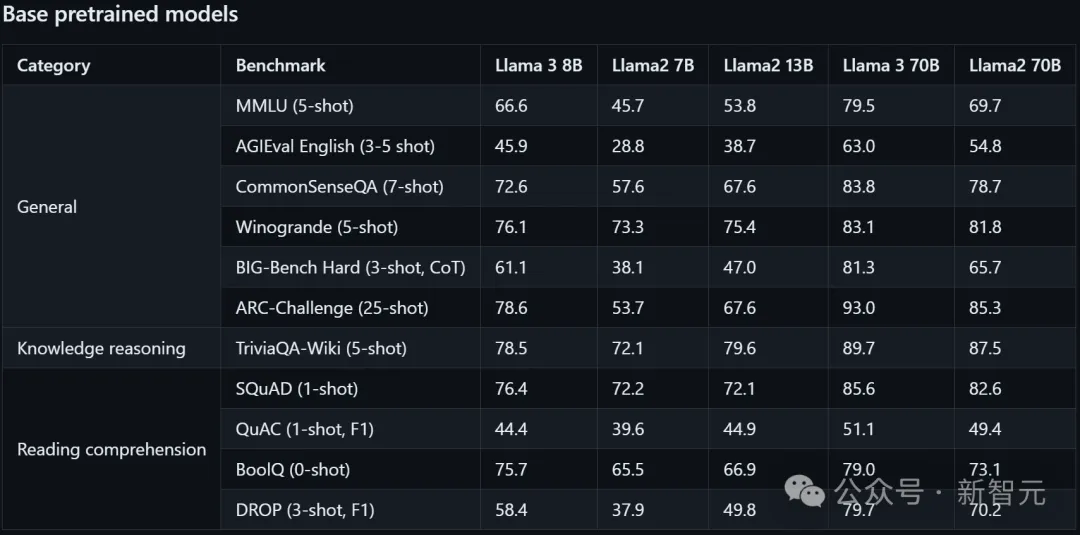

再来看看,Llama 3两个参数版本与Llama 2-7B、13B、70B的预训练模型对比。

毋庸置疑,Llama 3 8B肯定是要超越Llama 2 7B,甚至碾压了Llama 2 13B。

Llama 3 70B要比Llama 2 70B,尤其在推理(MMLU、ARC-Challenge)、AGIEval基准上上,实现了巨大提升。

图片

图片

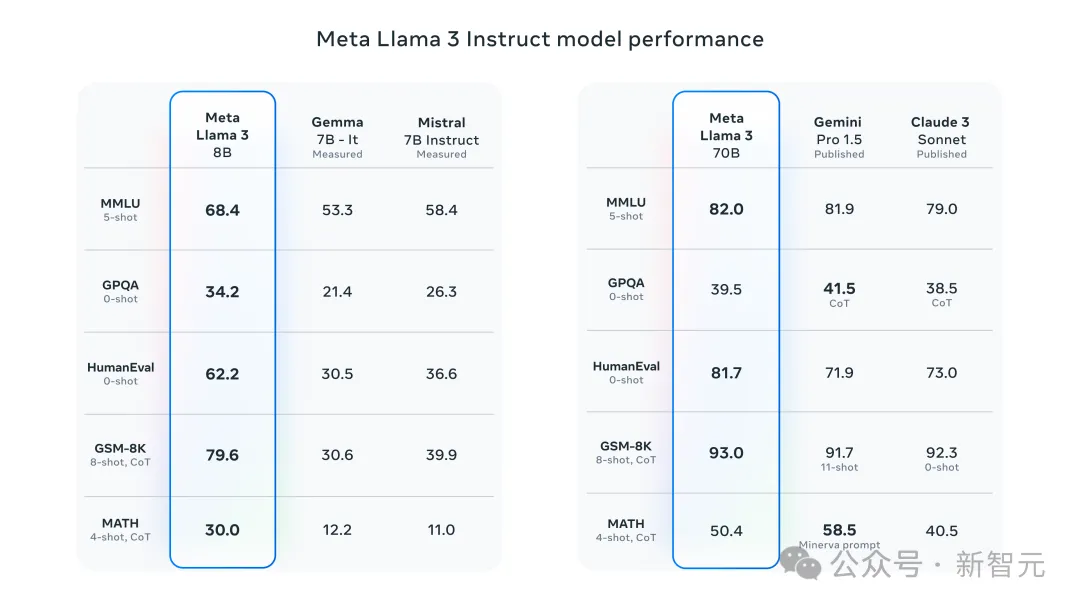

指令微调版本比较,Llama 3 8B同样超越了开源的Gemma 7B,以及Mistral 7B Instuct。

70B版本的Llama 3在推理(MMLU)、数学(GSM-8K)、甚至代码(HumanEval)基准上,比Gemini Pro 1.5和Claude 3 Sonnet更加亮眼。

图片

图片

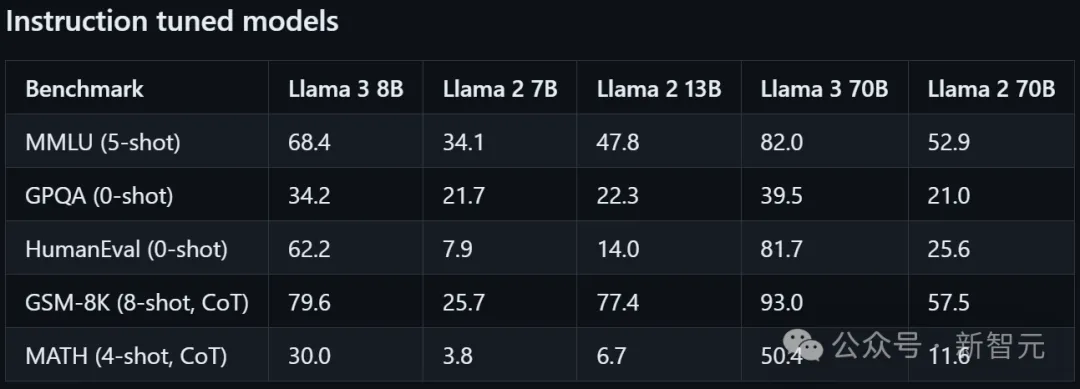

再来看看与自家Llama 2指令微调不同参数版本的性能对比。

Llama 3 8B与70B都要比相对同等参数的Llama 2,得到了很大的提升。

图片

图片

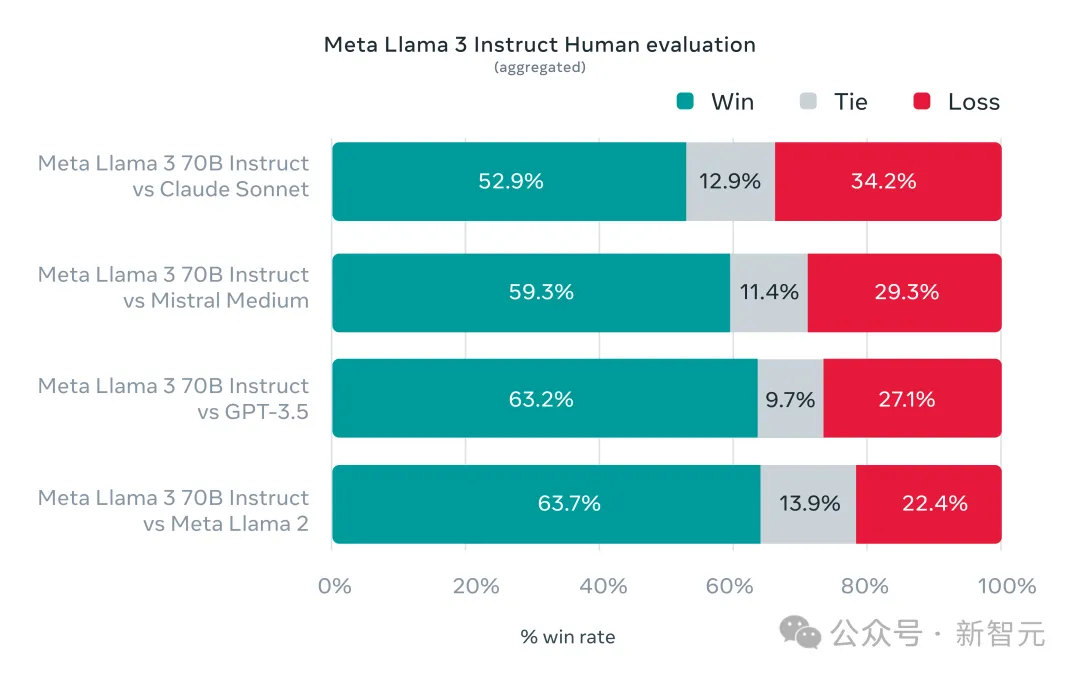

而在Llama 3的开发过程中,Meta不仅关注基准测试,还致力于优化模型在真实场景中的表现。

为此,Meta开发了一个高质量人工评估数据集,包含1,800个提示,这些提示了涵盖了12个关键的应用场景,包括询问建议、头脑风暴、分类、选择题、编码、创意写作、信息提取、角色扮演、开放性问答、逻辑推理、改写和总结。

为了防止Llama 3在评估数据集上过拟合,建模团队自己也无法访问它。

人工评估结果显示,Llama 3 70B的表现远胜于Llama 2、GPT-3.5、Mistral Medium和Claude Sonnet。

图片

图片

大模型发展到如今,再要往哪里创新?

在整个项目中,Meta重点关注了四个关键要素:模型架构、训练数据、扩大训练规模以及指令微调。

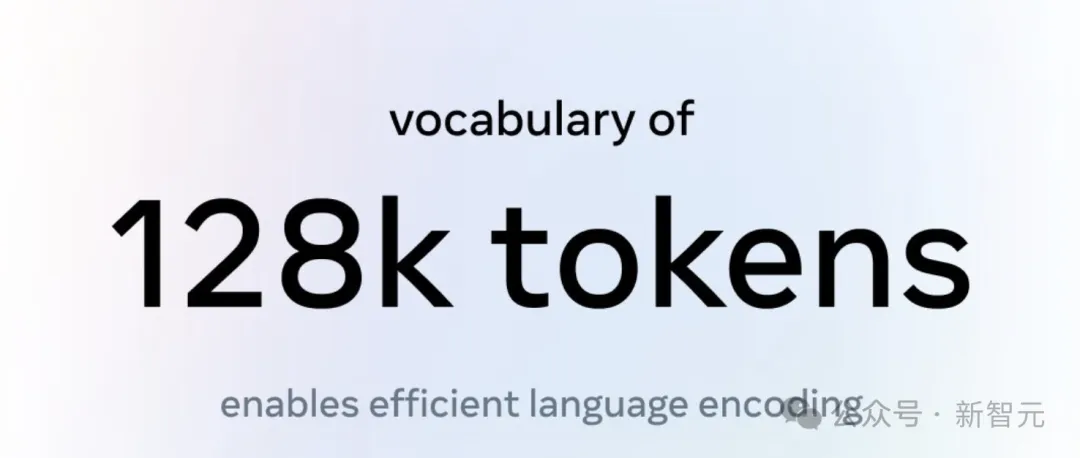

128K token分词器+GQA

在架构上,Meta依然为Llama 3选择了Transformer架构。

这个架构是相对标准的纯解码器Transformer,不过相比于Llama 2做了几个关键改进。

比如,Llama 3使用了一个具有128K个token的分词器,可以更有效地编码语言,这就显著提高了模型性能。

图片

图片

而为了提高Llama 3模型的推理速度,Meta在8B和70B两种规模上都采用了分组查询注意力(Grouped Query Attention,GQA)机制。

此外,Meta还在8,192个token的序列上训练模型,并通过掩码确保自注意力机制不会跨越文档边界。

15万亿token训练,7倍于Llama 2

同时,大型高质量的训练数据集也至关重要。

为了预训练数据,团队投入了大量资源。

最终,Llama 3在超过15万亿个token上进行了预训练,而这些token都是从公开可用的来源收集的。

它的训练数据集比Llama 2的大7倍,并且包含4倍多的代码。

为了应对多语言场景,Llama 3的预训练数据集中有超过5%是高质量的非英语数据,涵盖了30多种语言。

图片

图片

同时,为了让训练数据具有足够高的质量,Meta开发了一系列数据过滤管道。

这些管道包括使用了启发式过滤器、NSFW过滤器、语义去重方法和文本分类器,用来预测数据质量。

在这个过程中一个有意思的点就是——

前几代的Llama 在识别高质量数据方面居然出奇得好,因此,Meta使用Llama 2来生成了用于训练Llama 3的文本质量分类器的训练数据。

此外,为了评估在最终的预训练数据集中混合来自不同来源的数据的最佳方式,Meta还进行了大量实验。

最终,Meta就能够选择一个数据组合,让Llama 3在STEM、编码、历史知识等各种使用场景中,都能表现良好。

图片

图片

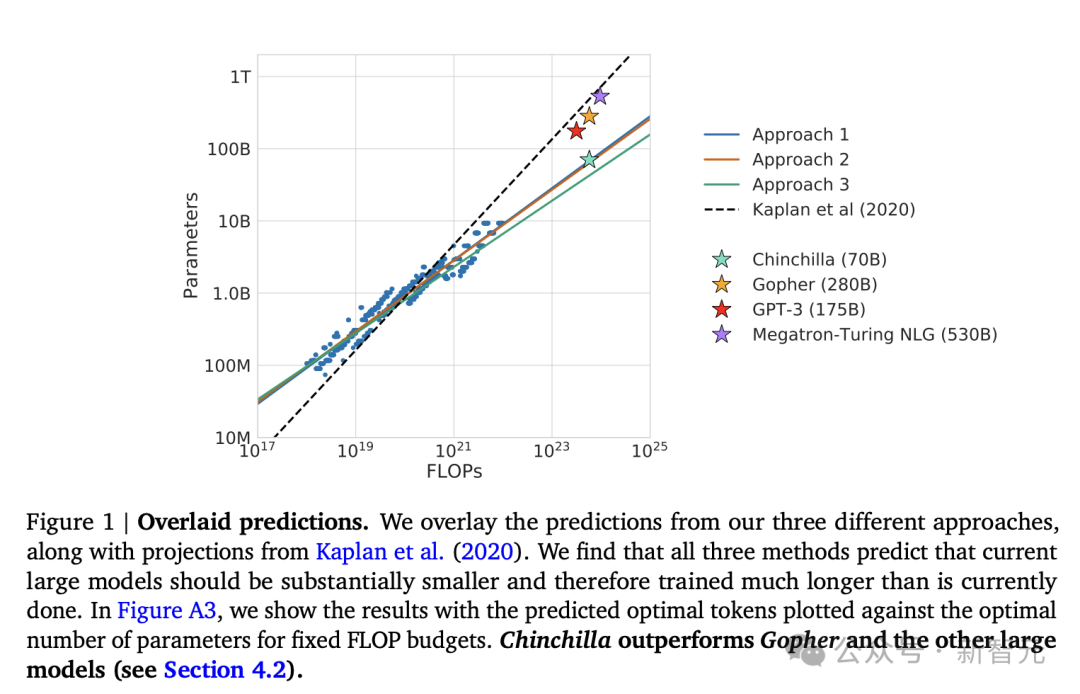

Scaling Law依旧是王道

为了有效利用预训练数据,团队在扩大预训练规模上,投入了大量精力。

针对下游基准评估,Meta开发了一系列详细的缩放定律。这就保证团队能够选择最佳的数据组合,同时最佳地利用训练计算资源。

图片

图片

而缩放定律可以帮助团队在实际训练模型之前,预测最大模型在关键任务上的性能,这是至关重要的,因为这就能确保,模型在各种使用场景和能力方面,都有出色的表现。

在这个过程中,团队对缩放行为观察到了有了几个有趣的新现象。

比如,虽然一个8B参数模型的Chinchilla最优训练计算量,对应于约2000亿个token,但Meta发现,即使在模型接受了两个数量级以上的数据训练后,模型性能仍在继续提高!

图片

图片

而8B和70B参数的Llama 3在接受了高达15T个token的训练后,继续呈对数线性提高。

更大的模型可以用更少的训练计算,来匹配这些较小模型的性能,不过,由于小模型在推理过程中的效率更高,因此反而更受青睐。

为了训练最大的Llama 3模型,团队结合了三种并行化方式:数据并行、模型并行和流水线并行。

由此,团队达到了最高效的实现:在同时使用16K个GPU训练时,每个GPU的计算利用率超过了400 TFLOPS。

团队在两个定制的24K GPU集群上进行了训练。为了最大限度地提高GPU正常运行时间,Meta还开发了一个先进的新训练技术栈,可以自动进行错误检测、处理和维护。

同时,Meta还大大提高了硬件可靠性和静默数据损坏的检测机制,开发了新的可扩展存储系统,减少了检查点和回滚的开销。

而这些改进,让总体的有效训练时间超过了95%。

和与Llama 2相比,这些改进直接让Llama 3的训练效率提高了大概三倍!

图片

图片

创新指令微调

同时,团队也对指令微调进行了创新。

Meta采用的后训练方法,是监督微调(SFT)、拒绝采样、近端策略优化(PPO)和直接策略优化(DPO)的组合。

Meta发现,在SFT中使用的提示和在PPO与DPO中使用的偏好排序,对对齐模型的性能的影响完全超出了预期。

Llama 3在性能上取得的最大改进,就是归功于对这些数据的仔细策划,并且对人类标注者提供的标准进行了多轮质量保证。

图片

图片

而通过PPO和DPO从偏好排序中学习,Llama 3在推理和编码任务上的性能也大大提高了。

如果问Llama 3一个很难回答的推理问题,它有时竟然能产生正确的推理过程。

这个过程中的难点在于,它知道如何得出正确答案,但不知道该如何选择。但通过在偏好排序上进行训练,就能让模型学会如何选择正确答案。

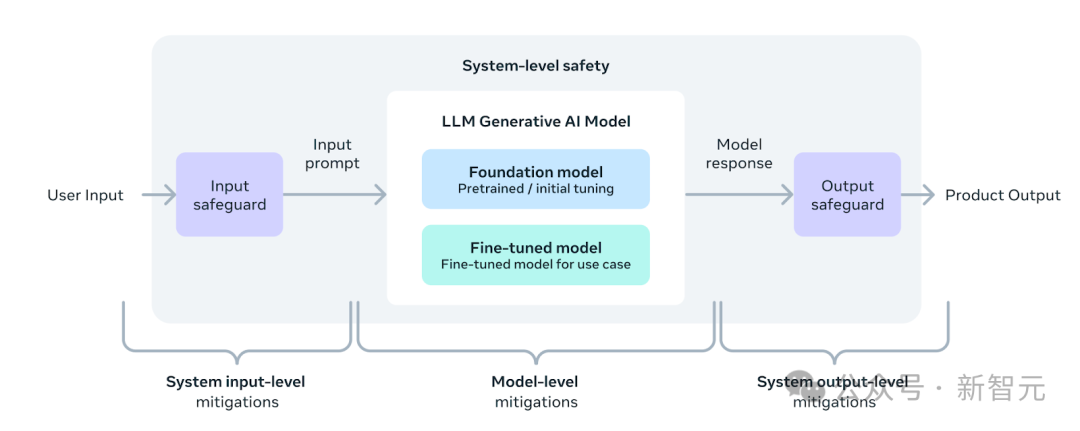

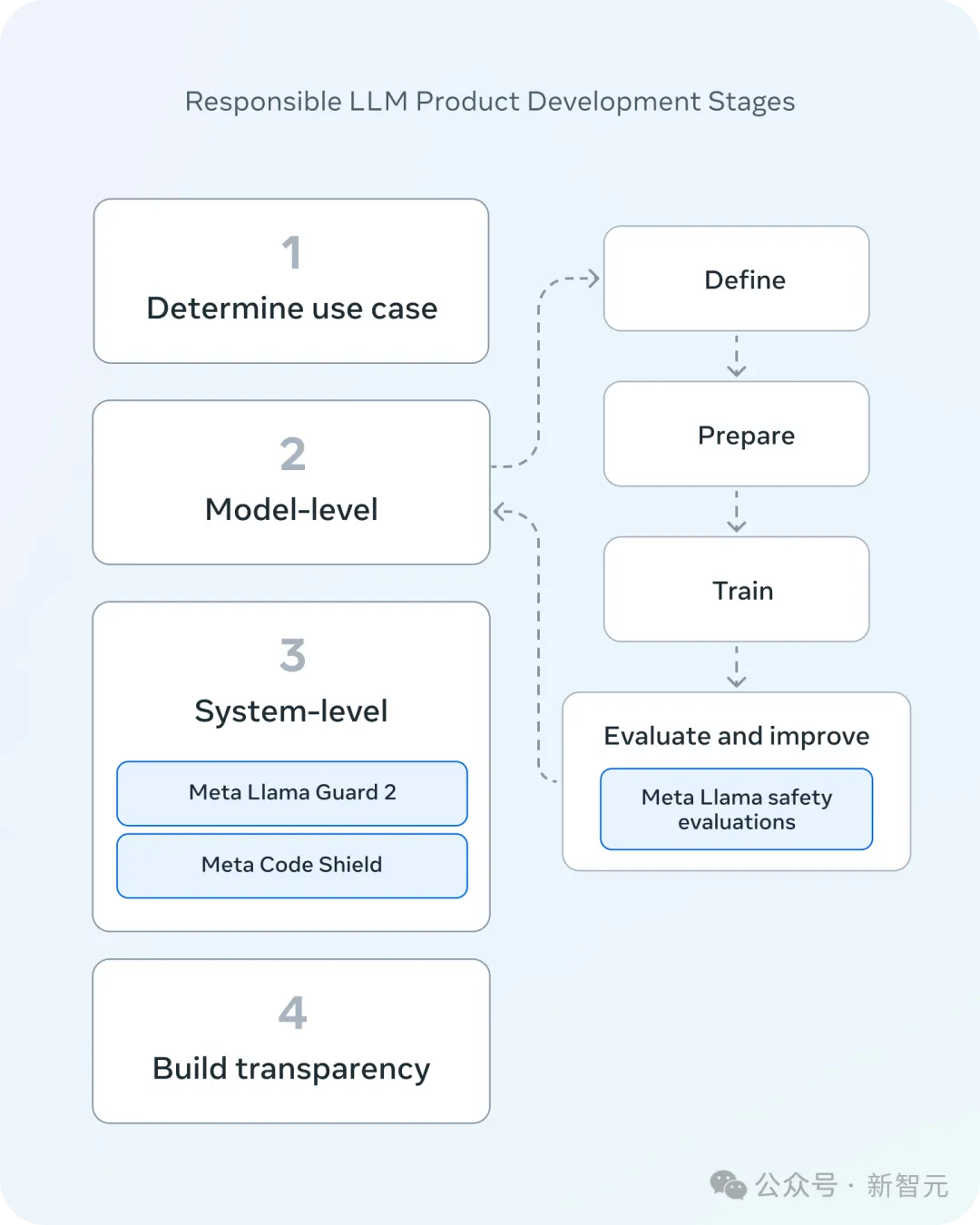

更安全

在部署上,团队采用了一种新的系统级方法。

Meta将Llama模型设想为一个更广泛系统的一部分,让开发者坐在驾驶座上。Llama模型将作为系统的基础部分,开发者在设计时会考虑最终的目标。

图片

图片

在模型安全上,指令微调起了重要作用。

通过内部和外部努力,团队对指令微调模型进行了安全测试。

红队方法会利用人类专家和自动化方法来生成对抗性提示,试图引发有问题的响应,比如化学、生物、网络安全、其他风险领域相关的滥用风险。

在这个过程中,团队让Llama Guard模型,成为安全的基础,并且可以根据应用需求进行微调。

新的Llama Guard 2使用MLCommons 分类法。此外,CyberSecEval 2在其前作的基础上进行了扩展,增加了评估LLM滥用代码解释器的倾向、攻击性网络安全能力和对提示注入攻击的敏感性的措施。

最后,引入的Code Shield也增加了对生成的LLM不安全代码的推理时过滤的支持。这样就能降低不安全的代码建议、代码解释器的滥用等。

另外,Meta还更新了负责任使用指南(RUG),建议根据适合应用的内容指南,检查和过滤所有输入和输出。

此外,云服务提供商也会提供内容审核API等工具,鼓励开发者进行负责任地部署。

图片

图片

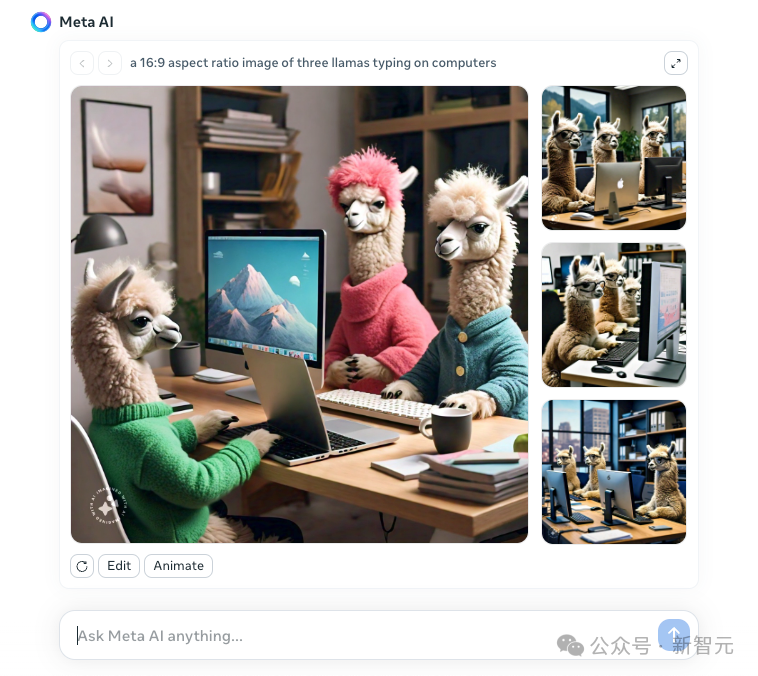

网页版Meta AI免登录,即可聊

与此同时,今天Meta还放出了网页版Meta AI,由最新Llama 3加持,号称是全球顶尖的AI助手之一。

整个页面UI设计非常简洁,不仅可以对话,还支持生图功能。

与ChatGPT-3.5免注册登录类似,与Meta AI聊天功能,进入网页随时随地即可开启,无需登录。

图片

图片

传送门:https://www.meta.ai/

不过,作图的话,是个例外。

图片

图片

其实,Meta AI助手在去年的Connect大会上,小扎首次做了预告。

而现在,全世界更多的人可以通过前所未有的方式与之互动。

不仅仅在网页上能聊,Meta AI还集成到了自家旗下社交应用中,比如Facebook、Ins、WhatsApp和Messenger。

接下来,一起感受下,Meta AI助手带来的与众不同的魅力吧。

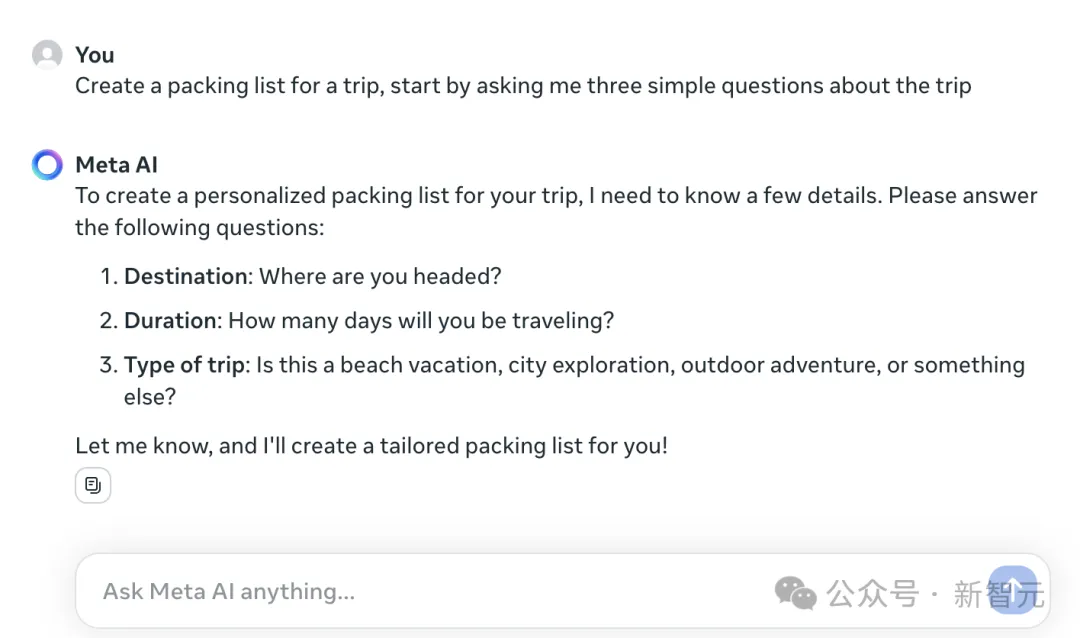

想要组织周末短途旅行,却来不及做出行计划?不用担心!

Meta AI首先会根据要求提出三个关于旅行问题,再去量身定制一份旅行清单!

- 目的地:您要去哪里?

- 持续时间:您将旅行多少天?

- 旅行类型:是海滩度假、城市探险、户外探险还是其他?

图片

图片

又或是你在数学问题上苦苦挣扎?需要让工作邮件显得更专业?Meta AI都可以提供帮助!

甚至,你可以登录以保存自己与Meta AI的对话,以供将来参考。

图片

图片

让Llama 3画一幅自画像。

图片

图片

Ins、Facebook等APP无缝集成

正如前面所说,Meta AI也可以在Facebook、Ins、WhatsApp和Messenger的搜索中使用。

这样的优势在于,可以随时访问来自网络的实时信息,无需在不同应用程序之间切换。

举个栗子,假设你正在Messenger群聊中计划一次滑雪之旅。

直接通过Messenger的搜索,可以让Meta AI查找从纽约到科罗拉多的航班,并找出时间段人最少的周末去旅行——所有这些都无需跳出Messenger即可完成。

图片

图片

当你正在刷Facebook,看到一个感兴趣的帖子,附有一张冰岛北极光图。

你可以直接问Meta AI,「一年中什么时候最适合观赏极光」?

图片

图片

除了在网页版,Meta AI的图像功能还可以在WhatsApp中体验。

当你在搜索框开始输入prompt,便会看到一个浮现的图像,会随着你输入的每几个字而变化。

可以清晰看到,Meta AI如何将你的想象变为现实。

图片

图片

据介绍,Meta AI生成的图像更加清晰、质量更好,而且在图像中融入文字的能力也得到了提升。

不论是专辑封面设计、婚礼指示牌、生日装饰,还是服装搭配灵感,Meta AI都可以生成相应的图像,以前所未有的速度和质量将你的想象变为现实。

它甚至会提供有用的提示和建议,提供改进图像的思路,让你可以在初始点的基础上不断迭代。

这还不是全部......

当你找到一张自己喜欢的图片,可以让Meta AI制作动画,以新的风格对其进行改进,甚至将其转化为GIF,与朋友分享。

图片

图片

可以看出,有了强大的Llama 3加持,Meta AI的表现比以往更要出色。

不久后,Meta AI即将在Quest头显中推出。

图片

图片

参考资料:

https://about.fb.com/news/2024/04/meta-ai-assistant-built-with-llama-3/

https://ai.meta.com/blog/meta-llama-3/

https://llama.meta.com/llama3/