本文经自动驾驶之心公众号授权转载,转载请联系出处。

写在前面&笔者的个人理解

本文研究了具有自由形式语言指令的开放词汇3D实例分割(OV-3DIS)。先前的作品只依赖于注释的基本类别进行训练,对看不见的长尾类别的泛化能力有限。最近的工作通过生成类无关掩码或将广义Mask从2D投影到3D来缓解对新类别的较差可泛化性,但忽略语义或几何信息,导致次优性能。相反,直接从3D点云生成可推广但与语义相关的Mask将产生更好的结果。在本文中,我们介绍了用LanguagE分割任何3D目标(SOLE),这是一种具有语义和几何意识的视觉语言学习框架,通过直接从三维点云生成语义相关的掩码,具有很强的可推广性。具体来说,我们提出了一种多模态融合网络,将多模态语义纳入主干和解码器中。此外,为了使3D分割模型与各种语言指令对齐并提高掩码质量,我们引入了三种类型的多模态关联作为监督。我们的SOLE在ScanNetv2、ScanNet200和Replica基准测试上大大优于以前的方法,尽管训练中没有类别标注,但结果甚至接近于完全监督的方法。此外,大量的定性结果证明了我们的SOLE对语言指令的通用性。

项目主页:https://cvrp-sole.github.io/

总结来说,本文的主要贡献如下:

- 我们为OV-3DIS提出了一个可视化语言学习框架—SOLE。为SOLE设计了一个多模态融合网络,该网络可以利用多模态信息直接预测三维点云中的语义mask,从而产生高质量和可推广segment。

- 我们提出了三种类型的多模态关联,以提高3D分割模型与语言之间的一致性。这些关联提高了掩码质量和对语言指令的响应能力。

- SOLE在ScanNetv2、Scannet200和Replica基准测试上取得了最先进的结果,其结果甚至接近完全监督的同类产品。此外,大量的定性结果表明,SOLE可以回答各种语言问题和指令。

相关工作回顾

闭集三维实例分割。三维实例分割旨在检测、分割和识别三维场景中的目标实例。先前的工作主要考虑闭集设置,其中训练和测试类别相同。这些方法在特征提取和解码过程中各不相同。随着变换器模型的发展,掩模预测成为一种比传统的盒检测解码方法更高效、更有效的方法。Mask3D对场景中固定数量的点进行采样作为查询,然后使用注意力机制直接预测最终的掩码,从而获得更好的结果。然而,无论解码方法如何,封闭集方法都缺乏处理看不见的类别的能力,从而阻碍了它们在现实世界中的应用。

开放式词汇2D分割。由于最近大规模视觉语言模型的成功,在开放词汇或零样本2D分割方面取得了显著的成就。共同的关键思想是利用2D多模态基础模型将图像级嵌入转移到像素级下游任务。LSeg、OpenSeg和OVSeg将像素级或掩码级视觉特征与开放词汇语义分割基础模型中的文本特征对齐。其他作品如X-Decoder、FreeSeg和SEEM提出了更统一的开放式词汇分割框架,包括实例、全景和referring分割。

开放词汇三维场景理解。开放词汇2D分割(OV-2DS)取得的显著成功促使了开放词汇3D分割的几项努力。然而,由于缺乏三维多模态基础模型,OV-2DS中的技术无法直接转移到三维领域。因此,研究人员建议将2D图像和3D点云对齐,从而将2D基础模型提升到3D。对于开放式词汇3D语义分割从2D基础模型中构建任务不可知的逐点特征表示,然后使用这些特征来查询3D场景中的开放式词汇概念。这些工作纯粹专注于将语义信息从2D转移到3D,限制了应用程序级别的识别任务。在这方面,引入了开放词汇3D实例分割(OV-3DIS)来检测和分割3D场景中各种类别的实例。PLA及其变体将训练类别划分为基类和新类,并仅使用基类注释来训练模型。OpenMask3D和OpenIns3D从掩码注释中学习类不可知的3D掩码,然后使用相应的2D图像从基础模型中获得类标签。最近,研究人员还研究了在没有训练的情况下将2D预测从2D实例分割模型直接提升到3D。以往的工作极大地促进了OV-3DIS的改进。然而,由于语义泛化能力差和掩码预测质量低,结果仍远不能令人满意。考虑到先前工作的局限性,我们通过设计一个具有多模态网络和各种多模态关联的视觉语言学习框架,显著改进了OV-3DIS。

方法详解

Objective:具有自由形式语言指令的开放词汇三维实例分割(OV-3DIS)的目标定义如下:给定一个三维点云,对应的二维图像和实例级三维掩码,我们的目标是训练一个没有GT注释的三维实例分割网络。在推理过程中,给定文本提示,经过训练的3D实例分割网络必须检测并分割相应的实例。

掩码预测基线。我们在基于Transformer的3D实例分割模型Mask3D上构建了我们的框架,该模型将实例分割任务视为掩码预测范式。具体来说,带有掩码查询的转换器解码器用于对实例进行分段。给定从场景中选择的Nq个查询,使用交叉注意力将信息从点云聚合到实例查询。在几个解码器层之后,Nq个查询变成具有相应语义预测的Nq个掩码。在训练过程中,采用匈牙利匹配来匹配和训练具有GT和掩码的模型。在推理阶段,将具有正确语义分类结果的Nq掩码作为最终输出。我们的SOLE利用了基于转换器的架构的掩码预测范式,其中模型仅使用掩码进行训练,而没有GT,以实现可推广的OV-3DIS。

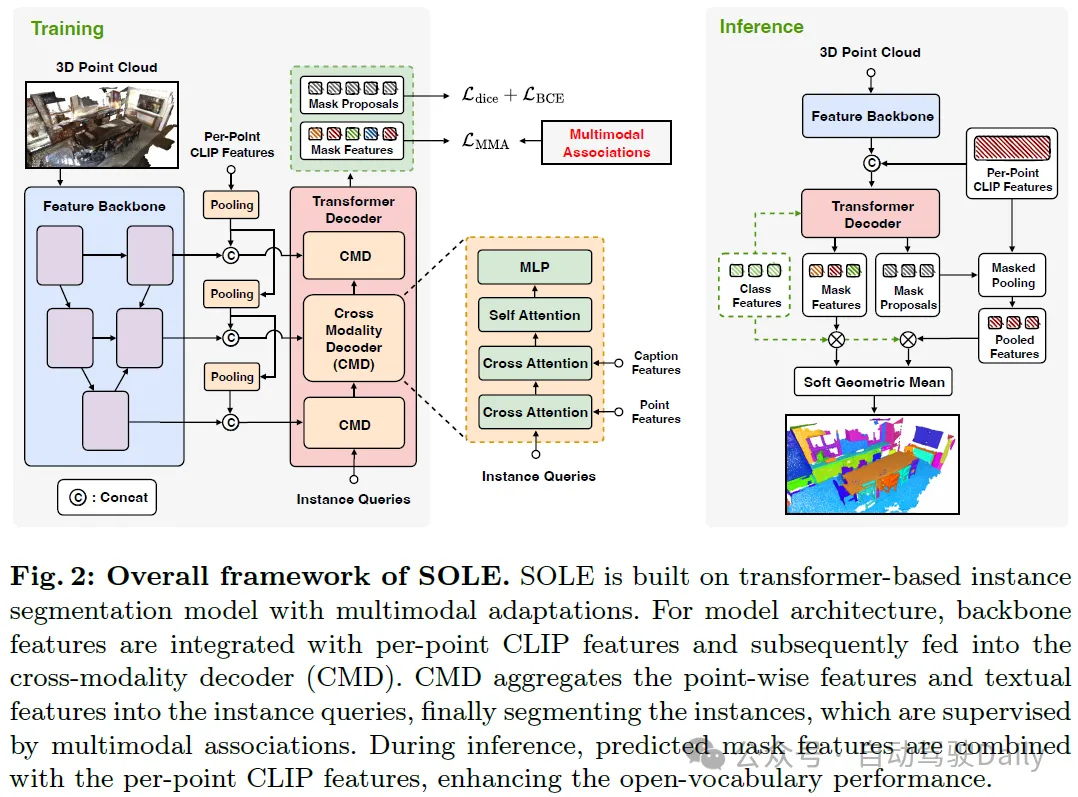

概述:SOLE的总体架构如图2所示。为了使用自由形式的语言指令实现开放式词汇实例分割,我们改进了具有多模态信息的基于转换器的实例分割模型:主干中的逐点CLIP特征和解码器中的文本信息。此外,为了在没有GT类标签的情况下获得更好的泛化能力,我们在目标实例上构建了三种类型的多模态关联:掩码视觉关联、掩码字幕关联和掩码实体关联来训练SOLE。配备了多模态框架和关联,我们的SOLE可以在各种语言提示下有效地分割实例。

Backbone Feature Ensemble

使用预先训练的模型 初始化主干是提高下游任务性能的有效方法,尤其是在下游数据不丰富的情况下。对于3D开放集设置,由于3D数据有限,利用2D基础模型至关重要。因此遵循基于相机位姿将2D图像的预训练视觉特征投影到3D点云。为了保持细粒度和可推广的特性,我们利用OpenSeg作为2D主干。这些特征包含CLIP特征空间中的视觉信息,该空间与文本信息对齐。

由于图像级的对比训练,CLIP特征空间主要关注语义信息,因此单独利用投影的特征无法在实例分割上实现最佳性能。为此,我们训练3D实例分割主干,并将其特征与投影的2D CLIP特征相结合。

从3D主干提取不同分辨率的特征,并分别与2D CLIP特征合并。如图2所示,CLIP特征采用了与3D主干相同的池化策略,使分辨率保持一致。最后,将具有多个分辨率的合并的逐点特征馈送到跨模态解码器中。

Cross Modality Decoder

投影的2D CLIP特征提供了可概括的视觉信息,但语言信息没有明确集成,限制了对语言指令的响应能力。为了避免这个问题,我们引入了跨模态解码器(CMD),将文本信息纳入我们框架的解码过程。具体来说,每个CMD模块包含三个注意力层。实例查询首先从CLIP组合的主干特征中提取视觉信息。然后将CLIP文本特征投影到第二关注层中的关键和值,结合文本领域知识。在训练过程中,CLIP文本特征是从每个目标掩码的字幕特征中获得的,而在推理过程中,它可以是查询实例的描述或其他形式的语言指令,如视觉问题或功能属性。最后,将自注意应用于实例查询,以进一步改进表示。通过将CLIP的多模态知识与多级CMD作为解码器相融合,SOLE可以以高质量的结果响应各种语言指令。

Vision-Language Learning

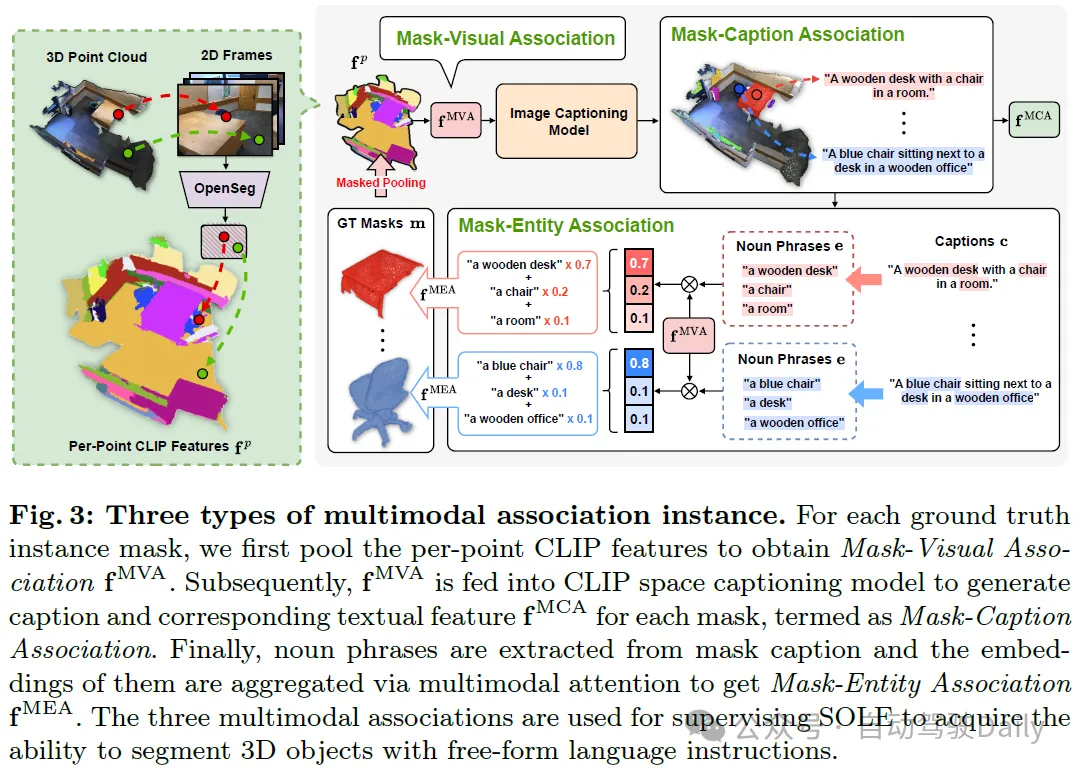

我们进行视觉语言学习,使我们的SOLE能够实现可推广的OV-3DIS。为了有效地响应各种语言指令,我们利用源于目标掩码注释的多模态信息来监督分割网络。具体而言,提出了三种分级粒度的监督类型:1)掩码视觉关联、2)掩码字幕关联和3)掩码实体关联。

- Mask-Visual Association (MVA):利用2D图像和3D点云之间的对应关系,我们可以通过对Nm目标实例掩码内的每点CLIP特征进行平均来获得实例级CLIP视觉特征。实例级CLIP视觉特征可以用作监督,以间接地将3D分割模型与CLIP文本空间对准。此外,作为3D点云和语言之间的中间表示,mask-visual关联也是以下两种细粒度关联的基础。

- Mask-Caption Association (MCA):尽管处于CLIP特征空间,面具视觉联想并不是一种准确的语言监督。相反,用语言指令直接监督模型会产生更好的结果。由于CLIP的强大泛化能力,现有工作中广泛研究了从CLIP空间生成文本。由于掩码视觉关联中的实例级CLIP视觉特征在CLIP视觉空间中,我们可以将它们馈送到CLIP空间字幕生成模型(DeCap)中,以获得掩码字幕。然后将掩码字幕馈送到CLIP文本模型中以提取掩码字幕关联。该关联表示实例掩码的语言信息,在CMD中用于在训练期间融合文本信息。

- Mask-Entity Association (MEA):尽管掩码-标题关联可以为语义和几何结构提供详细的语言描述,但对于特定类别来说,它可能是不明确的。如图3的示例所示。桌子的口罩说明是“房间里有一张带椅子的木制桌子”。这样的说明可能会导致椅子和桌子之间的模型混淆,或者将这两个实例误解为单个实例。因此,引入更细粒度的视觉语言关联以更好地进行语义学习是很重要的。

由于目标通常是标题中的名词,我们可以提取名词的实体级描述,并将其与实例进行匹配。具体来说,如图3所示,我们首先提取每个掩码标题ci的所有名词短语ei,并从CLIP文本编码器T中获得每个名词短语的文本特征,如下所示:

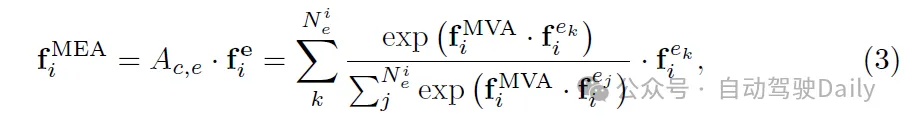

实体可以以硬或软的方式与掩模匹配。直观地说,最相似的实体可以被视为mask标签。然而,这种硬匹配有两个主要问题。首先,生成的字幕和相似性结果可能不准确,导致错误的监督。其次,尽管实体是正确的,但硬匹配忽略了上下文中的几何信息,从而削弱了对语言指令的响应能力。为此,我们提出了一种软匹配方法,通过多模态注意来获得掩码-实体关联。具体地,基于掩模特征和实体特征之间的注意力映射来获得第i个掩模的聚合实体特征:

Training and Inference

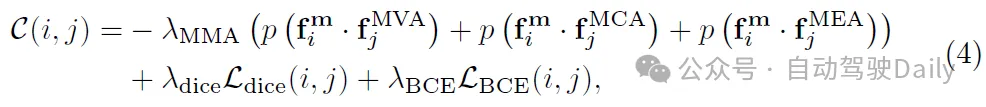

训练这三种类型的多模态关联是学习可推广的3D实例分割模型的有效监督。我们遵循掩码预测范式来训练分割模型,该模型通过匈牙利匹配将GT 实例与预测的掩码匹配。具体而言,第i个预测掩码与第j个GT实例之间的匹配成本计算为:

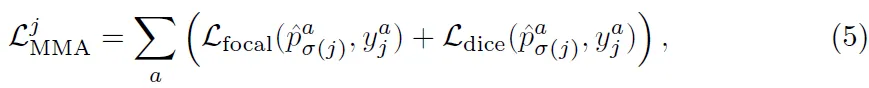

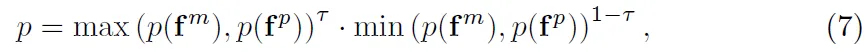

在匹配掩码和GT之后,使用掩码和语义损失的组合来训练模型。具体来说,所有三种类型的关联都用于在语义上监督模型。对于每个关联,我们按照使用focal loss和dice loss的组合,这可以确保独立生成每个类别的分割结果。第j个GT掩码的语义多模态关联损失为:

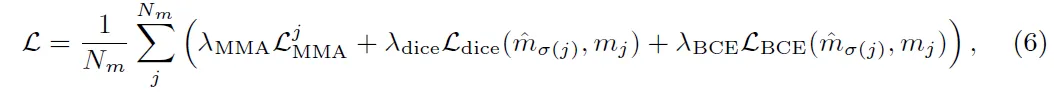

训练损失汇总如下:

推论:在推理过程中,我们将CLIP的视觉特征与预测的掩码特征相结合,以获得更好的泛化能力。具体地,在获得3D掩模之后,在掩模内汇集每点CLIP特征。然后将合并的CLIP特征和掩码特征馈送到分类器中,以获得各自的分类概率,并通过它们之间的软几何平均值得出最终概率:

实验

基准:我们主要将SOLE与OV-3DIS的两个现有工作流进行比较:类划分方法和掩码训练方法。类划分方法将训练类别划分为基本类别和新颖类别。所有遮罩标注和基本类别标签都用于训练模型。与这些方法相比,我们只在掩码注释上训练我们的模型,并在拆分的小说类别上与它们进行比较。掩码训练方法使用掩码注释训练类不可知的掩码生成器,并使用2D基础模型获得语义预测。mask训练方法的设置与我们的相似,我们直接在所有类别上与他们进行比较。

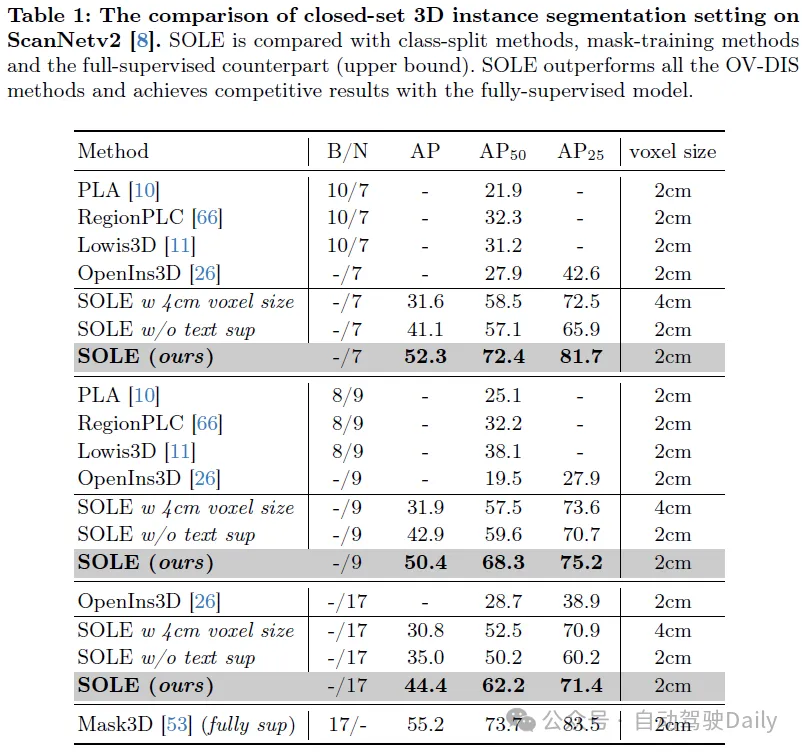

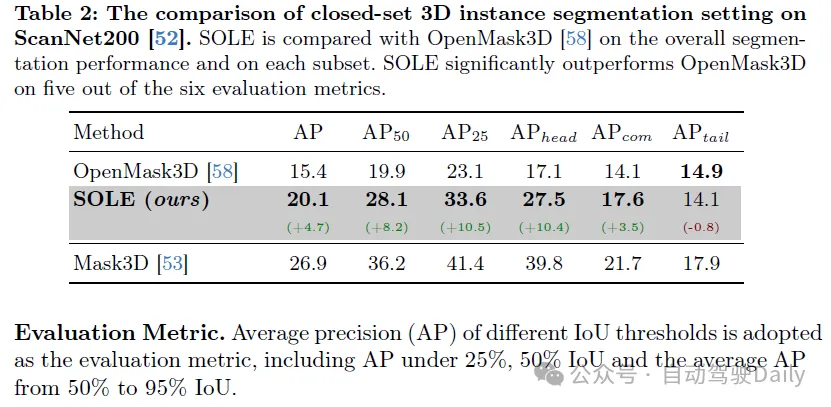

闭集3D实例分割方法比较:相关结果汇总在表1和表2。

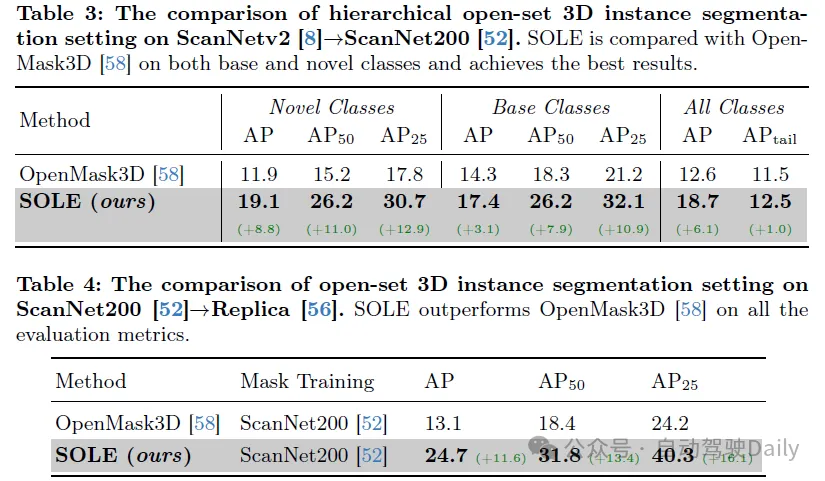

分层跨域开放集3DIS:相关结果汇总在表3和表4。

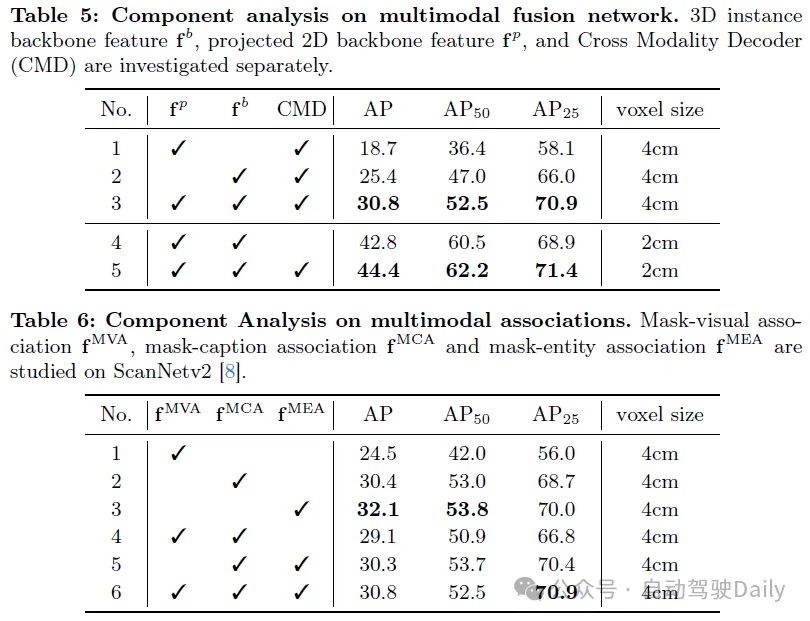

消融实验见表5和表6:

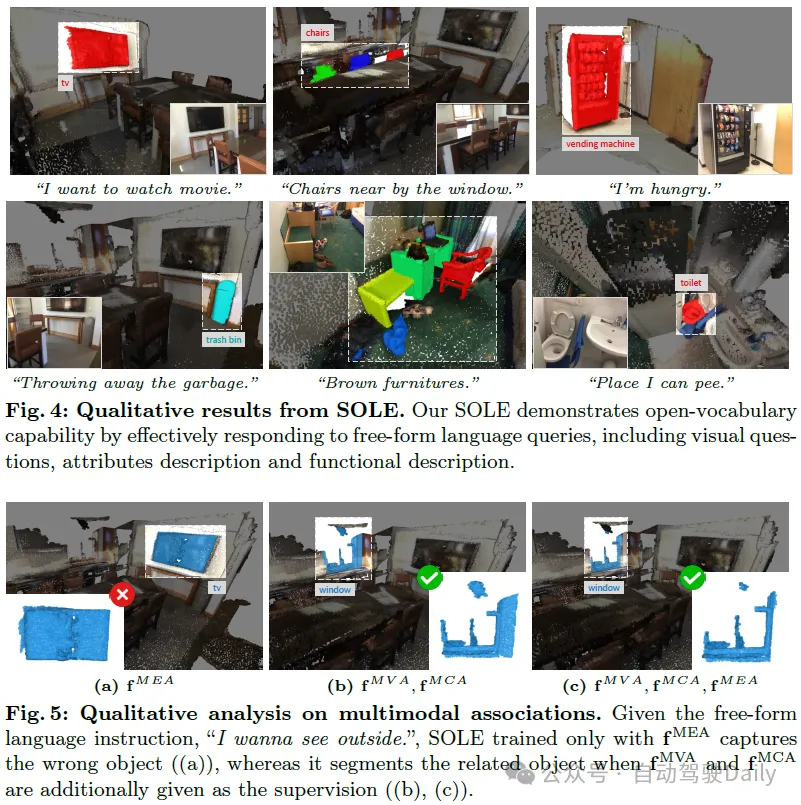

可视化见下图:

结论

本文提出了一种新的框架SOLE,用于自由形式语言指令的开放词汇三维实例分割。SOLE包含一个多模态融合网络,并由三种类型的多模态关联进行监督,旨在使模型与各种自由形式的语言指令保持一致。我们的框架在三个基准上以很大的优势优于以前的方法,同时与完全监督的框架实现了有竞争力的性能。此外,大量的定性结果证明了我们的SOLE对语言指令的通用性。