人类智慧的基础并不在于单个聪明的个体,而在于集体智慧。

比如说,我们的社会和经济体系就是建立在由具有不同专业和专长的不同个人组成的许多机构的基础上的。

Sakana AI团队相信,人工智能的发展也将遵循类似的集体道路。

人工智能的未来不会是一个单一的、巨大的、无所不知的AI系统,需要巨大的能量来训练、运行和维护;

而会是个由许多小型AI系统组成的广泛集合体,每个系统都有自己的专长,并相互连接,新的AI系统被开发来填补特定的专业。

事实上,开源基础模型可以很容易地在数百种不同的方向上进行扩展和微调,以产生在其自身专业中表现出色的新模型。

Open LLM排行榜上表现最佳的模型大多不再是原始的开源基础模型,如LLaMA或Mistral,而是对现有模型进行微调或合并的模型。

同时,计算资源相比于传统的LLM训练来说也要少得多。

目前,Hugging Face拥有50多万个模型,涵盖数十种不同的模态,原则上就可以组合成具有新能力的新模型。

Sakana AI把这个想法转成了现实。他们研究出一种进化模型合并的方法,这是一种使用进化技术来有效地发现不同开源模型的最佳组合方式的通用方法。

图片

图片

论文地址:https://arxiv.org/abs/2403.13187

令人吃惊的是,进化模型合并的方法,能够自动发现从非常不同的领域(如非英语语言和数学,或非英语语言和视觉)中合并不同模型的新方法,这些方法可能对人类专家自己来说都很难发现。

利用进化算法找到最优组合方式

人类的直觉是有限的。随着开放模型和任务的多样性不断增长,一种更系统化的方法才能解锁更有效的合并解决方案,那就是受自然选择启发的进化算法。

以下是一个简单的进化算法的举例,用于自动设计一个行驶距离很远的二维汽车。

起初,会随机产生许多设计,但只有少数可以向前移动的设计会将其成功的特征传递给下一代。

经过多代自然选择,这些遗传汽车可以在环境中高效地前进,穿越具有挑战性的地形。

图片

图片

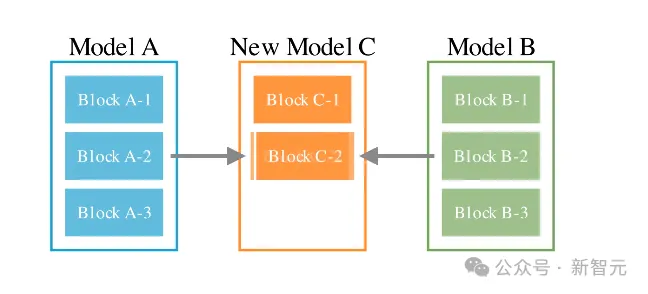

Sakana AI的进化模型合并方法,结合了两种不同的进化方法。

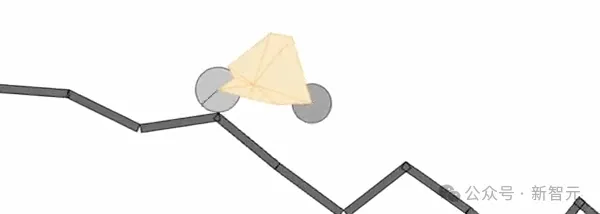

1. 在数据流空间(层)中合并模型

这种方法是利用进化发现如何最优将不同模型的层组合成新模型。

直觉和启发式方法被用于确定如何以及哪些层将一个模型的层与另一个模型的层组合起来。

图片

图片

这个问题具有组合性很强的大量搜索空间,最适合用优化算法(如进化)进行搜索。

2. 在参数空间(权重)中合并模型

第二种方法是演化出新的混合多个模型的权重的方法。

有无穷无尽的方式可以混合来自不同模型的权重,更不用说每一层的混合比例了。这就是进化方法可以应用于有效地找到组合多个模型的权重的新型混合策略的地方。

图片

图片

当这两种方法一起使用的时候,Sakana AI团队发现即使在相对相距较远的两个领域,例如数学和非英语语言,或视觉和非英语语言上,模型也能取得不错的表现。

融合的新模型表现出色

- 大型语言模型(EvoLLM-JP)

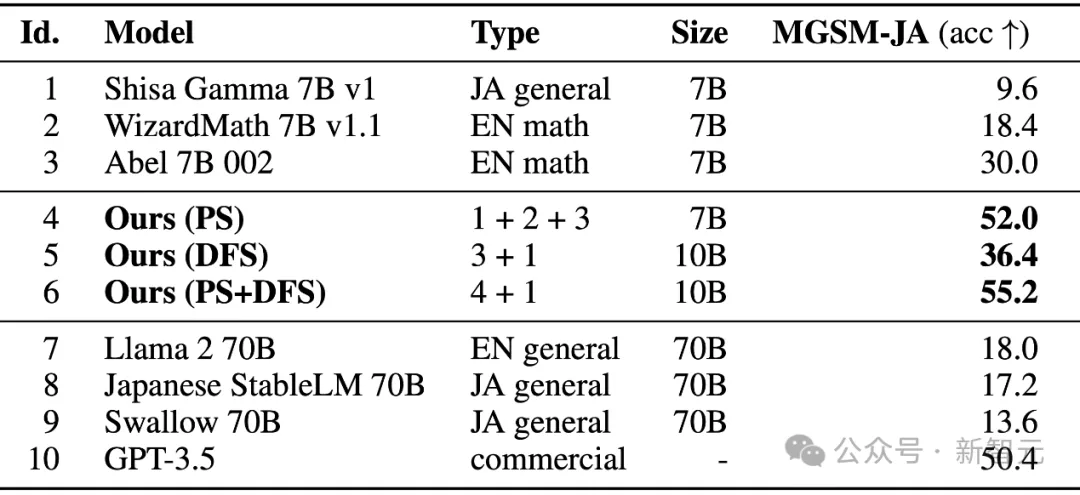

Sakana AI团队用进化模型合并的方法生成的第一个模型,是一个既会日语,又会数学的大语言模型。

为了构建这样的模型,他们使用了一种进化算法,将日语LLM(Shisa-Gamma)与数学专用LLM(WizardMath和Abel)合并。

图片

图片

LLM性能比较,MGSM-JA列显示了正确答案的百分比。模型1-3是原始模型,模型4-6是优化的合并模型。模型7-10是用于比较的现有高性能LLM的分数。

上表报告了演化的LLM模型的结果。模型4在参数空间中进行了优化,模型6进一步在数据流空间中使用模型4进行了优化。

这些模型的正确响应率显著高于三个源模型的正确响应率。

这个模型也可以产生一些有趣的示例,例如能够解答需要特定日本文化知识的数学问题等。

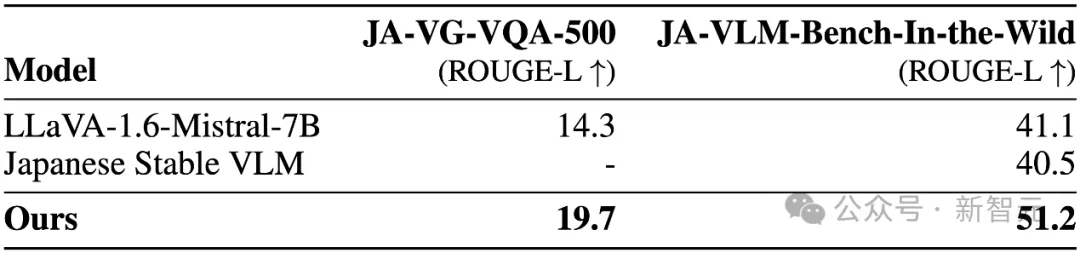

- 视觉语言模型(EvoVLM-JP)

进化算法不仅能够发现将仅处理文本的LLMs合并的新颖方法,还能够演变出为不同目的创建的不同架构的模型。例如日语和视觉结合的大模型。

JA-VG-VQA-500和JA-VLM-Bench-In-the-Wild都是关于图像的问题和答案的基准测试。得分越高,描述的准确性就越高。

有趣的是,合并之后的模型不仅能够比其基础LLaVa-1.6-Mistral-7B的英语VLM实现更高的分数,而且比现有的日语VLM JSVLM得分更高。

图片

图片

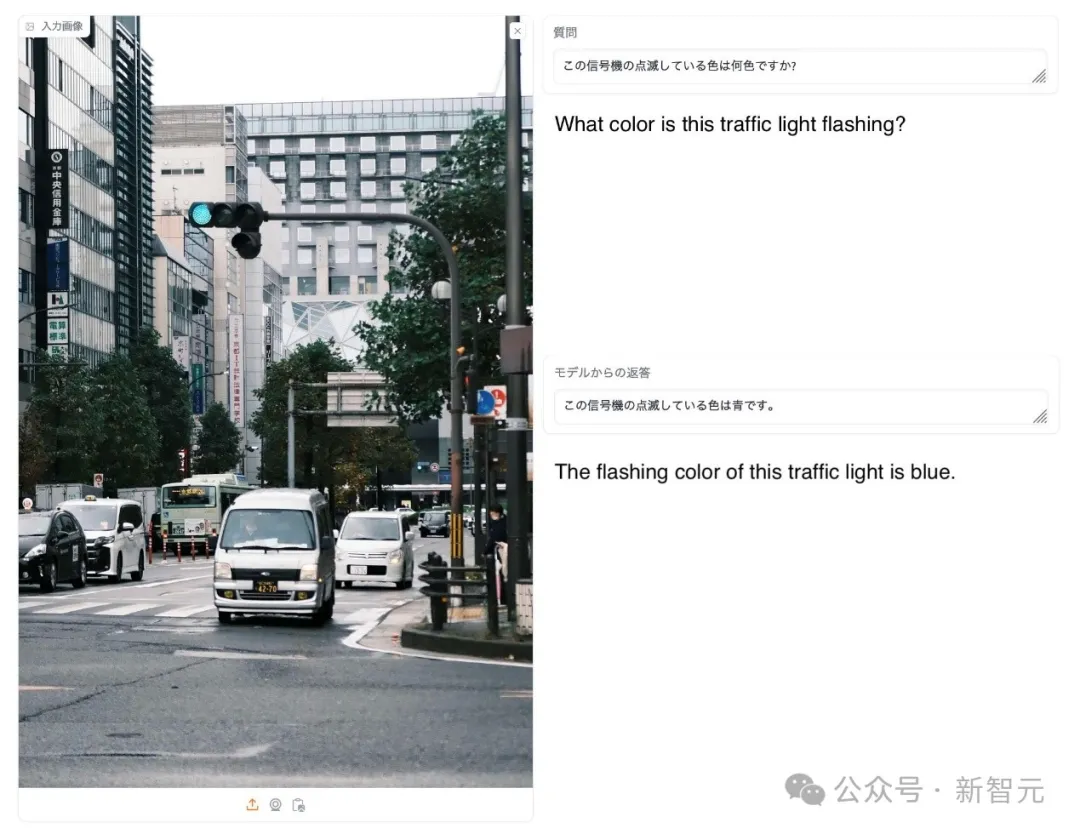

以下是一个的EvoVLM-JP的回答示例。大多数其他模型通常会输出绿色作为答案,但EvoVLM-JP的答案是蓝色。

绿色在技术上并不是错误的,但在日本的习惯中,交通灯的「前进许可」被描述为「蓝灯」。如果你正在学习日语,这是一个日本文化中很有趣的例子。

图片

图片

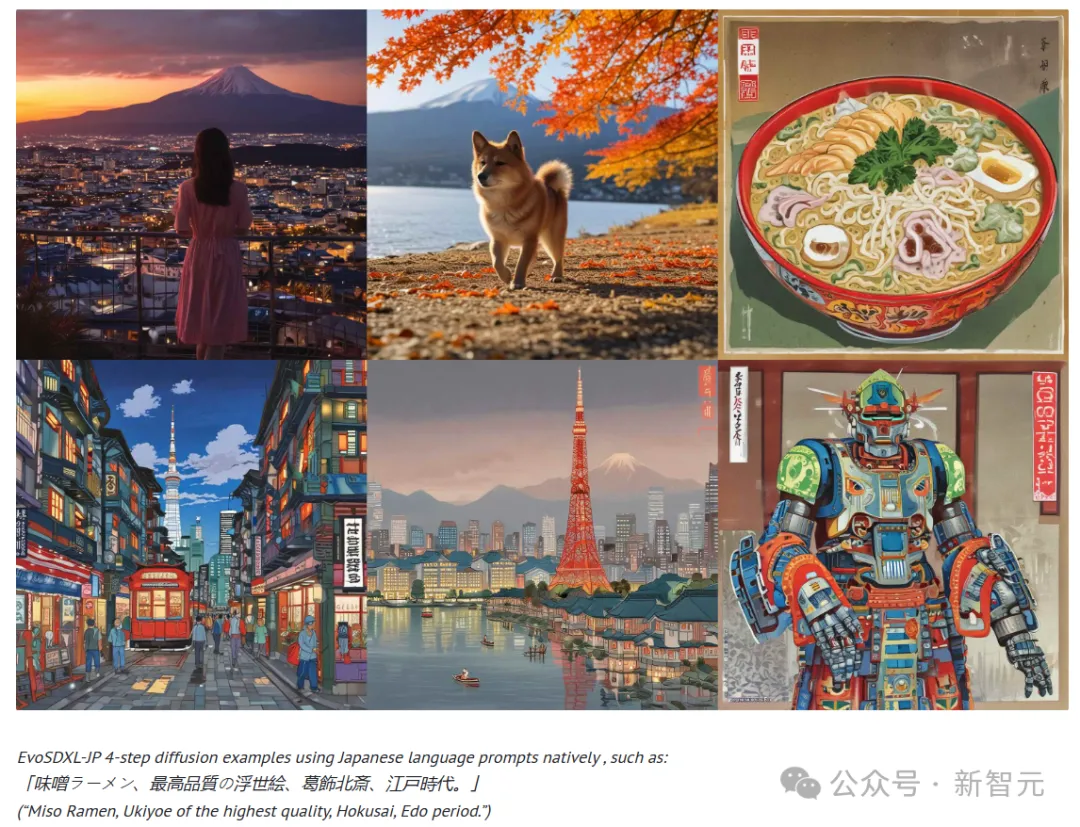

- 图像生成模型(EvoSDXL-JP)

进化算法也可以自动发现合并不同扩散模型的方法,而且生成速度特别快。

比如适用于日语的EvoSDXL-JP用「味噌拉面,最高品质的浮世绘,北斋,江户时代」这四个关键词,就能快速生成如下的图片,是不是很神奇?

图片

图片

预示AI发展新趋势?

在论文的最后,作者表示,现在仅仅呈现的是初步结果,也仅仅是将进化原则应用于基础模型开发的长期发展的开端。

这个项目背后的想法不是要创建更好的模型,而是为了获得更多指标,以帮助制定更有原则性的模型合并方法。

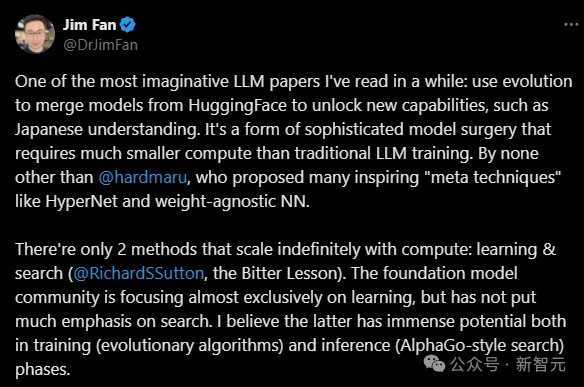

英伟达的高级科学家Jim Fan都评价道,

「基础模型社区几乎完全集中在学习上,但没有把重点放在搜索上。我相信后者在训练(进化算法)和推理(AlphaGo风格的搜索)阶段都有巨大的潜力。」

图片

图片

除了模型选择,Sakana AI团队还在探索使用进化来产生一群具有各自独特领域和行为的多样基础模型。

那这是不是预示着,能自我改进的模型集体智能也不远了?

参考资料:

https://twitter.com/DrJimFan/status/1771927650883522899