在探索人工智能边界时,我们时常惊叹于人类孩童的学习能力 —— 可以轻易地将他人的动作映射到自己的视角,进而模仿并创新。当我们追求更高阶的人工智能的时候,无非是希望赋予机器这种与生俱来的天赋。

由上海人工智能实验室,南京大学,中科院深圳先进技术研究院牵头,联合东京大学,复旦大学,浙江大学,中国科学技术大学等高校的学生和研究者,共同公布了跨视角技能学习数据集EgoExoLearn,为机器人赋予了通过观察他人学习新动作的能力。

- 论文链接:https://arxiv.org/abs/2403.16182

- 代码与数据集链接:https://github.com/OpenGVLab/EgoExoLearn

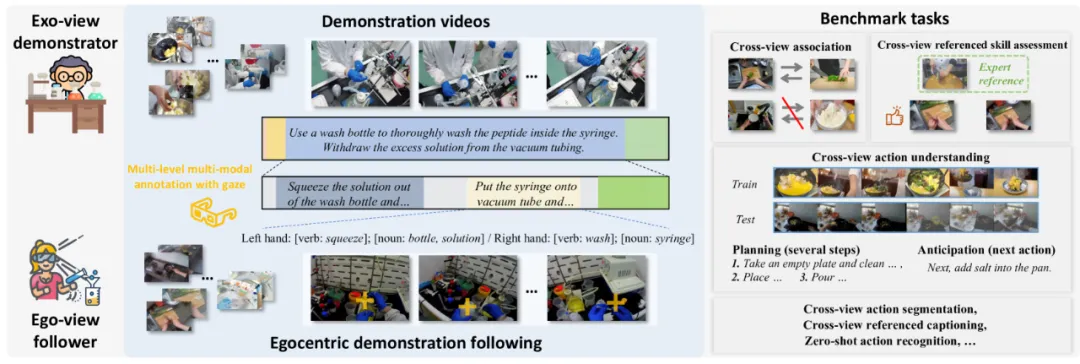

EgoExoLearn 数据集独辟蹊径,采集了第一视角与第三视角的视频素材。第一视角视频捕捉了人们学习第三视角演示动作的全过程,这种视角的转换与融合,为机器模拟人类学习模式提供了宝贵的数据资源。

数据集的构建不仅涵盖了日常生活的琐碎场景,更延伸到了专业实验室的复杂操作。EgoExoLearn 精心收录了总计 120 小时的视角与示范视频,旨在让机器在多种环境下都能有效学习。

除视频外,研究者还记录了高质量的注视数据,并辅以详尽的多模态标注。这些数据与标注的结合,构建了一个全面模拟人类学习过程的平台,有助于解决机器在不同视角下对异步动作过程的建模难题。

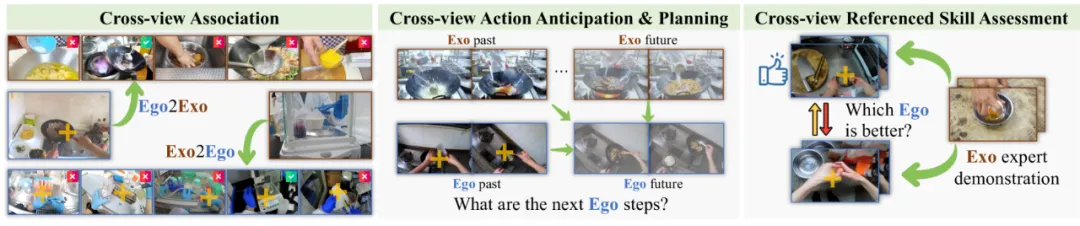

为了全面评估 EgoExoLearn 数据集的价值,研究者提出了一系列基准测试,如跨视角关联、跨视角行动规划及跨视角参考技能评估等,并进行了深入的分析。展望未来,EgoExoLearn 将成为跨视角行动桥接的重要基石,为机器人无缝学习真实世界中的人类行为提供坚实支撑。

期待 EgoExoLearn 数据集能助力 AI 技术的进一步突破,推动机器人从单纯的模仿走向真正的智能,实现与人类社会的和谐共存与共同发展。

研究背景

从孩童时期开始,人类就具备观察他人行为并将其映射到自己视角的能力,这种能力在进行高试错成本的实际操作(如危险化学实验)时尤为有益。随着人工智能系统的最新进展,下一代 AI 智能体将会在更通用的场景中执行任务。

然而,与人类不同,训练这些 AI 智能体通常需要在类似环境中拍摄的演示视频作为训练数据,这些视频的视角还必须与 AI 智能体一致(例如,第一视角)。尽管有很多工作尝试了在不同场景中收集此类数据,对于 AI 智能体来说,直接从不同地点和不同视角拍摄的演示视频中学习仍然至关重要。实现这一能力可以充分利用大规模公开教学视频数据的潜力,并且在人机合作场景中尤其是在新环境中有巨大作用。

目前朝这个目标努力的工作大致可以分为两个方向。一种是在模拟环境中学习模型,但这些模型在现实世界中的泛化仍然很困难。另一个方向是从现实世界中的人类活动中学习。然而,直接结合现有的多视角数据集的尝试通常会产生质量或规模较差的数据集。同时,目前这个方向的少数现有数据集只记录了在同一环境和时间同步方式下拍摄的自我中心和外部中心视角视频。在现实中,跟随演示时,通常需要桥接在不同地点和不同时间执行的一系列程序性动作。目前还没有可用于探索如何在现实的自我中心和外部中心视角中桥接异步程序性活动的数据集。

为了解决数据集缺乏问题,研究者提出了 EgoExoLearn,这是一个大规模数据集,包含演示视频和相应的第一视角跟做视频。其中摄像机佩戴者跟随演示视频中的动作,并在不同环境中执行相同任务。针对日常生活辅助和专业技能辅助这两个潜在应用,EgoExoLearn 包含了 747 个视频序列,总时长达 120 小时,涵盖场景包括日常食物制作和专业实验室实验。值得注意的是,EgoExoLearn 中的第一视角视频包含了显示人类执行任务时视觉注意力的眼动信号。这为更好地连接第一视角和第三视角中的行动提供了宝贵的线索。

更进一步,研究者分析了人类的跨视角理解能力,并相应地引入了新的任务和基准,希望这些可以对开发具有类似能力的下一代具身 AI 智能体起到重要帮助。当人类执行一个动作时,他 / 她可以将自我中心视角中正在进行的动作与演示中相应的动作联系起来并进行描述。通过演示视频中的知识,人类可以知道所需的动作步骤,并预测下一步应该是什么。此外,通过与演示的比较,人类还可以评估自己的技能水平。

基于上述分析,研究者设计了以下新任务:1) 跨视角关联,2) 跨视角动作理解,3) 跨视角参考技能评估,以及 4) 跨视角参考视频字幕。每个基准都经过精心定义、标注,并具体实现了相应模型。此外,研究者还首次探索了眼动在这些任务中的作用。研究者希望这个数据集能够为未来链接不同视角中的异步程序性动作的工作提供资源,从而激发设计擅长从现实世界人类演示中学习并将程序性动作映射到机器人中心视角的 AI 智能体。

数据集介绍

场景和任务

研究者考虑了程序性的目标导向任务,这些任务涵盖了从日常的食物制作到专业的实验室实验。这种选择基于它们所体现的两个未来体现性 AI 代理需要能够桥接自我 - 外部活动的潜在领域:日常生活辅助和专业支持。

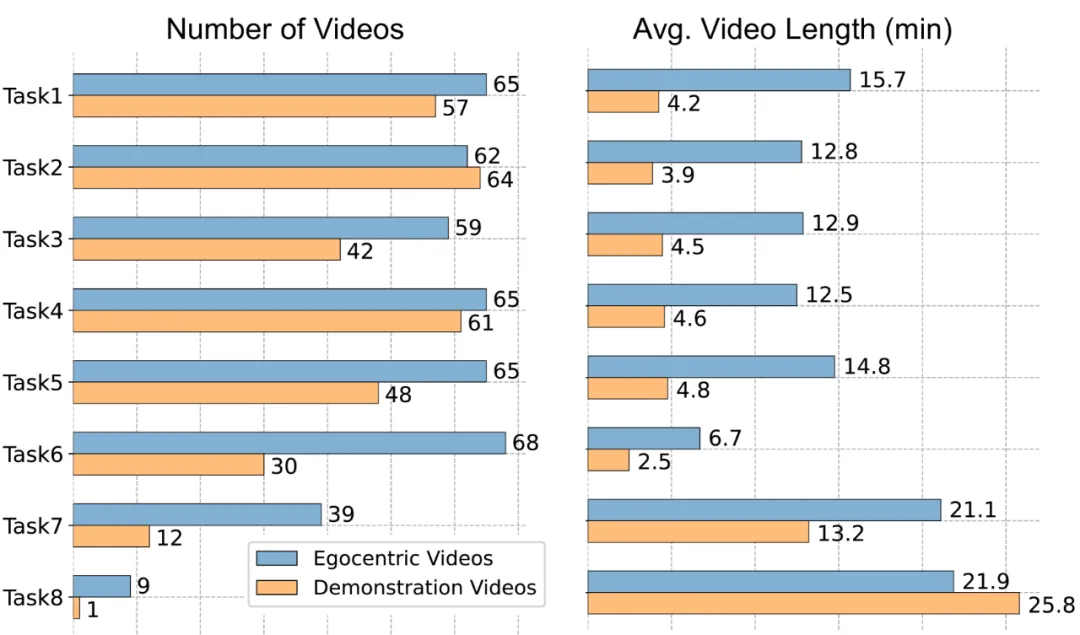

具体来说,EgoExoLearn 包含了 5 种日常任务(例如烹饪)和 3 种专业实验室任务(例如固相肽合成)。研究者在 4 个不同的厨房和 3 个不同的实验室中录制了自我中心视角的视频。下表显示了每个任务的视频数量以及平均视频长度。

数据收集流程

在每次收集开始之前,参与者需要完成一份问卷,收集基本的人口统计信息以及他们自我评估的执行指定任务的专长。然后在每次录制中,参与者将被要求从提供的列表中选择一个或几个外部中心视角的演示视频,并仔细学习详细的程序。一旦准备好了,他们将戴上 Pupil Invisible Glasses,完成眼动校准,并开始复制演示视频中执行的任务。虽然不鼓励,但参与者在录制过程中被允许重新观看演示视频。在每次录制之后,参与者被要求重新进行眼动校准,以确保眼动数据的准确性。对于 5 个日常任务,外部中心演示视频是手动从 YouTube 等在线视频平台策划的。对于实验室实验,外部中心演示视频是由资深实验室成员录制的教程。

数据集标注与统计

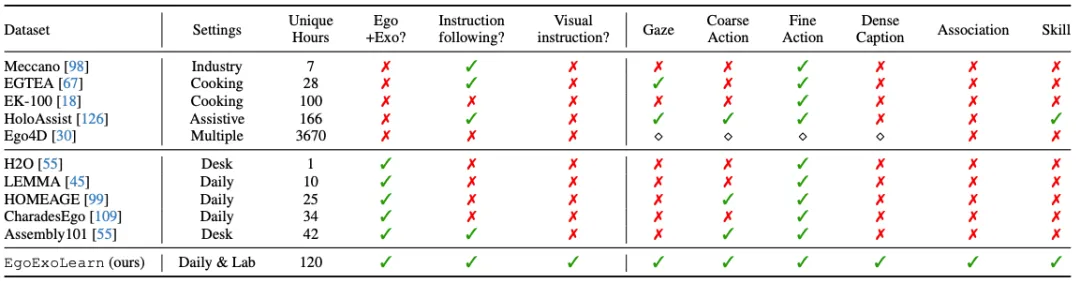

为了促进本文数据集在开发能够有效弥合自我和外部视角之间差距的算法方面,研究者提供了详细的多模态人类标注。粗略级别的语言标注、细致级别的语言标注、翻译与解析、技能水平标注。据了解,目前还没有与本文设置相同、可以直接比较的数据集。因此,研究者在下表中列举了本文数据集的各个方面,并与相关数据集进行了比较分析。EgoExoLearn 以其「视觉演示跟随」设置独特地丰富了该领域。除了这一独特设置之外,它还是第一个包括时间限定的语言字幕、标注的跨视角关联和多标签视频片段的自我中心数据集。同其他第一视角视频数据集的对比如下:

新基准 Benchmarks

为了评估连接异步的第一视角 - 第三视角程序性动作的能力,研究者引入了 4 个新的基准 benchmark,如下图所示:

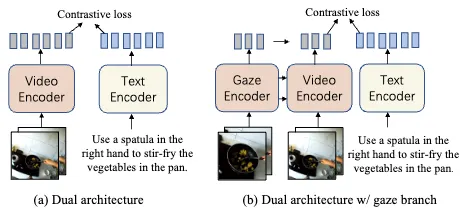

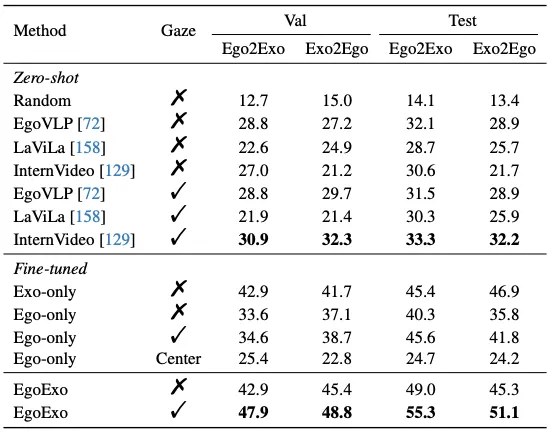

1) 跨视角关联 (cross-view association),探究模型有没有将不同视角的相同动作联系起来的能力,分为 Ego2Exo 和 Exo2Ego 两个设定。在(ego2exo)的情况下,给定一个自我中心视频,模型需要从一组候选的外部中心样本中预测出执行相同动作的相应外部中心视频。这里考验了模型对单一视角动作的理解能力,还考验了模型在跨视角情境下的泛化能力和预测准确性。基线模型与结果如下:

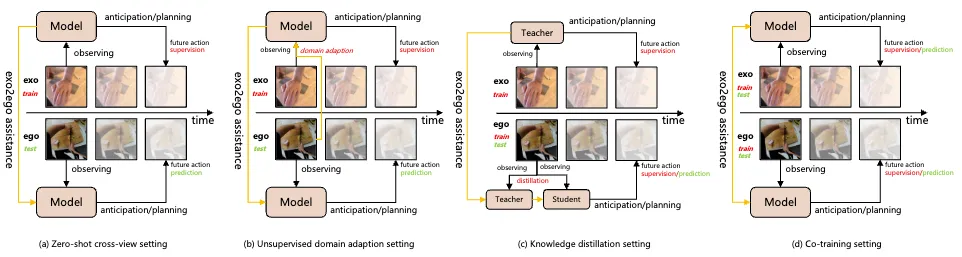

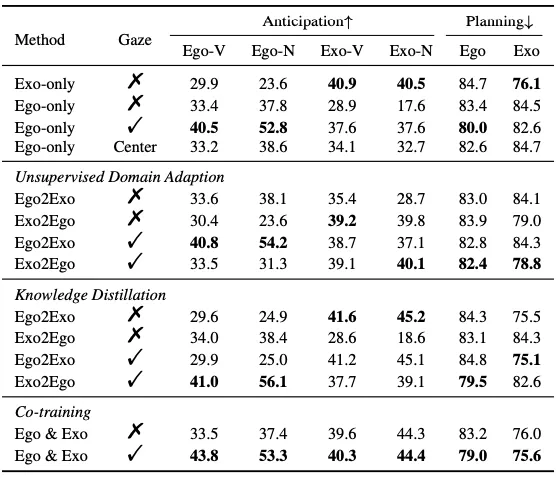

2) 跨视角动作理解 (cross-view action understanding),细分为三个子任务:跨视角动作预测、跨视角动作规划和跨视角动作分割。此外,研究者还探索了注视点(gaze)在协助这些任务中的作用。下图是四种训练设定与基线模型性能:

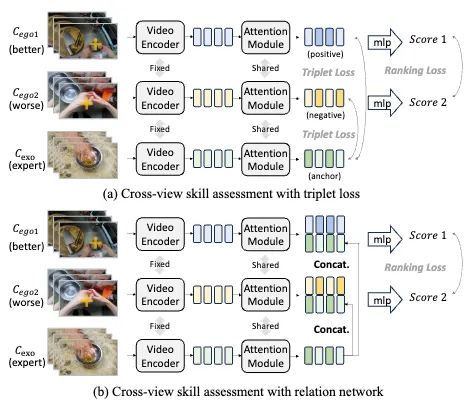

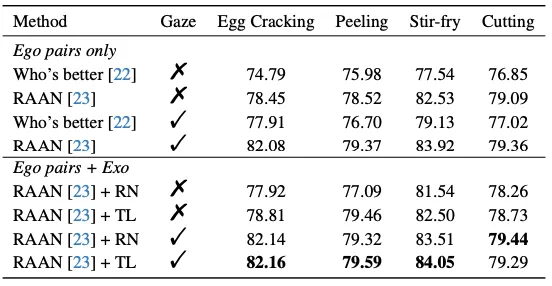

3) 跨视角参考技能评估 (cross-view referenced skill assessment) 主要目标是评估第一视角操作者的技能水准。研究者引入了第三视角的专家操作视频作为参考,通过与参考视频的对比,技能评估可以变得更加准确。基线模型与结果如下图所示:

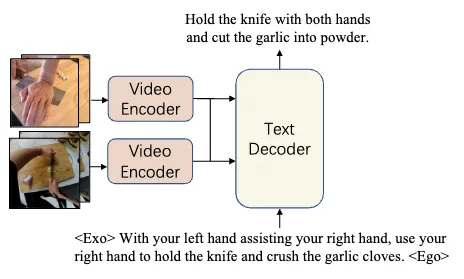

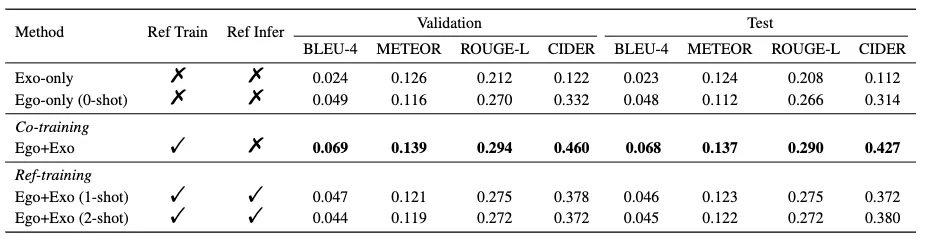

4) 跨视角参考视频描述 (cross-view referenced captioning)。使用另一个视角的视频作为参考,此项任务旨在提高模型利用跨视角参考而更好的进行视频描述的能力。模型设计和基线性能如下:

结论

对于下一代具身智能在现实世界中执行复杂任务而言,能够连接第一和第三视角中的异步程序性动作的能力是必不可少的。作为一个基础步骤,EgoExoLearn 包含了丰富的第一视角视频,其中每个视频都是在跟随第三视角演示视频的程序时拍摄的。这种现实的设置,结合多模态人工高质量标注,能够构建 4 个新颖的基准测试。而这些基准作为一个多功能的平台,可以被用于研究如何桥接跨视角的异步活动。EgoExoLearn 还可以促进新的研究方向,例如如何更好地利用注视和与手相关的标注。基准测试的结果表明,当前模型在连接第一和第三视角的异步活动方面尚有不足,未来还有显著的改进空间。