老黄的新GPU又在深夜炸场,震撼了所有的观众。

除了硬件参数上的震撼之外,大家伙最想知道的还是新GPU的售价会不会同样震撼。

下面就让我们从规格参数、工艺节点、封装设计等方面来深入分析一下新一代Blackwell GPU的系统、定价、利润,以及Jensen's Benevolence(老黄的仁慈)

在这个大模型的时代,英伟达正处于世界之巅,拥有至高无上的定价权。

需要AI算力的用户没有更好的选择,于是不得不接受英伟达「用银汤匙喂给他们的东西」,——毛利率超过85%的H100就是最好的例子。

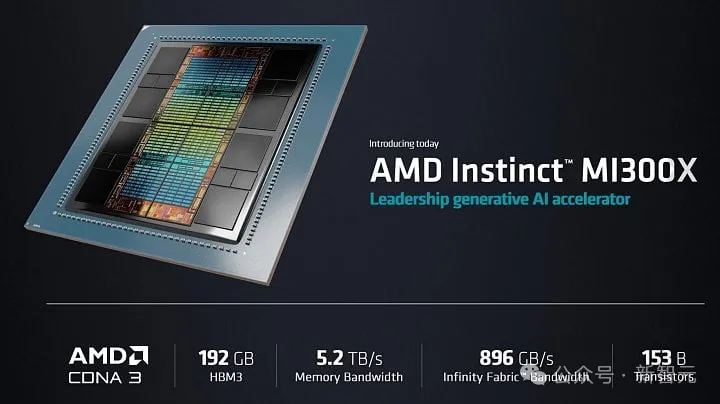

而这一代B100在性能和总体拥有成本方面的优势依然保持不变,超越了AMD的MI300X、英特尔的Gaudi 3。

不过这次新系列GPU的定价,可能会让很多人大吃一惊,也许我们会说「B」代表的不是「Blackwell」架构,而是「Benevolence」(老黄的仁慈)。

——因为AI时代的主宰和救世主黄仁勋正在向全世界微笑,尤其是对于「GPU-poor」(缺乏GPU的用户)来说。

B100 / B200规格

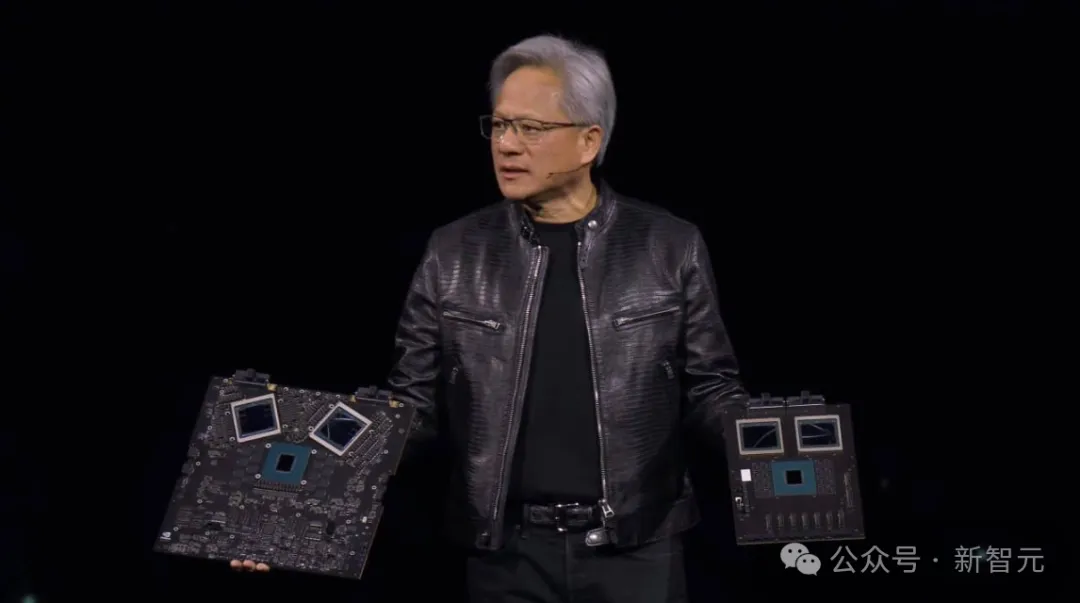

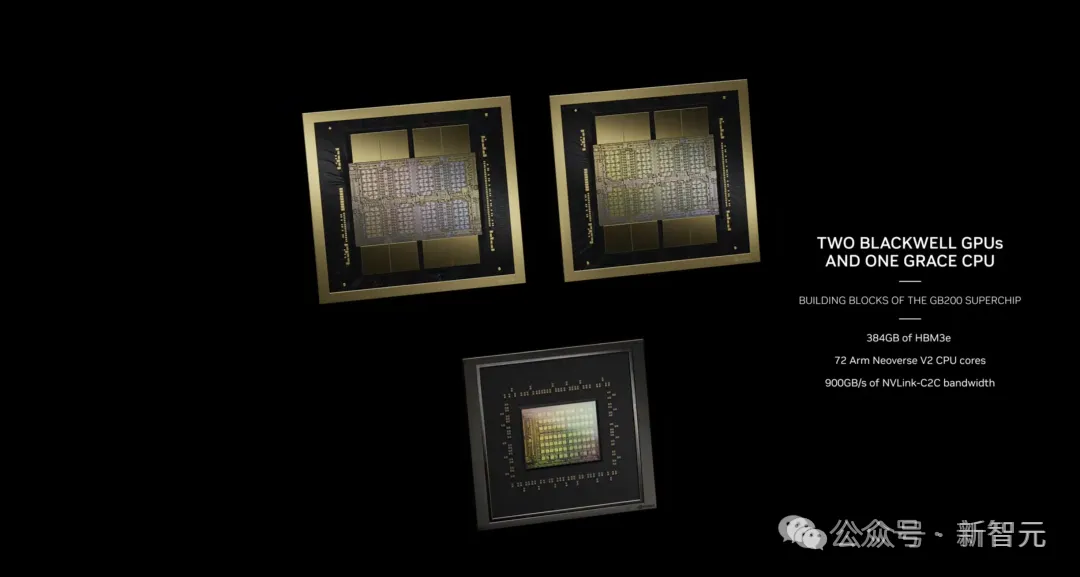

首先,Blackwell架构将2个GPU芯片粘在了一起,而工艺制程仍然保持在4nm,跟上一代的Hopper架构一样。

——在以往发布的最新数据中心GPU上,英伟达都会采用更新的工艺制程,而这一次没有。

这是因为台积电最初的3纳米N3B工艺存在问题,所以英伟达不仅没有吃到提升制程的红利,还不得不把硅片的总量增加一倍。

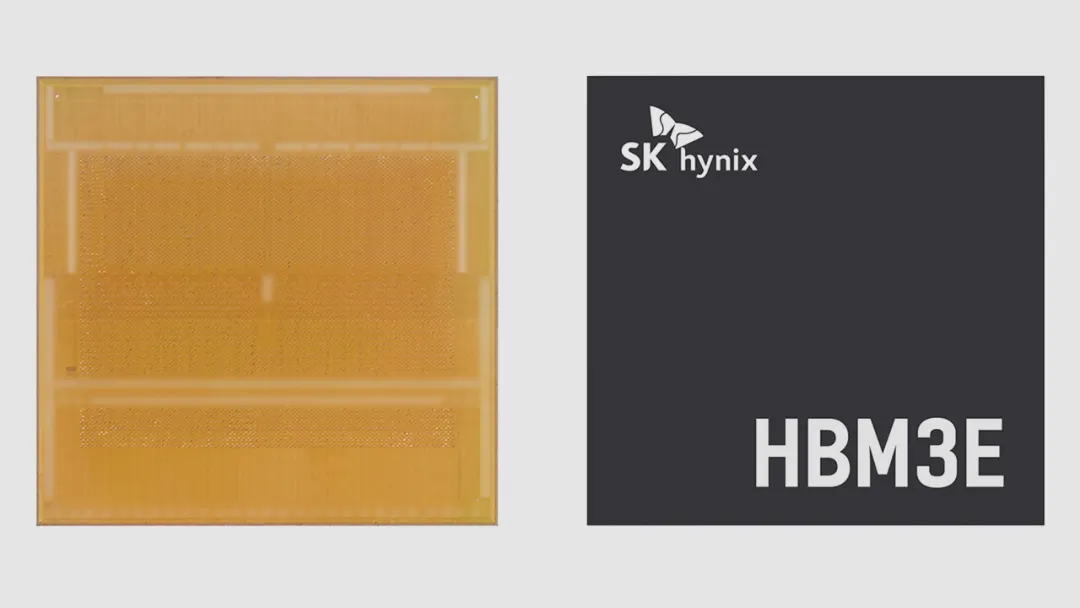

此外,新架构使用了8-hi HBM3E,容量高达192GB,这些显存的供应商是SK Hynix和Micron。

尽管其中绝大部分来自SK Hynix,但这也改变了SK Hynix作为H100显存唯一供应商的局面。

至于早就宣布要开发"世界上最快"的HBM3E的三星,目前仍然差点意思。

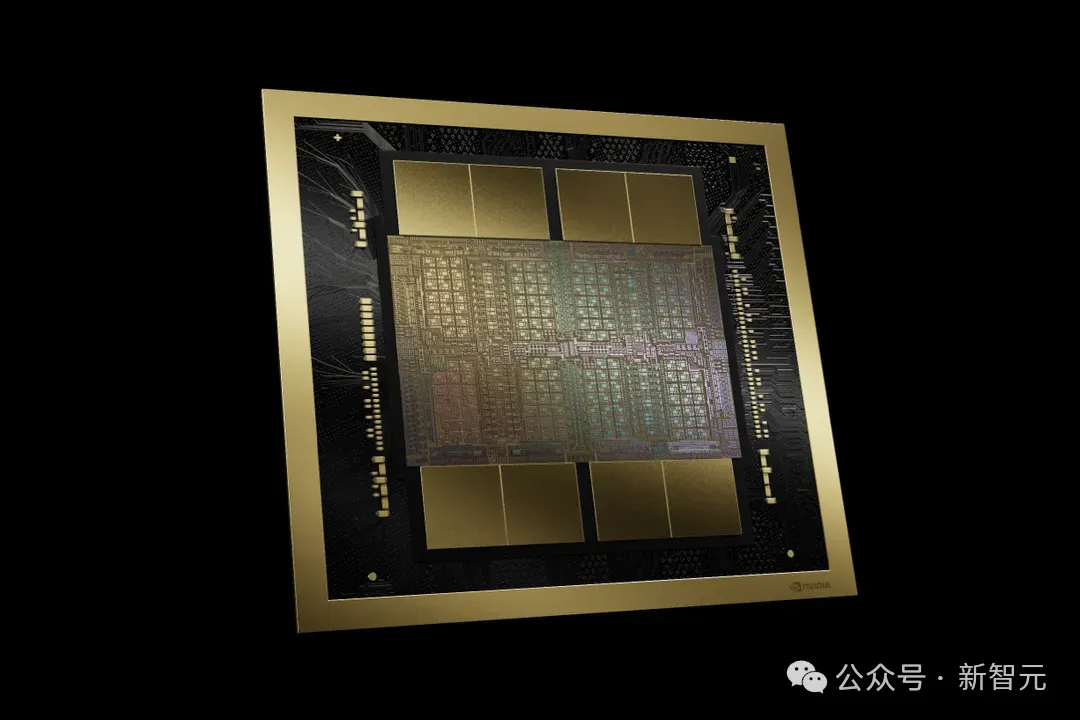

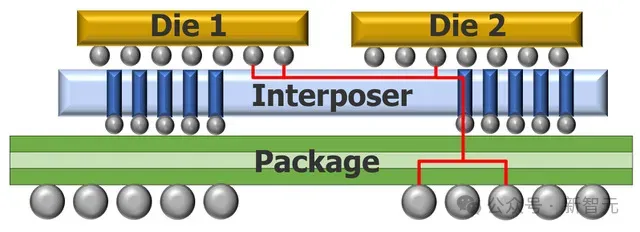

GPU的进化趋势是在更大的封装中使用更多的硅片(包括逻辑和存储器),而目前硅基插值器(silicon-based interposers)的尺寸已达到极限。

尺寸的增大会使硅片的生产面临更多问题,从而降低产量。相比于上一代,B100的封装尺寸要大得多,它将成为首款采用CoWoS-L的大容量产品(CoWoS-L是一种带有无源硅桥的有机RDL基底面)。

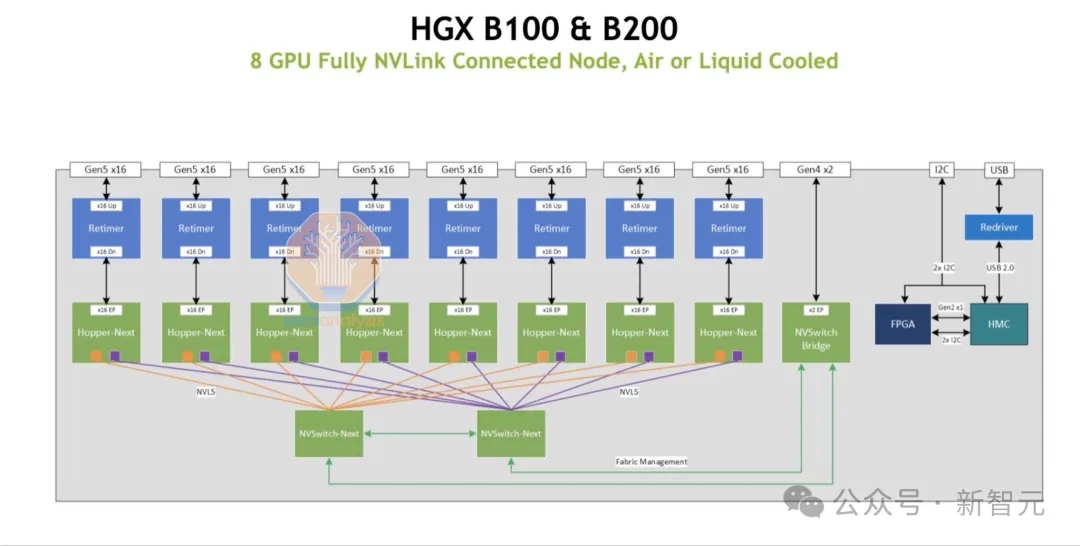

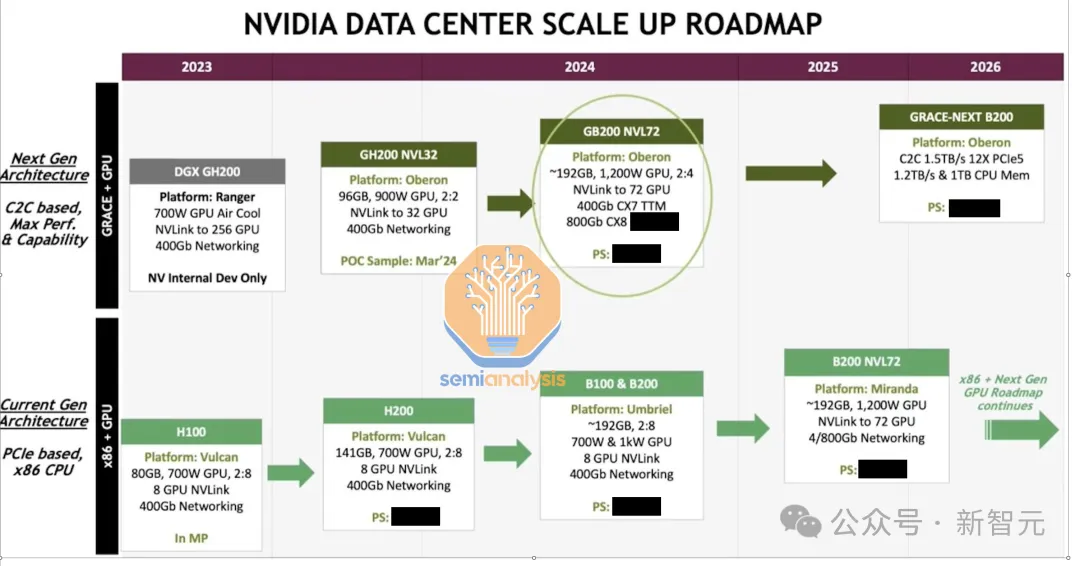

Umbriel 和 Miranda

Blackwell的第一个版本代号叫Umbriel,它保留了前代PCIe Gen 5、400G网络等,B100风冷式700W甚至可以无缝接入现有的H100和H200服务器底板。

不过B200的功率上限将提高到1000W,就需要重新设计服务器了。当然也有信息显示,1000W版本仍然可以采用风冷方式,令人感到意外。

标准版GPU的代号是Miranda,拥有PCIe Gen 6和800G的网络,而显存容量更是高达192GB。

目前,英伟达已经买断了所有36GB HBM的供应,SK Hynix和Micron将在明年初开始生产。这意味着,每块GPU的容量实际上可以达到288GB。

GB200平台

在供应链中,每个人都在讨论的产品是Oberon GB200平台,新平台解决了GH200的许多问题。

首先,GB200将所需的CPU数量减半,从而在总体拥有成本(TCO)上占据了优势。——GH200的价格实在是太贵了,而大多数的AI负载,实际上用不到服务器上昂贵的英伟达Grace CPU所提供的功能。

很多时候,GH200中的Grace芯片只是充当了世界上最昂贵的内存控制器。在可以单独购买GPU的场景下,基本上所有AI大公司都会选择买更多的GPU,而不是英伟达的CPU。

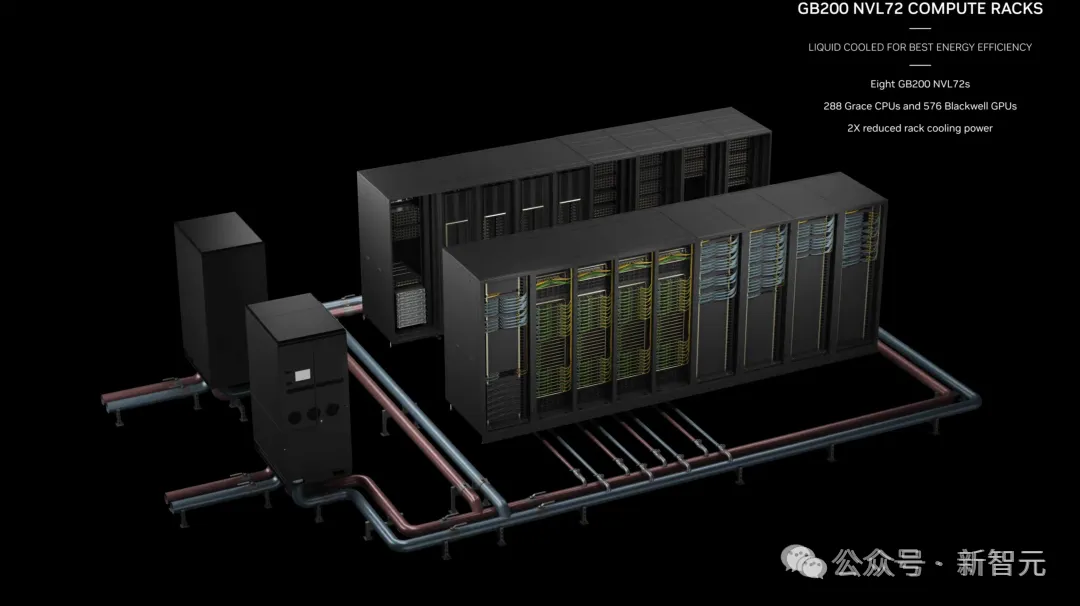

另一方面,英伟达正试图销售带液体冷却的集成机架。

英伟达不愿意单卖GPU或者NVSwitch,虽然让一些用户感到不满,但由于交换机背板、电源汇流排和冷却系统的集成度要求很高,也算是无可厚非。

在新的液冷机架中,CPU、GPU、NVSwitches和ConnectX7网卡全部采用水冷技术。

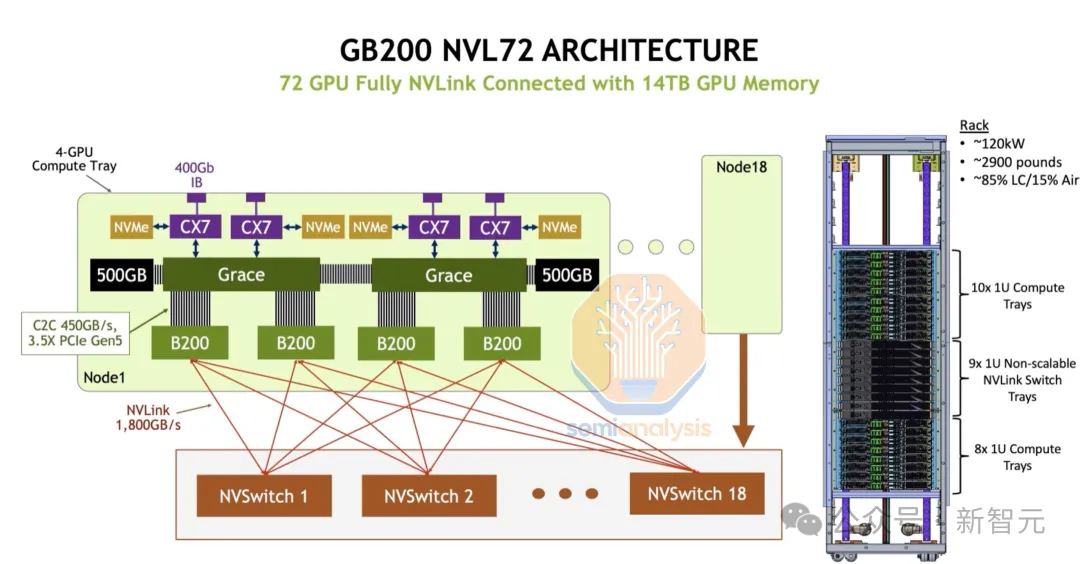

机架有两个版本:一种是120kW,可容纳72个GPU(总功率有点过分了),机架顶部有10个计算托盘,中间有9个NVSwitch托盘,底部有8个计算托盘。

每个计算托盘包含4个GPU、4个网卡、2个CPU、768GB HBM和2,000GB LPDDR5X。这个版本会晚一些上市。

另一种是功率较低的版本,这版本的机架有36个GPU和9个计算托盘,可以通过NVLink扩展连接两个机架。

对大多数公司来说,这个版本可能更容易部署。英伟达已通知机架的ODM厂商准备明年生产50,000个机架。

被卷到了

尽管B100为最终用户提供了更好的性价比,但本身的制造成本却增加了一倍以上。

SemiAnalysis表示,对于大批量超大规模定价,B100基板的平均售价仅仅约240,000美元。这对许多人来说是一个惊喜,因为这远低于ASP逐代增长50%的预期。

那么为什么老黄的定价会如此仁慈?答案是被卷到了。

AMD的MI300目前成为了合格的竞争对手,已经成功拿到了英伟达最大的两个客户Meta和微软的大订单,尽管AMD为此承担了很大的技术风险、并尽力降低了利润。

而另一方面,英伟达的所有主要客户都在设计自己的芯片。虽然迄今为止,只有谷歌取得了成功,但亚马逊仍在继续推出Inferentia和Trainium,Meta也在长期押注MTIA,微软同样开启了芯片之旅。

英伟达的防御形态

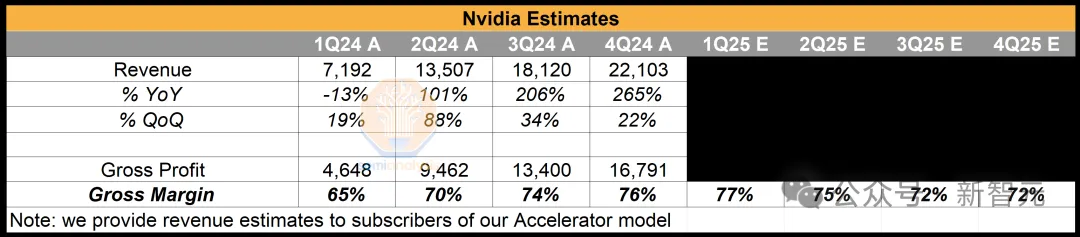

很明显,生产成本翻倍,但售价增加得不算太多,B100的利润率肯定是赶不上前代了。

H200也是如此,它的ASP与H100相同,但HBM显著增加,从而增加了BOM。

而H20则更糟糕,尽管价格卖的更低,但实际上它与H100使用了相同的GPU芯片,HBM容量也从80GB增加到96GB,因此总体BOM成本实际上也增加了。

——以上的分析虽然听起来很可怕,不过别担心,毛利率只会再下降几个百分点而已。

SemiAnalysis对此评价道:“英伟达更关心毛利润和市场份额,而不是毛利率。过分担心几个百分点是精打细算的人所做的事情,而不是像黄仁勋这样的有远见的人所做的,他想以仁慈的计算独裁者的身份统治世界。”

毕竟,英伟达在数据中心上的收入持续飙升,并且正在实现供应链多元化,从800G收发器到电力传输组件,——老黄正在下一盘大棋。

也许,随着时代的发展,英伟达这个显卡帝国可能不得不转换成防御形态,因为硬件和软件上的护城河,都不会永远坚不可摧。

但也许,新的帝国正在诞生之中。