Mamba是最近最火的模型之一,更是被业内认为可以有取代Transformer的潜力。今天介绍的这篇文章,探索了Mamba模型在时间序列预测任务上是有有效。本文首先给大家介绍Mamba的基础原理,再结合这篇文章探索在时间序列预测场景中Mamba是否有效。

论文标题:Is Mamba Effective for Time Series Forecasting?

下载地址:https://arxiv.org/pdf/2403.11144.pdf

1、Mamba基础原理

Mamba是一种基于State Space Model的结构,和RNN非常像。Mamba相比Transformer,在训练阶段和inference阶段都有随序列长度线性增长的时间复杂度,运算效率显著由于Transformer这种结构。

Mamba的核心可以分为以下4个部分:

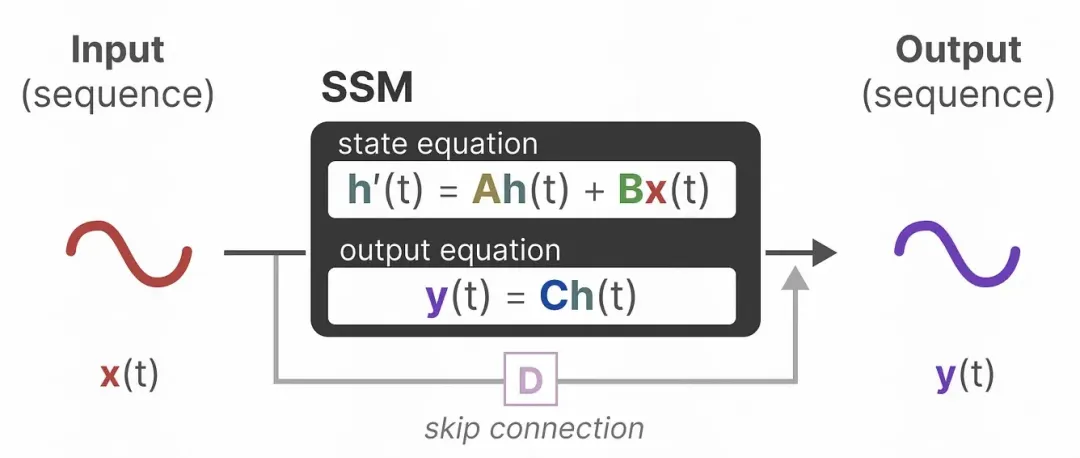

State Space Model(SSM):状态空间模型,用来刻画上一个状态对当前状态的影响,以及当前状态对输出的影响;State Space Model中假设上一个状态和当前时刻的输入会影响下一个状态,并且当前的观测结果是由当前状态决定的。SSM可以表示为如下形式,矩阵A、B、C、D为超参数;

图片

图片

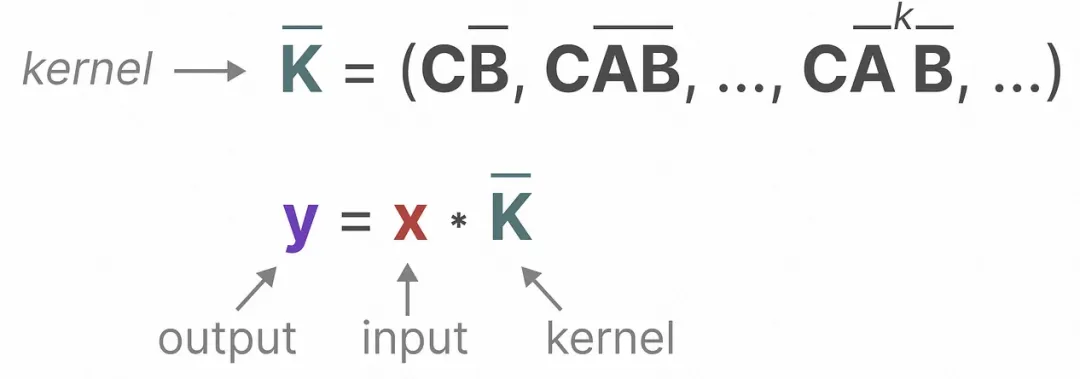

卷积表达:用卷积来表达SSM,实现训练阶段的并发计算,通过将SSM中的计算输出的公式按照时间展开,通过设计相应的卷积核到一定的形式,可以利用卷积来表达每个时刻的输出为前面3个时刻输出的函数:

图片

图片

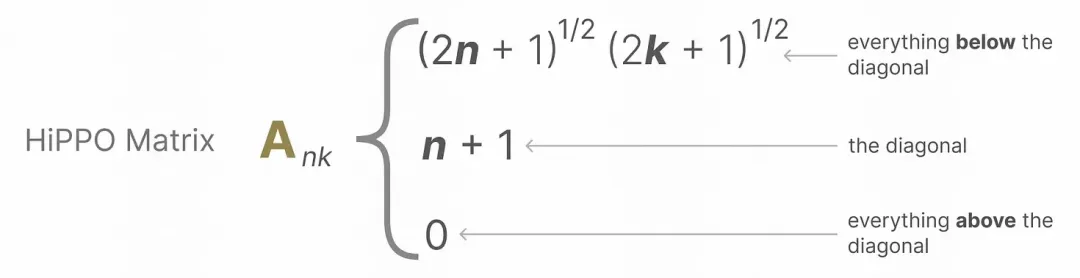

Hippo Matrix:对于参数A,引入Hippo Matrix实现对历史信息的衰减融合;

图片

图片

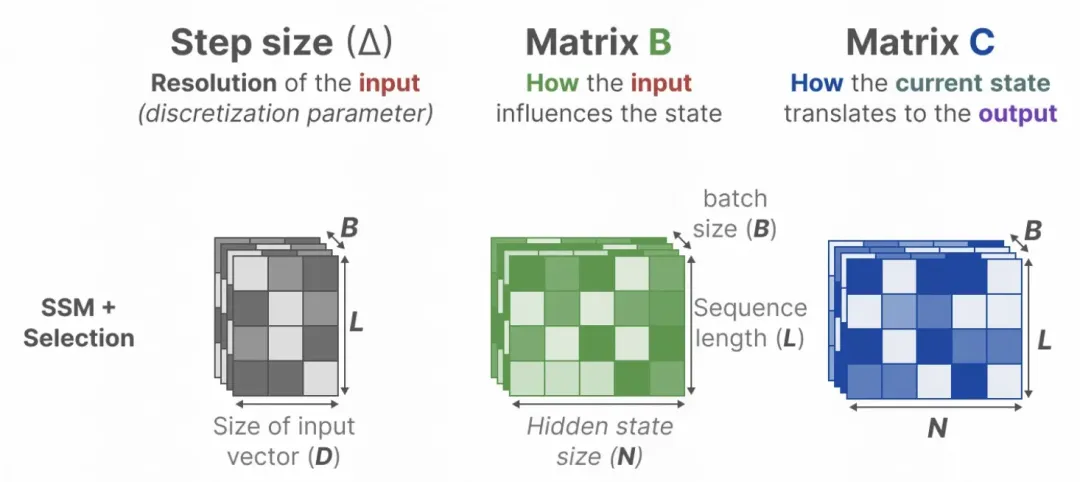

Selective模块:对于参数B和参数C个性化的矩阵实现对历史信息的个性化选择,将每个时刻的参数矩阵转换成关于输入的函数,实现每个时刻个性化的参数。

图片

图片

关于Mamba更详细的模型解析,以及后续的Mamba相关工作,也更新到了知识星球中,感兴趣的同学可以在星球中进一步深入学习。

2、Mamba时间序列模型

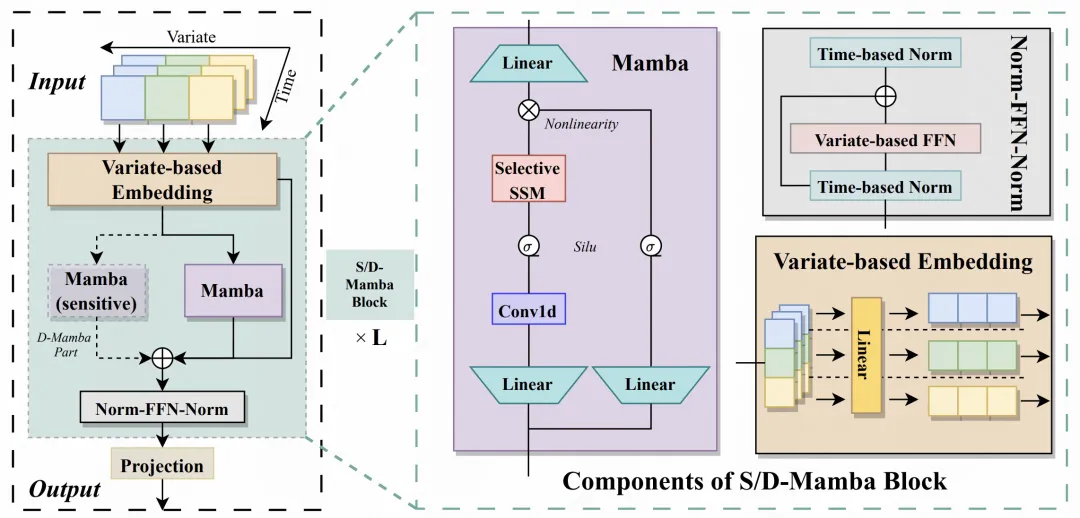

下面介绍一下这篇文章中提出的Mamba时间序列预测框架,整体基于Mamba,对时间序列数据进行适配。整体分为Embedding、S/D-Mamba layer、Norm-FFN-Norm Layer三个部分。

Embedding:类似iTransformer的处理方法,对每个变量单独进行映射,生成每个变量的embedding,再将每个变量的embedding输入到后续的Mamba中。因此本文也可以看成是对iTransformer的模型结构的一个改造,改成了Mamba结构;

S/D-Mamba layer:Embedding的输入维度为[batch_size, variable_number, dim],将其输入到Mamba中,文中探索了S和D两种Mamba层,分别表示每层用一个mamba还是两个mamba,两个mamba会将两个的输出相加得到每层的输出结果;

Norm-FFN-Norm Layer:在输出层,使用normalization层和FFN层对Mamba的输出表征进行归一化和映射,结合残差网络,提升模型收敛性和稳定性。

图片

图片

3、实验效果

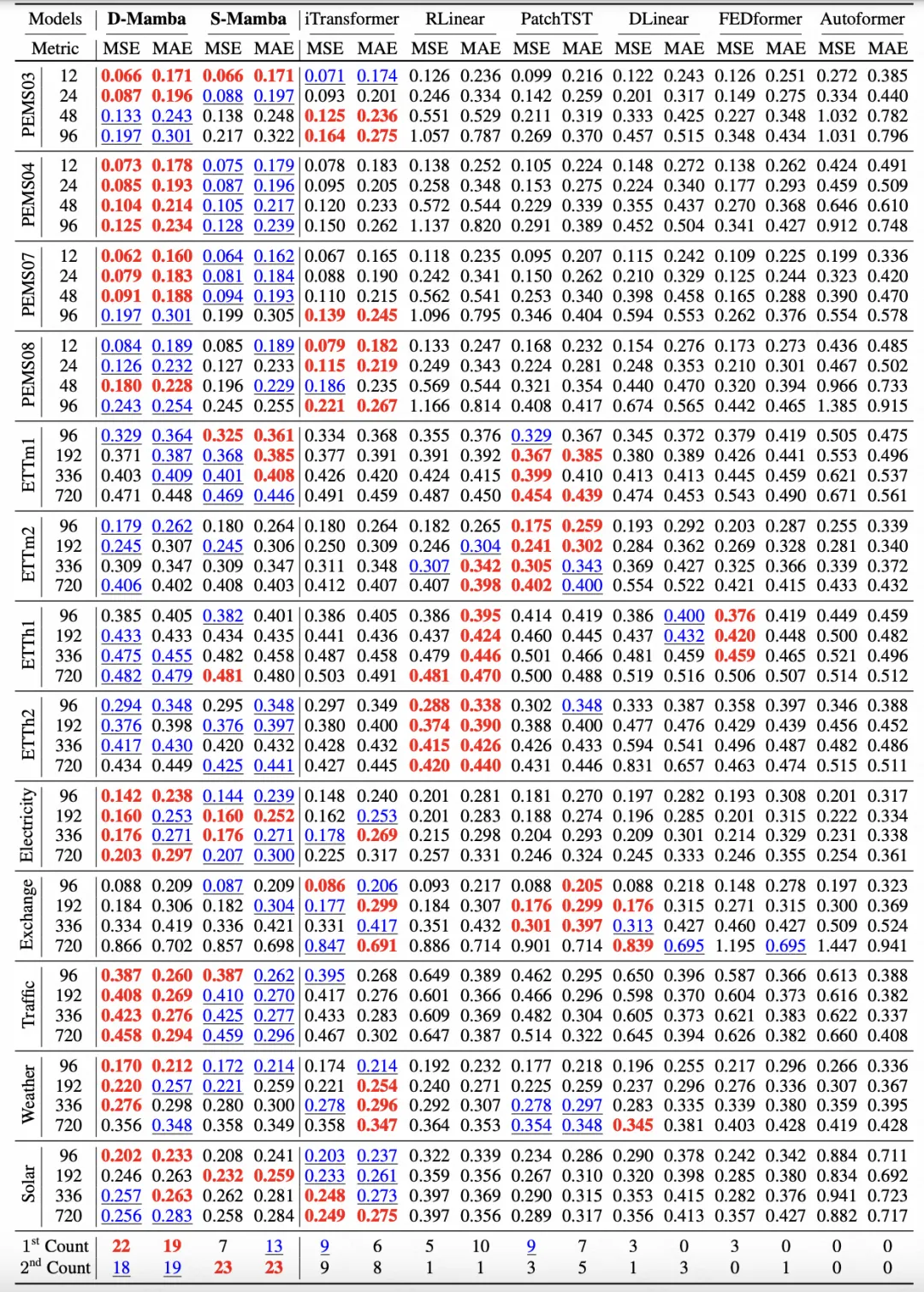

下图是文中的核心实验结果,对比了Mamba和iTransformer、PatchTST等业内主流时间序列模型的效果。文中还对不同的预测窗口、泛化性等进行了实验对比。实验表明,Mamba不仅在计算资源上有优势,在模型效果上也可以比肩Transformer相关的模型,并且在长周期的建模上也很有前景。

图片

图片