本文经自动驾驶之心公众号授权转载,转载请联系出处。

写在前面&笔者的个人理解

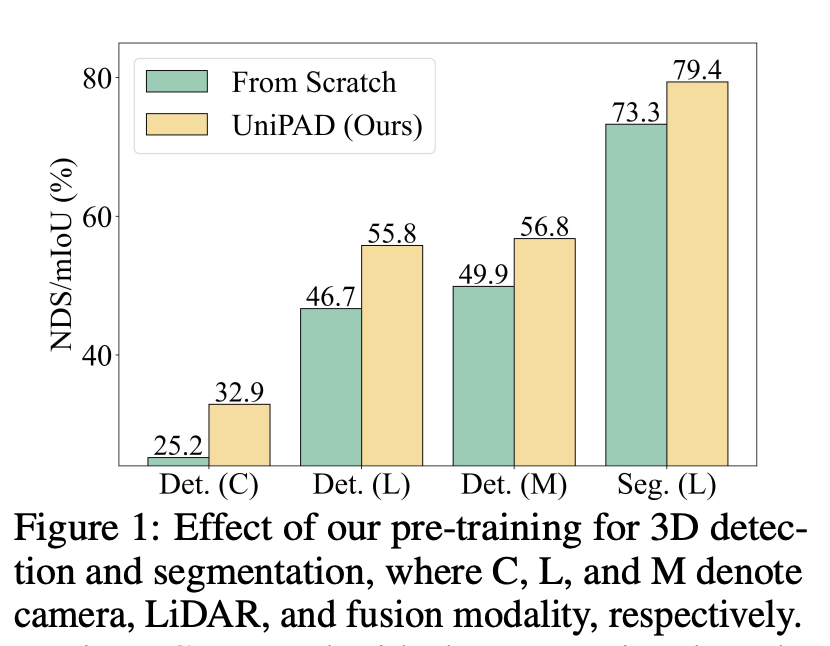

UniPAD研究了一个关键问题:如何有效地利用大量未标记的3D点云数据进行自监督学习,以增强其在3D目标检测和语义分割等下游任务中的应用效率。这个问题之所以重要,是因为在自动驾驶和许多其他领域,3D点云数据的有效使用能够极大提高任务执行的准确性和可靠性。尽管2D图像领域的自监督学习已经取得了显著进展,但由于3D点云数据的固有稀疏性和点分布的变异性,将这些方法扩展到3D点云上面临着更大的挑战。

传统的针对3D场景理解的预训练范式主要基于对比学习和遮蔽自编码(MAE)两大类方法,它们或面临样本选择的敏感性和实际应用的局限性,或在处理3D点云数据的不规则性和稀疏性方面遇到挑战。特别是,3D点云的遮蔽自编码任务在细粒度的几何结构预测上往往效果不佳,因为传统方法可能无法有效捕获3D空间中的连续性和结构信息。

针对上述挑战,论文提出了一种新颖的预训练范式,专为3D表示学习量身定制。该方法通过3D可微分神经渲染,以投影的2D深度图像上重建缺失的几何结构为目标,避免了复杂的正负样本分配,并隐式提供了连续的监督信号来学习3D形状结构。这一方法不仅提高了训练效率和内存使用的经济性,而且通过创新的采样策略,在精确性上取得了显著提升。

该研究的贡献主要体现在三个方面:

- 首次探索了一种新颖的3D可微分渲染方法,用于自动驾驶场景下的自监督学习。

- 该方法易于扩展,以预训练2D背景模型,并通过创新的采样策略,在有效性和效率上显示出其优越性。

- 通过在nuScenes数据集上进行广泛实验,该方法在多种预训练策略中性能最优,并且在七种背景模型和两种感知任务上的实验结果,为该方法的有效性提供了有力证据。

总体而言,这项研究为3D点云数据的自监督学习提出了一个创新的方法论框架,有效解决了之前方法存在的问题,同时在3D目标检测和语义分割等关键任务上实现了显著的性能提升。

方法

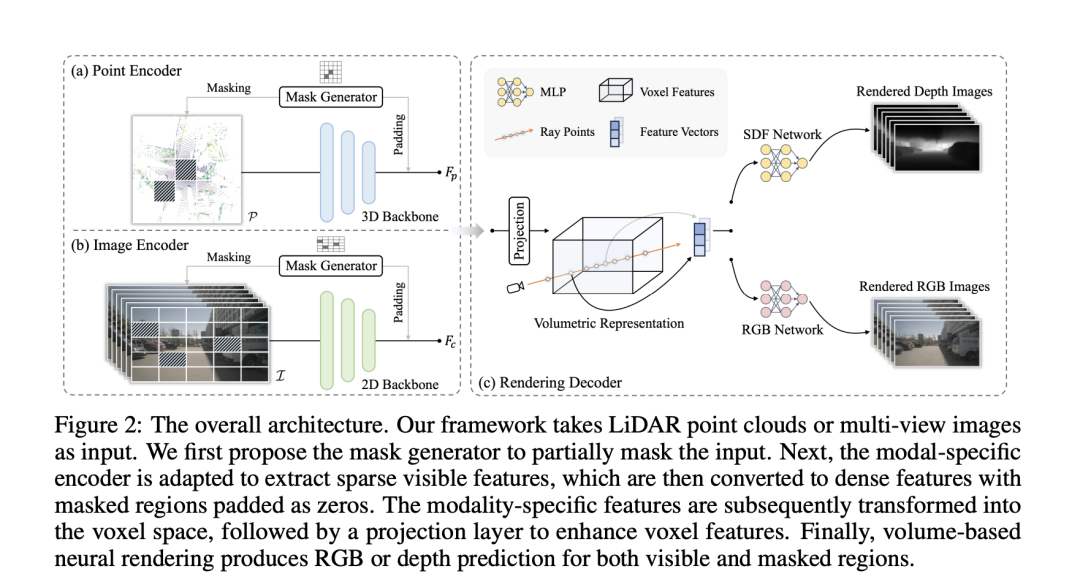

Modal-specific Encoder

在这个段落中,"Modal-specific Encoder"(模态特定编码器)是一种为不同类型的输入数据(例如LiDAR点云和多视图图像)设计的编码器,用于提取高质量的特征表示。这种编码器针对每种输入数据的特性进行优化,以有效处理数据的特定结构和信息。

- 对于LiDAR点云,使用如VoxelNet这样的点编码器来提取层次化特征。这种编码器能够处理点云的稀疏性,并从中提取有用的空间信息。

- 对于多视图图像,则采用经典的卷积网络来提取特征。这种网络适用于处理图像数据,能够捕捉到视觉纹理和形状信息。

此外,为了在不牺牲高级信息的同时捕获细粒度的细节,使用了额外的模态特定的FPN(Feature Pyramid Networks),这是一种高效聚合多尺度特征的方法,进一步增强了模型对于不同尺度信息的处理能力。

Mask Generator(遮罩生成器)是一种数据增强手段,通过选择性地移除输入数据的一部分来提高模型的泛化能力和表示能力。这种方法灵感来自之前的自监督学习方法,如He等人提出的MAE,通过增加训练难度来增强模型性能。在这个框架下,遮罩生成器采用块状遮罩,针对点云或图像,生成遮罩并应用到输出特征图的大小上,然后将其上采样到原始输入分辨率。对于点云,通过移除被遮罩区域的信息来获取可见区域;对于图像,则采用稀疏卷积,仅在可见位置进行计算。编码后,被遮罩的区域以零填充,并与可见特征结合形成规则的密集特征图。

"Modal-specific Encoder"和"Mask Generator"共同构成了一个强大的框架,通过模态特定的特征提取和创新的数据增强技术,显著提升了自监督学习在处理复杂3D点云和图像数据时的效率和性能。

Unified 3D Volumetric Representation

Unified 3D Volumetric Representation(统一的3D体积表示)是一种将来自不同模态的数据(如LiDAR点云和多视图图像)转换为统一的3D体积空间表示的方法。这种表示方法的目的是为了在预训练方法中兼容不同的输入模态,同时尽可能保留每种模态原始视图中的信息。

对于多视图图像,2D特征被转换到3D自车坐标系中,以获得体积特征。这一过程首先是定义3D体素坐标,其中是体素分辨率。然后,将投影到多视图图像上以索引相应的2D特征。通过双线性插值方法,结合变换矩阵和(分别代表从LiDAR坐标系到相机帧和从相机帧到图像坐标的转换),构造出体积特征。

对于3D点云模态,直接在点编码器中保留高度维度,以直接利用点云数据的空间信息。

在此基础上,通过使用包含个卷积层的投影层,进一步增强了体素表示的能力,使其能够更好地捕捉和表达3D空间中的细节和结构信息。

Neural Rendering Decoder

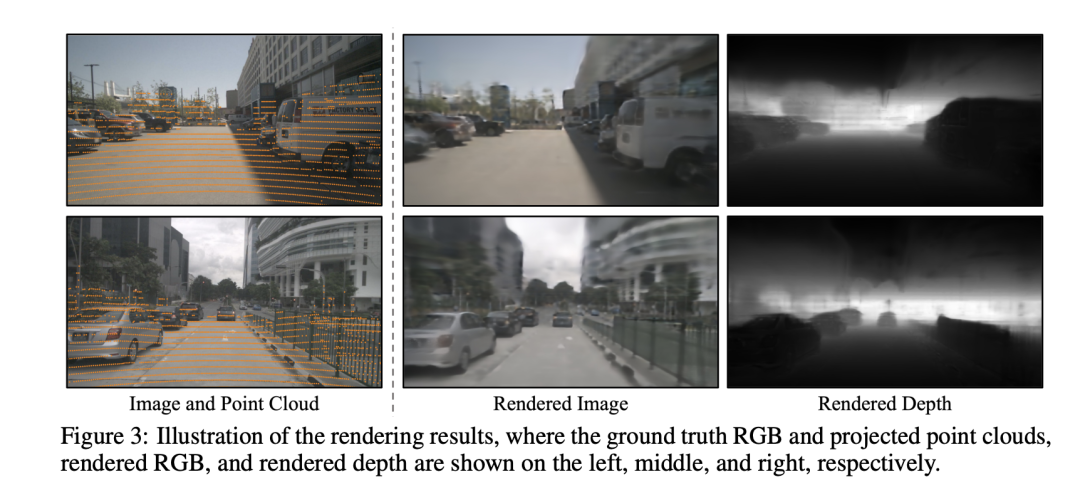

该部分引入了一种利用神经渲染技术灵活整合几何或纹理线索到学习到的体积特征中的新方法,这在统一的预训练架构中实现了对体积特征的有效使用。具体来说,提供体积特征后,从多视图图像或点云中采样一些光线,并使用可微分体积渲染技术为每条光线渲染颜色或深度。这种灵活性进一步促进了将3D先验融入所获取的图像特征中,通过额外的深度渲染监督实现,确保了其能够无缝集成到2D和3D框架中。

通过使用隐式符号距离函数(SDF)场来表示场景,能够高质量地表现出几何细节。SDF表示查询点与最近表面之间的3D距离,从而隐式地描述了3D几何形态。对于每个光线点,可以从体积表示中通过三线性插值提取特征嵌入。然后,通过浅层MLP预测SDF值。

对于颜色值,根据表面法线(即SDF值在光线点处的梯度)和来自的几何特征向量,通过MLP来确定颜色场。最后,通过沿光线集成预测的颜色和采样深度来渲染RGB值和深度。

此外,为了减轻计算负担,提出了三种内存友好的光线采样策略:扩张采样、随机采样和深度感知采样。这些策略通过选择性地采样光线,而不是渲染整个图像的所有光线,从而减少了计算需求,同时优化了神经渲染的精确度,专注于场景中最相关的部分。整体预训练损失由颜色损失和深度损失组成,用于训练模型以精确渲染给定场景的颜色和深度,从而在不同模态间建立了一个高效、统一且信息丰富的3D体积表示。

实验

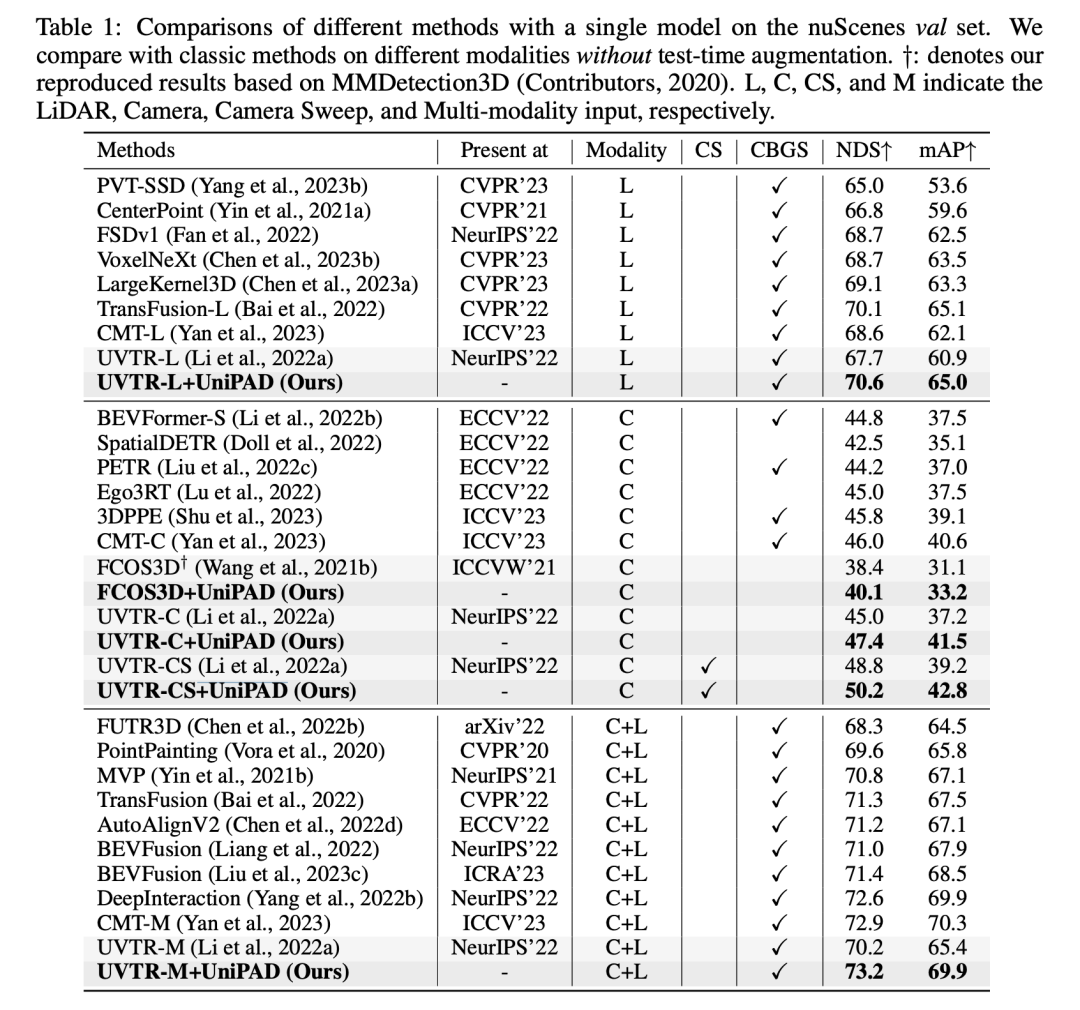

在这张表格的实验结果中,+UniPAD的方法在不同模态的输入数据上表现出色。这些模态包括LIDAR (L)、Camera (C)、Camera Stereo (CS) 和 Multi-input (C+L),对应于不同的3D目标检测和语义分割任务。通过使用UniPAD方法,我们看到在各种不同的配置和数据输入模态中,性能普遍得到提升。

当专注于LiDAR模态时,+UniPAD版本的UVT-RL方法达到了70.6%的NDS(Normalized Detection Score)和65.0%的mAP(mean Average Precision),这是这个类别中最高的得分。这表明UniPAD方法在处理点云数据时非常有效,能够提高模型的检测性能和精确度。在Camera模态中,UVT-RC+UniPAD版本比起原始的UVT-RC方法,在NDS和mAP上也有明显的提升。例如,原始的UVT-RC方法的NDS为45.0%,而UVT-RC+UniPAD的NDS为47.4%,在mAP上也从37.2%提高到了41.5%。当数据输入是Camera Stereo时,我们看到UVT-CS+UniPAD在NDS上得到了显著的提升,从原来的UVT-CS的48.3%提升至50.2%,在mAP上也从39.2%提升至42.8%。这表明UniPAD方法能够利用立体视觉的深度信息,以提高性能。

最后,在使用多种输入模态(Camera+LiDAR)的配置中,UVT-M+UniPAD方法在NDS上实现了73.2%,在mAP上实现了69.9%,这是所有列出配置中的最高分。这表明UniPAD方法能够有效地整合来自不同传感器的信息,进一步提高了模型在复杂场景下的表现。UniPAD方法的引入为各种基线方法带来了性能的显著提升,这证明了UniPAD在多种传感器数据融合和自监督预训练方面的有效性。这些改进可能是由于UniPAD方法能够更好地理解和整合来自不同模态的数据,从而为3D目标检测和语义分割任务提供了更丰富和更准确的特征表示。

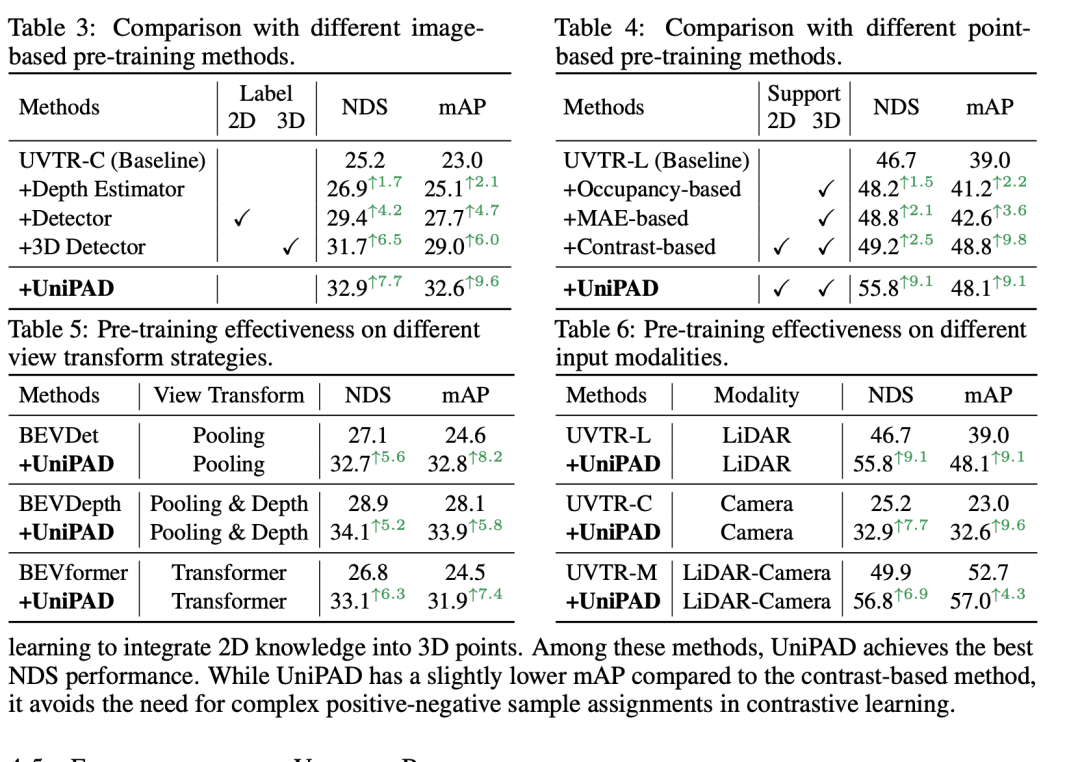

消融实验通常用来理解不同组件对模型性能的影响。根据提供的表格内容,我们可以总结以下关于体积基神经渲染的消融研究结果:

- 遮罩比例 (Mask ratio): 使用0.3的遮罩比例在NDS和mAP上分别取得了32.9%和32.6%的得分,表现出是这一系列实验中的最佳设置。这表明在输入数据中遮蔽30%的部分可以提供最佳的训练难度,有利于模型学习。

- 解码器深度 (Decoder depth): 解码器的深度影响模型的性能。一个具有(6, 4)层的解码器在NDS上达到了32.9%,这是测试的配置中最高的,表明一个较深的解码器可以提高精度。

- 解码器宽度 (Decoder width): 解码器的宽度对性能的影响较小。不同维度的解码器在NDS和mAP上的得分差异不大,最高分数与最低分数相差不到0.5%。

- 渲染技术 (Rendering technique): 在测试的三种不同的渲染方法中,NeuS方法(NDS 32.9%, mAP 32.6%)略胜一筹,表明良好设计的渲染技术对于表示学习是有益的。

- 采样策略 (Sampling strategy): 深度感知采样在NDS和mAP上均取得了32.9%和32.6%的最佳得分,优于扩张采样和随机采样,这显示出选择性地采样更为重要的区域可以提升渲染质量和模型性能。

- 特征投影 (Feature projection): 特征投影对于增强体素表示至关重要。与基线模型相比,去掉投影层会导致NDS和mAP的性能下降,这表明特征投影对于保持高质量的体素表示是必要的。

- 预训练组件 (Pre-trained components): 模型的预训练组件对于微调至关重要。只有编码器的模型(NDS 32.0%, mAP 31.8%)比只有基线的模型(NDS 25.2%, mAP 23.0%)性能有显著提升,而加入FPN和VT(Volume Transformer)后,模型在NDS上进一步提升到了32.9%,在mAP上提升到了32.6%,证明了在预训练阶段加入这些组件能够显著提升模型的性能。

通过这些消融实验,我们可以看出每个组件和参数选择如何影响最终的模型性能,并且可以得出哪些组件对于模型最为关键。这样的分析有助于研究者们理解和优化他们的模型结构。

讨论

这篇论文提出的方法在处理3D点云和多视图图像数据时表现出了显著的优势。通过将数据统一转换成3D体积表示,并使用先进的神经渲染技术,该方法在预训练阶段就能学习到丰富的几何和纹理特征,这在后续的下游任务中证明是有益的。特别是通过深度感知采样,该方法优先处理更为重要的数据区域,从而有效提高了模型的渲染质量和整体性能。此外,特征投影和体积变换器的应用进一步加强了体积表示,使得模型能够在预训练后更好地进行微调。

尽管如此,方法也存在一些局限性。例如,尽管解码器的深度和宽度调整显示出对模型性能有细微的影响,但这也意味着在资源有限的情况下,选择合适的模型规模和复杂度是一项挑战。此外,尽管深度感知采样策略在性能上取得了最佳结果,但它也依赖于高质量的深度信息,这在实际应用中可能受到传感器质量和环境因素的影响。最后,虽然预训练组件证明是提高性能的关键,但每个组件的设计和集成都需要仔细的考量,以确保模型的泛化能力和实际应用的有效性。这些挑战需要未来的研究工作来进一步探讨和解决。

结论

总结来说,这篇论文介绍的方法通过创新性地将3D点云和多视图图像统一到3D体积表示,并运用先进的神经渲染技术,显著提升了自监督学习的效果。该方法通过深度感知采样策略和有效的特征投影,使得预训练模型在多个下游任务中都取得了卓越的性能。然而,面对模型规模和复杂度的选择,以及在变化的环境和传感器条件下保持性能的挑战,仍有进一步的优化空间。未来的工作可以在提高模型的鲁棒性和适应性上进行更多的探索,以实现对这种方法的全面优化和应用。