本文篇幅很长,主题很多,但循序渐进,对「Sora 究竟是不是世界模拟器」这一说法给出了非常详实的解读。

最近,OpenAI 的文生视频模型 Sora 爆火。除了能够输出高质量的视频之外,OpenAI 更是将 Sora 定义为一个「世界模拟器」(world simulators)。

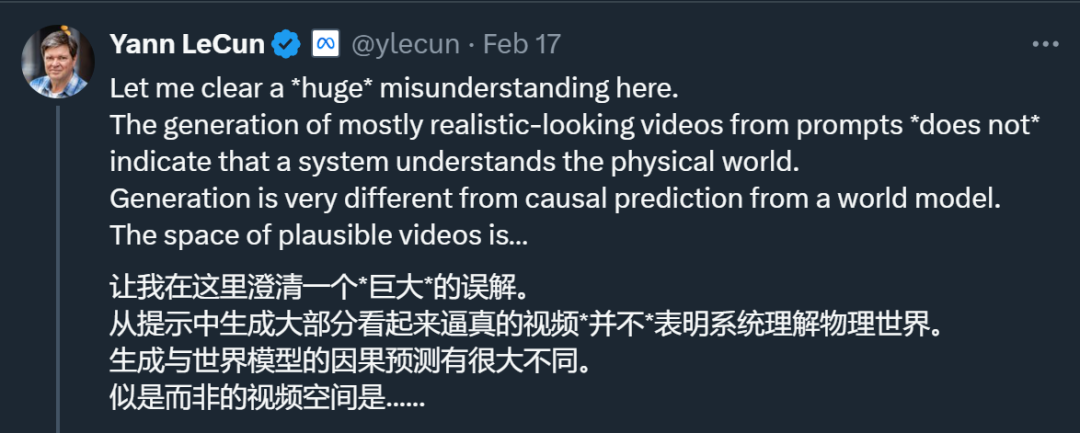

当然,这一说法遭到了包括图灵奖得主 Yann LeCun 在内很多学者的反驳。LeCun 的观点是:仅仅根据 prompt 生成逼真视频并不能代表一个模型理解了物理世界,生成视频的过程与基于世界模型的因果预测完全不同。

近日,澳大利亚麦考瑞大学的哲学助理教授 Raphaël Millière 撰写了一篇长文,深入探讨了 Sora 究竟是不是「世界模拟器」。

作者回顾了 Sora 的功能、工作原理以及它模拟 3D 场景属性的意义,讨论了认知科学中直观物理学文献、机器学习中「世界模型」的多义(多种解释)概念以及图像生成模型的可解释性研究。

结论是:Sora 并没有运行传统意义上的模拟,尽管它可能在更有限的意义上表现出了视觉场景的物理属性。但是,行为证据不足以充分评估 Sora 是世界模拟器这一说法。最后,作者对视频生成模型在未来 AI 和机器人学中的地位,以及它们与认知科学中正在进行的辩论之间的潜在相关性进行了预测。

本文主要内容包括如下:

- 引言

- 视频生成进展

- Sora(可能的)工作原理

- 模拟假设

- 直观物理学

- 世界模型

- 再看 Sora

- 结论

机器之心对原文做了不改变原意的整理编译(以第一人称 zhankai)。

引言

今年 2 月 15 日,OpenAI 推出了 Sora,输入文本 prompts 来生成视频和图像。Sora 最长生成了 60 秒的短视频,不过该模型至今没有开放使用。在 Sora 技术报告中,OpenAI 将它称为「世界模拟器」,并解释了训练 Sora 的动机:

我们教 AI 理解和模拟运动中的物理世界,希望达成的目标是训练模型并让它们帮助人们解决需要真实世界交互的问题。

此外,OpenAI 对 Sora 理论意义的理解是这样的,「我们的结果表明,扩展视频生成模型对于构建物理世界的通用模拟器而言,是一条很有希望的发展路径。」

这些取自 OpenAI 博客和技术报告中的大胆言论,仅仅可以被看做是 PR 宣传,而不是学术论文,更不用说经过同行评议的研究了。当然,这不是我们第一次看到视频生成公司这样说了。比如视频生成领域顶级初创公司 Runway,它也有这样的声明:

所谓世界模型,即能够构建环境的内在表示并用它来模拟未来环境事件的 AI 系统。你可以将 Gen-2 等视频生成系统看作是非常早期和有限形式的通用世界模型。

除了 PR 之外,OpenAI、Runway 的这些言论提及了关于 SOTA 视频生成模型内在结构的真正有趣的问题。不过,像「世界模拟器」和「通用世界模型」这样的描述对于定义上述问题没有多大帮助。

因此,接下来,我将试图阐明这些神经网络拥有了模拟物理世界的内在模型到底意味着什么,以及我们是否有任何证据证明像 Sora 这类 AI 系统做到了如此。

视频生成领域进展

此前,视频生成技术实现了如下图所示的效果。这些短视频由名为 MoCoGAN-HD 的模型生成,出自 ICLR 2021 论文《A Good Image Generator Is What You Need for High-Resolution Video Synthesis》。作者将视频合成问题描述为在静态图像生成模型的潜在空间中发现轨迹,从而利用生成对抗网络中的解耦表示。

论文地址:https://arxiv.org/abs/2104.15069

然而,不到三年的时间,Sora 问世了,为视频生成领域树立了新的标准。Sora 的效果是这样的:

Sora 生成的视频首先看起来非常逼真,与真实视频几乎没有区别。如果从静帧的视角来看,高分辨率、纹理细节和构图都有助于实现这种前所未有的真实感。

此外,Sora 最令人印象深刻的是它的时间一致性。生成视频比生成静态图像的难点在于前者必须随时间推移保持连贯性,需要从一帧到下一帧地描述非常广泛的细节。这包括随时间推移连贯地匹配或修改场景元素(物体和角色)的属性,其中形状和纹理等静态属性通常保持不变,而运动和交互等动态属性根据物理定律变化。

同时相机运动带来了额外的挑战,场景及元素的 3D 几何和照明必须在旋转、倾斜、平移、缩放等情况下保持一致。这同样适用于场景过渡,如空间跳切。Sora 生成的视频满足了这些需求。

从以上动图,我们可以看到,尽管相机快速移动,但场景中的几何形状和主要元素保持一致。当然 Sora 远未达到完美, 视频背景中会出现怪异的画面。尽管如此,Sora 已经比竞争对手好得多了。自 MoCoGAN-HD 推出以来,我们在短短几年内确实取得了长足的进步。

Sora(可能的)工作原理

Sora 背后的技术原理是怎样的呢?Sora 研发负责人之一 Bill Peebles 与纽约大学助理教授谢赛宁撰写的 DiT(扩散 Transformer)论文《Scalable Diffusion Models with Transformers》被认为是此次 Sora 背后的重要技术基础之一。

- 论文地址:https://arxiv.org/pdf/2212.09748v2.pdf

- GitHub 地址:https://github.com/facebookresearch/DiT

这篇论文最早的版本是 2022 年 12 月,2023 年 3 月更新了第二版。当时,扩散模型在图像生成方面取得了惊人的成果,几乎所有这些模型都使用卷积 U-Net 作为主干。

因此,论文的目的是探究扩散模型中架构选择的意义,并为未来的生成模型研究提供经验基线。该研究表明,U-Net 归纳偏置对扩散模型的性能不是至关重要的,并且可以很容易地用标准设计(如 transformer)取代。

具体来说,研究者提出了一种基于 transformer 架构的新型扩散模型 DiT,并训练了潜在扩散模型,用对潜在 patch 进行操作的 Transformer 替换常用的 U-Net 主干网络。他们通过以 Gflops 衡量的前向传递复杂度来分析扩散 Transformer (DiT) 的可扩展性。

在 Sora 出现之前,DiT 架构已用于文本条件式图像和视频生成。OpenAI 自己的解决方案是「视频压缩网络」,这可能是一个适用于视频的 VAE。基本思想与原始 DiT 相同:

- 视频压缩网络将原始视频输入压缩为潜在的时空表示;

- 压缩后的视频变为「时空 patch」,并作为输入 token 馈入到扩散 Transformer 中;

- 在最后一个 Transformer 块之后,解码器模型(与视频压缩网络联合训练)将生成的潜在表示映射回像素空间。

据我所知,这就是 Sora 背后的技术要点。因此,很多人认为 Sora 的架构没有什么真正的突破之处,本质上可能是一个视频 DiT 模型。Sora 很大程度上是一项工程壮举,也是缩放能力的另一个证明。随着训练算力的增加,样本质量随之提高。正如大语言模型一样,某些功能会随着规模的扩展而出现。

当然,Sora 受益于其他一些技巧,比如 DALL-E 3 首创的重字幕技术。OpenAI 训练了一个高度描述性的字幕生成器模型,并用它为 Sora 训练集中的所有视频添加字幕。这增加了生成的视频对复杂文本的遵循性。此外,Sora 模型的所有用户提示也通过 GPT 模型进行增强。

与其他 OpenAI 的模型一样,Sora 的一大未知是它的训练数据。事实上,很多人猜测 Sora 部分根据合成数据(尤其是虚拟引擎 5 等视频游戏引擎的输出)进行训练,这将有意义地促使该模型学习不同的配置(不同角度、场景构图、相机运动路径等)。这或许可以部分解释为什么 Sora 的输出如此一致。

我们需要记住的最后一件事是:与标准潜在扩散模型一样,视频压缩网络编码器和解码器之间的扩散过程完全发生在潜在空间中,而不是像素空间。

模拟假设

每个人都同意 Sora 是一个令人印象深刻的模型。但除了生成逼真视频之外,Sora 还有更深层的属性吗?OpenAI 团队似乎这样认为,他们在技术报告中称,Sora 获得了规模化的「模拟能力」,并通过动态相机运动、遮挡、物体存继性和视频游戏模拟来实现场景一致性。

OpenAI 得出结论,这些功能表明了,视频模型的继续扩展是开发物理和数字世界,以及生活在其中的物体、动物和人的高性能模拟器的一条有希望的路径。

我们可以将这一说法称为模拟假设,但该假设的问题在于它太模糊了。对于视频生成模型而言,模拟物理世界实际意味着什么?哪些证据可以支持这一说法?让我们一一来解答。

Sora 发布后,AI 领域的知名学者纷纷发表对模拟假设的看法。其中英伟达高级研究科学家 Jim Fan 将 Sora 描述为「数据驱动的物理引擎」,他的解释为 Sora 通过大量视频的梯度下降在神经参数中隐式地学习物理引擎。Sora 是一个可学习的模拟器或「世界模型」。

来源:https://twitter.com/DrJimFan/status/1758210245799920123

Sora 必须学习一些隐式的文本到 3D、3D 转换、光线追踪渲染和物理规则,以便尽可能准确地对视频像素进行建模。Sora 还必须学习游戏引擎的概念才能满足目标。

物理引擎术语有些令人困惑,尤其考虑到 Sora 可能是在虚拟引擎 5 的场景中接受训练的。我们首先需要澄清一点,即没有人(包括 Jim Fan)认真地暗示 Sora 在推理时确实有一个循环的物理引擎。换句话说,Sora 不会利用虚拟引擎的函数调用来生成视频。

这不仅仅因为我们完全不清楚它是如何工作的(资产、动画从哪里来),还因为 Sora 是一个 DiT 模型,而这些根本不是 DiT 的工作方式。

这里需要提一下,让神经网络调用物理引擎是以前尝试过的事情,但不是为了视频生成,而是为了物理推理。

此前,Ruibo Liu 等人(谷歌大脑团队、达特茅斯学院)在 2023 年发表的一篇论文《Mind's Eye: Grounded Language Model Reasoning through Simulation》中增强了一种语言模型,通过使用物理引擎(DeepMind 的 MuJoCo)模拟可能的结果,来提高在物理推理问题上的性能,并使用这些模拟的结果作为 prompt 中的提示。

论文地址:https://openreview.net/forum?id=4rXMRuoJlai

此外,MIT 的 Josh Tenenbaum 实验室对这一工作进行了探索,使用语言模型将自然语言查询转换成概率编程语言中的代码表达式。为了能够对语言中描述的物理现象进行推理,Lionel Wong 及其同事将一个物理模拟引擎集成到了这个框架中。

他们在概率生成程序中添加了一个 Simulate_physicals 函数,该函数采用指定对象属性(如位置和速度)的初始符号场景状态,并返回场景属性,这些属性在物理、建模运动和碰撞情况的基础上随时间更新。此外通过将物理模拟添加为函数调用,语言描述可以转换为查询,并对描述的物理情况如何随时间推移发挥作用进行推理。

论文地址:https://arxiv.org/pdf/2306.12672.pdf

这显然与 Sora 的做法相差甚远,Sora 是一个端到端的神经网络,而不是一个神经符号系统。那么,我们该如何理解 Sora 类似于模拟物理世界的「数据驱动的物理引擎」这一说法,来自谷歌 DeepMind 的高级 AI 总监 Nando de Freitas 表示,有限大小的神经网络在任何情况下可以预测接下来会发生什么的唯一方法是:学习促进此类预测的内部模型,包括直观的物理定律。

看来我们越来越接近模拟假设的明确定义了:在拥有有限参数集的端到端神经网络架构之上的足够好的视频生成模型,在训练中应该能够获得物理世界的内部模型。这是这类神经网络生成任意场景中的一致和逼真视频的最有效方法,也可能是唯一方法。

那么,Sora 是否真的从 2D 视频中归纳出物理定律呢?如前所述,这看起来可能就很荒谬。比如 Sora 会以某种方式获得热力学定律的内部模型,这似乎令人难以置信。游戏引擎通常也不模拟这些法则, 它们可能会模拟热效应(火灾、爆炸)和功(如物体克服摩擦移动),但这些模拟通常是高度抽象的,并不严格遵守热力学方程。并且游戏引擎也根本不需要这样做,它们的重点是渲染场景的视觉和交互可信度,而不是严格的物理准确性。

Sora 会做类似的事情吗?在回答这个问题之前,我们需要谈一谈直观物理学。

直观物理学

什么是直观物理学呢?对于人类而言,不仅仅是受过训练的物理学家,还包括外行甚至是婴儿,这些人都对物理世界有直观的理解。这就是认知科学家称为直观物理学的东西:一种快速、自动的日常推理,让人们知道各种物体相互作用时会发生什么,不需要有意识地思考物理计算。

研究表明,婴儿已经对物理世界的各个方面产生了稳定预期认知,包括物体持久性(即使看不见也知道物体的存在)、坚固性(物体不会相互洞穿)以及内聚力(物体是一起移动的连接整体)。即使在很小的时候,婴儿似乎也期待物体遵守某些物理原则,并将这些期望推广到新的物体,而不是必须单独学习每个特定物体的独特性。这是我们与生俱来的「核心知识」的一部分,而不是发展过程中学到的东西。

总之,人类很小的时候就非常善于理解物理世界及规则,无论与生俱来、还是后天习得,或者二者兼而有之。

如何做到的呢?认知科学中有一个重要假设:人们使用直观物理引擎(intuitive physics engine,IPE)在心理上模拟物理事件。该引擎近似现实中的物理动力学,并类似于计算机游戏中的物理引擎。

当我们观察物理场景时,可以根据嘈杂的感知证据来构建对物体、属性和作用力的心理表征,然后运行内部模拟来预测接下来发生什么。

图源:https://cicl.stanford.edu/papers/smith2023probabilistic.pdf

更准确的说,IPE 是一种生成因果模型,通过对不精确但大致准确的物理原理的随机模拟,将不可观测的物理变量和不确定性映射成可观测的物理现象。IPE 表示物理场景中物体的潜在物理变量(如质量、摩擦力、弹性)。这些变量不能直接观察到,但控制了物体在场景中的行为方式。

这里只关注对 IPE 假说的一个反对意见,它与视频生成模型的争论尤其相关。一些研究人员认为,人们对物理场景的判断有时仅取决于表面的视觉特征,而不是底层的物理特征。比如仅在静态图像上训练的 ResNet-50 等深度神经网络可以判断积木塔的稳定性,其表现可与成年人媲美。此外,人们被发现依赖积木塔的外观,而不是摩擦等物理约束,儿童则完全忽视形状。

IPE 假说支持者的普遍反应是,依赖启发式的证据可以简单地解释为限制 IPE 模拟的边界条件和机制。没有任何模型会声称自己可以无限制地使用物理模拟来处理所有抽象推理,近似是不可避免的。

因此我认为底线是:至少对于人类而言,人们很容易通过假设 IPE 的存在来解释直观的物理推理,而该 IPE 使用近似原理对物理场景进行概率心理模拟。这一假设仍然存在争议,并且有支持和反对的证据。但是,模拟假设至少有一个相对合理且经过深思熟虑的案例,还有丰富的实验文献支持。有了这些背景,接下来我们谈谈世界模型。

世界模型

「世界模型」一词是技术术语之一,其含义已被逐渐淡化,以致在实践中变得难以描述。

2018 年,Ha David、Schmidhuber Jürgen 合作撰写了一篇名为《World Models》的论文,在这篇文章中,世界模型包含一个感知组件,用于处理原始观察并将其压缩为紧凑编码。

Ha 和 Schmidhuber 关于世界模型的研究影响了后来许多作品。

我们以最近的研究来举例,几天前,Google DeepMind 推出了参数为 110 亿的基础世界模型 Genie,可以通过单张图像提示生成可玩的交互式环境。在如下动图中,谷歌先使用 Imagen2 生成图像,再使用 Genie 将它们变为动态方式:

另一位推崇世界模型的是 Yann LeCun,曾经提出了一种名为 JEPA(联合嵌入预测架构)的框架,在这一框架下,世界模型是一个内部预测模型,描述世界如何运作:

除此以外,在 Sora 模型发布的当天,Meta 推出了一个全新的无监督「视频预测模型」——V-JEPA,与 JEPA 一脉相承。

V-JEPA 和 Sora 之间的主要区别之一是它们各自的学习目标,以及这些目标可能对其潜在表示产生的下游影响。Sora 接受了像素空间中帧重建的训练,而 V-JEPA 接受了潜在空间中特征预测的训练。在 LeCun 看来,像素级生成目标不足以引发对世界中的规划和行动有用的抽象表示。

综合来看,人们对世界模型的理解略有不同。在强化学习(RL)中,世界模型主要关注以智能体为中心的预测,以及基于智能体行为对环境状态的模拟。在 Yann LeCun 对自主机器智能的构想中,世界模型同样关注以智能体为中心的预测,不过这里的预测是通过自监督在潜在空间中学习得到的。无论是生成模型、RL 模型还是 JEPA 模型,它们都没有达到因果推理文献中对世界模型强大因果概念的高标准。至于像 Sora 这样的视频生成模型,我们可以通过观察图像生成模型来寻找线索。

再看 Sora

与用于图像生成的潜在扩散模型一样,Sora 是根据视觉输入进行端到端训练的。训练和生成都不是明确地以物理变量为条件的。Sora 从根本上不同于使用物理引擎来运行模拟的复合模型。此外,Sora 在感知、预测和决策模块之间没有内置分离。

除此以外,Sora 与 Ha & Schmidhuber 的世界模型也有很大不同,它不会基于离散行为、观察和奖励信号的历史来运行模拟。在这方面,OpenAI 的技术报告在讨论通过提示生成视频示例时提到了《我的世界》(Minecraft),这有点误导。

Sora 可能模拟了离线强化学习中的智能体策略,但与 Genie 不同,Sora 没有接受过从视频中诱发潜在动作的训练,并且输出也不以此类动作为条件。

通过提示 Sora 生成的视频

然而,我们不能排除这样一个假设,Sora 是一个世界模拟器 —— 或者,稍微不那么夸张,在较弱意义上,它是一个世界模型。

然而这种观点受到了包括 LeCun、Gary Marcus 等在内的多位 AI 大佬的反对,这些批评者指出,Sora 生成的视频中公然违反了物理原理。不过 OpenAI 承认了这些局限,并提供了一些失败示例。例如,在下面示例中,人们可以看到明显的时空不一致,包括生成的视频违反重力、碰撞动力学、坚固性和物体持久性。

Sora 生成的视频违反重力和碰撞物理学

Sora 生成的视频中椅子自己飘起来了

这种视频的不一致性让我们感到不可思议,确实,示例中发生了一些奇怪的事情,如液体流过玻璃,椅子变成奇怪的形状,人在被遮挡时突然消失。

事实上,Sora 输出的结果很明显会在直观物理上出错。如果非要说 Sora 是一个较弱意义上的世界模型,那么它肯定不是一个完美的模型,甚至在各个方面都不完整。

与用于生成图像的潜在扩散模型一样,Sora 生成视频的过程并不发生在像素空间中,而是发生在潜在空间中 —— 时空 patch 潜在表示被编码的空间。

这一信息很重要,因为很多研究者认为 Sora 只是学习在逐帧像素变化中插入常见模式。Sora 架构中编码器和解码器之间发生的所有事情都发生在潜在空间中。对于 Sora 来说,直观物理相关的属性的潜在表示对于早期的生成过程(甚至在早期的扩散时间步长)具有因果效力,这并非难以置信。

结论

视频生成模型如 Sora 到底是不是世界模拟器,也许在某种意义上答案是肯定的。其视频生成过程不以直观物理的前向模拟为条件,而直观物理引擎可以做到这一点,但 Sora 有可能是由 3D 几何和动力学潜在表征塑造出来的。在后一种意义上,认为 Sora 是有限的世界模型是相当合理的。但这些都不能确定,我们需要用更多的方式探索 Sora。

在猜测的同时,我对视频生成模型的未来进行了一些预测。

我认为 Sora 不是一个特定意义上的模拟器,也许是一个功能更强大的视频生成模型。可以想象未来机器人系统会使用三个主要组件:(1)大规模视觉 - 语言模型,用于解析语言指令、翻译成规划并对视觉输入进行推理;(2)大规模视频生成模型,用于模拟未来可能的观察结果,以进行低级规划;(3) 通用可逆动力学模型,用于从这些模拟中提取合适的动作并相应地执行规划。也许(2)和(3)可以合并成一个通用的 Genie 风格的生成模型,或者三个模型都可以合并成一个巨大的 Gato 式多模态模型。

不管怎样,无论人们如何看待 Sora 和 OpenAI,思考视频生成背后的魔法都是令人兴奋 。

参考链接:https://artificialcognition.net/posts/video-generation-world-simulators/。