自美国OpenAI公司推出的ChatGPT风靡全球,并引发新一轮人工智能浪潮,国内外科技巨头争相布局大模型领域。

此次,钛媒体AGI梳理了2023年至今,阿里、百度、字节、腾讯、华为、小红书、美图、科大讯飞、三六零8家互联网科技公司在 AI 领域的最新技术成果,共计包含50款AI大模型及AI应用,以帮助读者快速了解互联网大厂在AI领域的最新技术动向。

阿里巴巴

2024年3月

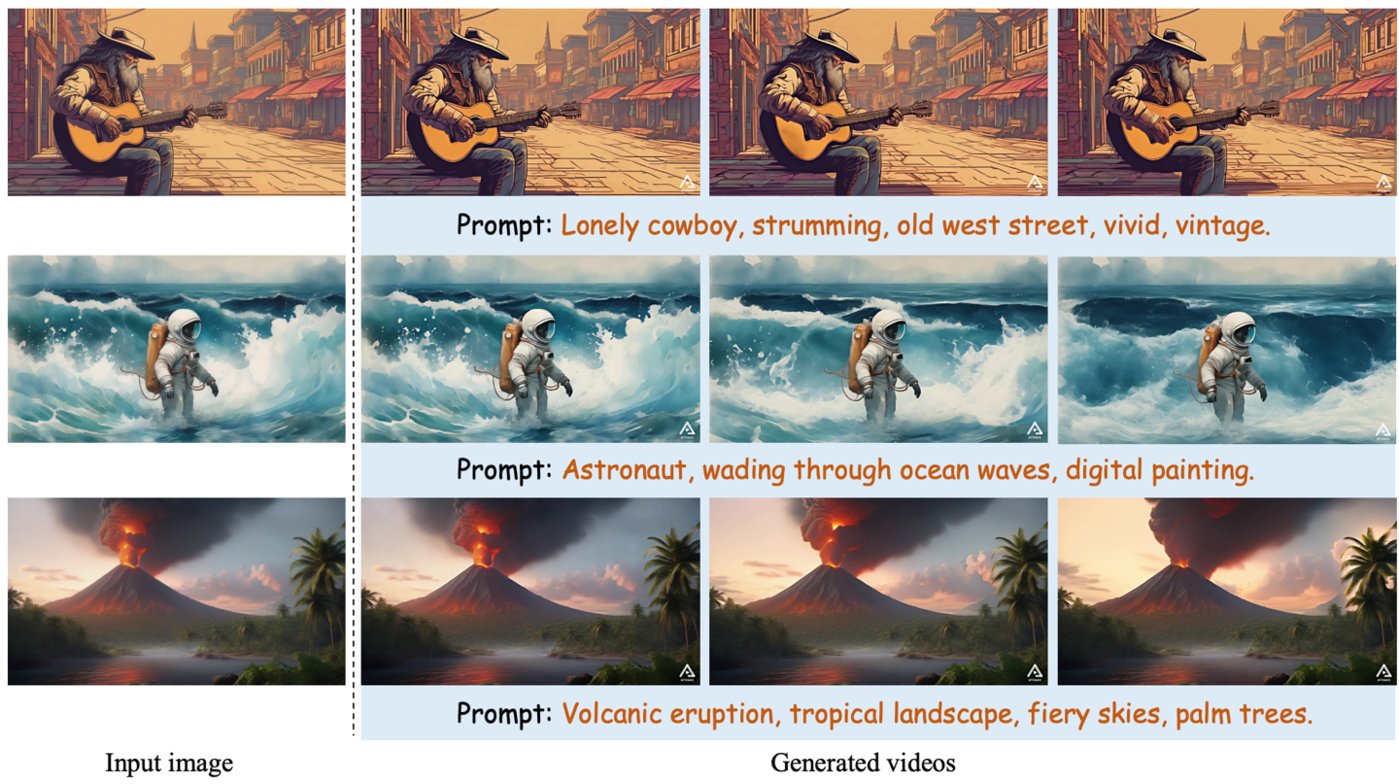

中国版“Sora”,文生视频框架——AtomoVideo

产品介绍:AtomoVideo是阿里巴巴推出的一个高保真图像视频生成框架,该框架利用高质量的数据集和训练策略,保持了时间性、运动强度、一致性和稳定性,并具有高灵活性,可应用于长序列视频预测任务。

因与Open AI此前推出的文生视频模型Sora功能相似,AtomoVideo也被称为中国版“Sora"。

产品功能:用户只需上传一张照片就能生成对应的视频。据悉AtomoVideo的核心在于多粒度图像注入技术,这一技术使得生成的视频对于给定的图像具有更高的保真度,能够更好地保留原始图像的细节和特征,从而使得生成的视频更加逼真。

另外,AtomoVideo的架构也具有很高的灵活性,它可以灵活地扩展到视频帧预测任务,通过迭代生成实现长序列预测,使得AtomoVideo在处理长序列的视频预测任务时,也能够保持良好的性能。

目前,阿里只发布了AtomoVideo的论文,代码,试玩页面还未公布。

适用人群或场景:视频创作者、影视拍摄

论文地址:https://arxiv.org/abs/2403.01800

电商人的AIGC创作平台——绘蛙

产品介绍:绘蛙是阿里AI电商团队针对淘宝、电商达人推出的一款可以生成文案和图片的智能创作平台,旨在提升电商营销效率。

产品功能:主要是AI文案生成和AI图片生成。在AI文案中,商家可以实现单商品种草、小红书爆文改写、穿搭分享等。以爆文改写为例,商家只需输入参考笔记内容,然后添加种草商品卖点、人设、笔记话题,即可生成小红书风格文案。

AI生图中,用户可以通过选择商品、选择模特和选择参考图生成自己想要的商品图片,支持自己上传模特图,也有自带的数字模特库可供使用,可以定制专属自己的AI模特,帮助商家节省商品拍摄和模特成本。

适用人群:淘宝、天猫店家、带货主播、电商达人

上线时间:未知

体验地址:https://www.ihuiwa.com/(需邀请码)

AI 图片-音频-视频模型——EMO

产品介绍:EMO是阿里巴巴推出的AI图片-音频-视频模型,该模型采用了 Stable Diffusion 的生成能力和 Audio2Video 扩散模型,能够生成富有表现力的人像视频。

不同于 OpenAI 的文生视频模型 Sora,EMO 主攻的是直接以图+音频生成视频方向,能够直接从给定的图像和音频,剪辑生成一段带有丰富人物表情的人物头部视频。

产品功能:用户只需要上传一张照片和一段任意音频,EMO就可以根据图片和音频生成一段会说话唱歌的AI视频。视频中人物具备丰富流畅的面部表情,能做到人物开口说话和唱歌时和和音频保持一致,最长时间可达1分30秒左右。

比如,你可以上传一张高启强的照片+一段罗翔老师的音频,就能得到一段“高启强普法”视频。或者,你可以上传一张蒙娜丽莎的照片,让蒙娜丽莎给你唱现代歌曲,唱rap等。

适用人群:有演讲需求人群、电商主播、视频自媒体及讲师等

GitHub:https://github.com/HumanAIGC/EMO

论文地址:https://arxiv.org/abs/2402.17485

项目主页: https://humanaigc.github.io/emote-portrait-alive/

2024年1月

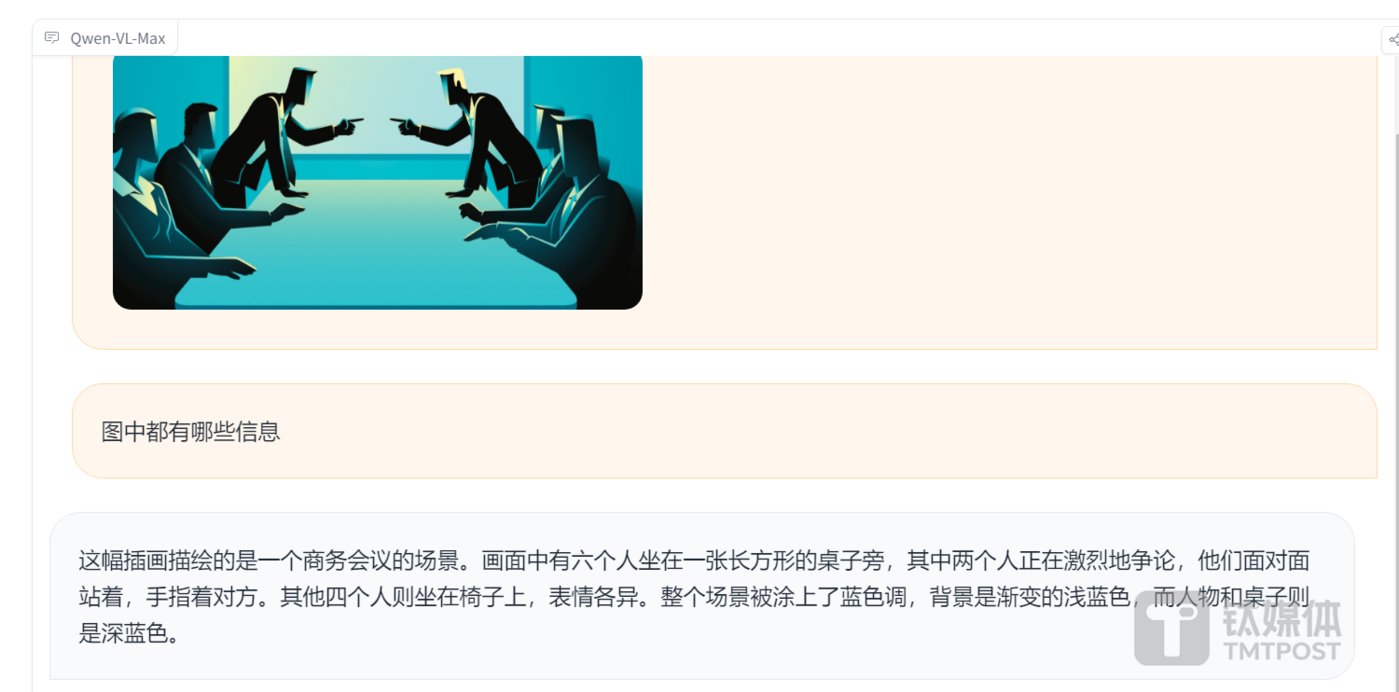

性能堪比Gemini Ultra的多模态大模型——Qwen-VL-Max

产品介绍:Qwen-VL是阿里推出的开源多模态视觉模型,2024年1月,继Plus版本之后,阿里又推出了Qwen-VL-Max版本。

产品功能:基础能力方面,Qwen-VL-Max能够准确描述和识别图片信息,并根据图片进行信息推理和扩展创作。这一特性使得该模型在多个权威测评中表现出色,整体性能堪比GPT-4V和Gemini Ultra。

视觉推理方面,Qwen-VL-Max可以理解并分析复杂的图片信息,包括识人、答题、创作和写代码等任务。同时该模型还具备视觉定位功能,可根据画面指定区域进行问答。

此外,Qwen-VL-Max在图像文本处理方面也取得了显著进步,中英文文本识别能力显著提高,支持百万像素以上的高清分辨率图和极端宽高比的图像,不仅能完整复现密集文本,还能从表格和文档中提取信息。

体验地址:https://huggingface.co/spaces/Qwen/Qwen-VL-Max

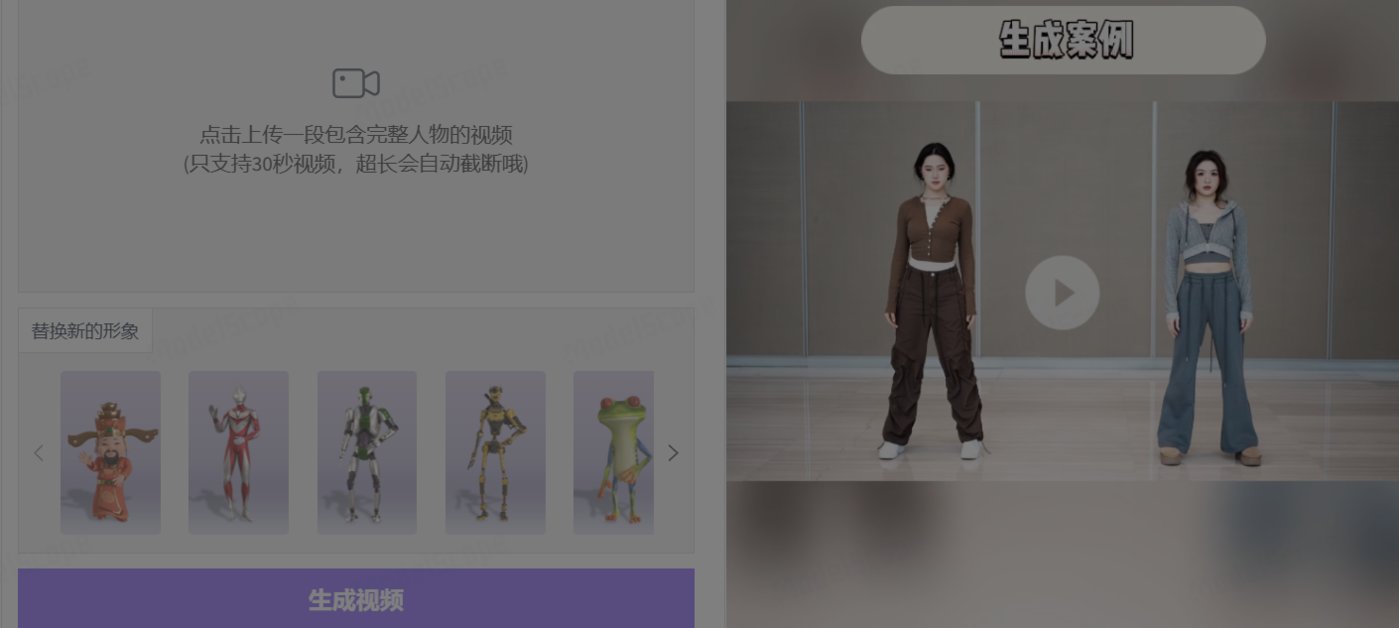

AI 生成3D动画工具——Motionshop

产品介绍:Motionshop是阿里巴巴智能计算研究院推出的一个AI角色动画框架,该框架利用视频处理、角色检测/分割/追踪、姿态分析、模型提取和动画渲染等多种技术,使得动态视频中的主角能够轻松跨越现实与虚拟的界限,一键变身为3D角色模型且不改变视频中的其他场景和人物。

产品功能:用户只需上传视频,AI便能智能识别视频中的主要人物,并将其无缝转换为生动的3D角色模型。同时保持视频中人物动作同步与真实感,能精确复刻原视频中人物的动作细节,确保3D角色的动作流畅自然,提供高度逼真的视觉效果。此外,Motionshop能将现实世界的人物与3D虚拟角色得以完美融合,创造出跨越现实与虚拟界限的全新体验,为视频内容增添无限可能。

适用人群或场景:视频内容生产者、影视拍摄

项目主页: https://aigc3d.github.io/motionshop/

体验地址:https://www.modelscope.cn/studios/Damo_XR_Lab/motionshop/summary

能让图片开口说话、唱歌的模型框架——DreamTalk

产品介绍:DreamTalk是由清华大学、阿里巴巴和华中科大共同开发的一个可以让人物照片开口说话、唱歌的模型框架。

产品功能:上传一张照片和音频,DreamTalk能够生成人物脸部动作看起来很真实的高质量视频,而且嘴唇动作能和音频都能一一对应。同时DreamTalk还支持多种语言,无论是中文、英文还是其他语言都能很好地同步。

据悉,DreamTalk 由三个关键组件组成:降噪网络、风格感知唇部专家和风格预测器。通过三项技术结合的方式,DreamTalk 能够生成具有多种说话风格的逼真说话面孔,并实现准确的嘴唇动作。

适用人群或场景:演讲、产品讲解、开会,直播、电商、线上授课等

项目主页: https://dreamtalk-project.github.io/

论文地址: https://arxiv.org/pdf/2312.09767.pdfGithub

地址: https://github.com/ali-vilab/dreamtalk

2023年12月

可控视频生成框架——DreamMoving

产品介绍:DreaMoving是一种基于扩散模型打造的可控视频生成框架,通过图文就能制作高质量人类跳舞视频。

产品功能:用户只需上传一张人像,以及一段提示词,就能生成对应的视频,而且改变提示词,生成的人物的背景和身上的衣服也会跟着变化。简单来说就是,一张图、一句话就能让任何人或角色在任何场景里跳舞。

适用人群或场景:娱乐主播、视频制作

论文链接:https://arxiv.org/pdf/2311.17117.pdf

项目地址:https://humanaigc.github.io/animate-anyone/

体验地址:https://huggingface.co/spaces/xunsong/Moore-AnimateAnyone

2023年11月

文生视频模型——I2VGen-XL

产品介绍:I2VGen-XL是阿里云推出的一款高清图像生成视频模型,这款模型的核心组件由两个部分构成,用以解决语义一致性和清晰度问题。

产品功能:用户只需上传一张图片,即可生成一段分辨率为1280*720的高清视频。由于在大规模混合视频和图像数据上进行了预训练,并在少量高质量数据集上进行了微调,这些数据集具有广泛的分布和多样的类别,这使得I2VGen-XL展示了良好的泛化能力,适用于不同类型的数据。

此外,为了提高视频质量,该研究训练了一个单独的 VLDM,专门处理高质量、高分辨率数据,并对第一阶段生成的视频采用 SDEdit 引入的噪声去噪过程。

视频生成效果方面,与 Gen2、Pika 生成效果相比, I2VGen-XL 生成的视频动作更加丰富,主要表现在更真实、更多样的动作,而 Gen-2 和 Pika 生成的视频似乎更接近静态。

使用人群及场景:视频内容创作者、影视制作

项目地址:https://i2vgen-xl.github.io/

论文地址:https://arxiv.org/abs/2311.04145

Github:https://arxiv.org/abs/2311.04145

开源的图像到视频动画合成框架——AnimateAnyone

产品介绍:Animate Anyone是一款能将静态图像转换为角色视频的模型框架。该框架在扩散模型的基础之上,引入了ReferenceNet、Pose Guider姿态引导器和时序生成模块等技术,以实现照片动起来时保持一致性、可控性和稳定性,输出高质量的动态化视频。

产品功能:角色视频生成,利用驱动信号从静态图像生成逼真的角色视频;扩散模型支持,借助扩散模型的力量,提供高质量的动画效果;ReferenceNet设计,通过空间注意力合并详细特征,保持外观特征的一致性;姿势指导器,引入高效的姿势指导器,确保角色动作的可控性和连续性;平滑过渡:采用有效的时间建模方法,保证视频帧之间的平滑过渡。

目前,Animate Anyone已在GitHub上斩获了近1.3万个星标,并在国内外引起了热烈讨论。

适用人群或场景:时尚行业,展示服装、造型;视频内容创作者、电商、舞者

论文链接:https://arxiv.org/pdf/2311.17117.pdf

项目链接:https://humanaigc.github.io/animate-anyone/

2023年4-7月

通义系列大模型——通义千问、通义万相和通义听悟

产品介绍:通义千问是阿里自研的 AI 大语言模型,可以帮助用户解决生活和工作中的问题,提供智能问答服务。2023年10月31日,通义千问2.0正式发布,阿里也随之推出通义千问App。相较于1.0版本,通义千问2.0在复杂指令理解、文学创作、通用数学、知识记忆、幻觉抵御等能力上均有显著提升。

通义万相是阿里通义大模型家族中的一款AI绘画大模型,可辅助人类进行图片创作。基于阿里研发的组合式生成模型Composer,通义万相提出了基于扩散模型的「组合式生成」框架,通过对配色、布局、风格等图像设计元素进行拆解和组合,提供了高度可控性和极大自由度的图像生成效果。

通义听悟是是依托通义千问大模型和音视频AI模型的AI助手,旨在帮助用户及客户在泛音视频内容场景下提升信息生产、整理、挖掘、洞察效率。

产品功能:通义千问具备多轮对话、文案创作、逻辑推理、多模态理解及多语言支持等功能。用户可以就任何问题与其对话互动,比如可以问他生活类常识、讲故事、写作文或文案、解答数学题等,但通义千问不具备多模态能力,不具备图像生成功能。

通义万相主要功能有三个,即文生图、相似图生成和风格迁移。在基础文生图功能中,可根据用户提示词生成水彩、扁平插画、二次元、油画、3D卡通画等风格图像;相似图片生成功能中,用户上传任意图片后,即可进行创意发散,生成内容、风格相似的AI画作。此外该模型还支持图像风格迁移,用户上传原图和风格图,可自动把原图处理为指定的风格图。

通义听悟融合融合了十多项 AI 功能,面向线上线下各种泛音视频场景,通义听悟可以提供音视频内容的实时字幕 / 转写、多语言翻译、内容理解 / 摘要,涵盖全文概要、章节速览、发言总结等高阶 AI 功能。

适用人群或场景:通义千问适用人群较为广泛,通义万相适用于艺术绘画创作,设计师、动漫爱好者;通义听悟可应用于智能客服、智能家居、智能音箱、智能穿戴设备等领域。

通义千问体验地址:https://tongyi.aliyun.com/qianwen/

通义万相体验地址:https://tongyi.aliyun.com/wanxiang/

通义听悟体验地址:https://tingwu.aliyun.com/home

百度

2024年1月

统一模态视频生成系统——UniVG

产品介绍:UniVG是百度推出的一款统一模态视频生成系统,其独特之处在于针对高自由度和低自由度两种任务采用不同的生成方式,以更好地平衡两者之间的关系。

产品功能:用户只需提供一张图片或一段文字,就能生成一段流畅的视频,与早期的AI视频生成工具相比,UniVG所生成的每一帧画面都更加稳定、连贯。

据悉,UniVG系统引入了“多条件交叉注意力”技术,用于高自由度视频生成,以生成与输入图像或文本语义一致的视频。而在低自由度视频生成方面,采用了“偏置高斯噪声”的方法,相较于传统的完全随机高斯噪声更能有效地保留输入条件的原始内容。

适用人群及场景:视频内容创作者

项目地址:https://top.aibase.com/tool/univg

项目演示页面: https://univg-baidu.github.io/

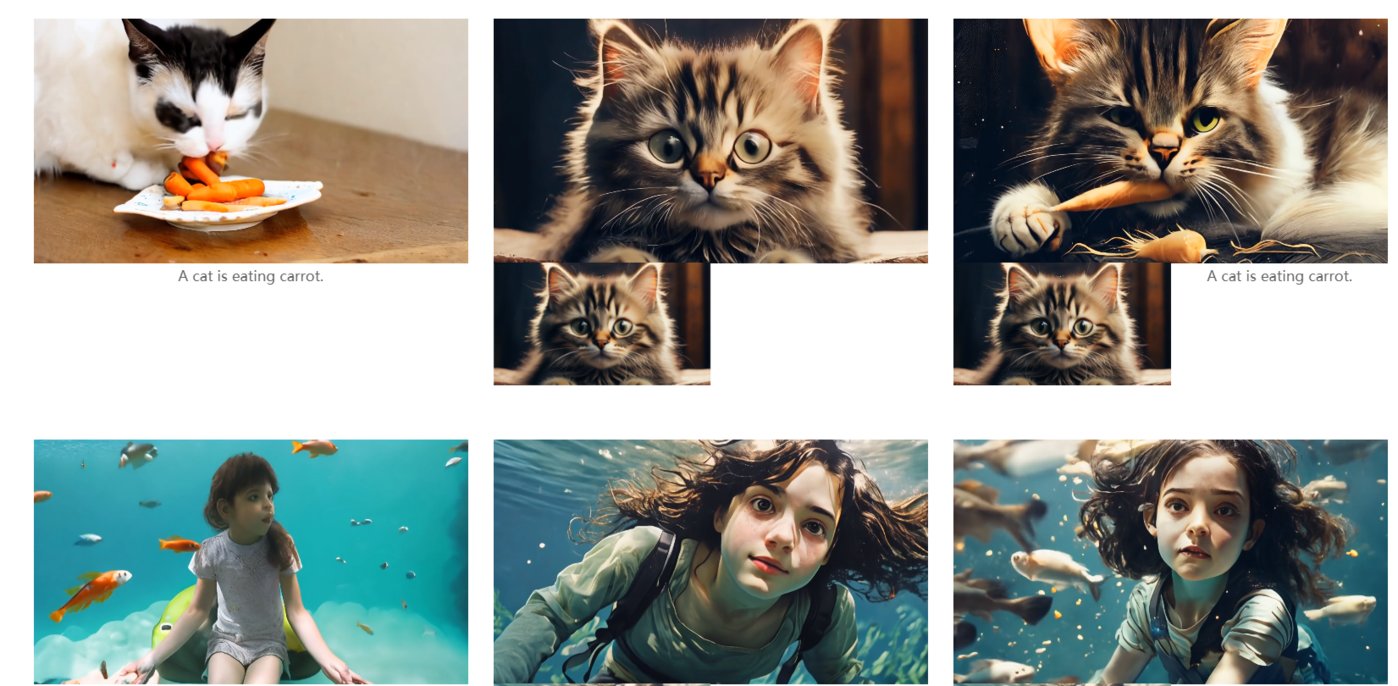

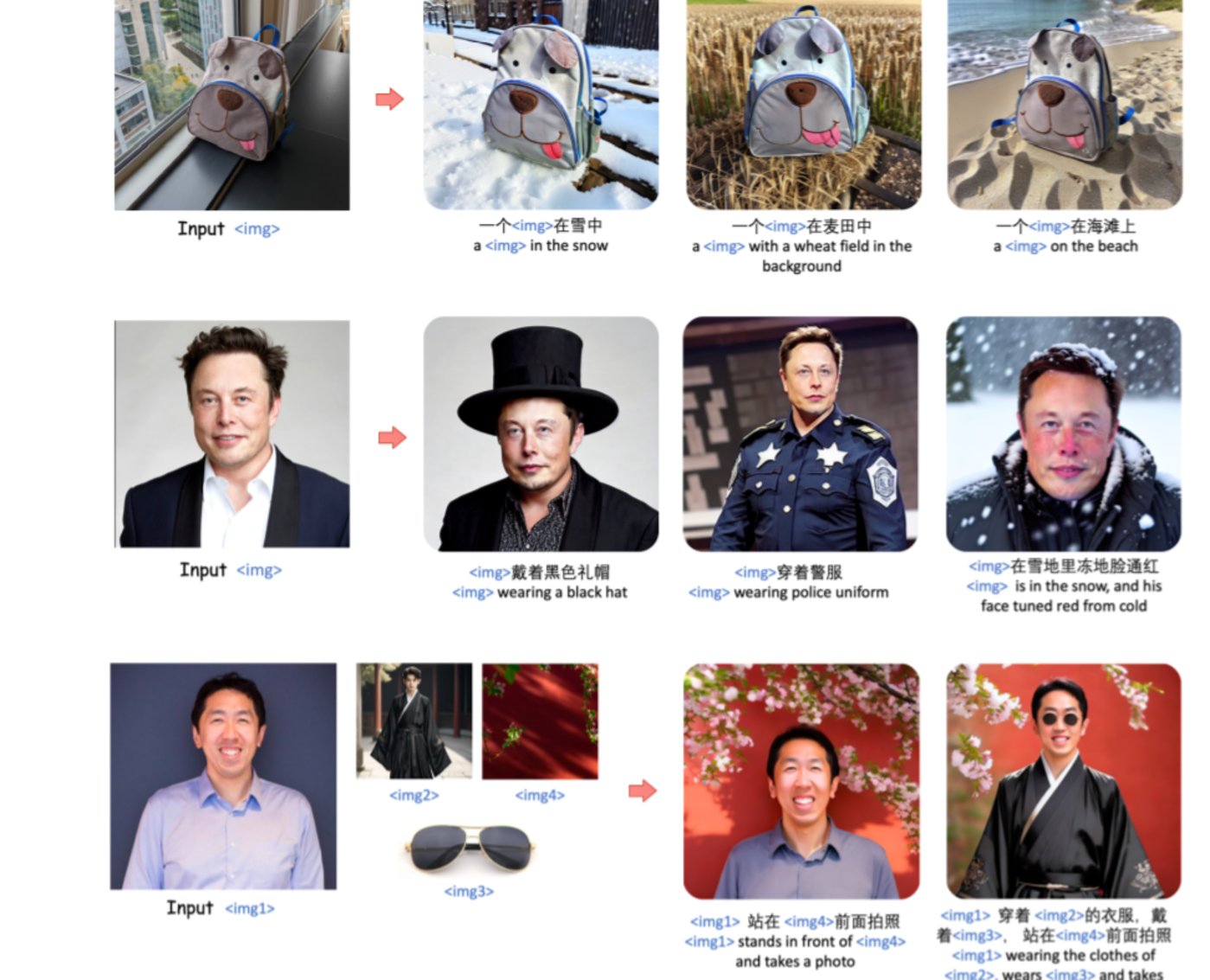

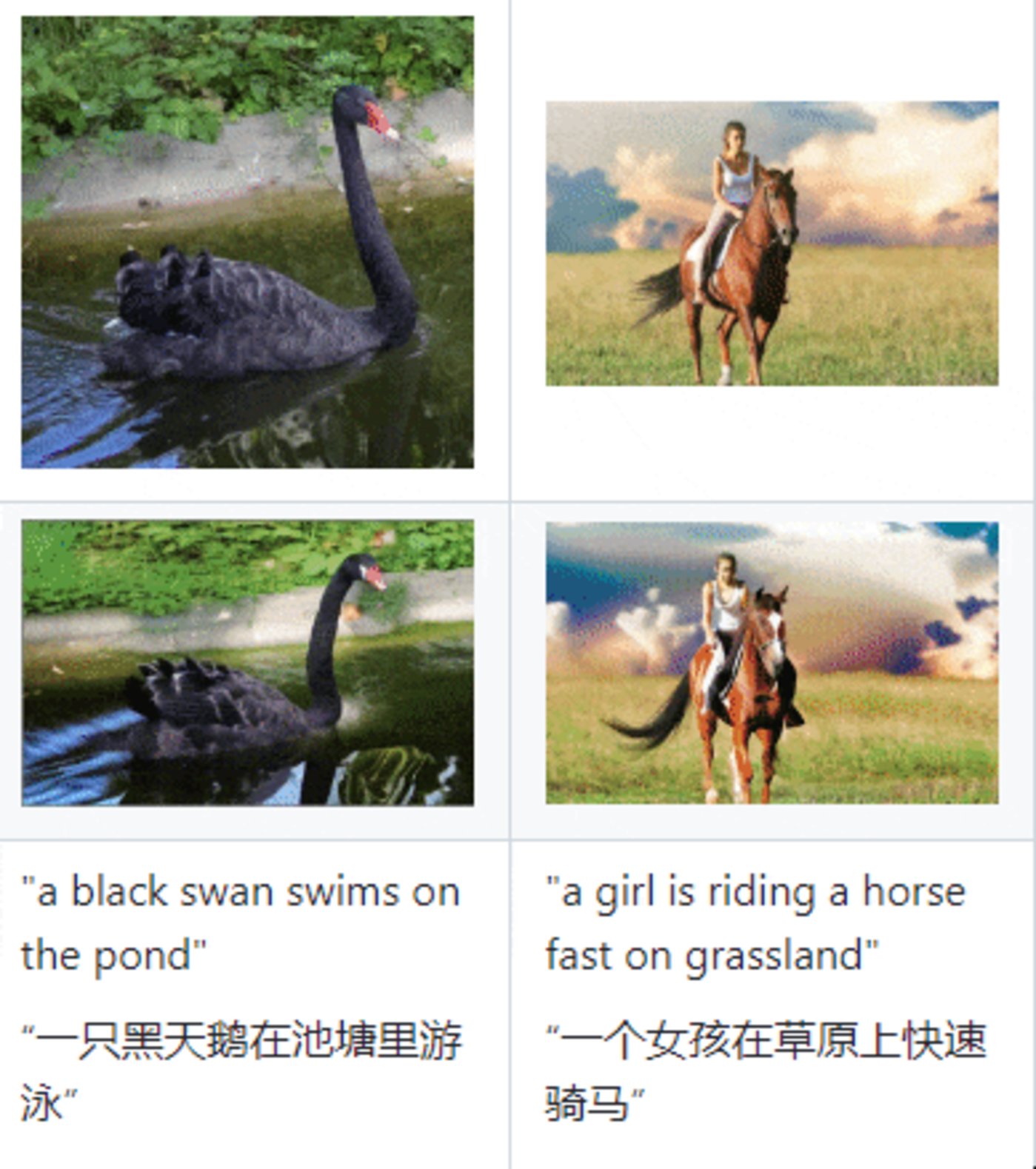

统一图像生成框架——UNIMO-G

产品介绍:百度推出的UNIMO-G统一图像生成框架,通过多模态条件扩散实现文本到图像生成,克服了文本描述简洁性对生成复杂细节图像的挑战。

产品功能:用户只要给出一张图,然后给出各种提示词,UNIMO-G就能根据提示词在图像基础上按照提示生成对应图像,比如上传一张马斯克图像,输入提示词给他穿上警服,就能得到一张身穿警服的马斯克图像。

据了解,UNIMO-G的核心组件包括多模态大语言模型和基于编码的多模态输入生成图像的条件去噪扩散网络。这一框架还采用了精心设计的数据处理管道,涉及语言基础和图像分割,用以构建多模态提示。

在测试中,UNIMO-G在文本到图像生成和零样本主题驱动合成方面表现卓越,特别是在处理包含多个图像实体的复杂多模态提示时,生成高保真图像的效果显著。

适用人群及场景:艺术创作者、漫画爱好者、摄影师

项目地址:https://top.aibase.com/tool/unimo-g

论文地址:https://arxiv.org/pdf/2401.13388.pdf

2023年3月

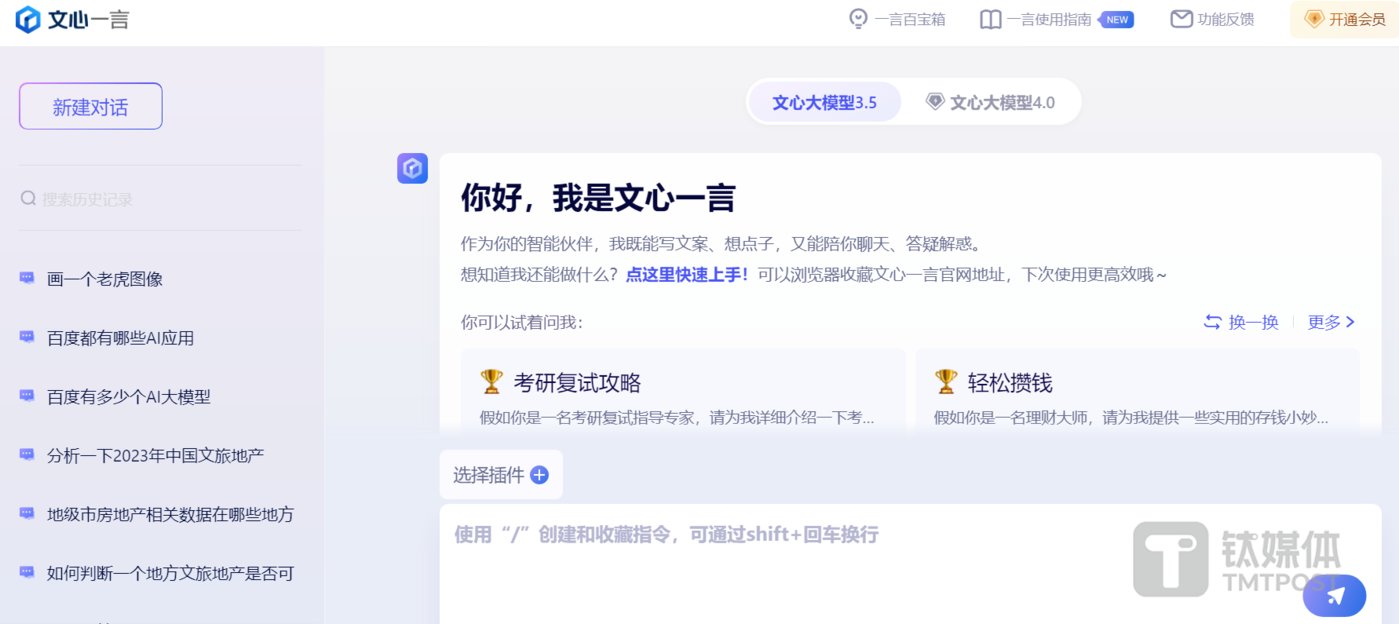

文心大模型系列产品——文心一言、文心一格和文心千帆

产品介绍:文心大模型是百度于2019年推出的自然语言处理大模型。该模型基于ERNIE系列模型具备跨模态、跨语言的深度语义理解与生成能力。2023年10月,文心大模型4.0 版本发布,实现基础模型的全面升级,理解、生成、逻辑、记忆四大能力显著提升,综合能力可直接对标GPT-4。

文心一言是百度基于文心大模型打造的生成式AI产品,与阿里的”通义千问”类似,可以进行任何内容的问答对话,可作为生活中的智能小助手。

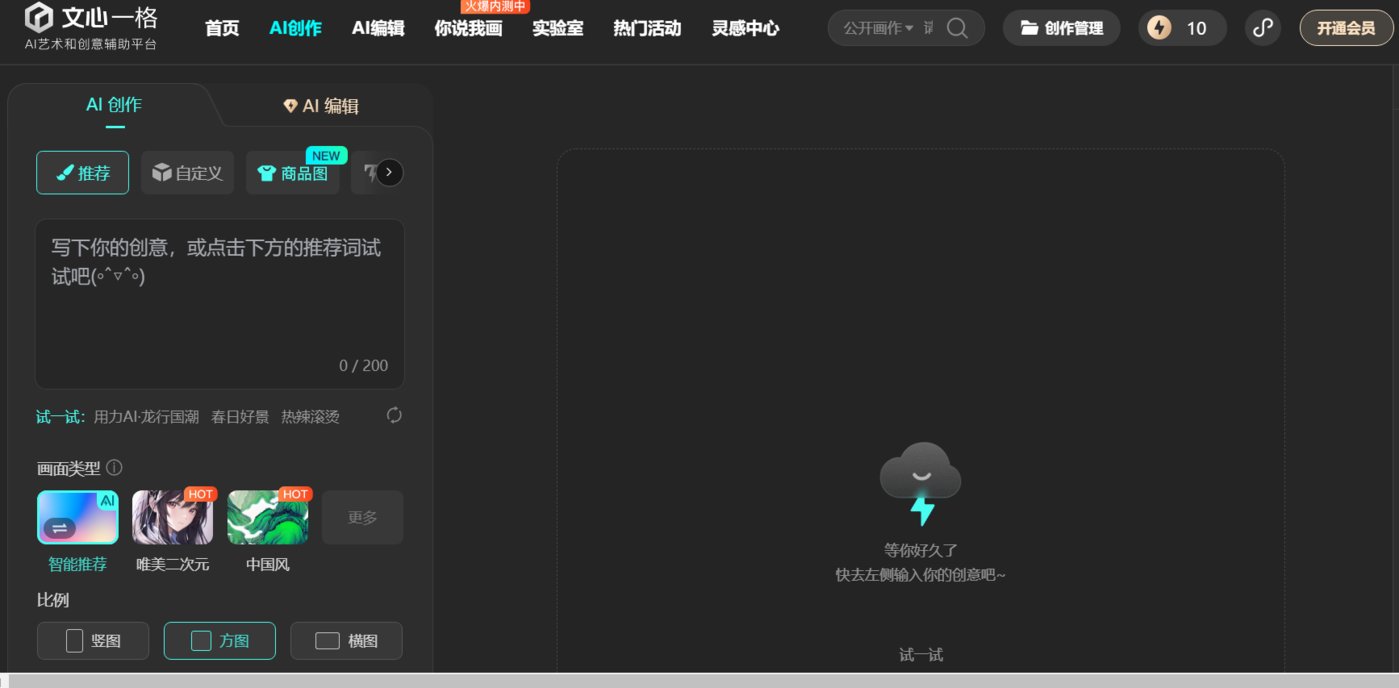

文心一格是百度基于文心大模型推出的AI艺术创作平台,可以生成多样化AI创意图片,辅助创意设计。

文心千帆是百度旗下企业级大模型生产平台,提供包括文心一言在内的大模型服务及第三方大模型服务,还提供大模型开发和应用的整套工具链。

产品功能:文心一言具有文学创作、商业文案创作、数理逻辑推算、中文理解、音频、图像生成等多模态生成能力。比如用户可以用文心一言解答任何生活及工作问题,帮助用户撰写任何领域的文案,解答数学逻辑题,用语音讲故事等。

文心一格的主要功能就是图像生成功能。用户只需要输入一句话或提示词,文心一格就能按照指示自动生成图像,且用户可以追加更详细的提示词对图像进一步优化或改变图像风格等。同时文心一格还具有二次编辑图片和图片叠加功能,比如可以涂抹掉图像中不满意的部分,让模型重新调整生成。或者给出两张图片,模型会自动生成一张叠加后的创意图。此外,文心一格还推出了海报创作、图片扩展和提升图片清晰度等功能,提供多种生图服务满足用户需求。

文心千帆主要功能有两个:其一是文心千帆以文心一言为核心,为企业提供大模型服务,帮助客户改造产品和生产流程。其二,作为一个大模型生产平台,企业可以在文心千帆上基于任何开源或闭源的大模型,开发自己的专属大模型。

适用人群及场景:文心一言受众群体广泛,文心一格适合有绘画创作和图像设计需求群体。文心千帆主要面向企业级B端客户。

体验地址:

文心一格:https://yige.baidu.com/creation

文心千帆:https://cloud.baidu.com/product/wenxinworkshop

字节跳动

2024年2月

字节版DALL·E文生图模型——SDXL-Lightning

产品介绍:SDXL-Lightning是一款由字节跳动开发的开源免费的文生图模型,能根据文本快速生成相应的高分辨率图像。

产品功能:用户在SDXL-Lightning上输入提示词,然后选择推理步骤(选择范围为1步—8步),等待数秒即可生成一张高清图像。

与以往的文生图模型相比,SDXL-Lightning的生成速度有显著提高,能够在最少步骤内完成文本到1024px分辨率图像的生成,适用于需要快速响应的应用场景。

SDXL-Lightning的生成速度之所以能够显著提升,主要是因为它通过结合渐进式蒸馏和对抗式蒸馏的方法,解决了扩散模型在生成过程中存在的速度慢和计算成本高的问题,同时保持生成图像的高质量和多样性,避免了传统蒸馏方法中存在的图像模糊问题。

使用SDXL-Lightning模型,可在几秒钟之内生成高达1024像素分辨率的图像。目前,该模型已经在Hugging Face平台上开源,并且下载量超过2200次,登上了Hugging Face流行趋势第三名,超越了gemma-2b,仅次于最新的谷歌gemma-7b,以及stabilityai/stable-cascade。

适用人群或场景:视频内容创作者、影视制作

体验地址:https://huggingface.co/spaces/AP123/SDXL-Lightning

文生视频模型——Boximator

产品介绍:Boximator是字节跳动推出的一款文生视频模型。与Gen-2、Pink1.0等模型不同的是,Boximator可以通过文本精准控制生成视频中人物或物体的动作。

产品功能:与Open AI发布的文生视频模型类似,Boximator也是通过用户给出文字描述或提示,就能按照指示生成对应的视频。据了解,为了实现对视频中物体、人物的动作控制,Boximator使用了“软框”和“硬框”两种约束方法。

硬框可精确定义目标对象的边界框。用户可以在图片中画出感兴趣的对象,Boximator会将其视为硬框约束,在之后的帧中精准定位该对象的位置。

软框定义一个对象可能存在的区域,形成一个宽松的边界框。对象需要停留在这个区域内,但位置可以有一定变化,实现适度的随机性。

两类框都包含目标对象的ID,用于在不同帧中跟踪同一对象。此外,框还包含坐标、类型等信息的编码。

不过,据字节跳动相关人士称,Boximator是视频生成领域控制对象运动的技术方法研究项目,目前还无法作为完善的产品落地,距离国外领先的视频生成模型在画面质量、保真率、视频时长等方面还有很大差距。

适用人群或场景:短视频创作者、影视制作

论文地址: https://arxiv.org/abs/2402.01566

项目地址: https://boximator.github.io/

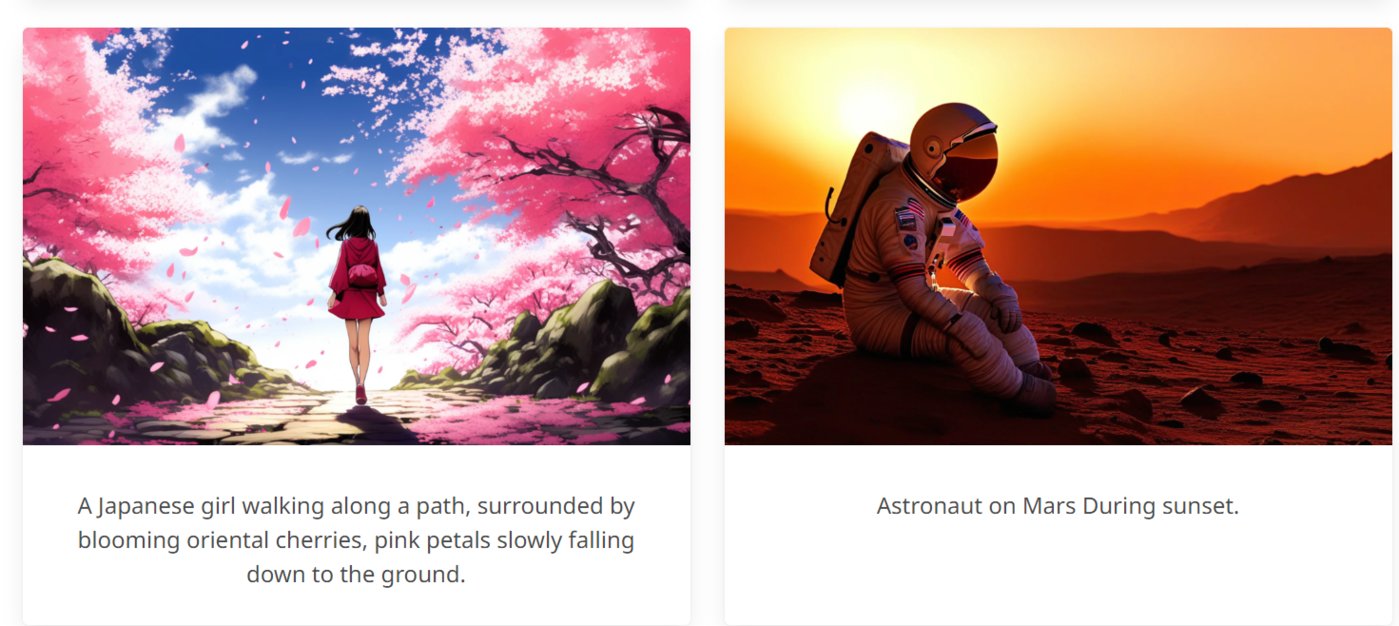

文生图AIGC工具——Dreamina

产品介绍:Dreamina是字节跳动旗下的AIGC工具,可以根据用户的文字提示生成创意图片。

产品功能:用户只需输入一段文字,Dreamina即可生成四幅由AI生成的创意图像。同时Dreamina支持多种图像风格,包括抽象、写实等,以满足不同用户的审美需求。此外,Dreamina还具备图像调整功能,用户可以对生成的图片进行修整,包括调整图片的大小比例和选择不同的模板类型。这种灵活性使得用户可以根据个人喜好或特定需求调整生成的图像。

适用人群或场景:艺术创作者、漫画爱好者

体验地址:https://dreamina.jianying.com/ai-tool/platform

AI 开发平台——Coze扣子

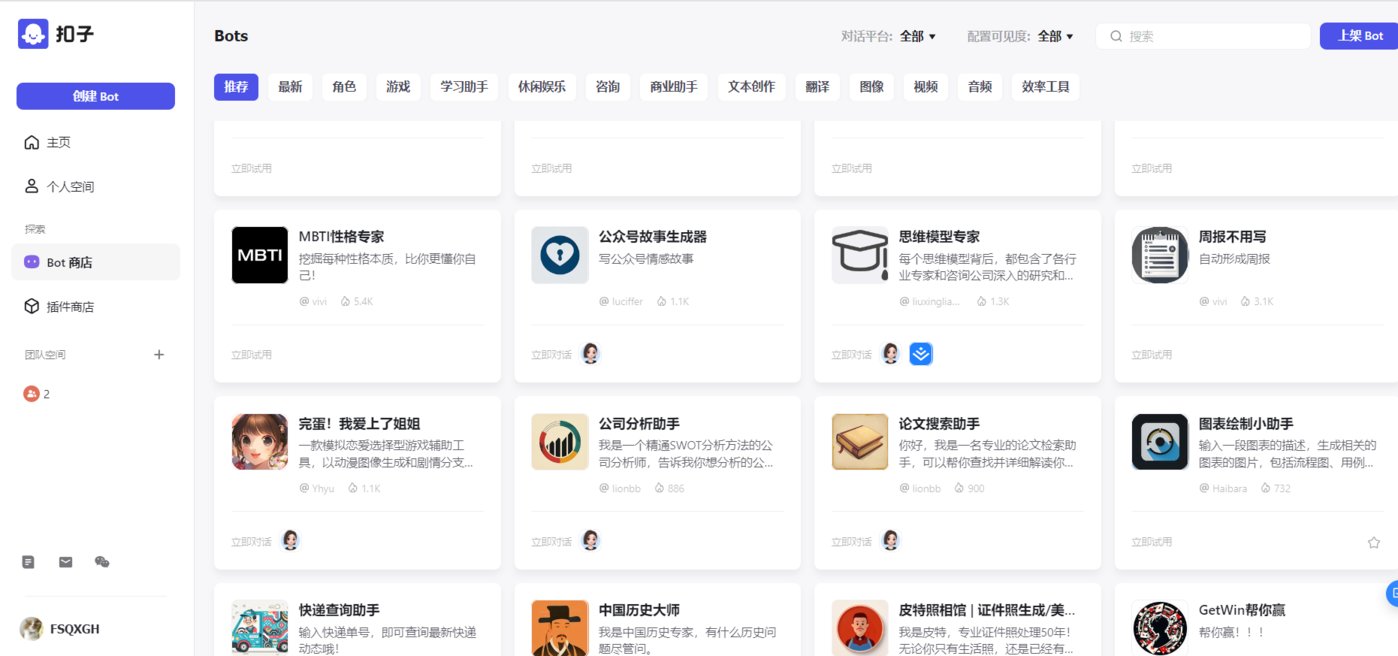

产品介绍:Coze扣子是字节跳动AI部门Flow开发的一站式 AI 开发平台,无论用户是否有编程基础,都可以利用Coze在30秒内轻松创建专属自己的“AI机器人”。

产品功能:在注册、登陆账号之后,用户可以通过首页超过60个的插件能力,以及创建Bot,实现多个能力应用。例如,我们希望有一个“新闻搜索助手”,通过简单的对话在30秒内就可以自动生成一个 AI 机器人,不需要任何代码编程,小白也能轻松上手。

同时,“扣子”平台也有一些自带的bot,涵盖旅游、出行和娱乐等场景,可以直接点击使用,而且还具备可无限扩展的能力集,全面实现个性化定义 AI 机器人技术能力。

此外,coze还支持上传创建自己所需bot的数据,可以与自己的数据进行交互,并且扣子还具备长期的对话记忆能力,通过数据交互和持久记忆为用户提供更加精准的回答。

适用人群或场景:所有用户都可适用

体验地址:https://www.coze.cn/store/bot

2024年1月

AI视频生成模型——MagicVideo-V2

产品介绍:MagicVideo-V2 是字节推出的AI视频生成模型,它将文本到图像模型、视频运动发生器、参考图像嵌入模块和帧插值模块集成到端到端视频生成管道中。这种结构使 MagicVideo-V2 能够制作高分辨率、美观的视频,并具有出色的保真度和流畅度。

产品功能:文本转图像功能,MagicVideo-V2 拥有先进的文本到图像模型,可以将文字转换为图像元素,为生成视频提供基础素材;视频运动生成功能:利用视频运动生成器,可以自动生成视频,节省用户的时间和精力;参考图像嵌入功能,MagicVideo-V2 支持参考图像嵌入功能,在生成视频时可以参考指定图像,使视频内容更加准确和多样化。此外,MagicVideo-V2 的帧插值模块能够平滑过渡视频中的每一帧,使生成的视频更加流畅和连贯。

适用人群或场景:电影制作、创意广告视频、创意短片

论文地址:https://arxiv.org/abs/2401.04468

项目网站:https://magicvideov2.github.io

2023年12月

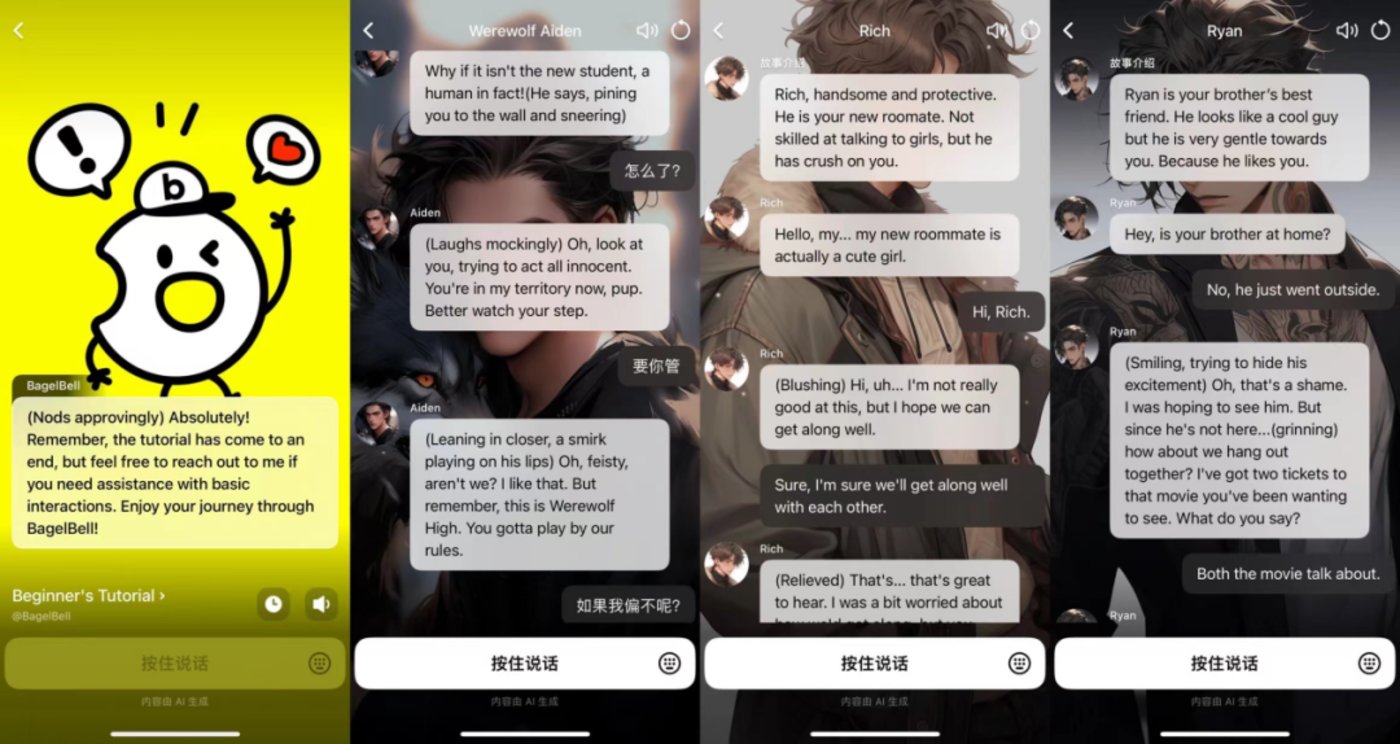

AI 剧情互动平台——BagelBell

产品介绍:BagelBell是字节推出的一款AI 剧情互动平台,用户可以通过 AI 身份图、故事名称和故事介绍了解不同的 AI 故事并与自己喜欢的故事互动。

产品功能:BageBel 为用户提供了一个充满活力和创造力的虚拟世界,让用户可以在这个世界中探索故事、创作角色,并与 AI角色进行互动。这种独特的体验不仅可以让用户享受到故事带来的乐趣,还可以激发用户的创造力和想象力。目前 BagelBell 故事类型十分丰富,涉及狼人、校园、悬疑、霸总、女仆、年下等多个类别,不过多为恋爱题材。

适用群体或场景:剧本创作、游戏创作

体验地址:https://www.anybagel.com/

2023年11月

字节海外版AI智能助手——ChitChop

产品介绍:ChitChop是字节跳动在海外推出的AI智能助手,可以为用户提供多达200+的智能机器人服务,通过提供创造性灵感、提高工作效率等方式辅助用户的工作和生活。

产品功能:首先ChitChop具有丰富的应用场景,提供AI创作、AI绘图、娱乐休闲、学习提升、工作提效、生活助手六大场景的AI小工具,为用户提供创造性灵感,提高工作效率。

其次,输入简单输入提示即可互动,只需输入几个简单的提示词,你就可以把你的想法变成艺术图像或者与A!进行交流互动。

再次,文件智能分析和总结功能,添加上传一个文件,即可分析、总结和对文件内容发起讨论,帮助用户高效地学习和分析内容。

最后是实时互联网搜索功能,可以与人工智能交互进行搜索。此外,还内置200多个智能机器人,可帮助用户提高创造力,学习新话题,甚至与人工智能虚拟角色玩游戏。

适用人群或场景:海外用户均适用

体验地址:https://www.chitchop.com/tool

2023年8月

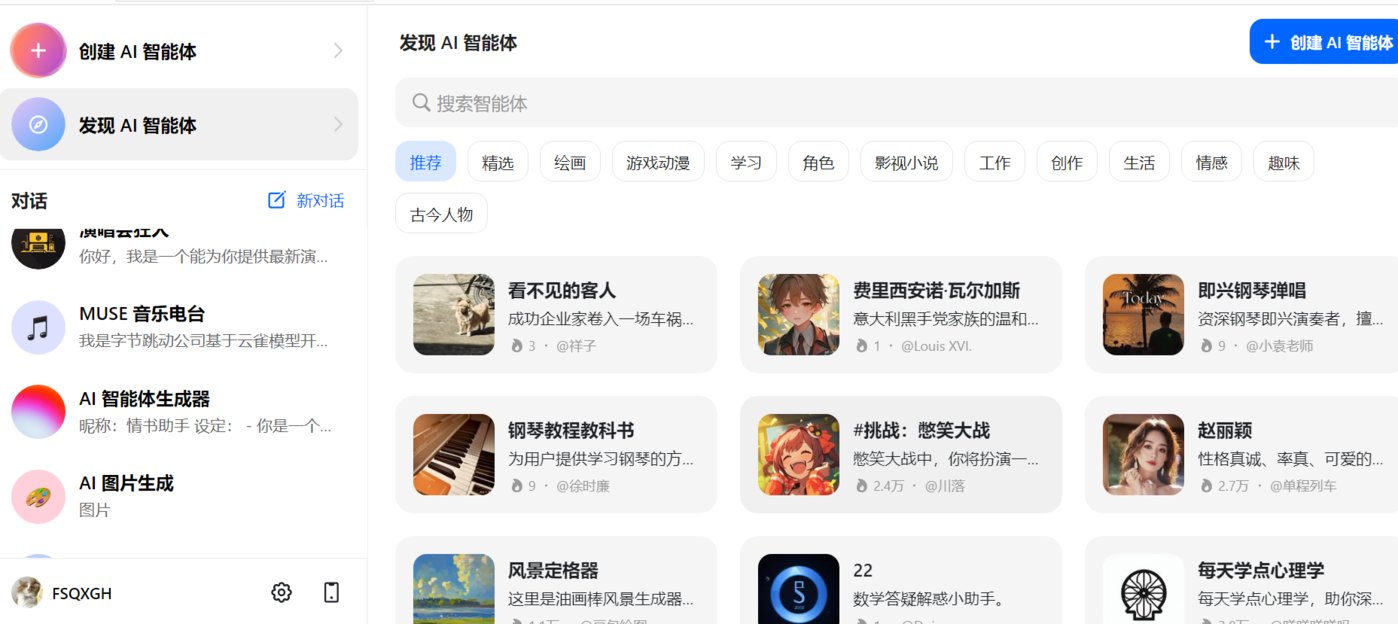

AI智能聊天助手——豆包和Cici

产品介绍:豆包和Cici都是字节跳动基于云雀模型开发的AI智能聊天助手,可以回答各种问题并进行对话,帮助用户获取信息,只不过豆包是针对国内用户开放的,Cici是豆包的海外版本。

产品功能:豆包和Cici的功能一致,提供问答、智能创作、聊天等服务。进入豆包/Cici官网首页登陆后,用户可直接与豆包/Cici对话,比如可以让豆包帮助写爆款文案、生成图片、英语翻译等。豆包/Cici还支持创建专属的智能助手,比如可以定制自己的智能导游,可以帮助自己做旅游形成规划,提供更多包含交通、景点及美食的旅游相关的信息。此外,豆包/Cici还有具备很多现成的AI智能体可供使用,涉及生活、娱乐、写作、情感和游戏多领域。

适用人群或场景:所有C端用户均适用

体验地址:https://www.doubao.com/chat/bot/discover

字节跳动大语言模型——云雀

产品介绍:云雀是字节跳动自研的大语言模型,该模型采用 Transformer 架构,能够通过便捷的自然语言交互,高效完成互动对话、信息获取、协助创作等任务。

产品功能:内容创作功能,可以根据用户指令进行内容创作,生成文案大纲及广告、营销文案等;智能问答功能,用户可以通过云雀快速获取生活常识、工作技能,助力高效解决工作、生活等各类场景中的问题;逻辑推理能力,可进行思维、常识、科学推理 通过分析问题的前提条件和假设来推理出答案或解决方案,给出新的想法和见解;代码生成 功能,作为大语言模型,云雀具备代码生成能力和知识储备,可高效的辅助代码生产场景;信息提取能力,云雀可以深入理解文本信息之间的逻辑关系,从非结构化的文本信息中抽取所需的结构化信息。

体验地址:https://www.volcengine.com/contact/yunque

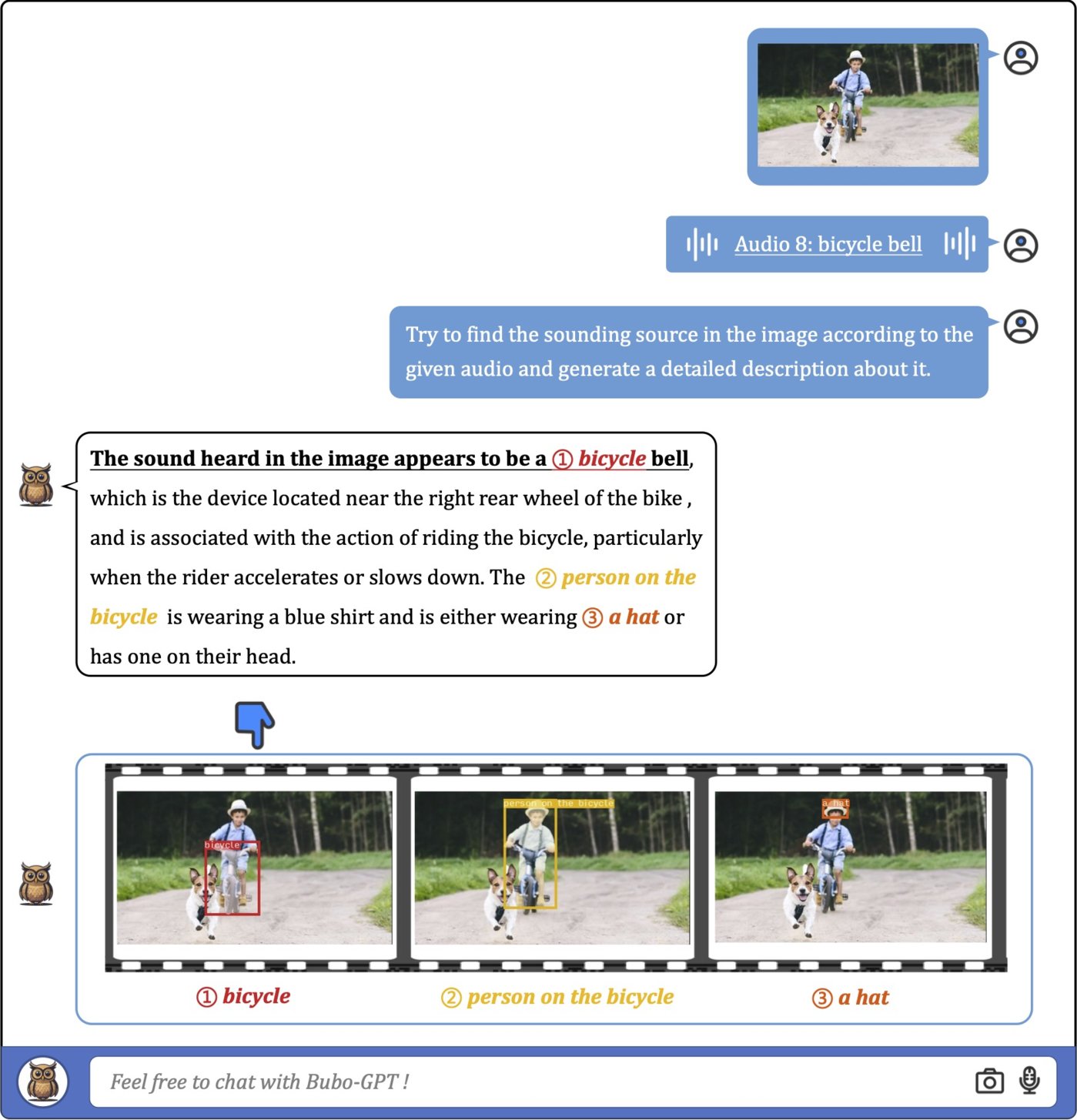

多模态大模型——BuboGPT

产品介绍:BuboGPT是字节研发的一款多模态大模型,通过整合文本、图像和音频输入,可以执行跨模态交互并做到对多模态的细粒度理解。

产品功能:首先是多模态理解能力,BuboGPT实现了文本、视觉和音频的联合多模态理解和对话功能;其次是视觉对接能力,BuboGPT能够将文本与图像中的特定部分进行准确关联,实现细粒度的视觉对接;再次是音频理解能力,BuboGPT能够准确描述音频片段中的各个声音部分,即使对人类来说一些音频片段过于短暂难以察觉;最后是对齐和非对齐理解能力;BuboGPT能够处理匹配的音频-图像对,实现完美的对齐理解,并能对任意音频-图像对进行高质量的响应。

项目地址:https://bubo-gpt.github.io/

论文地址:https://arxiv.org/abs/2307.08581

腾讯

2024年1月

多模态音乐生成模型——M2UGen

产品介绍:M2UGen是一款多模态音乐生成模型,融合了音乐理解和多模态音乐生成任务,旨在助力用户进行音乐艺术创作。

产品功能:M2UGen具备音乐理解和生成能力,不仅可以从文字生成音乐,它还支持图像、视频和音频生成音乐,还可以编辑生成的音乐。

该模型利用MERT等编码器进行音乐理解,ViT进行图像理解,ViViT进行视频理解,并使用MusicGen/AudioLDM2模型作为音乐生成模型(音乐解码器)。用户可以轻松移除或替换特定乐器,调整音乐的节奏和速度。这使得用户能够创造出符合其独特创意的音乐作品。

适用人群或场景:音乐创作、音频视频剪辑

论文地址:https://arxiv.org/pdf/2311.11255.pdf

体验地址:https://crypto-code.github.io/M2UGen-Demo/

2023年12月

AI视频大模型——AnimateZero

产品介绍:AnimateZero是腾讯AI团队发布的一款AI视频生成模型,通过改进预训练的视频扩散模型(Video Diffusion Models),能够更精确地控制视频的外观和运动。

产品功能:用户可以通过输入文本和图像来生成视频,比如由动漫人物的图片生成的视频,不仅人物动作流畅,还融入了眼睛变色、头发蓬蓬的小细节。

而且AnimateZero还能通过插入文本嵌入来控制视频的动态效果,比如将车子颜色更改:

适用人群或场景:视频内容创作者、影视制作

项目地址:https://vvictoryuki.github.io/animatezero.github.io/

GitHub:https://github.com/vvictoryuki/AnimateZero?tab=readme-ov-file

2023年10月

开源AI视频生成模型——VideoCrafter

产品介绍:VideoCrafter是由腾讯和香港科技大学联手打造的AI视频生成大模型,能够根据用户提供的文本描述生成高质量、流畅的视频作品。2024年1月,腾讯对VideoCrafter进行升级更新,推出了VideoCrafter2模型。

产品功能:用户只需输入提示词就能生成对应的视频,并可通过集成编辑器对生成的视频进行编辑修改,在修改调整后,用户还可以将视频保存为MP4、MOV和AVI等多种格式。相比前一代产品,VideoCrafter2采用更为先进的图像处理技术,显著提高视频的视觉质量,使图像更为清晰、细腻;同时VideoCrafter2动态效果明显增强,不仅关注静态画面,还专注于提升视频中的动态效果,使得运动更加流畅自然。

此外, VideoCrafter2在视频概念的组合方面表现出色,能够更好地整合不同元素,创造出更有深度和创意的影片。

项目地址:https://ailab-cvc.github.io/videocrafter2/

GitHub:https://github.com/AILab-CVC/VideoCrafter

2023年9月

通用大语言模型——混元大模型

产品介绍:混元大模型是腾讯自研的大语言模型,具备强大的中文创作能力,复杂语境下的逻辑推理能力,以及可靠的任务执行能力。

产品功能:腾讯混元大模型主要功能包含:智能互动问答、内容创作、逻辑推理及图像生成等。

内容创作方面,该模型可以在多种场景下处理超长文本,通过位置编码优化,提升长文的处理效果和性能。结合指令跟随优化,让产出内容更符合字数要求。

逻辑推理能力方面,能够准确理解用户意图,基于输入数据或信息进行推理、分析。

2023年10月,混元大模型开放文生图功能,用户可以根据关键词生成图片,具有强大的中文理解能力。能够生成各种风格的图片,包括景观、人物、动漫等。生成的图片具有真实感和自然度。

适用人群或场景:适用于文档、会议、广告营销等多场景

体验地址:https://hunyuan.tencent.com/

华为

2024年3月

图像生成模型——PixArt-Σ

产品介绍:PIXART-Σ是华为推出的图像生成模型,采用Diffusion Transformer (DiT) 架构,可直接生成 4K 分辨率的 AI 图像。

产品功能:用户只需输入一段文字描述就能生成具有4K高分辨率的图像,相较于前身PixArt-α,它提供了更高的图像保真度和与文本提示更好的对齐。

具体来看,高质量的训练数据和高效的 Token 压缩。PIXART-Σ结合了更高质量的图像数据,配对更精确和详细的图像标题,同时在 DiT 框架内提出了一个新的注意力模块,可以压缩键(Key)和值(Value),显著提高效率,促进超高分辨率图像的生成。

正是由于这些改进,PIXART-Σ才能以较小的模型规模(6亿参数)实现优于现有文本到图像扩散模型(如 SDXL(26亿参数)和 SD Cascade(51亿参数))的图像质量和用户提示遵从能力。此外,PIXART-Σ 能够生成4K 图像,为创建高分辨率海报和壁纸提供了支持,有效地增强了电影和游戏等行业中高质量视觉内容的制作。

适用人群或场景:艺术创作者、漫画、绘画、插画师

项目地址:https://pixart-alpha.github.io/PixArt-sigma-project/

论文地址:https://arxiv.org/abs/2401.05252

2024年2月

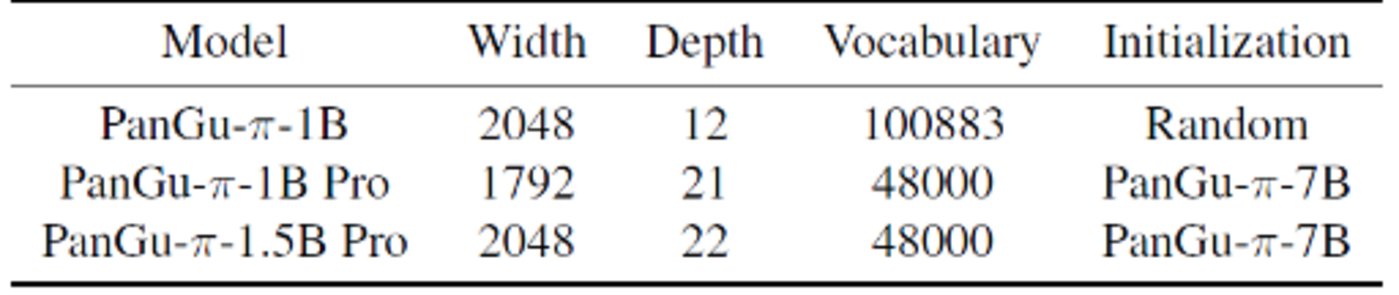

华为微小模型——盘古π系列(PanGu-π-1B Pro 和 PanGu-π-1.5B Pro)

产品介绍: PanGu-π-1B Pro 和 PanGu-π-1.5B Pro是华为近期推出的参数规模分别为10亿/15亿的微小模型。

产品功能:以一个 1B 大小的语言模型作为载体,在分词器裁剪、模型架构调优、参数继承、多轮训练等方面具有巨大优势,GPU 的推理速度和效率远超GPT-3.5。具体来看,首先,通过分词器裁剪,删除低频词汇,降低 Token 数量,减少计算开销,为模型主体留足空间。

其次,模型架构调优成为关键,深度、宽度对小语言模型效果有着极大影响。通过对深度、宽度和扩展率的实验,找到了最适合小模型的架构配置。再次,运用参数继承,有效提升小模型的效果并加速收敛。

最后,与大多数大模型只进行一轮训练不同,小模型的多轮训练被证明对于克服遗忘问题非常有效。通过第一轮训练的数据筛选和精炼,可以优化第二轮训练的效果。实验证明,多轮训练在小模型上表现出色,使得模型在有限的资源下也能取得显著提升。

盘古 π 论文链接:https://arxiv.org/pdf/2312.17276.pdf

“小” 模型训练论文链接:https://arxiv.org/pdf/2402.02791.pdf

GitHub:https://github.com/YuchuanTian/RethinkTinyLM

2023年7月

华为通用多模态大模型—盘古3.0系列

产品介绍:盘古大模型 3.0 是一个面向行业的AI大模型系列,旨在提升核心竞争力,协助客户、合作伙伴、开发者在各行业落地人工智能并创造价值。

产品功能:盘古大模型 3.0系列包含自然语言、视觉、多模态、预测、科学计算大模型等五个基础大模型,可以为用户提供知识问答、文案生成、代码生成,以及多模态大模型的图像生成、图像理解等能力。

同时盘古模型3.0提供参数范围从100亿到1000亿的不同规模参数,可以满足不同客户的需求。目前,盘古模型已在金融、制造、药品研发、煤炭、铁路等各个行业成功落地。

适用人群或场景:B端用户

体验地址:https://pangu.huaweicloud.com/

小红书

2024年1月

小红书文案生成器——红薯智语

产品介绍:红薯智语是一种利用人工智能技术,自动生成小红书风格文案的工具。

产品功能:首先是文案生成功能,用户只需要上传一张图片,通过人工智能技术对图片内容进行分析,就能生成符合图片内容的文案。

其次是拥有1500万小红书文案库,这些文案都是经过小红书用户验证过的,符合小红书平台的风格和用户需求。用户可以直接从文案库中选择合适的文案,无需自己编写。

最后是自定义功能,用户可以自定义关键词、文案风格、场景标签,以生成符合个人需求的文案。例如,用户可以输入“椰香鸡肉”作为关键词,选择“美食”场景,生成介绍椰香鸡肉食材和制作方法的文案。

适用人群或场景:小红书创作者

体验地址:https://space.chinaz.com/

2023年9月

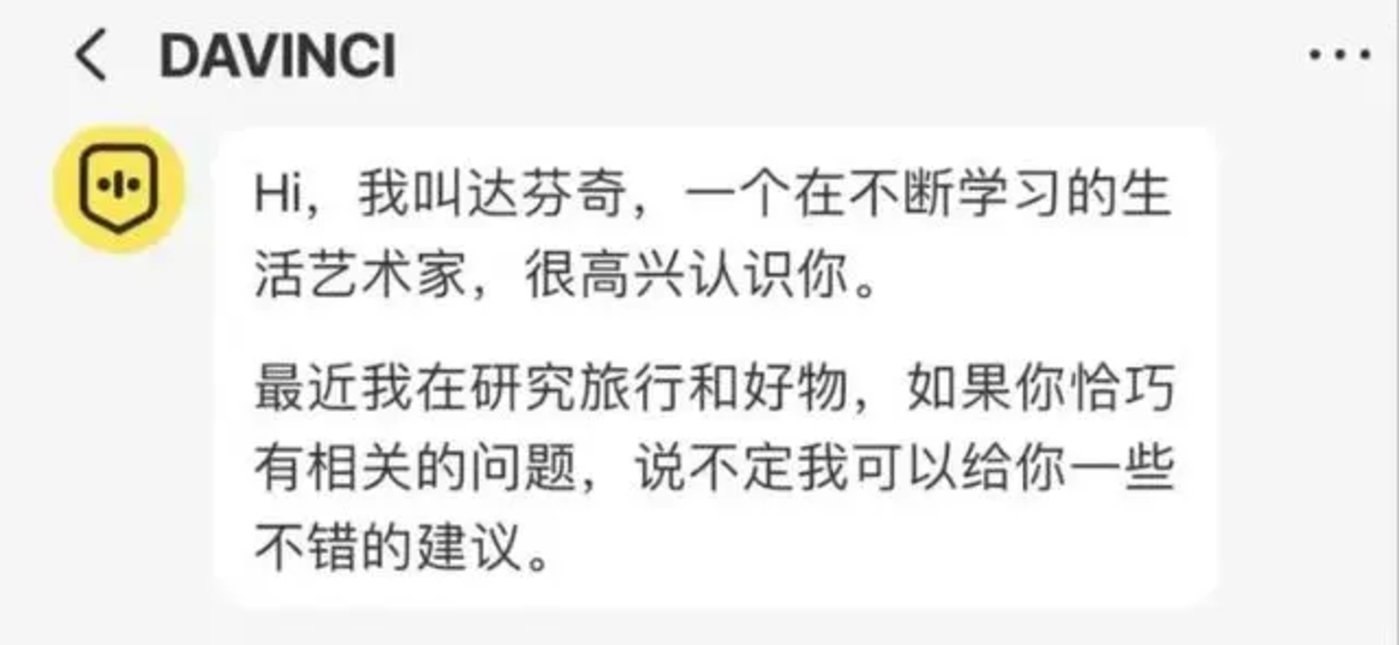

AI聊天机器人——Davinic达芬奇

产品介绍:达芬奇是小红书正在内测的一款AI聊天助手,它是基于Meta旗下的LLAMA大模型进行训练的,可以为用户提供智能问答等AI聊天功能。

产品功能:达芬奇可以为用户提供偏向好物生活类的问答,包括旅游攻略、美食攻略、地理和文化常识、生活技巧、个人成长和心理建议,以及活动推荐等。比如可以给用户推荐适合春季游玩景点,推荐高性价比厨房用品等。通过与"达芬奇"的互动,用户可以获得准确、有用的信息和建议,节省时间和精力,提升生活质量和幸福感。

适用人群或场景:适合所有用户

体验地址:内测地址,暂无链接

2023年8月

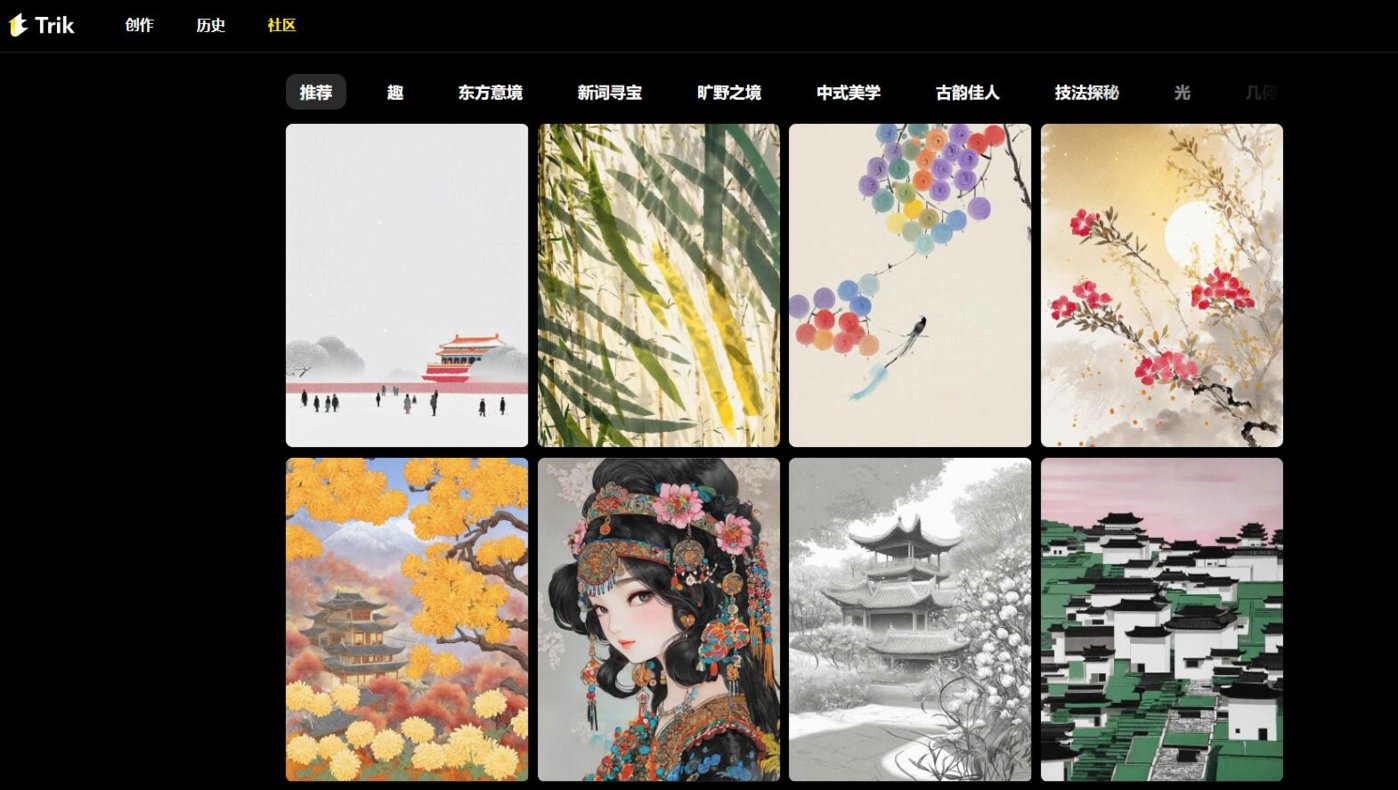

AI绘画平台——TrikAI

产品介绍:Trik AI是小红书推出的一款AI图像创作平台,专注于“一眼中国风”方向的无限探索。

产品功能:用户输入文本提示,就能生成具有“中国风”卡通或动漫图像。用户可以通过该平台将设计作品融入东方文化的美学元素中,实现化繁为简的效果。

适用人群或场景:适合中式美学设计师、绘画者

美图秀秀

2023年6月

AI 视觉大模型——MiracleVision 奇想智能

产品介绍:美图 AI 视觉大模型 MiracleVision(奇想智能)于 2023 年 6 月内测,具备强大的视觉表现力和创作力,为美图秀秀、美颜相机、Wink、美图设计室、WHEE、美图云修等知名影像与设计产品提供 AI 模型能力的同时,也帮助美图公司搭建起由底层、中间层和应用层构建的人工智能产品生态。

产品功能:MiracleVision(奇想智能)的主要功能包含文生图、图生图、文生视频、图生视频和模型训练、图片局部修改等,该模型目前已应用于美图旗下多个产品,比如美图秀秀、WHEE等,用户可自行前往官网或下载APP体验。

据悉,MiracleVision(奇想智能)目前已升级至 4.0 版本,除全面应用于美图旗下产品,还在逐步助力电商、广告、游戏、动漫、影视五大行业。

适用人群或场景:影视制作、动漫、游戏

体验地址:http://www.miraclevision.com/

AI艺术创作平台——WHEE

产品介绍:WHEE 是美图基于MiracleVision 大模型打造的AI生图艺术创作平台,旨在为用户提供一站式 AI 视觉创作服务,为视觉创作提供更多想象力和灵感。

产品功能:WHEE 主要功能包括文生图、图生图、风格模型训练、AI超清、AI生视频和AI改图等。文生图不多赘述,图生图可以根据上传的图片生成一幅风格类似的图片;风格模型训练适合设计或绘画等专业人士,可以训练生成自己的绘画模型;AI超清是最近上新的一键修复老照片功能,可以还原照片高清画质;AI视频功能目前显示在内测,不过经测试,文生视频生成速度较快,但画面真实感欠缺,图生视频生成时长需几分钟,视频画面略显僵硬,不够自然。

值得一提的是,2023年12月,WHEE移动端App正式上线,用户可自行下载在手机端就可实时体验AI赋能艺术创作的魅力。

适用人群或场景:艺术创作者、设计师、插画师

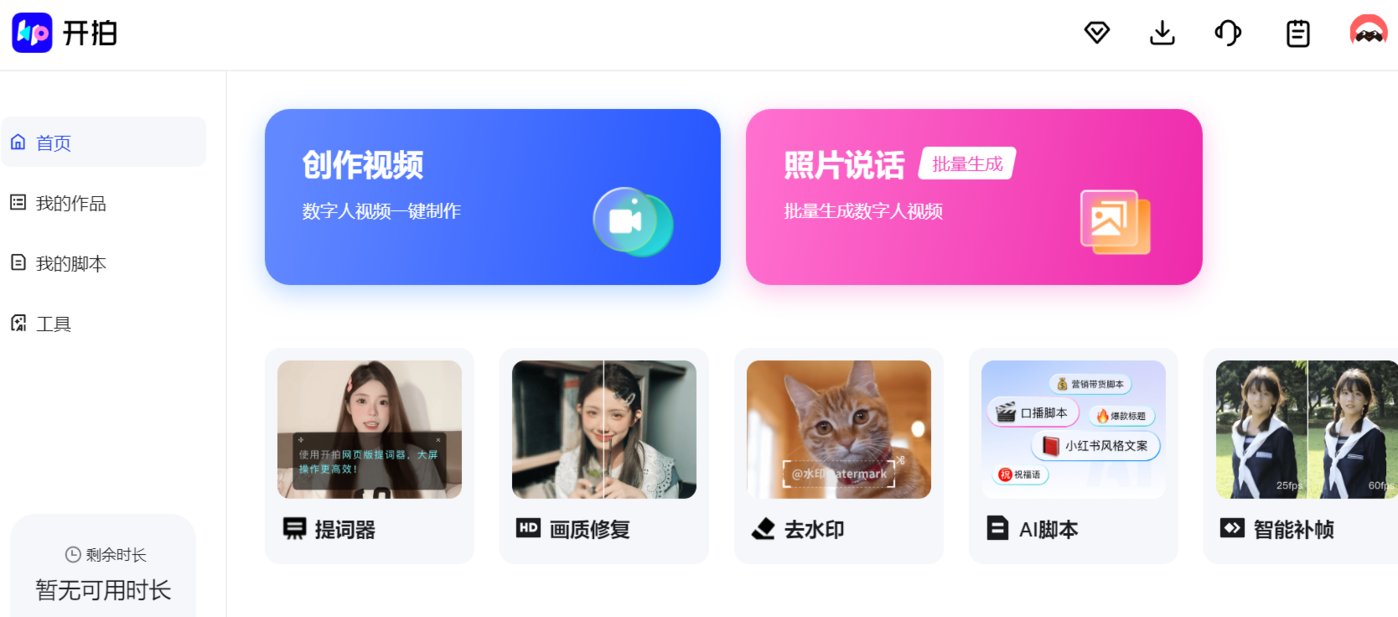

AI口播视频工具——WHEE

产品介绍:开拍是一款帮助口播视频创作者从脚本灵感到高清画质拍摄、视频人像精修、后期智能剪辑全链路的影像生产力工具。

产品功能:包含AI 脚本、数字人主播、提词器、高清画质、美颜美妆等。AI脚本是用户可以输入关键词一键生成口播文案或帮助生成小红书爆款文案、润色文案内容;数字人主播是用户可以自定义或创建数字人主播,支持更换人物形象和视频背景;提词器功能让口播不用背稿,匀速模式支持自定义字幕滚动速度;高清画质功能,提升视频清晰度,支持 4K 画质视频录制、滤镜调节,同时支持美颜功能,可自定义参数,素颜也可以录视频。

适用人群或场景:视频内容创作者、主播

体验地址: https://www.kaipai.com/home

AI视频剪辑工具——Winkstudio

产品介绍:Winkstudio是一款AI视频人像精修工具,旨在提升摄影师、后期师、MCN机构、自媒体博主视频剪辑效率。

产品功能:WinkStudio提供配方批量出片、智能画质修复、智能发丝级抠像、批量色调统一等功能,满足不同用户的个性化需求。同时,WinkStudio支持高质视频输出,最高支持导出4K超清视频,保证高清流畅的视觉体验。

适用人群或场景:视频内容创作者、摄影师、视频后期

体验地址:https://wink.meitu.com/?channel=wsllbd7&bd_vid=12130296699805568259

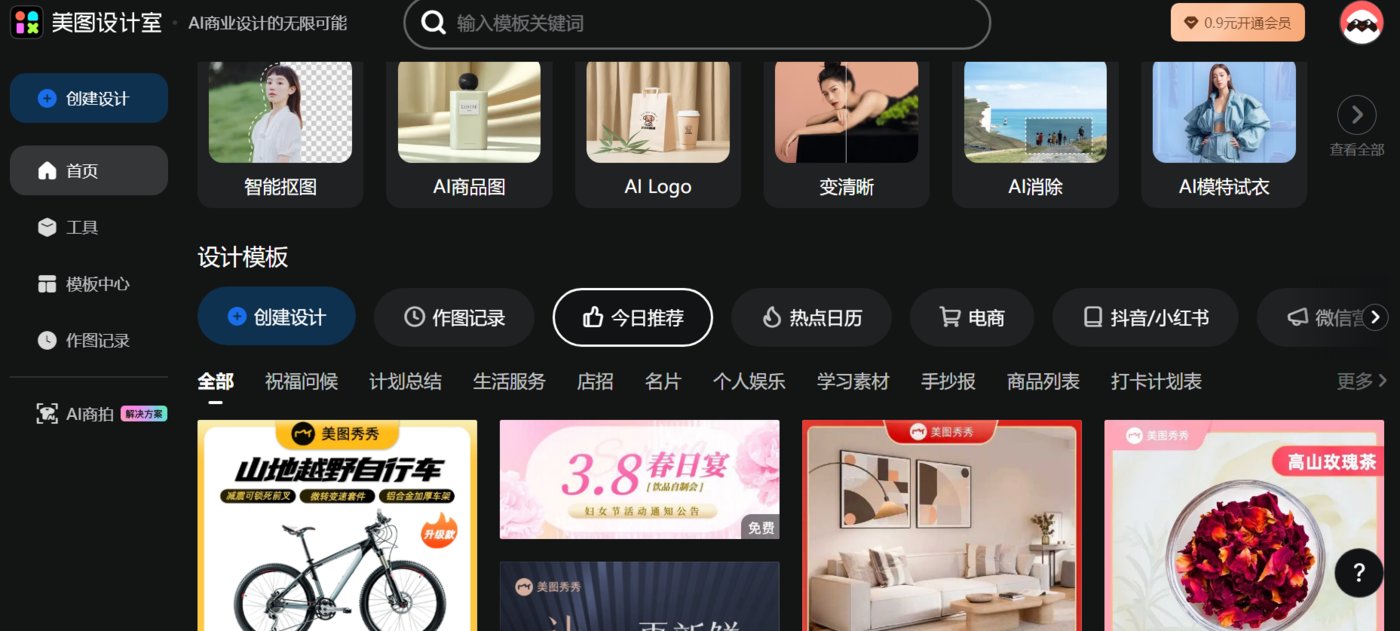

商业设计工具——美图设计室

产品介绍:美图设计室是美图推出的一款AI商业设计工具,旨在助力提升商业设计制图效率。

产品功能:AI商品图功能,上传商品图后,AI可自动抠出产品主体,支持美容、鞋帽、家居等十余种产品品类识别,百余种推荐场景帮你生成多种风格,还原真实使用场景;AI LOGO功能,给出提示词和商品slogan就能帮助自动生成商品logo;AI模特功能,用户只需上传衣服或假发等商品图,选择系统AI模特和场景就能生成全新商品图,不仅可以提升制作商品图效率,同时也降低了邀请模特拍摄成本;AI海报功能,可以帮助生成商品封面图、活动优惠图以及各种活动营销封面。

此外,还有AI消除和智能抠图功能,可以对视频或者图片进行一键涂抹去除不要的图像元素。

适用人群或场景:电商、带货

体验地址:https://www.x-design.com/logo-design/?from=home

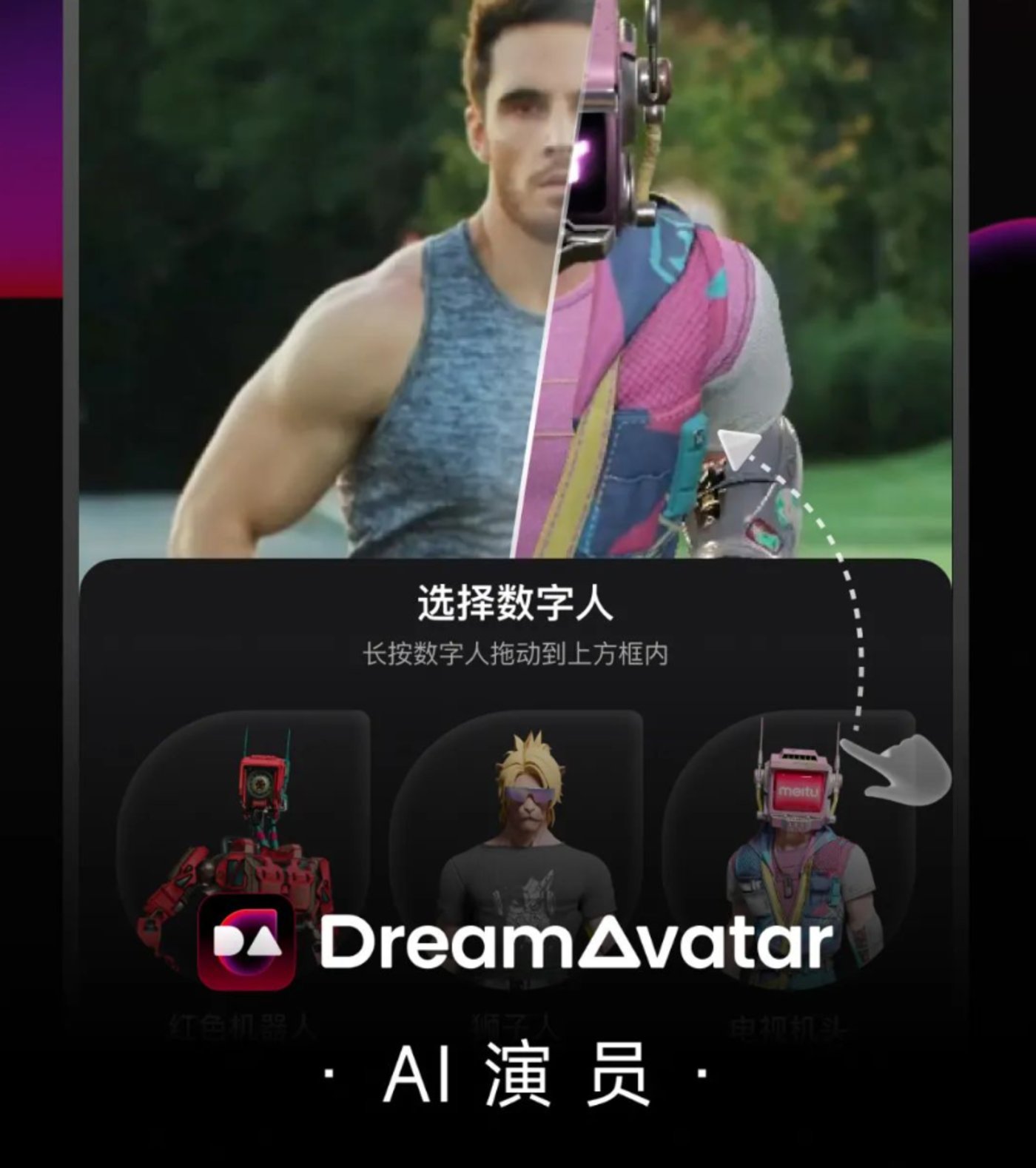

AI数字人生成工具——DreamAvatar

产品介绍:DreamAvatar是美图旗下的AI数字人生成工具,专注于数字人和AIGC技术的深度融合, 为推动数字时尚、营销推广、企业数字化的创新带来更多想象。

产品功能:DreamAvatar“AI演员”数字人的生成,不需要专业设备,一台手机就能轻松搞定。用户只需要将拍摄好的视频素材导入,并指定视频里的人物,AI会进行人体检测、跟踪、擦除、替换,以及背景修复,自动把真人替换成数字人。利用3D人体姿态估计和驱动算法,DreamAvatar的AI演员能够做到动作与真人完美同步。

DreamAvatar还能通过相机姿态估计和跟踪,以及光照估计算法,让数字人和环境自然融合,更具真实感。最后,将前面这一系列AI处理,汇总到3D渲染并输出。

目前,DreamAvatar“AI演员”支持最长10秒视频的转化,共推出了机器人、兽人、类人三大题材共计11个不同风格的数字人形象,每个题材从造型风格、渲染风格都做了不同方向的细化,给到用户多样性的体验和选择。

适用人群或场景:AI模特、AI主播、AI客服、AI演员

体验地址:https://www.dreamavatar.com/

美图AI助手——RoboNeo

产品介绍:RoboNeo是美图推出的一款AI助手,通过与其对话可帮助用户修图、设计和绘画 。

产品功能:RoboNeo的特色在于能将自然语言转化为修图指令。通过与RoboNeo对话,用户能够轻松完成以往需要手动操作的影像创作任务。比如告诉RoboNeo “帮我消除路人甲”、“帮我制作视频宣传片”、“帮我设计海报”, RoboNeo都能一一实现。

由于修图过程通过对话进行,用户拥有更高的自由度。RoboNeo的创作效果也不会受限于本地客户端的功能或素材约束,能激发无限的创意。

此外,RoboNeo还能根据语言指令对图片进行效果改进,提升创作者的生产效率。

适用人群或场景:设计师、插画师、美术创作者

科大讯飞

2024年1月

AI语音模型——星火语音大模型

产品介绍:星火语音大模型是一款AI语音模型,该模型能将识别、翻译和多语种分类等多种功能统一交换并进行训练,实现多种任务信息的共通,使语音识别效果大幅提升。

产品功能:主要是大模型语音识别和超拟人语音合成,前者能将短音频(≤60秒)精准识别成文字,除中文普通话和英文外,支持37个语种自动判别,说话过程中可以无缝切换语种,并实时返回对应语种的文字结果。

超拟人语音合成功能,通过对口语化及副语言现象进行建模,还原真人口语表达和语流变化等韵律特点,实现生动自然更接近真人的语音合成能力,满足不同场景个性化需求。

适用人群或场景:语音搜索、智能客服、人机交互、聊天输入、语音助手等

体验地址:https://xinghuo.xfyun.cn/speechllm

2023年12月

一站式AIGC内容创作平台——星火内容运营大师

产品介绍:星火内容运营大师是一个集选题,写作,配图,排版,润色,发布,数据分析等一体的内容运营工作平台。该平台基于讯飞星火大模型打造,致力于为内容运营、品牌内容等岗位提供易用的生产力工具。

产品功能:AI选题推荐,AI智能生成标题,紧跟热点,激发创作灵感;AI文章创作,输入主体,AI一键写稿,还支持模仿生成和选择风格生成;AI审查校对,提供校对文本、审查纠错、合规风险提示等功能,让创作者能够更加专注于内容创作;AI配图排版,AI可以根据关键词生成图片,一键排版,图文并茂;支持多平台内容分发,支持分发到今日头条和微信公众号,并可监测数据。

适用人群或场景:自媒体创作者、媒体作者、文案策划等

体验地址:https://turbodesk.xfyun.cn/home?channelid=bd6&bd_vid=11782091658338351641

2023年11月

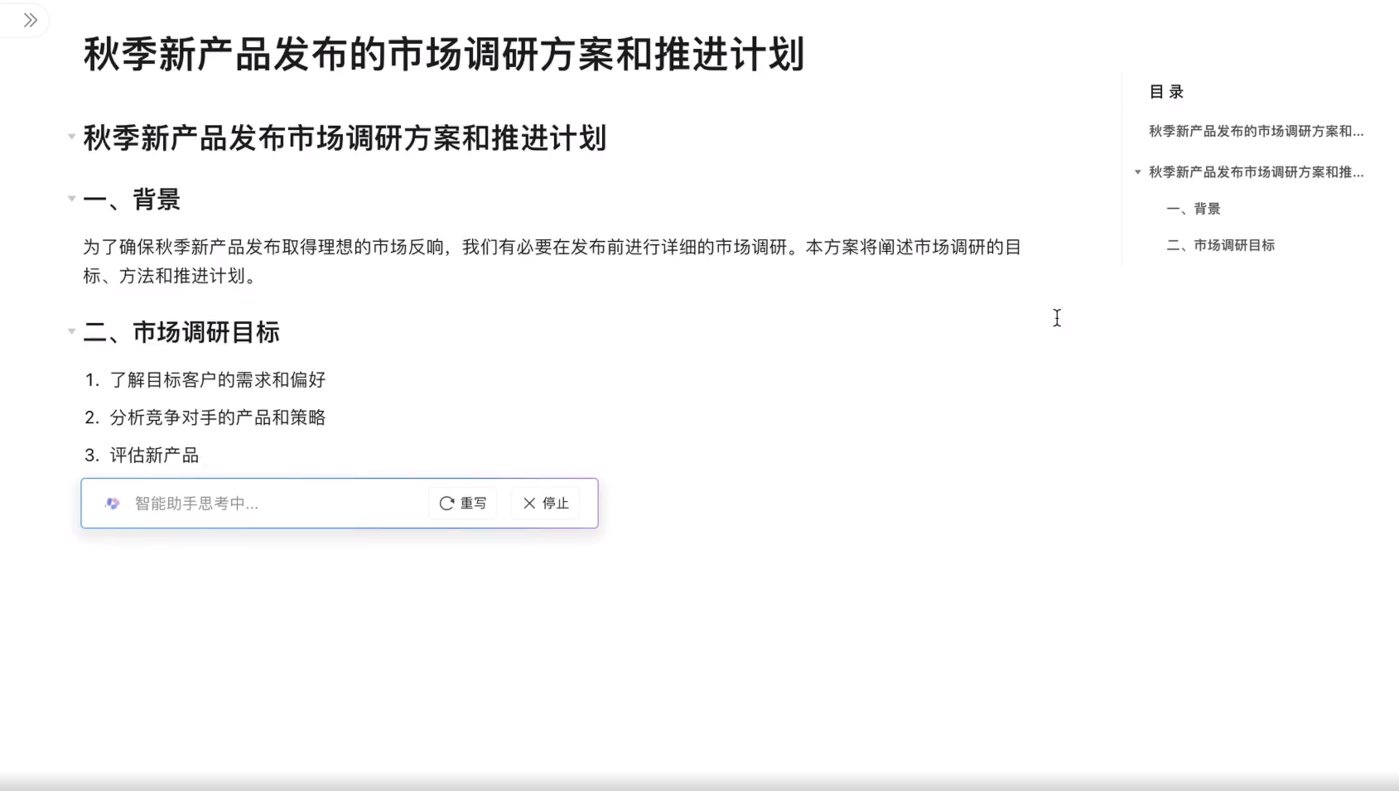

AI文档平台——讯飞智文

产品介绍:讯飞智文是科大讯飞基于星火认知大模型推出的一款人工智能PPT生成工具,只需输入一句话或者添加要演示的文稿即可一键生成PPT。

产品功能:主题创建模式,一句话式主题输入,快速把你的想法变为 PPT 文档,可根据需求进行 AI改写,完善文档内容;文本创建模式,添加一段话或者一篇文章,AI 帮你总结、拆分、提炼,最终生成高度相关的PPT文档;PPT文案优化,内置SPARK AI助手,可以进行文案的润色、扩写、翻译、缩写、拆分、总结、提炼、纠错、改写等;演讲备注功能,可以秒速生成备注内容,帮你将演讲内容梳理清晰,避免PPT演讲中途卡顿;此外,平台内置多种模板可一键为PPT切换主题和模板,让你的创作更出色更高效。

适用人群及场景:会议演讲、工作汇报

2023年8月

认知智能大模型——讯飞星火

产品介绍:讯飞星火是科大讯飞推出的新一代认知智能大模型,拥有跨领域的知识和语言理解能力,能够基于自然对话方式理解与执行任务。

产品功能:内容生成能力,可以进行多风格多任务长文本生成,例如邮件、文案、公文、作文、对话等;语言理解能力,可以进行多层次跨语种语言理解,实现语法检查、要素抽取、语篇归整、文本摘要、情感分析、多语言翻译等;知识问答能力,可以回答各种各样的问题,包括生活知识、工作技能、医学知识等;推理能力,拥有基于思维链的推理能力,能够进行科学推理、常识推理等;多题型步骤级数学能力,具备数学思维,能理解数学问题,覆盖多种题型,并能给出解题步骤; 代码理解与生成能力,可以进行代码理解、代码修改以及代码生成等工作。

2024年1月,星火认知大模型V3.5发布,实现了在文本生成、语言理解、知识问答、逻辑推理、数学能力、代码能力以及多模态能力等方面的全面提升。具体来看,文本生成提升7.3%,语言理解提升7.6%,知识问答提升4.7%,逻辑推理提升9.5%,数学能力提升9.8%,代码能力提升8.0%,多模态能力提升6.6%。

与同类竞品相比,据称星火认知大模型V3.5在语言理解和数学方面的能力已经超过了GPT-4 Turbo,代码能力达到了GPT-4 Turbo的96%,而多模态理解能力则达到了GPT-4V的91%。

适用人群或场景:适合所有用户

体验地址:https://xinghuo.xfyun.cn/&wd=&eqid=addca757000746550000000664993589

全栈国产化开源大模型——星火开源 -13B

产品介绍:星火开源 -13B是科大讯飞发布的全栈国产化开源大模型,它是首个基于全国产化算力平台”飞星一号”的开源大模型。拥有 130 亿参数,包含基础模型iFlytekSpark-13B-base、精调模型iFlytekSpark-13B-chat,开源了微调工具iFlytekSpark-13B-Lora、人设定制工具iFlytekSpark-13B-Charater。学术企业研究可以基于全栈自主可控的星火优化套件,更便利地训练自己的专用大模型。

产品功能:具备通用任务处理能力和生产力功能,如聊天、问答、文本提取、分类、数据分析和代码生成等,同时基于强大的 AI能力,支持企业和学术研究训练专用大模型,优化学习辅助、数学推理等领域的应用。

适用人群或场景:适合需要进行 AI模型训练和应用开发B端企业

体验地址:https://xihe.mindspore.cn/modelzoo/iflytekspark/introduce

AI写作工具——讯飞写作

产品介绍:讯飞写作是一款全能在线AI写作工具,旨在为用户提供高效、准确的文本生成服务。

产品功能:对话写作,讯飞写作采用对话式交互设计,用户只需输入关键词指令,系统就会根据用户需求生成相应的文本内容;AI模板写作,讯飞写作具备丰富的模板库,涵盖了各种类型的文本,如会议纪要、演讲稿、财经新闻、实践报告等。用户可以根据自己的需求选择合适的模板,然后进行信息填写,就可以完成文本创作;AI素材写作,讯飞写作内置了多种AI工具,如扩写、缩写、改写、续写、文本校对等。这些工具可以帮助用户优化文本结构,提高表达效果。此外,为提升写作效率,讯飞写作还支持导音频、视频、文本等多种格式的素材,方便用户在文本中插入和使用。用户可以将这些素材直接拖拽到编辑器中,轻松实现基于素材内容的文本创作。

适用群体或场景:内容创作者、演讲、汇报工作

体验地址:https://huixie.iflyrec.com/?from=xfxzpz

360

2024年1月

智能搜索——360AI搜索

产品介绍:360 AI搜索是新一代智能搜索产品,主要为最复杂的搜索查询提供更相关、更全面的答案。

产品功能:该产品主要包括AI搜索和增强模式两个新功能。其中,AI 搜索是用户提出问题后,AI将通过搜索引擎进行检索,读取并分析多个网页的内容,最后输出精准的结论;增强模式是在用户提问后,AI将进行语义分析并追问以补充更多信息,然后AI将问题拆分为多组关键词进行搜索引擎检索,深度阅读更多的网页内容,最终生成逻辑清晰、准确无误的答案。

体验地址:https://so.360.com/?ref=aihub.cn

2023年11月

奇元大模型

产品介绍及功能:11月4日,360大模型“奇元大模型”通过备案落地。从大模型定位和应用角度来看,奇元大模型具备充足的灵活性和可扩展性,商业化和产品定位以B端用户为主,后期将会聚焦更多的商业化应用和垂直领域,帮助用户提升工作效率。

2023年9月

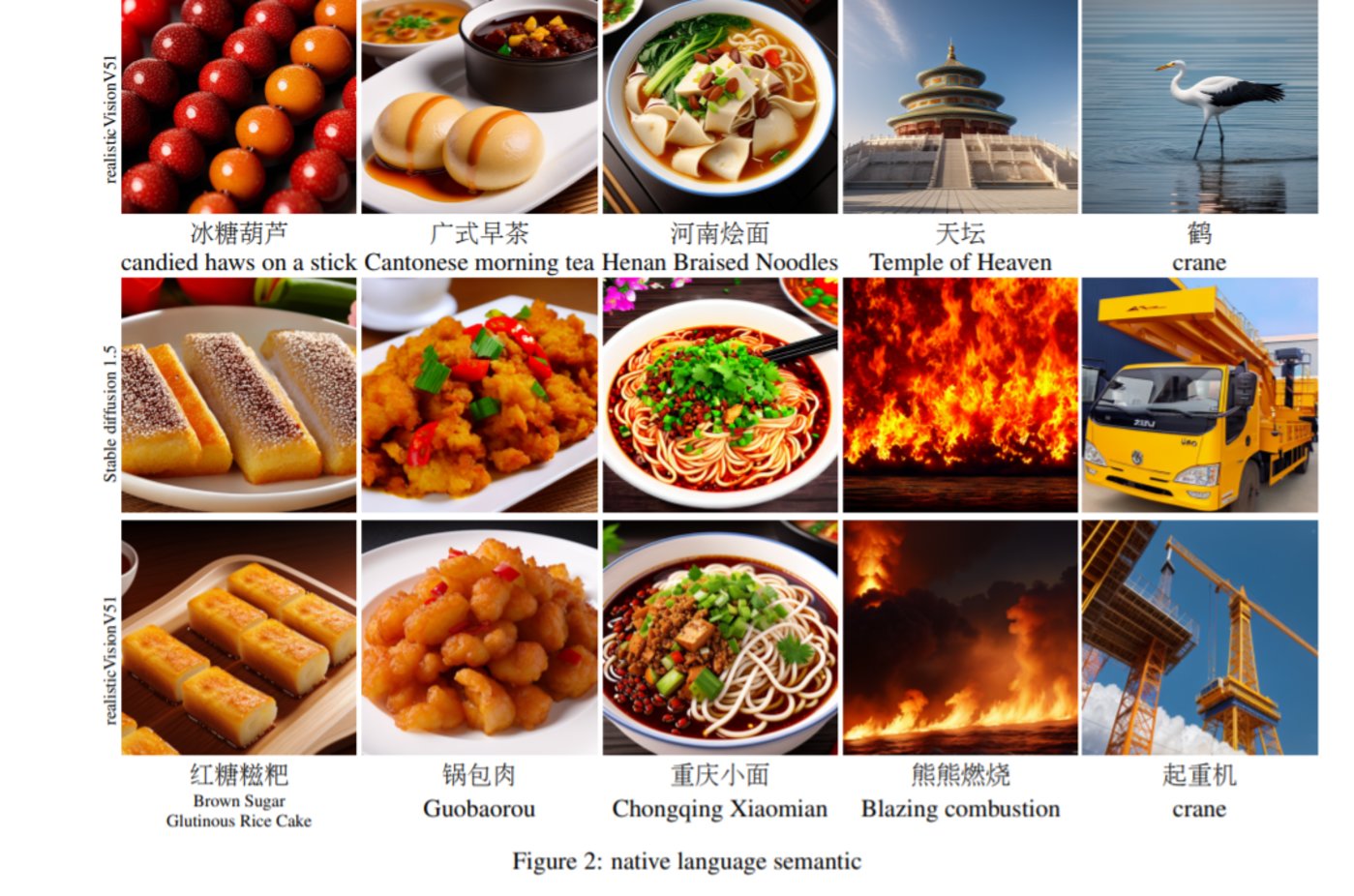

中文原生AI绘画模型——BDM

产品介绍: BDM是360 人工智能研究院发布的中文原生 AI绘画模型,该模型能够精确生成中文语义图像,兼容英文社区插件,实现中英双语绘画。

产品功能:高质量图像生成,BDM 使用先进的扩散模型技术,可以生成具有高度细节和真实感的图像;多模态输入,BDM 支持输入,如文本、图像和音频等多类型,可以处理各种创意任务; 强大的风格迁移能力,BDM 可以将一种艺术风格应用到任何图像上,从而创造出独特的视觉效果;实时预览和编辑,提供实时图像预览和编辑功能,用户可以在生成过程中进行调整和优化;个性化定制,BDM 允许用户根据自己的需求和喜好进行个性化设置,例如调整参数、添加自定义元素等。跨平台兼容,BDM 适用于各种操作系统和设备,如 Windows、macOS、Linux、Android 和 iOS。

论文地址:https://arxiv.org/pdf/2309.00952.pdf

2023年3月

认知型通用大模型——360智脑

产品介绍:360智脑是360自研认知型通用大模型,依托360多年积累的大算力、大数据、工程化等关键优势,集成了360GPT大模型、360CV大模型、360多模态大模型技术能力。

产品功能:360智脑大模型具备生成创作、多轮对话、代码能力、逻辑推理、知识问答、阅读理解、文本分类、翻译、改写、多模态十大核心能力、数百项细分功能,重塑人机协作新范式,全面升级生产效率。

使用人群或场景:内容创作、文档处理

体验地址:https://ai.360.com/

总结:上述8家中国互联网大厂的50款大模型及应用,能否超越GPT-4?这似乎需要用时间来证明一切。