本文经自动驾驶之心公众号授权转载,转载请联系出处。

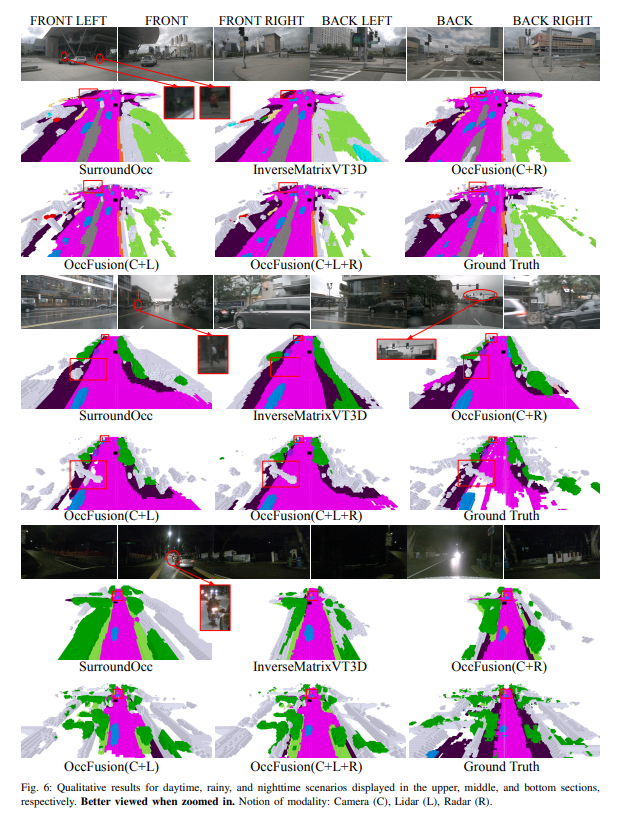

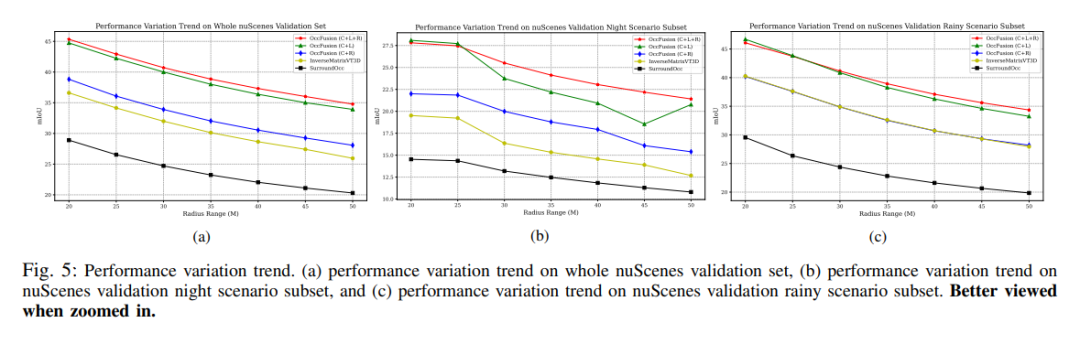

对3D场景的全面理解在自动驾驶中至关重要,最近的3D语义占用预测模型已经成功地解决了描述具有不同形状和类别的真实世界物体的挑战。然而,现有的3D占用预测方法在很大程度上依赖于全景相机图像,这使得它们容易受到照明和天气条件变化的影响。通过集成激光雷达和环视雷达等附加传感器的功能,本文的框架提高了占用预测的准确性和稳健性,从而在nuScenes基准上获得了顶级性能。此外,在nuScene数据集上进行的广泛实验,包括具有挑战性的夜间和雨天场景,证实了我们的传感器融合策略在各种感知范围内的卓越性能。

论文链接:https://arxiv.org/pdf/2403.01644.pdf

论文名称:OccFusion: A Straightforward and Effective Multi-Sensor Fusion Framework for 3D Occupancy Prediction

本文的主要贡献概述如下:

- 提出了一种多传感器融合框架,用于集成相机、激光雷达和雷达信息,以执行3D语义占用预测任务。

- 在3D语义占用预测任务中,将本文的方法与其他最先进的(SOTA)算法进行了比较,以证明多传感器融合的优势。

- 进行了彻底的消融研究,以评估不同传感器组合在具有挑战性的照明和天气条件下(如夜间和雨天)所实现的性能增益。

- 考虑到各种传感器组合和具有挑战性的场景,进行了一项全面的研究,以分析感知范围因素对我们的框架在3D语义占用预测任务中的性能的影响!

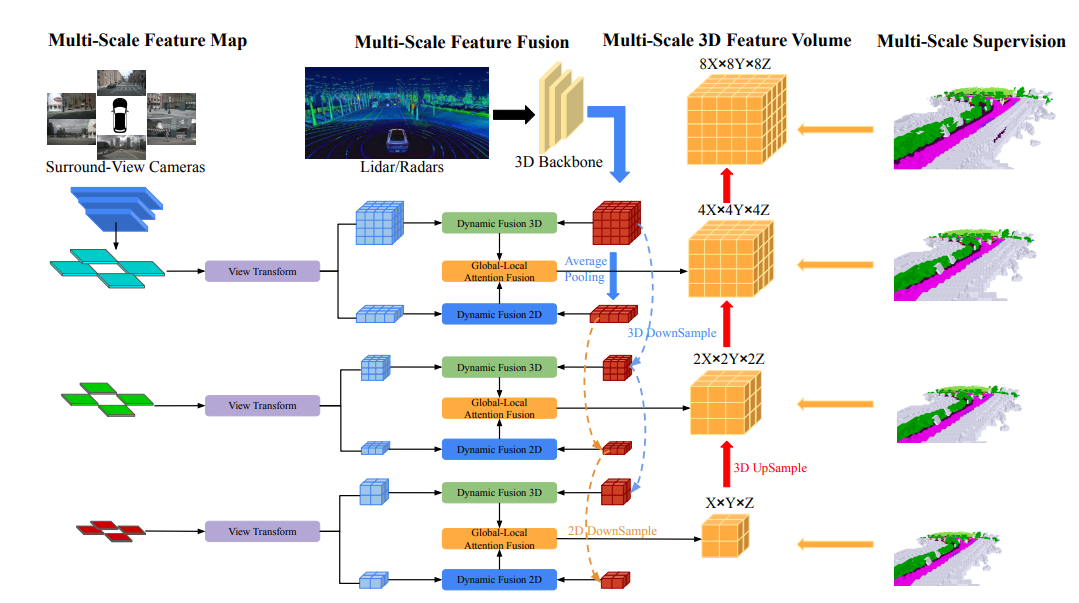

网络结构一览

OccFusion的总体架构如下所示。首先,将环绕视图图像输入到2D主干中以提取多尺度特征。随后,在每个尺度上进行视图变换,以获得每个级别的全局BEV特征和局部3D特征volume 。激光雷达和环视雷达生成的3D点云也被输入到3D主干中,以生成多尺度局部3D特征量和全局BEV特征。每个级别的动态融合3D/2D模块融合了相机和激光雷达/雷达的功能。在此之后,将每个级别的合并的全局BEV特征和局部3D特征volume 馈送到全局-局部注意力融合中,以生成每个尺度的最终3D volume 。最后,对每个级别的3D volume 进行上采样,并在采用多尺度监督机制的情况下进行skip连接。

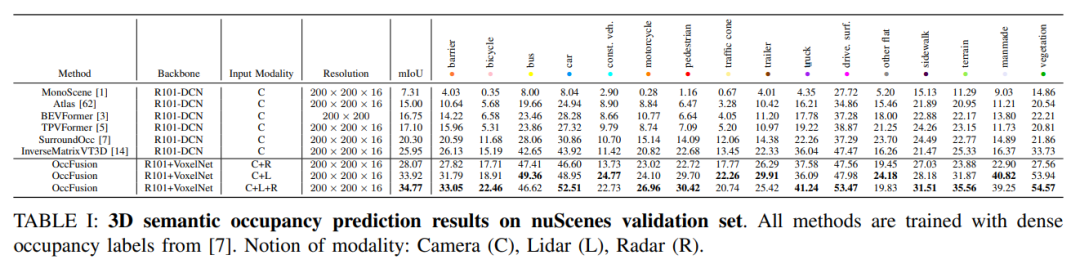

实验对比分析

nuScenes验证集上的3D语义占用预测结果。所有方法都使用密集占用标签进行训练。模态概念:相机(C)、激光雷达(L)、雷达(R)。

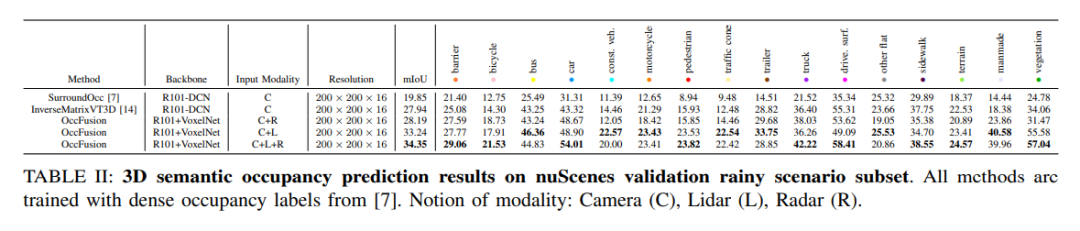

nuScenes验证雨天场景子集上的3D语义占用预测结果。所有方法都使用密集占用标签进行训练。模态概念:相机(C)、激光雷达(L)、雷达(R)。

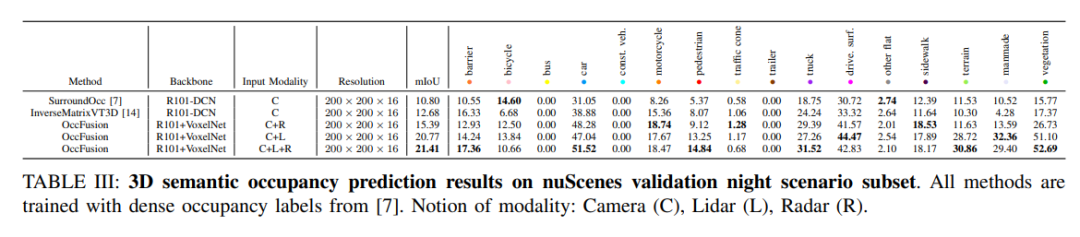

nuScenes验证夜间场景子集的3D语义占用预测结果。所有方法都使用密集占用标签进行训练。模态概念:相机(C)、激光雷达(L)、雷达(R)。

性能变化趋势。(a) 整个nuScenes验证集的性能变化趋势,(b)nuScenes验证夜间场景子集,以及(c)nuScene验证雨天场景子集的性能变化趋势。

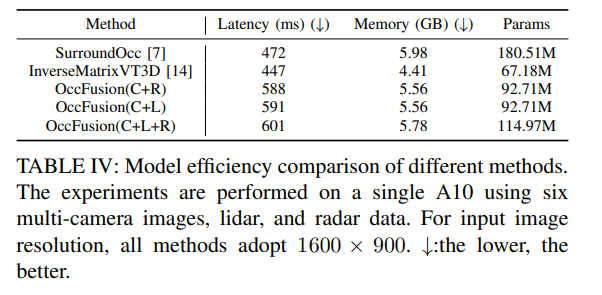

表四:不同方法的模型效率比较。实验是在一台A10上使用六幅多摄像头图像、激光雷达和雷达数据进行的。对于输入图像分辨率,所有方法均采用1600×900。↓:越低越好。

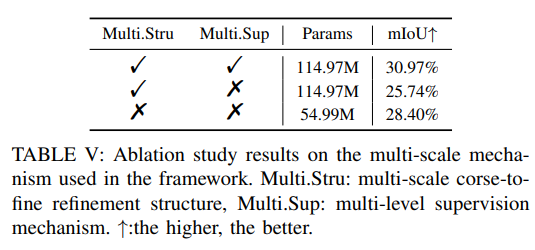

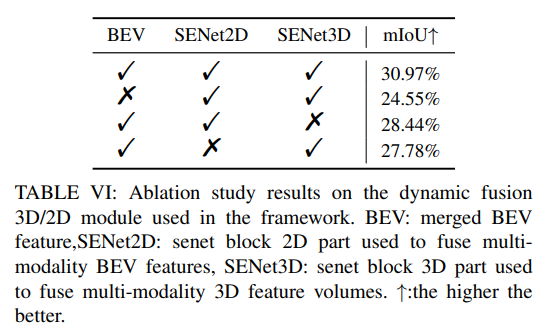

更多消融实验: