今年2月,美国人工智能巨头企业OpenAI再推行业爆款Sora,将之前ChatGPT以图文为主的生成式内容全面扩大到视频领域,引发了全球热议,这也是OpenAI首次进军人工智能视频生成领域。

据公司介绍,Sora使用Transformer架构,可根据文本指令创建近似现实且富有想象力的场景,生成多种风格、不同画幅、最长为一分钟的高清视频。该模型还能够根据静态图像生成视频,或对现有视频进行扩展或填充缺失的帧。

根据官方释出的样例,由Sora生成的视频近乎突破了人类肉眼识别真假事物的极限,除去一些可通过后期算法优化的逻辑性错误,在场景的还原程度上已经高度接近现实中的实拍画面。

这无疑引发影视内容创作行业的震荡,仅问世两天,就让主营图像处理、视频制作软件的Adobe股价应声下跌超过7%,不少影视从业人员开始担心日后饭碗不保。但如同ChatGPT一样,人们在担心被AI取代的同时,其“双刃剑”效应在迅速放大并引起了各方重视,无疑,在安全风险方面,Sora又是一针大剂量催化剂。

Sora 根据文本提示生成了一段以这位女性为主角的视频

Sora加剧“深度伪造”忧虑

严格来说,深度伪造并非AI时代的专属词汇,从早年间看似拙劣的换脸视频开始,深度伪造作为一项快速发展的技术,也在为人类敲响警钟。当AI时代来临,看似有意或无意的深度伪造视频将为人类认知带来巨大冲击。

“这一定是AI做的”

当你对一段真实拍摄的视频内容提出疑问,你可以不经思考地“甩锅”给AI:“这一定是用Sora生成的”;而一段确实是用AI生成的某政客演讲视频,你却为之鼓舞并投出选票。这样的场景,正是基于深度伪造对人类认知造成的紊乱。加利福尼亚大学伯克利分校信息学院副院长法里德甚至表示:“当新闻、图像、音频、视频——任何事情都可以伪造时,那么在那个世界里,就没有什么是真实的。”

这并非杞人忧天的说法,虽然Sora生成的缺陷视频仍被一些媒体放大当作“乐子“,但不可否认,Sora的出现让人们意识到AI深度伪造视频进步飞快,已经接近了真假难辨的程度。这种顾名思义的认知正在网络媒介中潜移默化,扰乱大众对视频内容真实性的判断。前阵子在海外社交圈疯传的威尔·史密斯狂吃意大利面的视频无疑就是这一现象的生动诠释,画面中所谓时隔1年的AI生成的史密斯在真实程度上已经天差地别,众多网友为此感叹AI的逼真,并对此深信不疑,但事实却是“高度逼真”的史密斯就是由本人亲自出镜拍摄。

威尔·史密斯吃意大利面的AI视频与实际的真人视频

如果说之前ChatGPT编织的虚假文本无法眼见为实,那么,当Sora加入唱起双簧,这种对大众认知的紊乱所产生的负面效果不言而喻,能够被滥用于造假、欺骗,甚至颠覆人们对现实的认知,产生的信任危机将损害社会的各行各业。

滥用导致的安全危机

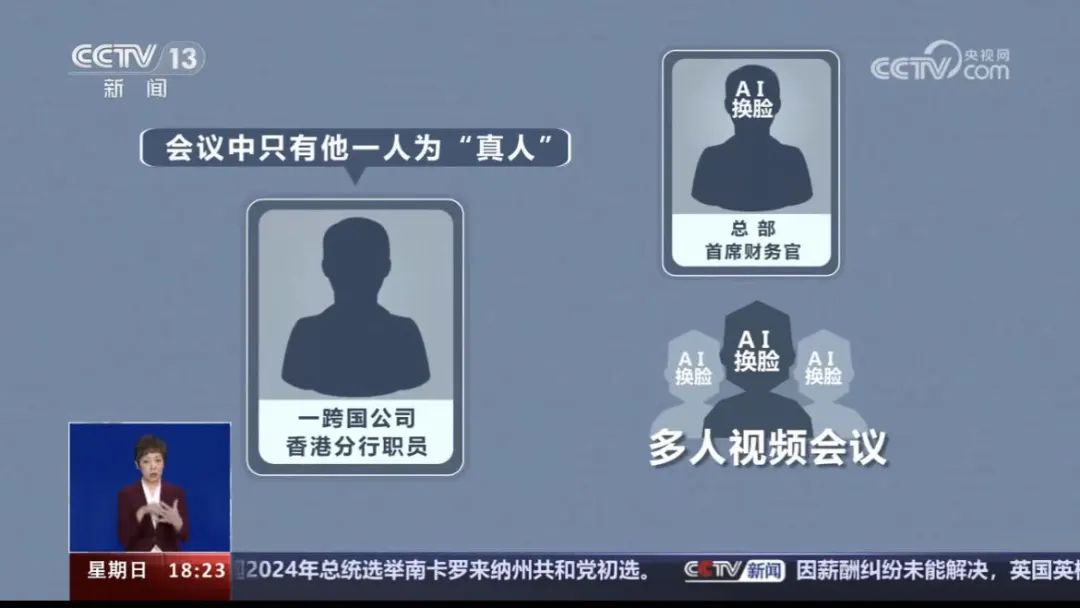

近年来,利用深度伪造的网络犯罪活动时有发生,就在Sora诞生前夕,中国香港就发生了当地迄今为止规模最大的一起利用AI深度伪造实施的诈骗活动。

据香港媒体介绍,某跨国公司香港分行职员在1月中收到该公司英国总部首席财务官的信息,声称要进行机密交易,并分别邀请该公司数名财务职员进行多人的视频会议。由于对方各人在会议内均显示了与现实相同的样貌,该职员信以为真,前后转账15次,共计将2亿港元转到了5个本地银行账户中,直到5天之后,该职员向总部过问此事时才发现被骗。

在本案例中,诈骗者通过公司的YouTube视频和从其他公开渠道获取的媒体资料,成功地仿造了英国公司高层管理人员的形象和声音,再利用深度伪造技术制作伪冒视频,造成多人参与视频会议的效果。目前,香港警方表示,整个案件还在进一步调查之中,还没有逮捕任何嫌疑人。

现在,Sora能实现用更少的人脸数据构造高逼真的特定人脸模型,如果后续正式开放使用,包括AI换脸在内的深度伪造技术门槛必将显著降低,犯罪分子可以更轻松地盗用、冒充他人身份。随着2024年选举大年的到来,世界多国政府已经开始担忧深度伪造对政治选举带来的恶劣影响。据统计,今年全世界至少有65个国家/地区将会先后举行选举,预计将影响全球超过40亿人。在此背景下,AI深度伪造可能被滥用以制造大量虚假音视频内容,从而试图操纵公众舆论和选举结果。

无疑,在深度伪造冲击大众认知、恶意虚假信息快速泛滥的趋势下,Sora的诞生正受到各方更加严格的审视,在惊叹其实力的喧哗后,Sora的达摩克利斯之剑已经高悬在每一位普罗大众头上。

Sora面临的安全挑战

和自家兄弟产品ChatGPT类似,Sora同样会抓取互联网中的视频内容进行训练、优化,如此一来,数据安全问题将成为Sora在网络安全方面所面临的重大挑战。有媒体报道提及,尽管OpenAI在发布时声称所有训练素材均源自公开渠道或经过合法授权,但并未透露具体涉及多少视频样本及其确切来源。

IDC分析师也指出,多模态大模型将读取更多的图像、视频类数据,这些图像视频数据是否合规是否安全,需要得到保障;另一方面,生成的视频与真实世界之间的差异,是否会影响到人身安全、社会稳定、企业安全等,也需要注意。

正如前文所述,在涉及虚假信息的深度伪造方面,虽然OpenAI表示在正式开放Sora使用前会采取几个重要的安全措施,防止其生成极端暴力、色情、仇恨以及有害的涉政内容,OpenAI还将进行专项“红队”攻击测试,招募错误信息、仇恨内容和偏见等领域的专家对其进行对抗性测试的方式来评估Sora被滥用的可能性。但OpenAI也承认,他们无法预测人们使用Sora的所有有益方式,也无法预测人们滥用技术的所有方式。

也有网络技术人员建议,以隐形水印的形式在视频图像中嵌入不可见的水印保护信息,以快速识别AI合成内容并进行溯源。但这种做法在应对将视频重新编码、模糊,或者经过多重转载损失一定画质,以及对视频进行二次加工处理后是否依然能够有效识别,目前还不得而知。

如何看待Sora

在“宁愿看视频也不愿看文字”的时代背景下,视频内容的产出正迎来爆发式增长。相关统计显示,从2015年至2020年,短视频内容年均增长率达到惊人的400%。视频已成为大众日常消遣、娱乐、获取外界信息最主要的方式之一。Sora作为一种视频创作领域的先进生产力,其诞生和发展就具有时代必然性,无论是内容创作者还是网络及信息安全相关的守护者,都应该以积极的心态应对随之带来的变革和挑战。

“哪些能做,哪些不能做”

在今年年初人工智能大本营美国接连发生“假拜登来电”以及“泰勒·斯威夫特虚假不雅照”事件后,美国方面对此表示深感忧虑。美国消费者技术协会首席执行官夏皮罗认为,政府需要在人工智能领域扮演重要角色,确保设置安全屏障和护栏,让产业内人士知道,哪些能做,哪些不能做。

在世界各国政府层面,Sora的推出势必将加速信息安全监管措施的出台。日前,欧盟各国政府已批准《欧盟人工智能法案》,该法案将禁止使用存在“不可接受风险”的AI系统,例如使用生物识别数据推断公众敏感特征的系统。欧洲议会预计将于4月签署这项法案,若一切顺利,这套法规将于2026年生效。

OpenAI也表示,将与世界各地的政策制定者、教育工作者和艺术家合作,了解他们的担忧,确定Sora的积极使用案例,并认为从现实世界的使用中学习是创建和发布越来越安全的人工智能系统的关键组成部分。