自从用上Newbing后,我就放弃CHATGPT 3.5了。昨天写完文章后,我又试了下ChatGPT,没想到去年被封的账号居然又可以用了,不过只能用3.5版本,要用4.0必须升级到PRO,每个月20美金。于是我没有尝试去付款,因为Newbing对我来说已经够用了。

我前几天发那篇关于多个公共大模型回答数据库问题的性能比较的文章后,有个朋友给我留言说用Newbing去和其他通识大模型做PK有点不公平,因为Newbing是一个工程化的系统,使用RAG+LLM的方式来提供服务,首先通过搜索查找到相关知识,再向大模型提问,性能肯定会比其他LLM要好。可能这个朋友是我对比的几种国产大模型的成员,因此他比较在意我的测试的公正性。事实确实是如此,因为其他大模型提供给我们的接口也是工程化的,不过并没有微软做得好,我也只能暂时这么比较了。

从上面的文字,很多朋友可能已经意识到了,通识大模型直接用于运维支撑,其性能是不足的,必须通过本地知识库的嵌入才能获得比较好的效果。这是因为在专业技术领域,通识大模型往往缺乏足够的专业领域知识,因此对于很多问题,它们只能照猫画虎去瞎猜,性能肯定是不足的。

图片

图片

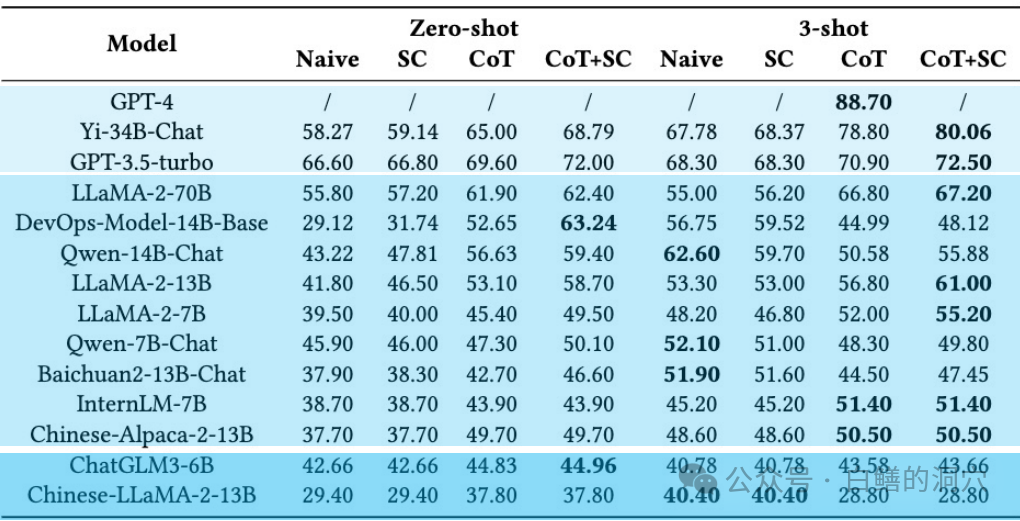

从去年11月份OpsEval发布运维大模型基准来看,通识大模型在OPS领域的表现不如人意。最主要的问题是幻觉问题,我们可以看出GPT 4.0的3-shot Cot这个标志Few shot思维链的指标也仅仅为88.70,只比Yi-34B-Chat这种参数规模小得多的模型搞出不到10%。这种水准无法作为权威提供服务,只能给人以参考。而对于Zero-shot的性能,就更加可怜了。Yi-34B仅仅为65%,也就是说大约1/3的大模型没有学习过的知识的回答是错误的。通识大模型对于需要精准回答的运维领域来说是能力不够的。

大模型因为训练成本昂贵并且无法增量训练(增量只能做微调),因此想要把层出不穷的新知识不断的添加到模型中去是不大现实的。通过RAG做本地知识库的向量嵌入,或者通过AutoPrompt来优化提问是弥补这一缺陷的有效办法,目前已经被大量的商用。

我前阵子也说过,对于搞技术的人来说,拥有一个能够随时给大家提供帮助的知识库十分重要。虽然说目前Newbing已经能够给我提供很好的帮助,不过在很多时候我依然觉得拥有一个私有知识库是十分必要的。

图片

图片

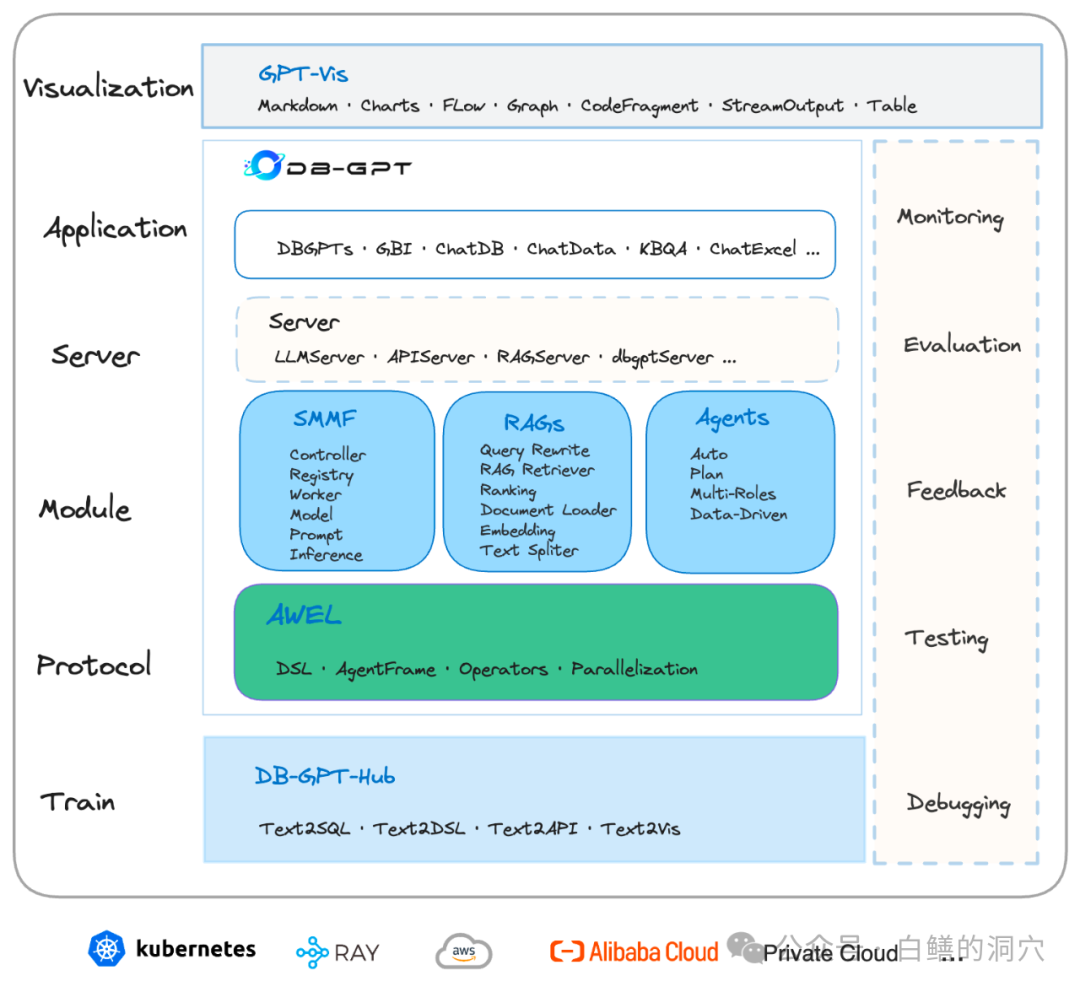

从去年开始我就一直在关注着蚂蚁的开源项目DB-GPT,这个在12GB显卡上就可以进行推理的大模型框架是DBA建立自己私有智能助理的不错的选择。经过一年的迭代,这个开源项目已经较为成熟了,对于想做这方面工作的朋友,所需的就是做自己的知识库就行了。