本文经自动驾驶之心公众号授权转载,转载请联系出处。

- 论文链接:https://browse.arxiv.org/pdf/2402.00637.pdf

- 视频链接:https://youtu.be/JmSLBBL9Ruo

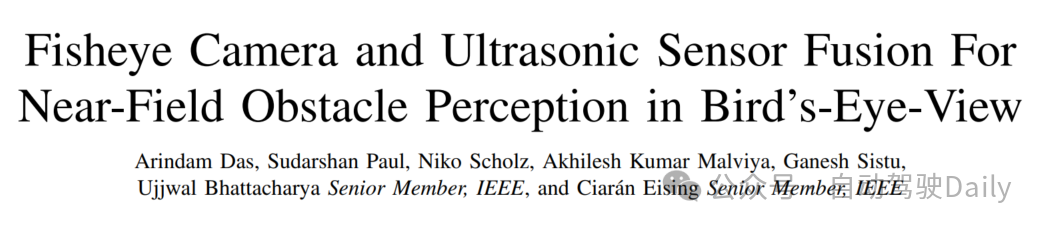

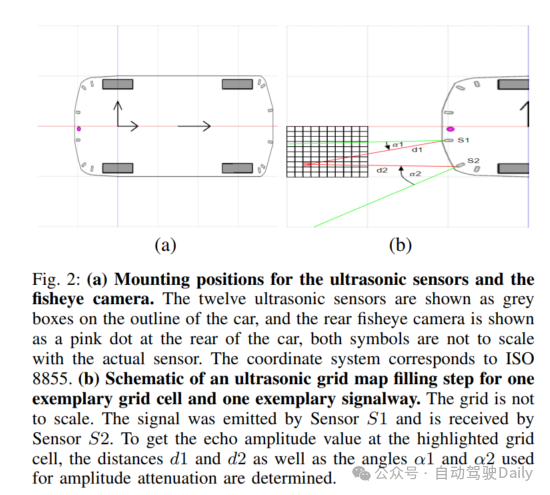

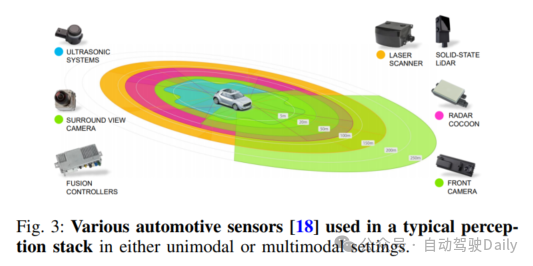

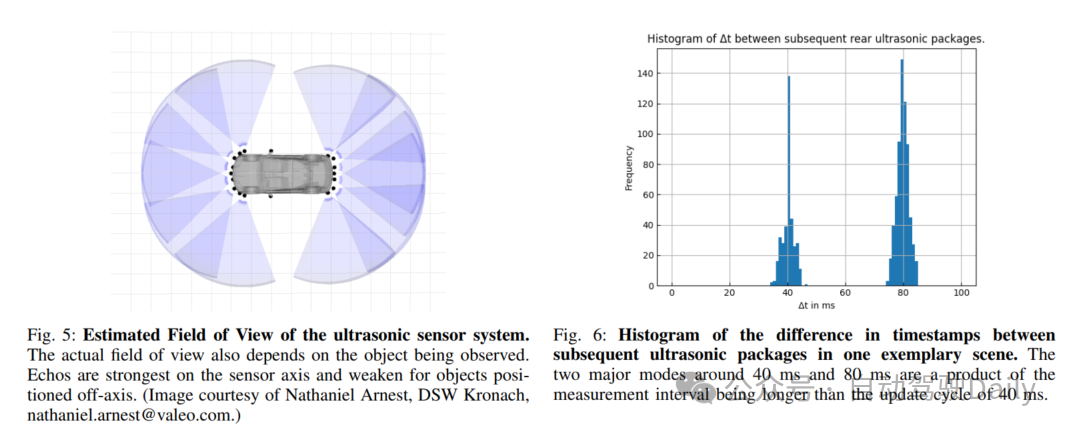

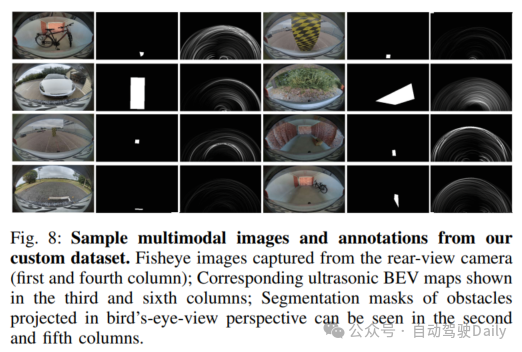

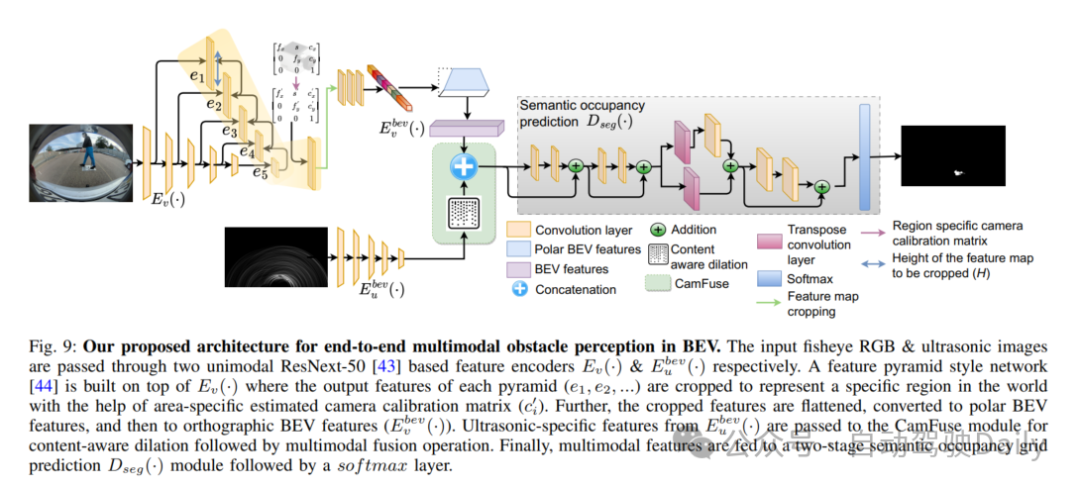

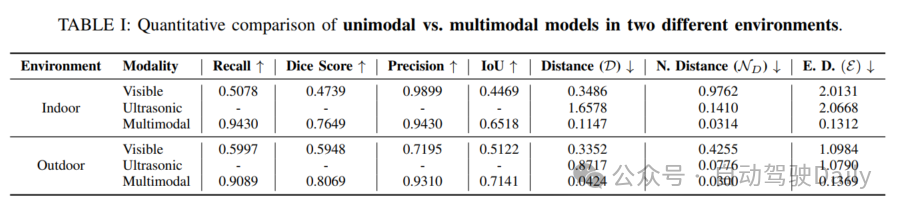

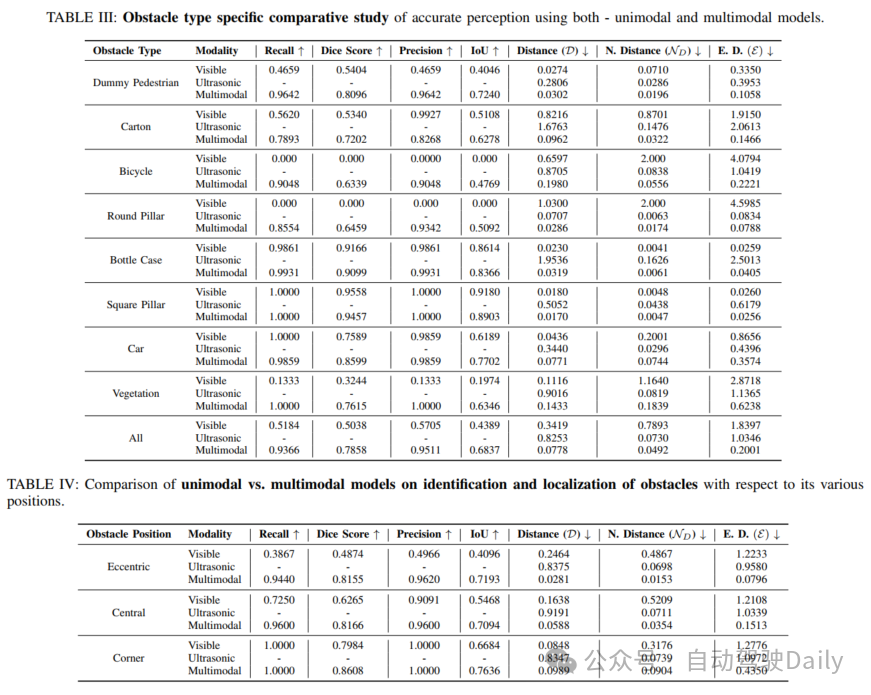

本文介绍了鱼眼相机与超声传感器融合实现鸟瞰图中近场障碍物感知。准确的障碍物识别是自动驾驶近场感知范围内的一项基本挑战。传统上,鱼眼相机经常用于全面的环视感知,包括后视障碍物定位。然而,这类相机的性能在弱光照条件、夜间或者受到强烈阳光照射时会显著下降。相反,像超声传感器这类成本较低的传感器在这些条件下基本不受影响。因此,本文提出了首个端到端的多模态融合模型,其利用鱼眼相机和超声传感器在鸟瞰图(BEV)中实现高效的障碍物感知。最初,采用ResNeXt-50作为一组单模态编码器,以提取每个模态特有的特征。随后,与可见光谱相关联的特征空间被转换为BEV。这两种模态的融合是通过级联来实现的。同时,基于超声频谱的单模态特征图通过内容感知的空洞卷积,用于缓解融合特征空间中两种传感器之间的传感器错误对齐。最后,融合的特征被两阶段语义占用编码器用来生成用于精确障碍物感知的逐网格预测。本文进行了系统性研究,以确定两种传感器多模态融合的最优策略。本文深入展示了数据集创建过程、标注指南,并且进行全面的数据分析,以确保充分覆盖所有场景。当应用于本文数据集时,结果证明了本文所提出的多模态融合方法的鲁棒性和有效性。

本文主要贡献

- 引入了一种新型的多传感器深度网络,其专门为鸟瞰图中的近场障碍物感知而设计。本文所提出的网络结合了鱼眼相机和超声传感器系统,这是首次朝着该方向努力;

- 建立了构建包括鱼眼相机和超声传感器数据的多传感器数据集的策略。本文定义了标注规则,并且提供了相关的数据统计,这对于构建适用于类似应用的多模态模型是至关重要的;

- 本文描述了一个实现非常高精度的端到端可训练网络的实现过程。此外,本文还提出了对proposal进行重构,以支持具有单模态输入的相同特征,从而对基于多模态解决方案的优势进行深入分析;

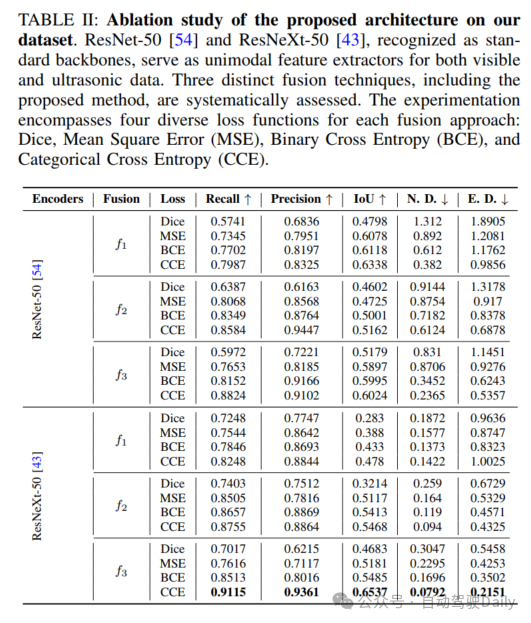

- 本文进行了全面的消融研究,涉及各种提出的网络组件、不同的特征融合技术、不同的增强方法和各种损失函数。

原文链接:https://mp.weixin.qq.com/s/B0zQZ2_SapKuynG2qis1ug